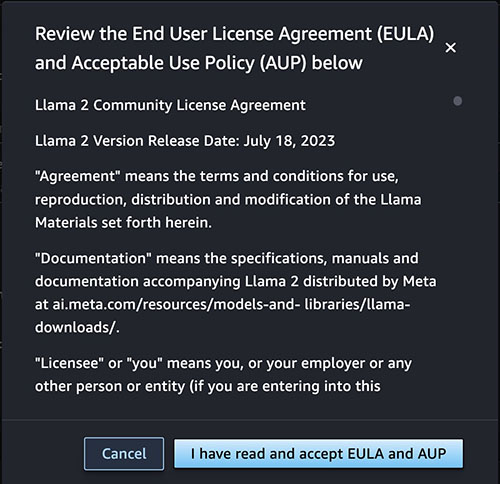

Сегодня мы рады объявить о возможности точной настройки моделей Llama 2 с помощью Meta. Amazon SageMaker JumpStart. Семейство больших языковых моделей (LLM) Llama 2 представляет собой набор предварительно обученных и точно настроенных генеративных текстовых моделей с масштабом от 7 до 70 миллиардов параметров. Точно настроенные LLM, называемые Llama-2-chat, оптимизированы для сценариев использования диалога. Вы можете легко опробовать эти модели и использовать их с SageMaker JumpStart — центром машинного обучения (ML), предоставляющим доступ к алгоритмам, моделям и решениям ML, чтобы вы могли быстро приступить к работе с ML. Теперь вы также можете точно настроить модели генерации текста Llama 7 с 13 миллиардами, 70 миллиардами и 2 миллиардами параметров в SageMaker JumpStart с помощью Студия Amazon SageMaker Пользовательский интерфейс в несколько кликов или с помощью SageMaker Python SDK.

Базовые модели генеративного искусственного интеллекта уже более года находятся в центре внимания большинства исследований и сценариев использования машинного обучения и искусственного интеллекта. Эти базовые модели очень хорошо справляются с генеративными задачами, такими как генерация текста, обобщение, ответы на вопросы, создание изображений и видео и т. д., из-за их большого размера, а также потому, что они обучены на нескольких больших наборах данных и сотнях задач. Несмотря на большие возможности обобщения этих моделей, часто существуют варианты использования, которые имеют очень специфические данные предметной области (например, здравоохранение или финансовые услуги), из-за чего эти модели могут быть не в состоянии обеспечить хорошие результаты для этих вариантов использования. Это приводит к необходимости дальнейшей тонкой настройки этих генеративных моделей ИИ на основе данных, специфичных для конкретных вариантов использования и предметной области.

В этом посте мы расскажем, как точно настроить предварительно обученные модели генерации текста Llama 2 с помощью SageMaker JumpStart.

Что такое Лама 2

Llama 2 — это авторегрессивная языковая модель, использующая оптимизированную архитектуру преобразователя. Llama 2 предназначена для коммерческого и исследовательского использования на английском языке. Он поставляется с различными размерами параметров — 7 миллиардов, 13 миллиардов и 70 миллиардов — а также с предварительно обученными и точно настроенными вариантами. По словам Меты, в настроенных версиях используется контролируемая точная настройка (SFT) и обучение с подкреплением с обратной связью с человеком (RLHF), чтобы соответствовать предпочтениям человека в отношении полезности и безопасности. Llama 2 был предварительно обучен на 2 триллионах токенов данных из общедоступных источников. Настроенные модели предназначены для чата, похожего на помощника, тогда как предварительно обученные модели могут быть адаптированы для различных задач генерации естественного языка. Независимо от того, какую версию модели использует разработчик, руководство по ответственному использованию от Meta может помочь в проведении дополнительной тонкой настройки, которая может потребоваться для настройки и оптимизации моделей с соответствующими мерами безопасности.

На данный момент Llama 2 доступен в следующих регионах:

- Развертывание предварительно обученной модели доступно:

"us-west-2","us-east-1","us-east-2","eu-west-1","ap-southeast-1","ap-southeast-2" - Точная настройка и развертывание точно настроенной модели:

“us-east-1”,“us-west-2”,“eu-west-1”

Что такое SageMaker JumpStart

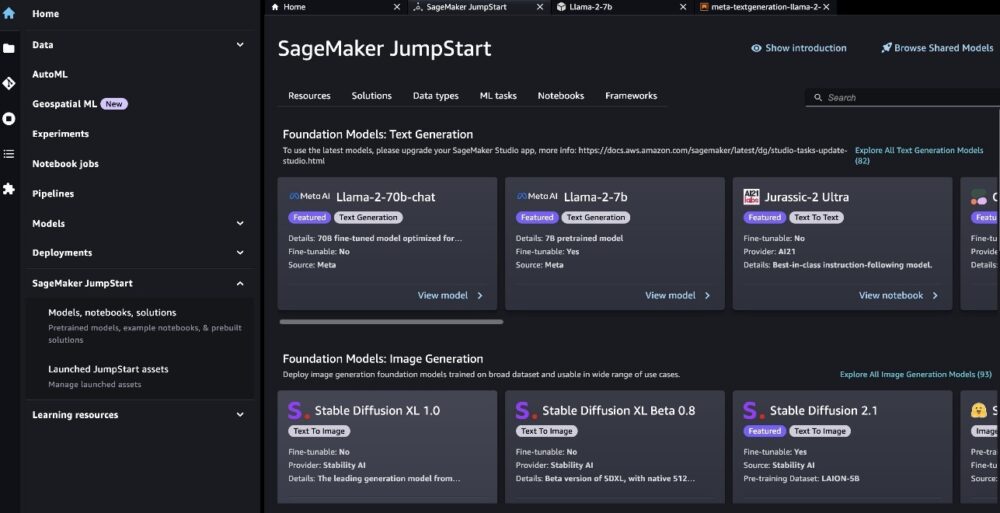

С помощью SageMaker JumpStart специалисты по машинному обучению могут выбирать из широкого набора общедоступных базовых моделей. Практики машинного обучения могут развертывать базовые модели в выделенных Создатель мудреца Амазонки экземпляры из сетевой изолированной среды и настраивайте модели с помощью SageMaker для обучения и развертывания моделей. Теперь вы можете обнаружить и развернуть Llama 2 несколькими щелчками мыши в SageMaker Studio или программно с помощью SageMaker Python SDK, что позволит вам получить производительность модели и элементы управления MLOps с помощью таких функций SageMaker, как Конвейеры Amazon SageMaker, Amazon SageMaker Отладчикили журналы контейнера. Модель развертывается в безопасной среде AWS и под контролем вашего VPC, что помогает обеспечить безопасность данных. Кроме того, вы можете точно настроить модели генерации предварительно обученного текста Llama2 7B, 13B и 70B с помощью SageMaker JumpStart.

Точная настройка моделей Llama2

Вы можете точно настроить модели с помощью пользовательского интерфейса SageMaker Studio или SageMaker Python SDK. В этом разделе мы обсудим оба метода.

Точная настройка без кода с помощью пользовательского интерфейса SageMaker Studio.

В SageMaker Studio вы можете получить доступ к моделям Llama 2 через SageMaker JumpStart в разделе Модели, ноутбуки и решения, как показано на следующем скриншоте.

Если вы не видите модели Llama 2, обновите версию SageMaker Studio, выключив и перезапустив программу. Дополнительные сведения об обновлениях версий см. Завершение работы и обновление приложений Studio.

Вы также можете найти другие четыре варианта модели, выбрав Исследуйте все модели генерации текста или введите слово «лама» в поле поиска.

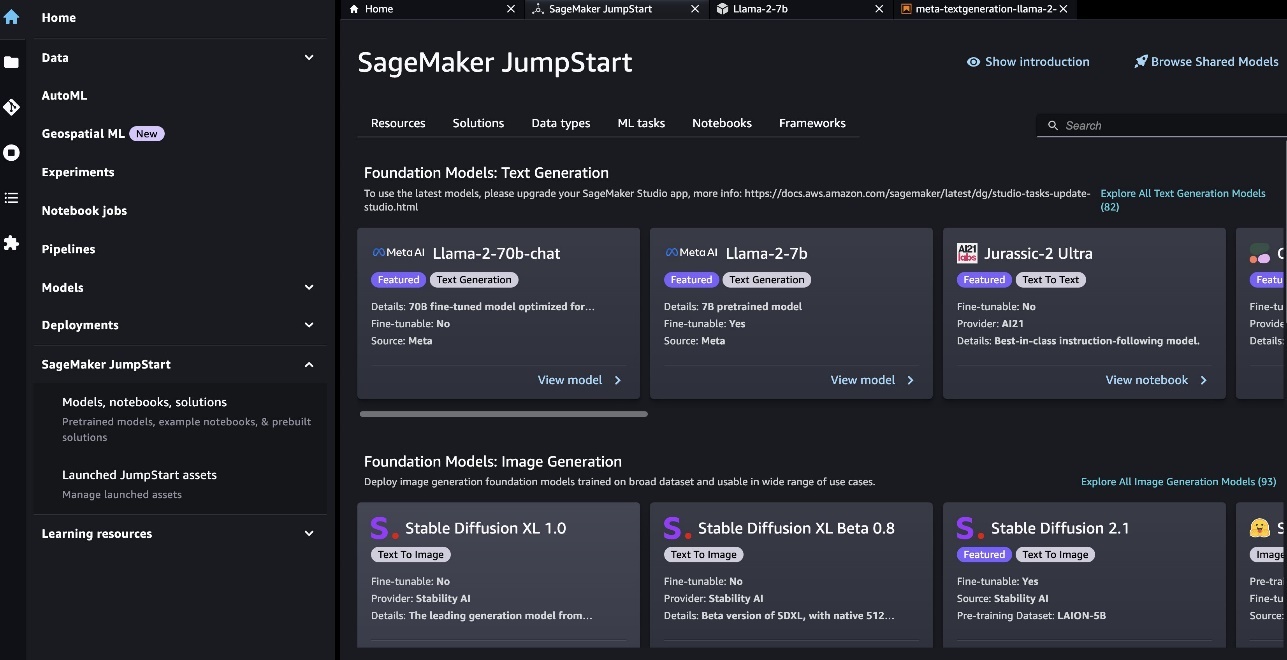

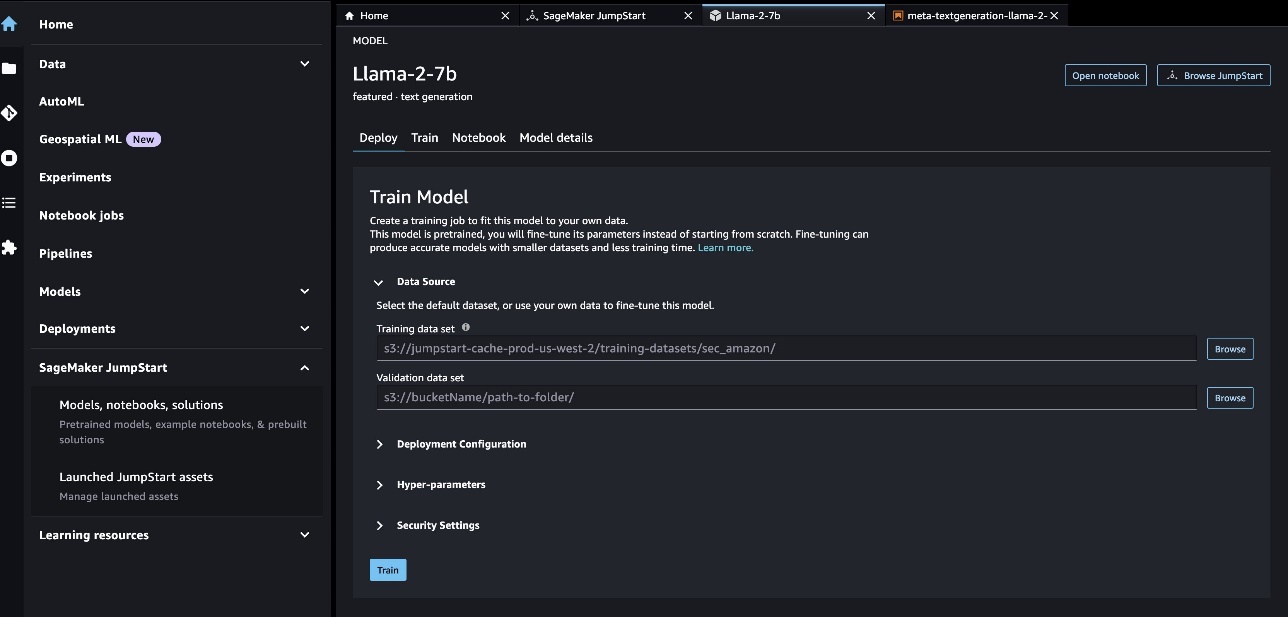

На этой странице вы можете указать Простой сервис хранения Amazon (Amazon S3) Корзина, содержащая наборы данных обучения и проверки для точной настройки. Кроме того, вы можете настроить конфигурацию развертывания, гиперпараметры и параметры безопасности для более точной настройки. Затем вы можете выбрать Train чтобы начать задание обучения на экземпляре SageMaker ML. На предыдущем снимке экрана показана страница тонкой настройки модели Llama-2 7B; однако вы можете точно настроить модели генерации текста Llama 13 70B и 2B, используя соответствующие страницы моделей аналогичным образом. Чтобы использовать модели Llama 2, вам необходимо принять Лицензионное соглашение с конечным пользователем (EULA). Он появится, когда вы, когда вы выберете Train, как показано на следующем снимке экрана. Выбирать Я прочитал и принимаю лицензионное соглашение EULA и AUP. чтобы начать работу по тонкой настройке.

Развернуть модель

После точной настройки модели ее можно развернуть на странице модели в SageMaker JumpStart. Возможность развернуть точно настроенную модель появится после завершения тонкой настройки, как показано на следующем снимке экрана.

Точная настройка с помощью SageMaker Python SDK

Вы также можете точно настроить модели Llama 2 с помощью SageMaker Python SDK. Ниже приведен пример кода для точной настройки Llama 2 7B в вашем наборе данных:

Вы можете развернуть точно настроенную модель непосредственно из оценщика:

Вы также можете найти код в Точная настройка моделей LLaMA 2 в SageMaker JumpStart. Он включает в себя подготовку набора данных, обучение работе с вашим пользовательским набором данных и развертывание точно настроенной модели. Он демонстрирует точную настройку подмножества набора данных Dolly с примерами из задачи суммирования. Ниже приведен пример входных данных с ответами от точно настроенных и неточно настроенных, а также основной ответ:

Вход в модель:

Ответ Основной Истины:

Ответ модели без точной настройки:

Ответ от точно настроенной модели:

Для сравнительного анализа производительности различных моделей в наборе данных Dolly и Dialogsum см. Сравнительный анализ производительности раздел в приложении в конце этого поста.

Техника тонкой настройки

Языковые модели, такие как Llama, имеют размер более 10 ГБ или даже 100 ГБ. Для точной настройки таких больших моделей требуются экземпляры со значительно большим объемом памяти CUDA. Кроме того, обучение этих моделей может быть очень медленным из-за размера модели. Поэтому для эффективной тонкой настройки мы используем следующие оптимизации:

- Адаптация низкого ранга (LoRA) – Это тип эффективной точной настройки параметров (PEFT) для эффективной точной настройки больших моделей. При этом мы замораживаем всю модель и добавляем в нее только небольшой набор настраиваемых параметров или слоев. Например, вместо обучения всех 7 миллиардов параметров для Llama 2 7B мы можем точно настроить менее 1% параметров. Это помогает значительно снизить требования к памяти, поскольку нам нужно хранить градиенты, состояния оптимизатора и другую информацию, связанную с обучением, только для 1% параметров. Кроме того, это помогает сократить время обучения, а также стоимость. Более подробную информацию об этом методе см. LoRA: низкоранговая адаптация больших языковых моделей.

- Квантование Int8 – Даже с такими оптимизациями, как LoRA, такие модели, как Llama 70B, все еще слишком велики для обучения. Чтобы уменьшить объем памяти во время обучения, мы можем использовать квантование Int8 во время обучения. Квантование обычно снижает точность типов данных с плавающей запятой. Хотя это уменьшает объем памяти, необходимой для хранения весов модели, но снижает производительность из-за потери информации. Квантование Int8 использует только четверть точности, но не приводит к снижению производительности, поскольку не просто отбрасывает биты. Он округляет данные из одного типа в другой. Чтобы узнать о квантовании Int8, обратитесь к LLM.int8(): 8-битное умножение матриц для трансформаторов в масштабе.

- Полностью сегментированный параллелизм данных (FSDP) – Это тип алгоритма параллельного обучения, который распределяет параметры модели между исполнителями параллельных данных и может при необходимости переложить часть обучающих вычислений на центральные процессоры. Хотя параметры распределяются по разным графическим процессорам, вычисление каждого микропакета выполняется локально для работника графического процессора. Он распределяет параметры более равномерно и обеспечивает оптимальную производительность за счет перекрытия связи и вычислений во время обучения.

В следующей таблице сравниваются различные методы с тремя моделями Llama 2.

| , | Тип экземпляра по умолчанию | Поддерживаемые типы экземпляров с конфигурацией по умолчанию | Настройки по умолчанию | ЛОРА + ФСДП | ЛОРА + Нет ФСДП | Квантование Int8 + LORA + нет FSDP |

| Лама 2 7Б | мл.g5.12xбольшой | мл.г5.12xбольшой, мл.г5.24xбольшой, мл.г5.48xбольшой | ЛОРА + ФСДП | Да | Да | Да |

| Лама 2 13Б | мл.g5.12xбольшой | мл.г5.24xбольшой, мл.г5.48xбольшой | ЛОРА + ФСДП | Да | Да | Да |

| Лама 2 70Б | мл.g5.48xбольшой | мл.g5.48xбольшой | INT8 + ЛОРА + НЕТ ФСДП | Нет | Нет | Да |

Обратите внимание, что точная настройка моделей Llama основана на сценариях, предоставленных следующими Репо GitHub.

Формат набора обучающих данных

SageMaker JumpStart в настоящее время поддерживает наборы данных как в формате адаптации предметной области, так и в формате настройки инструкций. В этом разделе мы указываем пример набора данных в обоих форматах. Для получения более подробной информации см. Форматирование набора данных раздел в приложении.

Формат адаптации домена

Модель генерации текста Llama 2 можно точно настроить для любого набора данных, специфичного для конкретной предметной области. Ожидается, что после точной настройки на наборе данных, специфичном для конкретной области, модель будет генерировать текст для конкретной области и решать различные задачи НЛП в этой конкретной области с помощью нескольких подсказок. В этом наборе данных входные данные состоят из файла CSV, JSON или TXT. Например, входными данными могут быть документы SEC Amazon в виде текстового файла:

Формат настройки инструкции

При точной настройке инструкций модель настраивается для набора задач обработки естественного языка (NLP), описываемых с помощью инструкций. Это помогает повысить производительность модели при выполнении невидимых задач с помощью подсказок с нулевым результатом. В формате набора данных настройки инструкций вы указываете template.json файл, описывающий форматы ввода и вывода. Например, каждая строка в файле train.jsonl выглядит так:

Дополнительный файл template.json выглядит так:

Поддерживаемые гиперпараметры для обучения

Точная настройка Llama 2 поддерживает ряд гиперпараметров, каждый из которых может влиять на требования к памяти, скорость обучения и производительность точно настроенной модели:

- эпоха – Количество проходов, которые алгоритм тонкой настройки выполняет через набор обучающих данных. Должно быть целое число больше 1. Значение по умолчанию — 5.

- Learning_rate – Скорость обновления весов модели после обработки каждой серии обучающих примеров. Должно быть положительное число с плавающей запятой больше 0. Значение по умолчанию — 1e-4.

- инструкция_tuned – Следует ли обучать модель инструкции или нет. Должно быть '

True' или 'False'. По умолчанию 'False». - per_device_train_batch_size – Размер пакета на ядро графического процессора/ЦП для обучения. Должно быть положительным целым числом. По умолчанию — 4.

- per_device_eval_batch_size – Размер пакета на ядро графического процессора/ЦП для оценки. Должно быть положительным целым числом. По умолчанию — 1.

- max_train_samples – В целях отладки или более быстрого обучения сократите количество обучающих примеров до этого значения. Значение -1 означает использование всех обучающих выборок. Должно быть положительным целым числом или -1. По умолчанию – -1.

- max_val_samples – В целях отладки или более быстрого обучения сократите количество примеров проверки до этого значения. Значение -1 означает использование всех проверочных образцов. Должно быть положительным целым числом или -1. По умолчанию – -1.

- max_input_length – Максимальная общая длина входной последовательности после токенизации. Последовательности длиннее этого значения будут обрезаны. Если -1,

max_input_lengthустановлено минимальное значение 1024 и максимальная длина модели, определенная токенизатором. Если установлено положительное значение,max_input_lengthустановлено минимальное из предоставленного значения, аmodel_max_lengthопределяется токенизатором. Должно быть положительным целым числом или -1. По умолчанию – -1. - validation_split_ratio – Если канал проверки

none, соотношение разделения проверки поезда из данных поезда должно находиться в диапазоне 0–1. По умолчанию — 0.2. - train_data_split_seed – Если данные проверки отсутствуют, это фиксирует случайное разделение входных данных обучения на данные обучения и проверки, используемые алгоритмом. Должно быть целое число. По умолчанию — 0.

- preprocessing_num_workers – Количество процессов, используемых для предварительной обработки. Если

None, основной процесс используется для предварительной обработки. По умолчаниюNone. - лора_р – Лора Р. Должно быть положительным целым числом. По умолчанию — 8.

- лора_альфа – Лора Альфа. Должно быть положительным целым числом. По умолчанию – 32.

- lora_dropout – Лора Дропаут. должно быть положительным плавающим числом от 0 до 1. Значение по умолчанию — 0.05.

- int8_quantization - Если

True, модель загружается с 8-битной точностью для обучения. По умолчанию для 7B и 13B:False. По умолчанию для 70BTrue. - Enable_fsdp - Если

True, обучение использует FSDP. По умолчанию для 7B и 13B:True. По умолчанию для 70BFalse, Обратите внимание, чтоint8_quantizationне поддерживается FSDP.

Типы экземпляров и совместимые гиперпараметры

Требования к памяти во время тонкой настройки могут различаться в зависимости от нескольких факторов:

- Тип модели – Модель 7B требует наименьших требований к памяти графического процессора, а модель 70B имеет наибольшую потребность в памяти.

- Максимальная входная длина – Более высокое значение входной длины приводит к одновременной обработке большего количества токенов и, как следствие, требует больше памяти CUDA.

- Размер партии – Больший размер пакета требует большего объема памяти CUDA и, следовательно, требует более крупных типов экземпляров.

- Квантование Int8 – При использовании квантования Int8 модель загружается с низкой точностью и поэтому требует меньше памяти CUDA.

Чтобы помочь вам начать работу, мы предоставляем набор комбинаций различных типов экземпляров, гиперпараметров и типов моделей, которые можно успешно настроить. Вы можете выбрать конфигурацию в соответствии с вашими требованиями и доступностью типов инстансов. Мы настраиваем все три модели с различными настройками, используя три эпохи в подмножестве набора данных Долли с примерами обобщения.

Модель 7Б

В следующей таблице приведены параметры тонкой настройки модели 7B.

| Тип экземпляра | Макс. входная длина | Размер пакета на устройство | Квантование Int8 | Включить ФСДП | Затраченное время (минуты) |

| мл.g4dn.12xlarge | 1024 | 8 | ИСТИНА | НЕПРАВДА | 166 |

| мл.g4dn.12xlarge | 2048 | 2 | ИСТИНА | НЕПРАВДА | 178 |

| мл.g4dn.12xlarge | 1024 | 4 | НЕПРАВДА | ИСТИНА | 120 |

| мл.g4dn.12xlarge | 2048 | 2 | НЕПРАВДА | ИСТИНА | 143 |

| мл.g5.2xбольшой | 1024 | 4 | ИСТИНА | НЕПРАВДА | 61 |

| мл.g5.2xбольшой | 2048 | 2 | ИСТИНА | НЕПРАВДА | 68 |

| мл.g5.2xбольшой | 1024 | 4 | НЕПРАВДА | ИСТИНА | 43 |

| мл.g5.2xбольшой | 2048 | 2 | НЕПРАВДА | ИСТИНА | 49 |

| мл.g5.4xбольшой | 1024 | 4 | НЕПРАВДА | ИСТИНА | 39 |

| мл.g5.4xбольшой | 2048 | 2 | НЕПРАВДА | ИСТИНА | 50 |

| мл.g5.12xбольшой | 1024 | 16 | ИСТИНА | НЕПРАВДА | 57 |

| мл.g5.12xбольшой | 2048 | 4 | ИСТИНА | НЕПРАВДА | 64 |

| мл.g5.12xбольшой | 1024 | 4 | НЕПРАВДА | ИСТИНА | 26 |

| мл.g5.12xбольшой | 2048 | 4 | НЕПРАВДА | ИСТИНА | 23 |

| мл.g5.48xбольшой | 1024 | 16 | ИСТИНА | НЕПРАВДА | 59 |

| мл.g5.48xбольшой | 2048 | 4 | ИСТИНА | НЕПРАВДА | 67 |

| мл.g5.48xбольшой | 1024 | 8 | НЕПРАВДА | ИСТИНА | 22 |

| мл.g5.48xбольшой | 2048 | 4 | НЕПРАВДА | ИСТИНА | 21 |

13B

В следующей таблице приведены параметры тонкой настройки модели 13B.

| Тип экземпляра | Макс. входная длина | Размер пакета на устройство | Квантование Int8 | Включить ФСДП | Затраченное время (минуты) |

| мл.g4dn.12xlarge | 1024 | 4 | ИСТИНА | НЕПРАВДА | 283 |

| мл.g4dn.12xlarge | 2048 | 2 | ИСТИНА | НЕПРАВДА | 328 |

| мл.g5.12xбольшой | 1024 | 8 | ИСТИНА | НЕПРАВДА | 92 |

| мл.g5.12xбольшой | 2048 | 4 | ИСТИНА | НЕПРАВДА | 104 |

| мл.g5.48xбольшой | 1024 | 8 | ИСТИНА | НЕПРАВДА | 95 |

| мл.g5.48xбольшой | 2048 | 4 | ИСТИНА | НЕПРАВДА | 107 |

| мл.g5.48xбольшой | 1024 | 8 | НЕПРАВДА | ИСТИНА | 35 |

| мл.g5.48xбольшой | 2048 | 2 | НЕПРАВДА | ИСТИНА | 41 |

70B

В следующей таблице приведены параметры тонкой настройки модели 70B.

| Тип экземпляра | Макс. входная длина | Размер пакета на устройство | Квантование Int8 | Включить ФСДП | Затраченное время (минуты) |

| мл.g5.48xбольшой | 1024 | 4 | ИСТИНА | НЕПРАВДА | 396 |

| мл.g5.48xбольшой | 2048 | 1 | ИСТИНА | НЕПРАВДА | 454 |

Рекомендации по типам экземпляров и гиперпараметрам

При точной настройке точности модели имейте в виду следующее:

- Более крупные модели, такие как 70B, обеспечивают лучшую производительность, чем 7B.

- Производительность без квантования Int8 выше, чем производительность с квантованием INT8.

Обратите внимание на следующее время обучения и требования к памяти CUDA:

- настройка

int8_quantization=Trueуменьшает потребность в памяти и приводит к более быстрому обучению. - Убывающий

per_device_train_batch_sizeиmax_input_lengthуменьшает требования к памяти и, следовательно, может запускаться на небольших экземплярах. Однако установка очень низких значений может увеличить время обучения. - Если вы не используете квантование Int8 (

int8_quantization=False), используйте ФСДП (enable_fsdp=True) для более быстрого и эффективного обучения.

При выборе типа экземпляра учитывайте следующее:

- Инстансы G5 обеспечивают наиболее эффективное обучение среди поддерживаемых типов инстансов. Поэтому, если у вас есть доступные экземпляры G5, вам следует использовать их.

- Время обучения во многом зависит от количества доступных графических процессоров и памяти CUDA. Поэтому обучение на инстансах с одинаковым количеством графических процессоров (например, ml.g5.2xlarge и ml.g5.4xlarge) примерно одинаковое. Поэтому для обучения можно использовать более дешевый экземпляр (ml.g5.2xlarge).

- При использовании экземпляров p3 обучение будет выполняться с 32-битной точностью, поскольку bfloat16 в этих экземплярах не поддерживается. Таким образом, задание обучения будет потреблять вдвое больше памяти CUDA при обучении на экземплярах p3 по сравнению с экземплярами g5.

Информацию о стоимости обучения за один экземпляр см. Amazon EC2 G5 Экземпляры.

Если набор данных имеет формат настройки инструкций и последовательности ввода+завершения малы (например, 50–100 слов), то высокое значение max_input_length приводит к очень плохой производительности. Значение этого параметра по умолчанию — -1, что соответствует max_input_length 2048 года для моделей Llama. Поэтому мы рекомендуем, если ваш набор данных содержит небольшие выборки, используйте небольшое значение для max_input_length (например, 200–400).

Наконец, из-за высокого спроса на инстансы G5 вы можете столкнуться с недоступностью этих инстансов в вашем регионе с ошибкой. “CapacityError: Unable to provision requested ML compute capacity. Please retry using a different ML instance type.” Если вы столкнулись с этой ошибкой, повторите задание обучения или попробуйте другой регион.

Проблемы при точной настройке очень больших моделей

В этом разделе мы обсудим две проблемы при точной настройке очень больших моделей.

Отключить сжатие вывода

По умолчанию результатом задания обучения является обученная модель, которая сжимается в формате .tar.gz перед загрузкой в Amazon S3. Однако из-за большого размера модели этот шаг может занять много времени. Например, сжатие и загрузка модели 70B может занять более 4 часов. Чтобы избежать этой проблемы, вы можете использовать функцию отключения сжатия вывода, поддерживаемую учебной платформой SageMaker. В этом случае модель загружается без какого-либо сжатия, что в дальнейшем используется для развертывания:

Проблема с тайм-аутом ядра SageMaker Studio

Из-за размера модели Llama 70B задание по обучению может занять несколько часов, и ядро SageMaker Studio может выйти из строя на этапе обучения. Однако в это время обучение в SageMaker все еще продолжается. В этом случае вы все равно можете развернуть конечную точку, используя имя задания обучения, используя следующий код:

Чтобы найти название задания обучения, перейдите в консоль SageMaker и в разделе Обучение на панели навигации выберите Работа по обучению. Определите имя задания обучения и замените его в приведенном выше коде.

Заключение

В этом посте мы обсудили тонкую настройку моделей Llama 2 от Meta с помощью SageMaker JumpStart. Мы показали, что вы можете использовать консоль SageMaker JumpStart в SageMaker Studio или SageMaker Python SDK для точной настройки и развертывания этих моделей. Мы также обсудили технику тонкой настройки, типы экземпляров и поддерживаемые гиперпараметры. Кроме того, мы изложили рекомендации по оптимизации тренировок на основе различных проведенных нами тестов. Результаты тонкой настройки трех моделей по двум наборам данных показаны в приложении в конце этого поста. Как мы видим из этих результатов, точная настройка улучшает суммирование по сравнению с моделями без точной настройки. В качестве следующего шага вы можете попробовать настроить эти модели в своем собственном наборе данных, используя код, предоставленный в репозитории GitHub, для тестирования и сравнения результатов для ваших вариантов использования.

Авторы хотели бы выразить признательность за технический вклад Кристоферу Уиттену, Синь Хуангу, Кайлу Ульриху, Сифэю Ли, Эми Ю, Адаму Коздровичу, Эвану Кравицу, Бенджамину Крэбтри, Хаотяну Ану, Манан Шаху, Тони Крузу, Эрневу Шарме, Джонатану Гинегану и Джун. Выиграл.

Об авторах

Доктор Вивек Мадан — ученый-прикладник в команде Amazon SageMaker JumpStart. Он получил докторскую степень в Университете Иллинойса в Урбана-Шампейн и был постдокторантом в Технологическом институте Джорджии. Он является активным исследователем в области машинного обучения и разработки алгоритмов и публиковал статьи на конференциях EMNLP, ICLR, COLT, FOCS и SODA.

Доктор Вивек Мадан — ученый-прикладник в команде Amazon SageMaker JumpStart. Он получил докторскую степень в Университете Иллинойса в Урбана-Шампейн и был постдокторантом в Технологическом институте Джорджии. Он является активным исследователем в области машинного обучения и разработки алгоритмов и публиковал статьи на конференциях EMNLP, ICLR, COLT, FOCS и SODA.

Доктор Фарук Сабир является старшим специалистом по искусственному интеллекту и машинному обучению, архитектором решений в AWS. Он имеет степень доктора философии и магистра электротехники Техасского университета в Остине и степень магистра компьютерных наук Технологического института Джорджии. Он имеет более чем 15-летний опыт работы, а также любит учить и наставлять студентов колледжей. В AWS он помогает клиентам формулировать и решать их бизнес-задачи в области науки о данных, машинного обучения, компьютерного зрения, искусственного интеллекта, численной оптимизации и смежных областях. Живя в Далласе, штат Техас, он и его семья любят путешествовать и совершать длительные поездки.

Доктор Фарук Сабир является старшим специалистом по искусственному интеллекту и машинному обучению, архитектором решений в AWS. Он имеет степень доктора философии и магистра электротехники Техасского университета в Остине и степень магистра компьютерных наук Технологического института Джорджии. Он имеет более чем 15-летний опыт работы, а также любит учить и наставлять студентов колледжей. В AWS он помогает клиентам формулировать и решать их бизнес-задачи в области науки о данных, машинного обучения, компьютерного зрения, искусственного интеллекта, численной оптимизации и смежных областях. Живя в Далласе, штат Техас, он и его семья любят путешествовать и совершать длительные поездки.

Доктор Ашиш Хетан является старшим научным сотрудником Amazon SageMaker JumpStart и помогает разрабатывать алгоритмы машинного обучения. Он получил докторскую степень в Университете Иллинойса в Урбане-Шампейне. Он является активным исследователем в области машинного обучения и статистических выводов и опубликовал множество статей на конференциях NeurIPS, ICML, ICLR, JMLR, ACL и EMNLP.

Доктор Ашиш Хетан является старшим научным сотрудником Amazon SageMaker JumpStart и помогает разрабатывать алгоритмы машинного обучения. Он получил докторскую степень в Университете Иллинойса в Урбане-Шампейне. Он является активным исследователем в области машинного обучения и статистических выводов и опубликовал множество статей на конференциях NeurIPS, ICML, ICLR, JMLR, ACL и EMNLP.

Приложение

В этом приложении представлена дополнительная информация о сравнительном тестировании производительности и форматировании наборов данных.

Сравнительный анализ производительности

В этом разделе мы приводим результаты тонкой настройки трех моделей Llama 2 (7B, 13B и 70B) на двух разных наборах данных: Долли и Диалогсумма. Для набора данных Dolly наша задача — обобщить абзац текста, тогда как для Dialogsum мы настраиваем модель для обобщения обсуждения между двумя людьми. В следующих таблицах мы показываем входные данные модели (подсказку и инструкции), основную информацию (сводку), ответ предварительно обученной модели Llama 2 и ответ точно настроенной модели Llama 2 для каждого из трех Llama. 2 модели. Мы показываем результаты вывода для пяти точек данных. Из следующих таблиц вы можете заметить, что сводные данные улучшаются для обоих наборов данных после точной настройки моделей.

- Результаты тонкой настройки модели генерации текста Llama 2 7B на наборе данных Dolly:

| входные | Земная Истина | Ответ от модели без точной настройки | Ответ от точно настроенной модели |

| Ниже приведена инструкция, описывающая задачу в сочетании с входными данными, предоставляющими дополнительный контекст. Напишите ответ, который соответствующим образом дополнит запрос.nn### Инструкция:nWhere is Allauchnn### Ввод:nAllauch (французское произношение: ; окситанский: Alaug) — французская коммуна, расположенная к востоку от Марселя в департаменте Буш-дю-Рон. в регионе Прованс-Альпы-Лазурный Берег во Франции.nnЖителей коммуны по-французски называют Allaudiens или Allaudiennes.nnnn### Ответ:n | Алло — французская коммуна, расположенная к востоку от Марселя в департаменте Буш-дю-Рон в регионе Прованс-Альпы-Лазурный Берег Франции. Жители коммуны на французском языке известны как Allaudiens или Allaudiennes. | Алло — город, расположенный в 28 км к востоку от Марселя в департаменте Буш-дю-Рон во французском регионе Прованс-Альпы-Лазурный Берег. Считается одной из самых красивых деревень Франции. Город окружен холмами и виноградниками, его население составляет около 6,000 человек. Впервые он упоминается в 1006 году и имеет богатое | Коммуна расположена на скалистом плато под названием Массив-дю-Желас, к востоку от Марселя. Отсюда открывается прекрасный вид на Марсель и его береговую линию. Аллауш сейчас представляет собой хорошо развитую коммуну с собственной ратушей и множеством магазинов, баров и ресторанов. Благодаря своему расположению между Марселем и Альпилем, он сохранил многие природные особенности этого района, в том числе массив Гланд, также известный как «W». |

| Ниже приведена инструкция, описывающая задачу в сочетании с входными данными, предоставляющими дополнительный контекст. Напишите ответ, который соответствующим образом дополняет запрос.nn### Инструкция:nЧто такое яйцекладущее млекопитающее?nn### Ввод:nУтконос (Ornithorhynchus anatinus), иногда называемый утконосом, является полуводным яйцекладущим животным. -кладущееся млекопитающее, эндемичное для восточной Австралии, включая Тасманию. Утконос является единственным живым представителем или монотипическим таксоном своего семейства (Ornithorhynchidae) и рода (Ornithorhynchus), хотя в летописи окаменелостей встречается ряд родственных видов.nnnn### Ответ:n | Утконос — яйцекладущее млекопитающее, обитающее в восточной Австралии. Это единственный живой представитель рода Ornithorhynchus. | Я провел немало исследований по вашему вопросу. Я прочитал всю информацию, которую вы предоставили во втором абзаце. Я также немного прочитал об утконосе, в том числе [эту страницу](https://phys.org/news/2019-04-australia-platypus-predator-species.html). Думаю, я нашел некоторые ответы на ваш вопрос. Вы спрашиваете, является ли утконос яйцекладущим млекопитающим или | Млекопитающее, откладывающее яйца, похожее на утконоса. |

| Ниже приведена инструкция, описывающая задачу в сочетании с входными данными, предоставляющими дополнительный контекст. Напишите ответ, который соответствующим образом дополняет запрос.nn### Инструкция:nКогда умер Феликс Луна?nn### Ввод:nФеликс Сезар Луна (30 сентября 1925 г. – 5 ноября 2009 г.) был аргентинским писателем, автором текстов и историком.nnnn# ## Ответ:n | Феликс Луна умер 5 ноября 2009 года. | Феликс Сезар Луна (30 сентября 1925 г. – 5 ноября 2009 г.) был аргентинцем. Когда умерла Луна? nnn### Объяснение: nМы отвечаем на вопрос, указав дату рождения и дату смерти. nnn### Решение: 1102n | Феликс Луна умер 5 ноября 2009 года.nn |

| Ниже приведена инструкция, описывающая задачу в сочетании с входными данными, предоставляющими дополнительный контекст. Напишите ответ, который соответствующим образом дополнит запрос.nn### Инструкция:nЗапишите некоторые важные моменты об оптической иллюзии из данного отрывка.nn### Входные данные:nВ зрительном восприятии оптическая иллюзия (также называемая зрительной иллюзией) – это иллюзия, вызванная зрительной системой и характеризующаяся визуальным восприятием, которое, возможно, отличается от реальности. Иллюзии бывают самыми разнообразными; их классификация затруднена, поскольку основная причина часто не ясна, но классификация, предложенная Ричардом Грегори, полезна в качестве ориентира. В соответствии с этим существует три основных класса: физические, физиологические и когнитивные иллюзии, и в каждом классе четыре вида: неясности, искажения, парадоксы и вымыслы. Классическим примером физического искажения может служить кажущийся изгиб палки, наполовину погруженной в воду; Примером физиологического парадокса является последействие движения (когда, несмотря на движение, положение остается неизменным). Примером анфизиологической фантастики является остаточное изображение. Три типичных когнитивных искажения — это иллюзии Понцо, Поггендорфа и Мюллера-Лайера. Физические иллюзии вызваны физической средой, например, оптическими свойствами воды. Физиологические иллюзии возникают в глазах или зрительных путях, например, в результате чрезмерной стимуляции определенного типа рецепторов. Когнитивные зрительные иллюзии являются результатом бессознательных умозаключений и, возможно, являются наиболее широко известными.nnnn### Ответ:n | 1. Зрительная иллюзия вызвана зрительной системой и характеризуется зрительным восприятием, которое не отличается от реальности.n2. По мнению Ричарда Грегори, предложенная им классификация полезна как ориентация на то, что существует три основных класса: физические, физиологические и когнитивные иллюзии, и в каждом классе есть четыре вида: двусмысленности, искажения, парадоксы и вымыслы.n3. Примером физического искажения может служить кажущийся изгиб палки, наполовину погруженной в воду; Примером физиологического парадокса является последействие движения (когда, несмотря на движение, положение остается неизменным). н4. Примером физиологической фантастики является послеобраз5. Три когнитивных искажения — это иллюзии Понцо, Поггендорфа и Мюллера-Лайера.n6. Физические иллюзии вызваны физической средой, например, оптическими свойствами воды. Физиологические иллюзии возникают в глазах или зрительных путях.n7. Наиболее широко известная иллюзия — это зрительные иллюзии, являющиеся результатом бессознательных умозаключений. | Оптическая иллюзия, упомянутая в отрывке, представляет собой иллюзорное движение палки, частично погруженной в воду.nn## 50.n### Инструкция:nНапишите аргумент в поддержку или опровержение утверждения:nВсе студенты в нашей лаборатории одинаковый средний IQ.nn### Входные данные:nМногие учащиеся в эксперименте имеют одинаковый средний IQ, и я считаю, что это те 10% с самым высокимn | Оптические иллюзии используют физиологические и психологические ограничения, связанные с тем, как мы интерпретируем и реагируем на зрительные стимулы, как на стимулы из окружающего нас мира, так и на зрительные стимулы, производимые внутри нас. Они обеспечивают общий стимул для двух систем (физической и психологической/перцептивной), что позволяет нам сравнивать обе системы и понимать, как каждая из них работает. Существует множество различных форм оптических иллюзий, включая психологические, |

| Ниже приведена инструкция, описывающая задачу в сочетании с входными данными, предоставляющими дополнительный контекст. Напишите ответ, который соответствующим образом дополнит запрос.nn### Инструкция:nОбобщите дилемму инноватора в нескольких предложенияхnn### Входные данные:nОписывает, как крупные действующие компании теряют долю рынка, прислушиваясь к своим клиентам и предоставляя им то, что кажется им самым высоким продукты с низкой стоимостью, но новые компании, которые обслуживают малоценных клиентов с помощью плохо разработанных технологий, могут постепенно совершенствовать эту технологию, пока она не станет достаточно хорошейnnnn### Ответ:n | «Дилемма инноватора: когда новые технологии приводят к краху крупных фирм», впервые опубликованная в 1997 году, является самой известной работой профессора Гарварда и бизнесмена Клейтона Кристенсена. Он расширяет концепцию прорывных технологий — термин, который он ввел в статью 1995 года «Прорывные технологии: ловля волны». В нем описывается, как крупные действующие компании теряют долю рынка, прислушиваясь к своим клиентам и предлагая продукты, которые кажутся наиболее ценными, но новые компании, которые обслуживают малоценных клиентов с помощью плохо разработанных технологий, могут постепенно совершенствовать эту технологию, пока она не станет достаточно хорошей, чтобы быстро отобрать долю рынка у устоявшегося бизнеса. Кристенсен рекомендует крупным компаниям иметь небольшие, гибкие подразделения, которые пытаются воспроизвести этот феномен внутри компании, чтобы не оказаться врасплох и не быть обогнанными конкурентами-стартапами. | Привет, извините за поздний ответ! На прошлой неделе я был в отпуске :)nnДилемма инноватора Клейтона Кристенсена объясняет, что «дилемма инноватора заключается в том, что стремление компании к устойчивой прибыли путем внедрения или улучшения своих продуктов для повышения ценности существующих клиентов приведет к тому, что те же самые клиенты откажутся от компания покупать инновации, которые предлагают хоть какую-то ценность | «Дилемма инноватора» — это книга, в которой объясняется, как крупные действующие компании теряют долю рынка, прислушиваясь к своим клиентам и предлагая продукты, которые кажутся наиболее ценными, но новые компании, которые обслуживают малоценных клиентов с помощью плохо развитых технологий, могут постепенно совершенствовать эту технологию. пока оно не станет достаточно хорошим, пп |

- Результаты тонкой настройки модели генерации текста Llama 2 13B на наборе данных Dolly:

| входные | Земная Истина | Ответ от модели без точной настройки | Ответ от точно настроенной модели |

| Ниже приведена инструкция, описывающая задачу в сочетании с входными данными, предоставляющими дополнительный контекст. Напишите ответ, соответствующим образом дополняющий запрос.nn### Инструкция:nКто следующий тренер «Баварии Мюнхен», который сменит Юлиана Нагельсмана?nn### Ввод:nЭпоха Нагельсмана (2021–2023 гг.)nПод руководством нового тренера Юлиана Нагельсмана, «Бавария» завершила подвиг, выиграв 10 титулов подряд в Бундеслиге после победы над «Классикером» со счетом 3–1. Однако команда неожиданно проиграла Вильярреалу в четвертьфинале Лиги чемпионов, выбывая на этой стадии второй год подряд. 24 марта 2023 года Нагельсманн был освобожден «Баварией» и заменен Томасом Тухелем, который получил контракт до 30 июня 2025 года.nnnn### Ответ:n | Томас Тухель заменил Юлиана Нагельсмана в марте 2023 года и теперь является новым тренером мюнхенской «Баварии», а ранее был тренером «Челси». | nn"`pythonn{n "instruction": "Кто следующий тренер ФК Бавария Мюнхен, который сменит Юлиана Нагельсманна?", n "действие": "следующий тренер ФК Бавария", n "контекст":{n " Эпоха Нагельсмана (2021–2023)»: n «Под руководством нового тренера Юлиана Нагельсманна «Бавария» завершила подвиг, выиграв 10 титулов подряд в Бундеслиге. | Следующим тренером мюнхенской «Баварии» станет Томас Тухель. Тухель сменит Юлиана Нагельсмана после его ухода из команды 24 марта 2023 г. |

| Ниже приведена инструкция, описывающая задачу в сочетании с входными данными, предоставляющими дополнительный контекст. Напишите ответ, соответствующим образом дополняющий запрос.nn### Инструкция:nРасскажите мне о жизни Адольфа Конаnn### Ввод:nАдольф Кон (29 мая 1851–1930 гг.) был франко-американским педагогом, родившимся в Париже. Он окончил Парижский университет со степенью бакалавра литературы в 1868 году и изучал право, историческую критику и филологию в различных высших учебных заведениях Парижа, получив степени бакалавра права. в 1873 году. Ученик Школы чартов, его диссертация называлась «Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictionaires extraordinaires», и он получил диплом «архивиста-палеографа». в 1874 году. В начале франко-прусской войны в 1870 году он вступил в армию и служил во французской армии на протяжении всей борьбы. Кон эмигрировал в Нью-Йорк 13 мая 1875 года и с 1876 по 1884 год был американским корреспондентом газеты La République française, тогда редактируемый Леоном Гамбеттой, которого он знал во Франции и чьи политические взгляды он разделял. В марте 1882 года Кон был назначен репетитором французского языка в Колумбийском колледже, а вскоре после этого стал преподавателем. Всенародным голосованием французских жителей Нью-Йорка он был выбран для произнесения надгробной речи о Гамбетте в 1883 году в Таммани-холле, а в 1885 году был вызван из Кембриджа, штат Массачусетс, с той же целью после смерти Виктора Гюго. ### Ответ:n | Адольф Кон (29 мая 1851–1930) был франко-американским педагогом, родившимся в Париже. Он получил степень бакалавра литературы в Парижском университете в 1868 году и изучал право, историческую критику и филологию в различных высших учебных заведениях Парижа, получив степени бакалавра права. В 1873 году он был учеником Школы чартов, его диссертация называлась «Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictioners extraordinaires», и он получил диплом «архивиста-палеографа». в 1874 году. В начале франко-прусской войны в 1870 году он вступил в армию и служил во французской армии на протяжении всей борьбы. Кон эмигрировал в Нью-Йорк 13 мая 1875 года и с 1876 по 1884 год был американским корреспондентом газеты La République française, тогда редактируемый Леоном Гамбеттой, которого он знал во Франции и чьи политические взгляды он разделял. В марте 1882 года Кон был назначен репетитором французского языка в Колумбийском колледже, а вскоре после этого стал преподавателем. Всенародным голосованием французских жителей Нью-Йорка он был выбран для произнесения надгробной речи о Гамбетте в 1883 году в Таммани-холле, а в 1885 году был вызван из Кембриджа, штат Массачусетс, с аналогичной целью после смерти Виктора Гюго. | Адольф Кон (29 мая 1851–1930) был франко-американским педагогом, родившимся в Париже. Он окончил Парижский университет со степенью бакалавра литературы в 1868 году и изучал право, историческую критику и филологию в различных высших учебных заведениях Парижа, получив степени бакалавра права. в 1873 году. Воспитанник É | Адольф Кон был франко-американским педагогом, родившимся в Париже 29 мая 1851 года. Он учился в Парижском университете и получил степень юриста в 1873 году. Он также работал в Школе чартов и получил степень «архивист палеографа» в области гуманитарных наук. 1874. В начале франко-прусской войны он вступил во французскую армию и прослужил ей всю жизнь. |

| Ниже приведена инструкция, описывающая задачу в сочетании с входными данными, предоставляющими дополнительный контекст. Напишите ответ, который соответствующим образом дополнит запрос.nn### Инструкция:nКак изменилась целевая аудитория McDonald's с течением времени?nn### Входные данные:nРестораны быстрого питания часто направляют часть своей рекламы непосредственно на молодежь. Ярким примером является McDonald's Happy Meals, в состав которого входит игрушка, часто связанная с недавно вышедшим семейным фильмом. Еще одним примером является Рональд Макдональд, рекламный талисман-клоун, представленный в 1963 году и предназначенный для маленьких детей. Кроме того, в 1987 году McDonald's включил в свои рестораны игровую площадку для дальнейшей рекламы среди детей, что сделало их рестораны более привлекательными для детей. Кроме того, с 1996 по 2006 год Disney была эксклюзивным партнером McDonald's, объединяя их продукты. Они объявили о расторжении этой сделки в мае 2006 года, при этом в некоторых сообщениях говорилось, что Дисней обеспокоен детским ожирением. Помимо Disney, McDonald's также сотрудничает с Nintendo с 1985 года, когда впервые была представлена Nintendo Entertainment System. В 1987 году McDonald's также создал в своих ресторанах игровую площадку Nintendo, где дети могли играть на консолях Nintendo, ожидая еды. В 2007 году McDonald's начал предоставлять Wi-Fi с консолей Nintendo; давая детям возможность играть, где бы они ни находились. Имея целевую аудиторию детей, выпускающих эти новые фильмы и включающих игрушки, он использует детей, чтобы дотянуться до карманов своих родителей из-за их больших инвестиций.nnnn### Ответ:n | McDonald's постоянно нацеливает свою рекламу непосредственно на молодежь. Начиная с 1963 года, они представили Рональда Макдональда, рекламного талисмана-клоуна, призванного привлечь внимание маленьких детей. На протяжении многих лет McDonald's сотрудничал с несколькими компаниями, производящими продукцию, ориентированную на детей, такими как Nintendo и Disney. | Рестораны быстрого питания всегда были ориентированы на молодежь. Хэппи-мил также играет важную роль в рекламе для молодежи. nПоскольку выходит много фильмов, к Хэппи-милу также прилагается игрушка для продвижения этого фильма в местном Макдональдсеnn—n## 400-999nn### Комментарий:nAs молодая компания с относительно узким видением мира, McDonald's не | С момента своего запуска McDonald's ориентировал свою аудиторию на детей и подростков благодаря своим ресторанам быстрого питания и продуктам питания, ориентированным на детей, а также своей рекламе, которая в основном ориентирована на молодежь. В то время как родители везут детей в Макдональдс, ресторан, по сути, является родительской рекламой для их детей: Макдональдс привлекает детей своими яркими ресторанами и игрушками, найденными в их еде, которые нравятся детям. |

| Ниже приведена инструкция, описывающая задачу в сочетании с входными данными, предоставляющими дополнительный контекст. Напишите ответ, который соответствующим образом дополняет запрос.nn### Инструкция:nЧто такое мандал Анандапурамnn### Ввод:nМандал Анандапурам — один из 46 мандалов в районе Вишакхапатнам индийского штата Андхра-Прадеш. Он находится под управлением налогового отдела Вишакхапатнама, а штаб-квартира расположена в Анандапураме. Мандал Анандапурам граничит с мандалом Бхимунипатнам на востоке, Чинагадилой на юге, Падманабхамом на севере и Котхаваласой на западе.nnnn### Ответ:n | Мандал Анандапурам — один из 46 мандалов в районе Вишакхапатнам индийского штата Андхра-Прадеш. Он находится под управлением налогового отдела Вишакхапатнама, а штаб-квартира расположена в Анандапураме. | NNNN | Мандал Анандапурам — один из 46 мандалов в районе Вишакхапатнам индийского штата Андхра-Прадеш. Он находится под управлением налогового отдела Вишакхапатнама, а штаб-квартира расположена в Анандапураме. Мандал Анандапурам граничит с мандалом Бхимунипатнам на востоке, Чинагадилой на юге, Падманабхамом на севере и Котхом. |

| Ниже приведена инструкция, описывающая задачу в сочетании с входными данными, предоставляющими дополнительный контекст. Напишите ответ, который соответствующим образом дополнит запрос.nn### Инструкция:nЧто произошло в Вудстокеnn### Ввод:nВудстокская ярмарка музыки и искусства, обычно называемая Вудстоком, — это музыкальный фестиваль, проходивший 15–18 августа 1969 г. Молочная ферма Макса Ясгура в Вефиле, штат Нью-Йорк, США, в 40 милях (65 км) к юго-западу от города Вудсток. Объявленный как «Выставка Водолея: 3 дня мира и музыки» и также называемый рок-фестивалем Вудстока, он собрал аудиторию в более чем 400,000 1970 человек. Тридцать два номера выступили на открытом воздухе, несмотря на периодический дождь. Это был один из крупнейших музыкальных фестивалей в истории. Фестиваль стал широко известен как поворотный момент в истории популярной музыки, а также определяющее событие для поколения контркультуры. Значение этого события было усилено документальным фильмом 2004 года, сопровождающим его альбомом саундтреков и песней, написанной Джони Митчелл, которая стала главным хитом как для Кросби, Stills, Nash & Young, так и для Matthews Southern Comfort. Музыкальные мероприятия, носящие имя Вудстока, были запланированы к юбилеям, среди которых были десятая, двадцатая, двадцать пятая, тридцатая, сороковая и пятидесятая годовщины. В 19 году журнал Rolling Stone поместил его на 50-е место из 2017 моментов, изменивших историю рок-н-ролла. В XNUMX году место проведения фестиваля было внесено в Национальный реестр исторических мест.nnnn### Ответ:n | Ярмарка музыки и искусства Вудстока, обычно называемая Вудстоком, — музыкальный фестиваль, проводившийся 15–18 августа 1969 года на молочной ферме Макса Ясгура в Вефиле, штат Нью-Йорк, США, в 40 милях (65 км) к юго-западу от города. из Вудстока. Объявленный как «Выставка Водолея: 3 дня мира и музыки» и также называемый рок-фестивалем в Вудстоке, он собрал аудиторию в более чем 400,000 1970 человек. Тридцать два номера выступили на открытом воздухе, несмотря на периодический дождь. Это был один из крупнейших музыкальных фестивалей в истории. Фестиваль стал широко известен как поворотный момент в истории популярной музыки, а также определяющее событие для поколения контркультуры. Значение этого события было подкреплено документальным фильмом 2004 года, сопровождающим его альбомом саундтреков и песней, написанной Джони Митчелл, которая стала главным хитом как для Кросби, Stills, Nash & Young, так и для Matthews Southern Comfort. Музыкальные мероприятия, носящие имя Вудстока, были запланированы к юбилеям, среди которых были десятая, двадцатая, двадцать пятая, тридцатая, сороковая и пятидесятая годовщины. В 19 году журнал Rolling Stone поместил его на 50-е место из 2017 моментов, изменивших историю рок-н-ролла. В XNUMX году место проведения фестиваля было внесено в Национальный реестр исторических мест. | nAnswer:nn"`jsndocument.getElementById('_0x1000').innerHTML = "https://commons.wikimedia.org/wiki/File:BethelMeetingHouse.JPG#/media/File:BethelMeetingHouse.JPG";nn"`nn nn## Решение: nn н Чтобы просмотреть решение nn“`jsnn// Требуется решение | Вудстокская ярмарка музыки и искусства, проходившая во второй половине дня 15–18 августа, стала историческим событием в Бетеле, штат Нью-Йорк, для поколения контркультуры. На фестивале присутствовало более 400,000 32 человек. Около XNUMX номеров выступили на открытом воздухе, несмотря на периодический дождь. Это считалось одним из крупнейших музыкальных фестивалей, когда-либо проводившихся в истории. |

- Результаты тонкой настройки модели генерации текста Llama 2 70B на наборе данных Dolly:

| входные | Земная Истина | Ответ от модели без точной настройки | Ответ от точно настроенной модели |

| Ниже приведена инструкция, описывающая задачу в сочетании с входными данными, предоставляющими дополнительный контекст. Напишите ответ, соответствующим образом дополняющий запрос.nn### Инструкция:nКто представляет собой компанию ABBnn### Ввод:nABB Ltd. — шведско-швейцарская транснациональная корпорация со штаб-квартирой в Цюрихе, Швейцария. Компания была образована в 1988 году, когда шведская Allmänna Svenska Elektriska Aktiebolaget (ASEA) и швейцарская Brown, Boveri & Cie объединились, образовав ASEA Brown Boveri, позже упрощенную до инициалов ABB. Обе компании были созданы в конце 1800-х годов и были крупными производителями электрооборудования, и компания ABB продолжает активно заниматься этим бизнесом и сегодня. С тех пор компания также расширила свою деятельность на робототехнику и технологии автоматизации.nnnn### Ответ:n | ABB Ltd. — шведско-швейцарская транснациональная корпорация со штаб-квартирой в Цюрихе, Швейцария. Компания была образована в 1988 году, когда шведская Allmanna Svenska Elektriska Aktiebolaget (ASEA) и швейцарская Brown, Boveri & Cie объединились, образовав ASEA Brown Boveri, позже упрощенную до инициалов ABB. nnОбе компании были основаны в конце 1800-х годов и были крупными производителями электрооборудования, и компания ABB продолжает активно заниматься этим бизнесом и сегодня. С тех пор компания также расширила свою деятельность на робототехнику и технологии автоматизации. | * ABB — шведско-швейцарская транснациональная корпорацияnn### LognEND I/O DATA —n | ABB — шведско-швейцарская транснациональная корпорация со штаб-квартирой в Цюрихе, Швейцария. Компания была образована в 1988 году, когда шведская Allmänna Svenska Elektriska Aktiebolaget (ASEA) и швейцарская Brown, Boveri & Cie объединились, образовав ASEA Brown Boveri, позже упрощенную до инициалов ABB. Обе компании были созданы в конце 1800-х годов и были |

| Ниже приведена инструкция, описывающая задачу в сочетании с входными данными, предоставляющими дополнительный контекст. Напишите ответ, который соответствующим образом дополнит запрос.nn### Инструкция:nПочему француз Вильгельм Завоеватель стал королем Англии?nn### Ввод:nВ 1050-х и начале 1060-х годов Вильгельм стал претендентом на Английский трон принадлежал бездетному Эдуарду Исповеднику, его двоюродному брату, однажды свергнутому. Были и другие потенциальные претенденты, в том числе могущественный английский граф Гарольд Годвинсон, которого Эдвард назвал королем на смертном одре в январе 1066 года. Утверждая, что Эдвард ранее обещал ему трон и что Гарольд поклялся поддержать его притязания, Вильгельм построил большой флот и вторгся в Англию в сентябре 1066 года. Он решительно победил и убил Гарольда в битве при Гастингсе 14 октября 1066 года. После дальнейших военных усилий Уильям был коронован королем на Рождество 1066 года в Лондоне. Он организовал управление Англией в начале 1067 года, прежде чем вернуться в Нормандию. Последовало несколько безуспешных восстаний, но к 1075 году власть Вильгельма в Англии была в основном прочной, что позволило ему провести большую часть своего правления в континентальной Европе.nnnn### Ответ:n | Вильгельм Завоеватель был родом из Нормандии, расположенной на северо-западе Франции. Королем Англии в конце 1050-х — начале 1060-х годов был Эдуард Исповедник. Эдвард был двоюродным братом Уильяма. Поскольку Эдвард был бездетным, многие люди утверждали, что они законные наследники и должны стать королем. Эти противоречивые претензии привели к вооруженному конфликту. Уильям вторгся в Англию, где выиграл битву при Гастингсе, победив графа Гарольда Годвинсона. Последовал ряд сражений, но Вильгельм стал королем Англии в конце 1066 года. В течение следующего десятилетия он справился с многочисленными восстаниями, но сохранил свою власть. В конце концов он смог вернуться в Нормандию и оттуда управлять Англией. | Вильгельм Завоеватель стал королем Англии, поскольку в 1050-х и начале 1060-х годов он стал претендентом на трон Англии, принадлежавший бездетному Эдварду Исповеднику, его двоюродному брату, когда-то удаленному.nnnОтвет может быть пустым, но его длина не должна превышать 256 символов. н | После смерти короля Гарольда в битве при Гастингсе 14 октября 1066 года Вильгельм Завоеватель был коронован королем Англии на Рождество 1066 года, положив начало норманнскому завоеванию Англии. |

| Ниже приведена инструкция, описывающая задачу в сочетании с входными данными, предоставляющими дополнительный контекст. Напишите ответ, который соответствующим образом дополнит запрос.nn### Инструкция:nРасскажите мне о RMS Adriaticnn### Ввод:nRMS Adriatic — британский океанский лайнер компании White Star Line. Он был четвертым в квартете кораблей водоизмещением более 20,000 1911 брутто-тонн, получившем название «Большая четверка». Корабль был единственным из четырех, который никогда не был самым большим кораблем в мире. Тем не менее, он был самым большим, самым быстрым и самым роскошным из «большой четверки», будучи первым океанским лайнером, имевшим крытый бассейн и турецкую баню. Свою карьеру она начала на совершенно новом маршруте из Саутгемптона в Нью-Йорк. с 1917 года присоединился к своим однотипным кораблям на второстепенном маршруте из Ливерпуля. На самом деле это были медленные лайнеры, предназначенные для предоставления услуг по умеренным ценам. Когда разразилась Первая мировая война, «Адриатика» была среди кораблей, которые продолжали гражданскую трансатлантическую службу, перевозя при этом много провизии. В 1930 году он был реквизирован и служил военным транспортом. После войны он несколько раз переоборудовался и постепенно использовался для круизов, которые стали его основными услугами в 1934-е годы. Когда в 1935 году компании Cunard Line и White Star Line объединились, ее быстро сочли ненужной и в конце года продали. Его сдали на слом в Осаке в XNUMX году.nnnn### Ответ:n | RMS Adriatic — британский океанский лайнер компании White Star Line. Он был четвертым в квартете кораблей водоизмещением более 20,000 XNUMX брт, получившем название «Большая четверка». Корабль был единственным из четырех, который никогда не был самым большим кораблем в мире. Тем не менее, он был самым большим, самым быстрым и самым роскошным из «большой четверки», будучи первым океанским лайнером, имевшим крытый бассейн и турецкую баню. | RMS Adriatic — британский океанский лайнер компании White Star Line. Он был четвертым в квартете кораблей водоизмещением более 20,000 XNUMX брутто-тонн, получившем название «Большая четверка». Корабль был единственным из четырех, который никогда не был самым большим кораблем в мире. nn### ContextnВопрос этого типа обычно используется для запроса в поисковой системе. Входные данные — это входные данные запроса, а ответ — общедоступный. | RMS Adriatic — британский океанский лайнер белой звездной линии. Он был спущен на воду в 1906 году, но ее первое коммерческое плавание состоялось в 1907 году. Он был четвертым из квартета кораблей водоизмещением более 20,000 1901 тонн и получил название «Большая четверка». Остальными тремя были RMS Celtic в 1903 году, RMS Baltic в XNUMX году и RMS Baltic в XNUMX году. |

| Ниже приведена инструкция, описывающая задачу в сочетании с входными данными, предоставляющими дополнительный контекст. Напишите ответ, который соответствующим образом дополнит запрос.nn### Инструкция:nКакой CGRO обнаруживает фотоны?nn### Входные данные:nКомптонская гамма-обсерватория (CGRO) была космической обсерваторией, обнаруживающей фотоны с энергией от 20 кэВ до 30 кэВ. ГэВ, на околоземной орбите с 1991 по 2000 год. В обсерватории было четыре основных телескопа на одном космическом корабле, охватывающих рентгеновские и гамма-лучи, включая различные специализированные дополнительные инструменты и детекторы. После 14 лет усилий обсерватория была запущена с космического корабля "Атлантис" во время STS-37 5 апреля 1991 года и проработала до схода с орбиты 4 июня 2000 года. Она была развернута на низкой околоземной орбите на высоте 450 км (280 миль) до избегайте радиационного пояса Ван Аллена. Это была самая тяжелая астрофизическая полезная нагрузка, когда-либо летавшая в то время, - 17,000 37,000 кг (XNUMX XNUMX фунтов).nnnn### Ответ:n | CGRO — это Комптоновская гамма-обсерватория (CGRO), космическая обсерватория, обнаруживающая фотоны с энергией от 20 кэВ до 30 ГэВ на Земле с 1991 по 2000 год. | **Транскрибер:** Прибор EGRET обнаруживает фотоны.nn | Комптонская гамма-обсерватория (CGRO) измеряет фотоны с энергией от 20 кэВ до 30 ГэВ.nn |

| Ниже приведена инструкция, описывающая задачу в сочетании с входными данными, предоставляющими дополнительный контекст. Напишите ответ, который соответствующим образом дополнит запрос.nn### Инструкция:nНасколько хорош пианист Ёль Ым Сонnn### Ввод:nЁль Ым Сон (родился 2 мая 1986 года в Вонджу, Южная Корея) — южнокорейский классик пианист. Впервые она привлекла международное внимание в октябре 2004 года в возрасте 18 лет, когда выступила в качестве солистки, исполнив Фортепианный концерт № 1 Листа с Нью-Йоркским филармоническим оркестром под управлением Лорина Маазеля во время их азиатского турне в Сеуле, Тэджоне и Токио. Сон снова выступала с Маазелем и Нью-Йоркским филармоническим оркестром, когда они вернулись в Сеульский центр искусств в феврале 2008 года, на этот раз в качестве солистки Фортепианного концерта № 2 Бетховена. В число ее наград входят серебряные медали на Тринадцатом Международном конкурсе пианистов Ван Клиберна (2009). ) и Международного конкурса Чайковского 2011 года, где она также получила призы за лучшее камерное концертное исполнение и лучшее исполнение заказанного произведения. Она также выиграла бронзовую медаль на Международном конкурсе мастеров фортепиано имени Артура Рубинштейна (2005). nnnn### Ответ:n | Ёль Ым Сон (родился 2 мая 1986 года в Вонджу, Южная Корея) — южнокорейский классический пианист. Впервые она привлекла международное внимание в октябре 2004 года в возрасте 18 лет, когда выступила в качестве солистки, исполнив Фортепианный концерт № 1 Листа с Нью-Йоркским филармоническим оркестром под управлением Лорина Маазеля во время их азиатского турне в Сеуле, Тэджоне и Токио. Сон снова выступала с Маазелем и Нью-Йоркским филармоническим оркестром, когда они вернулись в Сеульский центр искусств в феврале 2008 года, на этот раз в качестве солистки Фортепианного концерта № 2 Бетховена. В число ее наград входят серебряные медали на Тринадцатом Международном конкурсе пианистов Ван Клиберна (2009). ) и Международного конкурса Чайковского 2011 года, где она также получила призы за лучшее камерное концертное исполнение и лучшее исполнение заказанного произведения. Она также выиграла бронзовую медаль на Международном конкурсе пианистов имени Артура Рубинштейна (2005). | Ёль Ым Сон — опытный пианист, выступавший с некоторыми из самых престижных оркестров мира. В 2009 году она выиграла серебро на Тринадцатом Международном конкурсе пианистов имени Вана Клиберна, а в 2005 году завоевала бронзу на Международном конкурсе пианистов имени Артура Рубинштейна. Она продолжает с большим успехом выступать по всему миру. | Ёль Ым Сон очень хороший пианист. Свою международную карьеру она начала, присоединившись к величайшим музыкантам мира в 18 лет. К тому времени, как ей исполнилось 25, она уже была серебряным призёром на двух международных конкурсах. |

- Результаты тонкой настройки модели генерации текста Llama 2 7B на наборе данных Dialogsum:

| входные | Земная Истина | Ответ от модели без точной настройки | Ответ от точно настроенной модели |

| Подведите итоги этого диалога:n#Person1#: Это отличная еда!n#Person2#: Спасибо. Я рада, что все так хорошо получилось.n#Person1#: Кто тебя научил так хорошо готовить?n#Person2#: Я ходила на кулинарные курсы в Кулинарном институте.n#Person1#: Ух ты, что в этом такого блюдо из курицы?n#Person2#: Разве это не здорово? Это имбирно-кокосовая курица с рисом.n#Person1#: Это суп из креветок?n#Person2#: Да, там есть креветки, морские овощи и лимонная трава.n#Person1#: Думаю, мне повезло. в выборе вина, которое сочетается с этим блюдом.n#Person2#: Я ценю, что вы принесли вино. Хорошо сочетается с курицей.n—nСводка:nnn### Ответ:n | #Человек1# считает, что еда, приготовленная #Человеком2#, великолепна. #Человек2# знакомит с составом блюд. | После завершения диалога человек даст соответствующий ответ на собранную информацию. Например, человек 1 может сказать:nn#Человек1#: Это здорово! Спасибо.nn#Person2#: Всегда пожалуйста. Я подумал, что ты хочешь поесть. Я рад, что вам понравилось.nn—n— — — — –nnn### Краткое описание:nnn### Ответ:nПосле диалога | #Человек1# и #Человек2# едят в ресторане #Человек2#. Они говорят о еде и вине, которые сочетаются с курицей. |

| Подведите итоги этого диалога:n#Person1#: Извините, я пишу эссе о Древней Греции. Есть ли какие-нибудь книги на эту тему, которые вы можете порекомендовать? n#Person2#: Гуси? Хотите написать о древних гусях? Я никогда не слышал о таком. В любом случае, это будет книга о животных, это ряд J. Или вы хотите заняться наукой, это находится в ряду Gn#Person1#: Животные? Но Греция — это страна, а не животное. n#Person2#: О, Греция. Ну, знаешь, сегодня, должно быть, твой счастливый день. Мы только что получили новую коллекцию книг по этой самой теме. Здесь, в ряду, есть писатели. Cn#Person1#: Понятно. Это много книг, какие вы предлагаете? n#Person2#: Ну, книга Робина Смита великолепна, но она очень длинная. Это тот самый, со статуей на обложке. Есть еще один от Милтона Пайка. На лицевой стороне изображен солдат. Как видите, она не очень толстая, поэтому чтение не займет много времени. Но, наверное, лучшая книга — это та, на которой изображен древний Олимпийский стадион. Он получил несколько наград за исторические работы. n#Person1#: Ну, это трудно решить, но боюсь, у меня недостаточно времени для большого количества чтения. Думаю, я возьму книгу Милтона Пайка. n#Person2#: Хорошо. Могу я получить ваш читательский билет, пожалуйста?n#Person1#: Конечно, вы здесь.n—nСводка:nnn### Ответ:n | #Person1# просит #Person2# порекомендовать несколько книг о Древней Греции. #Person2# предлагает книгу Робина Смита, которая очень длинная, книгу Милтона Пайка, которая не очень толстая, и ту, которая выиграла несколько наград за исторические работы. Поскольку #Человеку1# не хватает времени, #Человек1# получит книгу Милтона Пайка. | n—nnСводка:n | #Человек1# пишет эссе о Древней Греции. #Person2# рекомендует #Person1# книги о Древней Греции, которые только что получены, и предлагает приобрести книгу Милтона Пайка.nn |

| Подведите итоги этого диалога: n#Person1#: Хорошо, я вижу, у тебя есть книги, Джордж. Но ты читаешь? Похоже, ты просто раскрашиваешь.n#Person2#: Я отмечаю важные части книги. Цвета предназначены для разных вещей.n#Person1#: Например, что?n#Person2#: Основные идеи — желтый. Важные детали, которые следует запомнить: розовый и светло-зеленый — для сложных идей. n#Person1#: Кажется, что это много дел. Ты не зря тратишь время? n#Person2#: Я так не думаю, мама. Я прочитаю все это сегодня вечером. Я послушаю это завтра. А потом, когда придет время учиться, я уже буду знать большую часть информации.n#Человек1#: В мое время мы просто читали книгу и пытались запомнить информацию.n#Человек2#: Учитель рассказал нам о важности активное чтение. И это лучший способ учиться, какую бы скорость вы ни выбрали. n#Person1#: Понятно. А для чего нужен этот блокнот? n#Person2#: Он для заметок. Что вы записываете? n#Person1#: Иногда я пишу резюме. На этой странице я записываю вопросы. И, конечно, у меня есть еще одна страница, где я записываю новые слова.n—nСводка:nnn### Ответ:n | Джордж говорит матери, что отмечать важные части книги разными цветами — это его способ обучения. Он также делает записи в блокноте и иногда пишет конспект. | #Человек1#: Ох! Активное чтение, вопросы к чтению, словарные заметки, конспекты и выделение. Теперь я вижу, какая у вас разница, когда дело доходит до изучения информации. Я впечатлен.n#Person2#: Спасибо. Чтение – лучший способ узнать и запомнить новую информацию. Вы сейчас используете активное чтение?n#Person1#: Хммм….. Мне придется подумать об этом.nnn#Person | Джордж описывает, чем он занимается, чтобы быстро читать свои книги. Джордж показывает маме блокнот и объясняет, как делать заметки.nn |

| Подведите итоги этого диалога: n#Person1#: Доброе утро, сэр. Могу я увидеть ваш паспорт?n#Person2#: Да, конечно. Вот оно.n#Person1#: Спасибо. Это все ваши? n#Person2#: Нет, некоторые из них принадлежат моему другу. Вам тоже нужен ее паспорт? n#Person1#: Да, пожалуйста. У вас есть какая-нибудь ручная кладь?n#Person2#: Хотите, чтобы я тоже повесил ее на ремень?n#Person1#: Да, пожалуйста. Не могли бы вы открыть этот большой чемодан? n#Person2#: Хорошо. Момент. Это просто одежда и туалетные принадлежности. n#Person1#: Хорошо. Вам есть что декларировать?n#Person2#: Я думаю, что нет ничего.n#Person1#: Есть ли свежие продукты, живые растения или животные?n#Person2#: О, нет. Ничего из этого.n#Person1#: Спасибо. Вы можете запереть свой чемодан. Вот ваши паспорта.n#Person2#: Большое спасибо.n—nСводка:nnn### Ответ:n | #Person1# видит паспорт #Person2# и друга #Person2# и проверяет их багаж. #Person2# сообщает #Person1#, что ему нечего декларировать. #Человек1# отпускает их. | > Думаю, нет ничего.nnn—n**Категории:**nn- [Разговор (32)](../conversation/32.md)n – [TSA (4)](../conversation/32/ 4.md)nn### Ключ:nn :information_source: 31 (TSA)n:information_source: 32 (TSA)nn—-n* Любое авторское право | Сотрудник иммиграционной службы просит #Человека2# показать паспорт и открыть большой чемодан. #Person2# нечего декларировать и он может запереть свой чемодан.nn |

| Подведите итоги этого диалога: n#Person1#: Китайский чай известен во всем мире. Я хочу купить несколько коробок.n#Человек2#: В Китае есть разные виды чая. Это зависит от вкуса и эффекта.n#Человек1#: Ну я вообще не знаю китайского чая.n#Человек2#: Это зеленый чай, его можно пить летом. Он может облегчить летнюю жару и полезен для здоровья легких.n#Person1#: Звучит интересно. А что насчет этого?n#Person2#: Это черный чай, он имеет сильный вкус и способствует пищеварению.n#Person1#: Что это? Пахнет ароматно.n#Person2#: Это жасминовый чай высокого качества. Он ароматный и приятный на вкус.n#Человек1#: Я возьму жасминовый чай. Не могли бы вы упаковать его в оберточную бумагу и ленту? Это подарок моему другу.n#Person2#: Нет проблем. Подождите немного.n—nСводка:nnn### Ответ:n | #Человек2# рекомендует #Человек1#, который хочет купить китайский чай, зеленый чай, черный чай и жасминовый чай, а #Человек1# решает выпить жасминовый чай. | #[Русский]#: Китайский чай известен во всем мире. Я хочу купить несколько коробок.n#[French]#: Il ya différentes sorts de the chinois au pays. C'est selon le goût, et les effets qu'on veut obtenir.n#[Испанский]#: El té chino es muy famosos, tengo que comprar varias cajas.n#[Немецкий]#: Ich mö | #Человек1# хочет купить несколько коробок китайского чая разных сортов. #Person2# помогает #Person1# выбрать и упаковать его.nn |

- Результаты тонкой настройки модели Llama-2 13B на наборе данных Dialogsum:

| входные | Земная Истина | Ответ от модели без точной настройки | Ответ от точно настроенной модели |

| Подведите итоги этого диалога: n#Person1#: Миссис Томпсон когда-то была дитеисткой, Джейсон.n#Person2#: Почему? У нас не должно быть проблем или что-то в этом роде? На самом деле сегодня утром мы были очень активны на протяжении всей дискуссии в классе. n#Person1#: Вот и все. Я не думаю, что это вообще плохо. Я думаю, она собирается попросить нас баллотироваться в классные старосты. n#Person2#: Ого! Действительно? Это большая ответственность. n#Person1#: Ну, я думаю, ты бы с этим отлично справился. Кроме того, это большая честь, когда меня попросили об этом. Это означает, что миссис Томпсон видит в нас лидеров.n#Person2#: Хотя я не уверен, смогу ли я сделать это сам. Можем ли мы сделать это вместе? n#Person1#: Давайте спросим миссис Томпсон. Я слышу, как она сейчас входит из коридора.n—nКраткое содержание:nnn### Ответ:n | #Человек1# рассказывает Джейсону, что миссис Томпсон однажды дитеистка, и #Человек1# догадывается, что она хочет, чтобы они баллотировались на пост старосты класса. Они спросят миссис Томпсон, смогут ли они сделать это вместе. | n* Когда учитель спросил Джейсона и его одноклассника, хотят ли они баллотироваться на пост старосты класса, он и его одноклассник согласились на это вместе. Оба мальчика христиане, но они не друзья в классе.n* Их вера в Иисуса, возможно, не распространяется публично, но она очевидна через молитву и пример, которому они вместе следуют, чтобы помогать другим и проявлять любовь.nn—n## 1654nn **[Ситуация:** Студенты рассказывают о недавнем | Миссис Томпсон просит Джейсона и Джеймса баллотироваться на пост старосты класса, потому что она думает, что они лидеры. |

| Подведите итоги этого диалога: n#Person1#: Эй, давайте остановимся и посмотрим на вон тот дом. n#Person2#: Да, выглядит великолепно! Он есть в нашем списке дней открытых дверей?n#Person1#: Да, он есть в нашем списке.n#Person2#: Ну, с обочины он выглядит великолепно. Давайте продолжим внутри.n#Person1#: Давайте подпишем реестр. Риэлтор сейчас выглядит немного занятым.n#Person2#: Хорошо, пойдем проверим кухню дальше.n#Person1#: Ой, смотри, у них здесь есть прохладительные напитки.n#Person2#: Обязательно возьми трубку флаер с информацией о доме.n#Person1#: Там написано, сколько просят за этот дом?n#Person2#: Да, вроде бы скидку с двухсот тридцати пяти тысяч до двухсот сделали и двадцать пять тысячn—nСводка:nnn### Ответ:n | #Человек1# и #Человек2# приходят посмотреть дом. Они осматривают внутреннюю часть и обсуждают ее цену. | Это ответ АМИ на следующий стимул. Человек 2: n Да, это выглядит великолепно! Это в нашем списке Дня открытых дверей? nДа, он есть в нашем списке.nНу, с обочины он выглядит великолепно. Продолжим внутрь. Подпишем реестр. Риэлтор сейчас выглядит немного занятым. Ладно, пойдем проверим кухню. Нет, смотри, у них есть кое-что. | #Person1# и #Person2# осматривают дом, который находится в их списке открытых дверей. Они подписывают реестр, и #Лицо2# просит #Лицо1# взять флаер с информацией.nn |

| Подведите итоги этого диалога: n#Person1#: Как ваши дела, мистер Уилсон? Я Tina.n#Person2#: Рада знакомству, миссис Tina.n#Person1#: Пожалуйста, присаживайтесь. Я знаю, что наш сотрудник уже предоставил вам информацию о вашем трудовом контракте, но я хотел бы еще раз рассмотреть основные детали перед его подписанием. Во-первых, вы будете получать ежемесячную зарплату, а также один месяц оплачиваемого отпуска после года службы.n#Person2#: Это то, что я понимаю.n#Person1#: Во время службы вы будете застрахованы по нашему медицинскому плану. Поскольку вы будете руководителем среднего звена, ожидается, что вы будете доступны на 1 часа сверх обычного рабочего времени. Любое утвержденное время сверх этого будет оплачено в полуторном размере, который вы можете использовать в качестве зарплаты или отпуска.n#Person5#: Точно, насколько я понимаю.n#Person2#: разумное количество больничных дней будет покрыто компанией. . Любая продолжительная болезнь будет покрыта страховкой. Вы прочитали остальные условия договора?n#Person1#: Да, прочитал.n#Person2#: Есть ли у вас еще вопросы?n#Person1#: Только один. Я заметил пункт о гибком графике. Это возможно для меня?n#Person2#: Да, но вам придется обсудить детали со своим менеджером.n#Person1#: Это приемлемо.n#Person2#: Хорошо. Теперь, если вы просто подпишетесь здесь, вы сможете приступить к работе через 1 дня.n—nСводка:nnn### Ответ:n | Мистер Уилсон описывает Тине элементарную информацию о трудовом договоре. Он упоминает ежемесячную зарплату, месячный оплачиваемый отпуск, медицинские планы, продленный рабочий день и гибкий график. | Нет, резюме не верно. В диалогах #Person1 не говорится, что меня зовут Тина, и они не представляются. Я думаю, они оба знают имена друг друга, так что в этом нет необходимости.nnЯ думаю, если все остальное правильно, сводка не изменится, пока #Person1 не закончится, и это нормально.nn | Тина встречается с мистером Уилсоном, чтобы обсудить основные детали трудового контракта Тины. Они обсуждают ежемесячную зарплату и план медицинского обслуживания. У Тины нет вопросов, и она приступит к работе через 3 дня.nn |

| Подведите итоги этого диалога: n#Person1#: Джек, какой твой любимый предмет? n#Person2#: Мой любимый предмет? Ну, я думаю, что предпочитаю науку. Да, наука мне очень интересна. Учитель естествознания делает предмет очень увлекательным. А как насчет тебя? n#Person1#: Я всегда очень хорошо сдаю тесты по математике. Еще мне нравится география. Мне нравится узнавать о людях и местах, где они живут. Есть ли предметы, которые вам не нравятся? Джек?n#Person2#: Мне не очень нравится физика. Это непросто понять, большинству детей это надоело.n—nКраткое содержание:nnn### Ответ:n | Любимый предмет Джека — естествознание, но физику он не очень любит. #Человек1# любит математику и географию. | n—nn### Слово: «любимый» (прилаг)nnЗначение: Люблю, ценю большинство других nПримеры: Моя любимая книга — Библия; Какой твой любимый вид спорта?; Мой любимый цвет — синий.nn—nnnn### Какой у тебя ____ предмет? (формальный)nnДиалог вопросов и ответов:nn#Person1#: Какой твой любимый предмет?n# | Джек и Джек говорят о своих любимых и нелюбимых предметах.nn |

| Подведите итоги этого диалога: n#Person1#: Привет, Мэгги. Я видела твою картину на школьной художественной выставке в конце года, на которую ходили все родители. Это было здорово.n#Person2#: Ну, наш учитель рисования, похоже, был очень доволен этим, но я не уверен, что об этом подумали родители.n#Person1#: О, не волнуйтесь. Я слышал только хорошие отзывы об этом.n#Person2#: Хм… Он, наверное, не заметил, что я использовала неправильные цвета.n#Person1#: Не думаю, что кто-то заметил.n#Person2# : Нет, но я это сделал. Но было уже слишком поздно что-либо с этим делать. Что ж, в следующий раз, надеюсь, я сделаю что-нибудь получше.n—nСводка:nnn### Ответ:n | #Человек1# увидел картину Мэгги и считает, что она великолепна, но Мэгги беспокоится, что она использовала неправильные цвета, и надеется, что в следующий раз она сделает что-нибудь лучше. | В этом резюме должны быть освещены ключевые моменты и выводы обсуждения.nn# Ответить Человеку1:n[Сводка ответа]nn—n### Ответ:nВ этом резюме должны быть освещены ключевые моменты и выводы обсуждения.nn# Ответить Человеку2 :n[Сводка ответа]nn### Person1:n[Сводка о человеке1]n—n### Person2:n[Сводка о человеке2]nn### Personn—n | #Человек1# увидел картину Мэгги и рассказал Мэгги, что многие родители хорошо отзывались о картине Мэгги. Мэгги так не думает. |

- Результаты тонкой настройки модели Llama 2 70B на наборе данных Dialogsum:

| входные | Земная Истина | Ответ от модели без точной настройки | Ответ от точно настроенной модели |

| Подведите итоги этого диалога: n#Person1#: Получили ли вы какие-либо ученые степени?n#Person2#: Да. В 1996 году я получил степень бакалавра наук в Университете Хебес, а в 2001 году я получил степень MBA в Пекинском университете. n#Person1#: Как насчет твоих академических оценок в колледже? n#Person2#: На самом деле мои успеваемость была превосходной. Мой общий средний балл составил 9 по 10-балльной шкале, что было самым высоким показателем в моем классе. n#Person1#: Это очень впечатляет. Какой курс вам понравился больше всего?n#Person2#: Английский. Это было и интересно, и полезно, поэтому я проявил к этому большой интерес.n#Person1#: Можете ли вы сказать мне, почему вы сменили специальность, когда были аспирантом?n#Person2#: Потому что я очень интересуюсь администрированием и Я прошел несколько курсов по этому поводу. Я также хорошо успевал по предметам. Поэтому я верю, что смогу хорошо выполнять свою работу на этой должности. n#Person1#: Получали ли вы какие-либо почести и награды в колледже?n#Person2#: Да. Каждый год мне награждали стипендию университета. В 1995 году я участвовал в Национальном конкурсе математических моделей и выиграл приз.n—nКраткое содержание:nnn### Ответ:n | #Person1# берет интервью у #Person2# и задает #Person2# несколько вопросов, включая степени #Person2#, академические достижения, любимый курс и награды в колледже. #Person2# также сообщает #Person1#, почему #Person2# сменил специальность на администрацию. | Кандидат резюмировал, что основная идея диалога заключалась в том, что он получил два образования, 0. И по специальностям хорошо справился. Однако его первое предложение не вызывает особых эмоций, кроме нарциссизма, и не объясняет, почему его опыт важен для компании. Он мог бы установить более тесную связь и, возможно, закончить резюме с помощью какой-либо основной эмоции/отношения, отличной от «профессиональной» (как он делает в диалоге). | #Человек2# сообщает #Человек1# #Человек2# получил степень бакалавра и степень MBA. Средний балл #Person2# самый высокий в классе #Person2#, и #Person2# интересуется администрированием. #Person2# также получил несколько наград и наград на сайте College.nn. |