Данные трансформируют каждую область и каждый бизнес. Однако, учитывая, что данные растут быстрее, чем большинство компаний могут их отслеживать, сбор данных и извлечение из них полезной информации становится сложной задачей. А современная стратегия данных может помочь вам добиться лучших бизнес-результатов с помощью данных. AWS предоставляет наиболее полный набор сервисов для сквозной путь передачи данных , чтобы помочь вам разблокировать ценность ваших данных и превратить его в понимание.

Специалисты по данным могут тратить до 80 % своего времени на подготовку данных для проектов машинного обучения (ML). Этот процесс подготовки в значительной степени представляет собой однообразную и утомительную работу и может включать в себя несколько программных API и пользовательских библиотек. Обработчик данных Amazon SageMaker помогает специалистам по данным и инженерам данных упростить и ускорить подготовку табличных данных и данных временных рядов, а также разработку функций с помощью визуального интерфейса. Вы можете импортировать данные из нескольких источников данных, таких как Простой сервис хранения Amazon (Амазон С3), Амазонка Афина, Амазонка Redshiftили даже сторонние решения, такие как Снежинка or DataBricks, и обрабатывайте свои данные с помощью более 300 встроенных преобразований данных и библиотеки фрагментов кода, чтобы вы могли быстро нормализовать, преобразовывать и комбинировать функции без написания кода. Вы также можете использовать собственные преобразования в PySpark, SQL или Pandas.

В этом посте показано, как можно запланировать автоматический запуск заданий по подготовке данных. Мы также изучаем новую возможность Data Wrangler для параметризованных наборов данных, которая позволяет указывать файлы для включения в поток данных с помощью параметризованных URI.

Обзор решения

Data Wrangler теперь поддерживает импорт данных с использованием параметризованного URI. Это обеспечивает дополнительную гибкость, поскольку теперь вы можете импортировать все наборы данных, соответствующие указанным параметрам, которые могут иметь тип String, Number, Datetime и Pattern, в URI. Кроме того, теперь вы можете запускать задания преобразования Data Wrangler по расписанию.

В этом посте мы создаем пример потока с набором данных Titanic, чтобы показать, как вы можете начать экспериментировать с этими двумя новыми функциями Data Wrangler. Чтобы загрузить набор данных, см. «Титаник» — машинное обучение на основе катастроф.

Предпосылки

Чтобы получить все функции, описанные в этом посте, вам необходимо использовать последнюю версию ядра Data Wrangler. Для получения дополнительной информации см. Обновление обработчика данных. Кроме того, вам нужно запустить Студия Amazon SageMaker JupyterLab 3. Чтобы просмотреть текущую версию и обновить ее, см. Версии JupyterLab.

Файловая структура

Для этой демонстрации мы используем простую файловую структуру, которую вы должны реплицировать, чтобы воспроизвести шаги, описанные в этом посте.

- В студии, создать новый блокнот.

- Запустите следующий фрагмент кода, чтобы создать структуру папок, которую мы используем (убедитесь, что вы находитесь в нужной папке в дереве файлов):

- Скопируйте

train.csvиtest.csvфайлы из исходного набора данных Титаника в папкиtitanic_dataset/trainиtitanic_dataset/test, Соответственно. - Запустите следующий фрагмент кода, чтобы заполнить папки необходимыми файлами:

Мы разделили train.csv файл набора данных Титаника на девять разных файлов, названных part_x, где х - номер детали. Часть 0 содержит первые 100 записей, часть 1 — следующие 100 и так далее до части 8. Каждая папка узла дерева файлов содержит копию девяти частей обучающих данных, за исключением train и test папки, которые содержат train.csv и test.csv.

Параметризованные наборы данных

Пользователи Data Wrangler теперь могут указывать параметры для наборов данных, импортированных из Amazon S3. Параметры набора данных указываются в URI ресурса, и его значение может быть изменено динамически, что обеспечивает большую гибкость при выборе файлов, которые мы хотим импортировать. Параметры могут быть четырех типов данных:

- Номер регистрации - Может принимать значение любого целого числа

- строка - Может принимать значение любой текстовой строки

- шаблон - Может принимать значение любого регулярного выражения

- Datetime – Может принимать значение любого из поддерживаемых форматов даты/времени.

В этом разделе мы представляем пошаговое руководство по этой новой функции. Это доступно только после импорта набора данных в текущий поток и только для наборов данных, импортированных из Amazon S3.

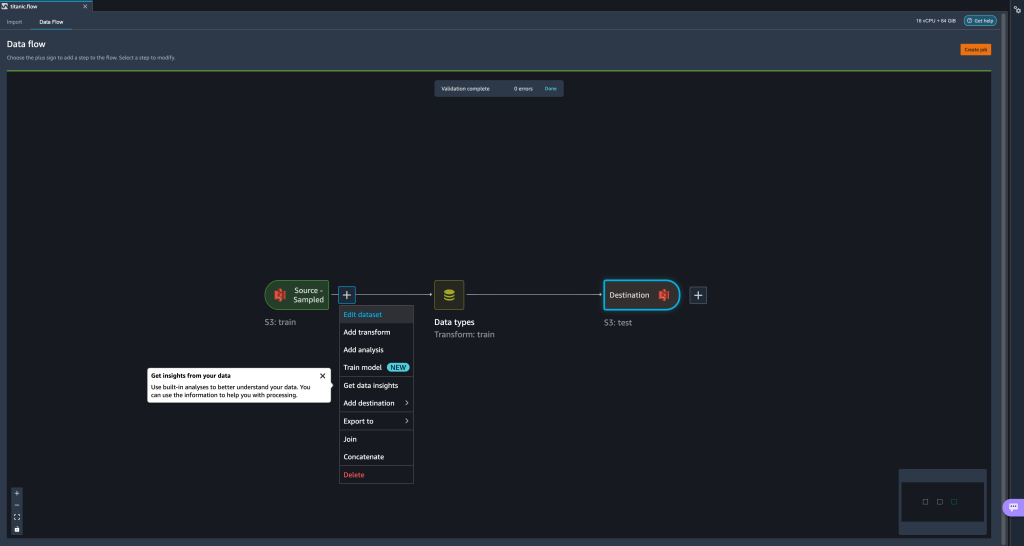

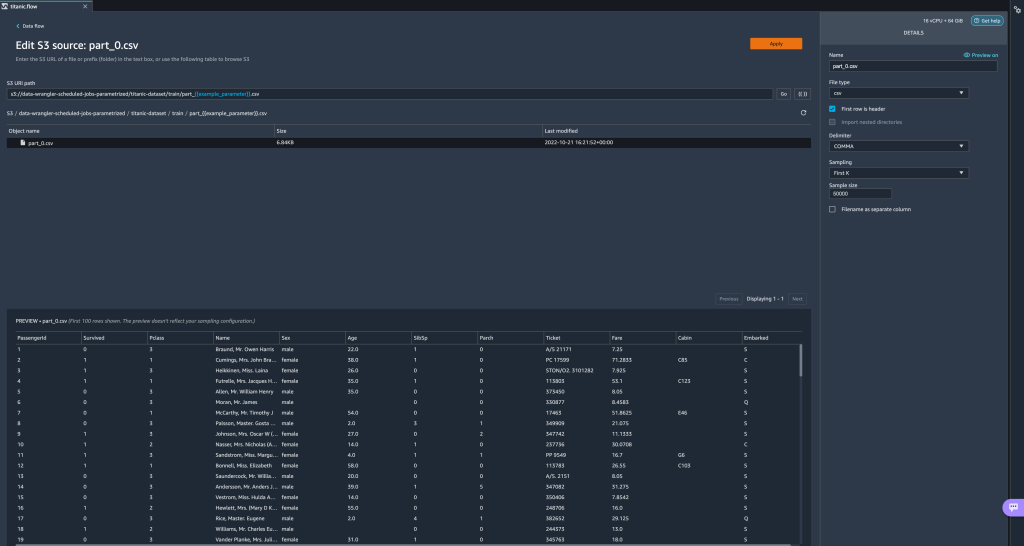

- В потоке данных выберите знак плюс (+) рядом с шагом импорта и выберите Изменить набор данных.

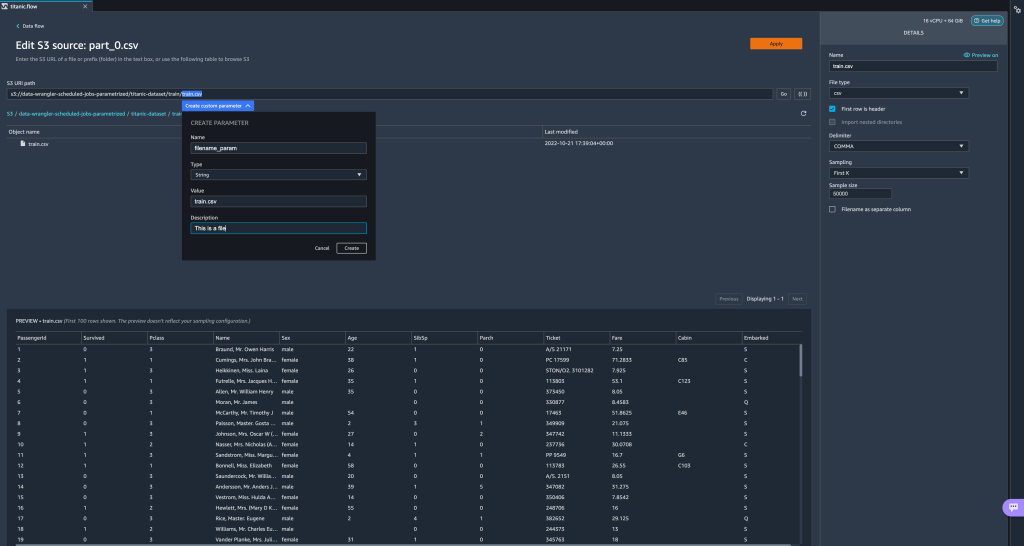

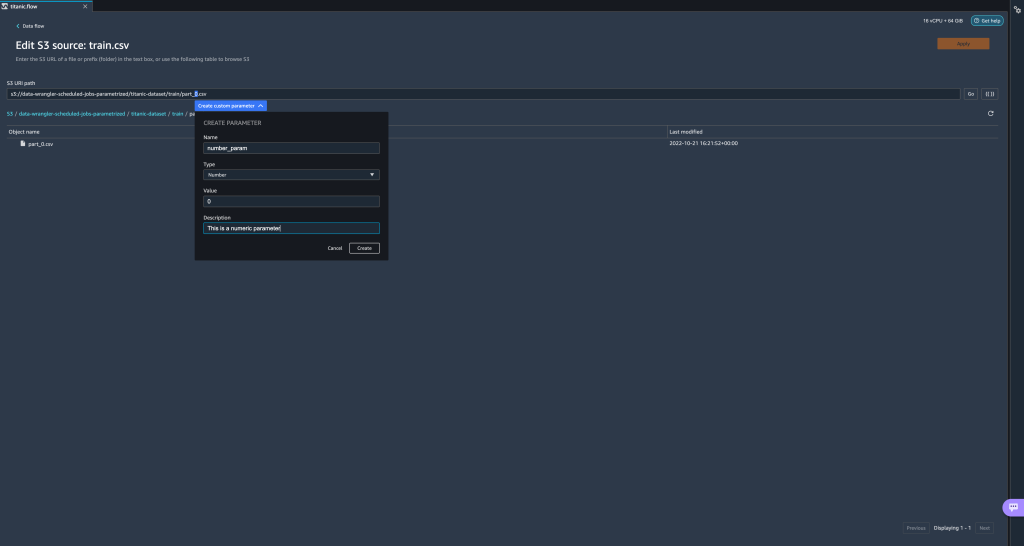

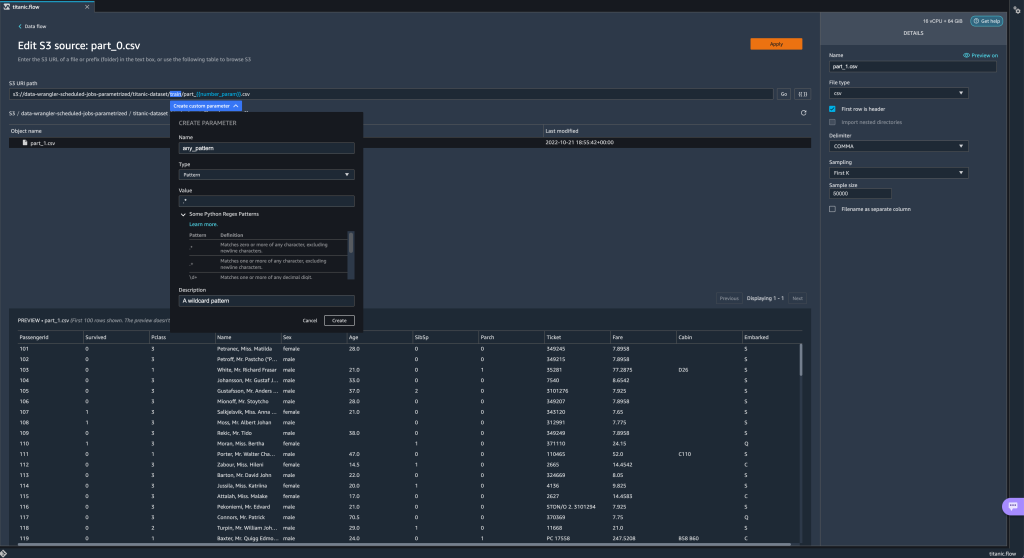

- Предпочтительный (и самый простой) способ создания новых параметров — выделение раздела вашего URI и выбор Создать специальный параметр в раскрывающемся меню. Вам нужно указать четыре вещи для каждого параметра, который вы хотите создать:

- Фамилия

- Тип

- Значение по умолчанию

- Описание

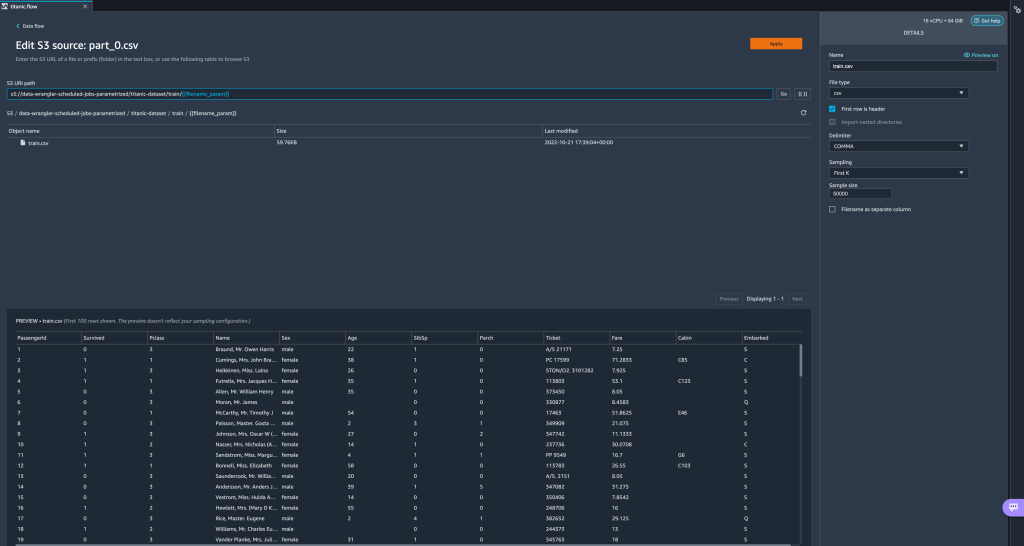

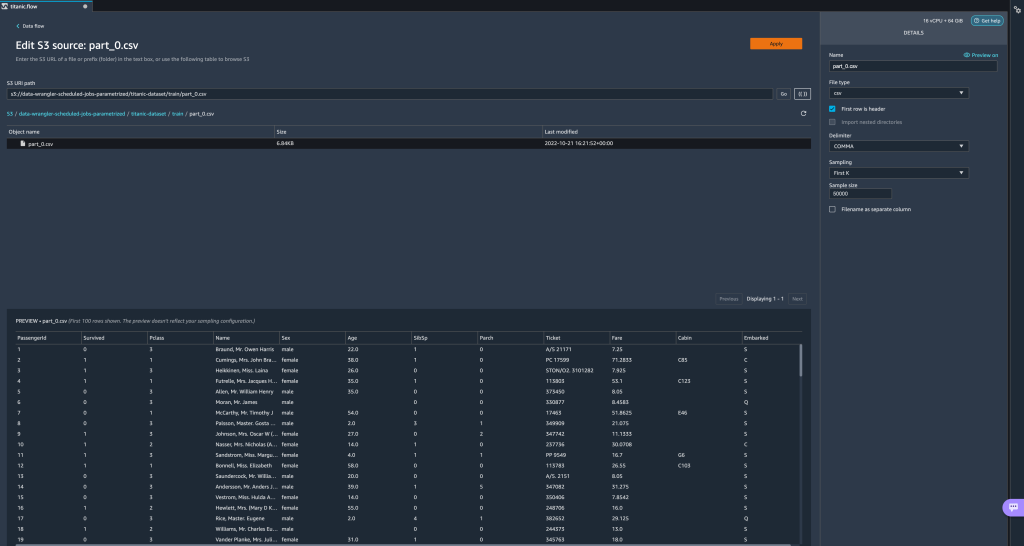

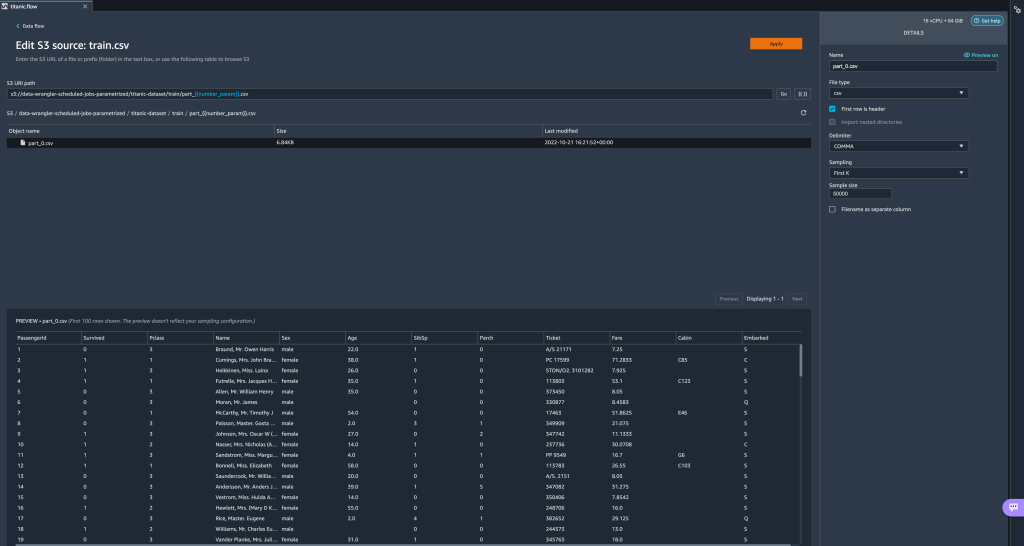

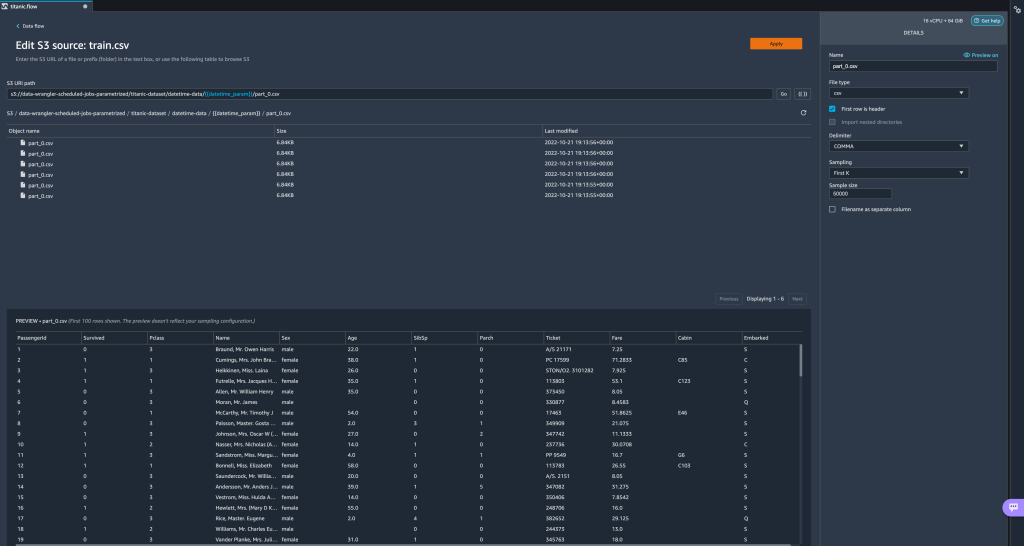

Здесь мы создали параметр типа String с именемfilename_paramсо значением по умолчаниюtrain.csv. Теперь вы можете видеть имя параметра, заключенное в двойные скобки, заменяя часть URI, которую мы ранее выделили. Поскольку определенное значение для этого параметра былоtrain.csv, теперь мы видим файлtrain.csvперечислены в таблице импорта.

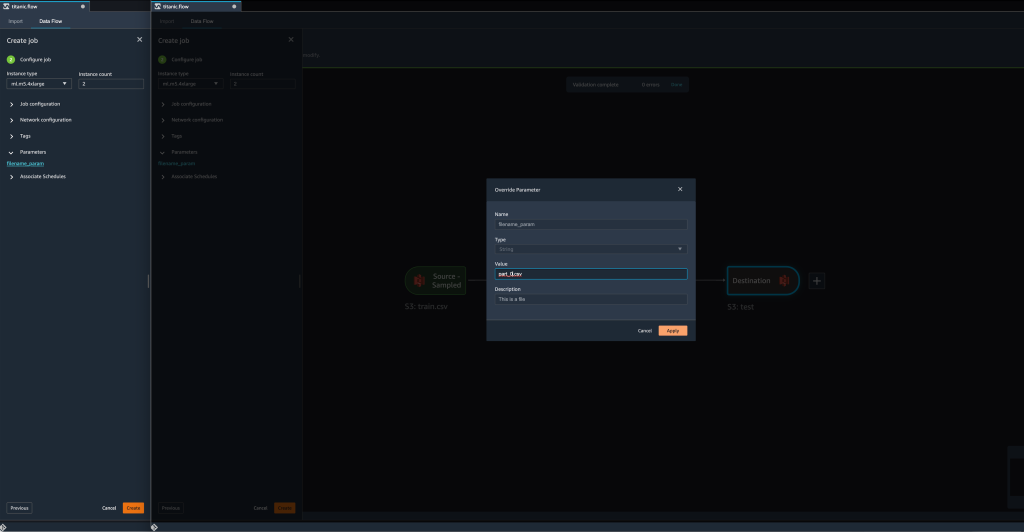

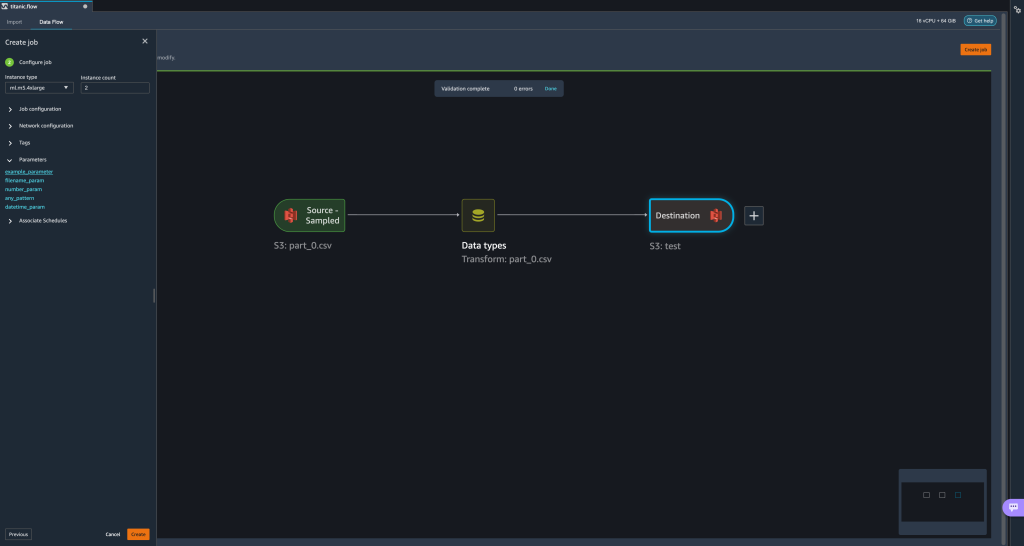

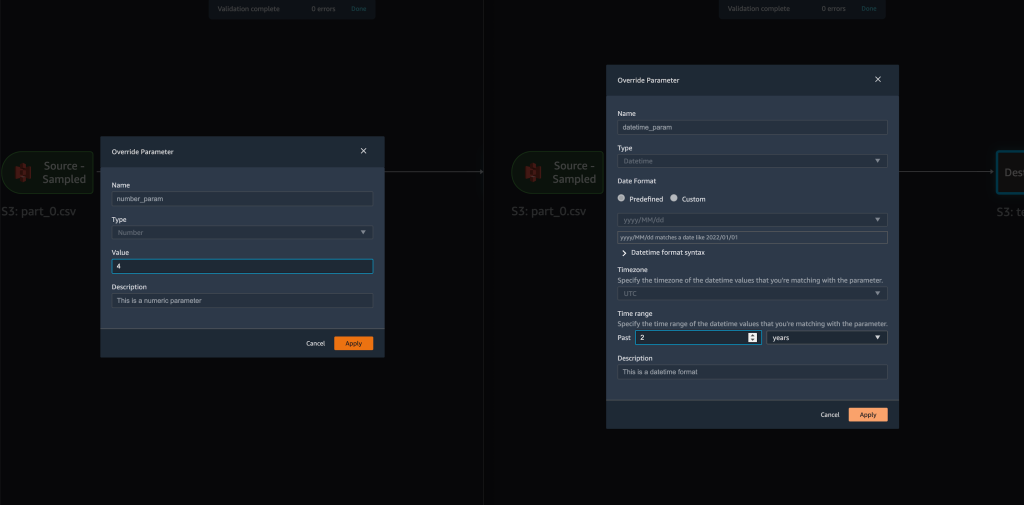

- Когда мы пытаемся создать задание преобразования, на Настроить задание шаг, теперь мы видим параметры раздел, где мы можем увидеть список всех наших определенных параметров.

- Выбор параметра дает нам возможность изменить значение параметра, в данном случае изменив набор входных данных для преобразования в соответствии с определенным потоком.

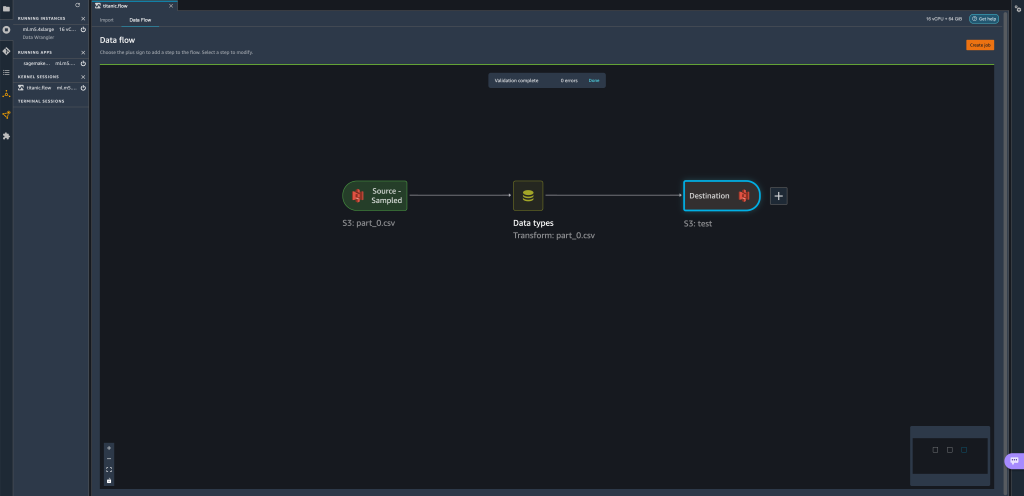

Предположим, что мы изменили значениеfilename_paramотtrain.csvвpart_0.csv, задание преобразования теперь занимаетpart_0.csv(при условии, что файл с именемpart_0.csvнаходится в той же папке), что и его новые входные данные.

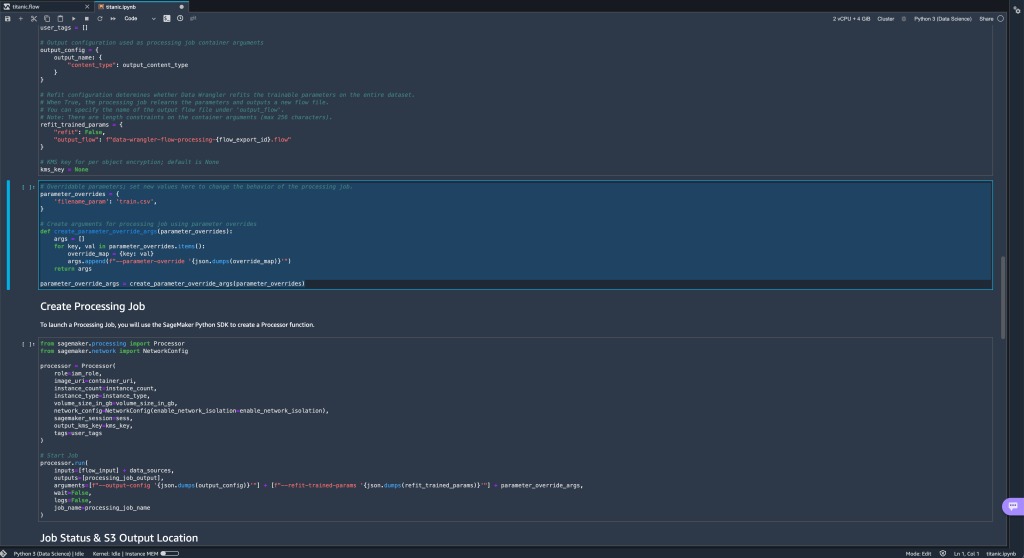

- Кроме того, если вы попытаетесь экспортировать свой поток в пункт назначения Amazon S3 (через блокнот Jupyter), вы увидите новую ячейку, содержащую определенные вами параметры.

Обратите внимание, что параметр принимает значение по умолчанию, но вы можете изменить его, заменив его значение вparameter_overridesсловарь (при этом ключи словаря оставляем без изменений).

Кроме того, вы можете создавать новые параметры из параметры UI. - Откройте его, выбрав значок параметров ({{}}) находится рядом с Go вариант; оба они расположены рядом со значением пути URI.

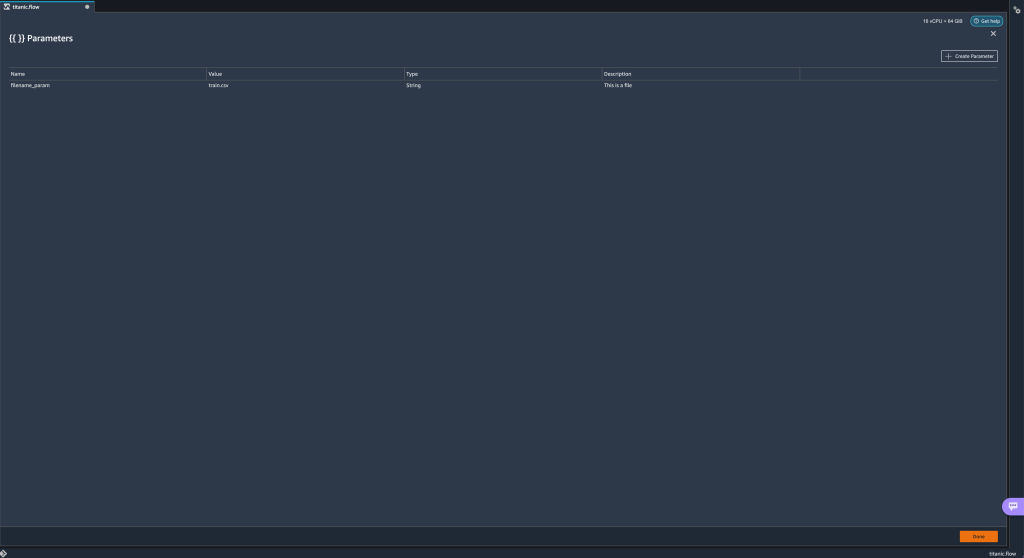

Откроется таблица со всеми параметрами, которые в настоящее время существуют в вашем файле потока (

Откроется таблица со всеми параметрами, которые в настоящее время существуют в вашем файле потока (filename_paramв этот момент). - Вы можете создать новые параметры для своего потока, выбрав Создать параметр.

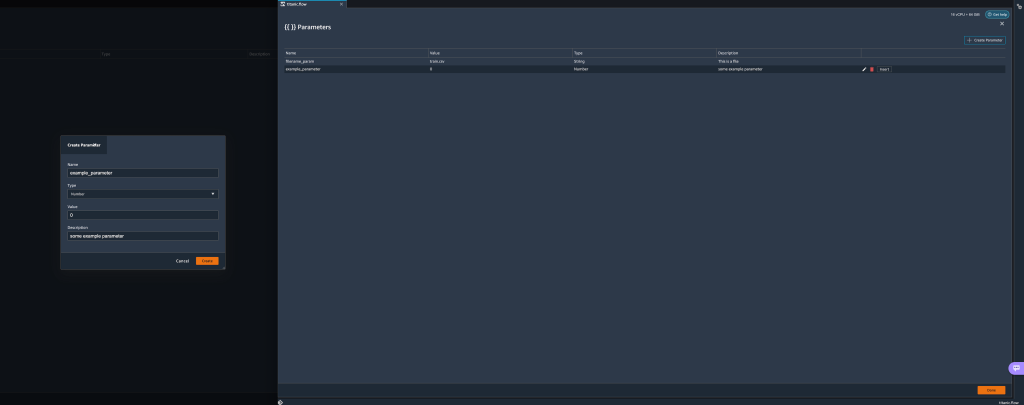

Откроется всплывающее окно, в котором можно создать новый настраиваемый параметр. - Здесь мы создали новый

example_parameterкак числовой тип со значением по умолчанию 0. Этот вновь созданный параметр теперь указан в параметры стол. При наведении курсора на параметр отображаются параметры Редактировать, Удалитьи Вставить.

- Изнутри параметры пользовательского интерфейса, вы можете вставить один из ваших параметров в URI, выбрав нужный параметр и выбрав Вставить.

Это добавит параметр в конец вашего URI. Вам нужно переместить его в нужный раздел вашего URI.

- Измените значение параметра по умолчанию, примените изменение (из модального), выберите Goи выберите значок обновления, чтобы обновить список предварительного просмотра, используя выбранный набор данных на основе вновь определенного значения параметра.

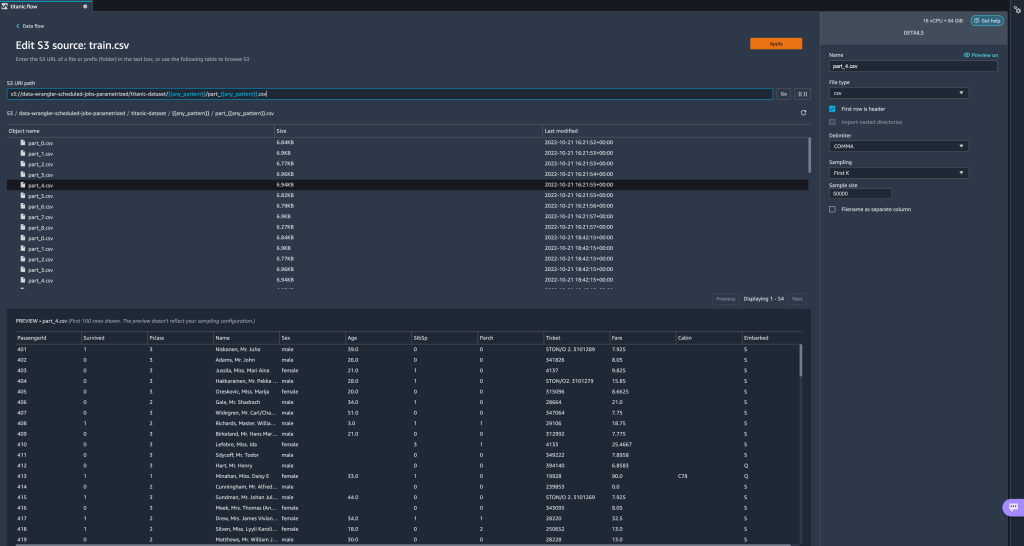

Давайте теперь рассмотрим другие типы параметров. Предположим, теперь у нас есть набор данных, разделенный на несколько частей, где каждый файл имеет номер части.

Давайте теперь рассмотрим другие типы параметров. Предположим, теперь у нас есть набор данных, разделенный на несколько частей, где каждый файл имеет номер части. - Если мы хотим динамически изменять номер файла, мы можем определить параметр Number, как показано на следующем снимке экрана.

Обратите внимание, что выбран файл, который соответствует номеру, указанному в параметре.

Обратите внимание, что выбран файл, который соответствует номеру, указанному в параметре. Теперь давайте продемонстрируем, как использовать параметр Pattern. Предположим, мы хотим импортировать все

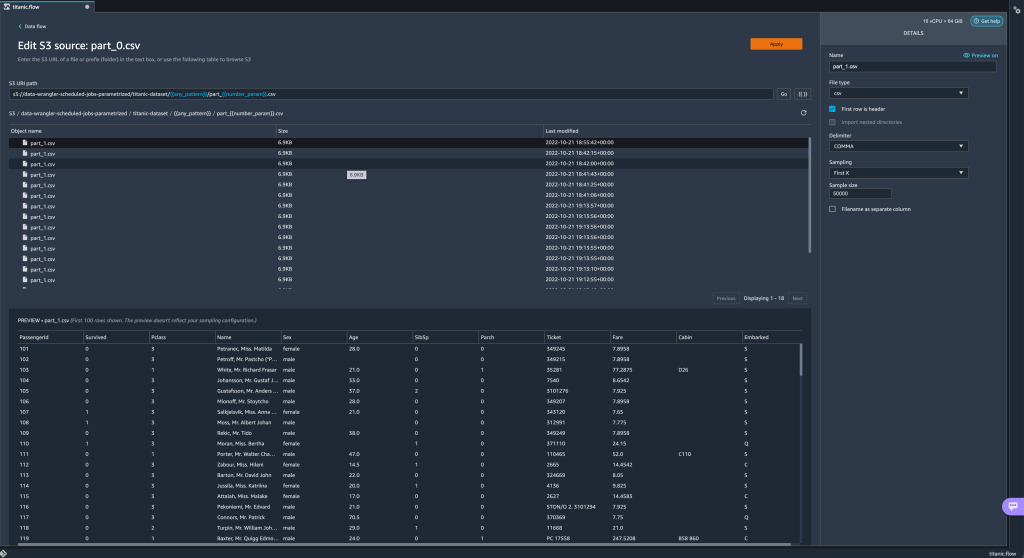

Теперь давайте продемонстрируем, как использовать параметр Pattern. Предположим, мы хотим импортировать все part_1.csvфайлы во всех папках подtitanic-dataset/папка. Параметры шаблона могут принимать любое допустимое регулярное выражение; в качестве примеров показаны некоторые шаблоны регулярных выражений. - Создайте параметр шаблона с именем

any_patternчтобы соответствовать любой папке или файлу вtitanic-dataset/папка со значением по умолчанию.*.Обратите внимание, что подстановочный знак — это не одна * (звездочка), а точка. - Выделить

titanic-dataset/часть пути и создайте настраиваемый параметр. На этот раз мы выбираем шаблон тип. Этот шаблон выбирает все файлы с именем

Этот шаблон выбирает все файлы с именем part-1.csvиз любой из папок вtitanic-dataset/. Параметр может использоваться более одного раза в пути. В следующем примере мы используем наш вновь созданный параметр

Параметр может использоваться более одного раза в пути. В следующем примере мы используем наш вновь созданный параметр any_patternдважды в нашем URI, чтобы соответствовать любому файлу детали в любой из папок вtitanic-dataset/. Наконец, давайте создадим параметр Datetime. Параметры даты и времени полезны, когда мы имеем дело с путями, разделенными по дате и времени, например, сгенерированными Пожарный шланг данных Amazon Kinesis (См. Динамическое секционирование в Kinesis Data Firehose). Для этой демонстрации мы используем данные из папки datetime-data.

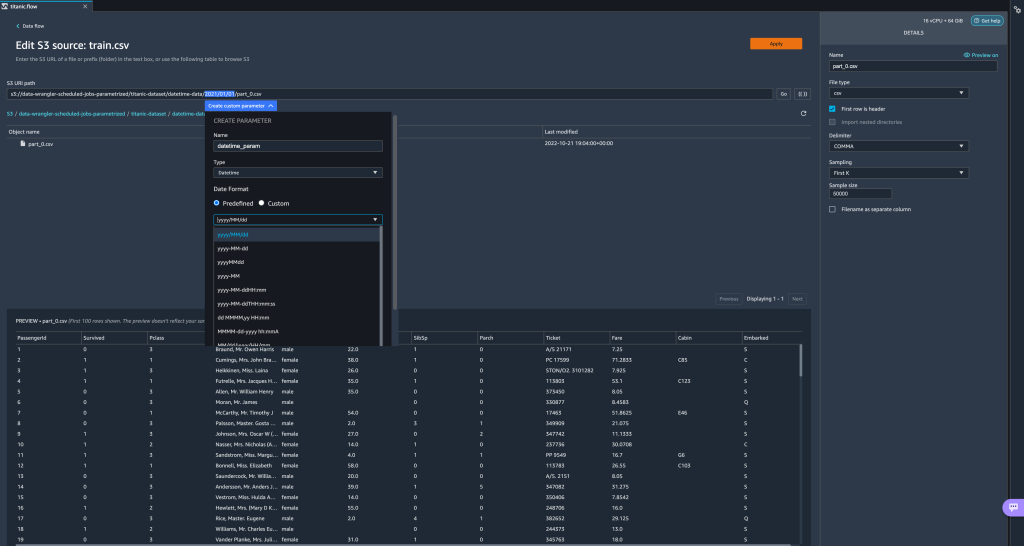

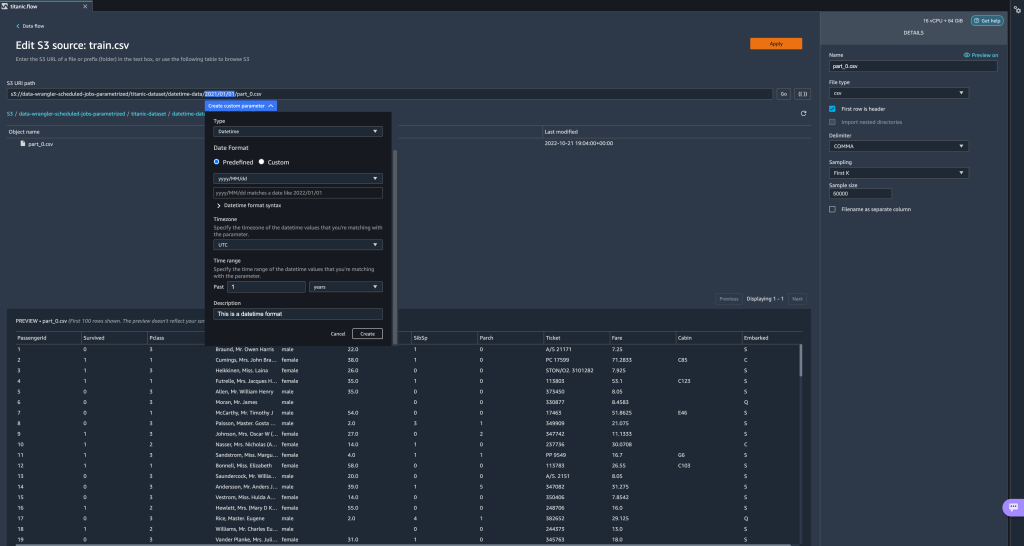

Наконец, давайте создадим параметр Datetime. Параметры даты и времени полезны, когда мы имеем дело с путями, разделенными по дате и времени, например, сгенерированными Пожарный шланг данных Amazon Kinesis (См. Динамическое секционирование в Kinesis Data Firehose). Для этой демонстрации мы используем данные из папки datetime-data. - Выберите часть вашего пути, которая является датой/временем, и создайте настраиваемый параметр. Выбрать Datetime тип параметра.

При выборе типа данных Datetime необходимо указать дополнительные сведения. - Прежде всего, вы должны указать формат даты. Вы можете выбрать любой из предопределенных форматов даты/времени или создать собственный.

Для предопределенных форматов даты/времени в легенде приводится пример даты, соответствующей выбранному формату. Для этой демонстрации мы выбираем формат гггг / ММ / дд.

- Затем укажите часовой пояс для значений даты/времени.

Например, текущая дата может быть 1 января 2022 года в одном часовом поясе, но может быть 2 января 2022 года в другом часовом поясе. - Наконец, вы можете выбрать временной диапазон, который позволяет выбрать диапазон файлов, которые вы хотите включить в свой поток данных.

Вы можете указать временной диапазон в часах, днях, неделях, месяцах или годах. Для этого примера мы хотим получить все файлы за последний год. - Введите описание параметра и выберите Создавай.

Если вы используете несколько наборов данных с разными часовыми поясами, время не преобразуется автоматически; вам необходимо предварительно обработать каждый файл или источник, чтобы преобразовать его в один часовой пояс. Выбранные файлы — это все файлы в папках, соответствующих прошлогодним данным.

Выбранные файлы — это все файлы в папках, соответствующих прошлогодним данным.

- Теперь, если мы создадим задание преобразования данных, мы сможем увидеть список всех определенных нами параметров и можем переопределить их значения по умолчанию, чтобы наши задания преобразования выбирали указанные файлы.

Расписание заданий обработки

Теперь вы можете запланировать задания обработки, чтобы автоматизировать выполнение заданий преобразования данных и экспорт преобразованных данных в Amazon S3 или Магазин функций Amazon SageMaker. Вы можете запланировать задания со временем и периодичностью, которые соответствуют вашим потребностям.

Использование запланированных заданий обработки Amazon EventBridge условиями, чтобы запланировать выполнение задания. Поэтому в качестве предварительного условия необходимо убедиться, что Управление идентификацией и доступом AWS (IAM), используемая Data Wrangler, а именно Создатель мудреца Амазонки роль исполнения экземпляра Studio имеет разрешения на создание правил EventBridge.

Настройка IAM

Внесите следующие обновления в роль исполнения IAM SageMaker, соответствующую экземпляру Studio, в котором запущен поток Data Wrangler:

- Прикрепите AmazonEventBridgeFullAccess управляемая политика.

- Прикрепите политику, чтобы предоставить разрешение на создание задания обработки:

- Предоставьте EventBridge разрешение на использование роли, добавив следующую политику доверия:

В качестве альтернативы, если вы используете другую роль для запуска задания обработки, примените политики, описанные в шагах 2 и 3, к этой роли. Для получения подробной информации о конфигурации IAM см. Создайте расписание для автоматической обработки новых данных.

Составьте расписание

Чтобы создать расписание, откройте поток в редакторе потоков Data Wrangler.

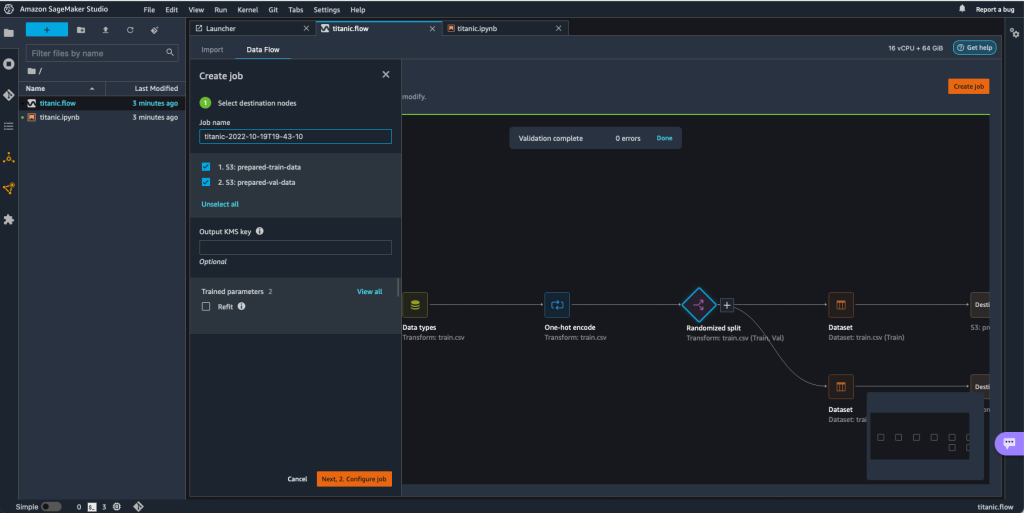

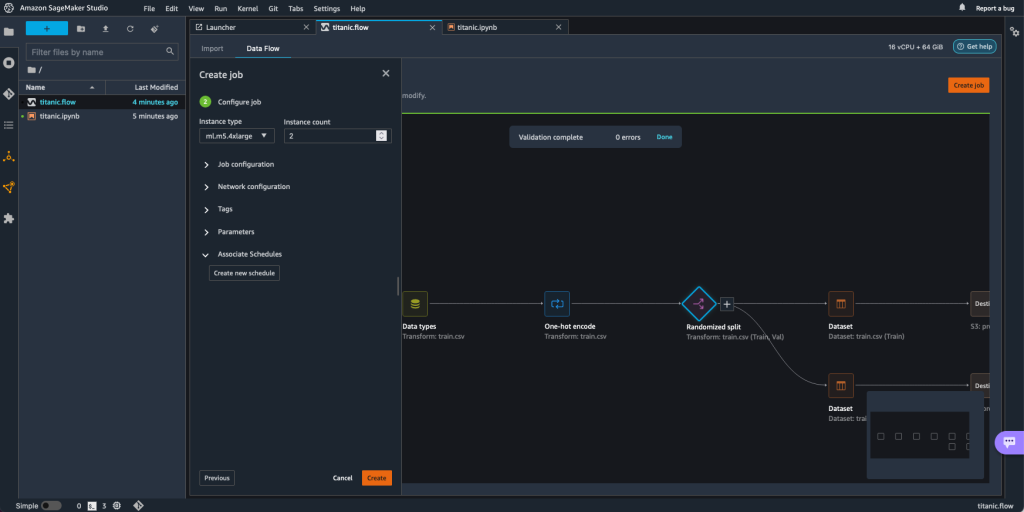

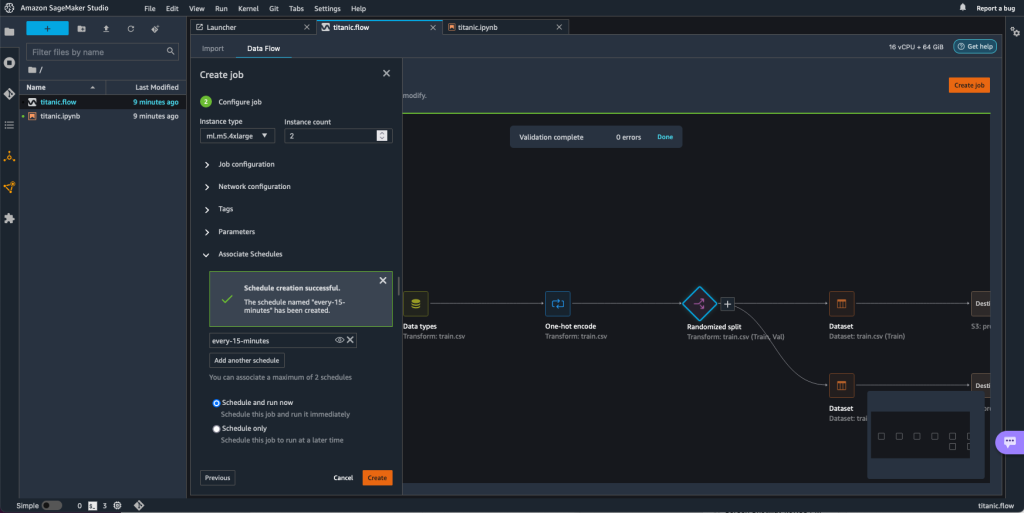

- На Поток данных , выберите Создать работу.

- Настройте необходимые поля и выберите Далее 2. Настройка задания.

- Расширьте Ассоциированные расписания.

- Выберите Создать новое расписание.

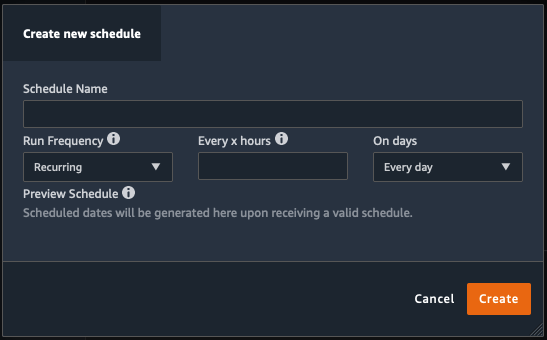

Ассоциация Создать новое расписание открывается диалоговое окно, в котором вы определяете подробности расписания задания обработки.

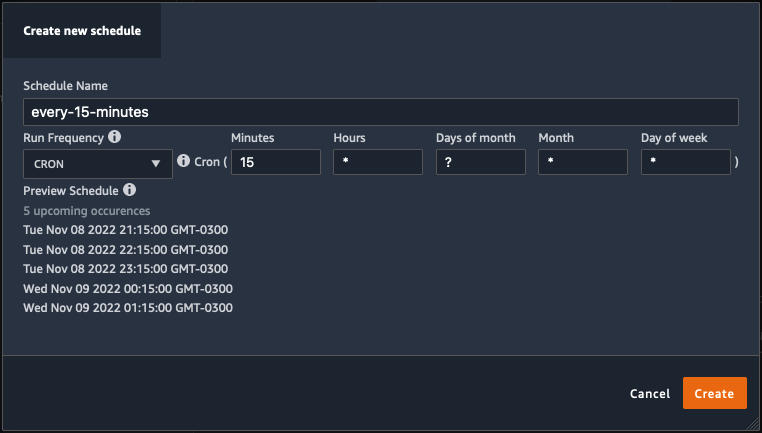

Диалог предлагает большую гибкость, чтобы помочь вам определить расписание. Например, задание обработки может выполняться в определенное время или каждые X часов в определенные дни недели.

Периодичность может быть гранулирована до минут.

- Определите имя расписания и периодичность, затем выберите Создавай чтобы сохранить расписание.

- У вас есть возможность сразу же запустить задание обработки вместе с планированием, которое позаботится о будущих запусках, или оставить задание выполняться только в соответствии с расписанием.

- Вы также можете определить дополнительное расписание для того же задания обработки.

- Чтобы завершить расписание задания обработки, выберите Создавай.

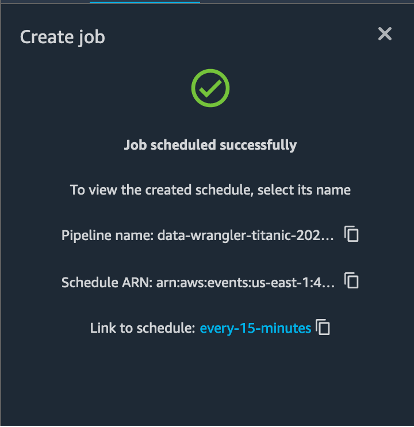

Вы видите сообщение «Задание запланировано успешно». Кроме того, если вы решили оставить задание для выполнения только по расписанию, вы увидите ссылку на только что созданное правило EventBridge.

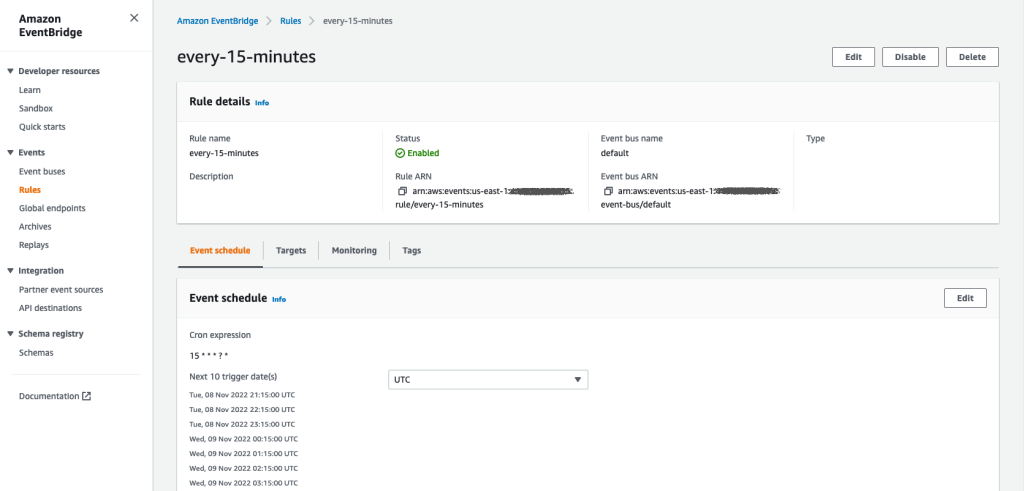

Если вы выберете ссылку расписания, в браузере откроется новая вкладка с правилом EventBridge. На этой странице вы можете вносить дополнительные изменения в правило и отслеживать историю его вызовов. Чтобы остановить выполнение запланированного задания обработки, удалите правило событий, содержащее имя расписания.

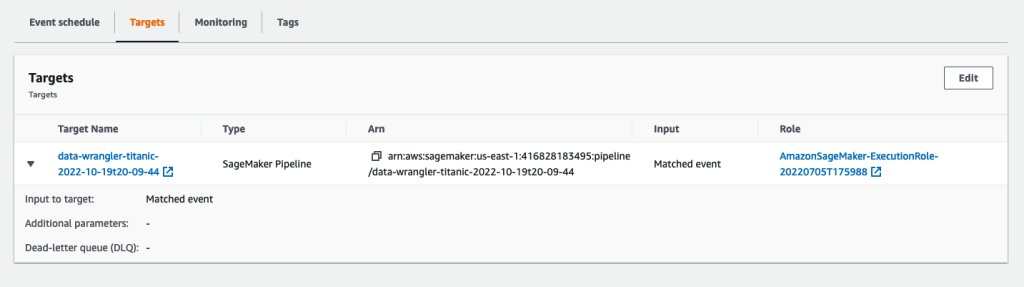

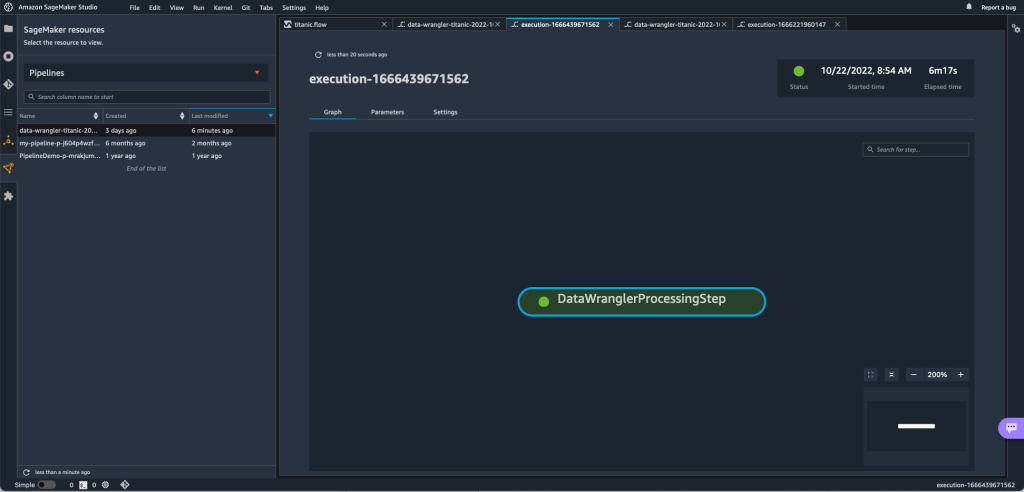

Правило EventBridge показывает в качестве цели конвейер SageMaker, который запускается в соответствии с заданным расписанием, а задание обработки вызывается как часть конвейера.

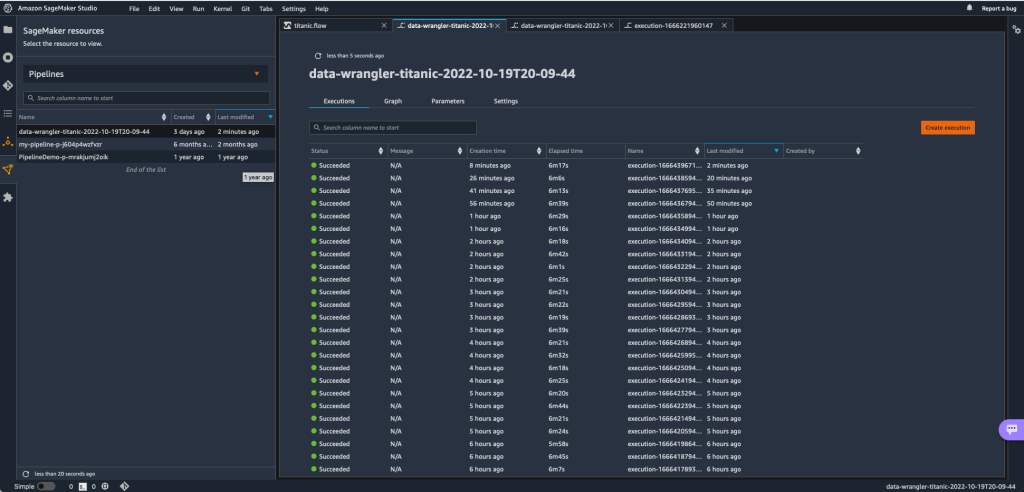

Чтобы отслеживать выполнение конвейера SageMaker, вы можете вернуться в Studio, выбрать Ресурсы SageMaker значок, выберите Трубопроводыи выберите имя конвейера, который вы хотите отслеживать. Теперь вы можете увидеть таблицу со всеми текущими и прошлыми запусками и состоянием этого конвейера.

Вы можете просмотреть дополнительные сведения, дважды щелкнув определенную запись.

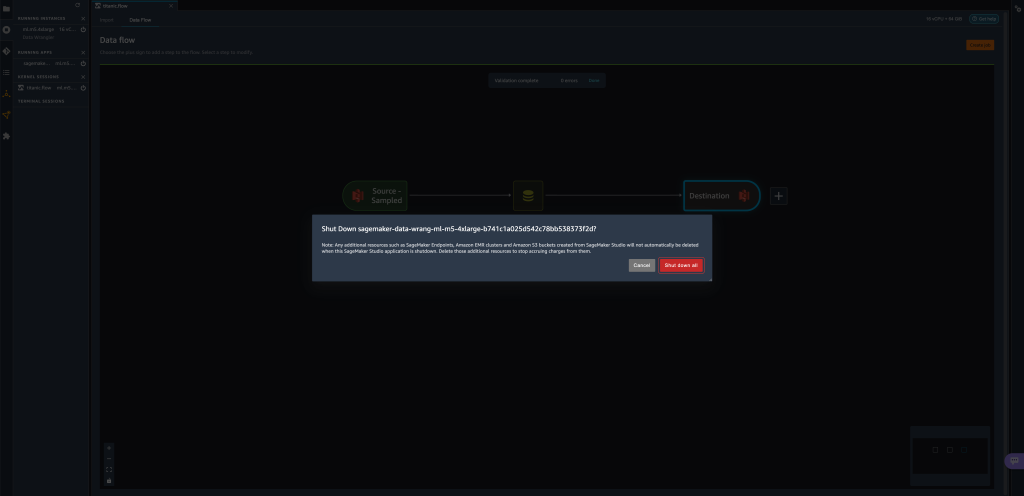

Убирать

Если вы не используете Data Wrangler, рекомендуется закрыть экземпляр, на котором он работает, чтобы избежать дополнительных сборов.

Чтобы не потерять работу, сохраните поток данных перед закрытием Data Wrangler.

- Чтобы сохранить поток данных в Studio, выберите Файл, а затем выберите Сохранить поток данных Wrangler. Data Wrangler автоматически сохраняет ваш поток данных каждые 60 секунд.

- Чтобы закрыть экземпляр Data Wrangler, в Studio выберите Запуск экземпляров и ядер.

- Под ЗАПУСК ПРИЛОЖЕНИЙ, выберите значок выключения рядом с

sagemaker-data-wrangler-1.0приложение

- Выберите Выключи все , чтобы подтвердить действие.

Data Wrangler работает на экземпляре ml.m5.4xlarge. Этот экземпляр исчезает из ЗАПУСК ИНСТАНСОВ когда вы закрываете приложение Data Wrangler.

После закрытия приложения Data Wrangler его необходимо перезапустить при следующем открытии файла потока Data Wrangler. Это может занять несколько минут.

Заключение

В этом посте мы продемонстрировали, как вы можете использовать параметры для импорта наборов данных с помощью потоков Data Wrangler и создания для них заданий преобразования данных. Параметризованные наборы данных обеспечивают большую гибкость используемых наборов данных и позволяют повторно использовать потоки. Мы также продемонстрировали, как можно настраивать запланированные задания для автоматизации преобразования и экспорта данных в Amazon S3 или Feature Store в нужное время и с периодичностью непосредственно из пользовательского интерфейса Data Wrangler.

Чтобы узнать больше об использовании потоков данных с Data Wrangler, см. Создание и использование потока обработчика данных и Цены на Amazon SageMaker. Чтобы начать работу с Data Wrangler, см. Подготовка данных машинного обучения с помощью Amazon SageMaker Data Wrangler.

Об авторах

Дэвид Ларедо является архитектором прототипов в группе прототипирования и облачной инженерии в Amazon Web Services, где он помог разработать несколько прототипов машинного обучения для клиентов AWS. Последние 6 лет он занимается машинным обучением, обучает и настраивает модели машинного обучения, а также внедряет сквозные конвейеры для производства этих моделей. В сферу его интересов входят НЛП, приложения машинного обучения и сквозное машинное обучение.

Дэвид Ларедо является архитектором прототипов в группе прототипирования и облачной инженерии в Amazon Web Services, где он помог разработать несколько прототипов машинного обучения для клиентов AWS. Последние 6 лет он занимается машинным обучением, обучает и настраивает модели машинного обучения, а также внедряет сквозные конвейеры для производства этих моделей. В сферу его интересов входят НЛП, приложения машинного обучения и сквозное машинное обучение.

Дживанильдо Алвес является архитектором прототипов в группе прототипирования и облачной инженерии в Amazon Web Services, помогая клиентам внедрять инновации и ускоряться, демонстрируя искусство возможного на AWS, уже внедрив несколько прототипов на основе искусственного интеллекта. У него долгая карьера в области разработки программного обеспечения, а ранее он работал инженером по разработке программного обеспечения в Amazon.com.br.

Дживанильдо Алвес является архитектором прототипов в группе прототипирования и облачной инженерии в Amazon Web Services, помогая клиентам внедрять инновации и ускоряться, демонстрируя искусство возможного на AWS, уже внедрив несколько прототипов на основе искусственного интеллекта. У него долгая карьера в области разработки программного обеспечения, а ранее он работал инженером по разработке программного обеспечения в Amazon.com.br.

Адриан Фуэнтес является менеджером программы в команде прототипирования и облачной инженерии в Amazon Web Services, предлагая клиентам инновации в области машинного обучения, Интернета вещей и блокчейна. У него более 15 лет опыта управления и реализации проектов и 1 год работы в AWS.

Адриан Фуэнтес является менеджером программы в команде прототипирования и облачной инженерии в Amazon Web Services, предлагая клиентам инновации в области машинного обучения, Интернета вещей и блокчейна. У него более 15 лет опыта управления и реализации проектов и 1 год работы в AWS.

- AI

- ай искусство

- генератор искусств ай

- искусственный интеллект

- Амазонское машинное обучение

- Обработчик данных Amazon SageMaker

- Объявления

- искусственный интеллект

- сертификация искусственного интеллекта

- искусственный интеллект в банковском деле

- робот с искусственным интеллектом

- роботы с искусственным интеллектом

- программное обеспечение искусственного интеллекта

- Машинное обучение AWS

- блокчейн

- конференция по блокчейну

- Coingenius

- разговорный искусственный интеллект

- криптоконференция ИИ

- дал-и

- обработка данных

- глубокое обучение

- google ai

- Средний (200)

- обучение с помощью машины

- Параметризованные наборы данных

- Платон

- Платон Ай

- Платон Интеллектуальные данные

- Платон игра

- ПлатонДанные

- платогейминг

- масштаб ай

- Запланированные задания

- синтаксис

- Технические инструкции

- зефирнет