Когда вы читаете такое предложение, ваш прошлый опыт говорит вам, что оно написано мыслящим, чувствующим человеком. И в этом случае действительно есть человек, печатающий эти слова: [Привет!]. Но в наши дни некоторые предложения, которые кажутся удивительно человеческими, на самом деле генерируются искусственный интеллект системы, обученные на большом количестве человеческого текста.

Люди так привыкли считать, что свободно язык исходит из думающего, чувствующего человека, что доказательство обратного может быть трудно уложить в голове. Как люди могут перемещаться по этой относительно неизведанной территории? Из-за устойчивой тенденции ассоциировать беглое выражение с беглым мышлением естественно — но потенциально ошибочно — думать, что если модель ИИ может свободно выражать себя, это означает, что она думает и чувствует точно так же, как люди.

Таким образом, неудивительно, что бывший инженер Google недавно заявил, что система искусственного интеллекта Google LaMDA обладает самоощущением, потому что она может красноречиво генерировать текст о своих предполагаемых чувствах. Это событие и последующее освещение в СМИ привело к номер справедливо скептически статьи и сообщений об утверждении, что вычислительные модели человеческого языка разумны, то есть способны думать, чувствовать и переживать.

Вопрос о том, что значит для модели ИИ быть разумной, сложен (см., например, мнение нашего коллеги), и наша цель здесь не в том, чтобы урегулировать его. Но, как язык исследователи, мы можем использовать нашу работу в когнитивной науке и лингвистике, чтобы объяснить, почему людям слишком легко попасть в когнитивную ловушку, думая, что сущность, которая может свободно использовать язык, является разумной, сознательной или разумной.

Использование ИИ для создания человекоподобного языка

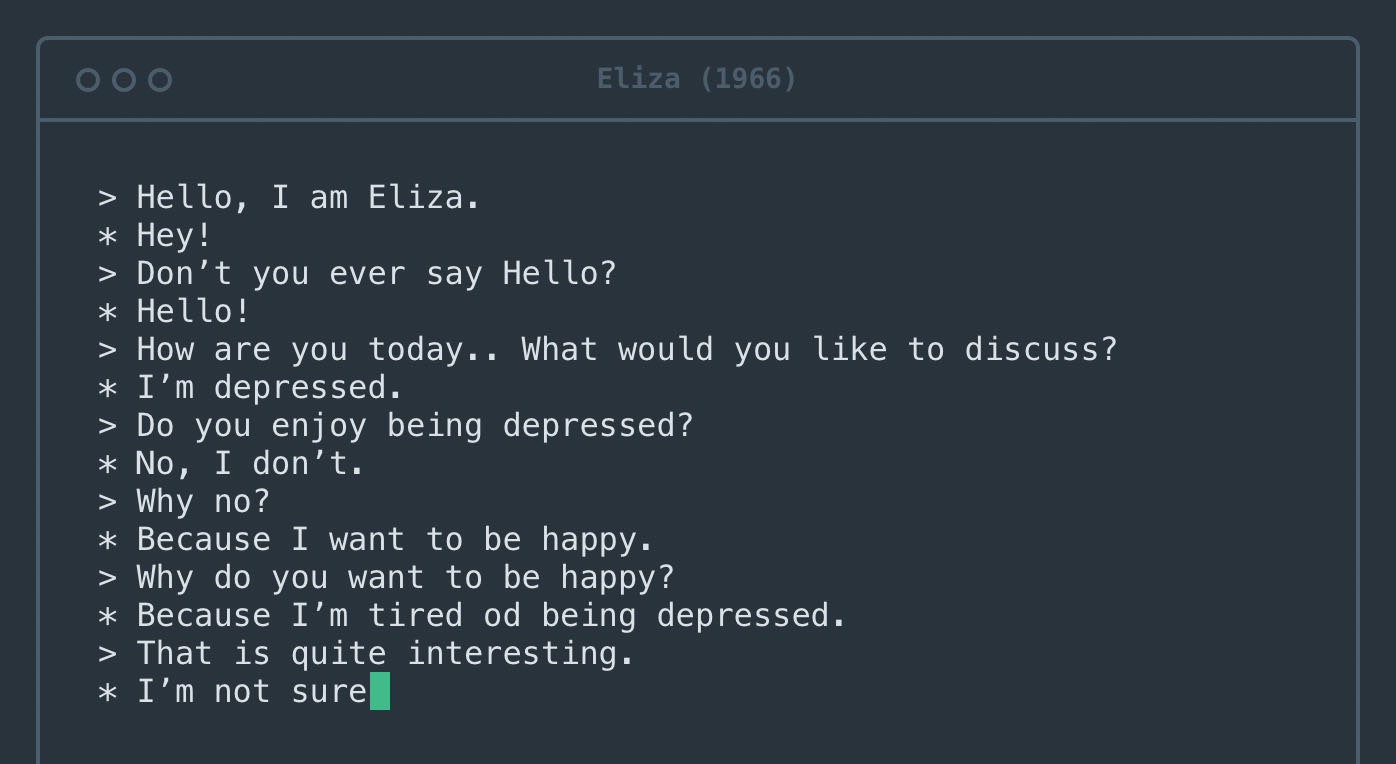

Текст, сгенерированный такими моделями, как Google LaMDA, трудно отличить от текста, написанного людьми. Это впечатляющее достижение является результатом многолетней программы по созданию моделей, генерирующих грамматически осмысленный язык.

Ранние версии, датируемые по крайней мере 1950-ми годами, известные как модели n-грамм, просто подсчитывали вхождения определенных фраз и использовали их, чтобы угадать, какие слова могут встречаться в определенных контекстах. Например, легко понять, что фраза «арахисовое масло и желе» более вероятна, чем «арахисовое масло и ананасы». Если у вас достаточно английского текста, вы будете снова и снова встречать фразу «арахисовое масло и желе», но никогда не увидите фразу «арахисовое масло и ананасы».

Сегодняшние модели, наборы данных и правила, приближающие человеческий язык, отличаются от этих ранних попыток несколькими важными моментами. Во-первых, они обучены практически всему интернету. Во-вторых, они могут изучать отношения между словами, которые находятся далеко друг от друга, а не только слова, которые являются соседями. В-третьих, они настраиваются с помощью огромного количества внутренних «ручек» — их так много, что даже инженерам, которые их проектируют, трудно понять, почему они генерируют одну последовательность слов, а не другую.

Однако задача моделей остается той же, что и в 1950-х годах: определить, какое слово, скорее всего, будет следующим. Сегодня они так хорошо справляются с этой задачей, что почти все предложения, которые они генерируют, кажутся плавными и грамматическими.

Арахисовое масло и ананасы?

Мы попросили большую языковую модель, GPT-3, чтобы закончить предложение «Арахисовое масло и ананасы___». В нем говорилось: «Арахисовое масло и ананасы — отличное сочетание. Сладкие и пикантные вкусы арахисового масла и ананаса идеально дополняют друг друга». Если бы человек сказал это, можно было бы сделать вывод, что он пробовал вместе арахисовое масло и ананас, составил мнение и поделился им с читателем.

Но как GPT-3 придумал этот абзац? Создавая слово, которое соответствует контексту, который мы предоставили. А потом еще один. А потом еще один. Модель никогда не видела, не трогала и не пробовала ананасы — она просто обработала все тексты в Интернете, в которых они упоминаются. И все же чтение этого абзаца может заставить человеческий разум — даже инженера Google — вообразить GPT-3 как разумное существо, которое может рассуждать об арахисовом масле и блюдах из ананасов.

Человеческий мозг запрограммирован на то, чтобы делать выводы о намерениях, стоящих за словами. Каждый раз, когда вы участвуете в разговоре, ваш разум автоматически создает ментальную модель вашего собеседника. Затем вы используете слова, которые они говорят, чтобы заполнить модель целями, чувствами и убеждениями этого человека.

Процесс перехода от слов к ментальной модели не вызывает затруднений и запускается каждый раз, когда вы получаете полноценное предложение. Этот когнитивный процесс экономит вам много времени и усилий в повседневной жизни, значительно облегчая ваше социальное взаимодействие.

Однако в случае с системами ИИ он дает осечку, создавая ментальную модель из воздуха.

Немного больше исследований может выявить серьезность этой осечки. Рассмотрим следующую подсказку: «Арахисовое масло и перья прекрасно сочетаются друг с другом, потому что___». GPT-3 продолжил: «Арахисовое масло и перья имеют прекрасный вкус вместе, потому что они оба имеют ореховый вкус. Арахисовое масло также гладкое и кремообразное, что помогает компенсировать текстуру пера».

Текст в этом случае такой же беглый, как и в нашем примере с ананасами, но на этот раз модель говорит что-то явно менее осмысленное. Начинаешь подозревать, что GPT-3 на самом деле никогда не пробовал арахисовое масло и перья.

Приписывая интеллект машинам, отрицая его людям

Печальная ирония заключается в том, что та же когнитивная предвзятость, которая заставляет людей приписывать человечность GPT-3, может заставить их обращаться с реальными людьми негуманным образом. Социокультурная лингвистика — изучение языка в его социальном и культурном контексте — показывает, что предположение о слишком тесной связи между беглым выражением и беглым мышлением может привести к предвзятому отношению к людям, говорящим иначе.

Например, люди с иностранным акцентом часто воспринимается как менее умный и имеют меньше шансов получить работу, для которой они квалифицированы. Подобные предубеждения существуют против носители диалектов которые не считаются престижными, например, южноанглийский в США против глухие люди, использующие языки жестов, и против людей с дефектами речи например, заикание.

Эти предубеждения очень вредны, часто приводят к расистским и сексистским предположениям, и снова и снова доказывается их необоснованность.

Свободное владение языком само по себе не означает человечность

Станет ли когда-нибудь ИИ разумным? Этот вопрос требует глубокого рассмотрения, и философы действительно обдумывал it на протяжении десятилетий. Однако исследователи установили, что вы не можете просто доверять языковой модели, когда она говорит вам о своих ощущениях. Слова могут ввести в заблуждение, и очень легко спутать беглую речь с беглой мыслью.![]()

Эта статья переиздана из Беседа под лицензией Creative Commons. Прочтите оригинал статьи.

Изображение Фото: Танча/Shutterstock.com

- Коинсмарт. Лучшая в Европе биржа биткойнов и криптовалют.

- Платоблокчейн. Интеллект метавселенной Web3. Расширение знаний. БЕСПЛАТНЫЙ ДОСТУП.

- КриптоХок. Альткоин Радар. Бесплатная пробная версия.

- Источник: https://singularityhub.com/2022/06/30/googles-ai-spotlights-a-human-cognitive-glitch-mistake-fluent-speech-for-fluent- Thought/

- "

- a

- О нас

- продвинутый

- против

- AI

- Все

- суммы

- Другой

- кроме

- появиться

- около

- гайд

- Юрист

- автоматически

- фон

- , так как:

- становиться

- за

- не являетесь

- ниже

- между

- граница

- Мозг

- строить

- Строительство

- способный

- случаев

- Вызывать

- века

- утверждать

- код

- познавательный

- собирать

- сочетание

- как

- комплемент

- полный

- компьютер

- Рассматривать

- рассмотрение

- контексты

- Разговор

- творческий

- кредит

- данным

- Знакомства

- Дней

- глубоко

- Проект

- Определять

- DID

- отличаться

- трудный

- каждый

- Рано

- усилие

- заниматься

- инженер

- Инженеры

- Английский

- организация

- по существу

- События

- повседневный

- пример

- опыт

- испытывающих

- First

- соответствовать

- после

- иностранный

- от

- порождать

- генерируется

- порождающий

- получающий

- Сбой

- цель

- Цели

- хорошо

- большой

- значительно

- помогает

- здесь

- Как

- Однако

- HTTPS

- огромный

- человек

- Человечество

- Людей

- изображение

- важную

- впечатляющий

- info

- пример

- Интеллекта

- Умный

- Интернет

- IT

- саму трезвость

- Джобс

- Знать

- известный

- язык

- большой

- вести

- УЧИТЬСЯ

- привело

- Лицензия

- Вероятно

- LINK

- мало

- Продукция

- ДЕЛАЕТ

- массивный

- смысл

- значимым

- означает

- Медиа

- психический

- может быть

- против

- модель

- Модели

- БОЛЕЕ

- Откройте

- следующий

- номер

- смещение

- Обзор

- Другое

- особый

- партнер

- Люди

- возможно

- человек

- личного

- личные данные

- фразы

- пожалуйста

- престижный

- процесс

- FitPartner™

- при условии

- квалифицированный

- вопрос

- читатель

- Reading

- Получать

- недавно

- Отношения

- остатки

- требуется

- исследователи

- условиями,

- Сказал

- то же

- Наука

- бесшовные

- смысл

- несколько

- общие

- показанный

- Shutterstock

- подпись

- аналогичный

- So

- Соцсети

- Software

- некоторые

- удалось

- южный

- говорить

- динамики

- конкретный

- Кабинет

- сладкий

- система

- системы

- говорит

- Ассоциация

- мышление

- время

- сегодня

- вместе

- лечить

- срабатывает

- Доверие

- понимать

- us

- использование

- способы

- Что

- КТО

- слова

- Работа

- бы

- ВАШЕ

- YouTube