Это гостевой пост, написанный в соавторстве Рамой Бадринатхом, Диваем Джиндалом и Уткаршем Агравалом из Meesho.

Мишо — самая быстрорастущая компания электронной коммерции в Индии, миссией которой является демократизация интернет-торговли для всех и сделать ее доступной для следующего миллиарда пользователей Индии. Meesho была основана в 2015 году и сегодня ориентирована на покупателей и продавцов по всей Индии. Торговая площадка Meesho предоставляет микро-, малому и среднему бизнесу и индивидуальным предпринимателям доступ к миллионам клиентов, выбор из более чем 30 категорий и более 900 подкатегорий, общеиндийскую логистику, платежные услуги и возможности поддержки клиентов для эффективного ведения бизнеса. бизнеса в экосистеме Meesho.

Как платформа электронной коммерции, Meesho стремится улучшить взаимодействие с пользователем, предлагая персонализированные и актуальные рекомендации по продуктам. Мы хотели создать обобщенную систему ранжирования каналов, которая учитывает индивидуальные предпочтения и историческое поведение, чтобы эффективно отображать продукты в ленте каждого пользователя. Благодаря этому мы хотели повысить вовлеченность пользователей, коэффициенты конверсии и общий рост бизнеса, адаптируя опыт покупок к уникальным требованиям каждого клиента и обеспечивая наилучшее соотношение цены и качества.

Мы использовали сервисы машинного обучения (ML) AWS, такие как Создатель мудреца Амазонки разработать мощный универсальный механизм ранжирования кормов (GFR). В этом посте мы обсуждаем ключевые компоненты GFR и то, как это решение на основе машинного обучения упростило жизненный цикл машинного обучения, обеспечив эффективное управление инфраструктурой, масштабируемость и надежность в экосистеме.

Обзор решения

Чтобы персонализировать каналы пользователей, мы проанализировали обширные исторические данные, извлекая информацию о функциях, включая модели просмотра и интересы. Эти ценные функции используются для построения моделей ранжирования. GFR персонализирует ленту каждого пользователя в режиме реального времени, учитывая различные факторы, такие как география, предыдущие модели покупок, каналы привлечения и многое другое. Некоторые функции, основанные на взаимодействии, также используются для определения привязанности пользователя к товару, категории товара или свойствам товара, таким как цена, рейтинг или скидка.

Также используются некоторые независимые от пользователя функции и оценки на уровне элемента. К ним относятся показатель популярности предмета и показатель склонности к покупке предмета. Все эти функции используются в качестве входных данных для модели обучения ранжированию (LTR), которая пытается определить вероятность клика (PCTR) и вероятность покупки (PCVR).

Для получения разнообразных и актуальных рекомендаций GFR выбирает продукты-кандидаты из нескольких каналов, включая эксплойты (известные предпочтения пользователей), исследования (новые и потенциально интересные продукты), популярность (трендовые элементы) и недавние (последние дополнения).

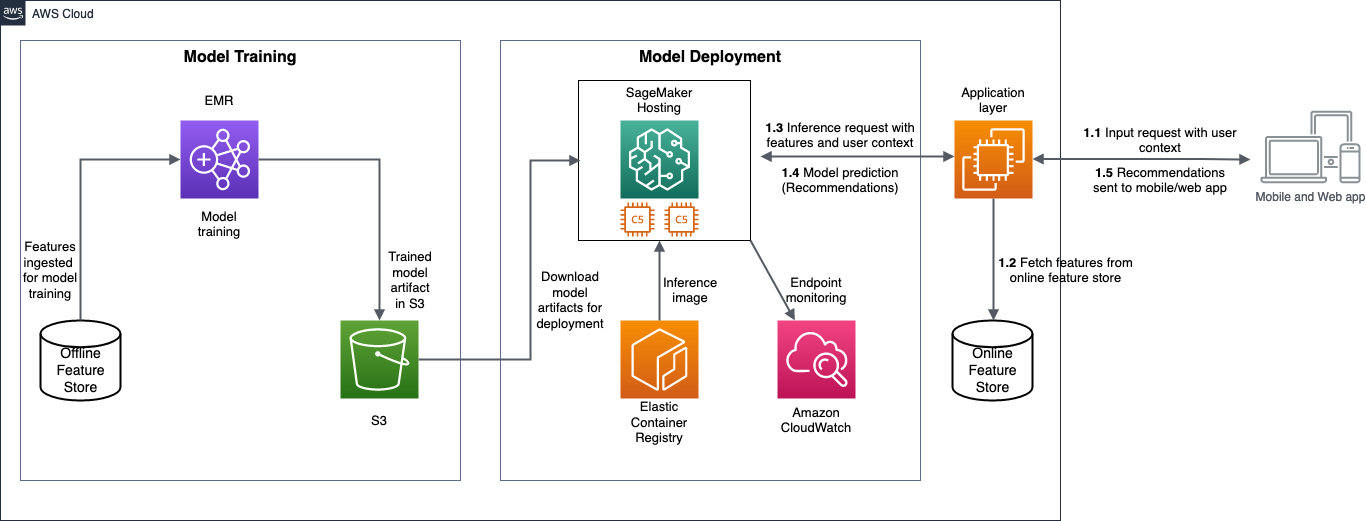

Следующая диаграмма иллюстрирует архитектуру GFR.

Архитектуру можно разделить на два компонента: обучение модели и развертывание модели. В следующих разделах мы более подробно обсудим каждый компонент и используемые сервисы AWS.

Модельное обучение

Мишо использовал Амазонка ЭМИ с Apache Spark для обработки сотен миллионов точек данных, в зависимости от сложности модели. Одной из основных задач было масштабное проведение распределенного обучения. Мы использовали Dask — распределенную среду обработки данных, которая изначально интегрируется с библиотеками Python — в Amazon EMR, чтобы масштабировать задания по обучению в кластере. Распределенное обучение модели помогло сократить время обучения с дней до часов и позволило нам эффективно и экономично планировать задания Spark. Мы использовали автономное хранилище функций для ведения истории всех значений функций, которые будут использоваться для обучения модели. Артефакты модели, полученные в результате обучения, хранятся в Простой сервис хранения Amazon (Amazon S3), обеспечивающий удобный доступ и управление версиями.

Мы использовали стратегию выборки по времени для создания обучающих, проверочных и тестовых наборов данных для обучения модели. Мы отслеживали различные показатели, чтобы оценить производительность модели, наиболее важными из которых являются площадь под кривой ROC и область под кривой точного отзыва. Мы также отслеживали калибровку модели, чтобы предотвратить проблемы чрезмерной и недостаточной уверенности при прогнозировании оценок вероятности.

Развертывание модели

Мишо использовал конечные точки вывода SageMaker с включенным автоматическим масштабированием для развертывания обученной модели. SageMaker обеспечивает простоту развертывания и поддержку различных платформ машинного обучения, что позволяет обслуживать модели с низкой задержкой. Хотя AWS предлагает стандартные изображения вывода, подходящие для большинства случаев использования, мы создали собственное изображение вывода, которое специально соответствует нашим потребностям, и внедрили его в Реестр Amazon Elastic Container (Амазон ЭКР).

Мы создали собственную платформу A/B-тестирования, которая облегчает мониторинг показателей A/B в реальном времени и позволяет нам оперативно принимать решения на основе данных. Мы также использовали A / B тестирования функция SageMaker для развертывания нескольких производственных вариантов на конечной точке. В ходе A/B-экспериментов мы наблюдали повышение коэффициента конверсии платформы примерно на 3.5 % и увеличение частоты открытия приложений пользователями, что подчеркивает эффективность этого подхода.

Мы отслеживали различные отклонения, такие как смещение функций и предыдущее смещение, несколько раз в день после развертывания модели, чтобы предотвратить ухудшение производительности модели.

Мы использовали AWS Lambda для настройки различных средств автоматизации и триггеров, необходимых во время переобучения модели, обновлений конечных точек и процессов мониторинга.

Рабочий процесс рекомендаций после развертывания модели работает следующим образом (как указано на схеме архитектуры решения):

- Запросы ввода с пользовательским контекстом и функциями взаимодействия принимаются на уровне приложения из мобильного и веб-приложения Meesho.

- Уровень приложения извлекает дополнительные функции, такие как исторические данные пользователя, из онлайн-хранилища функций и добавляет их к входным запросам.

- Добавленные функции отправляются на конечные точки в режиме реального времени для создания рекомендаций.

- Прогнозы модели отправляются обратно на прикладной уровень.

- Уровень приложения использует эти прогнозы для персонализации пользовательских каналов в мобильном или веб-приложении.

Заключение

Meesho успешно реализовал обобщенный рейтинг каналов с помощью SageMaker, в результате чего каждому клиенту были предложены персонализированные рекомендации по продуктам на основе их предпочтений и исторического поведения. Такой подход значительно улучшил вовлеченность пользователей и привел к более высоким показателям конверсии, что способствовало общему росту бизнеса компании. В результате использования сервисов AWS продолжительность жизненного цикла машинного обучения значительно сократилась: с нескольких месяцев до нескольких недель, что привело к повышению эффективности и производительности нашей команды.

С помощью этого усовершенствованного средства ранжирования каналов Meesho продолжает предоставлять индивидуальный подход к покупкам, повышая ценность своих клиентов и выполняя свою миссию по демократизации электронной коммерции для всех.

Команда благодарна за постоянную поддержку и руководство со стороны Равиндра Ядав, директор по науке о данных Meesho и Дебдут Мукерджи, руководитель отдела искусственного интеллекта в Meesho, сыгравший ключевую роль в обеспечении этого успеха.

Чтобы узнать больше о SageMaker, обратитесь к Руководство разработчика Amazon SageMaker.

Об авторах

Уткарш Агравал в настоящее время работает старшим специалистом по данным в Meesho. Ранее он работал с Fractal Analytics и Trell в различных областях, включая рекомендательные системы, временные ряды, НЛП и многое другое. Он получил степень магистра математики и информатики Индийского технологического института Харагпура (IIT), Индия.

Уткарш Агравал в настоящее время работает старшим специалистом по данным в Meesho. Ранее он работал с Fractal Analytics и Trell в различных областях, включая рекомендательные системы, временные ряды, НЛП и многое другое. Он получил степень магистра математики и информатики Индийского технологического института Харагпура (IIT), Индия.

Рама Бадринатх в настоящее время работает главным специалистом по данным в Meesho. Ранее он работал с Microsoft и ShareChat в различных областях, включая рекомендательные системы, искусственный интеллект изображений, НЛП и многое другое. Он имеет степень магистра машинного обучения Индийского института науки (IISc), Индия. Он также публиковал статьи на известных конференциях, таких как KDD и ECIR.

Рама Бадринатх в настоящее время работает главным специалистом по данным в Meesho. Ранее он работал с Microsoft и ShareChat в различных областях, включая рекомендательные системы, искусственный интеллект изображений, НЛП и многое другое. Он имеет степень магистра машинного обучения Индийского института науки (IISc), Индия. Он также публиковал статьи на известных конференциях, таких как KDD и ECIR.

Дивай Джиндал в настоящее время работает ведущим специалистом по данным в Meesho. Ранее он работал с Bookmyshow в различных областях, включая рекомендательные системы и динамическое ценообразование.

Дивай Джиндал в настоящее время работает ведущим специалистом по данным в Meesho. Ранее он работал с Bookmyshow в различных областях, включая рекомендательные системы и динамическое ценообразование.

Венугопал Пай — архитектор решений в AWS. Он живет в Бангалоре, Индия, и помогает клиентам, использующим цифровые технологии, масштабировать и оптимизировать свои приложения на AWS.

Венугопал Пай — архитектор решений в AWS. Он живет в Бангалоре, Индия, и помогает клиентам, использующим цифровые технологии, масштабировать и оптимизировать свои приложения на AWS.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- ПлатонЗдоровье. Биотехнологии и клинические исследования. Доступ здесь.

- Источник: https://aws.amazon.com/blogs/machine-learning/how-meesho-built-a-generalized-feed-ranker-using-amazon-sagemaker-inference/

- :имеет

- :является

- $UP

- 100

- 114

- 125

- 2015

- 30

- 7

- a

- О нас

- доступ

- доступной

- приобретение

- через

- добавить

- дополнительный

- дополнениями

- продвинутый

- После

- AI

- Цель

- Все

- разрешено

- Позволяющий

- причислены

- Несмотря на то, что

- Amazon

- Амазонка ЭМИ

- Создатель мудреца Амазонки

- Amazon Web Services

- an

- аналитика

- проанализированы

- и

- апаш

- приложение

- Применение

- Приложения

- подхода

- приблизительный

- архитектура

- МЫ

- ПЛОЩАДЬ

- AS

- At

- автоматический

- AWS

- Машинное обучение AWS

- назад

- основанный

- BE

- поведение

- не являетесь

- ЛУЧШЕЕ

- миллиард

- повышение

- просмотр

- построенный

- бизнес

- бизнес

- купить

- покупателей

- by

- CAN

- кандидат

- возможности

- захватить

- случаев

- категории

- Категории

- обслуживает

- проблемы

- каналы

- нажмите на

- Кластер

- Commerce

- Компания

- Компании

- сложность

- компонент

- компоненты

- вычисление

- конференции

- принимая во внимание

- считает

- строить

- Container

- контекст

- продолжается

- (CIJ)

- содействие

- Удобно

- Конверсия

- Создайте

- В настоящее время

- кривая

- изготовленный на заказ

- клиент

- служба поддержки

- Клиенты

- Порез

- данным

- точки данных

- наука о данных

- ученый данных

- управляемых данными

- Наборы данных

- день

- Дней

- решения

- Степень

- доставить

- демократизировать

- в зависимости

- развертывание

- развертывание

- развертывание

- подробность

- развивать

- Застройщик

- различный

- директор

- скидка

- обсуждать

- Дисплей

- распределенный

- распределенное обучение

- Разное

- Разделенный

- доменов

- вниз

- в течение

- динамический

- каждый

- простота

- электронной коммерции

- экосистема

- фактически

- эффективность

- затрат

- эффективный

- эффективно

- включен

- позволяет

- Конечная точка

- обязательство

- обеспечение

- предприниматели

- оценивать

- все члены

- опыт

- Впечатления

- Эксперименты

- Эксплуатировать

- Больше

- обширный

- облегчается

- факторы

- быстрый

- быстрорастущим

- Особенность

- Особенности

- фокусируется

- после

- следующим образом

- Что касается

- Основана

- Рамки

- каркасы

- частота

- от

- выполнение

- порождающий

- география

- СКФ

- Go

- признательный

- Рост

- Рост

- GUEST

- Guest Post

- руководство

- he

- помог

- помогает

- высший

- выделив

- очень

- исторический

- имеет

- ЧАСЫ

- Как

- HTML

- HTTPS

- Сотни

- сотни миллионов

- иллюстрирует

- изображение

- изображений

- в XNUMX году

- важную

- улучшать

- улучшенный

- in

- включают

- В том числе

- Увеличение

- расширились

- Индия

- Индийская кухня

- individual

- вход

- размышления

- Институт

- Интегрируется

- взаимодействие

- интересный

- интересы

- Интернет

- в

- вопросы

- IT

- пункты

- ЕГО

- Джобс

- всего

- хранится

- Основные

- известный

- Задержка

- последний

- слой

- вести

- ведущий

- УЧИТЬСЯ

- изучение

- привело

- уровень

- Жизненный цикл

- такое как

- жить

- Живет

- логистика

- Низкий

- машина

- обучение с помощью машины

- поддерживать

- основной

- сделать

- управление

- рынка

- магистра

- математика

- средний

- Метрика

- Майк

- Microsoft

- миллионы

- Наша миссия

- ML

- Мобильный телефон

- модель

- Модели

- деньги

- Мониторинг

- месяцев

- БОЛЕЕ

- самых

- с разными

- потребности

- следующий

- НЛП

- отметил,

- роман

- of

- предложенный

- предлагающий

- Предложения

- оффлайн

- on

- ONE

- те,

- онлайн

- открытый

- Оптимизировать

- or

- наши

- внешний

- за

- общий

- самоуверенность

- бумага

- шаблон

- паттеранами

- оплата

- Платежные услуги

- ПКВР

- производительность

- Олицетворять

- Персонализированные

- Платформа

- Платформы

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- играл

- пунктов

- популярность

- После

- потенциально

- мощный

- Точность

- прогнозирования

- Predictions

- предпочтения

- предотвращать

- предварительно

- цена

- цены

- Основной

- Предварительный

- процесс

- Процессы

- Продукт

- Производство

- производительность

- Продукция

- свойства

- приводит

- обеспечение

- опубликованный

- покупки

- толкнул

- Питон

- ранг

- Ранжирование

- Обменный курс

- Стоимость

- рейтинг

- реальные

- реального времени

- получила

- последний

- Рекомендация

- рекомендаций

- запись

- Цена снижена

- относиться

- соответствующие

- надежность

- Знаменитый

- Запросы

- обязательный

- Требования

- результат

- Роли

- Run

- sagemaker

- Вывод SageMaker

- Масштабируемость

- Шкала

- масштабирование

- график

- Наука

- Ученый

- Гол

- разделах

- выбор

- Продавцы

- старший

- послать

- Серии

- Услуги

- набор

- несколько

- Шоппинг

- существенно

- просто

- небольшой

- Решение

- Решения

- Источники

- Искриться

- конкретно

- стандарт

- диск

- магазин

- хранить

- Стратегия

- обтекаемый

- успех

- Успешно

- такие

- подходящее

- поддержка

- системы

- с учетом

- портняжное дело

- с

- команда

- Технологии

- тестXNUMX

- Тестирование

- чем

- который

- Ассоциация

- их

- Эти

- этой

- Через

- время

- Временные ряды

- раз

- в

- сегодня

- к

- трек

- специалистов

- Обучение

- трендов

- два

- под

- созданного

- Updates

- us

- использование

- используемый

- Информация о пользователе

- Пользовательский опыт

- пользователей

- использования

- через

- Использующий

- Проверка

- ценный

- ценностное

- Наши ценности

- различный

- версия

- стремятся

- законопроект

- we

- Web

- веб приложение

- веб-сервисы

- Недели

- ЧТО Ж

- , которые

- в то время как

- КТО

- будете

- в

- работавший

- рабочий

- работает

- работает

- зефирнет