Создатель мудреца Амазонки упрощает развертывание моделей машинного обучения (ML) для вывода в реальном времени и предлагает широкий выбор экземпляров ML, охватывающих процессоры и ускорители, такие как Вывод AWS. Будучи полностью управляемой услугой, вы можете масштабировать развертывание моделей, минимизировать затраты на логические выводы и более эффективно управлять моделями в рабочей среде с меньшими эксплуатационными нагрузками. Конечная точка вывода в реальном времени SageMaker состоит из конечной точки HTTPs и экземпляров ML, которые развертываются в нескольких зонах доступности для обеспечения высокой доступности. SageMaker автоматическое масштабирование приложения может динамически регулировать количество экземпляров машинного обучения, предоставленных для модели, в ответ на изменения рабочей нагрузки. Конечная точка равномерно распределяет входящие запросы по экземплярам ML с помощью циклического алгоритма.

Когда модели машинного обучения, развернутые на экземплярах, получают вызовы API от большого количества клиентов, случайное распределение запросов может работать очень хорошо, если ваши запросы и ответы не сильно различаются. Но в системах с генеративными рабочими нагрузками ИИ запросы и ответы могут быть чрезвычайно разными. В таких случаях зачастую желательно выполнить балансировку нагрузки, учитывая емкость и использование экземпляра, а не случайную балансировку нагрузки.

В этом посте мы обсуждаем стратегию маршрутизации наименьших невыполненных запросов (LOR) SageMaker и то, как она может минимизировать задержку для определенных типов рабочих нагрузок вывода в реальном времени, принимая во внимание емкость и использование экземпляров ML. Мы говорим о его преимуществах по сравнению с механизмом маршрутизации по умолчанию и о том, как вы можете включить LOR для развертывания вашей модели. Наконец, мы представляем сравнительный анализ улучшения задержки с помощью LOR по сравнению со стратегией маршрутизации по умолчанию, состоящей из случайной маршрутизации.

Стратегия SageMaker LOR

По умолчанию конечные точки SageMaker имеют стратегию случайной маршрутизации. SageMaker теперь поддерживает стратегию LOR, которая позволяет SageMaker оптимально направлять запросы к экземпляру, который лучше всего подходит для обслуживания этого запроса. SageMaker делает это возможным, отслеживая загрузку экземпляров вашей конечной точки, а также моделей или компонентов вывода, развернутых на каждом экземпляре.

На следующей интерактивной диаграмме показана политика маршрутизации по умолчанию, при которой запросы, поступающие к конечным точкам модели, случайным образом перенаправляются экземплярам ML.

На следующей интерактивной схеме показана стратегия маршрутизации, при которой SageMaker направит запрос к экземпляру с наименьшим количеством ожидающих обработки запросов.

В целом маршрутизация LOR хорошо работает для базовых моделей или генеративных моделей искусственного интеллекта, когда ваша модель реагирует от сотен миллисекунд до минут. Если ответ вашей модели имеет меньшую задержку (до сотен миллисекунд), вы можете получить больше пользы от случайной маршрутизации. В любом случае мы рекомендуем вам протестировать и определить лучший алгоритм маршрутизации для ваших рабочих нагрузок.

Как настроить стратегии маршрутизации SageMaker

SageMaker теперь позволяет вам устанавливать RoutingStrategy параметр при создании EndpointConfiguration для конечных точек. разные RoutingStrategy значения, поддерживаемые SageMaker:

LEAST_OUTSTANDING_REQUESTSRANDOM

Ниже приведен пример развертывания модели в конечной точке вывода, в которой включен LOR:

- Создайте конфигурацию конечной точки, установив

RoutingStrategyasLEAST_OUTSTANDING_REQUESTS: - Создайте конечную точку, используя конфигурацию конечной точки (без изменений):

Результаты

Мы провели тестирование производительности, чтобы измерить задержку сквозного вывода и пропускную способность кодеген2-7B модель, размещенная на экземплярах ml.g5.24xl с маршрутизацией по умолчанию и конечными точками интеллектуальной маршрутизации. Модель CodeGen2 принадлежит к семейству авторегрессионных языковых моделей и генерирует исполняемый код при наличии подсказок на английском языке.

В нашем анализе мы увеличили количество экземпляров ml.g5.24xl за каждой конечной точкой для каждого запуска теста по мере увеличения количества одновременных пользователей, как показано в следующей таблице.

| Пусконаладка | Количество одновременных пользователей | Количество экземпляров |

| 1 | 4 | 1 |

| 2 | 20 | 5 |

| 3 | 40 | 10 |

| 4 | 60 | 15 |

| 5 | 80 | 20 |

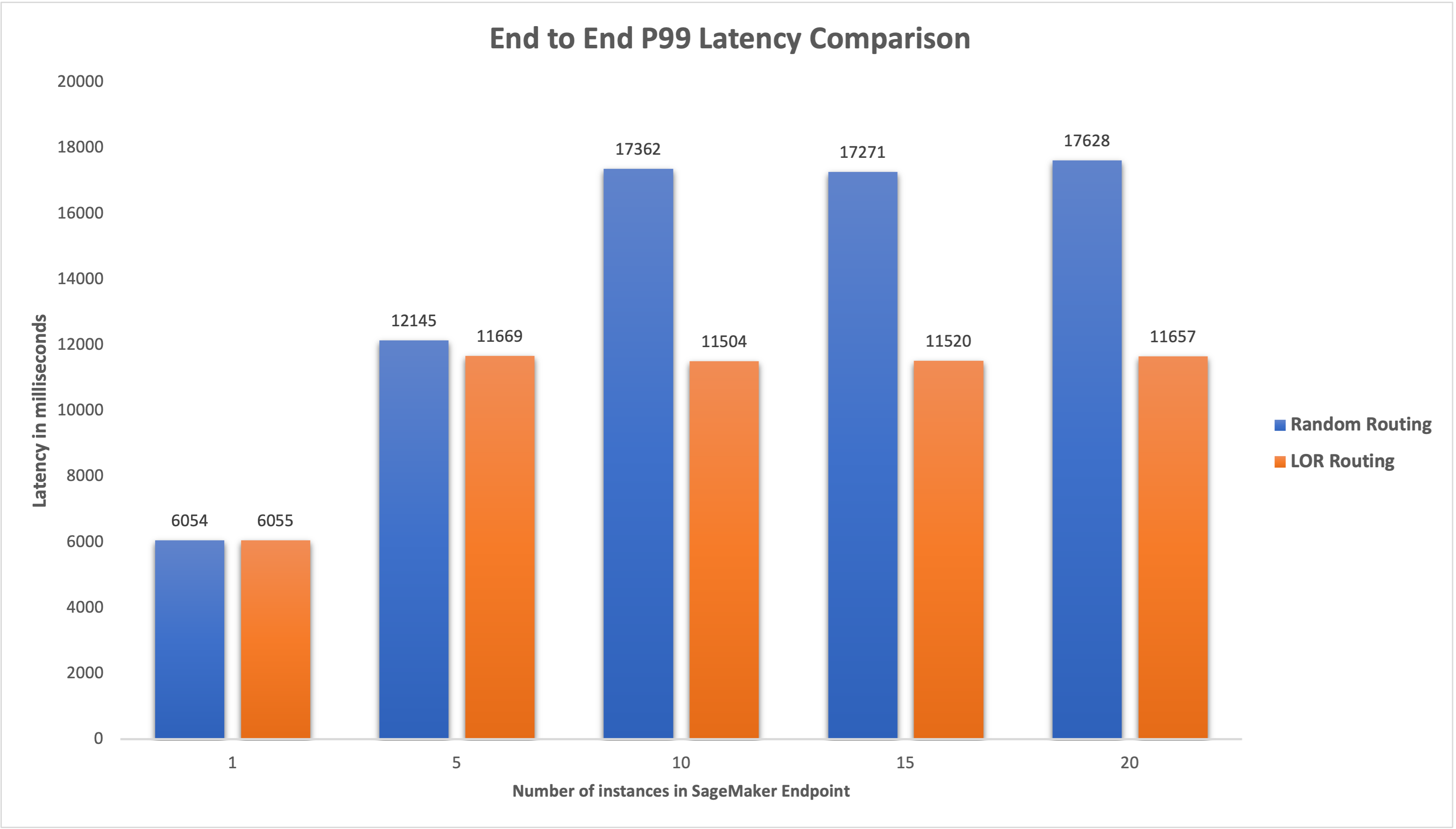

Мы измерили сквозную задержку P99 для обеих конечных точек и наблюдали улучшение задержки на 4–33 % при увеличении количества экземпляров с 5 до 20, как показано на следующем графике.

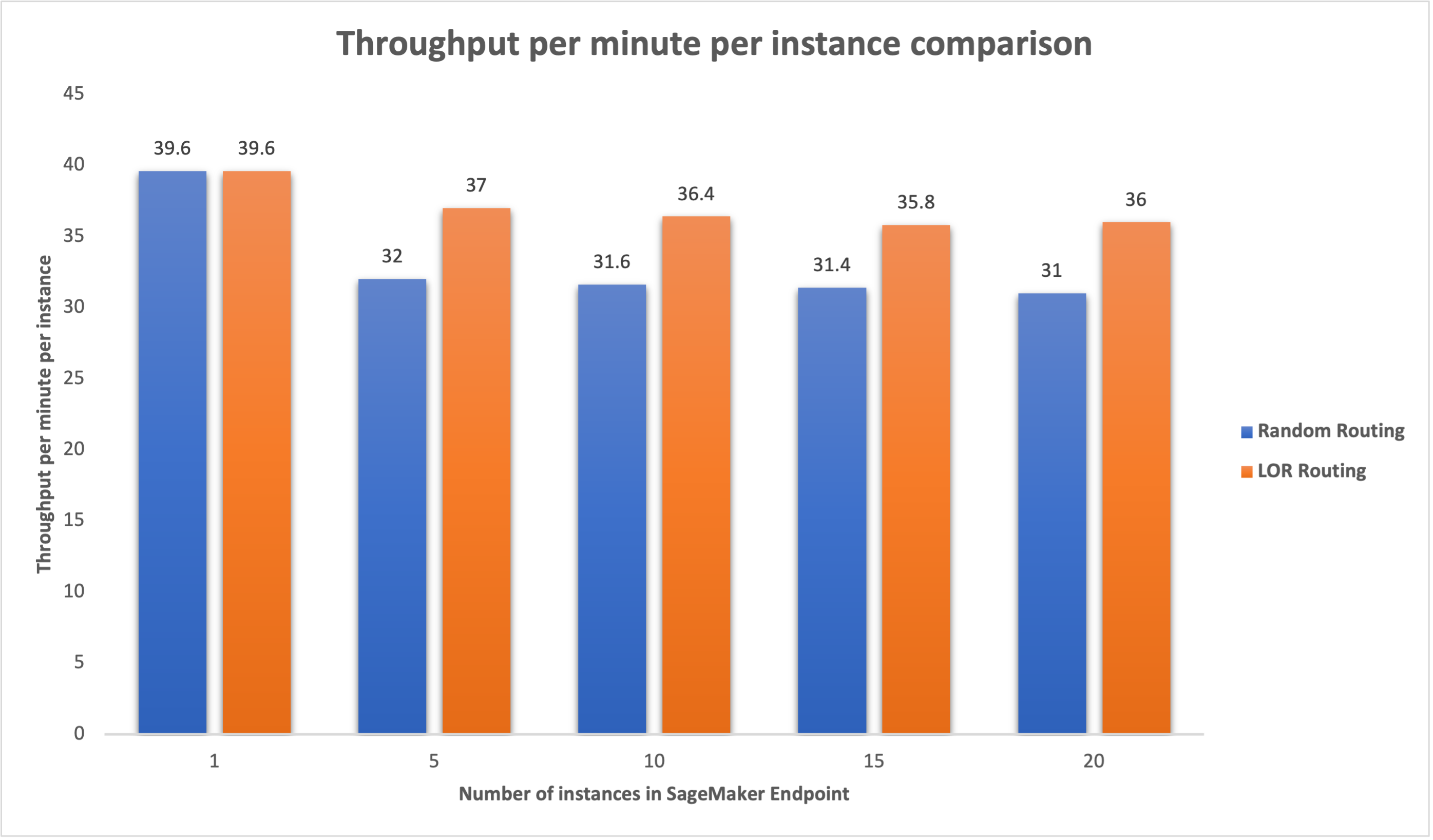

Аналогичным образом мы наблюдали улучшение пропускной способности на 15–16% в минуту на каждый экземпляр, когда количество экземпляров было увеличено с 5 до 20.

Это показывает, что интеллектуальная маршрутизация способна улучшить распределение трафика между конечными точками, что приводит к улучшению сквозной задержки и общей пропускной способности.

Заключение

В этом посте мы объяснили стратегии маршрутизации SageMaker и новую опцию включения маршрутизации LOR. Мы объяснили, как включить LOR и какую пользу он может принести при развертывании вашей модели. Наши тесты производительности показали улучшение задержки и пропускной способности во время обработки выводов в реальном времени. Дополнительную информацию о функциях маршрутизации SageMaker см. документации. Мы рекомендуем вам оценить рабочие нагрузки вывода и определить, оптимально ли вы настроены на стратегию маршрутизации.

Об авторах

Джеймс Парк — архитектор решений в Amazon Web Services. Он работает с Amazon.com над проектированием, созданием и развертыванием технологических решений на AWS, а также проявляет особый интерес к искусственному интеллекту и машинному обучению. В свободное время он любит искать новые культуры, новый опыт и оставаться в курсе последних технологических тенденций. Вы можете найти его на LinkedIn.

Джеймс Парк — архитектор решений в Amazon Web Services. Он работает с Amazon.com над проектированием, созданием и развертыванием технологических решений на AWS, а также проявляет особый интерес к искусственному интеллекту и машинному обучению. В свободное время он любит искать новые культуры, новый опыт и оставаться в курсе последних технологических тенденций. Вы можете найти его на LinkedIn.

Венугопал Пай — архитектор решений в AWS. Он живет в Бангалоре, Индия, и помогает клиентам, использующим цифровые технологии, масштабировать и оптимизировать свои приложения на AWS.

Венугопал Пай — архитектор решений в AWS. Он живет в Бангалоре, Индия, и помогает клиентам, использующим цифровые технологии, масштабировать и оптимизировать свои приложения на AWS.

Дэвид Нигенда является старшим инженером по разработке программного обеспечения в команде Amazon SageMaker, в настоящее время работает над улучшением рабочих процессов машинного обучения в производственной среде, а также над запуском новых функций логического вывода. В свободное время старается не отставать от своих детей.

Дэвид Нигенда является старшим инженером по разработке программного обеспечения в команде Amazon SageMaker, в настоящее время работает над улучшением рабочих процессов машинного обучения в производственной среде, а также над запуском новых функций логического вывода. В свободное время старается не отставать от своих детей.

Дипти Рагха — инженер-разработчик программного обеспечения в команде Amazon SageMaker. Ее текущая работа сосредоточена на создании функций для эффективного размещения моделей машинного обучения. В свободное время она любит путешествовать, ходить в походы и выращивать растения.

Дипти Рагха — инженер-разработчик программного обеспечения в команде Amazon SageMaker. Ее текущая работа сосредоточена на создании функций для эффективного размещения моделей машинного обучения. В свободное время она любит путешествовать, ходить в походы и выращивать растения.

Алан Тан является старшим менеджером по продуктам в SageMaker, возглавляет усилия по выводу больших моделей. Он увлечен применением машинного обучения в области аналитики. Вне работы он любит проводить время на свежем воздухе.

Алан Тан является старшим менеджером по продуктам в SageMaker, возглавляет усилия по выводу больших моделей. Он увлечен применением машинного обучения в области аналитики. Вне работы он любит проводить время на свежем воздухе.

Дхавал Патель является главным архитектором машинного обучения в AWS. Он работал с организациями, начиная от крупных предприятий и заканчивая стартапами среднего размера, над проблемами, связанными с распределенными вычислениями и искусственным интеллектом. Он специализируется на глубоком обучении, включая домены NLP и Computer Vision. Он помогает клиентам добиться высокопроизводительного логического вывода модели в SageMaker.

Дхавал Патель является главным архитектором машинного обучения в AWS. Он работал с организациями, начиная от крупных предприятий и заканчивая стартапами среднего размера, над проблемами, связанными с распределенными вычислениями и искусственным интеллектом. Он специализируется на глубоком обучении, включая домены NLP и Computer Vision. Он помогает клиентам добиться высокопроизводительного логического вывода модели в SageMaker.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- ПлатонЗдоровье. Биотехнологии и клинические исследования. Доступ здесь.

- Источник: https://aws.amazon.com/blogs/machine-learning/minimize-real-time-inference-latency-by-using-amazon-sagemaker-routing-strategies/

- :имеет

- :является

- :нет

- :куда

- $UP

- 1

- 100

- 125

- 150

- 17

- 1870

- 20

- 7

- 9

- a

- в состоянии

- О нас

- ускорители

- Достигать

- через

- AI

- AI модели

- Алан

- алгоритм

- позволяет

- Amazon

- Создатель мудреца Амазонки

- Amazon Web Services

- Amazon.com

- среди

- an

- анализ

- аналитика

- и

- API

- Приложения

- Применение

- МЫ

- ПЛОЩАДЬ

- искусственный

- искусственный интеллект

- AS

- At

- автоматический

- свободных мест

- AWS

- Баланс

- Балансировка

- BE

- за

- принадлежит

- бенчмаркинг

- польза

- Преимущества

- ЛУЧШЕЕ

- изоферменты печени

- широкий

- строить

- Строительство

- бремя

- но

- by

- Объявления

- CAN

- Пропускная способность

- случаев

- определенный

- изменение

- изменения

- клиентов

- код

- COM

- приход

- компоненты

- компьютер

- Компьютерное зрение

- вычисление

- параллельный

- Конфигурация

- настроить

- рассмотрение

- принимая во внимание

- состоит

- Расходы

- Создающий

- Текущий

- В настоящее время

- Клиенты

- Время

- глубоко

- глубокое обучение

- По умолчанию

- развертывание

- развернуть

- развертывание

- развертывания

- Проект

- Определять

- Развитие

- различный

- обсуждать

- распределенный

- распределенных вычислений

- распределение

- доменов

- в течение

- динамично

- каждый

- фактически

- эффективно

- усилия

- включить

- включен

- поощрять

- впритык

- Конечная точка

- инженер

- Английский

- предприятий

- оценивать

- пример

- Впечатления

- объяснены

- чрезвычайно

- семья

- Особенности

- в заключение

- Найдите

- фокусируется

- после

- Что касается

- основополагающий

- от

- полностью

- Общие

- генерирует

- генеративный

- Генеративный ИИ

- GIF

- данный

- график

- Рост

- Есть

- he

- помогает

- ее

- High

- его

- его

- кашель

- состоялся

- Как

- How To

- HTML

- HTTPS

- Сотни

- определения

- if

- иллюстрирует

- улучшать

- улучшение

- улучшение

- улучшение

- in

- В том числе

- Входящий

- расширились

- Индия

- пример

- Интеллекта

- интерактивный

- интерес

- в

- IT

- ЕГО

- JPG

- Сохранить

- Дети

- язык

- большой

- Крупные предприятия

- Задержка

- последний

- запуск

- ведущий

- УЧИТЬСЯ

- изучение

- наименее

- Живет

- загрузка

- серия

- ниже

- машина

- обучение с помощью машины

- ДЕЛАЕТ

- управлять

- управляемого

- менеджер

- способ

- Май..

- проводить измерение

- механизм

- миллисекунды

- минут

- Минут

- ML

- модель

- Модели

- Мониторинг

- БОЛЕЕ

- с разными

- Новые

- НЛП

- нет

- сейчас

- номер

- of

- Предложения

- .

- on

- оперативный

- Оптимизировать

- Опция

- or

- организации

- наши

- внешний

- на открытом воздухе

- внешнюю

- выдающийся

- за

- общий

- параметр

- особый

- страстный

- для

- производительность

- растения

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- политика

- возможное

- После

- представить

- Основной

- проблемам

- Продукт

- Менеджер по продукции

- Производство

- наводящие

- случайный

- ранжирование

- скорее

- реального времени

- Получать

- рекомендовать

- Цена снижена

- относиться

- Несмотря на

- Связанный

- запросить

- Запросы

- ответ

- ответы

- дорога

- маршрутизация

- Run

- sagemaker

- Шкала

- поиск

- выбор

- старший

- служить

- обслуживание

- Услуги

- набор

- установка

- она

- показал

- показанный

- Шоу

- умный

- Software

- разработка программного обеспечения

- Решения

- напряженность

- Стартапы

- пребывание

- простой

- стратегий

- Стратегия

- такие

- Поддержанный

- Поддержка

- системы

- ТАБЛИЦЫ

- с

- Говорить

- команда

- Технологии

- тестXNUMX

- тестов

- чем

- который

- Ассоциация

- Местоположение

- их

- Там.

- Эти

- этой

- пропускная способность

- время

- в

- трафик

- Путешествие

- Тенденции

- Типы

- пользователей

- через

- Наши ценности

- переменная

- очень

- видение

- we

- Web

- веб-сервисы

- ЧТО Ж

- были

- когда

- , которые

- в то время как

- будете

- Работа

- работавший

- Рабочие процессы

- работает

- работает

- Ты

- ВАШЕ

- зефирнет

- зоны