В этом посте рассказывается о наиболее распространенных проблемах, с которыми сталкиваются клиенты при поиске во внутренних документах, и даются конкретные рекомендации о том, как можно использовать сервисы AWS для создания генеративного диалогового бота с искусственным интеллектом, который делает внутреннюю информацию более полезной.

Неструктурированные данные составляют 80% всех данных. находится в организациях и состоит из хранилищ руководств, PDF-файлов, часто задаваемых вопросов, электронных писем и других документов, число которых увеличивается с каждым днем. Сегодня предприятия полагаются на постоянно растущие хранилища внутренней информации, и проблемы возникают, когда объем неструктурированных данных становится неуправляемым. Часто пользователи читают и проверяют множество различных внутренних источников, чтобы найти нужные им ответы.

Внутренние форумы вопросов и ответов могут помочь пользователям получить весьма конкретные ответы, но при этом требуют более длительного времени ожидания. В случае с внутренними часто задаваемыми вопросами, касающимися конкретной компании, длительное время ожидания приводит к снижению производительности труда сотрудников. Форумы вопросов и ответов сложно масштабировать, поскольку они полагаются на ответы, написанные вручную. Благодаря генеративному искусственному интеллекту в настоящее время происходит сдвиг парадигмы в том, как пользователи ищут и находят информацию. Следующим логическим шагом является использование генеративного искусственного интеллекта для сжатия больших документов в информацию меньшего размера для облегчения использования пользователем. Вместо того, чтобы тратить долгое время на чтение текста или ожидание ответов, пользователи могут создавать сводки в режиме реального времени на основе нескольких существующих хранилищ внутренней информации.

Обзор решения

Решение позволяет клиентам получать тщательно подобранные ответы на вопросы, заданные о внутренних документах, используя модель преобразователя для генерации ответов на вопросы о данных, на которых она не обучалась, - метод, известный как подсказка с нулевым выстрелом. Приняв это решение, клиенты могут получить следующие преимущества:

- Находить точные ответы на вопросы на основе существующих источников внутренних документов

- Сократите время, которое пользователи тратят на поиск ответов, используя большие языковые модели (LLM), чтобы предоставлять практически немедленные ответы на сложные запросы, используя документы с самой актуальной информацией.

- Поиск ранее отвеченных вопросов с помощью централизованной информационной панели.

- Уменьшите стресс, вызванный тратой времени на чтение информации вручную в поисках ответов.

Поисковая дополненная генерация (RAG)

Поисковая расширенная генерация (RAG) устраняет некоторые недостатки запросов на основе LLM, находя ответы в вашей базе знаний и используя LLM для обобщения документов в краткие ответы. Пожалуйста прочтите это после узнать, как реализовать подход RAG с Амазон Кендра. Следующие риски и ограничения связаны с запросами на основе LLM, которые адресует подход RAG с Amazon Kendra:

- Галлюцинации и отслеживаемость. LLMS обучается на больших наборах данных и генерирует ответы на основе вероятностей. Это может привести к неточным ответам, которые известны как галлюцинации.

- Несколько хранилищ данных. Чтобы ссылаться на данные из нескольких источников в вашем ответе, необходимо настроить экосистему соединителей для агрегирования данных. Доступ к нескольким репозиториям осуществляется вручную и требует много времени.

- Безопасность. Безопасность и конфиденциальность являются важнейшими факторами при развертывании диалоговых ботов на базе RAG и LLM. Несмотря на использование Amazon Comprehend для фильтрации персональных данных, которые могут быть предоставлены посредством пользовательских запросов, остается возможность непреднамеренного раскрытия личной или конфиденциальной информации, в зависимости от загруженных данных. Это означает, что контроль доступа к чат-боту имеет решающее значение для предотвращения непреднамеренного доступа к конфиденциальной информации.

- Актуальность данных. LLMS обучаются на данных до определенной даты, что означает, что информация часто не является актуальной. Стоимость обучения моделей на последних данных высока. Чтобы обеспечить точные и актуальные ответы, организации несут ответственность за регулярное обновление и обогащение содержания индексируемых документов.

- Стоимость. Затраты, связанные с развертыванием этого решения, должны учитываться предприятиями. При внедрении этого решения компаниям необходимо тщательно оценить свой бюджет и требования к производительности. Запуск LLM может потребовать значительных вычислительных ресурсов, что может увеличить эксплуатационные расходы. Эти затраты могут стать ограничением для приложений, которым необходимо работать в больших масштабах. Однако одно из преимуществ Облако AWS это возможность платить только за то, что вы используете. AWS предлагает простую и последовательную модель ценообразования с оплатой по мере использования, поэтому вы платите только за потребляемые ресурсы.

Использование Amazon SageMaker JumpStart

Для языковых моделей на основе преобразователей организации могут извлечь выгоду из использования Создатель мудреца Амазонки JumpStart, предлагающий коллекцию готовых моделей машинного обучения. Amazon SageMaker JumpStart предлагает широкий спектр базовых моделей генерации текста и ответов на вопросы (Q&A), которые можно легко развернуть и использовать. В это решение интегрирована модель FLAN T5-XL Amazon SageMaker JumpStart, но при этом следует учитывать различные аспекты. выбор модели фундамента.

Интеграция безопасности в наш рабочий процесс

Следуя лучшим практикам компонента безопасности Хорошо спроектированная структура, Амазон Когнито используется для аутентификации. Пулы пользователей Amazon Cognito можно интегрировать со сторонними поставщиками удостоверений, которые поддерживают несколько инфраструктур, используемых для контроля доступа, включая открытую авторизацию (OAuth), OpenID Connect (OIDC) или язык разметки утверждений безопасности (SAML). Идентификация пользователей и их действий позволяет решению поддерживать отслеживаемость. В решении также используется Обнаружение личной информации (PII) Amazon Comprehend функция автоматической идентификации и редактирования личных данных. Отредактированные персональные данные включают адреса, номера социального страхования, адреса электронной почты и другую конфиденциальную информацию. Такая конструкция гарантирует, что любая PII, предоставленная пользователем посредством входного запроса, будет отредактирована. Личные данные не сохраняются, не используются Amazon Kendra и не передаются в LLM.

Пошаговое руководство по решению

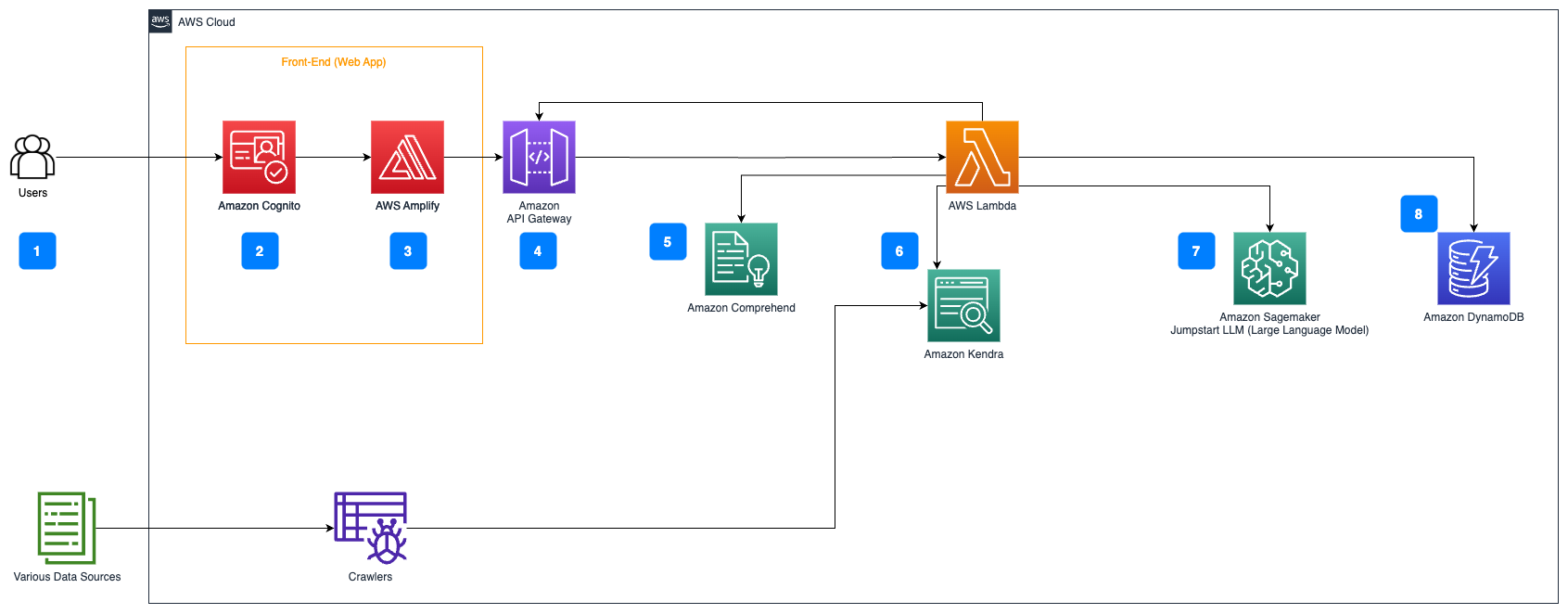

Следующие шаги описывают рабочий процесс ответа на вопросы в потоке документов:

- Пользователи отправляют запрос через веб-интерфейс.

- Амазон Когнито используется для аутентификации, обеспечивая безопасный доступ к веб-приложению.

- Интерфейс веб-приложения размещен на АМС Усиление.

- Шлюз API Amazon размещает REST API с различными конечными точками для обработки пользовательских запросов, аутентифицированных с помощью Amazon Cognito.

- Редактирование личных данных с помощью Amazon Comprehend:

- Обработка пользовательских запросов. Когда пользователь отправляет запрос или вводимые данные, они сначала проходят через Amazon Comprehend. Служба анализирует текст и идентифицирует любые объекты PII, присутствующие в запросе.

- Извлечение PII: Amazon Comprehend извлекает обнаруженные объекты PII из пользовательского запроса.

- Поиск соответствующей информации с помощью Амазон Кендра:

- Amazon Kendra используется для управления индексом документов, содержащим информацию, используемую для генерации ответов на запросы пользователя.

- Ассоциация Получение QA LangChain Модуль используется для построения цепочки разговоров, содержащей соответствующую информацию о запросах пользователя.

- Интеграция с Amazon SageMaker JumpStart:

- Функция AWS Lambda использует библиотеку LangChain и подключается к конечной точке Amazon SageMaker JumpStart с помощью контекстно-наполненного запроса. Конечная точка Amazon SageMaker JumpStart служит интерфейсом LLM, используемым для вывода.

- Сохранение ответов и возврат их пользователю:

- Ответ от LLM сохраняется в Amazon DynamoDB наряду с запросом пользователя, меткой времени, уникальным идентификатором и другими произвольными идентификаторами элемента, такими как категория вопросов. Сохранение вопросов и ответов в виде отдельных элементов позволяет функции AWS Lambda легко воссоздавать историю разговоров пользователя на основе времени, когда были заданы вопросы.

- Наконец, ответ отправляется обратно пользователю через HTTPs-запрос через ответ интеграции REST API Amazon API Gateway.

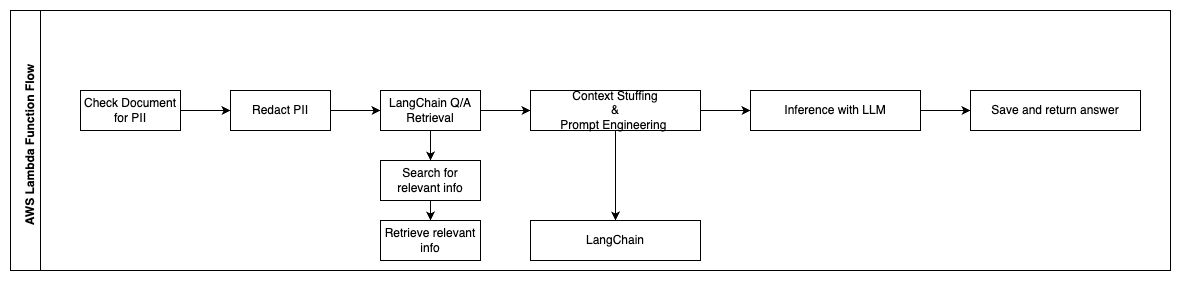

Следующие шаги описывают функции AWS Lambda и порядок их выполнения:

- Проверьте и отредактируйте любую персональную/конфиденциальную информацию.

- Цепочка поиска LangChain QA

- Найдите и получите соответствующую информацию

- Контекстная начинка и оперативное проектирование

- Вывод с помощью LLM

- Вернуть ответ и сохранить его

Use cases

Существует множество случаев использования в бизнесе, где клиенты могут использовать этот рабочий процесс. В следующем разделе объясняется, как этот рабочий процесс можно использовать в различных отраслях и вертикалях.

Помощь сотрудникам

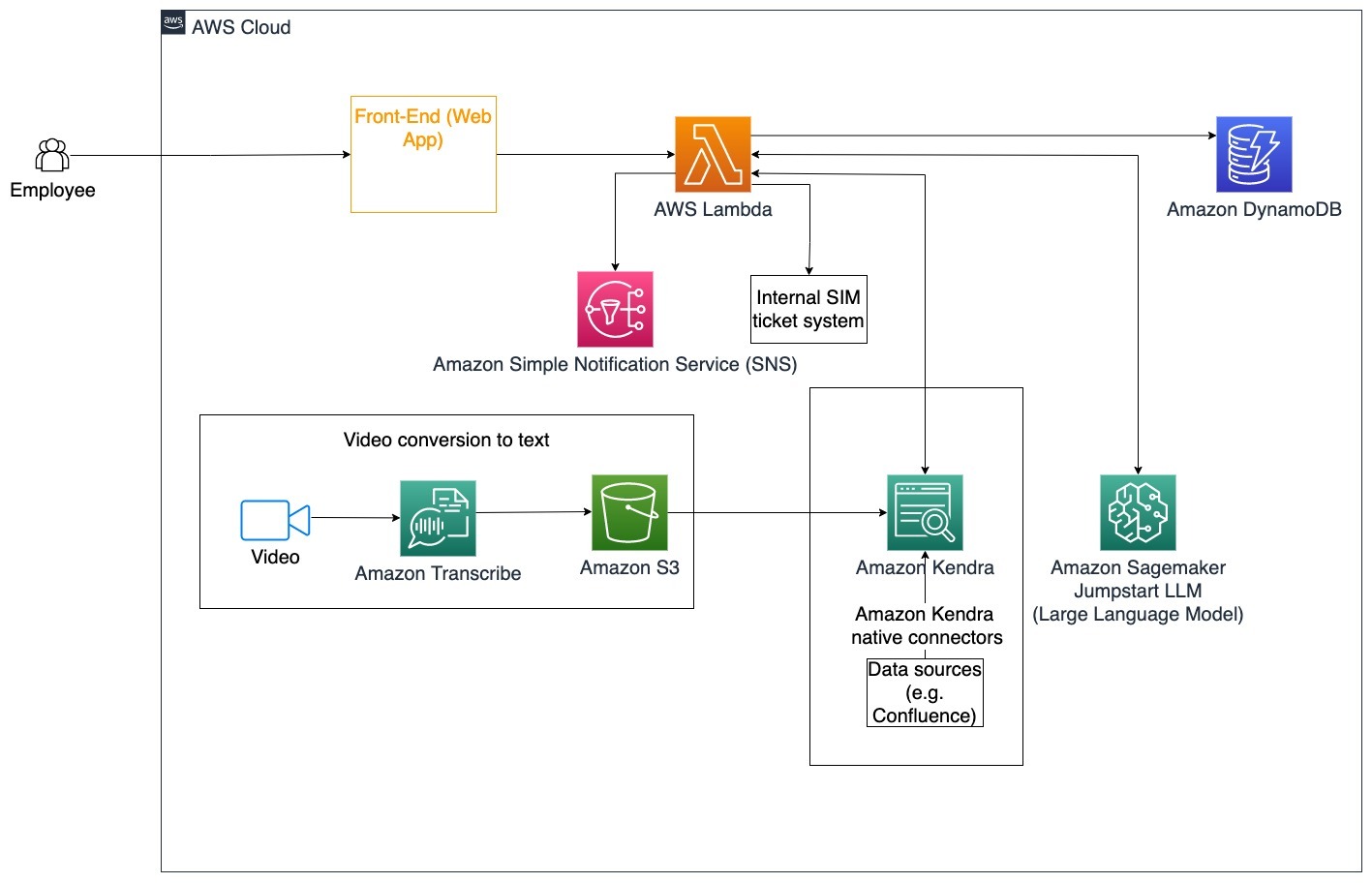

Хорошо продуманное корпоративное обучение может повысить удовлетворенность сотрудников и сократить время, необходимое для адаптации новых сотрудников. По мере того как организации растут и усложняются, сотрудникам становится все труднее понимать множество источников внутренних документов. Внутренние документы в этом контексте включают руководства, политики и стандартные операционные процедуры компании. В этом сценарии у сотрудника возникает вопрос о том, как действовать и редактировать заявку на регистрацию внутренней проблемы. Сотрудник может получить доступ к диалоговому боту с генеративным искусственным интеллектом (ИИ) и использовать его, чтобы задавать вопросы и выполнять следующие действия для конкретного билета.

Конкретный вариант использования: Автоматизируйте решение проблем для сотрудников на основе корпоративных правил.

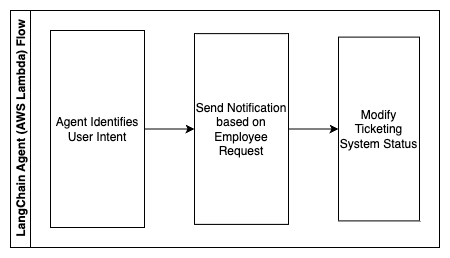

Следующие шаги описывают функции AWS Lambda и порядок их выполнения:

- Агент LangChain для определения намерения

- Отправка уведомления по запросу сотрудника

- Изменить статус заявки

На этой архитектурной схеме корпоративные обучающие видеоролики могут быть загружены через Amazon транскрибировать собрать лог этих видеоскриптов. Кроме того, контент корпоративного обучения, хранящийся в различных источниках (например, Confluence, Microsoft SharePoint, Google Drive, Jira и т. д.), можно использовать для создания индексов через коннекторы Amazon Kendra. Прочтите эту статью, чтобы узнать больше о коллекции туземных растений. Разъемы вы можете использовать Amazon Kendra в качестве источника. Затем сканер Amazon Kendra может использовать как видеосценарии корпоративного обучения, так и документацию, хранящуюся в этих других источниках, чтобы помочь диалоговому боту ответить на вопросы, относящиеся к руководящим принципам корпоративного обучения компании. Агент LangChain проверяет разрешения, изменяет статус заявки и уведомляет нужных лиц с помощью Amazon Simple Notification Service (Amazon соцсети).

Группы поддержки клиентов

Быстрое решение запросов клиентов улучшает качество обслуживания клиентов и способствует лояльности к бренду. База лояльных клиентов помогает стимулировать продажи, что способствует увеличению прибыли и повышению вовлеченности клиентов. Команды поддержки клиентов тратят много энергии, ссылаясь на множество внутренних документов и программного обеспечения для управления взаимоотношениями с клиентами, чтобы ответить на вопросы клиентов о продуктах и услугах. Внутренние документы в этом контексте могут включать общие сценарии звонков в службу поддержки клиентов, руководства по эскалации и бизнес-информацию. Диалоговый бот с генеративным искусственным интеллектом помогает оптимизировать затраты, поскольку обрабатывает запросы от имени службы поддержки клиентов.

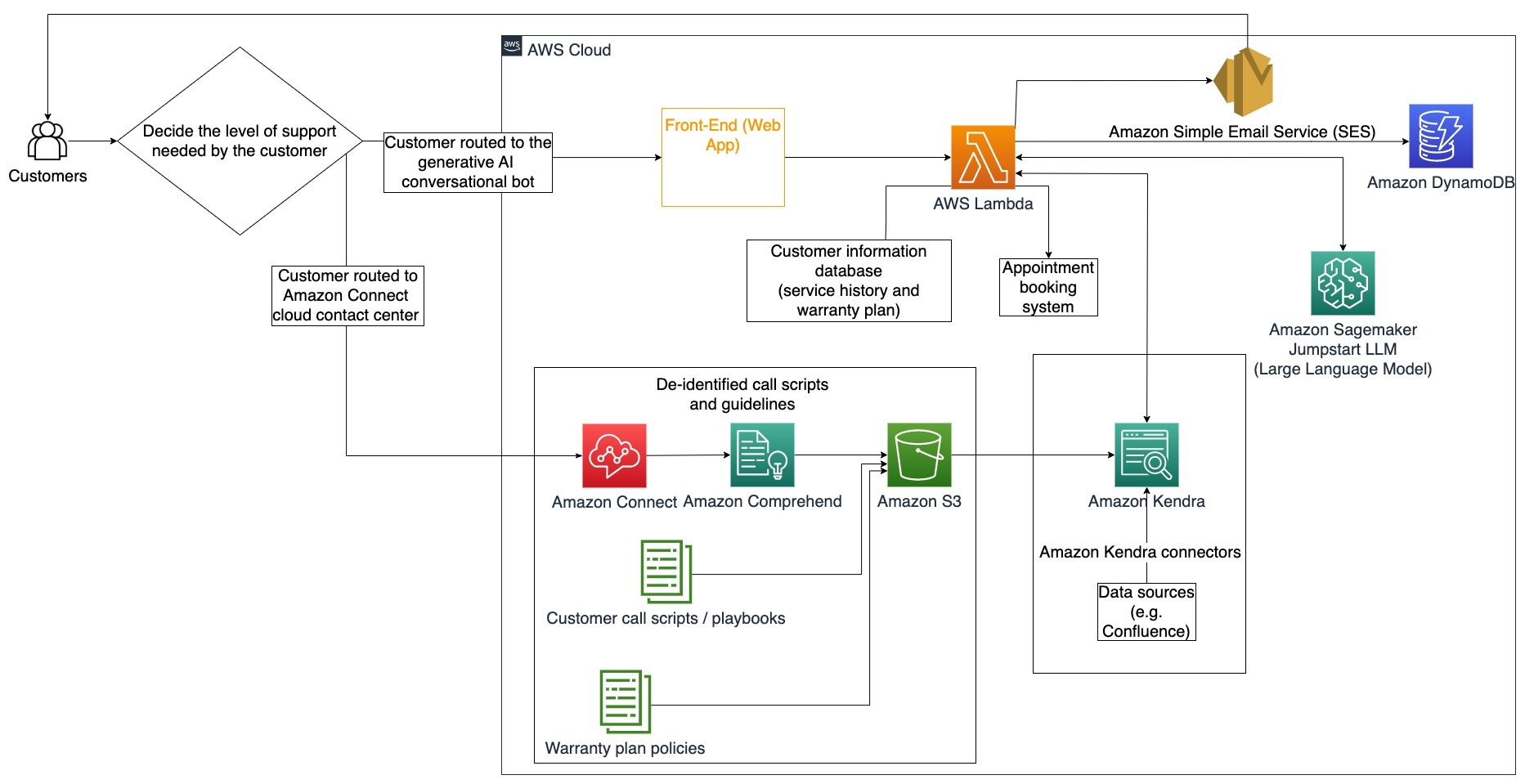

Конкретный вариант использования: Обработка запроса на замену масла на основе истории обслуживания и приобретенного плана обслуживания клиентов.

На этой архитектурной схеме клиент направляется либо к диалоговому боту с генеративным искусственным интеллектом, либо к Амазон Коннект Контактный центр. Это решение может быть основано на необходимом уровне поддержки или наличии агентов службы поддержки клиентов. Агент LangChain определяет намерения клиента и проверяет личность. Агент LangChain также проверяет историю обслуживания и приобретенный план поддержки.

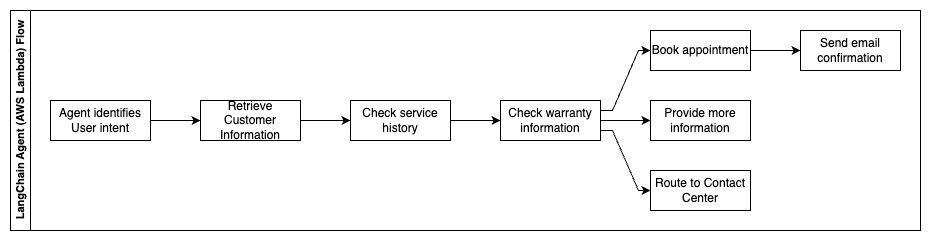

Следующие шаги описывают функции AWS Lambda и порядок их выполнения:

- Агент LangChain определяет намерение

- Получить информацию о клиенте

- Проверьте историю обслуживания клиентов и информацию о гарантии

- Запишитесь на прием, предоставьте дополнительную информацию или направьте в контакт-центр

- Отправить подтверждение по электронной почте

Amazon Connect используется для сбора журналов голосовых сообщений и чатов, а Amazon Comprehend используется для удаления личной информации (PII) из этих журналов. Затем сканер Amazon Kendra может использовать отредактированные журналы голосовых сообщений и чатов, сценарии звонков клиентам и политики плана поддержки клиентов для создания индекса. Как только решение принято, диалоговый бот с генеративным искусственным интеллектом решает, следует ли записаться на прием, предоставить дополнительную информацию или направить клиента в контакт-центр для получения дальнейшей помощи. Для оптимизации затрат агент LangChain также может генерировать ответы, используя меньшее количество токенов и менее дорогую модель большого языка для запросов клиентов с более низким приоритетом.

Финансовые услуги

Компании, предоставляющие финансовые услуги, полагаются на своевременное использование информации, чтобы оставаться конкурентоспособными и соблюдать финансовые правила. Используя генеративный диалоговый бот с искусственным интеллектом, финансовые аналитики и консультанты могут взаимодействовать с текстовой информацией в диалоговой форме и сократить время и усилия, необходимые для принятия более обоснованных решений. Помимо инвестиций и исследований рынка, генеративный диалоговый бот с искусственным интеллектом также может расширить человеческие возможности, выполняя задачи, которые традиционно требуют больше человеческих усилий и времени. Например, финансовое учреждение, специализирующееся на потребительских кредитах, может увеличить скорость обработки кредитов, обеспечивая при этом большую прозрачность для клиентов.

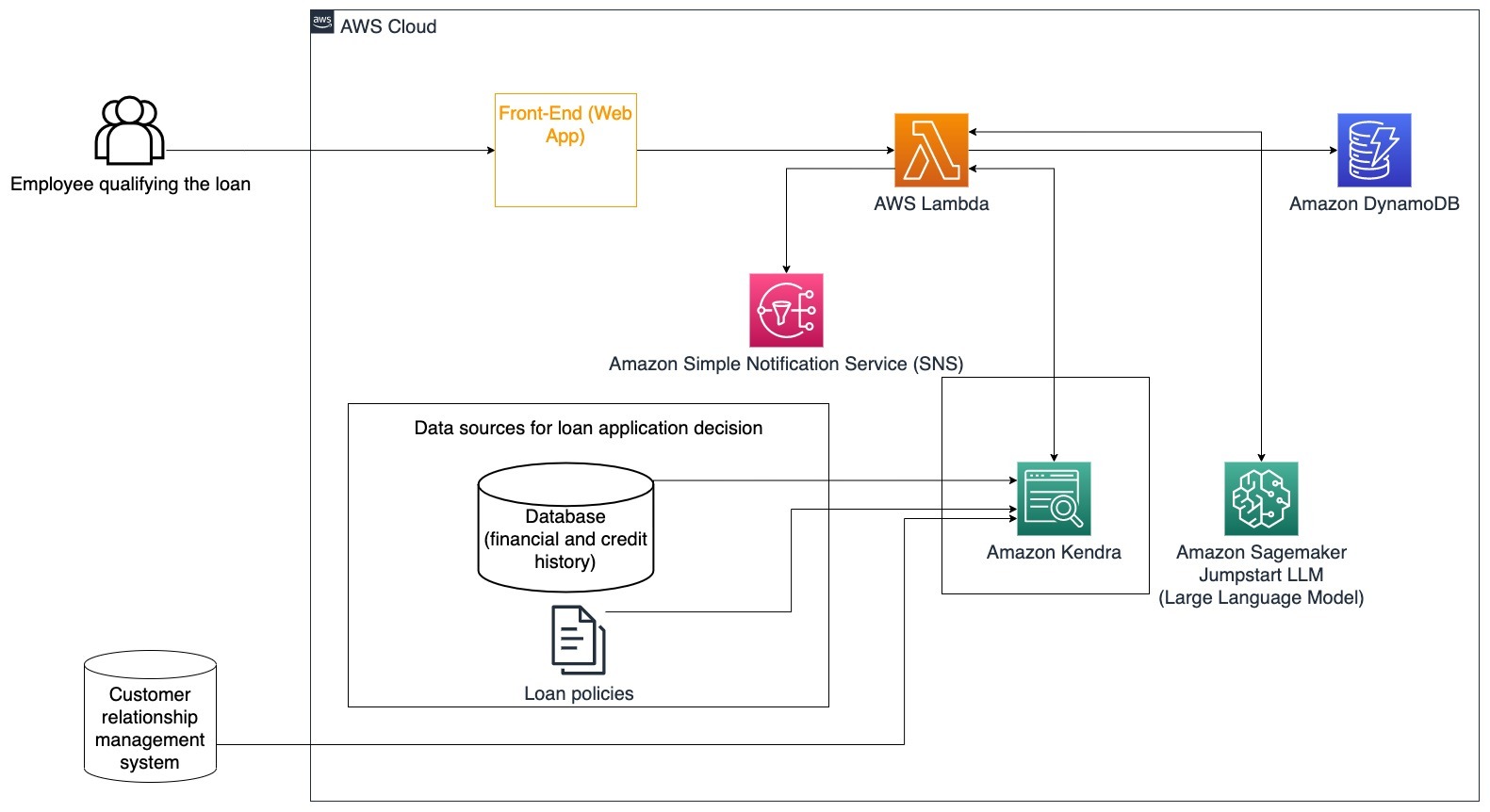

Конкретный вариант использования: Используйте финансовую историю клиента и предыдущие заявки на кредит, чтобы принять решение и объяснить решение о кредите.

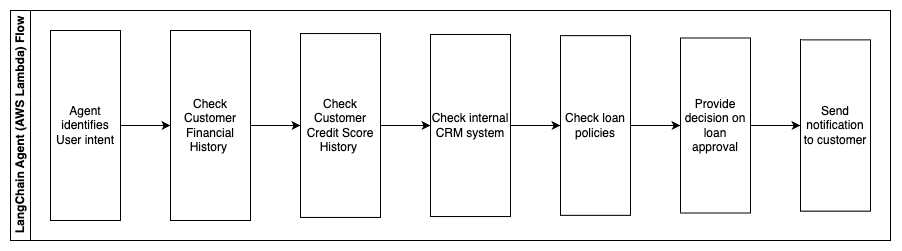

Следующие шаги описывают функции AWS Lambda и порядок их выполнения:

- Агент LangChain для определения намерения

- Проверьте финансовую и кредитную историю клиента

- Проверьте внутреннюю систему управления взаимоотношениями с клиентами

- Проверьте стандартную кредитную политику и предложите решение для сотрудника, имеющего право на получение кредита.

- Отправить уведомление клиенту

Эта архитектура включает финансовые данные клиентов, хранящиеся в базе данных, и данные, хранящиеся в инструменте управления взаимоотношениями с клиентами (CRM). Эти данные используются для принятия решения на основе внутренней кредитной политики компании. Клиент может задать уточняющие вопросы, чтобы понять, на какие кредиты он имеет право и на каких условиях он может принять кредит. Если диалоговый бот с генеративным искусственным интеллектом не может одобрить заявку на получение кредита, пользователь все равно может задать вопросы об улучшении кредитного рейтинга или альтернативных вариантах финансирования.

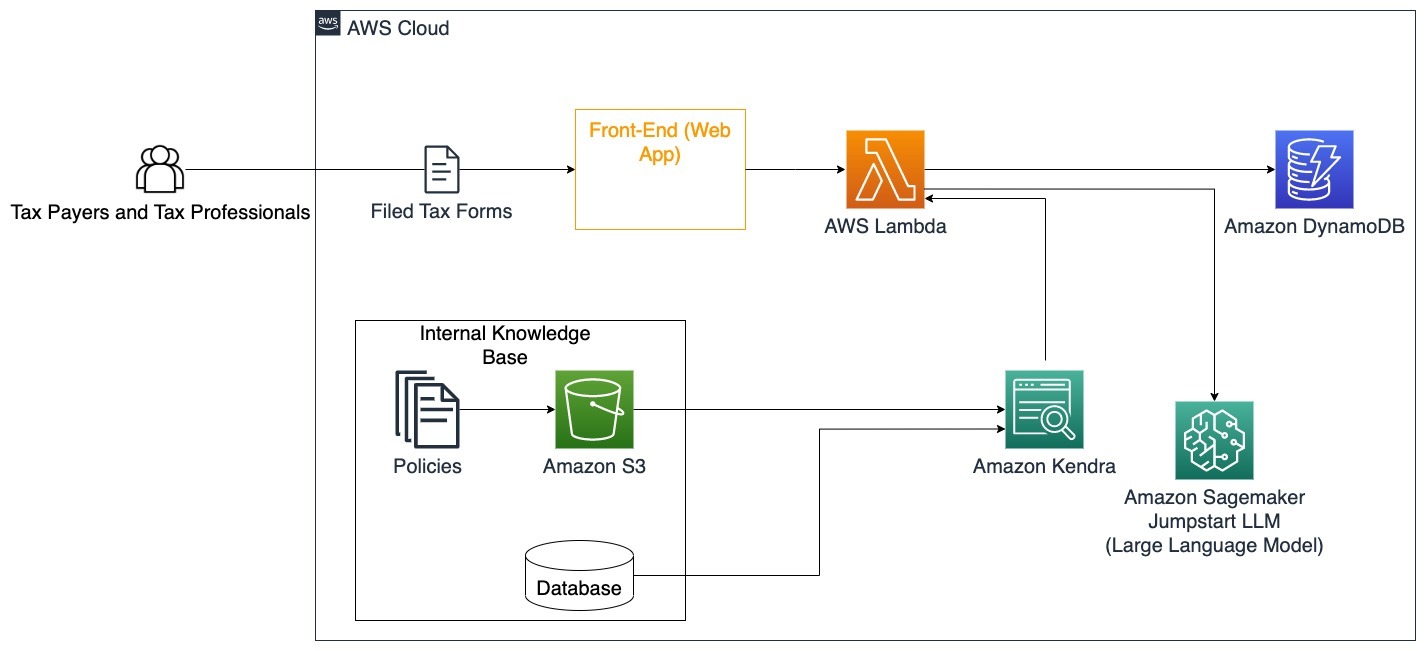

Правительство

Диалоговые боты с генеративным искусственным интеллектом могут принести большую пользу правительственным учреждениям, ускоряя процессы коммуникации, эффективности и принятия решений. Диалоговые боты с генеративным искусственным интеллектом также могут обеспечить мгновенный доступ к внутренним базам знаний, чтобы помочь государственным служащим быстро получить информацию, политику и процедуры (т. е. критерии приемлемости, процессы подачи заявок, а также услуги и поддержку граждан). Одним из решений является интерактивная система, которая позволяет налогоплательщикам и налоговым специалистам легко находить подробную информацию и льготы, связанные с налогами. Его можно использовать для понимания вопросов пользователей, обобщения налоговых документов и предоставления четких ответов посредством интерактивных бесед.

Пользователи могут задавать такие вопросы, как:

- Как работает налог на наследство и каковы налоговые пороги?

- Можете ли вы объяснить понятие подоходного налога?

- Каковы налоговые последствия при продаже второй недвижимости?

Кроме того, пользователи могут иметь возможность отправлять налоговые формы в систему, что может помочь проверить правильность предоставленной информации.

Эта архитектура показывает, как пользователи могут загружать в решение заполненные налоговые формы и использовать их для интерактивной проверки и получения рекомендаций по правильному заполнению необходимой информации.

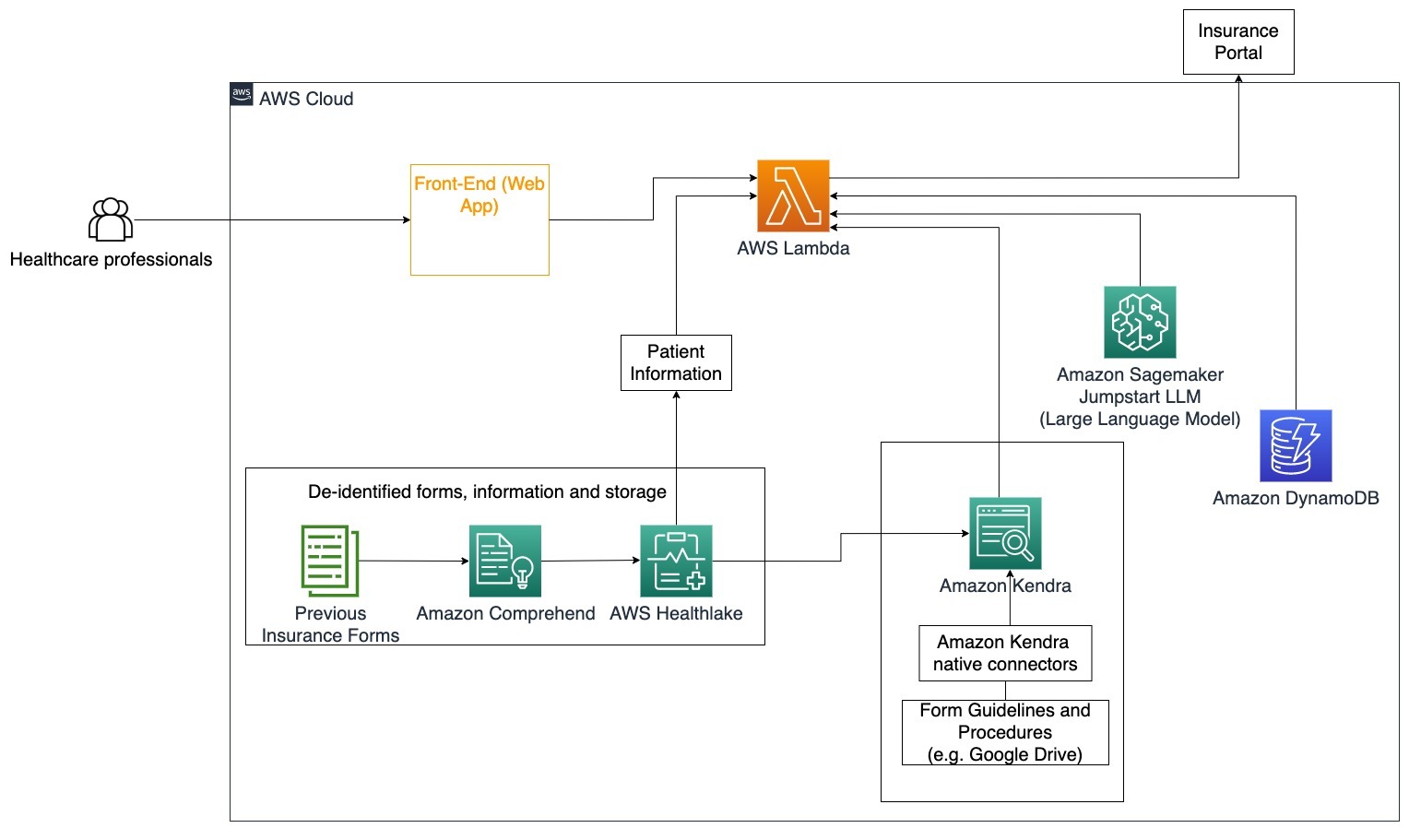

Здоровье

Предприятия здравоохранения имеют возможность автоматизировать использование больших объемов внутренней информации о пациентах, а также решать общие вопросы, касающиеся вариантов использования, таких как варианты лечения, страховые выплаты, клинические испытания и фармацевтические исследования. Использование генеративного диалогового бота с искусственным интеллектом позволяет быстро и точно генерировать ответы о медицинской информации на основе предоставленной базы знаний. Например, некоторые медицинские работники тратят много времени на заполнение форм для подачи страховых претензий.

В аналогичных условиях администраторам клинических исследований и исследователям необходимо найти информацию о вариантах лечения. Диалоговый бот с генеративным искусственным интеллектом может использовать предварительно созданные соединители в Amazon Kendra для получения наиболее актуальной информации из миллионов документов, опубликованных в результате текущих исследований, проводимых фармацевтическими компаниями и университетами.

Конкретный вариант использования: Сократите количество ошибок и время, необходимое для заполнения и отправки форм страхования.

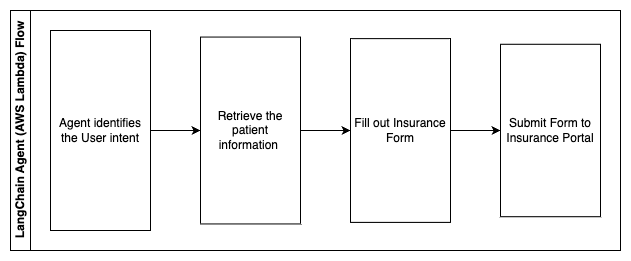

На этой архитектурной схеме медицинский работник может использовать диалогового бота с генеративным искусственным интеллектом, чтобы выяснить, какие формы необходимо заполнить для получения страховки. Затем агент LangChain может получить нужные формы и добавить необходимую информацию для пациента, а также дать ответы на описательные части форм на основе страховых полисов и предыдущих форм. Медицинский работник может редактировать ответы, предоставленные LLM, прежде чем утвердить форму и доставить ее на страховой портал.

Следующие шаги описывают функции AWS Lambda и порядок их выполнения:

- Агент LangChain для определения намерения

- Получите необходимую информацию о пациенте

- Заполните форму страхования на основе информации о пациенте и руководства по форме.

- Отправьте форму на страховой портал после одобрения пользователя.

AWS HealthLake используется для безопасного хранения медицинских данных, включая предыдущие формы страхования и информацию о пациентах, а Amazon Comprehend используется для удаления личной информации (PII) из предыдущих форм страхования. Затем сканер Amazon Kendra сможет использовать набор страховых форм и руководств для создания индекса. После того как формы будут заполнены генеративным искусственным интеллектом, формы, проверенные медицинским работником, могут быть отправлены на страховой портал.

Оценка стоимости

Стоимость развертывания базового решения для проверки концепции показана в следующей таблице. Поскольку базовое решение считается проверкой концепции, Amazon Kendra Developer Edition использовалась как недорогой вариант, поскольку рабочая нагрузка не будет использоваться в рабочей среде. Наше предположение для Amazon Kendra Developer Edition составляло 730 активных часов в месяц.

В случае Amazon SageMaker мы предположили, что клиент будет использовать экземпляр ml.g4dn.2xlarge для вывода в реальном времени с одной конечной точкой вывода для каждого экземпляра. Вы можете найти дополнительную информацию о ценах на Amazon SageMaker и доступных типах инстансов вывода. здесь.

| Сервис | Потребляемые ресурсы | Ориентировочная стоимость в месяц в долларах США |

| АМС Усиление | 150 минут сборки 1 ГБ передаваемых данных 500,000 запросов |

15.71 |

| Шлюз API Amazon | 1 млн вызовов REST API | 3.5 |

| AWS Lambda | 1 миллион запросов Продолжительность 5 секунд на запрос Выделено 2 ГБ памяти |

160.23 |

| Amazon DynamoDB | 1 миллионов прочтений 1 миллион пишет хранение 100 GB |

26.38 |

| Амазонка Мудрец | Вывод в реальном времени с помощью ml.g4dn.2xlarge | 676.8 |

| Амазон Кендра | Developer Edition с 730 часами в месяц 10,000 XNUMX отсканированных документов 5,000 запросов / день |

821.25 |

| . | . | Общая стоимость: 1703.87 |

* Amazon Cognito имеет бесплатный уровень в размере 50,000 50 активных пользователей в месяц, использующих пулы пользователей Cognito, или 2.0 активных пользователей в месяц, использующих поставщиков удостоверений SAML XNUMX.

Убирать

Чтобы сэкономить средства, удалите все ресурсы, которые вы развернули в рамках руководства. Вы можете удалить любые конечные точки SageMaker, которые вы создали, через консоль SageMaker. Помните, что удаление индекса Amazon Kendra не удаляет исходные документы из вашего хранилища.

Заключение

В этом посте мы показали вам, как упростить доступ к внутренней информации путем обобщения данных из нескольких репозиториев в режиме реального времени. После недавних разработок коммерчески доступных LLM возможности генеративного ИИ стали более очевидными. В этом посте мы продемонстрировали способы использования сервисов AWS для создания бессерверного чат-бота, который использует генеративный искусственный интеллект для ответа на вопросы. Этот подход включает уровень аутентификации и обнаружение PII Amazon Comprehend для фильтрации любой конфиденциальной информации, представленной в запросе пользователя. Будь то сотрудники здравоохранения, понимающие нюансы подачи страховых претензий, или сотрудники отдела кадров, понимающие конкретные правила всей компании, существует множество отраслей и вертикалей, которые могут извлечь выгоду из этого подхода. В основе чат-бота лежит базовая модель Amazon SageMaker JumpStart, а метод наполнения контекстом с использованием метода RAG используется для обеспечения более точной ссылки на внутренние документы в ответах.

Дополнительную информацию о работе с генеративным искусственным интеллектом на AWS см. Анонс новых инструментов для разработки с помощью генеративного ИИ на AWS. Более подробные инструкции по использованию метода RAG с сервисами AWS см. Быстро создавайте высокоточные приложения генеративного ИИ на корпоративных данных, используя Amazon Kendra, LangChain и большие языковые модели.. Поскольку подход в этом блоге не зависит от LLM, для вывода можно использовать любой LLM. В нашей следующей публикации мы опишем способы реализации этого решения с помощью Amazon Bedrock и Amazon Titan LLM.

Об авторах

Абхишек Малигехалли Шивалингайя — старший архитектор решений AI-сервисов в AWS. Он увлечен созданием приложений с использованием генеративного искусственного интеллекта, Amazon Kendra и NLP. У него около 10 лет опыта в создании решений для обработки данных и искусственного интеллекта, которые принесут пользу клиентам и предприятиям. Он даже создал (личного) чат-бота ради развлечения, чтобы отвечать на вопросы о своей карьере и профессиональном пути. Вне работы ему нравится делать портреты семьи и друзей, а также создавать произведения искусства.

Абхишек Малигехалли Шивалингайя — старший архитектор решений AI-сервисов в AWS. Он увлечен созданием приложений с использованием генеративного искусственного интеллекта, Amazon Kendra и NLP. У него около 10 лет опыта в создании решений для обработки данных и искусственного интеллекта, которые принесут пользу клиентам и предприятиям. Он даже создал (личного) чат-бота ради развлечения, чтобы отвечать на вопросы о своей карьере и профессиональном пути. Вне работы ему нравится делать портреты семьи и друзей, а также создавать произведения искусства.

Медха Айя — младший архитектор решений в AWS, базирующийся в Остине, штат Техас. Недавно в декабре 2022 года она окончила Техасский университет в Далласе со степенью магистра наук в области компьютерных наук со специализацией в области интеллектуальных систем с упором на искусственный интеллект и машинное обучение. Ей интересно узнать больше об искусственном интеллекте и машинном обучении и использовании сервисов AWS для поиска решений, которые могут принести пользу клиентам.

Медха Айя — младший архитектор решений в AWS, базирующийся в Остине, штат Техас. Недавно в декабре 2022 года она окончила Техасский университет в Далласе со степенью магистра наук в области компьютерных наук со специализацией в области интеллектуальных систем с упором на искусственный интеллект и машинное обучение. Ей интересно узнать больше об искусственном интеллекте и машинном обучении и использовании сервисов AWS для поиска решений, которые могут принести пользу клиентам.

Хьюго Це — младший архитектор решений в AWS в Сиэтле, штат Вашингтон. Он получил степень магистра информационных технологий в Университете штата Аризона и степень бакалавра экономики в Чикагском университете. Он является членом Ассоциации аудита и контроля информационных систем (ISACA) и Международного консорциума по сертификации безопасности информационных систем (ISC)2. Ему нравится помогать клиентам получать выгоду от технологий.

Хьюго Це — младший архитектор решений в AWS в Сиэтле, штат Вашингтон. Он получил степень магистра информационных технологий в Университете штата Аризона и степень бакалавра экономики в Чикагском университете. Он является членом Ассоциации аудита и контроля информационных систем (ISACA) и Международного консорциума по сертификации безопасности информационных систем (ISC)2. Ему нравится помогать клиентам получать выгоду от технологий.

Айман Ишимве — младший архитектор решений в AWS в Сиэтле, штат Вашингтон. Он получил степень магистра в области разработки программного обеспечения и информационных технологий Оклендского университета. У него есть опыт разработки программного обеспечения, в частности создания микросервисов для распределенных веб-приложений. Он с энтузиазмом помогает клиентам создавать надежные и масштабируемые решения на базе облачных сервисов AWS, следуя передовым практикам.

Айман Ишимве — младший архитектор решений в AWS в Сиэтле, штат Вашингтон. Он получил степень магистра в области разработки программного обеспечения и информационных технологий Оклендского университета. У него есть опыт разработки программного обеспечения, в частности создания микросервисов для распределенных веб-приложений. Он с энтузиазмом помогает клиентам создавать надежные и масштабируемые решения на базе облачных сервисов AWS, следуя передовым практикам.

Шервин Суреш — младший архитектор решений в AWS в Остине, штат Техас. Он получил степень магистра в области разработки программного обеспечения со специализацией в области облачных вычислений и виртуализации и степень бакалавра в области компьютерной инженерии в Университете штата Сан-Хосе. Он с энтузиазмом использует технологии для улучшения жизни людей любого происхождения.

Шервин Суреш — младший архитектор решений в AWS в Остине, штат Техас. Он получил степень магистра в области разработки программного обеспечения со специализацией в области облачных вычислений и виртуализации и степень бакалавра в области компьютерной инженерии в Университете штата Сан-Хосе. Он с энтузиазмом использует технологии для улучшения жизни людей любого происхождения.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Автомобили / электромобили, Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- ПлатонЗдоровье. Биотехнологии и клинические исследования. Доступ здесь.

- ЧартПрайм. Улучшите свою торговую игру с ChartPrime. Доступ здесь.

- Смещения блоков. Модернизация права собственности на экологические компенсации. Доступ здесь.

- Источник: https://aws.amazon.com/blogs/machine-learning/simplify-access-to-internal-information-using-retrieval-augmented-generation-and-langchain-agents/

- :имеет

- :является

- :нет

- :куда

- $UP

- 000

- 10

- 100

- 125

- 2022

- 50

- 7

- a

- в состоянии

- О нас

- Принять

- доступ

- доступа

- Учетные записи

- точный

- точно

- действия

- активный

- Добавить

- Дополнительно

- адреса

- адресация

- администраторы

- Принятие

- Консультанты

- После

- Агент

- агенты

- совокупный

- AI

- Услуги искусственного интеллекта

- AI / ML

- Все

- позволяет

- вдоль

- причислены

- альтернатива

- Amazon

- Шлюз API Amazon

- Амазон Когнито

- Amazon Comprehend

- Амазон Кендра

- Создатель мудреца Амазонки

- Amazon SageMaker JumpStart

- Amazon Web Services

- количество

- суммы

- an

- Аналитики

- анализы

- и

- ответ

- ответы

- любой

- API

- очевидный

- Применение

- Приложения

- деловое свидание, встреча

- подхода

- утвердить

- архитектура

- МЫ

- возникать

- Аризона

- около

- гайд

- искусственный

- искусственный интеллект

- Искусственный интеллект (AI)

- Картины

- AS

- спросить

- аспекты

- оценить

- помощь

- Помощь

- Юрист

- связанный

- Объединение

- предположение

- At

- аудит

- дополненная

- Остин

- подлинности

- Аутентификация

- разрешение

- автоматизировать

- автоматически

- свободных мест

- доступен

- AWS

- AWS Lambda

- назад

- фоны

- Использование темпера с изогнутым основанием

- основанный

- BE

- медведь

- , так как:

- становиться

- становится

- было

- до

- от имени

- за

- польза

- Преимущества

- ЛУЧШЕЕ

- лучшие практики

- Лучшая

- Блог

- книга

- Бот

- изоферменты печени

- боты

- Дно

- марка

- бюджет

- строить

- Строительство

- построенный

- бизнес

- бизнес

- но

- by

- призывают

- CAN

- возможности

- Карьера

- осторожно

- случаев

- случаев

- Категории

- вызванный

- Центр

- централизованная

- определенный

- Сертификация

- цепь

- проблемы

- изменение

- заряженный

- Chatbot

- контроль

- Проверки

- Чикаго

- требования

- Очистить

- Клинический

- клинические испытания

- облако

- облачных вычислений

- облачные сервисы

- собирать

- лыжных шлемов

- в промышленных масштабах

- Общий

- Связь

- Компании

- Компания

- Компании

- конкурентоспособный

- Заполненная

- комплектующие

- комплекс

- сложность

- соблюдать

- постигать

- компьютер

- Компьютерная инженерия

- Информатика

- вычисление

- концентрации

- сама концепция

- краткий

- проводятся

- слияние

- Свяжитесь

- подключает

- рассмотрение

- соображения

- считается

- последовательный

- Состоящий из

- Консоли

- консорциум

- потреблять

- потребление

- обращайтесь

- контакт-центр

- содержит

- содержание

- контекст

- непрерывно

- способствует

- контроль

- управление

- удобство

- Разговор

- диалоговый

- Беседы

- Корпоративное

- исправить

- Цена

- Расходы

- гусеничный

- Создайте

- Создать ценность

- создали

- Создающий

- кредит

- Критерии

- критической

- CRM

- решающее значение

- Куратор

- Текущий

- В настоящее время

- клиент

- Взаимодействие с клиентами

- опыт работы с клиентами

- Служба поддержки игроков

- служба поддержки

- Клиенты

- ежедневно

- Dallas

- данным

- точки данных

- наборы данных

- База данных

- Время

- Декабрь

- решать

- решение

- Принятие решений

- решения

- Степень

- поставляется

- в зависимости

- развернуть

- развертывание

- описывать

- Проект

- Несмотря на

- подробнее

- обнаруженный

- обнаружение

- Застройщик

- Развитие

- события

- различный

- трудный

- обнаружить

- распределенный

- документации

- Документация

- приносит

- не

- управлять

- продолжительность

- e

- легче

- легко

- Экономика

- экосистема

- edition

- затрат

- усилие

- или

- приемлемость

- Писем

- Сотрудник

- сотрудников

- позволяет

- призывает

- Конечная точка

- энергетика

- обязательство

- Двигатель

- Проект и

- обогащение

- обеспечивать

- обеспечивает

- обеспечение

- Предприятие

- предприятий

- лиц

- ошибки

- эскалация

- оценка

- и т.д

- Даже

- пример

- выполнять

- существующий

- дорогим

- опыт

- Объяснять

- Объясняет

- добыча

- Экстракты

- Face

- семья

- Особенность

- ФРС

- меньше

- фигура

- Файл

- заполнять

- заполненный

- заполнение

- фильтр

- финансовый

- финансовые данные

- финансовая история

- финансовое учреждение

- финансирование

- Найдите

- обнаружение

- Во-первых,

- Трансформируемость

- поток

- фокусировка

- после

- Что касается

- форма

- формы

- форумы

- найденный

- Год основания

- каркасы

- Бесплатно

- друзья

- от

- fun

- функция

- Функции

- далее

- Gain

- шлюз

- порождать

- поколение

- генеративный

- Генеративный ИИ

- получить

- данный

- дает

- Отдаете

- Правительство

- значительно

- Расти

- Рост

- Растет

- руководство

- методические рекомендации

- обрабатывать

- Ручки

- Управляемость

- Есть

- имеющий

- he

- Медицина

- информация о здоровье

- здравоохранение

- помощь

- помощь

- помогает

- ее

- High

- очень

- его

- история

- имеет

- состоялся

- хостов

- ЧАСЫ

- Как

- How To

- Однако

- hr

- HTML

- HTTPS

- человек

- i

- идентификатор

- идентификаторы

- идентифицирует

- определения

- идентифицирующий

- Личность

- if

- иллюстрирует

- осуществлять

- Осуществляющий

- последствия

- улучшать

- улучшается

- улучшение

- in

- углубленный

- неточный

- включают

- включает в себя

- В том числе

- доход

- подоходный налог

- Увеличение

- Увеличивает

- индекс

- индексированный

- Индексы

- лиц

- промышленности

- наделяют информацией

- информация

- Информационные системы

- информационная технология

- сообщил

- наследование

- вход

- пример

- мгновение

- вместо

- учреждение

- учреждения

- страхование

- интегрированный

- Интегрируется

- интеграции.

- Интеллекта

- Умный

- намерение

- взаимодействовать

- интерактивный

- заинтересованный

- Интерфейс

- в нашей внутренней среде,

- Мультиязычность

- в

- инвестиций

- вопрос

- IT

- пункты

- путешествие

- JPG

- Сохранить

- знания

- известный

- язык

- большой

- слой

- вести

- УЧИТЬСЯ

- изучение

- Меньше

- уровень

- Используя

- Библиотека

- ограничение

- недостатки

- линия

- Живет

- LLM

- варианты

- Кредиты

- журнал

- логический

- Длинное

- много времени

- дольше

- посмотреть

- серия

- любит

- бюджетный

- ниже

- верный

- Лояльность

- машина

- обучение с помощью машины

- сделанный

- поддерживать

- сделать

- ДЕЛАЕТ

- Создание

- управлять

- управление

- способ

- руководство

- вручную

- многих

- рынок

- исследования рынка

- магистра

- Май..

- означает

- основным медицинским

- член

- Память

- microservices

- Microsoft

- миллиона

- миллионы

- против

- ML

- модель

- Модели

- Модули

- Месяц

- ежемесячно

- БОЛЕЕ

- самых

- с разными

- родной

- необходимо

- Необходимость

- необходимый

- потребности

- Новые

- следующий

- НЛП

- уведомление

- номера

- Окленд

- OAuth

- of

- Предложения

- .

- Масло

- on

- Вводный

- консолидировать

- ONE

- постоянный

- только

- открытый

- работать

- операционный

- оперативный

- Возможность

- оптимизация

- Опция

- Опции

- or

- заказ

- организации

- оригинал

- Другое

- наши

- внешний

- контур

- внешнюю

- за

- парадигма

- часть

- части

- Прошло

- страстный

- пациент

- ОПЛАТИТЬ

- Люди

- для

- производительность

- Разрешения

- личного

- личные данные

- Лично

- в Фармацевтической отрасли

- мародерство

- план

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- пожалуйста

- Точка

- пунктов

- сборах

- Пулы

- Портал

- портреты

- возможности,

- возможность

- После

- Питание

- практиками

- представить

- предотвращать

- предыдущий

- предварительно

- цены

- модель ценообразования

- Предварительный

- приоритет

- политикой конфиденциальности.

- проблемам

- Процедуры

- продолжить

- процесс

- Обработанный

- Процессы

- обработка

- Производство

- производительность

- Продукция

- профессиональный

- профессионалы

- собственность

- обеспечивать

- при условии

- поставщики

- обеспечение

- опубликованный

- купленный

- Вопросы и ответы

- квалифицировать

- квалификационный

- Запросы

- вопрос

- Вопросы

- САЙТ

- быстро

- ассортимент

- Обменный курс

- Читать

- Reading

- реального времени

- последний

- недавно

- уменьшить

- снижает

- относиться

- привязка

- по

- регулярно

- правила

- отношения

- актуальность

- соответствующие

- полагаться

- остатки

- помнить

- удаление

- запросить

- Запросы

- требовать

- обязательный

- Требования

- исследованиям

- исследователи

- Постановления

- решения

- Полезные ресурсы

- ответ

- ответы

- ответственность

- ОТДЫХ

- результат

- возвращение

- отзывы

- правую

- рисках,

- надежный

- дорога

- Бег

- s

- sagemaker

- главная

- Сан -

- Сан - Хосе

- удовлетворение

- Сохранить

- масштабируемые

- Шкала

- сценарий

- Наука

- Гол

- скрипты

- Поиск

- поиск

- Сиэтл

- Во-вторых

- секунды

- Раздел

- безопасный

- безопасно

- безопасность

- продажа

- Отправить

- старший

- чувствительный

- послать

- Serverless

- служит

- обслуживание

- Услуги

- набор

- Наборы

- настройки

- несколько

- она

- сдвиг

- недостатки

- должен

- продемонстрированы

- показал

- показанный

- силосы

- аналогичный

- просто

- упростить

- с

- одинарной

- размера

- меньше

- So

- Соцсети

- Software

- разработка программного обеспечения

- разработка программного обеспечения

- Решение

- Решения

- некоторые

- Источник

- Источники

- специализация

- конкретный

- конкретно

- тратить

- Расходы

- стандарт

- Область

- Статус:

- оставаться

- Шаг

- Шаги

- По-прежнему

- диск

- магазин

- хранить

- хранение

- стресс

- начинка

- существенный

- такие

- предлагать

- суммировать

- поддержка

- система

- системы

- ТАБЛИЦЫ

- принимает

- задачи

- налог

- команда

- команды

- Технологии

- terms

- Техас

- текст

- текстовый

- который

- Ассоциация

- информация

- их

- сами

- тогда

- Там.

- Эти

- они

- сторонние

- этой

- Через

- билет

- продажи билетов

- ярус

- время

- кропотливый

- своевременно

- раз

- отметка времени

- исполин

- в

- сегодня

- Лексемы

- инструментом

- инструменты

- Прослеживаемость

- Традиционно

- специалистов

- Обучение

- трансформатор

- Прозрачность

- лечение

- суд

- испытания

- учебник

- Типы

- не в состоянии

- понимать

- понимание

- созданного

- Университеты

- Университет

- Чикагский университет

- новейший

- обновление

- обновление

- использование

- прецедент

- используемый

- Информация о пользователе

- пользователей

- использования

- через

- использовать

- использовать

- Использующий

- ценностное

- различный

- проверка

- проверить

- вертикалей

- с помощью

- Видео

- Видео

- Режимы

- ждать

- Ожидание

- законопроект

- Вашингтон

- способы

- we

- Web

- веб приложение

- веб-приложений

- веб-сервисы

- ЧТО Ж

- были

- Что

- когда

- будь то

- , которые

- в то время как

- КТО

- широкий

- Широкий диапазон

- в

- Работа

- рабочий

- работает

- бы

- письменный

- лет

- Ты

- ВАШЕ

- зефирнет