Generativna umetna inteligenca je postala običajno orodje za izboljšanje in pospeševanje ustvarjalnega procesa v različnih panogah, vključno z zabavo, oglaševanjem in grafičnim oblikovanjem. Omogoča bolj prilagojene izkušnje za občinstvo in izboljša splošno kakovost končnih izdelkov.

Ena od pomembnih prednosti generativne umetne inteligence je ustvarjanje edinstvenih in prilagojenih izkušenj za uporabnike. Storitve pretakanja na primer uporabljajo generativno umetno inteligenco za ustvarjanje prilagojenih naslovov filmov in vizualnih elementov za povečanje angažiranosti gledalcev in gradnjo vizualnih elementov za naslove na podlagi uporabnikove zgodovine ogledov in preferenc. Sistem nato ustvari na tisoče različic umetniškega dela naslova in jih preizkusi, da ugotovi, katera različica najbolj pritegne pozornost uporabnika. V nekaterih primerih so personalizirane umetnine za TV-serije znatno povečale razmerje med prikazi in kliki ter stopnje ogledov v primerjavi z oddajami brez personaliziranih umetnin.

V tej objavi prikazujemo, kako lahko uporabite generativne modele umetne inteligence, kot je Stable Diffusion, da ustvarite prilagojeno rešitev za avatarje Amazon SageMaker in hkrati prihranite stroške sklepanja z večmodelnimi končnimi točkami (MME). Rešitev prikazuje, kako lahko z nalaganjem 10–12 slik sebe natančno prilagodite prilagojeni model, ki lahko nato ustvari avatarje na podlagi katerega koli besedilnega poziva, kot je prikazano na naslednjih posnetkih zaslona. Čeprav ta primer ustvarja prilagojene avatarje, lahko tehniko uporabite za katero koli ustvarjalno umetniško generacijo s fino nastavitvijo določenih predmetov ali slogov.

Pregled rešitev

Naslednji diagram arhitekture opisuje celovito rešitev za naš generator avatarjev.

![]()

Obseg te objave in primer Koda GitHub osredotočamo se le na usposabljanje modela in orkestracijo sklepanja (zeleni del v prejšnjem diagramu). Lahko se sklicujete na celotno arhitekturo rešitve in nadgrajujete primer, ki ga ponujamo.

Usposabljanje modela in sklepanje je mogoče razdeliti na štiri korake:

- Naloži slike v Preprosta storitev shranjevanja Amazon (Amazon S3). V tem koraku vas prosimo, da zagotovite najmanj 10 svojih slik visoke ločljivosti. Več slik, boljši je rezultat, vendar dlje bo trajalo usposabljanje.

- Natančno prilagodite osnovni model Stable Diffusion 2.1 z uporabo asinhronega sklepanja SageMaker. V nadaljevanju te objave razložimo razloge za uporabo končne točke sklepanja za usposabljanje. Postopek natančnega prilagajanja se začne s pripravo slik, vključno z obrezovanjem obraza, spreminjanjem ozadja in spreminjanjem velikosti modela. Nato uporabimo Low-Rank Adaptation (LoRA), parametrsko učinkovito tehniko natančnega prilagajanja za velike jezikovne modele (LLM), da natančno prilagodimo model. Na koncu v naknadni obdelavi zapakiramo natančno nastavljene uteži LoRA s skriptom sklepanja in konfiguracijskimi datotekami (tar.gz) ter jih naložimo na lokacijo vedra S3 za MME SageMaker.

- Gostite natančno nastavljene modele z uporabo SageMaker MME z GPE. SageMaker bo dinamično naložil in predpomnil model z lokacije Amazon S3 na podlagi prometa sklepanja za vsak model.

- Za sklepanje uporabite natančno nastavljen model. Po Amazon Simple notification Service (Amazon SNS), ki nakazuje, da je fina nastavitev poslana, lahko ta model takoj uporabite tako, da predložite

target_modelparameter, ko prikličete MME za ustvarjanje vašega avatarja.

Vsak korak podrobneje razložimo v naslednjih razdelkih in se sprehodimo skozi nekaj vzorčnih izrezkov kode.

Pripravite slike

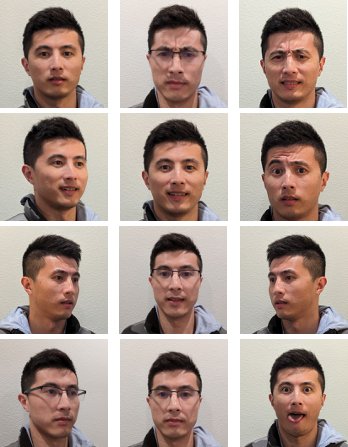

Če želite doseči najboljše rezultate pri natančnem prilagajanju stabilne difuzije za ustvarjanje slik sebe, morate običajno zagotoviti veliko količino in raznolikost svojih fotografij iz različnih zornih kotov, z različnimi izrazi in v različnih ozadjih. Z našo implementacijo pa lahko sedaj dosežete visokokakovosten rezultat že z 10 vhodnimi slikami. Dodali smo tudi avtomatizirano predhodno obdelavo za izločitev vašega obraza iz vsake fotografije. Vse kar potrebujete je, da jasno ujamete bistvo svojega videza iz več perspektiv. Vključite sprednjo fotografijo, profilni posnetek z obeh strani in fotografije iz vmesnih kotov. Vključite tudi fotografije z različnimi obraznimi izrazi, kot so nasmeh, namrščenost in nevtralen izraz. Mešanica izrazov bo modelu omogočila boljšo reprodukcijo vaših edinstvenih potez obraza. Vhodne slike narekujejo kakovost avatarja, ki ga lahko ustvarite. Da bi zagotovili, da je to opravljeno pravilno, priporočamo intuitivno izkušnjo sprednjega uporabniškega vmesnika, ki uporabnika vodi skozi postopek zajema in nalaganja slike.

Sledijo primeri selfie slik pod različnimi koti z različnimi obraznimi izrazi.

![]()

Natančno prilagodite model stabilne difuzije

Ko so slike naložene v Amazon S3, lahko prikličemo Asinhroni sklep SageMaker končno točko za začetek našega procesa usposabljanja. Asinhrone končne točke so namenjene primerom uporabe sklepanja z velikimi koristnimi obremenitvami (do 1 GB) in dolgimi časi obdelave (do 1 ure). Poleg drugih izvornih funkcij gostovanja SageMaker, kot je samodejno skaliranje, ponuja tudi vgrajen mehanizem čakalne vrste za postavljanje zahtev v čakalno vrsto in mehanizem obveščanja o zaključku naloge prek Amazon SNS.

Čeprav fino uravnavanje ni primer uporabe sklepanja, smo se odločili, da ga tukaj uporabimo namesto izobraževalnih opravil SageMaker zaradi njegovih vgrajenih mehanizmov za čakalno vrsto in obveščanje ter upravljano samodejno skaliranje, vključno z možnostjo zmanjšanja na 0 primerkov, ko storitev ni v uporabi. To nam omogoča enostavno prilagajanje storitve natančnega prilagajanja velikemu številu sočasnih uporabnikov in odpravlja potrebo po implementaciji in upravljanju dodatnih komponent. Vendar ima pomanjkljivost 1 GB obremenitve in 1 uro najdaljšega časa obdelave. Pri našem testiranju smo ugotovili, da je 20 minut dovolj časa za doseganje razmeroma dobrih rezultatov s približno 10 vhodnimi slikami na primerku ml.g5.2xlarge. Vendar bi bilo usposabljanje za SageMaker priporočljiv pristop za obsežnejša dela natančnega prilagajanja.

Za gostovanje asinhrone končne točke moramo opraviti več korakov. Prvi je definiranje našega modela strežnika. Za to objavo uporabljamo Velik vsebnik za sklepanje modela (LMI). LMI poganja DJL Serving, ki je visoko zmogljiva rešitev za streženje modela, ki ni odvisna od programskega jezika. To možnost smo izbrali, ker ima vsebnik sklepanja, ki ga upravlja SageMaker, že veliko izobraževalnih knjižnic, ki jih potrebujemo, kot je Hugging Face Difuzorji in Pospešite. To močno zmanjša količino dela, potrebnega za prilagajanje vsebnika za naše delo natančnega prilagajanja.

Naslednji delček kode prikazuje različico vsebnika LMI, ki smo jo uporabili v našem primeru:

Poleg tega moramo imeti a serving.properties datoteka, ki konfigurira lastnosti strežbe, vključno z mehanizmom za sklepanje, lokacijo artefakta modela in dinamičnim paketnim združevanjem. Nazadnje moramo imeti a model.py datoteka, ki naloži model v mehanizem sklepanja in pripravi vnos in izhod podatkov iz modela. V našem primeru uporabljamo model.py datoteko za pospešitev opravila natančnega prilagajanja, kar bomo podrobneje razložili v kasnejšem razdelku. Oba serving.properties in model.py datoteke so na voljo v training_service mapa.

Naslednji korak po definiranju našega modelnega strežnika je izdelava konfiguracije končne točke, ki določa, kako bo postrežen naš asinhroni sklep. Za naš primer samo definiramo največjo omejitev sočasnega klicanja in izhodno lokacijo S3. z ml.g5.2xlarge Na primer, ugotovili smo, da lahko natančno prilagodimo do dva modela hkrati, ne da bi naleteli na izjemo zmanjkanja pomnilnika (OOM), zato smo nastavili max_concurrent_invocations_per_instance na 2. To število bo morda treba prilagoditi, če uporabljamo drugačen niz parametrov za uglaševanje ali manjši tip primerka. Priporočamo, da to na začetku nastavite na 1 in spremljate uporabo pomnilnika GPE amazoncloudwatch.

Nazadnje ustvarimo model SageMaker, ki zapakira informacije vsebnika, datoteke modela in AWS upravljanje identitete in dostopa (IAM) v en sam objekt. Model je razporejen s konfiguracijo končne točke, ki smo jo definirali prej:

Ko je končna točka pripravljena, uporabimo naslednjo vzorčno kodo za priklic asinhrone končne točke in začetek postopka natančnega prilagajanja:

Za več podrobnosti o LMI na SageMakerju glejte Razmestite velike modele v Amazon SageMaker z vzporednim sklepanjem modelov DJLServing in DeepSpeed.

Po priklicu začne asinhrona končna točka postavljati naše opravilo natančnega prilagajanja v čakalno vrsto. Vsako opravilo poteka skozi naslednje korake: priprava slik, izvedba natančne nastavitve Dreambooth in LoRA ter priprava artefaktov modela. Potopimo se globlje v postopek natančne nastavitve.

Pripravite slike

Kot smo že omenili, kakovost vhodnih slik neposredno vpliva na kakovost natančno nastavljenega modela. Za primer uporabe avatarja želimo, da se model osredotoči na poteze obraza. Namesto da bi od uporabnikov zahtevali, da zagotovijo skrbno izbrane slike točne velikosti in vsebine, izvajamo korak predprocesiranja s tehnikami računalniškega vida, da ublažimo to breme. V koraku predprocesiranja najprej uporabimo model zaznavanja obrazov, da izoliramo največji obraz na vsaki sliki. Nato obrežemo in podložimo sliko na zahtevano velikost 512 x 512 slikovnih pik za naš model. Na koncu segmentiramo obraz iz ozadja in dodamo naključne različice ozadja. To pomaga poudariti poteze obraza, kar našemu modelu omogoča, da se uči iz samega obraza in ne iz ozadja. Naslednje slike prikazujejo tri korake v tem procesu.

| Korak 1: Zaznavanje obrazov z uporabo računalniškega vida | Korak 2: Obrežite in razširite sliko na 512 x 512 slikovnih pik | 3. korak (izbirno): Segmentirajte in dodajte različico ozadja |

Natančna nastavitev Dreambooth in LoRA

Za fino nastavitev smo združili tehnike Dreambooth in LoRA. Dreambooth vam omogoča, da prilagodite svoj model Stable Diffusion, z vdelavo subjekta v izhodno domeno modela z uporabo edinstvenega identifikatorja in razširitvijo slovarja jezikovne vizije modela. Uporablja metodo, imenovano predhodno konzerviranje ohraniti semantično znanje modela o razredu subjekta, v tem primeru osebe, in uporabiti druge objekte v razredu za izboljšanje končnega rezultata slike. Tako lahko Dreambooth doseže visokokakovostne rezultate s samo nekaj vhodnimi slikami predmeta.

Naslednji delček kode prikazuje vnose v naš trainer.py razreda za našo rešitev za avatarje. Upoštevajte, da smo izbrali <<TOK>> kot enolični identifikator. To je narejeno namenoma, da se izognemo izbiri imena, ki je morda že v slovarju modela. Če ime že obstaja, se mora model odučiti in nato ponovno naučiti predmet, kar lahko povzroči slabe rezultate natančnega prilagajanja. Predmetni razred je nastavljen na “a photo of person”, ki omogoča predhodno ohranitev tako, da najprej ustvari fotografije ljudi, ki se dodajo kot dodatni vložki med postopkom natančnega prilagajanja. To bo pomagalo zmanjšati prekomerno opremljanje, saj poskuša model ohraniti prejšnje znanje osebe z uporabo predhodne metode ohranjanja.

V konfiguraciji so bile omogočene številne možnosti za varčevanje s pomnilnikom, vključno z fp16, use_8bit_adamin kopičenje gradienta. To zmanjša pomnilniški odtis na manj kot 12 GB, kar omogoča natančno nastavitev do dveh modelov hkrati na ml.g5.2xlarge na primer.

LoRA je učinkovita tehnika natančnega prilagajanja za LLM, ki zamrzne večino uteži in pritrdi majhno omrežje adapterjev na določene plasti vnaprej usposobljenega LLM, kar omogoča hitrejše usposabljanje in optimizirano shranjevanje. Za stabilno razširjanje je adapter pritrjen na kodirnik besedila in komponente U-Net inferenčnega cevovoda. Kodirnik besedila pretvori vhodni poziv v latentni prostor, ki ga razume model U-Net, model U-Net pa uporabi latentni pomen za ustvarjanje slike v nadaljnjem procesu razširjanja. Rezultat natančne nastavitve je samo text_encoder in uteži adapterjev U-Net. V času sklepanja je mogoče te uteži znova pritrditi na osnovni model stabilne difuzije za reprodukcijo rezultatov natančne nastavitve.

Spodnje slike so podroben diagram natančnega prilagajanja LoRA, ki ga je zagotovil izvirni avtor: Cheng-Han Chiang, Yung-Sung Chuang, Hung-yi Lee, »AACL_2022_tutorial_PLMs«, 2022

S kombinacijo obeh metod smo lahko ustvarili personaliziran model, medtem ko smo prilagodili za velikostni red manj parametrov. To je povzročilo veliko hitrejši čas usposabljanja in zmanjšano uporabo GPE. Poleg tega je bil shramba optimizirana s težo adapterja le 70 MB v primerjavi s 6 GB za polni model Stable Diffusion, kar predstavlja 99-odstotno zmanjšanje velikosti.

Pripravite artefakte modela

Ko je fina nastavitev končana, bo korak naknadne obdelave TAR uteži LoRA z ostalimi datotekami za streženje modela za NVIDIA Triton. Uporabljamo zaledje Python, kar pomeni, da sta potrebna konfiguracijska datoteka Triton in skript Python, uporabljen za sklepanje. Upoštevajte, da mora biti skript Python poimenovan model.py. Datoteka TAR končnega modela mora imeti naslednjo strukturo datotek:

Gostite natančno nastavljene modele z uporabo SageMaker MME z GPE

Ko so modeli natančno nastavljeni, z uporabo SageMaker MME gostimo prilagojene modele Stable Diffusion. SageMaker MME je zmogljiva funkcija uvajanja, ki omogoča gostovanje več modelov v enem vsebniku za eno končno točko. Samodejno upravlja promet in usmerjanje do vaših modelov, da optimizira uporabo virov, prihrani stroške in minimizira operativno breme upravljanja na tisoče končnih točk. V našem primeru delujemo na instancah GPU, SageMaker MME pa podpirajo GPU s strežnikom Triton. To vam omogoča izvajanje več modelov na eni napravi GPE in izkoriščanje prednosti pospešenega računanja. Za več podrobnosti o tem, kako gostiti Stable Diffusion na SageMaker MME, glejte Ustvarite visokokakovostne slike z modeli Stable Diffusion in jih stroškovno učinkovito uvedite z Amazon SageMaker.

Za naš primer smo naredili dodatno optimizacijo za hitrejše nalaganje natančno nastavljenih modelov med situacijami hladnega zagona. To je mogoče zaradi zasnove adapterja LoRA. Ker so uteži osnovnega modela in okolja Conda enaki za vse natančno nastavljene modele, lahko te skupne vire delimo tako, da jih vnaprej naložimo v vsebnik gostovanja. Tako ostane samo konfiguracijska datoteka Triton, Python backend (model.py), in uteži adapterja LoRA, ki se dinamično naložijo iz Amazona S3 po prvem priklicu. Naslednji diagram prikazuje vzporedno primerjavo.

![]()

To bistveno zmanjša datoteko modela TAR s približno 6 GB na 70 MB, zato jo je veliko hitreje naložiti in razpakirati. Za izvedbo prednalaganja v našem primeru smo ustvarili pomožni zaledni model Python models/model_setup. Skript preprosto prekopira osnovni model Stable Diffusion in okolje Conda iz Amazon S3 na skupno lokacijo za skupno rabo med vsemi natančno nastavljenimi modeli. Sledi delček kode, ki izvede nalogo:

Nato bo vsak natančno nastavljen model pokazal na skupno lokacijo na vsebniku. Okolje Conda je navedeno v config.pbtxt.

Osnovni model Stable Diffusion se naloži iz initialize() funkcijo vsakega model.py mapa. Nato uporabimo prilagojene uteži LoRA na unet in text_encoder model za reprodukcijo vsakega natančno nastavljenega modela:

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Avtomobili/EV, Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- BlockOffsets. Posodobitev okoljskega offset lastništva. Dostopite tukaj.

- vir: https://aws.amazon.com/blogs/machine-learning/build-a-personalized-avatar-with-generative-ai-using-amazon-sagemaker/

- :ima

- : je

- :ne

- :kje

- $GOR

- 1

- 10

- 100

- 12

- 13

- 15%

- 17

- 20

- 32

- 7

- 70

- 700

- 8

- 9

- a

- sposobnost

- Sposobna

- O meni

- pospešeno

- pospeševanje

- dostop

- dostopen

- akumulacija

- Doseči

- čez

- prilagoditev

- dodajte

- dodano

- Poleg tega

- Dodatne

- Poleg tega

- Prilagojen

- Prednost

- Oglaševanje

- po

- AI

- AI modeli

- Storitve AI

- AI / ML

- vsi

- ublažiti

- omogočajo

- Dovoli

- omogoča

- že

- Prav tako

- Čeprav

- amater

- Amazon

- Amazon SageMaker

- Amazon Web Services

- Ambient

- znesek

- an

- anatomija

- in

- kaj

- aplikacije

- Uporabi

- pristop

- približno

- Arhitektura

- SE

- Umetnost

- umetniško delo

- AS

- Sredstva

- pomoč

- At

- pozornosti

- Privlači

- občinstva

- Avtor

- avto

- Avtomatizirano

- samodejno

- Na voljo

- avatar

- avatarji

- izogniti

- AWS

- Backend

- ozadje

- ozadja

- Slab

- baza

- temeljijo

- Osnovni

- BE

- ker

- postanejo

- bilo

- zadaj

- počutje

- spodaj

- koristi

- BEST

- Boljše

- med

- telo

- tako

- Broken

- izgradnjo

- vgrajeno

- obremenitev

- poslovni

- vendar

- by

- Cache

- se imenuje

- CAN

- Zmogljivosti

- zajemanje

- previdno

- primeru

- primeri

- ujete

- izzivi

- Stroški

- izbral

- filmsko

- mestno pokrajino

- razred

- jasno

- Koda

- hladno

- kombinirani

- združevanje

- kako

- Skupno

- v primerjavi z letom

- Primerjava

- dokončanje

- dokončanje

- kompleksna

- deli

- sestava

- Izračunajte

- računalnik

- Računalniška vizija

- Koncept

- sočasno

- konfiguracija

- Posoda

- vsebina

- pretvorbo

- Core

- strošek

- stroški

- Ovitki

- ustvarjajo

- ustvaril

- Ustvarjanje

- kreacije

- Creative

- pridelek

- kurirano

- Trenutno

- Stranke, ki so

- prilagodite

- meri

- Cut

- datum

- dan

- namenjen

- globoko

- globoko učenje

- globlje

- opredeliti

- opredeljen

- Določa

- definiranje

- Demokratiziranje

- izkazati

- Dokazano

- dokazuje,

- razporedi

- razporejeni

- uvajanja

- uvajanje

- Oblikovanje

- Podatki

- podrobno

- Podrobnosti

- Odkrivanje

- Ugotovite,

- Razvojni

- naprava

- drugačen

- Difuzija

- neposredno

- razne

- Naredi sam

- do

- ne

- domena

- opravljeno

- navzdol

- Osnutek

- sestavljene

- 2

- med

- dinamično

- dinamično

- e

- e-trgovina

- vsak

- prej

- enostavno

- učinkovite

- odpravlja

- vdelava

- omogočena

- omogoča

- srečanje

- spodbujanje

- konec koncev

- Endless

- Končna točka

- sodelovanje

- Motor

- Inženiring

- okrepi

- izboljšanje

- Podjetje

- Zabava

- okolje

- okolja

- EPIC

- Bistvo

- Primer

- Primeri

- Razen

- izjema

- obstaja

- širi

- izkušnje

- Doživetja

- poskus

- strokovno znanje

- Pojasnite

- raziskuje

- izpostavljena

- izraz

- izrazi

- dodatna

- ekstrakt

- Obraz

- obraza

- Napaka

- družina

- hitreje

- Feature

- Lastnosti

- Feet

- Nekaj

- manj

- Številke

- file

- datoteke

- končna

- končno

- finančna

- prva

- Osredotočite

- osredotočena

- Osredotoča

- po

- Odtis

- za

- je pokazala,

- štiri

- FRAME

- iz

- polno

- funkcija

- Games

- igre na srečo

- ustvarjajo

- ustvarja

- ustvarjajo

- generacija

- generativno

- Generativna AI

- generator

- dobili

- gif

- GitHub

- Cilj

- dogaja

- dobro

- GPU

- Grafično

- več

- zelo

- Zelen

- bruto

- vodi

- roke

- Imajo

- ob

- he

- pomoč

- pomoč

- Pomaga

- jo

- tukaj

- visokozmogljivo

- visoka kvaliteta

- visoka ločljivost

- Označite

- zelo

- njegov

- zgodovina

- upam,

- gostitelj

- gostovanje

- uro

- Hiša

- Kako

- Kako

- Vendar

- HTML

- http

- HTTPS

- identifikator

- identiteta

- if

- slika

- slike

- takoj

- Vplivi

- izvajati

- Izvajanje

- izboljšanje

- in

- vključujejo

- Vključno

- Povečajte

- povečal

- individualnost

- industrij

- Industrija

- Podatki

- informativni

- na začetku

- inovativne

- inovativne tehnologije

- vhod

- vhodi

- navdihujoča

- primer

- Namesto

- Navodila

- zavarovanje

- namenjen

- obresti

- v

- intuitivno

- IT

- ITS

- sam

- james

- Job

- Delovna mesta

- pridružil

- jpg

- json

- samo

- samo en

- Ključne

- znanje

- label

- jezik

- velika

- Največji

- pozneje

- plasti

- vodi

- Vodja

- Vodstvo

- UČITE

- učenje

- Lee

- knjižnice

- Razsvetljava

- kot

- LIMIT

- LLM

- obremenitev

- obremenitve

- kraj aktivnosti

- Long

- več

- Poglej

- ljubezen

- nizka

- stroj

- strojno učenje

- je

- Glavne

- Znamka

- Izdelava

- upravljanje

- upravlja

- upravitelj

- upravlja

- upravljanje

- več

- Trženje

- Trženje in oglaševanje

- največja

- Maj ..

- kar pomeni,

- pomeni

- Mehanizem

- Mehanizmi

- mediji

- Spomin

- omenjeno

- Sporočilo

- Metoda

- Metode

- minimalna

- Minute

- mix

- ML

- Model

- modeli

- zmernost

- spremljanje

- več

- Najbolj

- motivirani

- Film

- veliko

- več

- morajo

- Ime

- Imenovan

- materni

- naravna

- Obdelava Natural Language

- Nimate

- mreža

- Nevtralna

- Naslednja

- Noben

- prenosnik

- Opaziti..

- Obvestilo

- zdaj

- Številka

- Nvidia

- predmet

- predmeti

- of

- off

- Olje

- on

- ONE

- samo

- na

- operativno

- optimizacija

- Optimizirajte

- optimizirana

- Možnost

- možnosti

- or

- orkestracijo

- izvirno

- OS

- Ostalo

- naši

- ven

- obrisi

- izhod

- več

- Splošni

- paket

- pakete

- pad

- vzporedno

- parameter

- parametri

- del

- opravil

- strastno

- pot

- ljudje

- popolna

- Izvedite

- opravlja

- oseba

- Osebnost

- prilagodite

- Prilagojene

- perspektive

- fotografija

- slike

- slika

- cevi

- plinovod

- Platforme

- platon

- Platonova podatkovna inteligenca

- PlatoData

- Točka

- slaba

- portret

- možnosti

- mogoče

- Prispevek

- potencial

- poganja

- močan

- Predictor

- nastavitve

- Pripravimo

- Pripravlja

- priprava

- ohranjanje

- prejšnja

- primarni

- Tiskanje

- Predhodna

- Postopek

- obravnavati

- Izdelek

- produktni vodja

- Izdelki

- profil

- Programiranje

- projekti

- Spodbujanje

- pravilno

- Lastnosti

- zagotavljajo

- če

- zagotavlja

- Python

- kakovost

- Količina

- naključno

- območje

- Cene

- precej

- utemeljitev

- reading

- pripravljen

- Priporočamo

- priporočeno

- zmanjša

- Zmanjšana

- zmanjšuje

- Zmanjšanje

- odražajo

- o

- povezane

- predstavlja

- zahteva

- zahteva

- obvezna

- vir

- viri

- Odgovor

- odgovorna

- REST

- povzroči

- Rezultati

- Rockstar

- vloga

- grobo

- usmerjanje

- Run

- deluje

- sagemaker

- Sklep SageMaker

- Enako

- Shrani

- Lestvica

- skaliranje

- sci-fi

- Obseg

- galerija

- Oddelek

- oddelki

- glej

- seme

- Segment

- SAMO

- Self

- višji

- poslan

- Serija

- Storitev

- Storitve

- služijo

- nastavite

- nastavitev

- nastavitev

- več

- Oblikujte

- Delite s prijatelji, znanci, družino in partnerji :-)

- deli

- oster

- je

- shot

- shouldnt

- pokazale

- Razstave

- strani

- pomemben

- bistveno

- Simon

- Enostavno

- preprosto

- sam

- situacije

- Velikosti

- majhna

- manj

- delček

- socialna

- družbeni mediji

- socialne platforme

- Rešitev

- rešitve

- nekaj

- Vesolje

- specialist

- specializacijo

- specifična

- Poraba

- Spin

- stabilna

- Začetek

- začel

- začne

- Korak

- Koraki

- shranjevanje

- shranjeni

- pretakanje

- pretakanje storitev

- String

- Struktura

- predmet

- kasneje

- uspešno

- taka

- dovolj

- dobavo

- podpora

- Preverite

- sistem

- Bodite

- Naloga

- skupina

- TechCrunch

- tehnike

- Tehnologije

- Tehnologija

- Testiranje

- testi

- kot

- da

- O

- njihove

- Njih

- POTEM

- zato

- te

- ta

- čeprav?

- mislil

- miselno vodstvo

- tisoče

- 3

- skozi

- čas

- krat

- naslove

- do

- orodje

- vrh

- Prometa

- Vlak

- usposabljanje

- preoblikovanje

- Potovanje

- Triton

- poskusite

- tv

- dva

- tip

- tipično

- ui

- pod

- razumel

- edinstven

- nepotrebna

- naložili

- Prenos

- us

- ZDA

- uporaba

- primeru uporabe

- Rabljeni

- uporabnik

- Uporabniki

- uporablja

- uporabo

- pripomoček

- uporabiti

- vrednost

- raznolikost

- različnih

- različica

- preko

- Poglej

- ogled

- Virginia

- Vizija

- slike

- želeli

- je

- vodni žig

- we

- web

- spletne storitve

- teža

- so bili

- Kaj

- kdaj

- ki

- medtem

- katerih

- široka

- Širok spekter

- bo

- z

- brez

- delo

- deluje

- Klobase

- bi

- X

- let

- Vi

- Vaša rutina za

- sami

- zefirnet