Podatki spreminjajo vsako področje in vsako podjetje. Ker pa podatki rastejo hitreje, kot lahko večina podjetij sledi, je zbiranje podatkov in pridobivanje vrednosti iz teh podatkov izziv. A sodobna podatkovna strategija vam lahko pomaga ustvariti boljše poslovne rezultate s podatki. AWS ponuja najpopolnejši nabor storitev za podatkovno potovanje od konca do konca da vam pomaga odkleni vrednost iz svojih podatkov in ga spremeni v vpogled.

Podatkovni znanstveniki lahko porabijo do 80 % svojega časa za pripravo podatkov za projekte strojnega učenja (ML). Ta postopek priprave je večinoma nediferencirano in dolgočasno delo ter lahko vključuje več programskih API-jev in knjižnic po meri. Amazon SageMaker Data Wrangler pomaga podatkovnim znanstvenikom in podatkovnim inženirjem poenostaviti in pospešiti pripravo tabelarnih in časovnih vrst podatkov ter inženiring funkcij prek vizualnega vmesnika. Podatke lahko uvozite iz več podatkovnih virov, kot npr Preprosta storitev shranjevanja Amazon (Amazon S3), Amazonska Atena, Amazon RedShift, ali celo rešitve tretjih oseb, kot je Snowflake or DataBricks, in obdelujte svoje podatke z več kot 300 vgrajenimi transformacijami podatkov in knjižnico izrezkov kode, tako da lahko hitro normalizirate, transformirate in kombinirate funkcije, ne da bi pisali kodo. Svoje transformacije po meri lahko prenesete tudi v PySpark, SQL ali Pandas.

Ta objava prikazuje, kako lahko načrtujete samodejno izvajanje opravil za pripravo podatkov. Raziskujemo tudi novo zmogljivost Data Wrangler za parametrizirane nize podatkov, ki vam omogoča, da določite datoteke, ki bodo vključene v tok podatkov s pomočjo parametriziranih URI-jev.

Pregled rešitev

Data Wrangler zdaj podpira uvoz podatkov z uporabo parametriranega URI-ja. To omogoča dodatno prilagodljivost, saj lahko zdaj uvozite vse nabore podatkov, ki se ujemajo z navedenimi parametri, ki so lahko tipa String, Number, Datetime in Pattern, v URI. Poleg tega lahko zdaj sprožite opravila transformacije Data Wrangler po urniku.

V tej objavi ustvarimo vzorčni tok z naborom podatkov Titanic, da pokažemo, kako lahko začnete eksperimentirati s tema dvema novima funkcijama Data Wranglerja. Če želite prenesti nabor podatkov, glejte Titanik – strojno učenje iz katastrofe.

Predpogoji

Za pridobitev vseh funkcij, opisanih v tej objavi, morate uporabljati najnovejšo različico jedra Data Wranglerja. Za več informacij glejte Posodobite Data Wrangler. Poleg tega morate teči Amazon SageMaker Studio JupyterLab 3. Če si želite ogledati trenutno različico in jo posodobiti, glejte JupyterLab Versioning.

Struktura datoteke

Za to predstavitev sledimo preprosti datotečni strukturi, ki jo morate ponoviti, da lahko ponovite korake, opisane v tej objavi.

- V studiu, ustvarite nov zvezek.

- Zaženite naslednji delček kode, da ustvarite strukturo mape, ki jo uporabljamo (prepričajte se, da ste v želeni mapi v drevesu datotek):

- Kopirajte

train.csvintest.csvdatoteke iz izvirnega nabora podatkov Titanik v mapetitanic_dataset/trainintitanic_dataset/testOz. - Zaženite naslednji delček kode, da napolnite mape s potrebnimi datotekami:

Razdelimo si train.csv podatkovnega niza Titanik v devet različnih datotek, poimenovanih part_x, kjer je x številka dela. Del 0 ima prvih 100 zapisov, del 1 naslednjih 100 in tako naprej do dela 8. Vsaka mapa vozlišča datotečnega drevesa vsebuje kopijo devetih delov podatkov o usposabljanju, razen train in test mape, ki vsebujejo train.csv in test.csv.

Parametrizirani nizi podatkov

Uporabniki Data Wrangler lahko zdaj določijo parametre za nabore podatkov, uvožene iz Amazon S3. Parametri nabora podatkov so določeni v URI-ju virov, njegovo vrednost pa je mogoče dinamično spreminjati, kar omogoča večjo prilagodljivost pri izbiri datotek, ki jih želimo uvoziti. Parametri so lahko štiri vrste podatkov:

- Število – Lahko sprejme vrednost katerega koli celega števila

- String – Lahko sprejme vrednost katerega koli besedilnega niza

- Vzorec – Lahko sprejme vrednost katerega koli regularnega izraza

- Datum – Lahko sprejme vrednost katerega koli od podprtih formatov datuma/časa

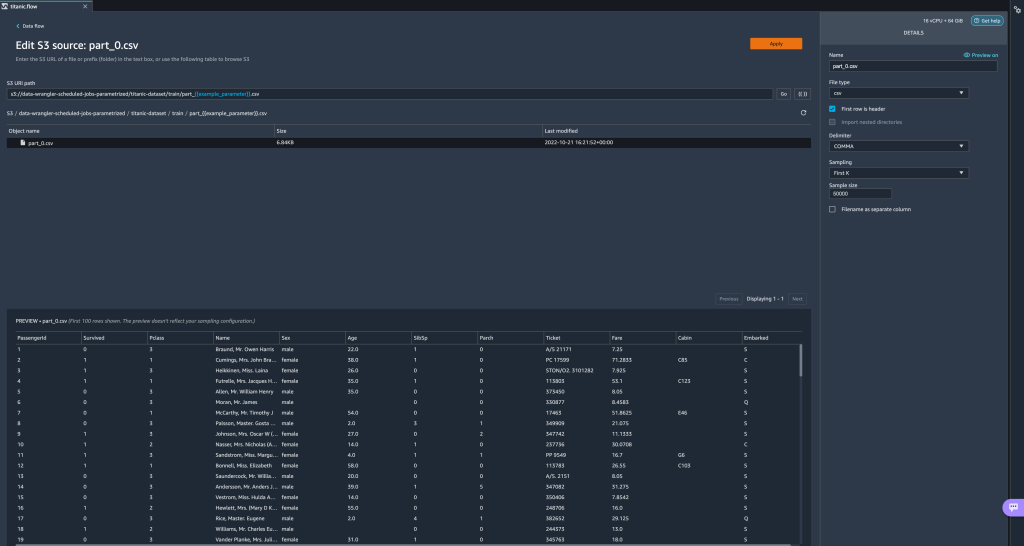

V tem razdelku ponujamo predstavitev te nove funkcije. To je na voljo šele, ko svoj nabor podatkov uvozite v trenutni tok in samo za nabore podatkov, uvožene iz Amazon S3.

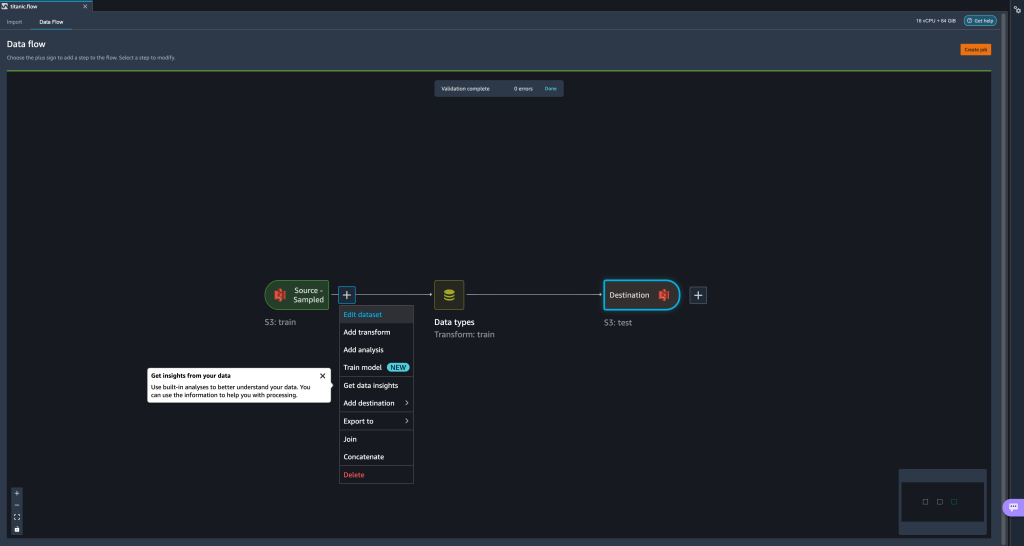

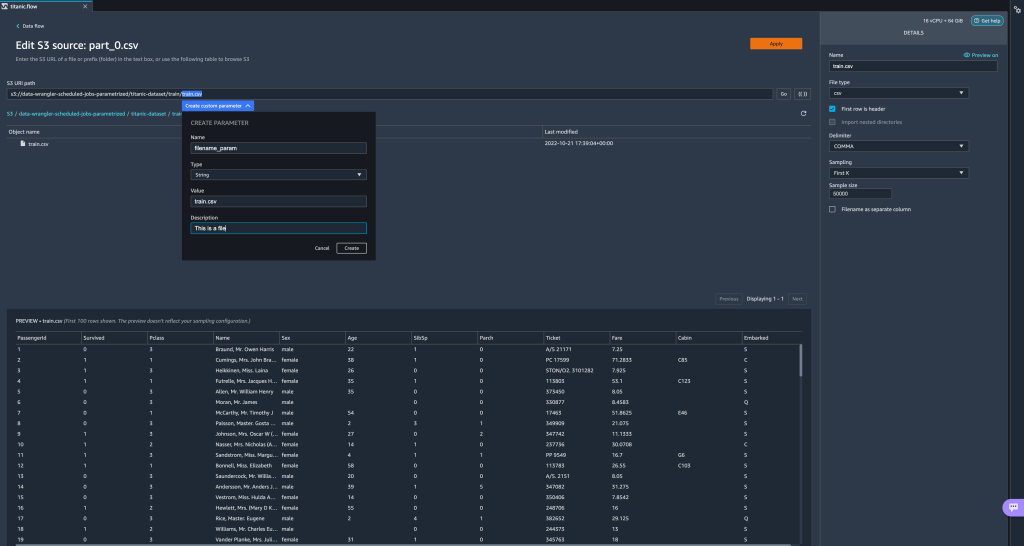

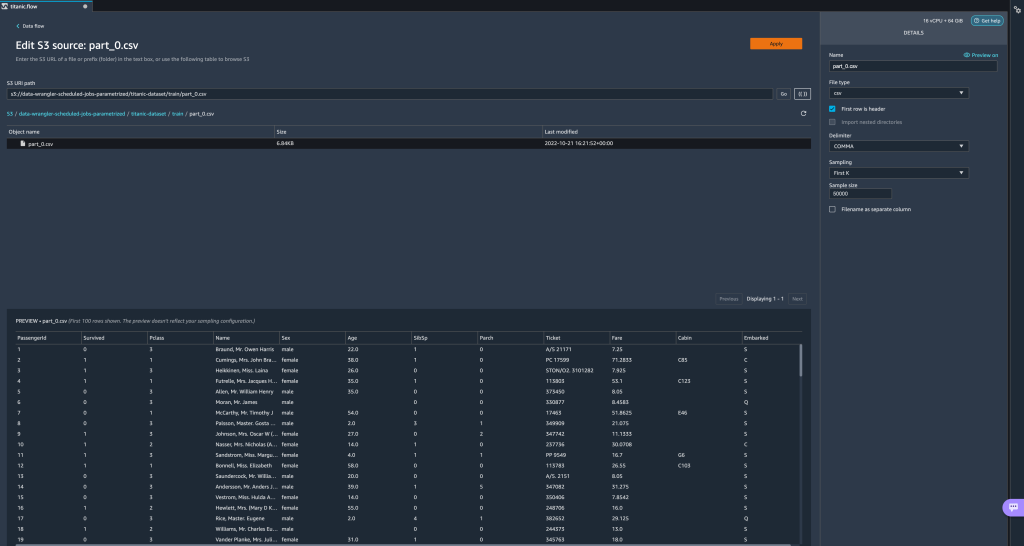

- V svojem toku podatkov izberite znak plus (+) poleg koraka uvoza in izberite Uredi nabor podatkov.

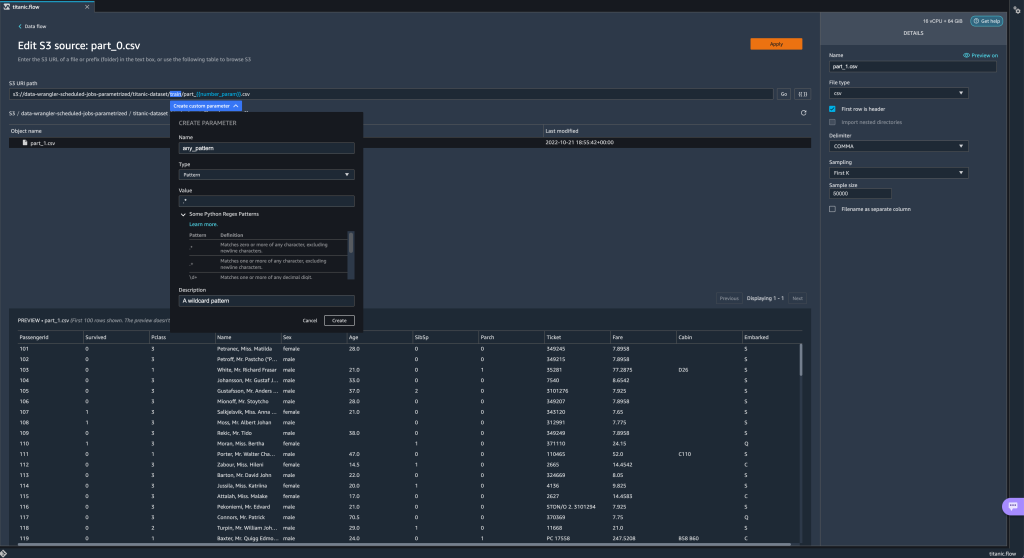

- Najprimernejši (in najpreprostejši) način ustvarjanja novih parametrov je, da označite del svojega URI-ja in izberete Ustvari parameter po meri v spustnem meniju. Za vsak parameter, ki ga želite ustvariti, morate določiti štiri stvari:

- Ime

- tip

- Privzeta vrednost

- Opis

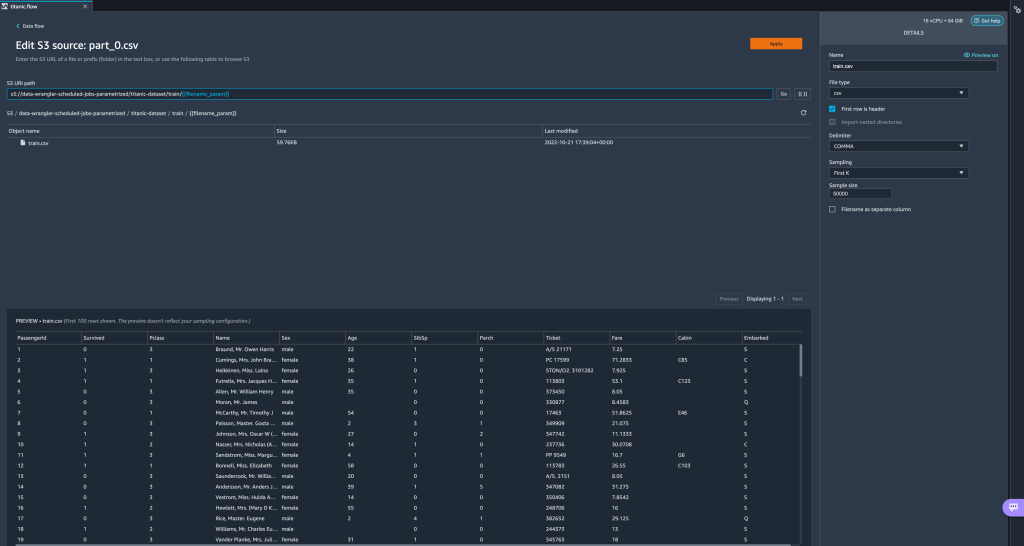

Tukaj smo ustvarili parameter tipa String, imenovanfilename_params privzeto vrednostjotrain.csv. Zdaj lahko vidite ime parametra v dvojnih oklepajih, ki nadomešča del URI-ja, ki smo ga prej označili. Ker je bila definirana vrednost za ta parametertrain.csv, zdaj vidimo datotekotrain.csvnavedene v tabeli za uvoz.

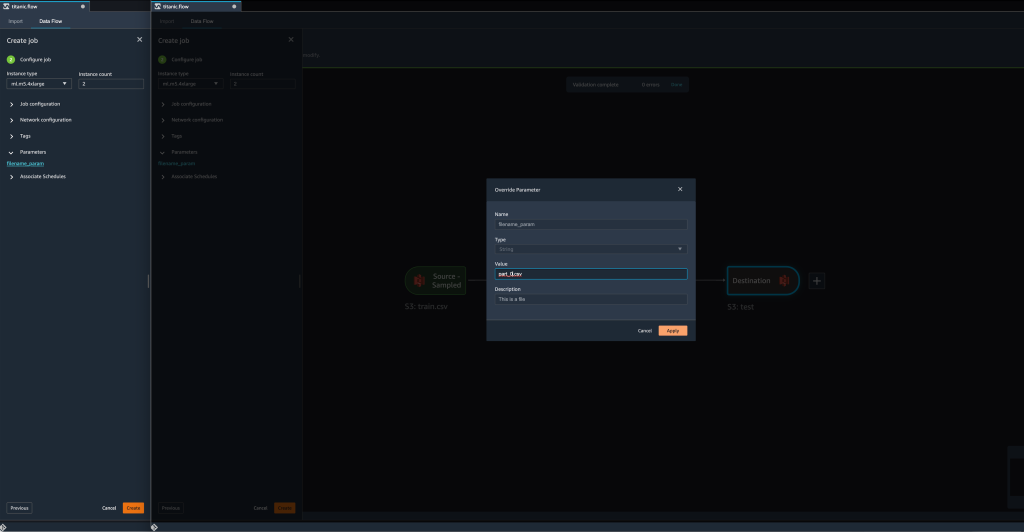

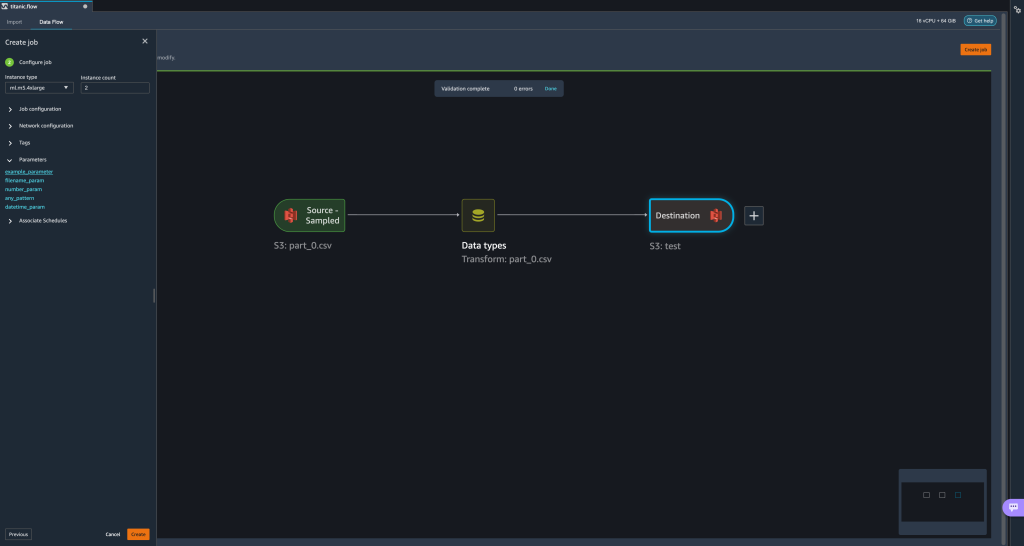

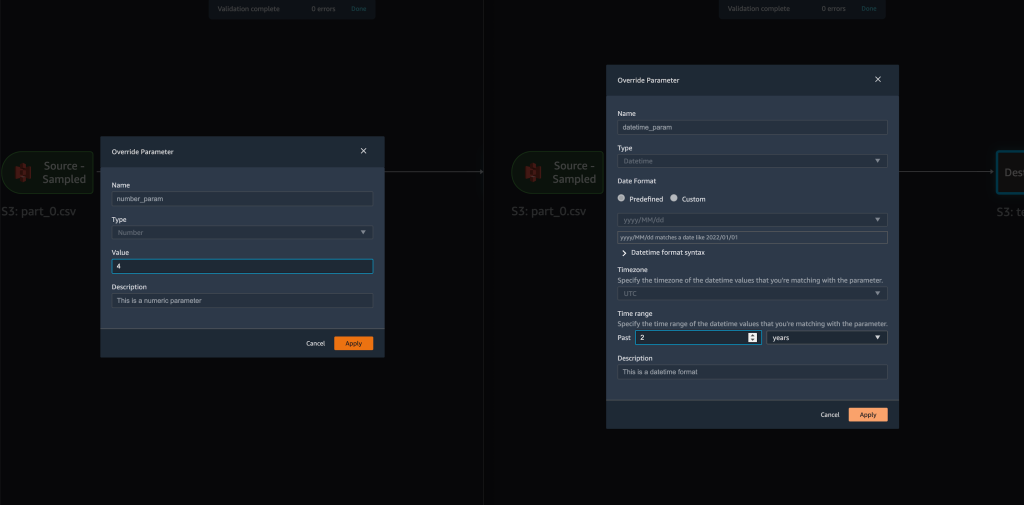

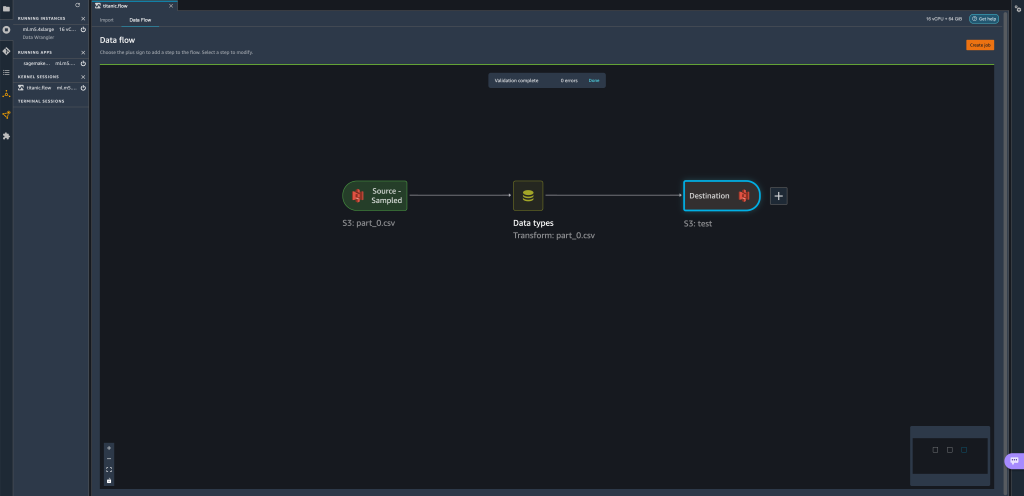

- Ko poskušamo ustvariti preoblikovalno službo, na Konfigurirajte opravilo korak, zdaj vidimo a parametri razdelek, kjer lahko vidimo seznam vseh naših definiranih parametrov.

- Izbira parametra nam daje možnost, da spremenimo vrednost parametra, v tem primeru spremenimo vhodni nabor podatkov, ki se preoblikuje v skladu z definiranim tokom.

Ob predpostavki, da spremenimo vrednostfilename_paramiztrain.csvdopart_0.csv, zdaj poteka delo preoblikovanjapart_0.csv(pod pogojem, da datoteka z imenompart_0.csvobstaja v isti mapi) kot novi vhodni podatki.

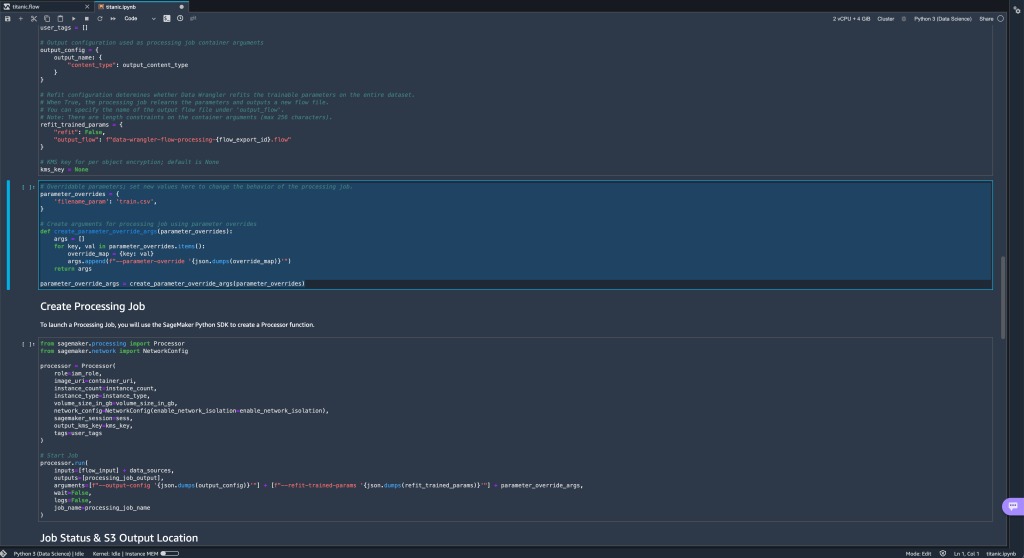

- Poleg tega, če poskusite izvoziti svoj tok na destinacijo Amazon S3 (prek zvezka Jupyter), boste zdaj videli novo celico, ki vsebuje parametre, ki ste jih definirali.

Upoštevajte, da ima parameter privzeto vrednost, vendar jo lahko spremenite tako, da zamenjate njeno vrednost vparameter_overridesslovar (pri čemer pustite ključe slovarja nespremenjene).

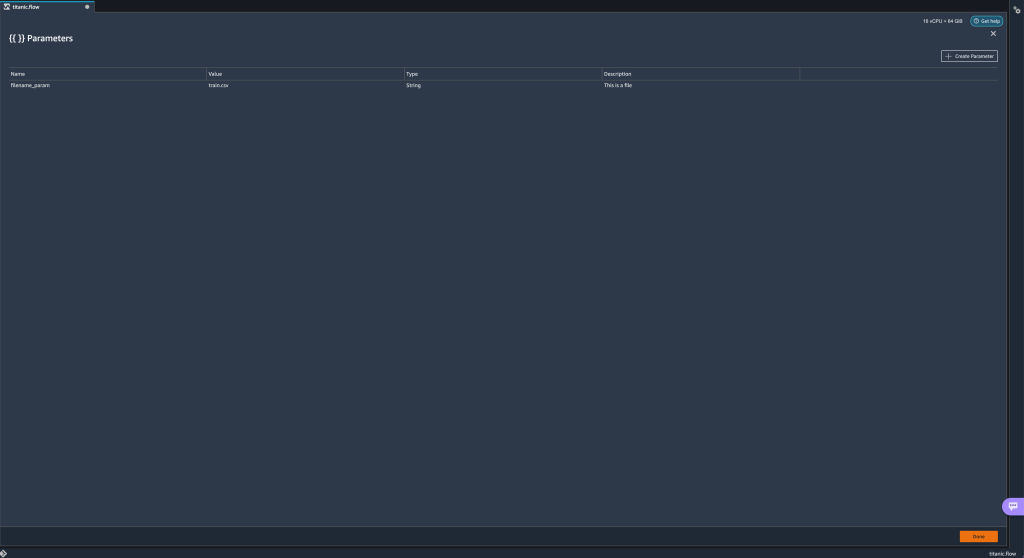

Poleg tega lahko ustvarite nove parametre iz parametri Uporabniški vmesnik. - Odprite ga tako, da izberete ikono parametrov ({{}}), ki se nahaja poleg Go možnost; oba se nahajata poleg vrednosti poti URI.

Odpre se tabela z vsemi parametri, ki trenutno obstajajo v vaši datoteki toka (

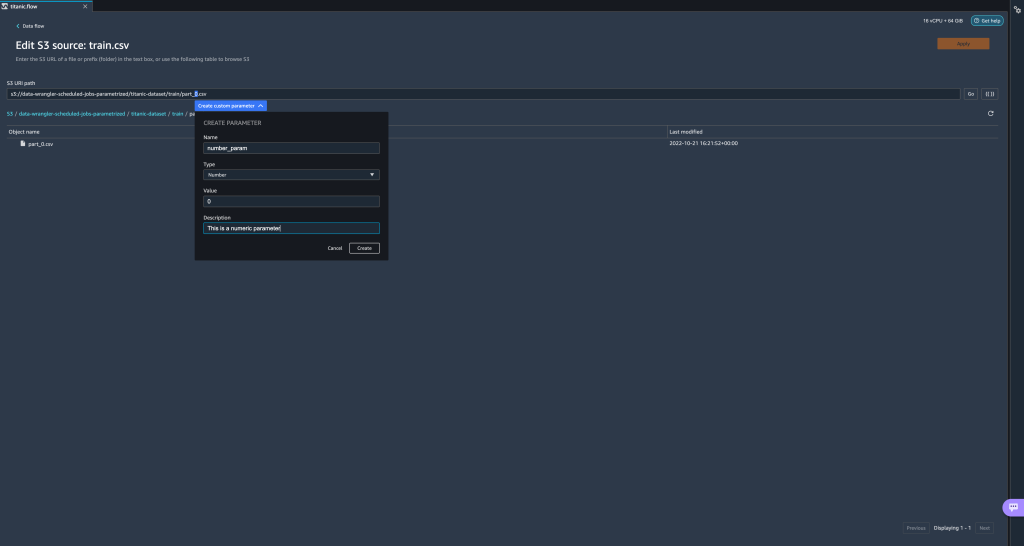

Odpre se tabela z vsemi parametri, ki trenutno obstajajo v vaši datoteki toka (filename_paramna tej točki). - Z izbiro lahko ustvarite nove parametre za svoj tok Ustvari parameter.

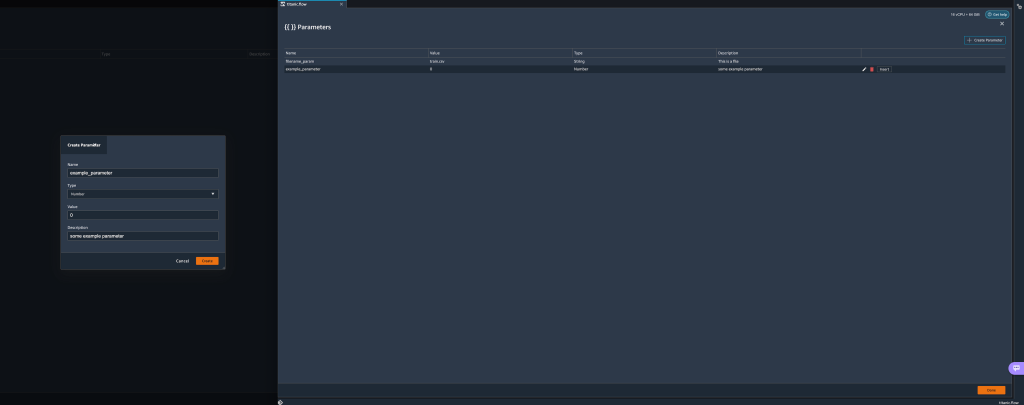

Odpre se pojavno okno, v katerem lahko ustvarite nov parameter po meri. - Tukaj smo ustvarili novo

example_parameterkot vrsto števila s privzeto vrednostjo 0. Ta na novo ustvarjen parameter je zdaj naveden v parametri tabela. Če miškin kazalec premaknete nad parameter, se prikažejo možnosti Uredi, Brisanjein Vstavi.

- Od znotraj v parametri UI, lahko vstavite enega od svojih parametrov v URI tako, da izberete želeni parameter in izberete Vstavi.

To doda parameter na konec vašega URI-ja. Premakniti ga morate v želeni razdelek znotraj vašega URI-ja.

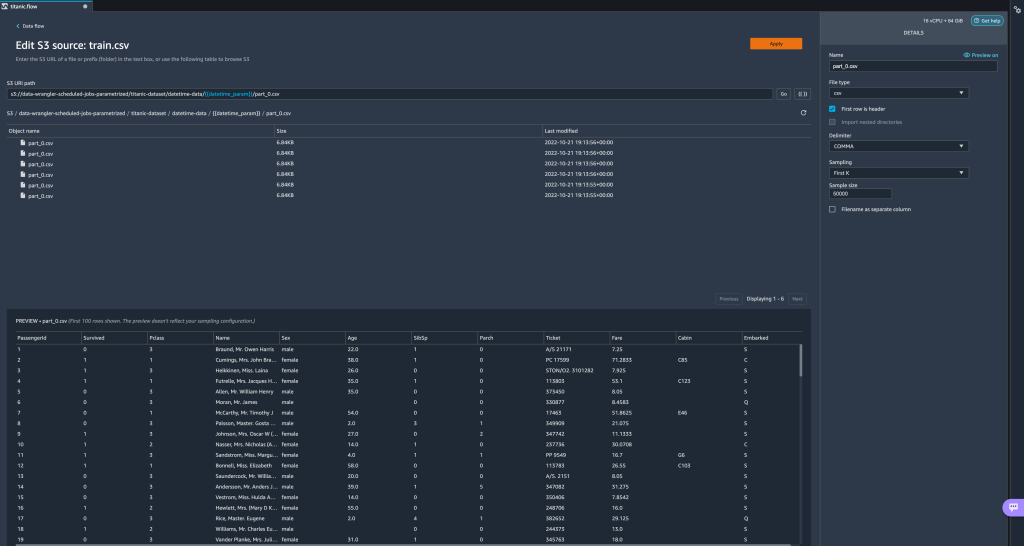

- Spremenite privzeto vrednost parametra, uporabite spremembo (iz modala), izberite Goin izberite ikono za osvežitev, da posodobite seznam predogleda z uporabo izbranega nabora podatkov na podlagi na novo definirane vrednosti parametra.

Raziščimo zdaj druge vrste parametrov. Predpostavimo, da imamo zdaj nabor podatkov, razdeljen na več delov, kjer ima vsaka datoteka številko dela.

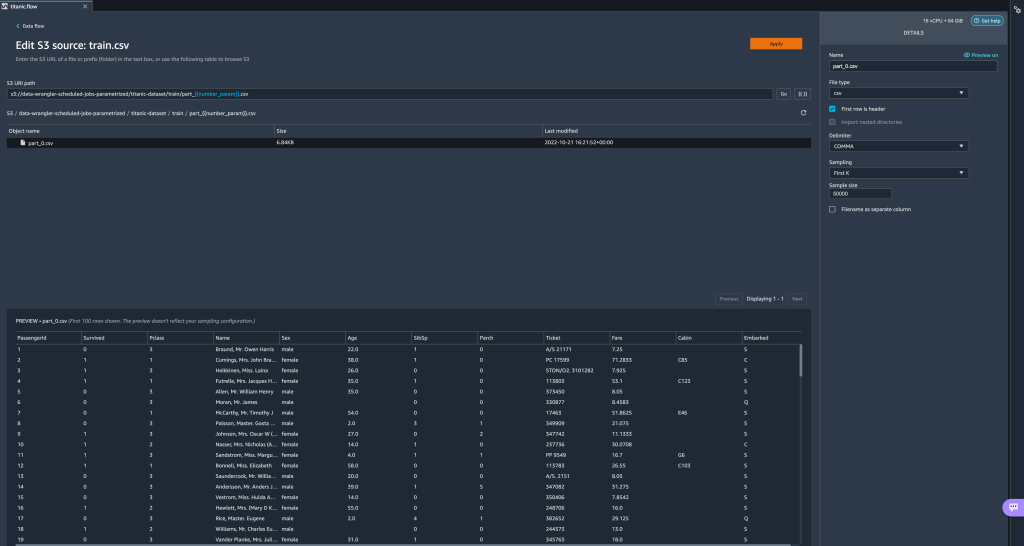

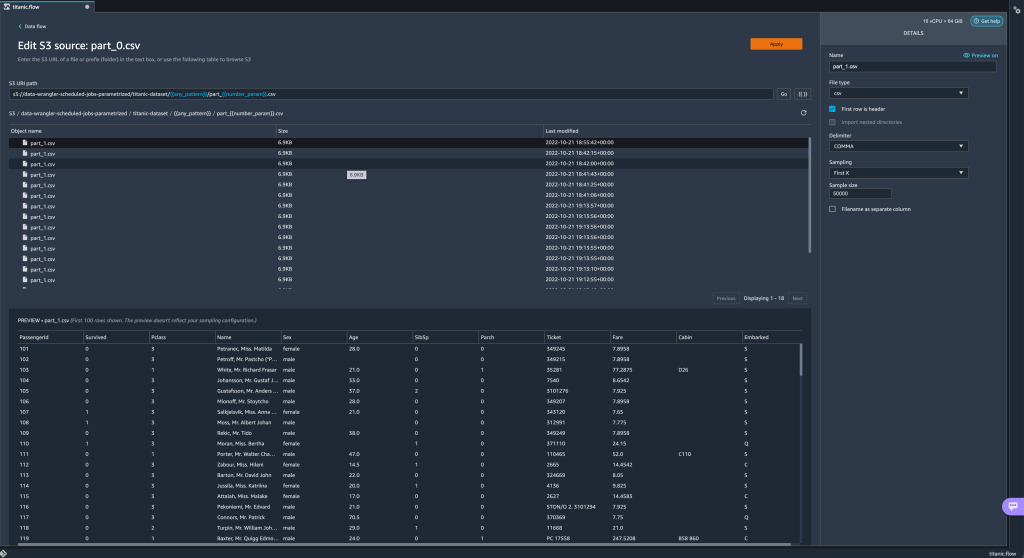

Raziščimo zdaj druge vrste parametrov. Predpostavimo, da imamo zdaj nabor podatkov, razdeljen na več delov, kjer ima vsaka datoteka številko dela. - Če želimo dinamično spremeniti številko datoteke, lahko definiramo parameter Število, kot je prikazano na naslednjem posnetku zaslona.

Upoštevajte, da je izbrana datoteka tista, ki ustreza številki, podani v parametru.

Upoštevajte, da je izbrana datoteka tista, ki ustreza številki, podani v parametru. Zdaj pa pokažimo, kako uporabljati parameter Pattern. Recimo, da želimo uvoziti vse

Zdaj pa pokažimo, kako uporabljati parameter Pattern. Recimo, da želimo uvoziti vse part_1.csvdatoteke v vseh mapah podtitanic-dataset/mapo. Parametri vzorca lahko sprejmejo kateri koli veljaven regularni izraz; kot primeri so prikazani nekateri vzorci regularnih izrazov. - Ustvarite parameter Pattern, imenovan

any_patternda se ujema s katero koli mapo ali datoteko podtitanic-dataset/mapo s privzeto vrednostjo.*.Upoštevajte, da nadomestni znak ni ena * (zvezdica), ampak ima tudi piko. - Označite

titanic-dataset/del poti in ustvarite parameter po meri. Tokrat izbiramo Vzorec tip. Ta vzorec izbere vse klicane datoteke

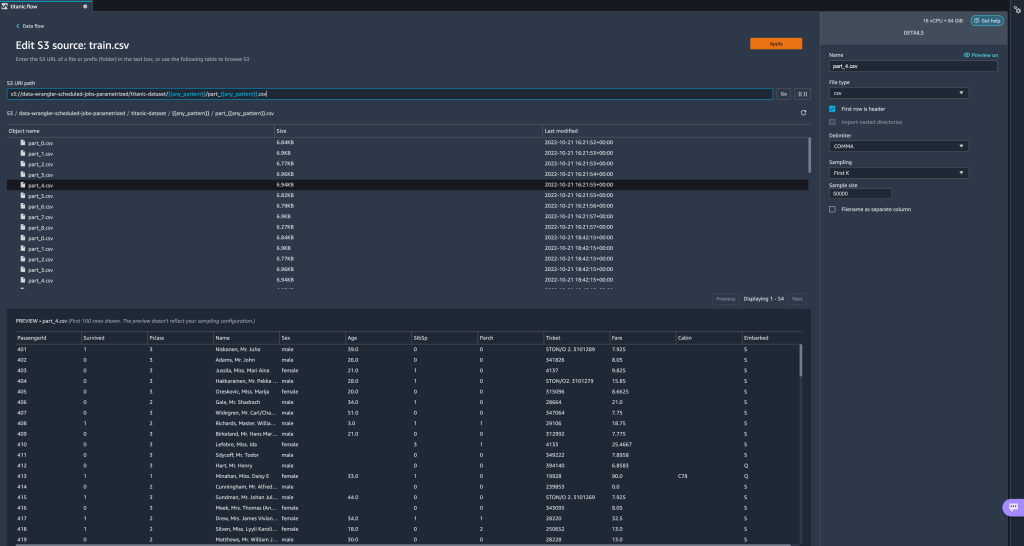

Ta vzorec izbere vse klicane datoteke part-1.csviz katere koli mape podtitanic-dataset/. Parameter lahko na poti uporabite večkrat. V naslednjem primeru uporabimo naš na novo ustvarjen parameter

Parameter lahko na poti uporabite večkrat. V naslednjem primeru uporabimo naš na novo ustvarjen parameter any_patterndvakrat v našem URI-ju, da se ujema s katero koli delno datoteko v kateri koli od map podtitanic-dataset/. Končno ustvarimo parameter Datetime. Parametri datuma in časa so uporabni, ko imamo opravka s potmi, ki so razdeljene po datumu in času, kot so tiste, ki jih ustvari Amazon Kinesis Data Firehose (Glej Dinamično particioniranje v Kinesis Data Firehose). Za to predstavitev uporabimo podatke v mapi datetime-data.

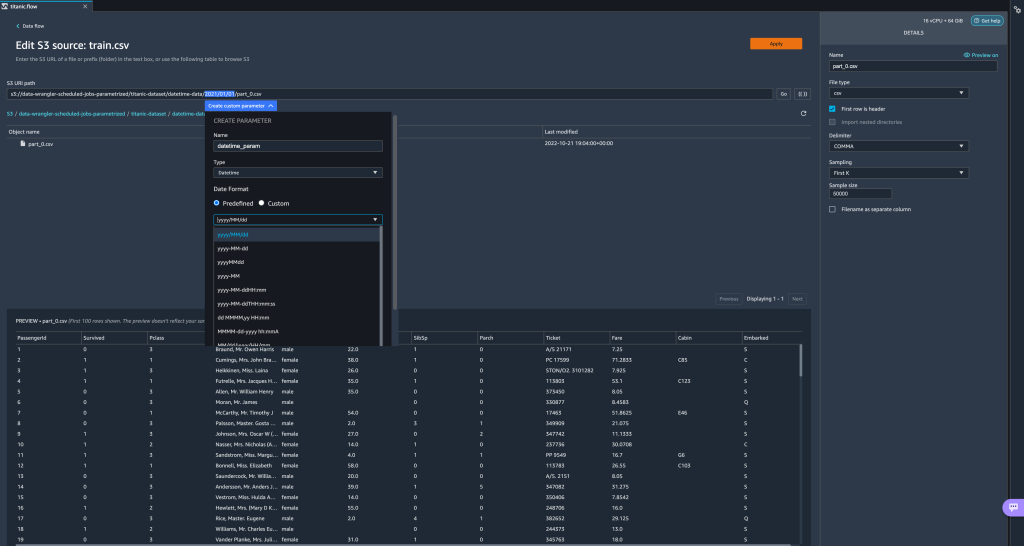

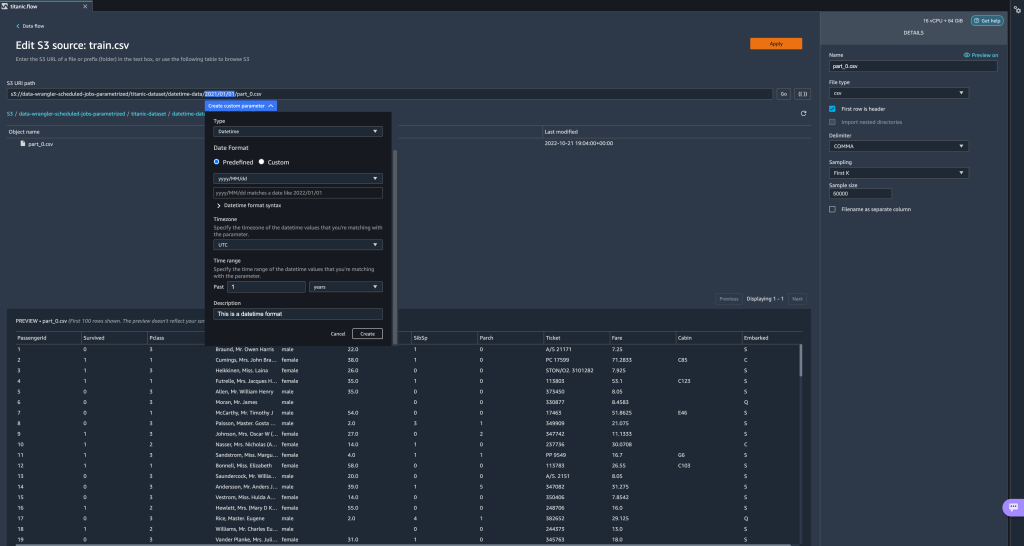

Končno ustvarimo parameter Datetime. Parametri datuma in časa so uporabni, ko imamo opravka s potmi, ki so razdeljene po datumu in času, kot so tiste, ki jih ustvari Amazon Kinesis Data Firehose (Glej Dinamično particioniranje v Kinesis Data Firehose). Za to predstavitev uporabimo podatke v mapi datetime-data. - Izberite del svoje poti, ki je datum/čas, in ustvarite parameter po meri. Izberite Datum vrsta parametra.

Ko izberete podatkovni tip Datetime, morate izpolniti več podrobnosti. - Najprej morate zagotoviti obliko datuma. Izberete lahko katero koli od vnaprej določenih oblik zapisa datuma/časa ali ustvarite obliko po meri.

Za vnaprej določene oblike datuma/časa legenda ponuja primer datuma, ki se ujema z izbrano obliko. Za to predstavitev izberemo obliko llll/MM/dd.

- Nato določite časovni pas za vrednosti datuma/časa.

Trenutni datum je lahko na primer 1. januar 2022 v enem časovnem pasu, lahko pa je 2. januar 2022 v drugem časovnem pasu. - Nazadnje lahko izberete časovni obseg, ki vam omogoča izbiro obsega datotek, ki jih želite vključiti v tok podatkov.

Časovni razpon lahko določite v urah, dnevih, tednih, mesecih ali letih. Za ta primer želimo pridobiti vse datoteke iz prejšnjega leta. - Vnesite opis parametra in izberite ustvarjanje.

Če uporabljate več naborov podatkov z različnimi časovnimi pasovi, se čas ne pretvori samodejno; vsako datoteko ali vir morate predhodno obdelati, da jo pretvorite v en časovni pas. Izbrane datoteke so vse datoteke v mapah, ki ustrezajo lanskim podatkom.

Izbrane datoteke so vse datoteke v mapah, ki ustrezajo lanskim podatkom.

- Zdaj, če ustvarimo opravilo za pretvorbo podatkov, lahko vidimo seznam vseh naših definiranih parametrov in lahko preglasimo njihove privzete vrednosti, tako da naša opravila za preoblikovanje izberejo navedene datoteke.

Načrtujte opravila obdelave

Zdaj lahko načrtujete opravila obdelave za avtomatizirano izvajanje opravil preoblikovanja podatkov in izvoz vaših pretvorjenih podatkov v Amazon S3 ali Trgovina s funkcijami Amazon SageMaker. Dela lahko razporedite s časom in periodičnostjo, ki ustreza vašim potrebam.

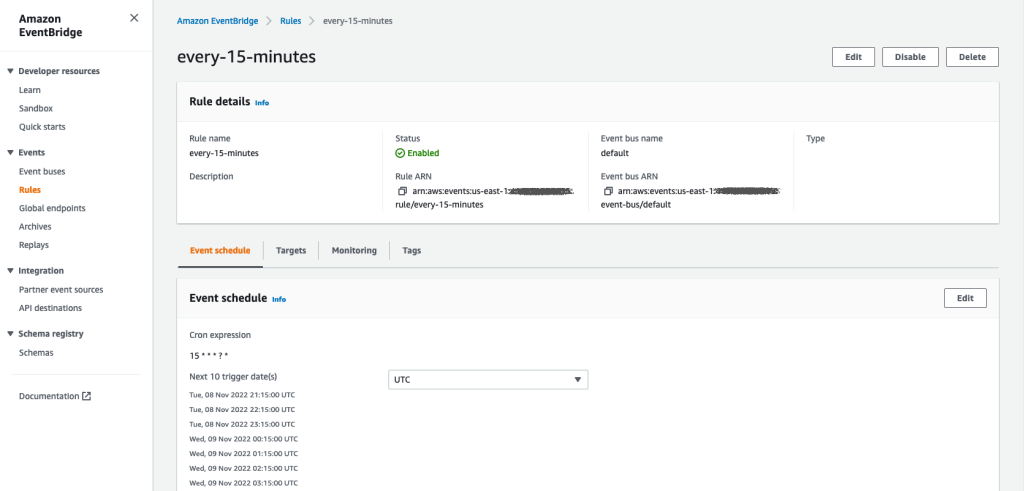

Uporaba načrtovanih opravil obdelave Amazon EventBridge pravila za načrtovanje izvajanja opravila. Zato morate kot predpogoj zagotoviti, da AWS upravljanje identitete in dostopa (IAM), ki jo uporablja Data Wrangler, in sicer Amazon SageMaker izvršilna vloga primerka Studio ima dovoljenja za ustvarjanje pravil EventBridge.

Konfigurirajte IAM

Nadaljujte z naslednjimi posodobitvami izvedbene vloge IAM SageMaker, ki ustreza instanci Studio, kjer se izvaja tok Data Wrangler:

- Pritrdite AmazonEventBridgeFullAccess upravljana politika.

- Priložite pravilnik za dodelitev dovoljenja za ustvarjanje opravila obdelave:

- Dodelite dovoljenje EventBridge za prevzem vloge, tako da dodate naslednji pravilnik zaupanja:

Če za izvajanje opravila obdelave uporabljate drugo vlogo, uporabite pravilnike, opisane v korakih 2 in 3, za to vlogo. Za podrobnosti o konfiguraciji IAM glejte Ustvarite urnik za samodejno obdelavo novih podatkov.

Ustvarite urnik

Če želite ustvariti urnik, odprite tok v urejevalniku toka Data Wrangler.

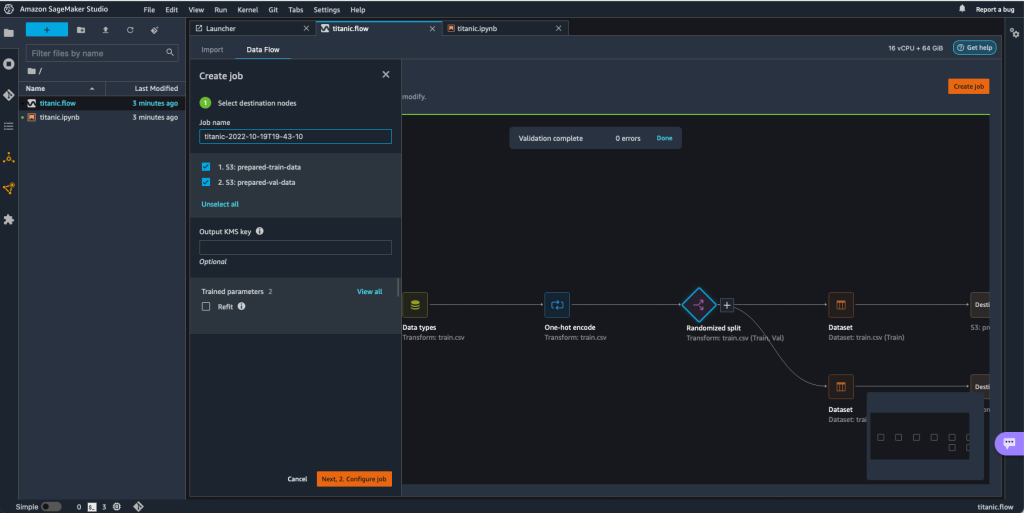

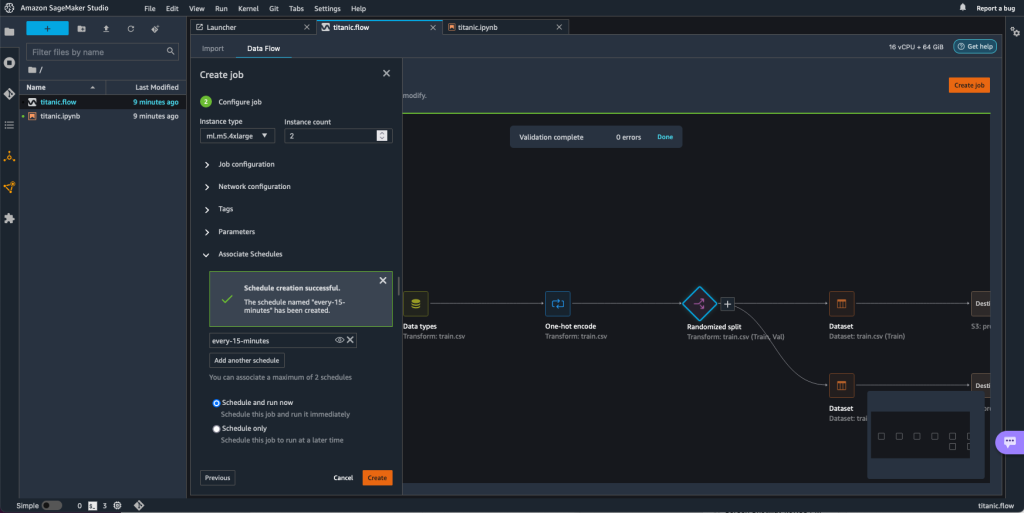

- o Pretok podatkov izberite jeziček Ustvari službo.

- Konfigurirajte zahtevana polja in izberite Nato 2. Konfigurirajte opravilo.

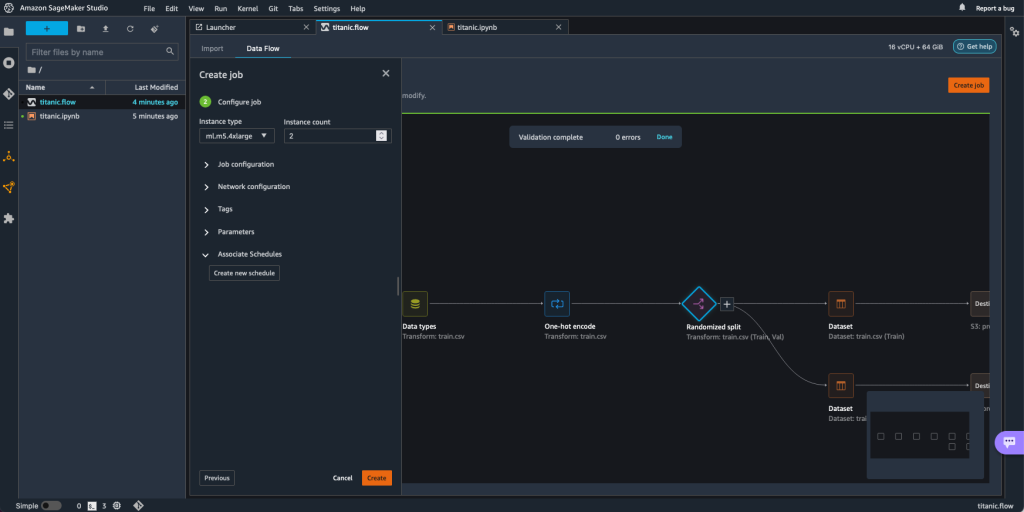

- Razširi Urniki sodelavcev.

- Izberite Ustvari nov urnik.

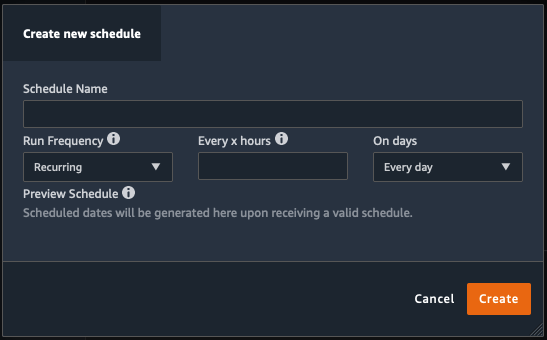

O Ustvari nov urnik odpre se pogovorno okno, kjer določite podrobnosti razporeda opravil obdelave.

Pogovorno okno ponuja veliko prilagodljivost, ki vam pomaga določiti urnik. Posel obdelave lahko na primer izvajate ob določenem času ali vsakih X ur ob določenih dnevih v tednu.

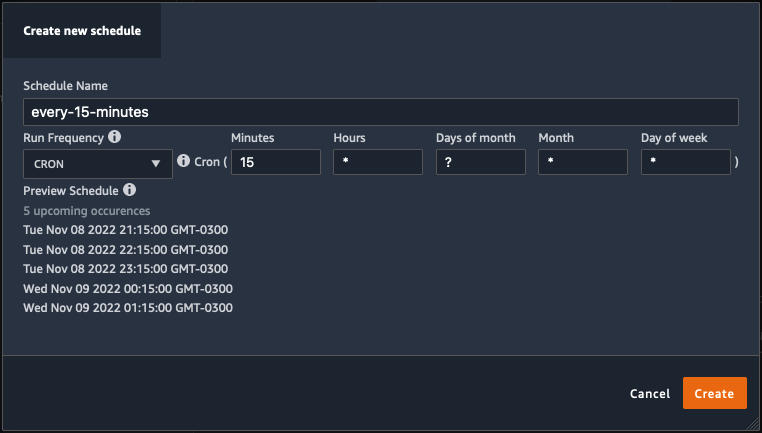

Periodičnost je lahko zrnata do ravni minut.

- Določite ime urnika in periodičnost ter nato izberite ustvarjanje da shranite urnik.

- Imate možnost, da začnete opravilo obdelave takoj skupaj z razporejanjem, ki skrbi za prihodnje teke, ali pa pustite, da se opravilo izvaja le po urniku.

- Določite lahko tudi dodaten urnik za isto opravilo obdelave.

- Če želite dokončati urnik za opravilo obdelave, izberite ustvarjanje.

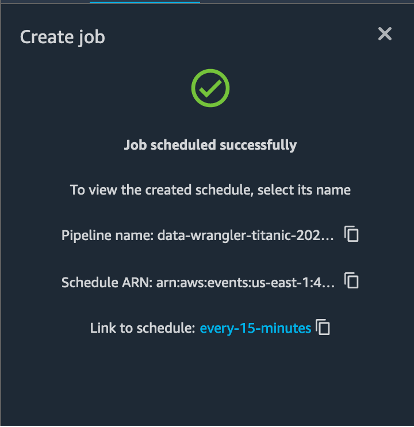

Videli boste sporočilo »Opravilo je uspešno načrtovano«. Poleg tega, če se odločite, da se opravilo izvaja samo po urniku, vidite povezavo do pravila EventBridge, ki ste ga pravkar ustvarili.

Če izberete povezavo razporeda, se v brskalniku odpre nov zavihek, ki prikazuje pravilo EventBridge. Na tej strani lahko naredite nadaljnje spremembe pravila in sledite njegovi zgodovini klicev. Če želite ustaviti izvajanje načrtovanega opravila obdelave, izbrišite pravilo dogodka, ki vsebuje ime urnika.

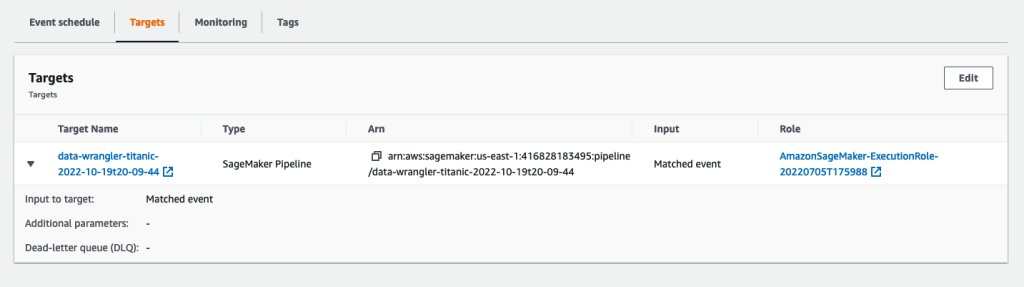

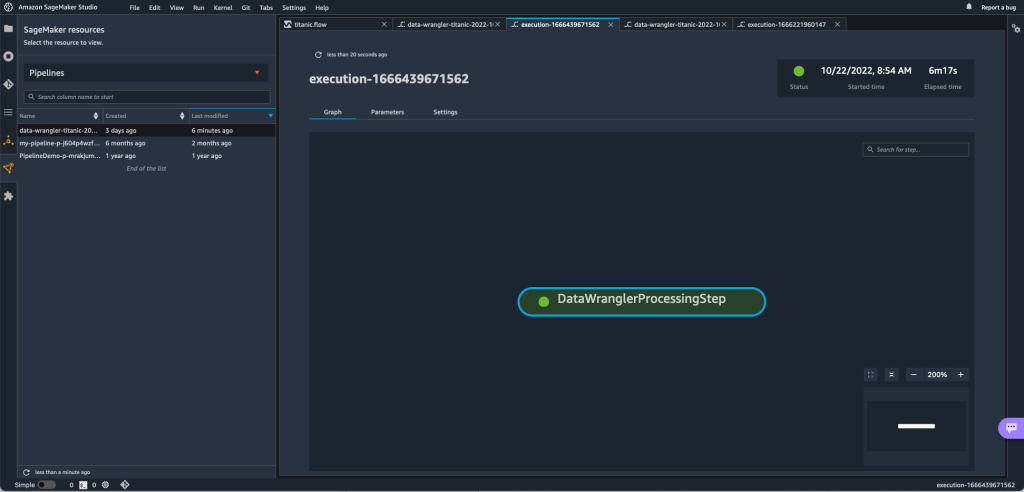

Pravilo EventBridge prikazuje cevovod SageMaker kot svoj cilj, ki se sproži v skladu z definiranim razporedom, opravilo obdelave pa je priklicano kot del cevovoda.

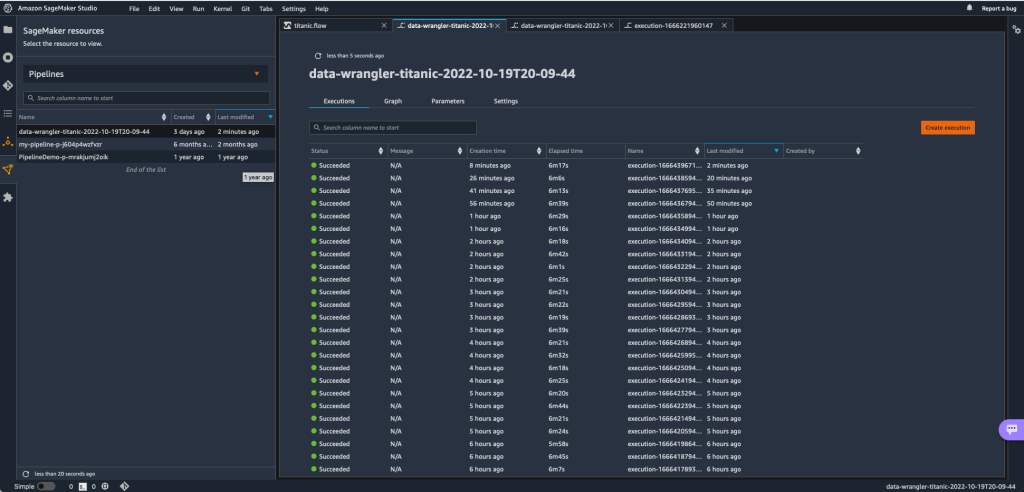

Če želite slediti tekom cevovoda SageMaker, se lahko vrnete v Studio in izberete Viri SageMaker ikona, izberite Cevovodiin izberite ime cevovoda, ki mu želite slediti. Zdaj lahko vidite tabelo z vsemi trenutnimi in preteklimi zagoni ter stanjem tega cevovoda.

Več podrobnosti si lahko ogledate tako, da dvokliknete določen vnos.

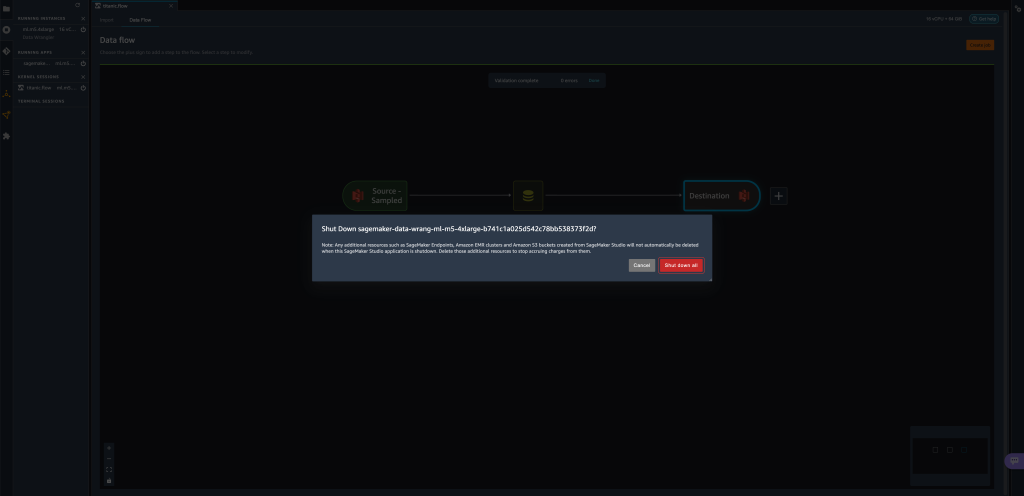

Čiščenje

Ko Data Wranglerja ne uporabljate, je priporočljivo, da zaustavite primerek, na katerem se izvaja, da se izognete dodatnim stroškom.

Da preprečite izgubo dela, shranite pretok podatkov, preden zaustavite Data Wrangler.

- Če želite shraniti pretok podatkov v Studio, izberite file, nato izberite Shrani podatkovni tok Wranglerja. Data Wrangler samodejno shrani vaš pretok podatkov vsakih 60 sekund.

- Če želite zaustaviti primerek Data Wrangler, v Studiu izberite Izvajanje primerkov in jeder.

- Pod TEKUČE APLIKACIJE, izberite ikono za zaustavitev poleg

sagemaker-data-wrangler-1.0app.

- Izberite Zapri vse potrditi.

Data Wrangler deluje na primerku ml.m5.4xlarge. Ta primer izgine iz ZATOČNI PRIMERKI ko zaprete aplikacijo Data Wrangler.

Ko zaustavite aplikacijo Data Wrangler, se mora znova zagnati, ko naslednjič odprete datoteko toka Data Wrangler. To lahko traja nekaj minut.

zaključek

V tej objavi smo pokazali, kako lahko uporabite parametre za uvoz naborov podatkov s tokovi Data Wrangler in na njih ustvarite opravila za pretvorbo podatkov. Parametrizirani nabori podatkov omogočajo večjo prilagodljivost na naborih podatkov, ki jih uporabljate, in vam omogočajo, da ponovno uporabite svoje tokove. Pokazali smo tudi, kako lahko nastavite načrtovana opravila za avtomatizacijo transformacij in izvozov podatkov v Amazon S3 ali Feature Store, ob času in periodičnosti, ki ustreza vašim potrebam, neposredno iz uporabniškega vmesnika Data Wrangler.

Če želite izvedeti več o uporabi podatkovnih tokov z Data Wranglerjem, glejte Ustvarite in uporabite Data Wrangler Flow in Cene Amazon SageMaker. Če želite začeti uporabljati Data Wrangler, glejte Pripravite podatke ML z Amazon SageMaker Data Wrangler.

O avtorjih

David Laredo je arhitekt prototipov za ekipo za izdelavo prototipov in oblakov pri Amazon Web Services, kjer je pomagal razviti več prototipov strojnega učenja za stranke AWS. Zadnjih 6 let se ukvarja s strojnim učenjem, usposablja in izpopolnjuje modele ML ter izvaja cevovode od konca do konca za proizvodnjo teh modelov. Njegova področja zanimanja so NLP, ML aplikacije in end-to-end ML.

David Laredo je arhitekt prototipov za ekipo za izdelavo prototipov in oblakov pri Amazon Web Services, kjer je pomagal razviti več prototipov strojnega učenja za stranke AWS. Zadnjih 6 let se ukvarja s strojnim učenjem, usposablja in izpopolnjuje modele ML ter izvaja cevovode od konca do konca za proizvodnjo teh modelov. Njegova področja zanimanja so NLP, ML aplikacije in end-to-end ML.

Givanildo Alves je arhitekt prototipov pri ekipi za izdelavo prototipov in oblakov pri Amazon Web Services, ki strankam pomaga pri inovacijah in pospeševanju s prikazovanjem umetnosti možnega na AWS, saj je že implementiral več prototipov v zvezi z umetno inteligenco. Ima dolgo kariero na področju programskega inženiringa in je prej delal kot inženir za razvoj programske opreme pri Amazon.com.br.

Givanildo Alves je arhitekt prototipov pri ekipi za izdelavo prototipov in oblakov pri Amazon Web Services, ki strankam pomaga pri inovacijah in pospeševanju s prikazovanjem umetnosti možnega na AWS, saj je že implementiral več prototipov v zvezi z umetno inteligenco. Ima dolgo kariero na področju programskega inženiringa in je prej delal kot inženir za razvoj programske opreme pri Amazon.com.br.

Adrian Fuentes je programski vodja pri ekipi za izdelavo prototipov in oblakov pri Amazon Web Services, ki uvaja inovacije za stranke na področju strojnega učenja, interneta stvari in verige blokov. Ima več kot 15 let izkušenj z vodenjem in izvajanjem projektov ter 1 leto službovanja na AWS.

Adrian Fuentes je programski vodja pri ekipi za izdelavo prototipov in oblakov pri Amazon Web Services, ki uvaja inovacije za stranke na področju strojnega učenja, interneta stvari in verige blokov. Ima več kot 15 let izkušenj z vodenjem in izvajanjem projektov ter 1 leto službovanja na AWS.

- AI

- ai art

- ai art generator

- imajo robota

- Strojno učenje Amazon

- Amazon SageMaker Data Wrangler

- Obvestila

- Umetna inteligenca

- certificiranje umetne inteligence

- umetna inteligenca v bančništvu

- robot z umetno inteligenco

- roboti z umetno inteligenco

- programska oprema za umetno inteligenco

- Strojno učenje AWS

- blockchain

- blockchain konferenca ai

- coingenius

- pogovorna umetna inteligenca

- kripto konferenca ai

- dall's

- obdelava podatkov

- globoko učenje

- Srednje (200)

- strojno učenje

- Parametrizirani nizi podatkov

- platon

- platon ai

- Platonova podatkovna inteligenca

- Igra Platon

- PlatoData

- platogaming

- lestvica ai

- Načrtovana delovna mesta

- sintaksa

- Tehnična navodila

- zefirnet