Ekipe podatkovne znanosti in podatkovnega inženiringa porabijo precejšen del svojega časa v fazi priprave podatkov v življenjskem ciklu strojnega učenja (ML), pri čemer izvajajo korake izbire, čiščenja in transformacije podatkov. To je nujen in pomemben korak v katerem koli delovnem procesu ML za ustvarjanje pomembnih vpogledov in napovedi, saj slabi ali nizkokakovostni podatki močno zmanjšajo ustreznost pridobljenih vpogledov.

Ekipe podatkovnega inženiringa so tradicionalno odgovorne za vnos, konsolidacijo in pretvorbo neobdelanih podatkov za nadaljnjo porabo. Podatkovni znanstveniki morajo pogosto izvesti dodatno obdelavo podatkov za domensko specifične primere uporabe ML, kot so naravni jezik in časovne vrste. Na primer, nekateri algoritmi ML so lahko občutljivi na manjkajoče vrednosti, redke značilnosti ali izstopajoče vrednosti in zahtevajo posebno obravnavo. Tudi v primerih, ko je nabor podatkov v dobrem stanju, bodo podatkovni znanstveniki morda želeli preoblikovati porazdelitve funkcij ali ustvariti nove funkcije, da bi povečali vpoglede, pridobljene iz modelov. Da bi dosegli te cilje, se morajo podatkovni znanstveniki zanesti na ekipe podatkovnega inženiringa, da se prilagodijo zahtevanim spremembam, kar povzroči odvisnost in zamudo v procesu razvoja modela. Druga možnost je, da se ekipe za podatkovno znanost odločijo, da bodo interno izvajale pripravo podatkov in inženiring funkcij z uporabo različnih programskih paradigem. Vendar pa zahteva vlaganje časa in truda v namestitev in konfiguracijo knjižnic in ogrodij, kar ni idealno, saj je ta čas mogoče bolje porabiti za optimizacijo delovanja modela.

Amazon SageMaker Data Wrangler poenostavlja pripravo podatkov in postopek inženiringa funkcij, s čimer skrajša čas, ki je potreben za združevanje in pripravo podatkov za ML, s tednov na minute, tako da zagotavlja enoten vizualni vmesnik za podatkovne znanstvenike za izbiro, čiščenje in raziskovanje svojih naborov podatkov. Data Wrangler ponuja več kot 300 vgrajenih transformacij podatkov za pomoč pri normalizaciji, transformaciji in kombiniranju funkcij brez pisanja kode. Podatke lahko uvozite iz več podatkovnih virov, kot npr Storitev Amazon Simple Storage (Amazon S3), Amazonska Atena, Amazon RedShiftin Snowflake. Zdaj lahko uporabite tudi Podatkovne palice kot vir podatkov v Data Wranglerju za enostavno pripravo podatkov za ML.

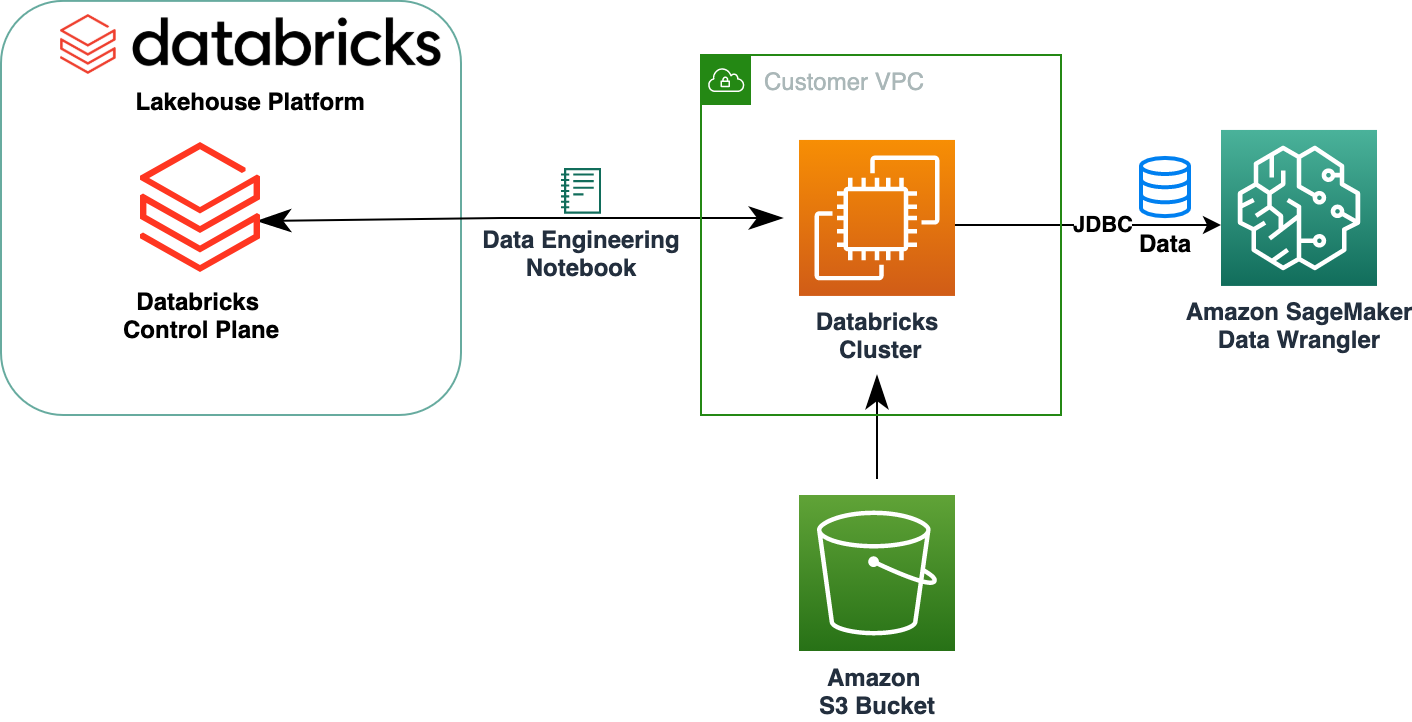

Platforma Databricks Lakehouse združuje najboljše elemente podatkovnih jezer in podatkovnih skladišč za zagotavljanje zanesljivosti, močnega upravljanja in zmogljivosti podatkovnih skladišč z odprtostjo, prilagodljivostjo in podporo strojnega učenja podatkovnih jezer. Z Databricks kot virom podatkov za Data Wrangler se lahko zdaj hitro in enostavno povežete z Databricks, interaktivno poizvedujete po podatkih, shranjenih v Databricks, z uporabo SQL, in predogledate podatke pred uvozom. Poleg tega lahko svoje podatke v Databricks združite s podatki, shranjenimi v Amazon S3, in podatki, poizvedovanimi prek Amazon Athena, Amazon Redshift in Snowflake, da ustvarite pravi nabor podatkov za vaš primer uporabe ML.

V tej objavi preoblikujemo nabor podatkov Lending Club Loan z uporabo Amazon SageMaker Data Wrangler za uporabo pri usposabljanju modelov ML.

Pregled rešitev

Naslednji diagram ponazarja našo arhitekturo rešitev.

Podatkovni niz Lending Club Loan vsebuje popolne podatke o posojilih za vsa posojila, izdana v obdobju 2007–2011, vključno s trenutnim stanjem posojila in najnovejšimi informacijami o plačilu. Ima 39,717 vrstic, 22 stolpcev s funkcijami in 3 ciljne oznake.

Za pretvorbo naših podatkov z uporabo Data Wranglerja dokončamo naslednje korake na visoki ravni:

- Prenesite in razdelite nabor podatkov.

- Ustvarite tok Data Wrangler.

- Uvozite podatke iz Databricks v Data Wrangler.

- Uvozite podatke iz Amazon S3 v Data Wrangler.

- Pridruži podatke.

- Uporabi transformacije.

- Izvozi nabor podatkov.

Predpogoji

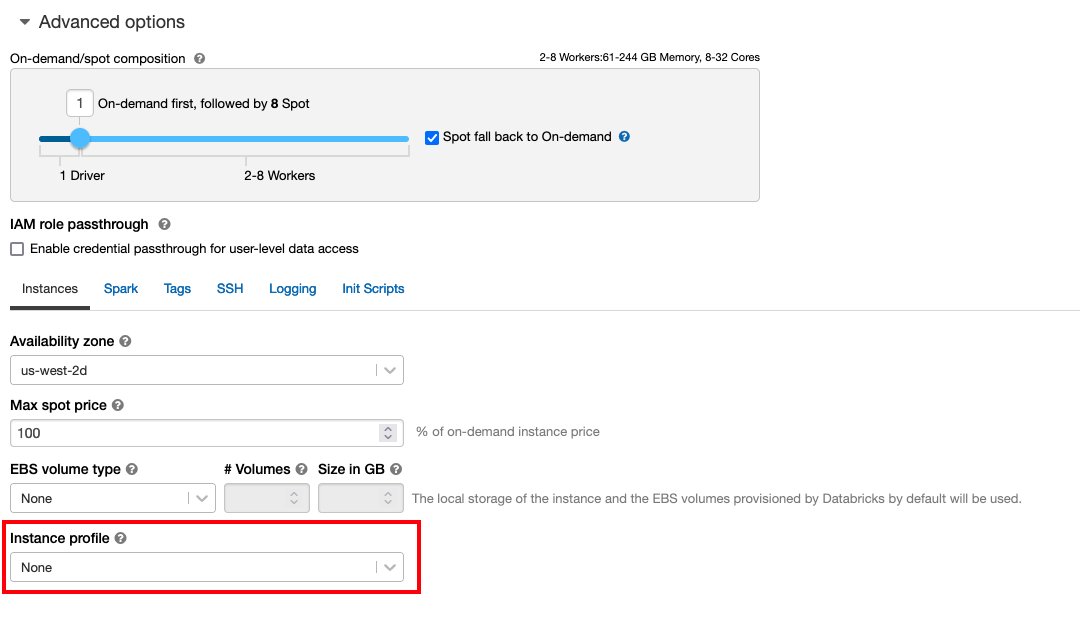

Objava predvideva, da imate delujočo gručo Databricks. Če se vaša gruča izvaja na AWS, preverite, ali imate konfigurirano naslednje:

Nastavitev Databricks

- An profil primerka z zahtevanimi dovoljenji za dostop do vedra S3

- A vedro politika z zahtevanimi dovoljenji za ciljno vedro S3

Sledite Zavarujte dostop do veder S3 z uporabo profilov primerkov za zahtevano AWS upravljanje identitete in dostopa (IAM), pravilnik vedra S3 in konfiguracija gruče Databricks. Zagotovite, da je gruča Databricks konfigurirana z ustreznimi Instance Profile, izbrano pod naprednimi možnostmi, za dostop do želenega vedra S3.

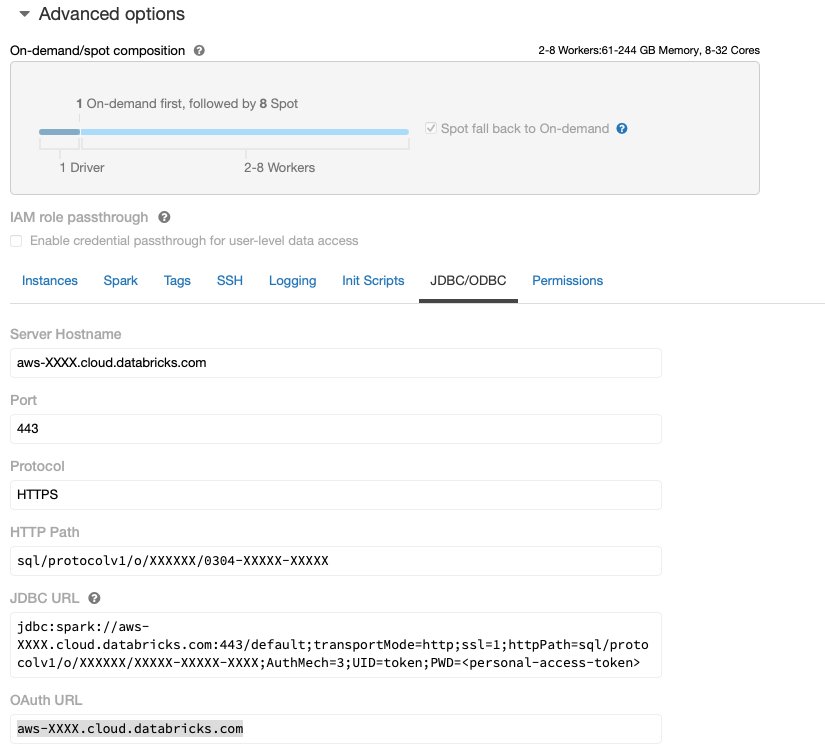

Ko je gruča Databricks pripravljena in zagnana z zahtevanim dostopom do Amazon S3, lahko pridobite JDBC URL iz vaše gruče Databricks, ki jih bo uporabil Data Wrangler za povezavo z njo.

Pridobite URL JDBC

Če želite pridobiti URL JDBC, izvedite naslednje korake:

- V Databricks se pomaknite do uporabniškega vmesnika gruč.

- Izberite svojo gručo.

- o konfiguracija izberite jeziček Dodatne možnosti.

- Pod Dodatne možnosti, izberite JDBC/ODBC tab.

- Kopirajte URL JDBC.

Poskrbite, da boste zamenjali svoj osebni dostop žeton v URL-ju.

Nastavitev Data Wranglerja

Ta korak predvideva, da imate dostop do Amazon SageMaker, primerka Amazon SageMaker Studioin uporabnik Studia.

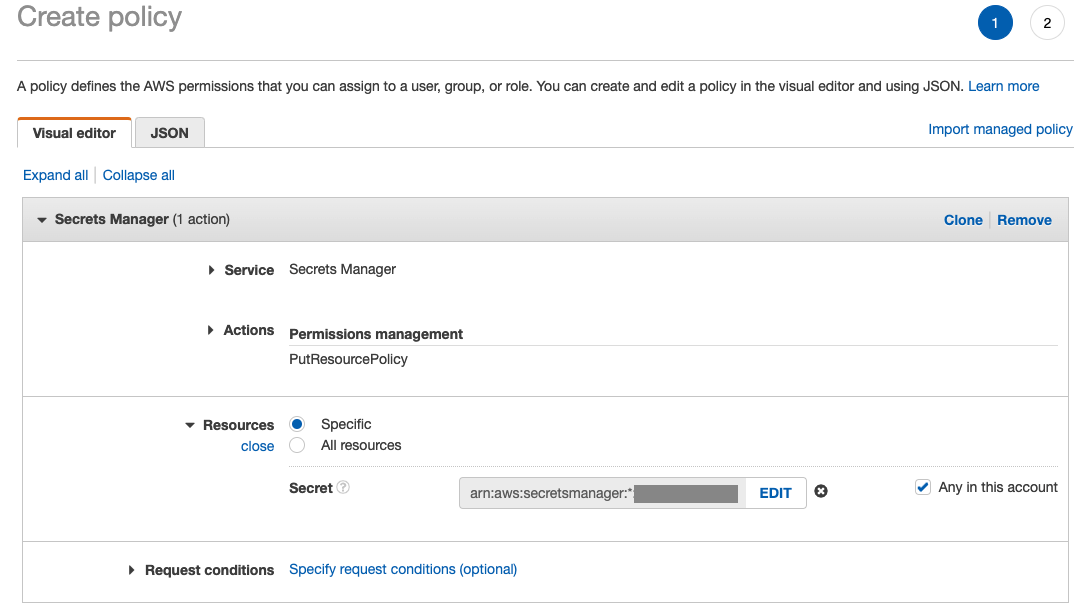

Da omogoči dostop do povezave Databricks JDBC iz programa Data Wrangler, uporabnik Studia potrebuje naslednje dovoljenje:

secretsmanager:PutResourcePolicy

Sledite spodnjim korakom, da posodobite vlogo izvajanja IAM, dodeljeno uporabniku Studio z zgornjim dovoljenjem, kot skrbniški uporabnik IAM.

- Na konzoli IAM izberite vloge v podoknu za krmarjenje.

- Izberite vlogo, dodeljeno vašemu uporabniku Studio.

- Izberite Dodajte dovoljenja.

- Izberite Ustvari vgrajeno politiko.

- Za storitev izberite Upravitelj skrivnosti.

- On Proces, izberite Raven dostopa.

- Izberite Upravljanje dovoljenj.

- Izberite PutResourcePolicy.

- za viri, izberite specifična in izberite Kateri koli v tem računu.

Prenesite in razdelite nabor podatkov

Lahko začnete z prenos nabora podatkov. Za namene predstavitve smo nabor podatkov razdelili tako, da smo kopirali stolpce funkcij id, emp_title, emp_length, home_ownerin annual_inc ustvariti drugo posojila_2.csv mapa. Zgoraj omenjene stolpce odstranimo iz prvotne datoteke posojil, razen stolpca id in preimenujte izvirno datoteko v posojila_1.csv. Naložite posojila_1.csv datoteko Podatkovne palice ustvariti tabelo loans_1 in posojila_2.csv v vedru S3.

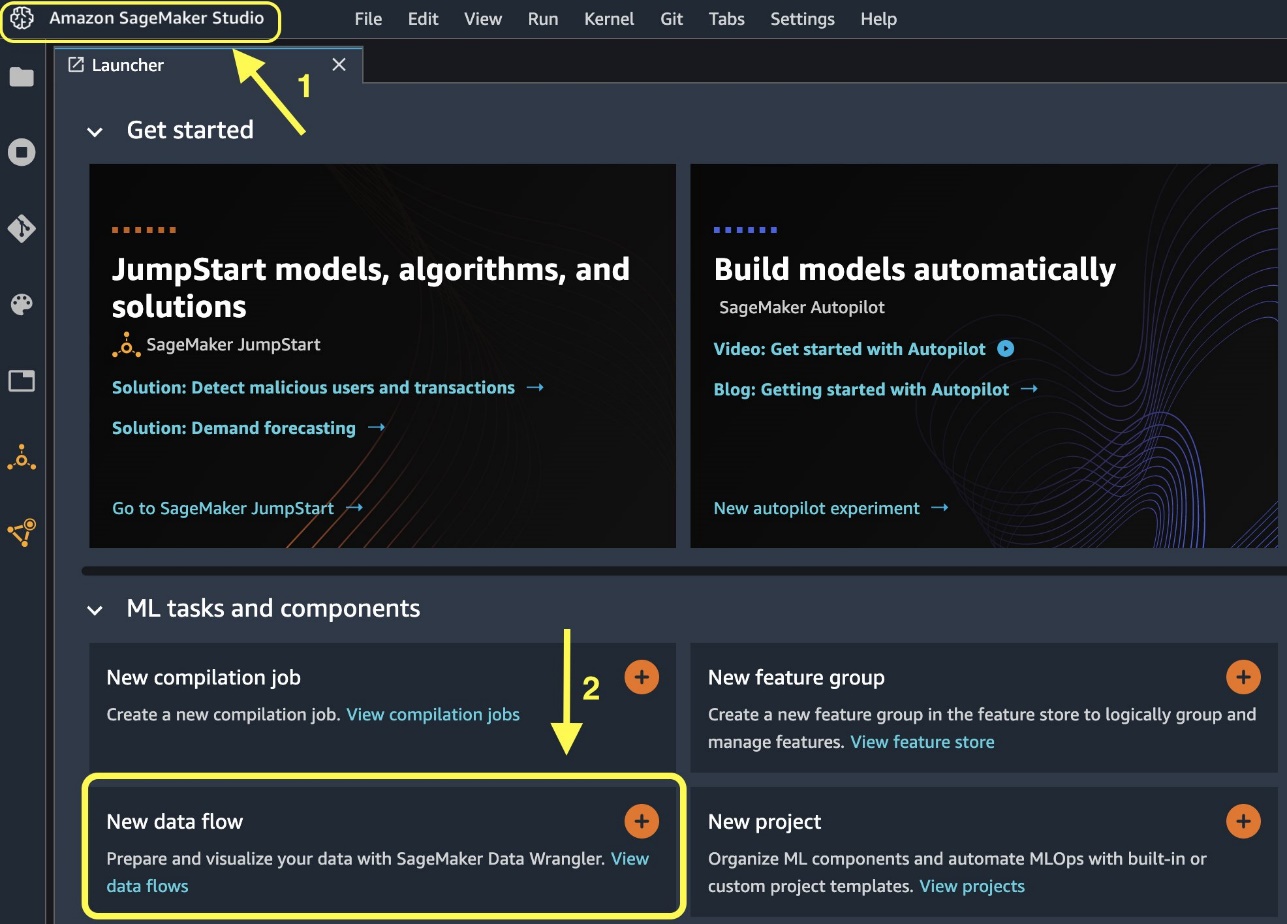

Ustvarite tok Data Wrangler

Za informacije o predpogojih za Data Wrangler glejte Začnite z Data Wrangler.

Začnimo z ustvarjanjem novega toka podatkov.

Druga možnost je, da ustvarite nov tok podatkov iz zaganjalnika.

- Na konzoli Studio izberite Amazon SageMaker Studio v podoknu za krmarjenje.

- Izberite Nov pretok podatkov.

Ustvarjanje novega toka lahko traja nekaj minut. Ko je tok ustvarjen, vidite Uvozi podatke stran.

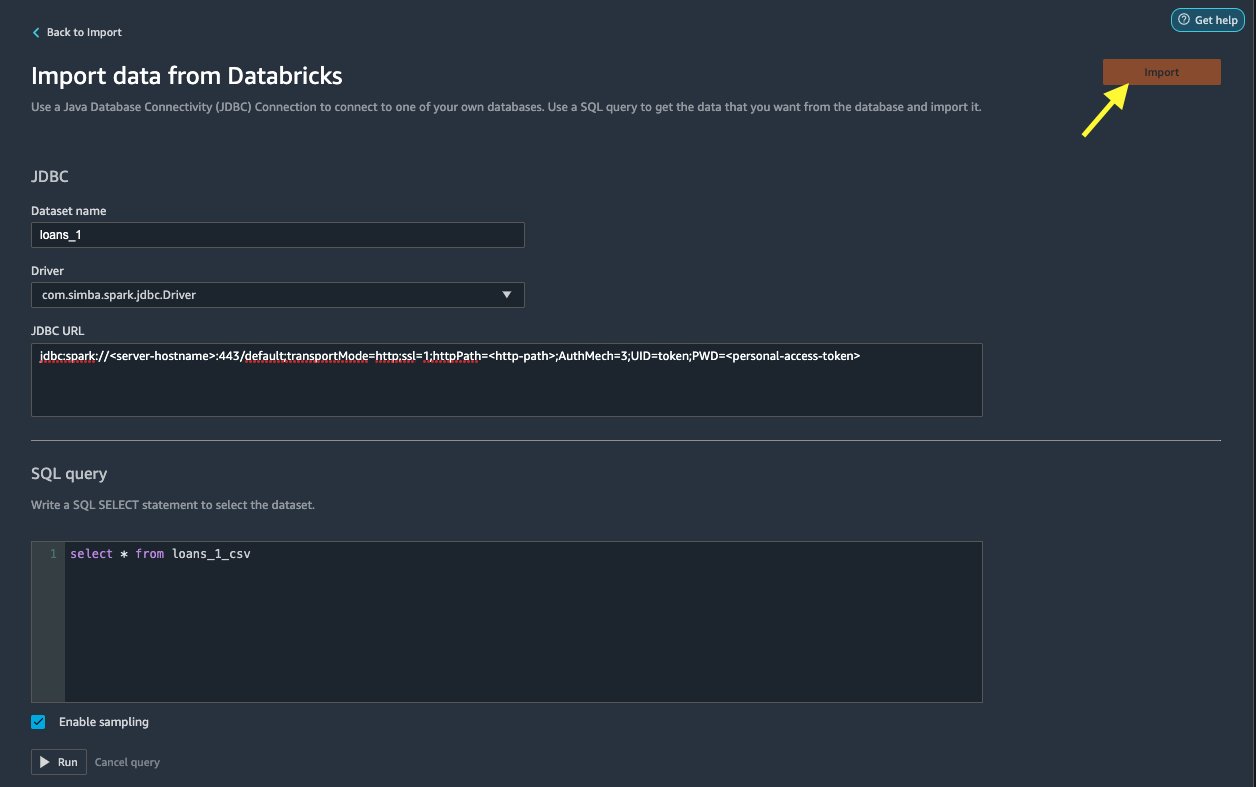

Uvozite podatke iz Databricks v Data Wrangler

Nato smo nastavili Databricks (JDBC) kot vir podatkov v Data Wranglerju. Za uvoz podatkov iz Databricks moramo najprej dodati Databricks kot vir podatkov.

- o Uvozi podatke zavihek vašega toka Data Wrangler, izberite Dodaj vir podatkov.

- V spustnem meniju izberite Databricks (JDBC).

o Uvozite podatke iz Databricks stran, vnesete podatke o gruči.

- za Ime nabora podatkov, vnesite ime, ki ga želite uporabiti v datoteki toka.

- za Voznik, izberite gonilnik

com.simba.spark.jdbc.Driver. - za JDBC URL, vnesite URL vaše gruče Databricks, pridobljene prej.

URL mora biti podoben naslednji obliki jdbc:spark://<serve- hostname>:443/default;transportMode=http;ssl=1;httpPath=<http- path>;AuthMech=3;UID=token;PWD=<personal-access-token>.

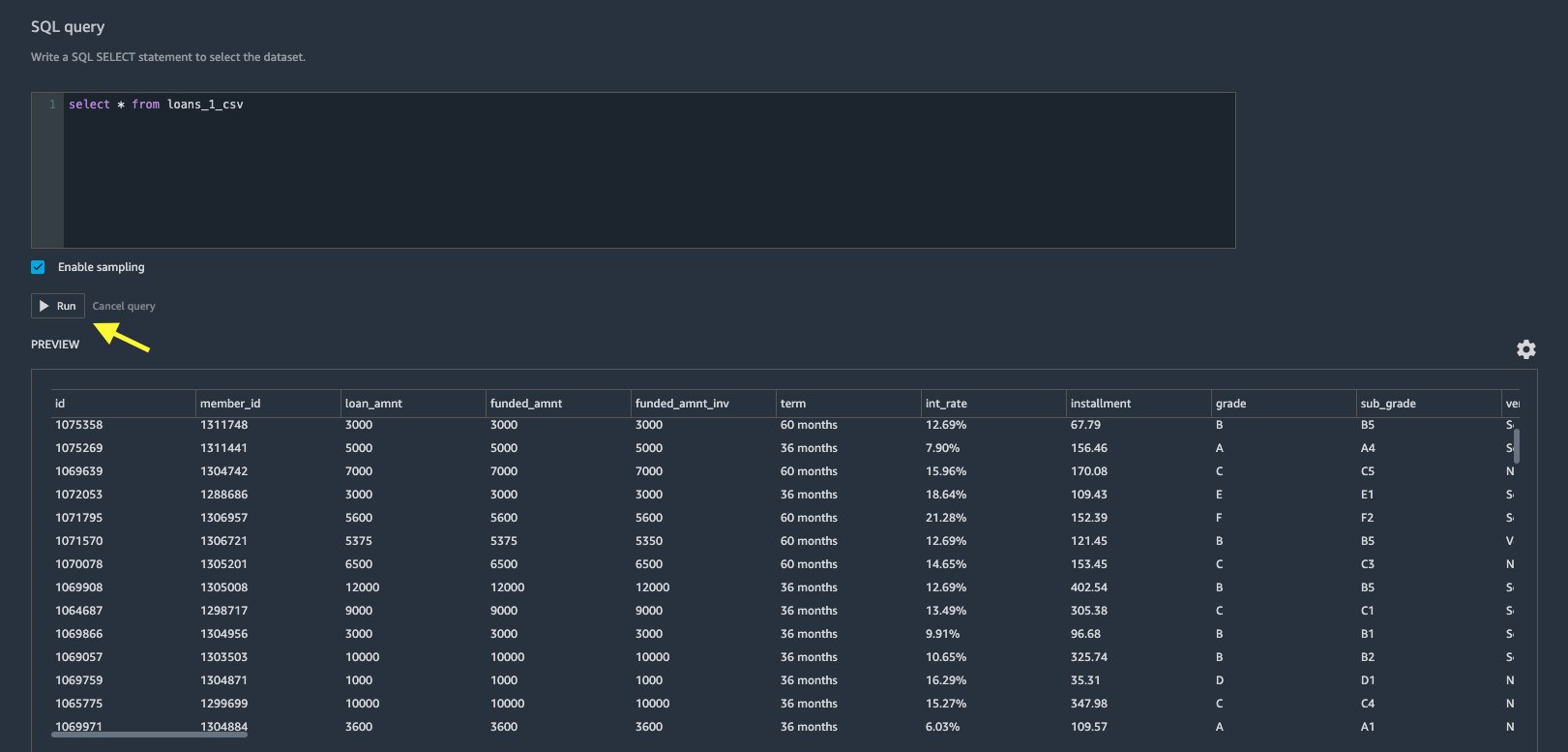

- V urejevalniku poizvedb SQL podajte naslednji stavek SQL SELECT:

Če ste med nalaganjem podatkov v Databricks izbrali drugo ime tabele, ustrezno zamenjajte loans_1 v zgornji poizvedbi SQL.

v Poizvedba SQL v razdelku Data Wrangler, lahko poizvedujete po kateri koli tabeli, ki je povezana z bazo podatkov JDBC Databricks. Vnaprej izbrani Omogoči vzorčenje nastavitev privzeto pridobi prvih 50,000 vrstic vašega nabora podatkov. Odvisno od velikosti nabora podatkov, preklic izbire Omogoči vzorčenje lahko povzroči daljši čas uvoza.

- Izberite Run.

Izvajanje poizvedbe omogoča predogled vašega nabora podatkov Databricks neposredno v Data Wranglerju.

Data Wrangler zagotavlja prilagodljivost za nastavitev več sočasnih povezav z eno gručo Databricks ali več gruč, če je potrebno, kar omogoča analizo in pripravo na kombiniranih nizih podatkov.

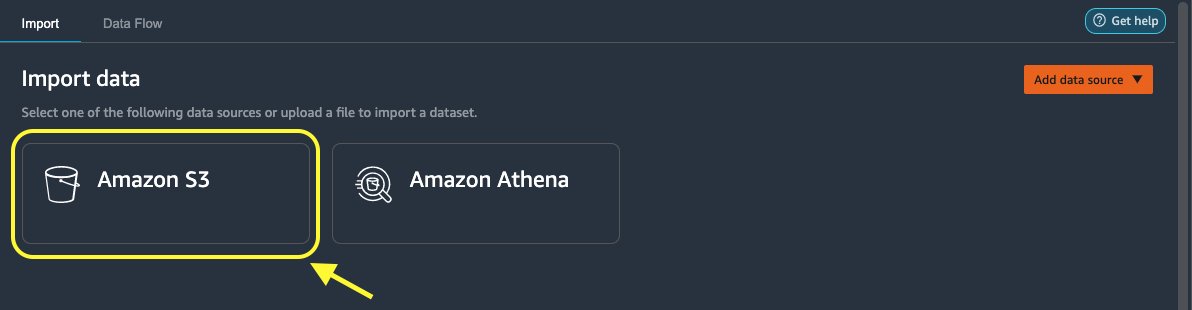

Uvozite podatke iz Amazon S3 v Data Wrangler

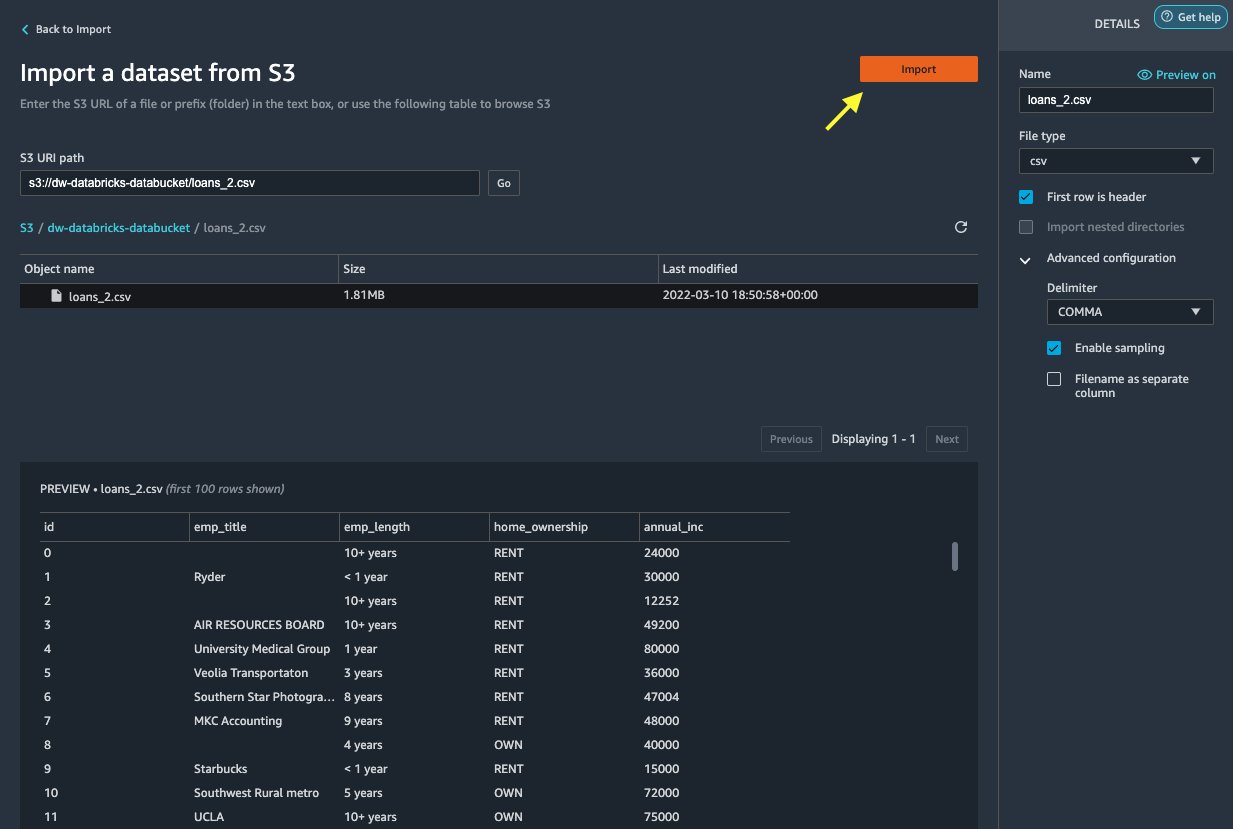

Nato uvozimo loan_2.csv datoteko iz Amazon S3.

- Na zavihku Uvozi izberite Amazon S3 kot vir podatkov.

- Pomaknite se do vedra S3 za

loan_2.csvDatoteka.

Ko izberete datoteko CSV, si lahko predogledate podatke.

- v podrobnosti podokno, izberite Napredna konfiguracija Prepričati se Omogoči vzorčenje je izbran in ODSTAVEK je izbran za Delititer.

- Izberite uvoz.

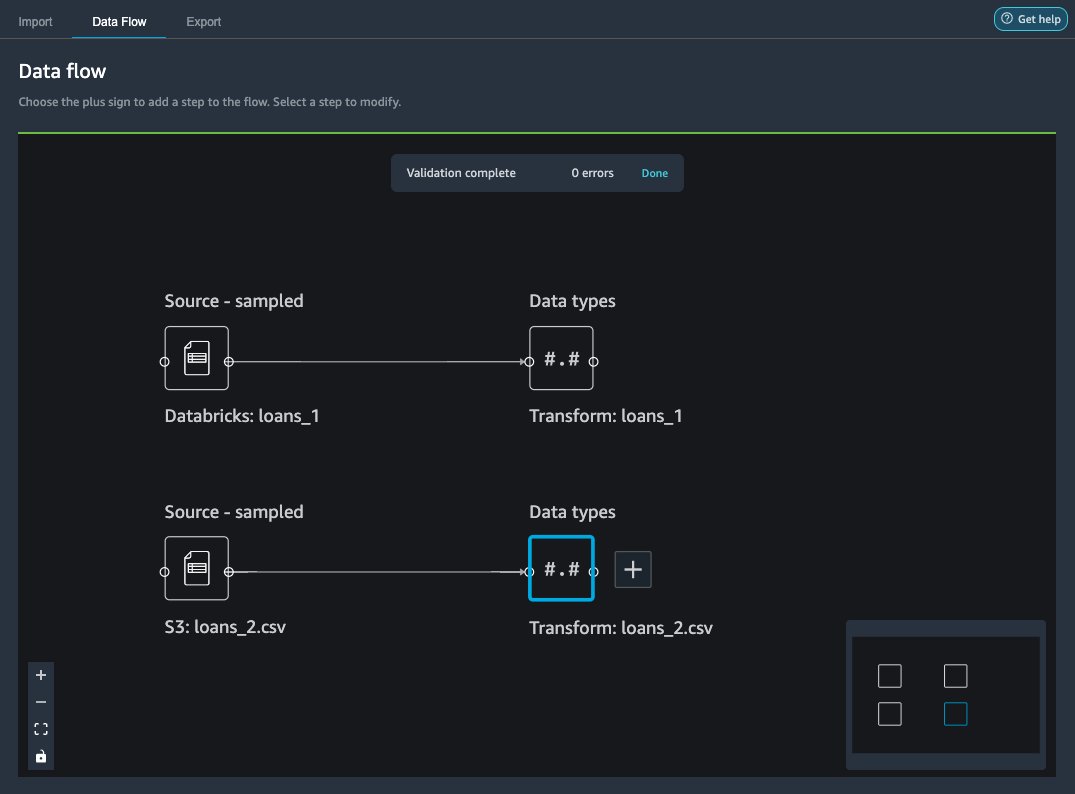

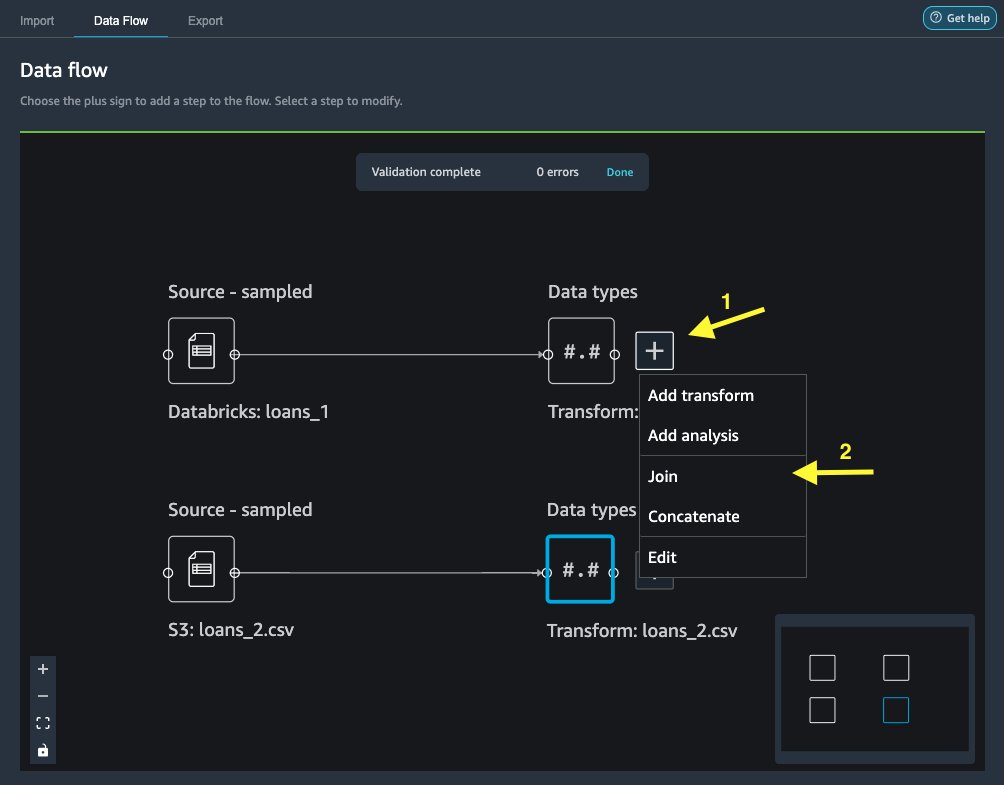

Po loans_2.csv je nabor podatkov uspešno uvožen, vmesnik za pretok podatkov prikaže vire podatkov Databricks JDBC in Amazon S3.

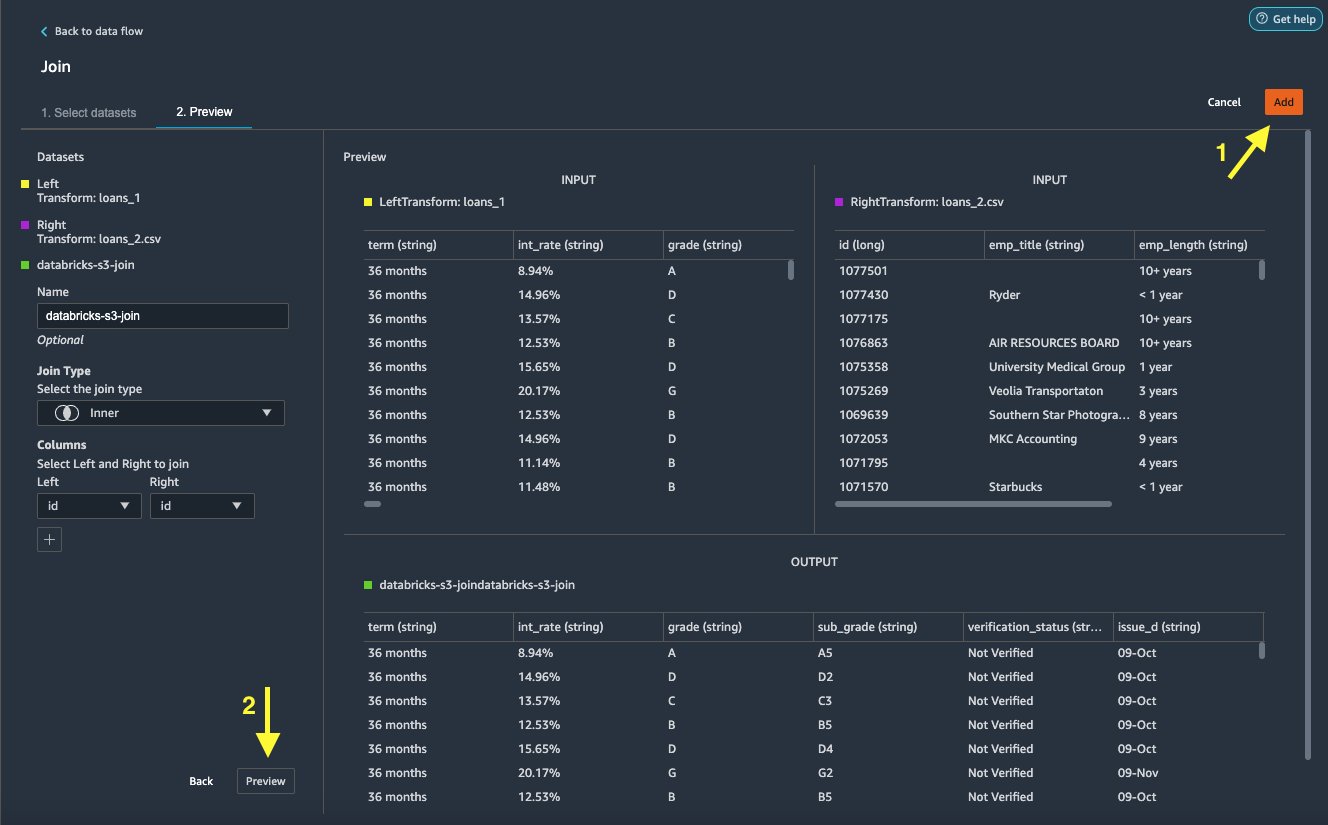

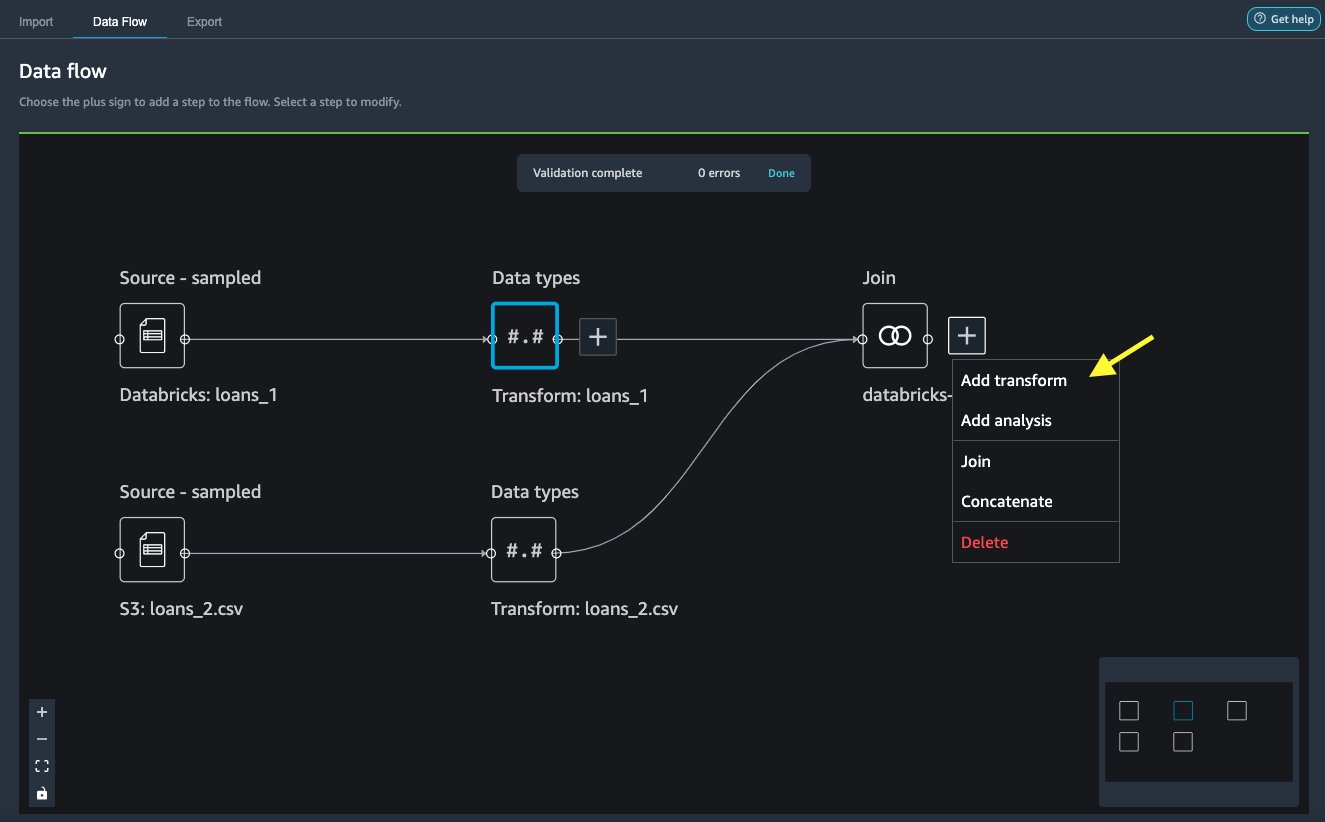

Pridruži podatke

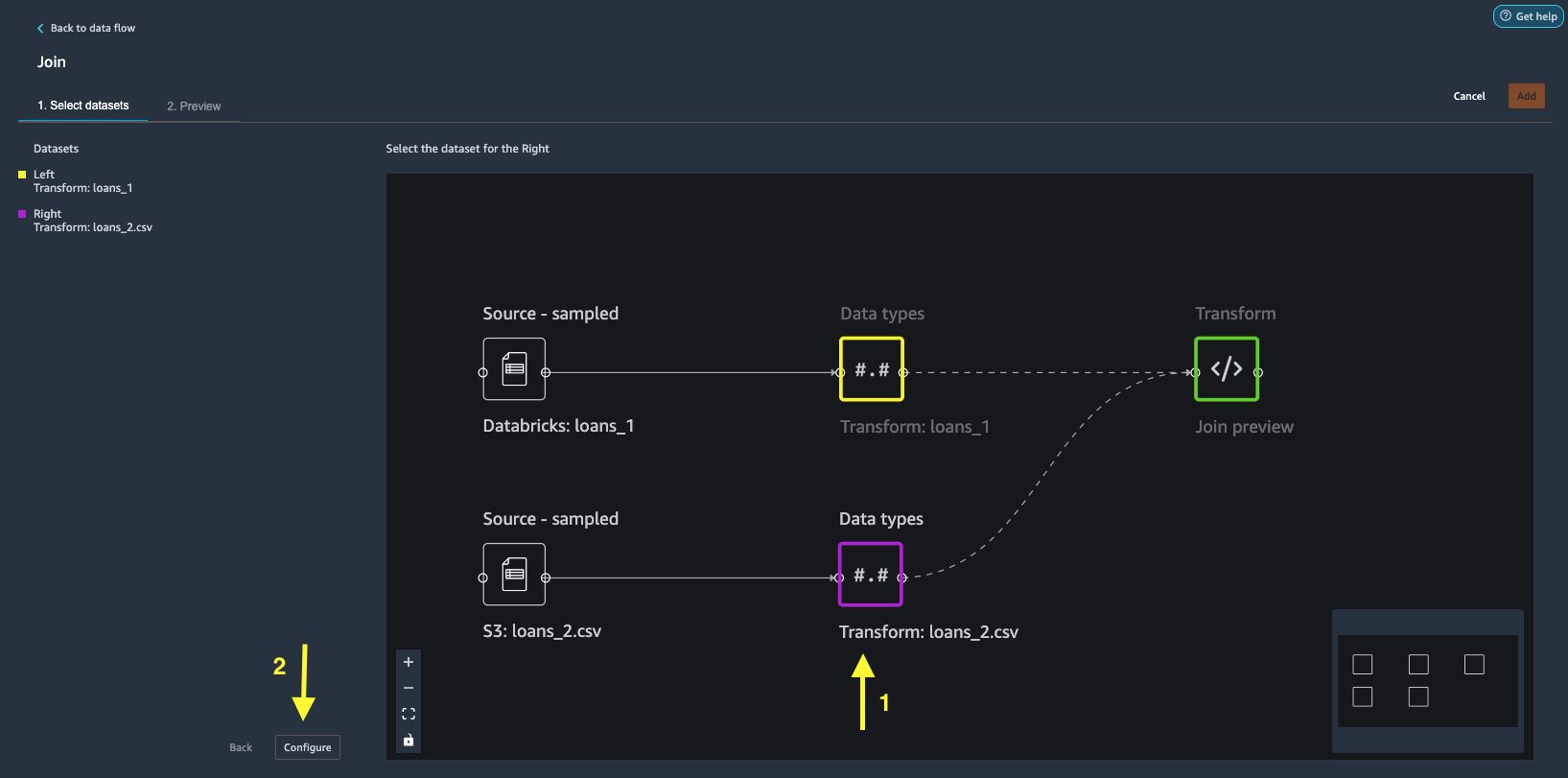

Zdaj, ko smo uvozili podatke iz Databricks in Amazon S3, združimo nabore podatkov s skupnim enoličnim identifikatorskim stolpcem.

- o Pretok podatkov zavihek, za Vrste podatkov, izberite znak plus za

loans_1. - Izberite pridruži se.

- Izberite

loans_2.csvdatoteko kot Prav nabor podatkov. - Izberite Konfiguracija za nastavitev meril pridružitve.

- za Ime, vnesite ime za pridružitev.

- za Vrsta pridružitve, izberite Notranja za to objavo.

- Izberite

idstolpec, ki se mu želite pridružiti. - Izberite Uporabi za predogled združenega nabora podatkov.

- Izberite Dodaj da ga dodate v tok podatkov.

Uporabi transformacije

Data Wrangler ima več kot 300 vgrajenih transformacij, ki ne zahtevajo kodiranja. Za pripravo nabora podatkov uporabimo vgrajene transformacije.

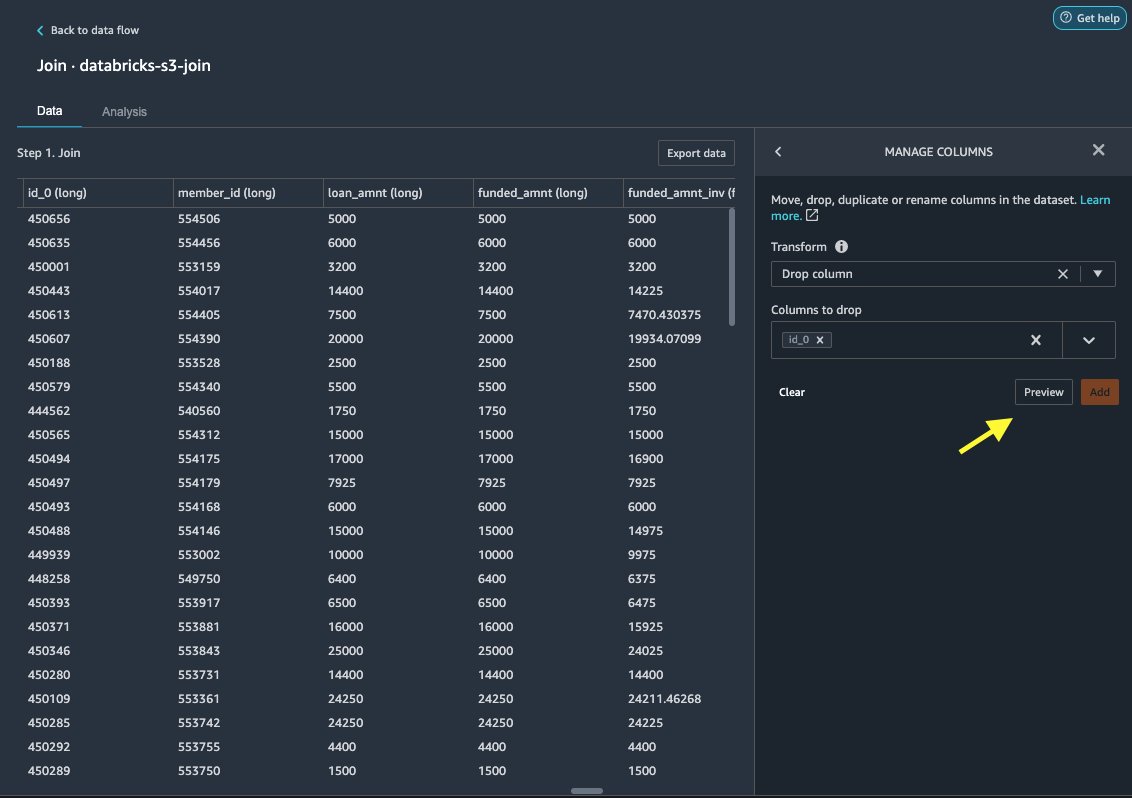

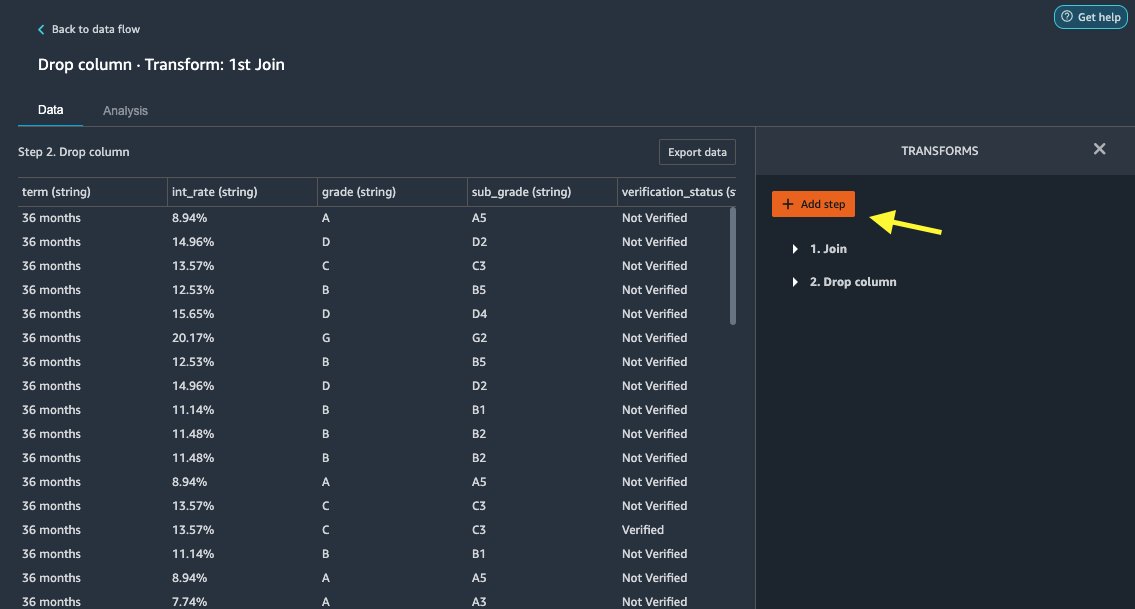

Spustite stolpec

Najprej izpustimo odvečni stolpec ID.

- Na združenem vozlišču izberite znak plus.

- Izberite Dodaj preoblikovanje.

- Pod preoblikuje, izberite + Dodaj korak.

- Izberite Upravljanje stolpcev.

- za Transform, izberite Spustite stolpec.

- za Stolpci za spuščanje, izberite stolpec

id_0. - Izberite predogled.

- Izberite Dodaj.

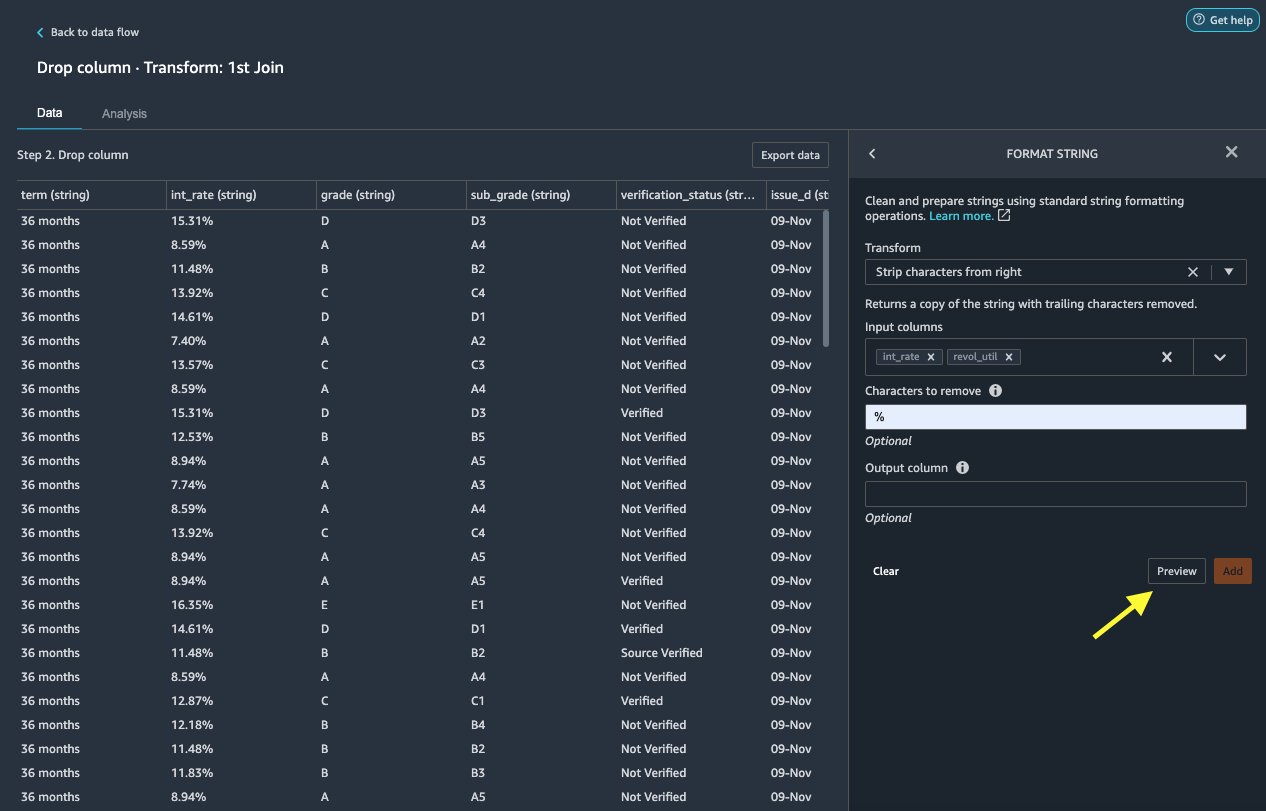

Oblikuj niz

Uporabimo oblikovanje niza, da odstranimo simbol odstotka iz int_rate in revol_util stolpcev.

- o datum zavihek, pod Preoblikuje, izberite + Dodaj korak.

- Izberite Oblikuj niz.

- za Transform, izberite Črtaj znake z desne.

Data Wrangler vam omogoča, da izbrano transformacijo uporabite na več stolpcih hkrati.

- za Vnosni stolpci, izberite

int_rateinrevol_util. - za Znaki za odstranitev, vnesite

%. - Izberite predogled.

- Izberite Dodaj.

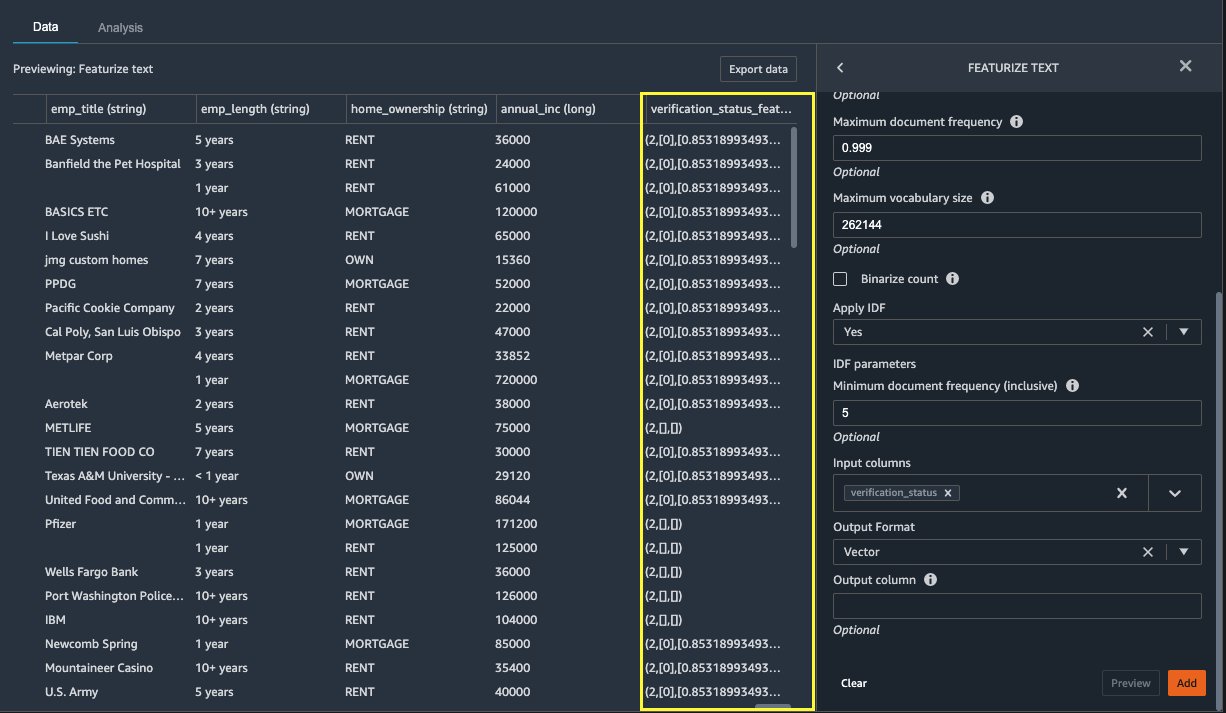

Označite besedilo

Zdaj vektorizirajmo verification_status, stolpec s funkcijo besedila. Besedilni stolpec pretvorimo v vektorje frekvence termina–inverzne frekvence dokumenta (TF-IDF) z uporabo vektorizatorja štetja in standardnega tokenizatorja, kot je opisano spodaj. Data Wrangler ponuja tudi možnost, da po želji prinesete svoj lasten tokenizer.

- Pod transformatorji, izberite + Dodaj korak.

- Izberite Označite besedilo.

- za Transform, izberite Vektorizirajte.

- za Vnosni stolpci, izberite

verification_status. - Izberite predogled.

- Izberite Dodaj.

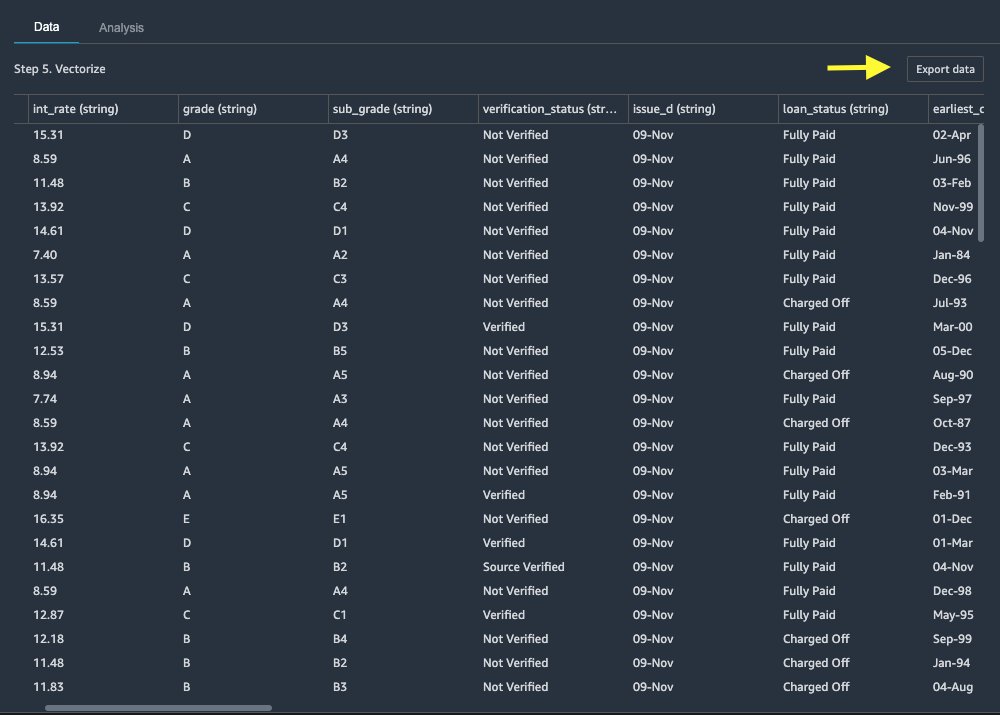

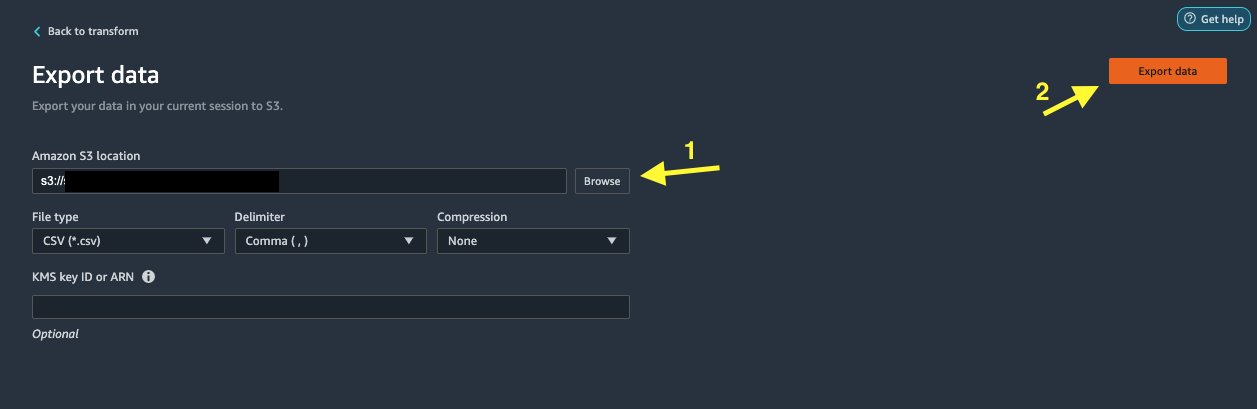

Izvozi nabor podatkov

Ko uporabimo več transformacij za različne vrste stolpcev, vključno z besedilnimi, kategoričnimi in številskimi, smo pripravljeni za uporabo transformiranega nabora podatkov za usposabljanje modela ML. Zadnji korak je izvoz transformiranega nabora podatkov v Amazon S3. V Data Wranglerju imate na izbiro več možnosti za nadaljnjo uporabo transformacij:

- Izberite Korak izvoza za samodejno ustvarjanje prenosnega računalnika Jupyter s kodo SageMaker Processing za obdelavo in izvoz transformiranega nabora podatkov v vedro S3. Za več informacij glejte Zaženite opravila obdelave z nekaj kliki z uporabo Amazon SageMaker Data Wrangler.

- Izvozite prenosnik Studio, ki ustvari a Cevovod SageMaker z vašim pretokom podatkov ali prenosni računalnik, ki ustvari Trgovina s funkcijami Amazon SageMaker skupino funkcij in doda funkcije v spletno trgovino s funkcijami brez povezave.

- Izberite Izvozi podatke za neposredni izvoz v Amazon S3.

V tej objavi izkoriščamo prednosti Izvozi podatke možnost v Transform za izvoz preoblikovanega nabora podatkov neposredno v Amazon S3.

- Izberite Izvozi podatke.

- za S3 lokacija, izberite Brskanje in izberite svoje vedro S3.

- Izberite Izvozi podatke.

Čiščenje

Če je vaše delo s Data Wrangler končano, zaustavite primer Data Wrangler v izogib dodatnim pristojbinam.

zaključek

V tej objavi smo obravnavali, kako lahko hitro in preprosto nastavite in povežete Databricks kot vir podatkov v Data Wranglerju, interaktivno poizvedujete po podatkih, shranjenih v Databricks, z uporabo SQL, in predogledate podatke pred uvozom. Poleg tega smo pogledali, kako lahko svoje podatke v Databricks združite s podatki, shranjenimi v Amazon S3. Nato smo uporabili transformacije podatkov na kombiniranem naboru podatkov, da smo ustvarili cevovod za pripravo podatkov. Če želite raziskati več zmožnosti analize Data Wranglerja, vključno z ustvarjanjem poročil o uhajanju ciljev in pristranskosti, si oglejte naslednjo objavo v spletnem dnevniku Pospešite pripravo podatkov z Amazon SageMaker Data Wrangler za predvidevanje ponovnega sprejema diabetičnega bolnika.

Za začetek uporabe Data Wrangler glejte Pripravite podatke ML z Amazon SageMaker Data Wranglerin si oglejte najnovejše informacije o Data Wranglerju Stran izdelka.

O avtorjih

Roop Bains je arhitekt rešitev pri AWS, ki se osredotoča na AI/ML. Strastno želi pomagati strankam pri inovacijah in doseganju njihovih poslovnih ciljev z uporabo umetne inteligence in strojnega učenja. V prostem času Roop uživa v branju in pohodništvu.

Roop Bains je arhitekt rešitev pri AWS, ki se osredotoča na AI/ML. Strastno želi pomagati strankam pri inovacijah in doseganju njihovih poslovnih ciljev z uporabo umetne inteligence in strojnega učenja. V prostem času Roop uživa v branju in pohodništvu.

Igor Alekseev je arhitekt partnerskih rešitev pri AWS na področju podatkov in analitike. Igor sodeluje s strateškimi partnerji in jim pomaga zgraditi kompleksne arhitekture, optimizirane za AWS. Preden se je pridružil AWS, je kot Data/Solution Architect izvajal številne projekte na področju velikih podatkov, vključno z več podatkovnimi jezeri v ekosistemu Hadoop. Kot podatkovni inženir je sodeloval pri uporabi AI/ML za odkrivanje goljufij in pisarniško avtomatizacijo. Igorjevi projekti so bili v različnih panogah, vključno s komunikacijami, financami, javno varnostjo, proizvodnjo in zdravstvenim varstvom. Prej je Igor delal kot full stack inženir/tehnični vodja.

Igor Alekseev je arhitekt partnerskih rešitev pri AWS na področju podatkov in analitike. Igor sodeluje s strateškimi partnerji in jim pomaga zgraditi kompleksne arhitekture, optimizirane za AWS. Preden se je pridružil AWS, je kot Data/Solution Architect izvajal številne projekte na področju velikih podatkov, vključno z več podatkovnimi jezeri v ekosistemu Hadoop. Kot podatkovni inženir je sodeloval pri uporabi AI/ML za odkrivanje goljufij in pisarniško avtomatizacijo. Igorjevi projekti so bili v različnih panogah, vključno s komunikacijami, financami, javno varnostjo, proizvodnjo in zdravstvenim varstvom. Prej je Igor delal kot full stack inženir/tehnični vodja.

Huong Nguyen je starejša vodja izdelkov pri AWS. Vodi uporabniško izkušnjo za SageMaker Studio. Ima 13 let izkušenj pri ustvarjanju izdelkov, ki jih obvladujejo kupci in temeljijo na podatkih tako za podjetja kot za potrošnike. V prostem času rada bere, je v naravi in se druži z družino.

Huong Nguyen je starejša vodja izdelkov pri AWS. Vodi uporabniško izkušnjo za SageMaker Studio. Ima 13 let izkušenj pri ustvarjanju izdelkov, ki jih obvladujejo kupci in temeljijo na podatkih tako za podjetja kot za potrošnike. V prostem času rada bere, je v naravi in se druži z družino.

Henry Wang je inženir za razvoj programske opreme pri AWS. Nedavno se je po diplomi na UC Davis pridružil ekipi Data Wrangler. Zanimata ga podatkovna znanost in strojno učenje, za hobi pa se ukvarja s 3D-tiskanjem.

Henry Wang je inženir za razvoj programske opreme pri AWS. Nedavno se je po diplomi na UC Davis pridružil ekipi Data Wrangler. Zanimata ga podatkovna znanost in strojno učenje, za hobi pa se ukvarja s 3D-tiskanjem.

- Coinsmart. Najboljša evropska borza bitcoinov in kriptovalut.

- Platoblockchain. Web3 Metaverse Intelligence. Razširjeno znanje. PROST DOSTOP.

- CryptoHawk. Altcoin radar. Brezplačen preizkus.

- Vir: https://aws.amazon.com/blogs/machine-learning/prepare-data-from-databricks-for-machine-learning-using-amazon-sagemaker-data-wrangler/

- "

- 000

- 100

- 39

- 3d

- O meni

- dostop

- prilagoditi

- Dodatne

- napredno

- Prednost

- algoritmi

- vsi

- Amazon

- Analiza

- analitika

- Uporaba

- Arhitektura

- umetni

- Umetna inteligenca

- Umetna inteligenca in strojno učenje

- dodeljena

- Avtomatizacija

- AWS

- počutje

- BEST

- Big Podatki

- Blog

- meja

- izgradnjo

- vgrajeno

- poslovni

- Zmogljivosti

- primeri

- Izberite

- čiščenje

- klub

- Koda

- Kodiranje

- Stolpec

- kombinirani

- Skupno

- Communications

- kompleksna

- konfiguracija

- povezane

- povezava

- povezave

- premislek

- Konzole

- konsolidacijo

- Potrošnik

- poraba

- Vsebuje

- ustvaril

- ustvari

- Ustvarjanje

- Trenutna

- Stranke, ki so

- datum

- znanost o podatkih

- Baze podatkov

- zamuda

- Odvisno

- Odkrivanje

- Razvoj

- drugačen

- neposredno

- prikazovalniki

- navzdol

- voznik

- Drop

- enostavno

- ekosistem

- urednik

- omogočajo

- omogočanje

- inženir

- Inženiring

- Vnesite

- Podjetje

- Primer

- Razen

- izvedba

- izkušnje

- raziskuje

- družina

- Feature

- Lastnosti

- pristojbine

- financiranje

- prva

- prilagodljivost

- Pretok

- po

- format

- goljufija

- polno

- ustvarjajo

- generacija

- dobro

- upravljanje

- skupina

- zdravstveno varstvo

- pomoč

- Kako

- HTTPS

- identiteta

- izvajali

- Pomembno

- uvoz

- Vključno

- industrij

- Podatki

- vpogledi

- Intelligence

- obresti

- vmesnik

- naložbe

- vključeni

- IT

- Delovna mesta

- pridružite

- pridružil

- Oznake

- jezik

- Zadnji

- vodi

- vodi

- učenje

- posojanje

- Posojila

- Pogledal

- stroj

- strojno učenje

- upravitelj

- proizvodnja

- ML

- Model

- modeli

- več

- več

- naravna

- Narava

- ostalo

- Nove funkcije

- prenosnik

- Ponudbe

- offline

- na spletu

- Možnost

- možnosti

- Da

- lastne

- partner

- partnerji

- strastno

- Plačilo

- odstotek

- performance

- Osebni

- faza

- platforma

- politika

- Napovedi

- predogled

- Postopek

- Izdelek

- Izdelki

- Programiranje

- projekti

- zagotavlja

- zagotavljanje

- javnega

- namene

- hitro

- Surovi

- reading

- zmanjšanje

- poročilo

- zahteva

- obvezna

- odgovorna

- tek

- Varnost

- Znanost

- Znanstveniki

- izbran

- Serija

- Storitev

- nastavite

- nastavitev

- pomemben

- Enostavno

- Velikosti

- Software

- Razvoj programske opreme

- Rešitev

- rešitve

- prostori

- preživeti

- Poraba

- po delih

- sveženj

- standardna

- Začetek

- začel

- Izjava

- Status

- shranjevanje

- trgovina

- Strateško

- močna

- studio

- Uspešno

- podpora

- ciljna

- skupina

- skozi

- čas

- usposabljanje

- Transform

- Preoblikovanje

- ui

- edinstven

- Nadgradnja

- uporaba

- raznolikost

- različnih

- medtem

- brez

- delo

- delal

- deluje

- pisanje