Dostava podatkov in vpogledov v skoraj realnem času omogoča podjetjem, da se hitro odzovejo na potrebe svojih strank. Podatki v realnem času lahko prihajajo iz različnih virov, vključno s socialnimi mediji, napravami IoT, nadzorom infrastrukture, nadzorom klicnega centra in več. Zaradi širine in globine podatkov, ki se zaužijejo iz več virov, podjetja iščejo rešitve za zaščito zasebnosti svojih strank in preprečujejo dostop do občutljivih podatkov iz končnih sistemov. Prej ste se morali zanašati na mehanizme pravil za podatke, ki omogočajo osebno identifikacijo (PII), ki so lahko označevali lažno pozitivne ali zgrešene podatke, ali pa ste morali zgraditi in vzdrževati modele strojnega učenja (ML) po meri za prepoznavanje PII v vaših pretočnih podatkih. Prav tako ste morali uvesti in vzdrževati infrastrukturo, potrebno za podporo teh motorjev ali modelov.

Za poenostavitev tega postopka in zmanjšanje stroškov lahko uporabite Amazonsko razumevanje, storitev za obdelavo naravnega jezika (NLP), ki uporablja ML za iskanje vpogledov in odnosov, kot so ljudje, kraji, občutki in teme v nestrukturiranem besedilu. Zdaj lahko uporabite zmogljivosti Amazon Comprehend ML za odkrivanje in urejanje PII v e-poštnih sporočilih strank, vstopnicah za podporo, ocenah izdelkov, družbenih medijih in še več. Izkušnje ML niso potrebne. Na primer, lahko analizirate zahteve za podporo in članke znanja, da odkrijete entitete PII in popravite besedilo, preden indeksirate dokumente. Po tem so dokumenti brez entitet PII in uporabniki lahko uporabljajo podatke. Redigiranje subjektov, ki omogočajo osebno prepoznavo, vam pomaga zaščititi zasebnost vaše stranke in spoštovati lokalne zakone in predpise.

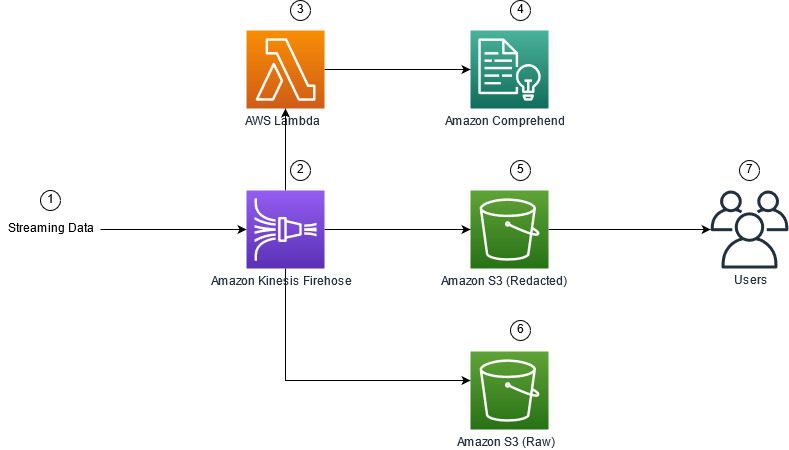

V tem prispevku se boste naučili implementirati Amazon Comprehend v svoje pretočne arhitekture za redigiranje oseb PII v skoraj realnem času z uporabo Amazon Kinesis Data Firehose z AWS Lambda.

Ta objava je osredotočena na redigiranje podatkov iz izbranih polj, ki so zaužiti v pretočno arhitekturo z uporabo Kinesis Data Firehose, kjer želite ustvariti, shraniti in vzdrževati dodatne izpeljane kopije podatkov za uporabo s strani končnih uporabnikov ali nadaljnjih aplikacij. Če uporabljate Amazonski kinezi podatkovni tokovi ali imajo dodatne primere uporabe zunaj redakcije PII, glejte Prevajanje, urejanje in analiziranje pretočnih podatkov s funkcijami SQL z Amazon Kinesis Data Analytics, Amazon Translate in Amazon Comprehend, kjer pokažemo, kako lahko uporabite Amazon Kinesis Data Analytics Studio powered by Apaški cepelin in Apache Flash za interaktivno analizo, prevajanje in urejanje besedilnih polj v pretočnih podatkih.

Pregled rešitev

Naslednja slika prikazuje primer arhitekture za izvajanje redakcije PII pretočnih podatkov v realnem času z uporabo Preprosta storitev shranjevanja Amazon (Amazon S3), Transformacija podatkov Kinesis Data Firehose, Amazonsko razumevanjein AWS Lambda. Poleg tega uporabljamo AWS SDK za Python (Boto3) za funkcije Lambda. Kot je prikazano v diagramu, neobdelano vedro S3 vsebuje neredigirane podatke, redigirano vedro S3 pa vsebuje redigirane podatke po uporabi Amazon Comprehend DetectPiiEntities API znotraj funkcije Lambda.

Vključeni stroški

Poleg stroškov Kinesis Data Firehose, Amazon S3 in Lambda bo ta rešitev povzročila stroške uporabe storitve Amazon Comprehend. Znesek, ki ga plačate, je faktor skupnega števila zapisov, ki vsebujejo PII in znake, ki jih obdela funkcija Lambda. Za več informacij glejte Cene Amazon Kinesis Data Firehose, Amazonske celovite cenein AWS Lambda cene.

Na primer, predpostavimo, da imate 10,000 zapisov dnevnikov in da je ključna vrednost, iz katere želite redigirati PII, 500 znakov. Od 10,000 dnevniških zapisov je za 50 opredeljenih, da vsebujejo PII. Podrobnosti o stroških so naslednje:

Vsebuje PII stroške:

- Velikost posamezne vrednosti ključa = 500 znakov (1 enota = 100 znakov)

- Število enot (100 znakov) na zapis (najmanjše število je 3 enote) = 5

- Skupno število enot = 10,000 (zapisov) x 5 (enot na zapis) x 1 (zahtev Amazon Comprehend na zapis) = 50,000

- Cena na enoto = 0.000002 USD

- Skupni strošek za identifikacijo dnevniških zapisov s PII z uporabo ContainsPiiEntities API = 0.1 USD [50,000 enot x 0.000002 USD]

Uredi stroške PII:

- Skupno število enot, ki vsebujejo PII = 50 (zapisov) x 5 (enot na zapis) x 1 (zahtev Amazon Comprehend na zapis) = 250

- Cena na enoto = 0.0001 USD

- Skupni stroški za prepoznavanje lokacije PII z uporabo DetectPiiEntities API = [število enot] x [strošek na enoto] = 250 x 0.0001 USD = 0.025 USD

Skupni stroški identifikacije in redakcije:

- Skupni stroški: 0.1 USD (preverjanje, če polje vsebuje podatke, ki omogočajo osebno prepoznavo) + 0.025 USD (uredi polja, ki vsebujejo podatke, ki omogočajo osebno prepoznavo) = 0.125 USD

Razmestite rešitev z AWS CloudFormation

Za to objavo nudimo Oblikovanje oblaka AWS redakcijo pretočnih podatkov Predloga, ki zagotavlja vse podrobnosti o izvedbi za omogočanje ponovljivih uvajanj. Po uvedbi ta predloga ustvari dve vedri S3: eno za shranjevanje neobdelanih vzorčnih podatkov, zaužitih iz Amazon Kinesis Data Generator (KDG), in eno za shranjevanje redigiranih podatkov. Poleg tega ustvari tok dostave Kinesis Data Firehose s DirectPUT kot vhod in funkcijo Lambda, ki kliče Amazon Comprehend VsebujePiiEntities in DetectPiiEntities API za prepoznavanje in urejanje podatkov, ki omogočajo osebno prepoznavo. Funkcija Lambda se opira na uporabniški vnos v spremenljivke okolja, da določi, katere ključne vrednosti je treba pregledati za PII.

Funkcija Lambda v tej rešitvi ima omejeno velikost tovora na 100 KB. Če je podana koristna obremenitev, kjer je besedilo večje od 100 KB, jo bo funkcija Lambda preskočila.

Za namestitev rešitve izvedite naslednje korake:

- Zaženite sklad CloudFormation na vzhodu ZDA (N. Virginia)

us-east-1:

- Vnesite ime sklada in pustite druge parametre privzete

- Izberite Potrjujem, da lahko AWS CloudFormation ustvari vire IAM z imeni po meri.

- Izberite Ustvari sklad.

Ročno razporedite sredstva

Če želite arhitekturo zgraditi ročno namesto z uporabo AWS CloudFormation, dokončajte korake v tem razdelku.

Ustvarite vedra S3

Ustvarite vedra S3 z naslednjimi koraki:

- Na konzoli Amazon S3 izberite Žlice v podoknu za krmarjenje.

- Izberite Ustvari vedro.

- Ustvarite eno vedro za svoje neobdelane podatke in eno za redigirane podatke.

- Zapomnite si imena veder, ki ste jih pravkar ustvarili.

Ustvarite funkcijo Lambda

Če želite ustvariti in razmestiti funkcijo Lambda, dokončajte naslednje korake:

- Na konzoli Lambda izberite Ustvari funkcijo.

- Izberite Avtor iz nič.

- za Ime funkcije, vnesite

AmazonComprehendPII-Redact. - za Čas izvajanja, izberite Python 3.9.

- za Arhitekturatako, da izberete x86_64.

- za Izvršilna vlogatako, da izberete Ustvarite novo vlogo z dovoljenji Lambda.

- Ko ustvarite funkcijo, vnesite to kodo:

- Izberite uvajanje.

- V podoknu za krmarjenje izberite Konfiguracija.

- Pomaknite se na Spremenljivke okolja.

- Izberite Uredi.

- za Ključne, vnesite

keys. - za vrednost, vnesite ključne vrednosti, iz katerih želite odstraniti PID, ločene z vejico in presledkom. Na primer, enter

Tweet1,Tweet2če uporabljate vzorčne testne podatke, navedene v naslednjem razdelku te objave. - Izberite Shrani.

- Pomaknite se na Splošna konfiguracija.

- Izberite Uredi.

- Spremenite vrednost Timeout do 1 minute.

- Izberite Shrani.

- Pomaknite se na Dovoljenja.

- Izberite ime vloge pod Izvršilna vloga.

Preusmerjeni ste na AWS upravljanje identitete in dostopa (IAM) konzola. - za Dodajte dovoljenja, izberite Priložite pravilnike.

- Vnesite

Comprehendv iskalno vrstico in izberite pravilnikComprehendFullAccess. - Izberite Priložite pravilnike.

Ustvarite tok dostave Firehose

Če želite ustvariti tok dostave Firehose, izvedite naslednje korake:

- Na konzoli Kinesis Data Firehose izberite Ustvari tok dostave.

- za virtako, da izberete Neposredni PUT.

- za destinacijatako, da izberete Amazon S3.

- za Ime toka dostave, vnesite

ComprehendRealTimeBlog. - Pod Pretvorite izvorne zapise z AWS Lambdatako, da izberete omogočeno.

- za AWS Lambda funkcija, vnesite ARN za funkcijo, ki ste jo ustvarili, ali poiščite funkcijo

AmazonComprehendPII-Redact. - za Velikost pufra, nastavite vrednost na 1 MB.

- za Interval medpomnilnika, pustite 60 sekund.

- Pod Nastavitve cilja, izberite vedro S3, ki ste ga ustvarili za redigirane podatke.

- Pod Nastavitve varnostnih kopij, izberite vedro S3, ki ste ga ustvarili za neobdelane zapise.

- Pod Dovoljenje, ustvarite ali posodobite vlogo IAM ali izberite obstoječo vlogo z ustreznimi dovoljenji.

- Izberite Ustvari tok dostave.

Razmestite rešitev za pretakanje podatkov s Kinesis Data Generatorjem

Generator podatkov Kinesis (KDG) lahko uporabite za vnos vzorčnih podatkov v Kinesis Data Firehose in preizkusite rešitev. Za poenostavitev tega postopka ponujamo funkcijo Lambda in predlogo CloudFormation za ustvarjanje Amazon Cognito uporabnika in dodeli ustrezna dovoljenja za uporabo KDG.

- o Stran Amazon Kinesis Data Generator, izberite Ustvarite uporabnika Cognito z CloudFormation.Preusmerjeni ste na konzolo AWS CloudFormation, da ustvarite svoj sklad.

- Podajte uporabniško ime in geslo za uporabnika, s katerim se prijavljate v KDG.

- Ostale nastavitve pustite privzete in ustvarite svoj sklad.

- o Izhodi izberite povezavo KDG UI.

- Za prijavo vnesite svoje uporabniško ime in geslo.

Pošljite testne zapise in potrdite redakcijo v Amazon S3

Če želite preizkusiti rešitev, opravite naslednje korake:

- Prijavite se v URL KDG, ki ste ga ustvarili v prejšnjem koraku.

- Izberite regijo, kjer je bil nameščen sklad AWS CloudFormation.

- za Tok/tok dostave, izberite tok dostave, ki ste ga ustvarili (če ste uporabili predlogo, ima obliko

accountnumber-awscomprehend-blog). - Ostale nastavitve pustite privzete.

- Za predlogo zapisa lahko ustvarite lastne teste ali uporabite naslednjo predlogo. Če za testiranje uporabljate spodnje vzorčne podatke, bi morali imeti posodobljene spremenljivke okolja v

AmazonComprehendPII-RedactLambda funkcija zaTweet1,Tweet2. Če je uveden prek CloudFormation, posodobite spremenljivke okolja naTweet1,Tweet2znotraj ustvarjene funkcije Lambda. Vzorčni testni podatki so spodaj: - Izberite Pošlji podatkein počakajte nekaj sekund, da se zapisi pošljejo v vaš tok.

- Po nekaj sekundah ustavite generator KDG in preverite vedra S3 za dostavljene datoteke.

Sledi primer neobdelanih podatkov v neobdelanem vedru S3:

Sledi primer redigiranih podatkov v redigiranem vedru S3:

Občutljivi podatki so bili odstranjeni iz redigiranih sporočil, kar zagotavlja zaupanje, da lahko te podatke delite s končnimi sistemi.

Pospravi

Ko končate s preizkušanjem te rešitve, počistite svoje vire z uporabo konzole AWS CloudFormation, da izbrišete vse vire, ki so razporejeni v tem primeru. Če ste sledili ročnim korakom, boste morali ročno izbrisati dve vedri, AmazonComprehendPII-Redact funkcija, ComprehendRealTimeBlog tok, skupina dnevnikov za ComprehendRealTimeBlog tok in vse vloge IAM, ki so bile ustvarjene.

zaključek

Ta objava vam je pokazala, kako integrirati urejanje PII v svojo arhitekturo pretakanja v skoraj realnem času in skrajšati čas obdelave podatkov z redigiranjem med letom. V tem scenariju posredujete redigirane podatke svojim končnim uporabnikom, skrbnik podatkovnega jezera pa zavaruje neobdelano vedro za kasnejšo uporabo. Prav tako lahko zgradite dodatno obdelavo z Amazon Comprehend, da prepoznate ton ali čustva, identificirate entitete v podatkih in razvrstite vsako sporočilo.

Kot del te objave smo zagotovili posamezne korake za vsako storitev in vključili tudi predlogo CloudFormation, ki vam omogoča, da zagotovite zahtevana sredstva v svojem računu. To predlogo je treba uporabiti samo za dokaz koncepta ali scenarijev testiranja. Oglejte si vodnike za razvijalce za Amazonsko razumevanje, Lambdain Kinesis Data FireHose za morebitne omejitve storitev.

Če želite začeti z identifikacijo in urejanjem PII, glejte Osebni podatki (PII). S primerom arhitekture v tej objavi bi lahko integrirali katerega koli API-ja Amazon Comprehend s podatki v skoraj realnem času s pretvorbo podatkov Kinesis Data Firehose. Če želite izvedeti več o tem, kaj lahko zgradite s svojimi podatki v skoraj realnem času s Kinesis Data Firehose, glejte Priročnik za razvijalce Amazon Kinesis Data Firehose. Ta rešitev je na voljo v vseh regijah AWS, kjer sta na voljo Amazon Comprehend in Kinesis Data Firehose.

O avtorjih

Joe Morotti je arhitekt rešitev pri Amazon Web Services (AWS), ki pomaga strankam Enterprise na srednjem zahodu ZDA. Imel je širok nabor tehničnih vlog in uživa v prikazovanju kupčeve umetnosti možnega. V prostem času uživa v kakovostnem preživljanju časa z družino, kjer raziskuje nove kraje in pretirano analizira uspešnost svoje športne ekipe.

Joe Morotti je arhitekt rešitev pri Amazon Web Services (AWS), ki pomaga strankam Enterprise na srednjem zahodu ZDA. Imel je širok nabor tehničnih vlog in uživa v prikazovanju kupčeve umetnosti možnega. V prostem času uživa v kakovostnem preživljanju časa z družino, kjer raziskuje nove kraje in pretirano analizira uspešnost svoje športne ekipe.

Sriharsh Adari je višji arhitekt rešitev pri Amazon Web Services (AWS), kjer strankam pomaga pri delu nazaj od poslovnih rezultatov do razvoja inovativnih rešitev na AWS. V preteklih letih je pomagal številnim strankam pri transformacijah podatkovne platforme v različnih industrijskih vertikalah. Njegovo osrednje strokovno področje vključuje tehnološko strategijo, podatkovno analitiko in podatkovno znanost. V prostem času rad igra tenis, gleda televizijske oddaje in igra tablo.

Sriharsh Adari je višji arhitekt rešitev pri Amazon Web Services (AWS), kjer strankam pomaga pri delu nazaj od poslovnih rezultatov do razvoja inovativnih rešitev na AWS. V preteklih letih je pomagal številnim strankam pri transformacijah podatkovne platforme v različnih industrijskih vertikalah. Njegovo osrednje strokovno področje vključuje tehnološko strategijo, podatkovno analitiko in podatkovno znanost. V prostem času rad igra tenis, gleda televizijske oddaje in igra tablo.

- AI

- ai art

- ai art generator

- imajo robota

- Amazon Kinesis

- analitika

- Umetna inteligenca

- certificiranje umetne inteligence

- umetna inteligenca v bančništvu

- robot z umetno inteligenco

- roboti z umetno inteligenco

- programska oprema za umetno inteligenco

- Strojno učenje AWS

- blockchain

- blockchain konferenca ai

- coingenius

- pogovorna umetna inteligenca

- kripto konferenca ai

- dall's

- globoko učenje

- Srednje (200)

- Kinesis Data FireHose

- strojno učenje

- platon

- platon ai

- Platonova podatkovna inteligenca

- Igra Platon

- PlatoData

- platogaming

- lestvica ai

- sintaksa

- zefirnet