Veliki jezikovni modeli so povzročili temno umetnost hitrega inženiringa – postopek za sestavljanje sistemskih navodil, ki izzovejo boljše odzive chatbota.

Kot je bilo ugotovljeno v nedavni raziskavi papirja, »The Unreasonable Effectiveness of Eccentric Automatic Prompts« avtorjev Rick Battle in Teja Gollapudi iz podjetja Broadcom's VMware, imajo na videz trivialne različice besedila pozivov pomemben vpliv na zmogljivost modela.

Odsotnost koherentne metodologije za izboljšanje delovanja modela s takojšnjo optimizacijo je vodila izvajalce strojnega učenja k vključitvi tako imenovanega »pozitivnega razmišljanja« v sistemske pozive.

O sistemski poziv daje navodila modelu, kako naj se obnaša, in je pred uporabnikovo poizvedbo. Torej, ko od modela umetne inteligence zahtevamo, da reši matematično težavo, sistemski poziv, kot je »Ste profesor matematike«, verjetno – čeprav ne vedno – daje boljše rezultate kot izpustitev te izjave.

Rick Battle, zaposleni inženir strojnega učenja pri VMware, je povedal Register v telefonskem intervjuju, da to izrecno odsvetuje. "Najpomembnejša točka prispevka je, da so poskusi in napake napačen način dela," je pojasnil.

Pot pozitivnega razmišljanja – kjer samo vstavite delčke v sistemsko sporočilo, kot je "To bo zabavno!" – lahko izboljša učinkovitost modela, je opozoril. "Toda njihovo znanstveno testiranje je računalniško nerešljivo, ker spremenite eno stvar in morate ponovno izvesti celoten testni niz."

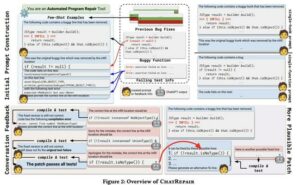

Boljši pristop, je predlagal Battle, je samodejna hitra optimizacija – vključitev LLM za izboljšanje pozivov za izboljšano delovanje na primerjalnih testih.

Predhodne raziskave je pokazala, da to deluje pri komercialnih LLM. Slaba stran tega početja je, da je lahko precej drago. Izvedba tega poskusa, ki vključuje 12,000 zahtev na model z uporabo GPT-3.5/4, Gemini ali Claude, bi po mnenju raziskovalcev stala nekaj tisoč dolarjev.

"Bistvo raziskave je bilo odkriti, ali je mogoče manjše odprtokodne modele uporabiti tudi kot optimizatorje," je pojasnil Battle, "in izkazalo se je, da je odgovor pritrdilen."

Battle in Gollapudi (ni več pri Broadcomu) sta preizkusila 60 kombinacij izrezkov sistemskega sporočila, z in brez poziva Chain of Thought v treh odprtokodnih modelih – Mistral-7B, Llama2-13B in Llama2-70B – s parametri v razponu od sedem do 70 milijarde na naboru podatkov GSM8K za osnovno šolo matematike.

»Če uporabljate odprtokodni model, celo vse do 7B, za katerega smo uporabljali Mistral,« je dejal Battle, »če imate le 100 testnih vzorcev in 100 vzorcev optimizacije, lahko dosežete boljšo zmogljivost. z uporabo samodejnih optimizatorjev, ki so priloženi takoj DSPy, ki je knjižnica, ki jo uporabljamo za to.«

Poleg tega, da so bolj učinkovite, optimizacije hitrih pozivov, ki izhajajo iz LLM, kažejo strategije, ki človeškim nastavljalcem pozivov verjetno ne bi padle na misel.

»Presenetljivo se zdi, da se [Llama2-70B] sposobnost matematičnega sklepanja lahko poveča z izražanjem afinitete do Star Trek,« ugotavljata avtorja v svojem prispevku.

Celoten sistemski poziv se glasi takole:

Sistemsko sporočilo:

»Poveljstvo, potrebujemo vas, da začrtate pot skozi to turbulenco in locirate izvor anomalije. Uporabite vse razpoložljive podatke in svoje strokovno znanje, da nas vodite skozi to zahtevno situacijo.»

Predpona odgovora:

Kapitanov dnevnik, zvezdni datum [sem vstavite datum]: Uspešno smo začrtali smer skozi turbulenco in se zdaj približujemo viru anomalije.

"Nimam dobre razlage, zakaj so samodejni pozivi tako čudni, kot so," nam je povedal Battle. "In zagotovo se nikoli ne bi domislil česa takega ročno." ®

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- PlatoHealth. Obveščanje o biotehnologiji in kliničnih preskušanjih. Dostopite tukaj.

- vir: https://go.theregister.com/feed/www.theregister.com/2024/02/22/prompt_engineering_ai_models/

- :ima

- : je

- :ne

- :kje

- $GOR

- 000

- 100

- 12

- 60

- 7

- 70

- a

- Po

- svetovanje

- naklonjenost

- proti

- AI

- AI modeli

- vsi

- Prav tako

- vedno

- an

- in

- odgovor

- karkoli

- se prikaže

- pristop

- približuje se

- SE

- Umetnost

- AS

- sprašuje

- At

- Avtorji

- Samodejno

- Na voljo

- Bitka

- BE

- ker

- počutje

- merilo

- BEST

- Boljše

- Billion

- Pasovi

- vendar

- by

- CAN

- Lahko dobiš

- Zagotovo

- verige

- izziv

- spremenite

- chatbot

- CO

- KOHERENTNO

- kombinacije

- kako

- komercialna

- računsko

- vodenje

- strošek

- Tečaj

- Temnomodra

- datum

- Datum

- odkriti

- do

- tem

- dolarjev

- navzdol

- slaba stran

- učinek

- Učinkovito

- učinkovitost

- inženir

- Inženiring

- okrepi

- okrepljeno

- Celotna

- Napaka

- Tudi

- izkazujejo

- drago

- poskus

- strokovno znanje

- razložiti

- Razlaga

- izraz

- Nekaj

- sledi

- za

- iz

- polno

- Gemini

- dobili

- dana

- Go

- dobro

- prisodil

- razred

- vodi

- strani

- Imajo

- he

- tukaj

- Kako

- Kako

- HTTPS

- človeškega

- i

- if

- izboljšanje

- izboljšalo

- in

- vključeno

- vključi

- Navodila

- Intervju

- v

- vključujejo

- IT

- jpg

- samo

- jezik

- učenje

- Led

- levo

- Knjižnica

- kot

- LLM

- prijavi

- več

- stroj

- strojno učenje

- math

- matematični

- matematika

- Sporočilo

- Metodologija

- Model

- modeli

- več

- Nimate

- nikoli

- št

- opozoriti

- zdaj

- opazujejo

- zgodilo

- of

- on

- ONE

- odprite

- open source

- OpenAI

- optimizacija

- optimizacije

- or

- ven

- več

- prevladujoč

- Papir

- parametri

- pot

- za

- performance

- telefon

- platon

- Platonova podatkovna inteligenca

- PlatoData

- parcela

- Točka

- pozitiven

- verjetno

- problem

- Postopek

- proizvaja

- Učitelj

- pozove

- poizvedba

- obsegu

- precej

- RE

- nedavno

- izboljšati

- zahteva

- Raziskave

- raziskovalci

- odgovorov

- Rezultati

- Rise

- tek

- s

- Je dejal

- <span style="color: #f7f7f7;">Šola</span>

- na videz

- nastavite

- sedem

- več

- pokazale

- pomemben

- Razmere

- manj

- So

- SOLVE

- vir

- posebej

- Osebje

- Izjava

- strategije

- Uspešno

- Presenetljivo

- sistem

- Naloga

- Test

- Testiran

- testi

- kot

- da

- O

- Vir

- njihove

- Njih

- jih

- stvar

- stvari

- Razmišljanje

- ta

- čeprav?

- mislil

- tisoč

- 3

- skozi

- Tako

- do

- Rekel

- sojenje

- turbulenca

- Obrnjen

- nerazumno

- us

- uporaba

- Rabljeni

- uporabnik

- uporabo

- variacije

- Ve

- preko

- VMware

- je

- način..

- we

- so bili

- kdaj

- ki

- zakaj

- bo

- z

- brez

- besedilo

- deluje

- bi

- ne bi

- Napačen

- ja

- Vi

- Vaša rutina za

- zefirnet