Danes z veseljem sporočamo, da je Mixtral-8x7B velik jezikovni model (LLM), ki ga je razvil Mistral AI, je strankam na voljo prek Amazon SageMaker JumpStart za uvedbo z enim klikom za tekoče sklepanje. Mixtral-8x7B LLM je vnaprej usposobljena redka mešanica ekspertnega modela, ki temelji na hrbtenici s 7 milijardami parametrov z osmimi strokovnjaki na plast za naprej. Ta model lahko preizkusite s SageMaker JumpStart, središčem za strojno učenje (ML), ki omogoča dostop do algoritmov in modelov, tako da lahko hitro začnete uporabljati ML. V tem prispevku bomo predstavili, kako odkriti in uvesti model Mixtral-8x7B.

Kaj je Mixtral-8x7B

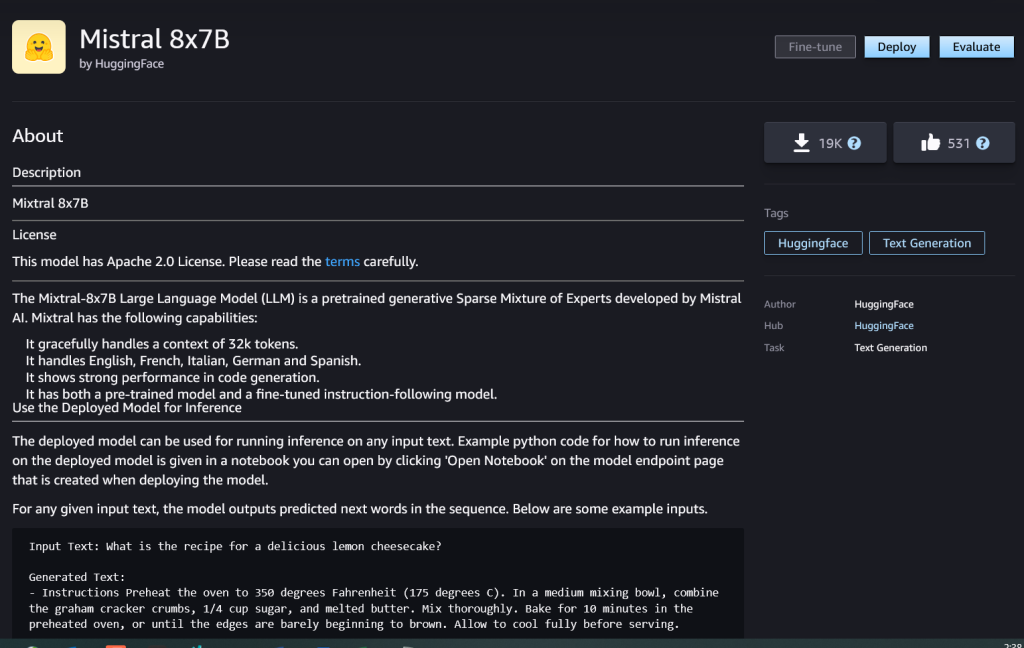

Mixtral-8x7B je temeljni model, ki ga je razvil Mistral AI, podpira angleško, francosko, nemško, italijansko in špansko besedilo z možnostjo generiranja kode. Podpira različne primere uporabe, kot so povzemanje besedila, klasifikacija, dopolnjevanje besedila in dopolnjevanje kode. V načinu klepeta se dobro obnaša. Da bi prikazal enostavno prilagodljivost modela, je Mistral AI izdal tudi model Mixtral-8x7B-instruct za primere uporabe klepeta, natančno nastavljen z uporabo različnih javno dostopnih podatkovnih nizov pogovorov. Modeli Mixtral imajo veliko dolžino konteksta do 32,000 žetonov.

Mixtral-8x7B zagotavlja znatne izboljšave zmogljivosti v primerjavi s prejšnjimi najsodobnejšimi modeli. Njegova redka mešanica arhitektur strokovnjakov mu omogoča doseganje boljših rezultatov delovanja pri 9 od 12 primerjalnih vrednosti obdelave naravnega jezika (NLP), ki jih je testiral Mistral AI. Mixtral se ujema ali presega zmogljivosti modelov, ki so do 10-krat večji od svoje velikosti. Z uporabo le delčka parametrov na žeton doseže večje hitrosti sklepanja in nižje računske stroške v primerjavi z zgoščenimi modeli enakovrednih velikosti – na primer s skupno 46.7 milijarde parametrov, vendar le 12.9 milijard uporabljenih na žeton. Zaradi te kombinacije visoke zmogljivosti, večjezične podpore in računalniške učinkovitosti je Mixtral-8x7B privlačna izbira za NLP aplikacije.

Model je na voljo pod permisivno licenco Apache 2.0 za uporabo brez omejitev.

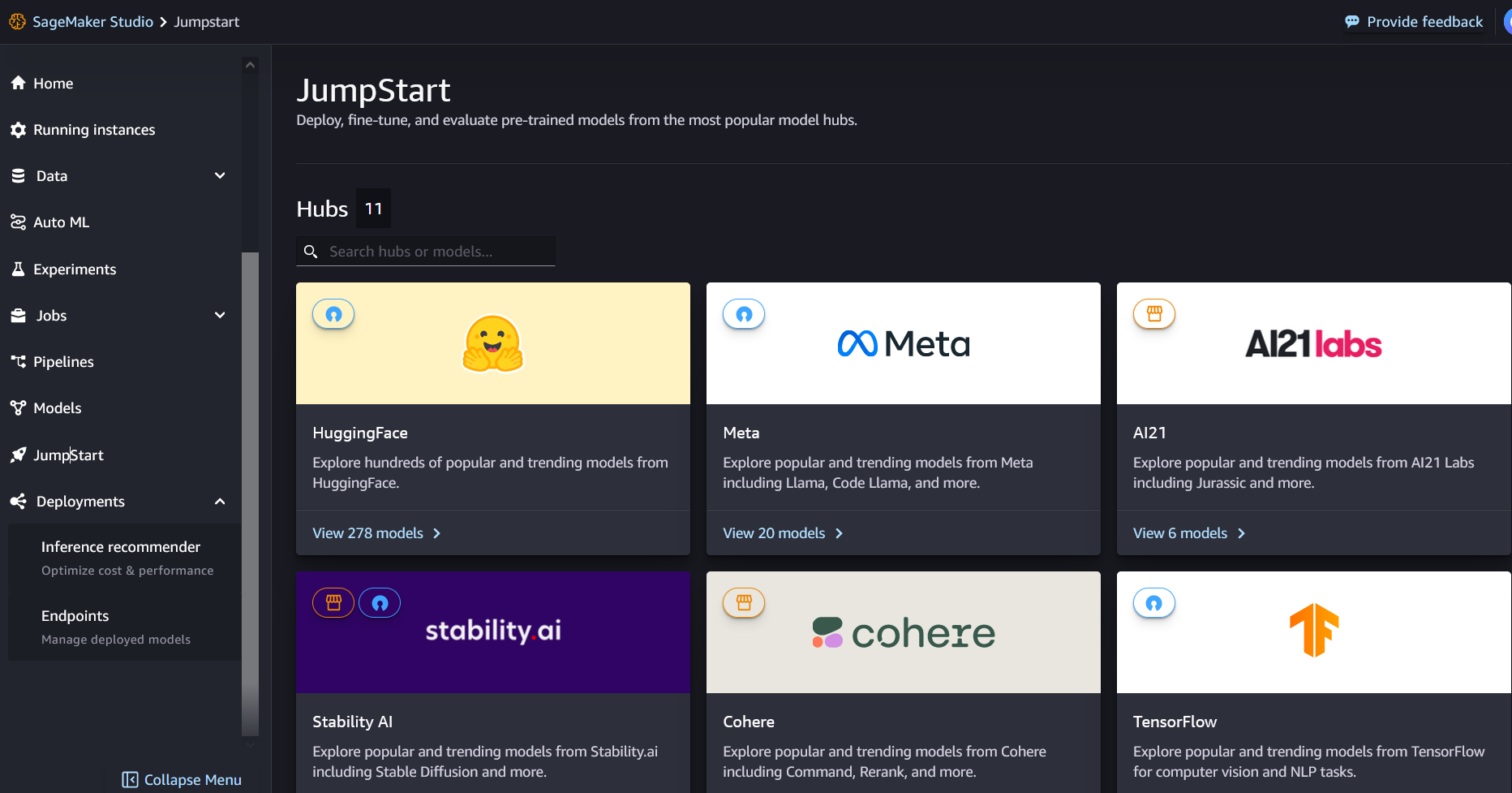

Kaj je SageMaker JumpStart

S SageMaker JumpStart lahko praktiki ML izbirajo med rastočim seznamom najuspešnejših modelov temeljev. Strokovnjaki ML lahko uvedejo temeljne modele v namenske Amazon SageMaker primerke v omrežno izoliranem okolju in prilagodite modele z uporabo SageMakerja za usposabljanje in uvajanje modelov.

Zdaj lahko odkrijete in uvedete Mixtral-8x7B z nekaj kliki Amazon SageMaker Studio ali programsko prek SDK-ja SageMaker Python, kar vam omogoča, da izpeljete zmogljivost modela in kontrole MLOps s funkcijami SageMaker, kot je Amazonski cevovodi SageMaker, Napaka Amazon SageMaker, ali kontejnerski dnevniki. Model je nameščen v varnem okolju AWS in pod vašimi kontrolami VPC, kar pomaga zagotoviti varnost podatkov.

Odkrijte modele

Do modelov temeljev Mixtral-8x7B lahko dostopate prek SageMaker JumpStart v uporabniškem vmesniku SageMaker Studio in SDK SageMaker Python. V tem razdelku bomo opisali, kako odkriti modele v SageMaker Studio.

SageMaker Studio je integrirano razvojno okolje (IDE), ki ponuja enoten spletni vizualni vmesnik, kjer lahko dostopate do namensko izdelanih orodij za izvajanje vseh razvojnih korakov ML, od priprave podatkov do gradnje, usposabljanja in uvajanja vaših modelov ML. Za več podrobnosti o tem, kako začeti in nastaviti SageMaker Studio, glejte Amazon SageMaker Studio.

V SageMaker Studio lahko do SageMaker JumpStart dostopate tako, da izberete jumpstart v podoknu za krmarjenje.

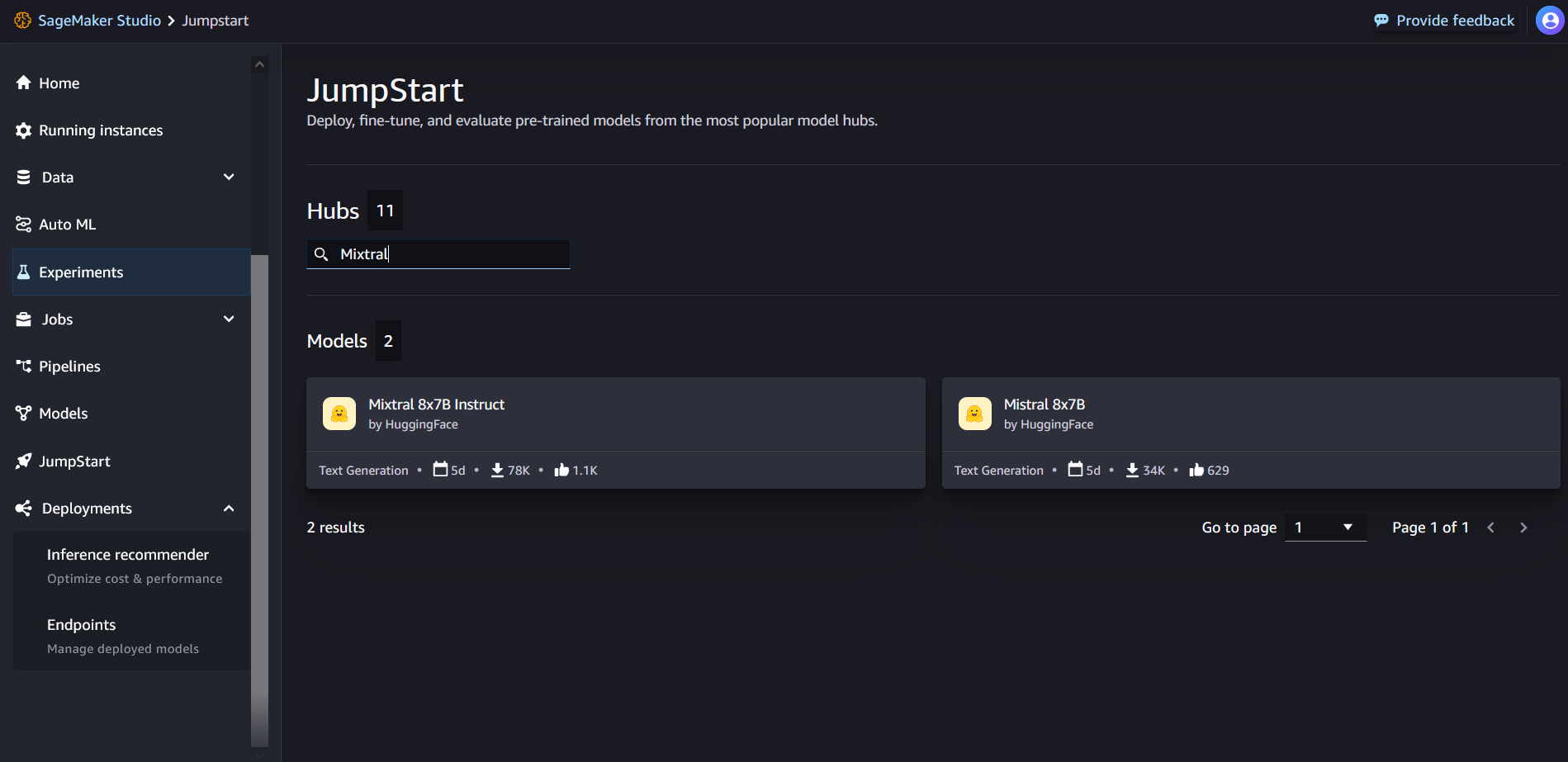

Na ciljni strani SageMaker JumpStart lahko v iskalnem polju poiščete »Mixtral«. Videli boste rezultate iskanja, ki prikazujejo Mixtral 8x7B in Mixtral 8x7B Instruct.

Izberete lahko kartico modela, da si ogledate podrobnosti o modelu, kot so licenca, podatki, uporabljeni za usposabljanje, in način uporabe. Našli boste tudi uvajanje gumb, ki ga lahko uporabite za razmestitev modela in ustvarjanje končne točke.

Namestite model

Uvajanje se začne, ko izberete uvajanje. Ko je uvajanje končano, je bila ustvarjena končna točka. Končno točko lahko preizkusite tako, da posredujete koristno obremenitev zahteve za vzorčno sklepanje ali izberete možnost testiranja s SDK-jem. Ko izberete možnost za uporabo SDK-ja, boste videli primer kode, ki jo lahko uporabite v svojem želenem urejevalniku zvezkov v SageMaker Studio.

Za uvajanje s SDK-jem začnemo z izbiro modela Mixtral-8x7B, ki ga določi model_id with value huggingface-llm-mixtral-8x7b. Kateri koli od izbranih modelov lahko namestite na SageMaker z naslednjo kodo. Podobno lahko uvedete Mixtral-8x7B instruct z lastnim ID-jem modela:

To razmesti model v SageMaker s privzetimi konfiguracijami, vključno s privzeto vrsto primerka in privzetimi konfiguracijami VPC. Te konfiguracije lahko spremenite tako, da podate neprivzete vrednosti v JumpStartModel.

Ko je uveden, lahko izvajate sklepanje glede na uvedeno končno točko prek napovedovalca SageMaker:

Primer pozivov

Z modelom Mixtral-8x7B lahko komunicirate kot s katerim koli standardnim modelom za generiranje besedila, kjer model obdela vhodno zaporedje in izpiše predvidene naslednje besede v zaporedju. V tem razdelku ponujamo primere pozivov.

Ustvarjanje kode

Z uporabo prejšnjega primera lahko uporabimo pozive za ustvarjanje kode, kot so naslednji:

Dobite naslednji izhod:

Poziv za analizo razpoloženja

Z Mixtral 8x7B lahko izvedete analizo razpoloženja z naslednjim pozivom:

Dobite naslednji izhod:

Pozivi za odgovarjanje na vprašanja

Z Mixtral-8x7B lahko uporabite poziv za odgovor na vprašanje, kot je ta:

Dobite naslednji izhod:

Mixtral-8x7B Instruct

Različica Mixtral-8x7B, ki je prilagojena navodilom, sprejema oblikovana navodila, kjer se morajo vloge pogovora začeti z uporabniškim pozivom in preklapljati med uporabniškimi navodili in pomočnikom (vzorčni odgovor). Format navodil je treba strogo upoštevati, sicer bo model ustvaril neoptimalne rezultate. Predloga, ki se uporablja za izdelavo poziva za model Instruct, je definirana na naslednji način:

Upoštevajte, da <s> in </s> sta posebna žetona za začetek niza (BOS) in konec niza (EOS), medtem ko [INST] in [/INST] so navadni nizi.

Naslednja koda prikazuje, kako lahko formatirate poziv v obliki navodil:

Pridobivanje znanja

Za poziv za pridobivanje znanja lahko uporabite naslednjo kodo:

Dobite naslednji izhod:

Kodiranje

Modeli Mixtral lahko prikažejo primerjalne prednosti za naloge kodiranja, kot je prikazano v naslednji kodi:

Matematika in sklepanje

Modeli Mixtral poročajo tudi o prednostih matematične natančnosti:

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- PlatoHealth. Obveščanje o biotehnologiji in kliničnih preskušanjih. Dostopite tukaj.

- vir: https://aws.amazon.com/blogs/machine-learning/mixtral-8x7b-is-now-available-in-amazon-sagemaker-jumpstart/

- :ima

- : je

- :ne

- :kje

- $GOR

- 000

- 1

- 10

- 100

- 11

- 12

- 120

- 13

- 130

- 14

- 15%

- 16

- 17

- 1M

- 200

- 25

- 26%

- 30

- 32

- 50

- 600

- 7

- 72

- 8

- 9

- a

- sposobnosti

- O meni

- nad

- pospeševanje

- Sprejema

- dostop

- računi

- natančnost

- Doseči

- Dosega

- čez

- aktivna

- dodano

- dodajanje

- po

- proti

- AI

- AI / ML

- algoritmi

- vsi

- Prav tako

- Amazon

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- znesek

- an

- Analiza

- in

- in infrastrukturo

- Objavi

- odgovor

- kaj

- Apache

- privlačna

- aplikacije

- uporabna

- Uporaba

- Arhitektura

- SE

- Argument

- članek

- AS

- Pomočnik

- At

- Na voljo

- AWS

- nazaj

- Hrbtenica

- temeljijo

- bash

- baterija

- Bajezijski

- BE

- ker

- bilo

- pred

- Začetek

- meni

- Bell

- primerjalno

- meril

- Boljše

- med

- Bill

- zaračunavanje

- Billion

- krepko

- Kupil

- Pasovi

- Break

- prinašajo

- izgradnjo

- Building

- vgrajeno

- poslovni

- vendar

- by

- izračun

- klic

- se imenuje

- poziva

- CAN

- kartice

- primeru

- primeri

- spremenite

- klepet

- izbira

- Izberite

- izbiri

- chris

- Razvrstitev

- klik

- Koda

- Kodiranje

- kombinacija

- v primerjavi z letom

- zbranih

- dokončanje

- računalniški

- Izračunajte

- računalnik

- Računalniška vizija

- konference

- nenehno

- Posoda

- vsebina

- ozadje

- se nadaljuje

- stalno

- Nadzor

- Pogovor

- strošek

- stroški

- bi

- ustvarjajo

- ustvaril

- ključnega pomena

- Pokal

- Trenutna

- Stranke, ki so

- customization

- prilagodite

- datum

- Varovanje podatkov

- nabor podatkov

- dan

- Dnevi

- namenjen

- privzeto

- opredeljen

- Demokratiziranje

- izkazati

- razporedi

- razporejeni

- uvajanja

- uvajanje

- razpolaga

- drift

- Podrobnosti

- Razvoj

- razvili

- Razvojni

- Razvoj

- DICT

- DID

- odkriti

- do

- ne

- dolarjev

- domen

- opravljeno

- navzdol

- Drop

- Duke

- vojvodska univerza

- vsak

- Gospodarska

- urednik

- učinkovitosti

- Jajca

- ostalo

- omogočajo

- omogoča

- omogočanje

- konec

- Končna točka

- Inženiring

- Angleščina

- zagotovitev

- okolje

- EOS

- enako

- Enakovredna

- etično

- Primer

- presega

- razburjen

- izključuje

- strokovnjak

- Strokovnjaki

- Pojasnite

- Razlaga

- razširitev

- družina

- hitreje

- Lastnosti

- Nekaj

- datoteke

- Filtri

- Najdi

- prva

- po

- sledi

- za

- format

- Fundacija

- ulomek

- francosko

- iz

- funkcija

- Prihodnost

- glavni namen

- ustvarjajo

- ustvarila

- generacija

- generativno

- Generativna AI

- nemški

- dobili

- Go

- dobro

- prisodil

- Pridelovanje

- sovražijo

- Imajo

- he

- pomoč

- pomoč

- Pomaga

- jo

- tukaj

- visoka

- Hills

- njegov

- Kako

- Kako

- HTML

- HTTPS

- Hub

- i

- ICE

- sladoled

- ID

- if

- Illinois

- bolezen

- uvoz

- Pomembno

- izboljšanje

- Izboljšave

- in

- vključujejo

- Vključno

- Vključena

- Infrastruktura

- vhod

- vhodi

- primer

- Navodila

- integrirati

- integrirana

- interakcijo

- interesi

- vmesnik

- Izmišljeno

- izolirani

- IT

- italijanski

- ITS

- sam

- jpg

- otroci

- znanje

- Kyle

- Labs

- pristanek

- jezik

- velika

- Zadnja

- plast

- Interesenti

- učenje

- dolžina

- Naj

- Licenca

- kot

- všeč mi je

- Meje

- LINK

- Seznam

- Poslušanje

- malo

- LLM

- Logika

- si

- nižje

- stroj

- strojno učenje

- je

- IZDELA

- Izdelava

- upravitelj

- več

- tekme

- math

- matematika

- me

- srednje

- mešanico

- ML

- MLOps

- način

- Model

- modeli

- spremembe

- mesec

- več

- motorno kolo

- veliko

- pomnoži

- Glasba

- morajo

- my

- naravna

- Obdelava Natural Language

- ostalo

- negativna

- mreža

- Nevtralna

- Novo

- Naslednja

- nlp

- Noben

- Upoštevajte

- prenosnik

- zdaj

- Številka

- of

- Olje

- on

- enkrat

- ONE

- samo

- deluje

- operacijski sistem

- Možnost

- or

- Ostalo

- drugače

- ven

- izhod

- izhodi

- zunaj

- več

- lastne

- Stran

- plačana

- podokno

- članki

- parameter

- parametri

- Podaje

- strast

- strastno

- poti

- za

- Izvedite

- performance

- Dr.

- telefon

- platon

- Platonova podatkovna inteligenca

- PlatoData

- Točka

- prenosni

- pozitiven

- Prispevek

- pred

- napovedano

- Predictor

- prednostno

- priprava

- prejšnja

- , ravnateljica

- Tiskanje

- postopkovno

- Postopek

- Procesi

- obravnavati

- Izdelek

- Program

- Programiranje

- pozove

- blaginja

- zagotavljajo

- ponudniki

- zagotavlja

- javno

- objavljeno

- Python

- četrtletje

- vprašanje

- hitro

- RE

- reading

- Recept

- Rekurzivno

- zmanjša

- glejte

- redni

- sprosti

- poročilo

- zahteva

- Raziskave

- raziskovalec

- viri

- spoštovan

- Odgovor

- odgovorna

- Omejitve

- povzroči

- Rezultati

- vrnitev

- vrne

- jahanje

- Tveganje

- vloga

- vloge

- soba

- Run

- tek

- s

- SA

- sagemaker

- sol

- razširljive

- Lestvica

- Znanost

- Znanstvenik

- SDK

- Iskalnik

- Oddelek

- zavarovanje

- varnost

- glej

- izberite

- izbran

- izbiranje

- izbor

- višji

- sentiment

- ločena

- Zaporedje

- Serija

- Storitve

- nastavite

- je pokazala,

- pokazale

- Razstave

- pomemben

- podobno

- Enostavno

- saj

- sam

- Velikosti

- So

- socialna

- Društvo

- Software

- Rešitev

- španski

- posebna

- specialist

- določeno

- hitrosti

- Poraba

- standardna

- Začetek

- začel

- začne

- state-of-the-art

- Statistično

- Korak

- Koraki

- Še vedno

- ustavil

- trgovina

- naravnost

- Strateško

- tok

- prednosti

- String

- strukturirano

- studio

- taka

- podpora

- Podpora

- Podpira

- sistem

- meni

- Naloge

- ključi

- skupina

- Tehnologija

- Predloga

- Test

- Testiran

- Testiranje

- besedilo

- da

- O

- Prihodnost

- POTEM

- te

- jih

- ta

- skozi

- čas

- Časovne serije

- krat

- do

- skupaj

- žeton

- Boni

- tudi

- orodja

- Skupaj za plačilo

- Vlak

- usposabljanje

- Res

- poskusite

- tweet

- tip

- ui

- pod

- univerza

- unix

- odklepanje

- dokler

- uporaba

- primeru uporabe

- Rabljeni

- uporabnik

- uporablja

- uporabo

- Uporaben

- Valley

- vrednost

- Vrednote

- raznolikost

- različica

- Video

- Poglej

- Vizija

- obisk

- vizualna

- sprehod

- je

- Voda

- we

- web

- spletne storitve

- Web-Based

- Dobro

- Kaj

- Kaj je

- kdaj

- medtem ko

- ki

- bele

- WHO

- bo

- z

- v

- brez

- besede

- delo

- bi

- pisati

- pisni

- Vi

- Vaša rutina za

- zefirnet

Rachna Chadha je glavni arhitekt rešitev AI/ML v Strategic Accounts pri AWS. Rachna je optimist, ki verjame, da lahko etična in odgovorna uporaba umetne inteligence izboljša družbo v prihodnosti ter prinese gospodarsko in družbeno blaginjo. V prostem času Rachna rada preživlja čas z družino, hodi na pohode in posluša glasbo.

Rachna Chadha je glavni arhitekt rešitev AI/ML v Strategic Accounts pri AWS. Rachna je optimist, ki verjame, da lahko etična in odgovorna uporaba umetne inteligence izboljša družbo v prihodnosti ter prinese gospodarsko in družbeno blaginjo. V prostem času Rachna rada preživlja čas z družino, hodi na pohode in posluša glasbo. Dr. Kyle Ulrich je uporabni znanstvenik z

Dr. Kyle Ulrich je uporabni znanstvenik z  Christopherja Whittena je razvijalec programske opreme v ekipi JumpStart. Pomaga pri prilagajanju izbire modela in integraciji modelov z drugimi storitvami SageMaker. Chris je navdušen nad pospeševanjem vseprisotnosti umetne inteligence na različnih poslovnih področjih.

Christopherja Whittena je razvijalec programske opreme v ekipi JumpStart. Pomaga pri prilagajanju izbire modela in integraciji modelov z drugimi storitvami SageMaker. Chris je navdušen nad pospeševanjem vseprisotnosti umetne inteligence na različnih poslovnih področjih. Dr. Fabio Nonato de Paula je višji vodja specialista GenAI SA, ki ponudnikom modelov in strankam pomaga pri prilagajanju generativne umetne inteligence v AWS. Fabio ima strast do demokratizacije dostopa do generativne tehnologije umetne inteligence. Zunaj dela lahko najdete Fabia, ki se vozi z motorjem po hribih doline Sonoma ali bere ComiXology.

Dr. Fabio Nonato de Paula je višji vodja specialista GenAI SA, ki ponudnikom modelov in strankam pomaga pri prilagajanju generativne umetne inteligence v AWS. Fabio ima strast do demokratizacije dostopa do generativne tehnologije umetne inteligence. Zunaj dela lahko najdete Fabia, ki se vozi z motorjem po hribih doline Sonoma ali bere ComiXology. Dr. Ashish Khetan je višji aplikativni znanstvenik z vgrajenimi algoritmi Amazon SageMaker in pomaga pri razvoju algoritmov strojnega učenja. Doktoriral je na Univerzi Illinois Urbana-Champaign. Je aktiven raziskovalec strojnega učenja in statističnega sklepanja ter je objavil številne članke na konferencah NeurIPS, ICML, ICLR, JMLR, ACL in EMNLP.

Dr. Ashish Khetan je višji aplikativni znanstvenik z vgrajenimi algoritmi Amazon SageMaker in pomaga pri razvoju algoritmov strojnega učenja. Doktoriral je na Univerzi Illinois Urbana-Champaign. Je aktiven raziskovalec strojnega učenja in statističnega sklepanja ter je objavil številne članke na konferencah NeurIPS, ICML, ICLR, JMLR, ACL in EMNLP. Karl Albertsen vodi izdelke, inženiring in znanost za Amazon SageMaker Algorithms in JumpStart, SageMakerjevo vozlišče za strojno učenje. Navdušen je nad uporabo strojnega učenja za odklepanje poslovne vrednosti.

Karl Albertsen vodi izdelke, inženiring in znanost za Amazon SageMaker Algorithms in JumpStart, SageMakerjevo vozlišče za strojno učenje. Navdušen je nad uporabo strojnega učenja za odklepanje poslovne vrednosti.