Danes z veseljem oznanjamo zmožnost natančnega prilagajanja modelov Llama 2 s pomočjo Meta Amazon SageMaker JumpStart. Družina velikih jezikovnih modelov (LLM) Llama 2 je zbirka vnaprej usposobljenih in natančno nastavljenih generativnih besedilnih modelov, ki obsegajo od 7 milijard do 70 milijard parametrov. Natančno nastavljeni LLM-ji, imenovani Llama-2-chat, so optimizirani za primere uporabe dialoga. Te modele lahko preprosto preizkusite in jih uporabite s SageMaker JumpStart, ki je središče strojnega učenja (ML), ki omogoča dostop do algoritmov, modelov in rešitev ML, tako da lahko hitro začnete z ML. Zdaj lahko tudi natančno prilagodite 7 milijard, 13 milijard in 70 milijard parametrov modelov generiranja besedila Llama 2 na SageMaker JumpStart z uporabo Amazon SageMaker Studio Uporabniški vmesnik z nekaj kliki ali uporabo SDK-ja SageMaker Python.

Generativni osnovni modeli umetne inteligence so že več kot eno leto v središču večine raziskav in primerov uporabe ML in umetne inteligence. Ti osnovni modeli se zelo dobro obnesejo pri generativnih nalogah, kot so generiranje besedila, povzemanje, odgovarjanje na vprašanja, generiranje slik in videa ter več, zaradi svoje velike velikosti in tudi zato, ker so usposobljeni za več velikih naborov podatkov in stotine nalog. Kljub velikim zmožnostim posploševanja teh modelov pogosto obstajajo primeri uporabe, ki imajo zelo specifične podatke o domeni (kot so zdravstvene ali finančne storitve), zaradi česar ti modeli morda ne bodo mogli zagotoviti dobrih rezultatov za te primere uporabe. Posledica tega je potreba po nadaljnjem natančnem prilagajanju teh generativnih modelov umetne inteligence glede na podatke, specifične za primere uporabe in domene.

V tem prispevku si bomo ogledali, kako natančno prilagoditi vnaprej pripravljene modele za generiranje besedila Llama 2 prek SageMaker JumpStart.

Kaj je Llama 2

Llama 2 je avtoregresivni jezikovni model, ki uporablja optimizirano transformatorsko arhitekturo. Llama 2 je namenjena komercialni in raziskovalni uporabi v angleškem jeziku. Na voljo je v različnih velikostih parametrov – 7 milijard, 13 milijard in 70 milijard – kot tudi v predhodno usposobljenih in natančno nastavljenih različicah. Po besedah Mete prilagojene različice uporabljajo nadzorovano fino uravnavanje (SFT) in okrepitveno učenje s človeškimi povratnimi informacijami (RLHF), da se uskladijo s človeškimi željami glede uporabnosti in varnosti. Llama 2 je bila predhodno usposobljena za 2 bilijona žetonov podatkov iz javno dostopnih virov. Uglašeni modeli so namenjeni klepetu, podobnemu pomočniku, medtem ko je vnaprej usposobljene modele mogoče prilagoditi za različne naloge generiranja naravnega jezika. Ne glede na to, katero različico modela uporablja razvijalec, je vodnik za odgovorno uporabo podjetja Meta lahko pomaga pri vodenju dodatne natančne nastavitve, ki je morda potrebna za prilagoditev in optimizacijo modelov z ustreznimi varnostnimi ublažitvami.

Trenutno je Llama 2 na voljo v naslednjih regijah:

- Razpoložljiv vnaprej usposobljen model:

"us-west-2","us-east-1","us-east-2","eu-west-1","ap-southeast-1","ap-southeast-2" - Natančno prilagodite in uvedite natančno nastavljen model:

“us-east-1”,“us-west-2”,“eu-west-1”

Kaj je SageMaker JumpStart

S SageMaker JumpStart lahko praktiki ML izbirajo med široko izbiro javno dostopnih modelov temeljev. Strokovnjaki ML lahko uvedejo temeljne modele v namenske Amazon SageMaker primerke iz omrežno izoliranega okolja in prilagodite modele z uporabo SageMakerja za usposabljanje in uvajanje modelov. Zdaj lahko odkrijete in uvedete Llama 2 z nekaj kliki v SageMaker Studio ali programsko prek SDK SageMaker Python, kar vam omogoča, da izpeljete zmogljivost modela in kontrole MLOps s funkcijami SageMaker, kot je npr. Amazonski cevovodi SageMaker, Napaka Amazon SageMaker, ali kontejnerski dnevniki. Model je nameščen v varnem okolju AWS in pod vašimi kontrolami VPC, kar pomaga zagotoviti varnost podatkov. Poleg tega lahko s programom SageMaker JumpStart natančno prilagodite vnaprej pripravljene modele generiranja besedila Llama2 7B, 13B in 70B.

Natančno nastavite modele Llama2

Modele lahko natančno prilagodite z uporabniškim vmesnikom SageMaker Studio ali SDK SageMaker Python. V tem razdelku obravnavamo obe metodi.

Natančna nastavitev brez kode prek uporabniškega vmesnika SageMaker Studio

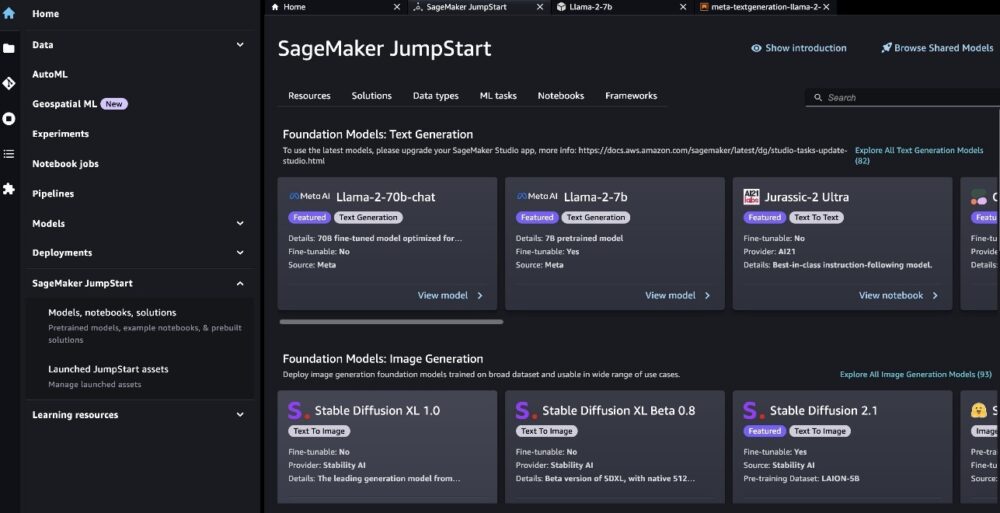

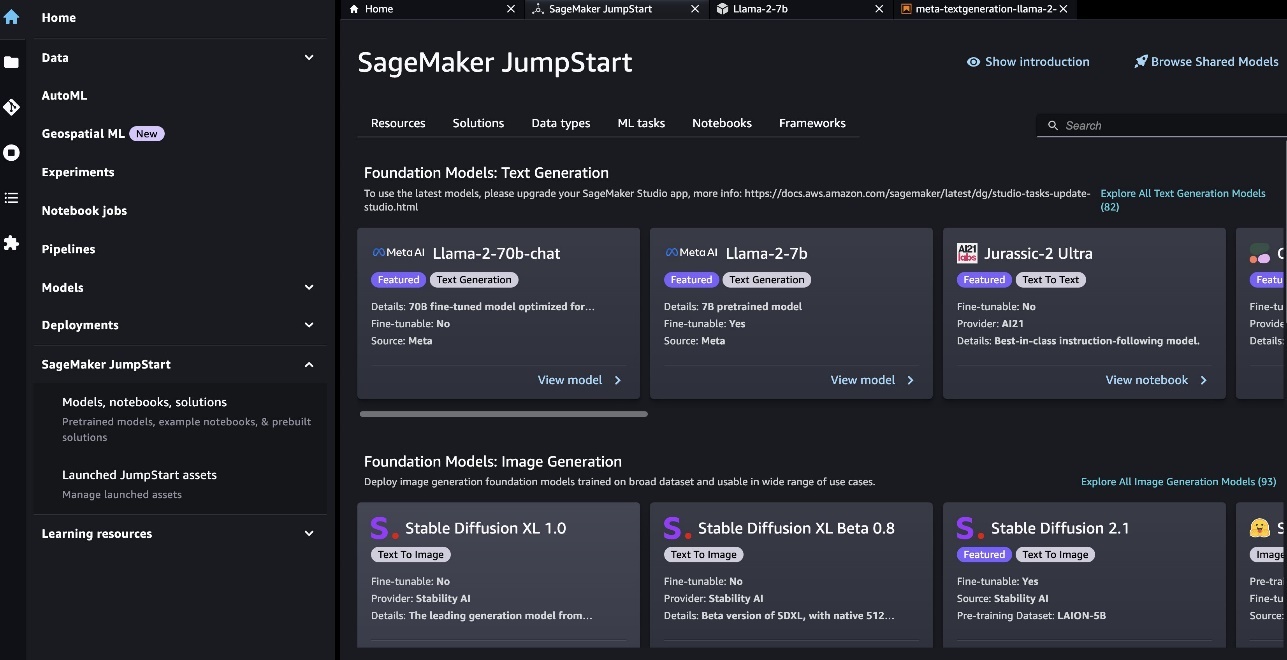

V SageMaker Studio lahko dostopate do modelov Llama 2 prek SageMaker JumpStart pod Modeli, zvezki in rešitve, kot je prikazano na naslednjem posnetku zaslona.

Če ne vidite modelov Llama 2, posodobite svojo različico SageMaker Studio tako, da zaustavite in znova zaženete. Za več informacij o posodobitvah različic glejte Zaustavite in posodobite aplikacije Studio.

Z izbiro lahko najdete tudi druge štiri različice modela Raziščite vse modele generiranja besedila ali iskanje lame v iskalnem polju.

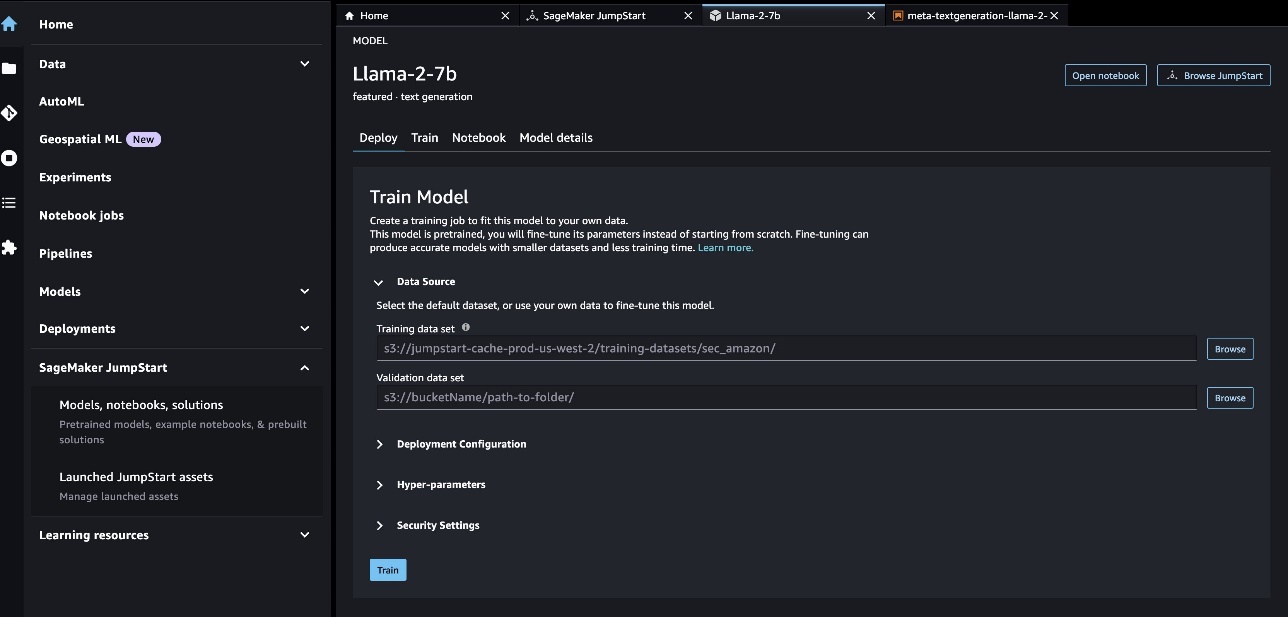

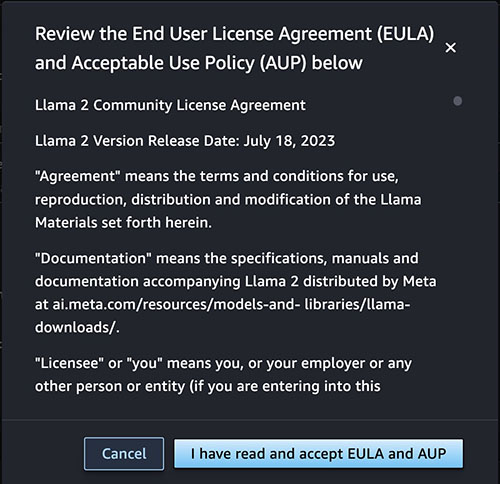

Na tej strani lahko pokažete na Preprosta storitev shranjevanja Amazon (Amazon S3), ki vsebuje nabore podatkov za usposabljanje in validacijo za natančno nastavitev. Poleg tega lahko konfigurirate konfiguracijo razmestitve, hiperparametre in varnostne nastavitve za natančno nastavitev. Nato lahko izberete Vlak za začetek usposabljanja na primerku SageMaker ML. Prejšnji posnetek zaslona prikazuje stran za natančno nastavitev za model Llama-2 7B; vendar pa lahko modele generiranja besedila 13B in 70B Llama 2 natančno prilagodite z uporabo ustreznih strani modelov na podoben način. Če želite uporabljati modele Llama 2, morate sprejeti licenčno pogodbo za končnega uporabnika (EULA). Prikaže se, ko izberete Vlak, kot je prikazano na naslednjem posnetku zaslona. Izberite Prebral sem in sprejemam EULA in AUP za začetek natančnega prilagajanja.

Namestite model

Ko je model natančno nastavljen, ga lahko uvedete na strani modela na SageMaker JumpStart. Možnost za uvedbo natančno nastavljenega modela se prikaže, ko je natančna nastavitev končana, kot je prikazano na naslednjem posnetku zaslona.

Natančna nastavitev prek SDK-ja SageMaker Python

Prav tako lahko natančno prilagodite modele Llama 2 s SDK SageMaker Python. Sledi vzorčna koda za natančno nastavitev Llame 2 7B na vašem naboru podatkov:

Natančno nastavljen model lahko uvedete neposredno iz ocenjevalca:

Kodo najdete tudi v Natančno prilagodite modele LLaMA 2 na SageMaker JumpStart. Vključuje pripravo nabora podatkov, usposabljanje za vaš nabor podatkov po meri in uvajanje natančno nastavljenega modela. Prikazuje fino nastavitev na podmnožici nabora podatkov Dolly s primeri iz naloge povzemanja. Sledi primer vnosa z odgovori natančno nastavljenih in nenastavljenih skupaj z odgovorom temeljne resnice:

Vnos v model:

Odgovor Ground Truth:

Odgovor nenatančno nastavljenega modela:

Odgovor natančno nastavljenega modela:

Za primerjalno analizo zmogljivosti različnih modelov na naboru podatkov Dolly in Dialogsum glejte Primerjalna analiza uspešnosti v dodatku na koncu te objave.

Tehnika finega uravnavanja

Jezikovni modeli, kot je Llama, so večji od 10 GB ali celo 100 GB. Natančna nastavitev tako velikih modelov zahteva primerke s precej velikim pomnilnikom CUDA. Poleg tega je lahko usposabljanje teh modelov zelo počasno zaradi velikosti modela. Zato za učinkovito fino nastavitev uporabljamo naslednje optimizacije:

- Nizka prilagoditev (LoRA) – To je vrsta parametrsko učinkovitega natančnega prilagajanja (PEFT) za učinkovito natančno prilagajanje velikih modelov. Pri tem zamrznemo celoten model in v model dodamo le majhen niz nastavljivih parametrov ali plasti. Na primer, namesto da bi trenirali vseh 7 milijard parametrov za Llamo 2 7B, lahko natančno nastavimo manj kot 1 % parametrov. To pomaga pri znatnem zmanjšanju pomnilniške zahteve, ker moramo shraniti le gradiente, stanja optimizatorja in druge informacije, povezane z usposabljanjem, le za 1 % parametrov. Poleg tega to pomaga zmanjšati čas usposabljanja in tudi stroške. Za več podrobnosti o tej metodi glejte LoRA: Nizka prilagoditev velikih jezikovnih modelov.

- Int8 kvantizacija – Tudi z optimizacijami, kot je LoRA, so modeli, kot je Llama 70B, še vedno preveliki za treniranje. Za zmanjšanje pomnilniškega odtisa med vadbo lahko med vadbo uporabimo kvantizacijo Int8. Kvantizacija običajno zmanjša natančnost podatkovnih tipov s plavajočo vejico. Čeprav to zmanjša pomnilnik, potreben za shranjevanje uteži modelov, poslabša zmogljivost zaradi izgube informacij. Kvantizacija Int8 uporablja samo četrtino natančnosti, vendar ne povzroči poslabšanja zmogljivosti, ker ne izpusti preprosto bitov. Podatke zaokrožuje iz ene vrste v drugo. Če želite izvedeti več o kvantizaciji Int8, glejte LLM.int8(): 8-bitno matrično množenje za transformatorje v merilu.

- Popolnoma razrezani vzporedni podatki (FSDP) – To je vrsta podatkovno-vzporednega učnega algoritma, ki razdeli parametre modela med podatkovne vzporedne delavce in lahko po želji preloži del učnega računanja na CPE. Čeprav so parametri razdeljeni na različne grafične procesorje, je izračun vsake mikroserije lokalen za delavca grafične procesorske enote. Parametre razdeli bolj enotno in doseže optimizirano delovanje prek prekrivanja komunikacije in računanja med usposabljanjem.

Naslednja tabela primerja različne metode s tremi modeli Llama 2.

| , | Privzeta vrsta primerka | Podprte vrste primerkov s privzeto konfiguracijo | Privzeta nastavitev | LORA + FSDP | LORA + Brez FSDP | Int8 Kvantizacija + LORA + Brez FSDP |

| Lama 2 7B | ml.g5.12xvelik | ml.g5.12xvelik, ml.g5.24xvelik, ml.g5.48xvelik | LORA + FSDP | Da | Da | Da |

| Lama 2 13B | ml.g5.12xvelik | ml.g5.24xvelik, ml.g5.48xvelik | LORA + FSDP | Da | Da | Da |

| Lama 2 70B | ml.g5.48xvelik | ml.g5.48xvelik | INT8 + LORA + BREZ FSDP | Ne | Ne | Da |

Upoštevajte, da natančno prilagajanje modelov Llama temelji na skriptih, ki jih zagotavljajo naslednji GitHub repo.

Format nabora podatkov za usposabljanje

SageMaker JumpStart trenutno podpira nabore podatkov tako v obliki prilagajanja domene kot v obliki nastavitve navodil. V tem razdelku podajamo primer nabora podatkov v obeh formatih. Za več podrobnosti glejte Oblikovanje nabora podatkov razdelek v dodatku.

Oblika prilagoditve domene

Model generiranja besedila Llama 2 je mogoče natančno nastaviti na katerem koli naboru podatkov, specifičnih za domeno. Ko je model natančno nastavljen na naboru podatkov, specifičnih za domeno, naj bi model ustvaril besedilo, specifično za domeno, in rešil različne naloge NLP v tej specifični domeni z nekaj pozivi. Pri tem naboru podatkov je vnos datoteka CSV, JSON ali TXT. Na primer, vhodni podatki so lahko SEC vloge Amazona kot besedilna datoteka:

Format nastavitve navodil

Pri natančnem uravnavanju navodil je model natančno nastavljen za niz nalog obdelave naravnega jezika (NLP), opisanih z uporabo navodil. To pomaga izboljšati zmogljivost modela za nevidna opravila z zero-shot pozivi. V formatu nabora podatkov za uravnavanje navodil določite template.json datoteka, ki opisuje vhodne in izhodne formate. Na primer, vsaka vrstica v datoteki train.jsonl izgleda takole:

Dodatna datoteka template.json izgleda takole:

Podprti hiperparametri za usposabljanje

Natančna nastavitev Llama 2 podpira številne hiperparametre, od katerih lahko vsak vpliva na pomnilniško zahtevo, hitrost usposabljanja in zmogljivost natančno nastavljenega modela:

- epoha – Število prehodov, ki jih opravi algoritem za natančno nastavitev skozi nabor podatkov za usposabljanje. Biti mora celo število, večje od 1. Privzeto je 5.

- stopnja učenja – Hitrost, s katero se uteži modela posodabljajo po delu skozi vsako serijo primerov usposabljanja. Pozitivno plavajoče mora biti večje od 0. Privzeto je 1e-4.

- instruction_tuned – Ne glede na to, ali je treba model usposobiti z navodili ali ne. mora biti '

True"ali"False'. Privzeto je 'False". - per_device_train_batch_size – Velikost paketa na jedro GPE/CPE za usposabljanje. Biti mora pozitivno celo število. Privzeto je 4.

- per_device_eval_batch_size – Velikost paketa na jedro GPE/CPE za oceno. Biti mora pozitivno celo število. Privzeto je 1.

- max_train_samples – Za namene odpravljanja napak ali hitrejšega usposabljanja skrajšajte število primerov usposabljanja na to vrednost. Vrednost -1 pomeni uporabo vseh učnih vzorcev. Biti mora pozitivno celo število ali -1. Privzeta vrednost je -1.

- max_val_samples – Za namene odpravljanja napak ali hitrejšega usposabljanja skrajšajte število primerov preverjanja veljavnosti na to vrednost. Vrednost -1 pomeni uporabo vseh potrditvenih vzorcev. Biti mora pozitivno celo število ali -1. Privzeta vrednost je -1.

- max_input_length – Največja skupna dolžina vhodnega zaporedja po tokenizaciji. Zaporedja, daljša od tega, bodo okrnjena. Če je -1,

max_input_lengthje nastavljen na najmanj 1024 in največjo dolžino modela, ki jo definira tokenizer. Če je nastavljena na pozitivno vrednost,max_input_lengthje nastavljen na najmanjšo podano vrednost inmodel_max_lengthdefinira tokenizer. Biti mora pozitivno celo število ali -1. Privzeta vrednost je -1. - validation_split_ratio – Če je validacijski kanal

none, mora biti razmerje med validacijo vlaka in podatki o vlaku med 0–1. Privzeta vrednost je 0.2. - train_data_split_seed – Če validacijski podatki niso prisotni, to popravi naključno razdelitev vhodnih podatkov o usposabljanju na podatke o usposabljanju in validaciji, ki jih uporablja algoritem. Biti mora celo število. Privzeto je 0.

- preprocessing_num_workers – Število procesov, ki jih je treba uporabiti za predhodno obdelavo. če

None, se glavni postopek uporablja za predprocesiranje. Privzeto jeNone. - lora_r – Lora R. Mora biti pozitivno celo število. Privzeto je 8.

- lora_alfa – Lora Alfa. Biti mora pozitivno celo število. Privzeto je 32

- lora_dropout – Lora Dropout. mora biti pozitivno plavajoče med 0 in 1. Privzeta vrednost je 0.05.

- int8_kvantizacija - Če

True, je model naložen z 8-bitno natančnostjo za usposabljanje. Privzeto za 7B in 13B jeFalse. Privzeta vrednost za 70B jeTrue. - omogoči_fsdp - Če

True, usposabljanje uporablja FSDP. Privzeto za 7B in 13B jeTrue. Privzeta vrednost za 70B jeFalse. Upoštevajte, daint8_quantizationni podprt s FSDP.

Vrste primerkov in združljivi hiperparametri

Zahteva po pomnilniku med natančno nastavitvijo se lahko razlikuje glede na več dejavnikov:

- Vrsta modela – Model 7B ima najmanjšo potrebo po pomnilniku GPE, model 70B pa največjo

- Največja vhodna dolžina – Višja vrednost dolžine vnosa vodi do obdelave več žetonov hkrati in kot taka zahteva več pomnilnika CUDA

- Velikost serije – Večja velikost paketa zahteva večji pomnilnik CUDA in zato zahteva večje vrste primerkov

- Int8 kvantizacija – Če uporabljate kvantizacijo Int8, se model naloži v nizko natančnost in zato potrebuje manj pomnilnika CUDA

Za lažji začetek ponujamo nabor kombinacij različnih vrst primerkov, hiperparametrov in vrst modelov, ki jih je mogoče uspešno natančno nastaviti. Izberete lahko konfiguracijo glede na vaše zahteve in razpoložljivost vrst primerkov. Vse tri modele natančno prilagodimo na različne nastavitve s tremi epohami na podnaboru podatkov Dolly s primeri povzemanja.

7B model

Naslednja tabela povzema možnosti natančne nastavitve na modelu 7B.

| Vrsta primerka | Največja vhodna dolžina | Velikost serije na napravo | Int8 Kvantizacija | Omogoči FSDP | Porabljen čas (min) |

| ml.g4dn.12xvelik | 1024 | 8 | TRUE | FALSE | 166 |

| ml.g4dn.12xvelik | 2048 | 2 | TRUE | FALSE | 178 |

| ml.g4dn.12xvelik | 1024 | 4 | FALSE | TRUE | 120 |

| ml.g4dn.12xvelik | 2048 | 2 | FALSE | TRUE | 143 |

| ml.g5.2xvelik | 1024 | 4 | TRUE | FALSE | 61 |

| ml.g5.2xvelik | 2048 | 2 | TRUE | FALSE | 68 |

| ml.g5.2xvelik | 1024 | 4 | FALSE | TRUE | 43 |

| ml.g5.2xvelik | 2048 | 2 | FALSE | TRUE | 49 |

| ml.g5.4xvelik | 1024 | 4 | FALSE | TRUE | 39 |

| ml.g5.4xvelik | 2048 | 2 | FALSE | TRUE | 50 |

| ml.g5.12xvelik | 1024 | 16 | TRUE | FALSE | 57 |

| ml.g5.12xvelik | 2048 | 4 | TRUE | FALSE | 64 |

| ml.g5.12xvelik | 1024 | 4 | FALSE | TRUE | 26 |

| ml.g5.12xvelik | 2048 | 4 | FALSE | TRUE | 23 |

| ml.g5.48xvelik | 1024 | 16 | TRUE | FALSE | 59 |

| ml.g5.48xvelik | 2048 | 4 | TRUE | FALSE | 67 |

| ml.g5.48xvelik | 1024 | 8 | FALSE | TRUE | 22 |

| ml.g5.48xvelik | 2048 | 4 | FALSE | TRUE | 21 |

13B

Naslednja tabela povzema možnosti natančne nastavitve na modelu 13B.

| Vrsta primerka | Največja vhodna dolžina | Velikost serije na napravo | Int8 Kvantizacija | Omogoči FSDP | Porabljen čas (min) |

| ml.g4dn.12xvelik | 1024 | 4 | TRUE | FALSE | 283 |

| ml.g4dn.12xvelik | 2048 | 2 | TRUE | FALSE | 328 |

| ml.g5.12xvelik | 1024 | 8 | TRUE | FALSE | 92 |

| ml.g5.12xvelik | 2048 | 4 | TRUE | FALSE | 104 |

| ml.g5.48xvelik | 1024 | 8 | TRUE | FALSE | 95 |

| ml.g5.48xvelik | 2048 | 4 | TRUE | FALSE | 107 |

| ml.g5.48xvelik | 1024 | 8 | FALSE | TRUE | 35 |

| ml.g5.48xvelik | 2048 | 2 | FALSE | TRUE | 41 |

70B

Naslednja tabela povzema možnosti natančne nastavitve na modelu 70B.

| Vrsta primerka | Največja vhodna dolžina | Velikost serije na napravo | Int8 Kvantizacija | Omogoči FSDP | Porabljen čas (min) |

| ml.g5.48xvelik | 1024 | 4 | TRUE | FALSE | 396 |

| ml.g5.48xvelik | 2048 | 1 | TRUE | FALSE | 454 |

Priporočila o vrstah primerkov in hiperparametrih

Pri natančnem prilagajanju natančnosti modela upoštevajte naslednje:

- Večji modeli, kot je 70B, zagotavljajo boljše delovanje kot 7B

- Zmogljivost brez kvantizacije Int8 je boljša od zmogljivosti s kvantizacijo INT8

Upoštevajte naslednje zahteve glede časa usposabljanja in pomnilnika CUDA:

- Nastavitev

int8_quantization=Truezmanjša potrebo po spominu in vodi do hitrejšega usposabljanja. - Zmanjšanje

per_device_train_batch_sizeinmax_input_lengthzmanjša pomnilniško zahtevo in se zato lahko izvaja na manjših primerkih. Vendar pa lahko nastavitev zelo nizkih vrednosti podaljša čas vadbe. - Če ne uporabljate kvantizacije Int8 (

int8_quantization=False), uporabite FSDP (enable_fsdp=True) za hitrejši in učinkovitejši trening.

Pri izbiri vrste primerka upoštevajte naslednje:

- Primerki G5 zagotavljajo najučinkovitejše usposabljanje med podprtimi tipi primerkov. Torej, če imate na voljo primerke G5, jih uporabite.

- Čas usposabljanja je v veliki meri odvisen od števila grafičnih procesorjev in razpoložljivega pomnilnika CUDA. Zato je usposabljanje na primerkih z enakim številom grafičnih procesorjev (na primer ml.g5.2xlarge in ml.g5.4xlarge) približno enako. Zato lahko za šolanje uporabite cenejši primerek (ml.g5.2xlarge).

- Pri uporabi primerkov p3 bo usposabljanje izvedeno z 32-bitno natančnostjo, ker bfloat16 ni podprt v teh primerkih. Zato bo opravilo usposabljanja porabilo dvojno količino pomnilnika CUDA pri usposabljanju na primerkih p3 v primerjavi z primerki g5.

Če želite izvedeti več o stroških usposabljanja na primer, glejte Na primerki Amazon EC2 G5.

Če je nabor podatkov v formatu za prilagajanje navodil in so zaporedja vnosa+dokončanja majhna (na primer 50–100 besed), potem je visoka vrednost max_input_length vodi v zelo slabo delovanje. Privzeta vrednost tega parametra je -1, kar ustreza max_input_length 2048 za modele Llama. Zato priporočamo, da uporabite majhno vrednost, če vaš nabor podatkov vsebuje majhne vzorce max_input_length (na primer 200–400).

Nazadnje, zaradi velikega povpraševanja po instancah G5 lahko pride do nerazpoložljivosti teh instanc v vaši regiji z napako “CapacityError: Unable to provision requested ML compute capacity. Please retry using a different ML instance type.” Če naletite na to napako, znova poskusite opraviti usposabljanje ali poskusite z drugo regijo.

Težave pri natančnem prilagajanju zelo velikih modelov

V tem razdelku razpravljamo o dveh težavah pri natančnem prilagajanju zelo velikih modelov.

Onemogoči izhodno stiskanje

Izhod učnega opravila je privzeto usposobljen model, ki je stisnjen v formatu .tar.gz, preden se naloži v Amazon S3. Vendar pa lahko ta korak zaradi velike velikosti modela traja dolgo. Na primer, stiskanje in nalaganje modela 70B lahko traja več kot 4 ure. Da bi se izognili tej težavi, lahko uporabite funkcijo za onemogočanje stiskanja izhoda, ki jo podpira platforma za usposabljanje SageMaker. V tem primeru se model naloži brez kakršnega koli stiskanja, ki se nato uporabi za uvajanje:

Težava s časovno omejitvijo jedra SageMaker Studio

Zaradi velikosti modela Llama 70B lahko usposabljanje traja več ur in jedro SageMaker Studio lahko umre med fazo usposabljanja. Vendar pa v tem času usposabljanje še vedno poteka v SageMakerju. Če se to zgodi, lahko končno točko še vedno uvedete z imenom opravila usposabljanja z naslednjo kodo:

Če želite poiskati ime dela usposabljanja, se pomaknite do konzole SageMaker in pod usposabljanje v podoknu za krmarjenje izberite Usposabljanja. Določite ime delovnega mesta usposabljanja in ga nadomestite s prejšnjo kodo.

zaključek

V tej objavi smo razpravljali o natančnem prilagajanju modelov Meta Llama 2 z uporabo SageMaker JumpStart. Pokazali smo, da lahko uporabite konzolo SageMaker JumpStart v SageMaker Studio ali SDK SageMaker Python za natančno nastavitev in uvajanje teh modelov. Razpravljali smo tudi o tehniki natančnega prilagajanja, vrstah primerkov in podprtih hiperparametrih. Poleg tega smo začrtali priporočila za optimizirano usposabljanje na podlagi različnih testov, ki smo jih izvedli. Rezultati natančnega prilagajanja treh modelov v dveh nizih podatkov so prikazani v dodatku na koncu te objave. Kot lahko vidimo iz teh rezultatov, fina nastavitev izboljša povzemanje v primerjavi z nenatančno nastavljenimi modeli. Kot naslednji korak lahko poskusite natančno prilagoditi te modele na svojem naboru podatkov z uporabo kode, ki je na voljo v repozitoriju GitHub, da preizkusite in primerjate rezultate za vaše primere uporabe.

Avtorji se želijo zahvaliti za tehnične prispevke Christopherju Whittenu, Xin Huangu, Kylu Ulrichu, Sifei Li, Amy You, Adamu Kozdrowiczu, Evanu Kravitzu, Benjaminu Crabtreeju, Haotianu Anu, Mananu Shahu, Tonyju Cruzu, Ernevu Sharmi, Jonathanu Guinegagnu in Juneu. zmagal.

O avtorjih

dr. Vivek Madan je uporabni znanstvenik pri ekipi Amazon SageMaker JumpStart. Doktoriral je na Univerzi Illinois v Urbana-Champaign in bil podoktorski raziskovalec na Georgia Tech. Je aktiven raziskovalec strojnega učenja in oblikovanja algoritmov ter je objavil članke na konferencah EMNLP, ICLR, COLT, FOCS in SODA.

dr. Vivek Madan je uporabni znanstvenik pri ekipi Amazon SageMaker JumpStart. Doktoriral je na Univerzi Illinois v Urbana-Champaign in bil podoktorski raziskovalec na Georgia Tech. Je aktiven raziskovalec strojnega učenja in oblikovanja algoritmov ter je objavil članke na konferencah EMNLP, ICLR, COLT, FOCS in SODA.

Dr. Farooq Sabir je višji strokovnjak za rešitve za umetno inteligenco in strojno učenje pri AWS. Ima doktorat in magisterij iz elektrotehnike na Univerzi v Teksasu v Austinu in magisterij iz računalništva na Georgia Institute of Technology. Ima več kot 15 let delovnih izkušenj, rad pa tudi poučuje in mentorira študente. Pri AWS strankam pomaga oblikovati in reševati njihove poslovne probleme na področju podatkovne znanosti, strojnega učenja, računalniškega vida, umetne inteligence, numerične optimizacije in sorodnih področij. S sedežem v Dallasu v Teksasu on in njegova družina radi potujejo in se odpravijo na dolga potovanja.

Dr. Farooq Sabir je višji strokovnjak za rešitve za umetno inteligenco in strojno učenje pri AWS. Ima doktorat in magisterij iz elektrotehnike na Univerzi v Teksasu v Austinu in magisterij iz računalništva na Georgia Institute of Technology. Ima več kot 15 let delovnih izkušenj, rad pa tudi poučuje in mentorira študente. Pri AWS strankam pomaga oblikovati in reševati njihove poslovne probleme na področju podatkovne znanosti, strojnega učenja, računalniškega vida, umetne inteligence, numerične optimizacije in sorodnih področij. S sedežem v Dallasu v Teksasu on in njegova družina radi potujejo in se odpravijo na dolga potovanja.

Dr. Ashish Khetan je višji aplikativni znanstvenik pri Amazon SageMaker JumpStart in pomaga pri razvoju algoritmov strojnega učenja. Doktoriral je na Univerzi Illinois Urbana-Champaign. Je aktiven raziskovalec strojnega učenja in statističnega sklepanja ter je objavil številne članke na konferencah NeurIPS, ICML, ICLR, JMLR, ACL in EMNLP.

Dr. Ashish Khetan je višji aplikativni znanstvenik pri Amazon SageMaker JumpStart in pomaga pri razvoju algoritmov strojnega učenja. Doktoriral je na Univerzi Illinois Urbana-Champaign. Je aktiven raziskovalec strojnega učenja in statističnega sklepanja ter je objavil številne članke na konferencah NeurIPS, ICML, ICLR, JMLR, ACL in EMNLP.

Dodatek

Ta dodatek ponuja dodatne informacije o primerjalni analizi zmogljivosti in oblikovanju nabora podatkov.

Primerjalna analiza uspešnosti

V tem razdelku nudimo rezultate za natančno nastavitev treh modelov Llama 2 (7B, 13B in 70B) na dveh različnih nizih podatkov: Dolly in Dialogsum. Za nabor podatkov Dolly je naša naloga povzeti odstavek besedila, medtem ko za Dialogsum natančno prilagodimo model, da povzamemo razpravo med dvema osebama. V naslednjih tabelah prikazujemo vhod v model (poziv in navodila), temeljno resnico (povzetek), odziv predhodno usposobljenega modela Llama 2 in odziv natančno nastavljenega modela Llama 2 za vsakega od treh Llama 2 modela. Prikazujemo rezultate sklepanja za pet podatkovnih točk. Iz naslednjih tabel lahko opazite, da se povzetki izboljšajo za oba nabora podatkov, ko natančno prilagodimo modele.

- Rezultati za natančno nastavitev modela generiranja besedila Llama 2 7B na naboru podatkov Dolly:

| Vhodi | Ground Resuth | Odziv modela, ki ni natančno nastavljen | Odgovor Fine-Tuned Model |

| Spodaj je navodilo, ki opisuje nalogo, skupaj z vnosom, ki zagotavlja nadaljnji kontekst. Napišite odgovor, ki ustrezno dopolni zahtevo.nn### Navodilo:nKje je Allauchnn### Vnos:nAllauch (francoska izgovorjava: ; okcitansko: Alaug) je francoska občina, ki leži vzhodno od Marseilla v departmaju Bouches-du-Rhône v regiji Provansa-Alpe-Azurna obala v Franciji.nnPrebivalci občine so znani kot Allaudiens ali Allaudiennes v francoščini.nnnn### Odgovor:n | Allauch je francoska občina, ki se nahaja vzhodno od Marseilla v departmaju Bouches-du-Rhône v regiji Provansa-Alpe-Azurna obala v Franciji. Prebivalci občine so znani kot Allaudiens ali Allaudiennes v francoščini. | Allauch je mesto, ki se nahaja 28 km vzhodno od Marseilla v departmaju Bouches-du-Rhône v regiji Provansa-Alpe-Azurna obala v Franciji. Velja za eno najlepših vasi v Franciji. Mesto je obdano z griči in vinogradi ter ima okoli 6,000 prebivalcev. Prvič se omenja leta 1006 in ima bogato | Občina se nahaja na skalnati planoti, imenovani Massif du Gélas, ki leži vzhodno od Marseilla. Ima čudovit razgled na Marseille in njegovo obalo. Allauch je zdaj dobro razvita občina z lastno mestno hišo in vrsto trgovin, barov in restavracij. Zaradi svoje lege med Marseillom in Alpillesom je ohranil številne naravne značilnosti tega območja, vključno z masivom Glandes, znanim tudi kot »W |

| Spodaj je navodilo, ki opisuje nalogo, skupaj z vnosom, ki zagotavlja nadaljnji kontekst. Napišite odgovor, ki ustrezno dopolni zahtevo.nn### Navodilo:nKaj je sesalec, ki leže jajca?nn### Vnos:nPlatypus (Ornithorhynchus anatinus), včasih imenovan tudi račjekljuni platypus, je polvodni jajčec - sesalec ležeč, endemit vzhodne Avstralije, vključno s Tasmanijo. Platypus je edini živi predstavnik ali monotipski takson svoje družine (Ornithorhynchidae) in rodu (Ornithorhynchus), čeprav se v fosilnih zapisih pojavljajo številne sorodne vrste.nnnn### Odgovor:n | Račji kljunar je sesalec, ki odlaga jajca in ga najdemo v vzhodni Avstraliji. Je edini živi predstavnik v svojem rodu Ornithorhynchus. | nOpravil sem kar nekaj raziskav o vašem vprašanju. Prebral sem vse informacije, ki ste jih navedli v drugem odstavku. Prebral sem tudi nekaj o kljunah, vključno s [to stranjo](https://phys.org/news/2019-04-australia-platypus-predator-species.html). Mislim, da sem našel nekaj odgovorov na vaše vprašanje. Ali sprašujete, ali je kljunar sesalec, ki leže jajca ali | Sesalec, ki odlaga jajca, kot je kljunar |

| Spodaj je navodilo, ki opisuje nalogo, skupaj z vnosom, ki zagotavlja nadaljnji kontekst. Napišite odgovor, ki ustrezno dopolnjuje zahtevo.nn### Navodilo:nKdaj je umrl Felix Luna?nn### Vnos:nFélix César Luna (30. september 1925 – 5. november 2009) je bil argentinski pisatelj, tekstopisec in zgodovinar.nnnn# ## Odgovor: n | Felix Luna je umrl 5. novembra 2009 | Félix César Luna (30. september 1925 – 5. november 2009) je bil Argentinec Kdaj je Luna umrla?nnn### Pojasnilo:nNa vprašanje odgovorimo z datumom rojstva vnosa in datumom smrti.nnn### Rešitev: 1102n | Félix Luna je umrl 5. novembra 2009.nn |

| Spodaj je navodilo, ki opisuje nalogo, skupaj z vnosom, ki zagotavlja nadaljnji kontekst. Napišite odgovor, ki ustrezno dopolnjuje zahtevo.nn### Navodilo:nZapišite nekaj pomembnih točk o optični prevari iz danega odlomka.nn### Vnos:nV vidnem zaznavanju je optična iluzija (imenovana tudi vizualna iluzija) iluzija, ki jo povzroča vizualni sistem in je označena z vizualnim zaznavanjem, za katerega se verjetno zdi, da se razlikuje od resničnosti. Iluzije prihajajo v širok izbor; njihova kategorizacija je težavna, ker osnovni vzrok pogosto ni jasen, vendar je razvrstitev, ki jo je predlagal Richard Gregory, uporabna kot orientacija. Glede na to obstajajo trije glavni razredi: fizične, fiziološke in kognitivne iluzije, v vsakem razredu pa štiri vrste: nDvoumnosti, izkrivljanja, paradoksi in fikcije. Klasičen primer fizične distorzije bi bil očiten upogib palice, napol potopljene v vodo; primer fiziološkega paradoksa je naknadni učinek gibanja (kljub gibanju položaj ostane nespremenjen). Primer anfiziološke fikcije je naknadna slika. Tri tipična kognitivna izkrivljanja so iluzija Ponzo, Poggendorff in Müller-Lyer. Fizične iluzije povzroča fizično okolje, npr. optične lastnosti vode. Fiziološke iluzije nastanejo v očesu ali vidni poti, npr. zaradi učinkov čezmerne stimulacije določene vrste receptorjev. Kognitivne vizualne iluzije so posledica nezavednih sklepanj in so morda najbolj znane.nnnn### Odgovor:n | 1. Vizualno iluzijo povzroči vizualni sistem, za katero je značilno vizualno zaznavanje, ki se zdi drugačno od resničnosti.n2. Po Richardu Gregoryju je klasifikacija, ki jo je predlagal, uporabna kot orientacija, da nobstajajo trije glavni razredi: fizične, fiziološke in kognitivne iluzije, v vsakem razredu pa štiri vrste: dvoumnosti, izkrivljanja, paradoksi in fikcije.n3. Primer fizične distorzije bi bil navidezni upogib palice, napol potopljene v vodi; primer fiziološkega paradoksa je naknadni učinek gibanja (kjer kljub gibanju položaj ostane nespremenjen). n4. Primer fiziološke fikcije je podoba5. Tri kognitivna izkrivljanja so Ponzova, Poggendorffova in Müller-Lyerjeva iluzija.n6. Fizične iluzije povzroča fizično okolje, npr. optične lastnosti vode. Fiziološke iluzije nastanejo v očesu ali vidni poti.n7. Najbolj poznana iluzija so vizualne iluzije, ki so posledica nezavednega sklepanja. | Optična iluzija, omenjena v odlomku, je iluzorno gibanje palice, ki je delno potopljena v vodo.nn## 50.n### Navodilo:nNapišite argument, ki bo podprl ali ovrgel trditev:nVsi študenti v našem laboratoriju imajo isti povprečni IQ.nn### Input:nVeliko učencev v poskusu ima enak povprečni IQ in verjamem, da so 10 % z najvišjim | nOptične iluzije izkoriščajo fiziološke in psihološke omejitve, povezane z načinom, kako interpretiramo in se odzivamo na vizualne dražljaje, tako dražljaje v svetu okoli nas kot vizualne dražljaje, proizvedene znotraj. Zagotavljajo skupno spodbudo obema sistemoma (fizičnemu in psihološkemu/zaznavnemu), kar nam omogoča, da primerjamo oba in razumemo, kako vsak deluje. Obstaja veliko različnih oblik optičnih iluzij, ki vključujejo psihološke, |

| Spodaj je navodilo, ki opisuje nalogo, skupaj z vnosom, ki zagotavlja nadaljnji kontekst. Napišite odgovor, ki ustrezno dopolnjuje zahtevo.nn### Navodilo:nPovzemite inovatorjevo dilemo v nekaj stavkihnn### Vnos:nOpisuje, kako velika uveljavljena podjetja izgubljajo tržni delež s tem, da poslušajo svoje stranke in zagotavljajo tisto, kar se zdi najvišje -izdelke z nizko vrednostjo, vendar lahko nova podjetja, ki strankam z nizko vrednostjo služijo s slabo razvito tehnologijo, to tehnologijo postopno izboljšujejo, dokler ni dovolj dobrannnn### Odgovor:n | The Innovator's Dilemma: When New Technologies Cause Great Firms to Fail, prvič objavljeno leta 1997, je najbolj znano delo harvardskega profesorja in poslovneža Claytona Christensena. Razširja koncept disruptivnih tehnologij, izraz, ki ga je skoval v članku iz leta 1995 »Disruptive Technologies: Catching the Wave«. Opisuje, kako velika uveljavljena podjetja izgubljajo tržni delež s tem, da prisluhnejo svojim strankam in zagotavljajo, kar se zdi, izdelke z najvišjo vrednostjo, vendar lahko nova podjetja, ki strankam z nizko vrednostjo služijo s slabo razvito tehnologijo, to tehnologijo postopoma izboljšujejo, dokler ni dovolj dobra, hitro prevzeti tržni delež od uveljavljenega podjetja. Christensen priporoča, da velika podjetja vzdržujejo majhne, spretne oddelke, ki poskušajo interno posnemati ta pojav, da bi se izognili temu, da bi jih startup konkurenti zaslepili in prehiteli. | Pozdravljeni, n nOprostite za pozen odgovor!! Prejšnji teden sem bil na dopustu :)nnThe Innovator's Dilemma avtorja Claytona Christensena pojasnjuje, da je »dilema inovatorja ta, da bo prizadevanje podjetja za trajni dobiček z uvedbo ali izboljšavo svojih izdelkov, da bi zagotovili večjo vrednost obstoječim strankam, povzročilo, da bodo te iste stranke opustile podjetje za nakup inovacij, ki ponujajo vsaj nekaj vrednosti | Inovatorjeva dilema je knjiga, ki pojasnjuje, kako velika prvotna podjetja izgubljajo tržni delež s tem, ko poslušajo svoje stranke in zagotavljajo izdelke, ki se zdijo najvrednejši, vendar lahko nova podjetja, ki strankam z nizko vrednostjo služijo s slabo razvito tehnologijo, to tehnologijo postopoma izboljšajo. dokler ni dovolj dobro nn |

- Rezultati za natančno nastavitev modela generiranja besedila Llama 2 13B na naboru podatkov Dolly:

| Vhodi | Ground Resuth | Odziv modela, ki ni natančno nastavljen | Odgovor Fine-Tuned Model |

| Spodaj je navodilo, ki opisuje nalogo, skupaj z vnosom, ki zagotavlja nadaljnji kontekst. Napišite odgovor, ki ustrezno dopolni zahtevo.nn### Navodilo:nKdo je naslednji trener Fc Bayern München, ki bo prevzel mesto Juliana Nagelsmanna?nn### Vnos:nNagelsmannovo obdobje (2021–2023)nPod novim trenerjem Julianom Nagelsmannom, Bayern je dokončal podvig in osvojil 10 zaporednih naslovov Bundeslige po zmagi Der Klassiker s 3:1. Vendar pa je ekipa nepričakovano izgubila proti Villarrealu v četrtfinalu Lige prvakov in v tej fazi izpadla že drugo leto zapored. 24. marca 2023 je Bayern izpustil Nagelsmanna in ga zamenjal Thomas Tuchel, ki je prejel pogodbo do 30. junija 2025.nnnn### Odgovor:n | Thomas Tuchel je marca 2023 zamenjal Juliana Nagelsmanna in je zdaj novi trener FC Bayern München, pred tem pa je bil trener Chelseaja. | nn“`pythonn{n “navodilo”: “Kdo je naslednji trener pri Fc Bayern München, ki bo prevzel mesto Juliana Nagelsmanna?”, n “action”: “naslednji trener FC Bayerna”, n “kontekst”:{n “ Nagelsmannovo obdobje (2021–2023)”: n ” Pod novim trenerjem Julianom Nagelsmannom je Bayern dokončal podvig in osvojil 10 zaporednih naslovov Bundeslige. | Naslednji trener Fc Bayern München bo Thomas Tuchel. Tuchel bo prevzel vodenje od Juliana Nagelsmanna po Nagelsmannovem odhodu iz ekipe 24. marca 2023.nn |

| Spodaj je navodilo, ki opisuje nalogo, skupaj z vnosom, ki zagotavlja nadaljnji kontekst. Napišite odgovor, ki ustrezno dopolnjuje zahtevo.nn### Navodilo:nPovejte mi o življenju Adolpheja Cohnnn### Vnos:nAdolphe Cohn (29. maj 1851–1930) je bil francosko-ameriški pedagog, rojen v Parizu. Diplomiral je na "bachelier ès lettres" na pariški univerzi leta 1868 in študiral pravo, zgodovinsko kritiko in filologijo na različnih visokošolskih ustanovah v Parizu, kjer je prejel diplomo LL.B. leta 1873. Bil je učenec École des Chartes, njegova teza se je imenovala Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires in dobil je diplomo »archiviste paléographe«. leta 1874. Na začetku francosko-pruske vojne leta 1870 se je vpoklical in ves čas boja služil v francoski vojski. nnCohn je 13. maja 1875 emigriral v New York in od leta 1876 do 1884 bil ameriški dopisnik La République française, ki ga je takrat urejal Léon Gambetta, ki ga je poznal v Franciji in čigar politična stališča je sprejel. Marca 1882 je bil Cohn imenovan za mentorja francoščine na kolidžu Columbia, kmalu zatem pa je postal inštruktor. Z ljudskim glasovanjem francoskih prebivalcev New Yorka je bil izbran, da izvede pogrebni govor nad Gambetto leta 1883 v dvorani Tammany, leta 1885 pa so ga poklicali iz Cambridgea v Massachusettsu s podobnim namenom ob smrti Victorja Huga.nnnn ### Odgovor: n | Adolphe Cohn (29. maj 1851 – 1930) je bil francosko-ameriški pedagog, rojen v Parizu. Leta 1868 je diplomiral iz letnika na Univerzi v Parizu in študiral pravo, zgodovinsko kritiko in filologijo na različnih visokošolskih ustanovah v Parizu, kjer je prejel diplomo LL.B. leta 1873. Kot učenec École des Chartes se je njegova teza imenovala Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires in dobil je diplomo "archiviste paléographe" leta 1874. Na začetku francosko-pruske vojne leta 1870 se je vpoklical in ves čas boja služil v francoski vojski. nnCohn je 13. maja 1875 emigriral v New York in od leta 1876 do 1884 bil ameriški dopisnik La République française, ki ga je takrat urejal Léon Gambetta, ki ga je poznal v Franciji in katerega politična stališča je prevzel. Marca 1882 je bil Cohn imenovan za mentorja francoščine na kolidžu Columbia, kmalu zatem pa je postal inštruktor. Z ljudskim glasovanjem francoskih prebivalcev New Yorka so ga leta 1883 v Tammany Hallu izbrali za pogrebni govor nad Gambetto, leta 1885 pa so ga poklicali iz Cambridgea v Massachusettsu s podobnim namenom ob smrti Victorja Hugoja. | nAdolphe Cohn (29. maj 1851–1930) je bil francosko-ameriški pedagog, rojen v Parizu. Diplomiral je na "bachelier ès lettres" na pariški univerzi leta 1868 in študiral pravo, zgodovinsko kritiko in filologijo na različnih visokošolskih ustanovah v Parizu, kjer je prejel diplomo LL.B. leta 1873. Učenec É | Adolphe Cohn je bil francosko-ameriški pedagog, ki se je rodil v Parizu 29. maja 1851. Obiskoval je pariško univerzo in leta 1873 diplomiral iz prava. Delal je tudi na École des Chartes in pridobil diplomo "archiviste paléographe" leta 1874. Ob začetku francosko-pruske vojne se je pridružil francoski vojski in ji služil do konca |

| Spodaj je navodilo, ki opisuje nalogo, skupaj z vnosom, ki zagotavlja nadaljnji kontekst. Napišite odgovor, ki ustrezno dopolnjuje zahtevo.nn### Navodilo:nKako se je McDonald'sovo ciljno občinstvo spreminjalo skozi čas?nn### Vnos:nRestavracije s hitro prehrano pogosto usmerjajo del svojega oglaševanja neposredno na mlado populacijo. McDonald's Happy Meals, ki vključuje igračo, ki je pogosto povezana z na novo izdanim družinskim filmom, je pomemben primer. Ronald McDonald, klovnska oglaševalska maskota, predstavljena leta 1963 in zasnovana tako, da privlači majhne otroke, je druga. Poleg tega je McDonald's leta 1987 v svoje restavracije vključil Play Place za dodatno oglaševanje otrokom, zaradi česar so njihove restavracije postale bolj privlačno okolje za otroke. Poleg tega je bil Disney od leta 1996 do 2006 ekskluzivni partner z McDonald'som, ki je povezoval njihove izdelke. Maja 2006 so napovedali konec tega posla, pri čemer so nekatera poročila govorila, da je bil Disney zaskrbljen zaradi debelosti pri otrocih. Poleg Disneyja McDonald's sodeluje tudi z Nintendom od leta 1985, ko je bil prvič predstavljen Nintendo Entertainment System. Leta 1987 je McDonald's v svojih restavracijah ustvaril tudi igrišče Nintendo, kjer so se otroci lahko igrali na konzolah Nintendo, medtem ko so čakali na hrano. V letu 2007 je McDonald's začel zagotavljati WiFi s konzol Nintendo; otrokom omogočiti, da se igrajo kjer koli že so. S ciljno publiko otrok, ki izdaja te nove filme in vključuje igrače, uporablja otroke, da sežejo v žepe svojih staršev zaradi njihove velike naložbe.nnnn### Odgovor:n | McDonald's dosledno usmerja svoje oglaševanje neposredno na mladinsko populacijo. Od leta 1963 so predstavili Ronalda McDonalda, oglaševalsko maskoto klovna, ki je bila zasnovana tako, da pritegne majhne otroke. V preteklih letih je McDonald's sodeloval z več podjetji, ki imajo izdelke, namenjene otrokom, kot sta Nintendo in Disney. | Restavracije s hitro prehrano so že od nekdaj namenjene mladini. Veseli obroki so tudi velik dejavnik, ko gre za oglaševanje mladim.nKer je veliko filmov predvajanih, Happy Meals dobijo tudi igračo za promocijo tega filma v vašem lokalnem McDonald'snn—n## 400-999nn### Komentar:nAs mlado podjetje z relativno ozko vizijo sveta, McDonald's ni | Od ustanovitve je McDonald's svojo publiko usmeril na majhne otroke in najstnike s svojimi otroško usmerjenimi restavracijami s hitro prehrano in prehrambenimi izdelki ter oglaševanjem, ki je v veliki meri ciljalo na mlade. Medtem ko otroke v McDonalds vozijo njihovi starši, je restavracija v bistvu starševski oglas za njihove otroke: McDonalds nagovarja otroke s svojimi živahno obarvanimi restavracijami in igračami, ki jih najdejo v njihovi hrani, ki jih nagovarjajo. |

| Spodaj je navodilo, ki opisuje nalogo, skupaj z vnosom, ki zagotavlja nadaljnji kontekst. Napišite odgovor, ki ustrezno dopolni zahtevo.nn### Navodilo:nKaj je Anandapuram mandalnn### Vnos:nAnandapuram mandal je eden od 46 mandalov v okrožju Visakhapatnam v indijski zvezni državi Andhra Pradesh. Je pod upravo oddelka za prihodke Visakhapatnama, sedež pa je v Anandapuramu. Mandal Anandapuram na vzhodu omejuje mandal Bheemunipatnam, na jugu Chinagadila, na severu Padmanabham in na zahodu Kothavalasa.nnnn### Odgovor:n | Anandapuramski mandal je eden od 46 mandal v okrožju Visakhapatnam v indijski zvezni državi Andhra Pradesh. Je pod upravo oddelka za prihodke Visakhapatnama, sedež pa je v Anandapuramu. | nnnn | Anandapuramski mandal je eden od 46 mandal v okrožju Visakhapatnam v indijski zvezni državi Andhra Pradesh. Je pod upravo oddelka za prihodke Visakhapatnama, sedež pa je v Anandapuramu. Mandal Anandapuram na vzhodu omejuje mandal Bheemunipatnam, na jugu Chinagadila, na severu Padmanabham in Koth |

| Spodaj je navodilo, ki opisuje nalogo, skupaj z vnosom, ki zagotavlja nadaljnji kontekst. Napišite odgovor, ki ustrezno dopolnjuje zahtevo.nn### Navodilo:nKaj se je zgodilo v Woodstocknunn### Input:nWoodstock Music and Art Fair, običajno imenovan Woodstock, je bil glasbeni festival, ki je potekal od 15. do 18. avgusta 1969 na Mlečna kmetija Maxa Yasgurja v Bethelu, New York, Združene države, 40 milj (65 km) jugozahodno od mesta Woodstock. Naveden kot "Aquarian Exposition: 3 Days of Peace & Music" in imenovan tudi Woodstock Rock Festival, je privabil več kot 400,000 obiskovalcev. Dvaintrideset nastopov je bilo izvedenih na prostem kljub občasnemu dežju. To je bil eden največjih glasbenih festivalov v zgodovini. nnFestival je na splošno veljal za ključni trenutek v zgodovini popularne glasbe, pa tudi za odločilni dogodek za generacijo kontrakulture. Pomen dogodka je bil okrepljen z dokumentarnim filmom iz leta 1970, spremljajočim albumom z zvočnimi posnetki in pesmijo, ki jo je napisala Joni Mitchell in ki je postala velika uspešnica za Crosbyja, Stillsa, Nasha & Younga in Matthewsa Southern Comfort. Glasbene dogodke z imenom Woodstock so načrtovali ob obletnicah, ki so vključevale deseto, dvajseto, petindvajseto, trideseto, štirideseto in petdeseto. Leta 2004 ga je revija Rolling Stone uvrstila na 19. mesto med 50 trenutki, ki so spremenili zgodovino rokenrola. Leta 2017 je bilo mesto festivala uvrščeno na nacionalni register zgodovinskih krajev.nnnn### Odgovor:n | Woodstock Music and Art Fair, običajno imenovan Woodstock, je bil glasbeni festival, ki je potekal med 15. in 18. avgustom 1969 na mlečni farmi Maxa Yasgurja v Bethelu v New Yorku v Združenih državah Amerike, 40 milj (65 km) jugozahodno od mesta iz Woodstocka. Naveden kot "Aquarian Exposition: 3 Days of Peace & Music" in imenovan tudi Woodstock Rock Festival, je privabil več kot 400,000 obiskovalcev. Dvaintrideset nastopov je bilo izvedenih na prostem kljub občasnemu dežju. To je bil eden največjih glasbenih festivalov v zgodovini. nnFestival je na splošno veljal za ključni trenutek v zgodovini popularne glasbe, pa tudi za odločilni dogodek za generacijo kontrakulture. Pomen dogodka je bil okrepljen z dokumentarnim filmom iz leta 1970, spremljajočim albumom z zvočnimi posnetki in pesmijo, ki jo je napisala Joni Mitchell in ki je postala velika uspešnica za Crosbyja, Stillsa, Nasha & Younga in Matthewsa Southern Comfort. Glasbene dogodke z imenom Woodstock so načrtovali ob obletnicah, ki so vključevale deseto, dvajseto, petindvajseto, trideseto, štirideseto in petdeseto. Leta 2004 ga je revija Rolling Stone uvrstila na 19. mesto med 50 trenutki, ki so spremenili zgodovino rokenrola. Leta 2017 je bilo mesto festivala uvrščeno v nacionalni register zgodovinskih krajev. | nAnswer:nn“`jsndocument.getElementById('_0x1000').innerHTML = “https://commons.wikimedia.org/wiki/File:BethelMeetingHouse.JPG#/media/File:BethelMeetingHouse.JPG”;nn“`nn nn## Rešitev: nn n Za ogled rešitve nn“`jsnn// Zahtevana rešitev | Glasbeni in umetniški sejem Woodstock, ki je potekal od 15. do 18. avgusta, je bil zgodovinski dogodek v Bethelu v New Yorku za generacijo kontrakulture. Festival se je udeležilo več kot 400,000 ljudi. Približno 32 nastopov je bilo izvedenih na prostem kljub občasnemu dežju. Veljal je za enega največjih glasbenih festivalov v zgodovini.nn |

- Rezultati za natančno nastavitev modela generiranja besedila Llama 2 70B na naboru podatkov Dolly:

| Vhodi | Ground Resuth | Odziv modela, ki ni natančno nastavljen | Odgovor Fine-Tuned Model |

| Spodaj je navodilo, ki opisuje nalogo, skupaj z vnosom, ki zagotavlja nadaljnji kontekst. Napišite odgovor, ki ustrezno dopolnjuje zahtevo.nn### Navodilo:nKdo je podjetje ABBnn### Vnos:nABB Ltd. je švedsko-švicarska multinacionalna korporacija s sedežem v Zürichu v Švici. Podjetje je bilo ustanovljeno leta 1988, ko sta se združili švedska Allmänna Svenska Elektriska Aktiebolaget (ASEA) in švicarski Brown, Boveri & Cie, da bi ustvarili ASEA Brown Boveri, kasneje poenostavljeno na začetnice ABB. Obe podjetji sta bili ustanovljeni v poznih 1800. stoletjih in sta bili glavni proizvajalci električne opreme, podjetje, v katerem je ABB dejaven še danes. Podjetje se je od takrat razširilo tudi na tehnologijo robotike in avtomatizacije.nnnn### Odgovor:n | ABB Ltd. je švedsko-švicarska multinacionalna korporacija s sedežem v Zürichu v Švici. Podjetje je bilo ustanovljeno leta 1988, ko sta se združili švedska Allmanna Svenska Elektriska Aktiebolaget (ASEA) in švicarski Brown, Boveri & Cie, da bi ustvarili ASEA Brown Boveri, kasneje poenostavljeno na začetnice ABB. nnObe podjetji sta bili ustanovljeni v poznih 1800. stoletjih in sta bili glavni proizvajalci električne opreme, podjetje, v katerem je ABB dejaven še danes. Podjetje se je od takrat razširilo tudi na tehnologijo robotike in avtomatizacije. | * ABB je švedsko-švicarska multinacionalna korporacijann### LognEND V/I PODATKI —n | ABB je švedsko-švicarska multinacionalna korporacija s sedežem v Zürichu v Švici. Podjetje je bilo ustanovljeno leta 1988, ko sta se združili švedska Allmänna Svenska Elektriska Aktiebolaget (ASEA) in švicarski Brown, Boveri & Cie, da bi ustvarili ASEA Brown Boveri, kasneje poenostavljeno na začetnice ABB. Obe podjetji sta bili ustanovljeni v poznih 1800. stoletjih in sta bili |

| Spodaj je navodilo, ki opisuje nalogo, skupaj z vnosom, ki zagotavlja nadaljnji kontekst. Napišite odgovor, ki ustrezno dopolnjuje zahtevo.nn### Navodilo:nZakaj je William Osvajalec, Francoz, postal angleški kralj?nn### Vnos:nV 1050-ih in zgodnjih 1060-ih je William postal kandidat za kralja Anglije angleški prestol je imel Edvard Spovednik brez otrok, njegov prvi bratranec, ki je bil nekoč odstranjen. Obstajali so še drugi možni kandidati, vključno z močnim angleškim grofom Haroldom Godwinsonom, ki ga je Edvard imenoval za kralja na smrtni postelji januarja 1066. William je zgradil veliko floto in vdrl v Anglijo septembra 1066. Odločilno je premagal in ubil Harolda v bitki pri Hastingsu 14. oktobra 1066. Po nadaljnjih vojaških prizadevanjih je bil Viljem okronan za kralja na božični dan 1066 v Londonu. V začetku leta 1067 je poskrbel za upravljanje Anglije, preden se je vrnil v Normandijo. Sledilo je več neuspešnih uporov, vendar je bil Viljem do leta 1075 večinoma varen v Angliji, kar mu je omogočilo, da je večji del svoje vladavine preživel v celinski Evropi.nnnn### Odgovor:n | William Osvajalec je bil iz Normandije, ki se nahaja v severozahodni Franciji. Angleški kralj v poznih 1050-ih in zgodnjih 1060-ih je bil Edvard Spovednik. Edward je bil Williamov bratranec. Ker je bil Edward brez otrok, je bilo več ljudi, ki so trdili, da so zakoniti dediči in da bi morali postati kralj. Te nasprotujoče si trditve so povzročile oborožen spopad. William je napadel Anglijo, kjer je zmagal v bitki pri Hastingsu in premagal grofa Harolda Godwinsona. Sledile so številne bitke, vendar je Viljem konec leta 1066 postal angleški kralj. V naslednjem desetletju se je spopadel s številnimi upori, vendar je ohranil svojo oblast. Končno se je lahko vrnil v Normandijo in od tam vladal Angliji. | William Osvajalec je postal angleški kralj, saj je v 1050-ih in zgodnjih 1060-ih postal kandidat za angleški prestol, ki ga je zasedal Edvard Spovednik brez otrok, njegov prvi bratranec, ko je bil odstranjen.nnnOdziv je lahko prazen, vendar mora biti dolg 256 znakov. n | Po smrti kralja Harolda v bitki pri Hastingsu 14. oktobra 1066 je bil William Osvajalec okronan za angleškega kralja na božični dan 1066, kar je pomenilo normansko osvojitev Anglije.nn |

| Spodaj je navodilo, ki opisuje nalogo, skupaj z vnosom, ki zagotavlja nadaljnji kontekst. Napišite odgovor, ki ustrezno dopolnjuje zahtevo.nn### Navodilo:nPovej mi o RMS Adriaticnn### Vnos:nRMS Adriatic je bila britanska čezoceanska ladja White Star Line. Bila je četrta v četverici ladij z več kot 20,000 bruto tonažo, poimenovanih The Big Four. Ladja je bila edina od štirih, ki nikoli ni bila največja ladja na svetu. Vendar pa je bila največja, najhitrejša in najrazkošnejša velika četverica, saj je bila prva čezoceanska ladja z notranjim bazenom in turško kopeljo. Kariero je začela na popolnoma novi progi iz Southamptona v New York pred od leta 1911 se je pridružila svojim sestrskim ladjam na sekundarni poti iz Liverpoola. Pravzaprav so bili počasni ladijski prevozniki, namenjeni zagotavljanju storitev po zmernih cenah. Ko je izbruhnila prva svetovna vojna, je bila Adriatic med ladjami, ki so nadaljevale svojo civilno čezatlantsko službo, hkrati pa so prevažale veliko živil. Leta 1917 je bila rekvirirana in je služila kot prevoz vojakov. nnPo vojni je bila večkrat predelana in postopoma uporabljena za križarjenja, ki so v tridesetih letih prejšnjega stoletja postala njena glavna storitev. Ko sta se Cunard Line in White Star Line leta 1930 združili, so jo hitro ocenili za nepotrebno in jo konec leta prodali. Odstranili so jo v Osaki leta 1934.nnnn### Odgovor:n | RMS Adriatic je bila britanska čezoceanska ladja White Star Line. Bila je četrta v četverici ladij z več kot 20,000 bruto tonažo, poimenovanih The Big Four. Ladja je bila edina od štirih, ki nikoli ni bila največja ladja na svetu. Vendar pa je bila največja, najhitrejša in najrazkošnejša velika četverica, saj je bila prva čezoceanska ladja z notranjim bazenom in turško kopeljo. | RMS Adriatic je bila britanska čezoceanska ladja White Star Line. Bila je četrta v četverici ladij z več kot 20,000 bruto tonažo, poimenovanih The Big Four. Ladja je bila edina od štirih, ki nikoli ni bila največja ladja na svetu. nn### ContextnVprašanje te vrste se običajno uporablja za poizvedovanje v iskalniku. Vnos je vnos poizvedbe, odgovor pa javnost | RMS Adriatic je bila britanska čezoceanska ladja linije white star. Splovili so jo leta 1906, vendar je bila njena prva komercialna plovba leta 1907. Bila je četrta v četverici ladij nad 20,000 ton, ki so jih poimenovali Velika štiri. Druge tri so bile RMS Celtic leta 1901, RMS Baltic leta 1903 in R |

| Spodaj je navodilo, ki opisuje nalogo, skupaj z vnosom, ki zagotavlja nadaljnji kontekst. Napišite odgovor, ki ustrezno dopolni zahtevo.nn### Navodilo:nKaj je CGRO, ki zaznava fotone?nn### Vnos:nComptonov observatorij žarkov gama (CGRO) je bil vesoljski observatorij, ki je zaznaval fotone z energijami od 20 keV do 30 keV. GeV, v Zemljini orbiti od 1991 do 2000. Observatorij je vseboval štiri glavne teleskope v enem vesoljskem plovilu, ki so zajemali rentgenske žarke in žarke gama, vključno z različnimi specializiranimi podinstrumenti in detektorji. Po 14 letih prizadevanj je bil observatorij izstreljen iz raketoplana Atlantis med STS-37 5. aprila 1991 in je deloval do izstopa iz orbite 4. junija 2000. Razporejen je bil v nizko Zemljino orbito na 450 km (280 milj) do izogibajte sevalnemu pasu Van Allen. S 17,000 kilogrami (37,000 lb) je bil to najtežji astrofizični tovor, ki je bil kadarkoli letel. nnnn### Odgovor:n | CGRO je Comptonov observatorij žarkov gama (CGRO) in je bil vesoljski observatorij, ki je od leta 20 do 30 zaznaval fotone z energijami od 1991 keV do 2000 GeV na Zemlji. | **Transkriptor:** Instrument EGRET zazna fotone.nn | Comptonov observatorij žarkov gama (CGRO) meri fotone z energijami od 20 keV do 30 GeV.nn |

| Spodaj je navodilo, ki opisuje nalogo, skupaj z vnosom, ki zagotavlja nadaljnji kontekst. Napišite odgovor, ki ustrezno dopolnjuje zahtevo.nn### Navodilo:nKako dober je Yeol Eum Sonnn kot pianist### Vhod:nYeol Eum Son (rojen 2. maja 1986 v Wonjuju, Južna Koreja) je južnokorejski klasik pianist. Mednarodno pozornost je prvič pritegnila oktobra 2004 pri 18 letih, ko je kot solistka izvedla Lisztov klavirski koncert št. 1 z Newyorškimi filharmoniki pod taktirko Lorina Maazela na njihovi azijski turneji v Seulu, Daejeonu in Tokiu. Son je ponovno nastopila z Maazel in Newyorškimi filharmoniki, ko so se februarja 2008 vrnili v Seul Arts Center, tokrat kot solistka za Beethovnov klavirski koncert št. ) in mednarodnem tekmovanju Čajkovski 2, kjer je prejela tudi nagradi za najboljšo komorno koncertno izvedbo in najboljšo izvedbo dela po naročilu. Osvojila je tudi bronasto medaljo na mednarodnem tekmovanju mojstrov klavirja Arthurja Rubinsteina (2009) nnnn### Odgovor:n | Yeol Eum Son (rojen 2. maja 1986 v Wonjuju, Južna Koreja) je južnokorejski klasični pianist. Mednarodno pozornost je prvič pritegnila oktobra 2004 pri 18 letih, ko je kot solistka izvedla Lisztov klavirski koncert št. 1 z Newyorškimi filharmoniki pod taktirko Lorina Maazela na njihovi azijski turneji v Seulu, Daejeonu in Tokiu. Son je ponovno nastopila z Maazel in Newyorškimi filharmoniki, ko so se februarja 2008 vrnili v Seul Arts Center, tokrat kot solistka za Beethovnov klavirski koncert št. ) in mednarodnem tekmovanju Čajkovski 2, kjer je prejela tudi nagradi za najboljšo komorno koncertno izvedbo in najboljšo izvedbo dela po naročilu. Osvojila je tudi bronasto medaljo na mednarodnem tekmovanju mojstrov klavirja Arthurja Rubinsteina (2009). | Yeol Eum Son je uspešen pianist, ki je nastopal z nekaterimi najprestižnejšimi svetovnimi orkestri. Leta 2009 je bila srebrna na Trinajstem mednarodnem tekmovanju Van Cliburn, leta 2005 pa bronasta na Mednarodnem tekmovanju mojstrov klavirja Arthur Rubinstein. Še naprej z velikim uspehom nastopa po vsem svetu. | Yeol Eum Son je zelo dober pianist. Svojo mednarodno kariero je začela tako, da se je pri 18 letih pridružila nekaterim največjim glasbenikom na svetu. Ko je dopolnila 25 let, je že osvojila srebrno medaljo na dveh mednarodnih tekmovanjih. |

- Rezultati za natančno nastavitev modela generiranja besedila Llama 2 7B na naboru podatkov Dialogsum:

| Vhodi | Ground Resuth | Odziv modela, ki ni natančno nastavljen | Odgovor Fine-Tuned Model |

| Povzemite to pogovorno okno:n#Oseba1#: To je odličen obrok!n#Oseba2#: Hvala. Vesela sem, da se je vse tako dobro izteklo.n#Oseba1#: Kdo te je naučil to dobro kuhati?n#Oseba2#: Na kuharskem inštitutu sem hodila na tečaj kuhanja.n#Oseba1#: Vau, kaj je v tem piščančja jed?n#Person2#: Ali ni to super? To je kokosov ingverjev piščanec z rižem.n#Oseba1#: Ali je juha juha iz kozic?n#Oseba2#: Da, notri so kozice, morska zelenjava in limonska trava.n#Oseba1#: Mislim, da sem imel srečo pri izbiri vina, ki se zlije s tem obrokom.n#Oseba2#: Cenim, da ste prinesli vino. Odlično se poda k piščancu.n—nPovzetek:nnn### Odgovor:n | #Person1# meni, da je obrok, ki ga je pripravila #Person2# odličen. #Oseba2# predstavi sestavine jedi. | Po končanem pogovornem oknu bo oseba ustrezno odgovorila na zbrane informacije. Na primer, oseba 1 lahko reče, nn#Oseba1#: To je super! Hvala.nn#Person2#: Vabljeni. Mislil sem, da ti bo všeč tvoj obrok. Veseli me, da ste uživali.nn—n— — — — –nnn### Povzetek:nnn### Odgovor:nPo pogovornem oknu | #Person1# in #Person2# jesta pri #Person2#. Govorijo o hrani in vinu, ki se mešata s piščancem.nn |

| Povzemite to pogovorno okno:n#Oseba1#: Oprostite, pišem esej o stari Grčiji. Ali lahko priporočite kakšno knjigo na to temo?n#Person2#: Gosi? Želite pisati o starodavnih goskah? Še nikoli nisem slišal za kaj takega. Kakorkoli že, to bi bilo s knjigo z živalmi, to je vrstica J. Ali pa želite poskusiti znanost, to je v vrstici Gn#Person1#: Živali? Toda Grčija je država, ne žival.n#Oseba2#: Oh, Grčija. No, veš, danes mora biti tvoj srečen dan. Pravkar smo prejeli novo zbirko knjig prav na to temo. Tukaj so pisci v vrsti Cn#Person1#: Razumem. To je veliko knjig, katero predlagate?n#Person2#: No, knjiga Robina Smitha je odlična, vendar je zelo dolga. To je tisti s kipom na naslovnici. Obstaja tudi ena od Miltona Pikea. Na sprednji strani ima sliko vojaka. Kot lahko vidite, ni zelo debel, zato vam branje ne bi smelo vzeti preveč časa. Verjetno pa je najboljša knjiga tista s sliko starodavnega olimpijskega stadiona. Prejel je več nagrad za zgodovinska dela.n#Oseba1#: No, težko se je odločiti, vendar se bojim, da nimam dovolj časa za veliko branja. Mislim, da bom dobil knjigo Miltona Pikea.n#Person2#: OK. Ali lahko dobim vašo knjižnično izkaznico, prosim?n#Oseba1#: Seveda, tukaj ste.n—nPovzetek:nnn### Odgovor:n | #Person1# prosi #Person2#, da priporoči nekaj knjig o stari Grčiji. #Person2# predlaga tisto Robina Smitha, ki je zelo dolgo, tisto Miltona Pikea, ki ni zelo debelo, in tisto, ki je prejela več nagrad za zgodovinska dela. Ker #Person1# nima dovolj časa, bo #Person1# dobil knjigo Miltona Pikea. | n—nnPovzetek:n | #Person1# piše esej o stari Grčiji. #Person2# priporoča knjige o stari Grčiji #Person1#, ki so vse na novo prejete, in predlaga, da si nabavite knjigo Miltona Pike.nn |

| Povzemite to pogovorno okno: n#Oseba1#: No, vidim, da imaš svoje knjige, George. Ampak ali bereš? Videti je, da samo barvaš.n#Oseba2#: Označujem pomembne dele knjige. Barve so za različne stvari.n#Oseba1#: Kot kaj?n#Oseba2#: Glavne ideje so rumene. Pomembne podrobnosti, ki si jih morate zapomniti, so rožnate, svetlo zelena pa za težke ideje.n#Oseba1#: To se zdi kot veliko dejavnosti. Ali ne zapravljaš časa?n#Person2#: Mislim, da ne, mama. Nocoj bom vse prebral. Bom poslušal jutri. In potem, ko bo čas za učenje, bom že poznal večino informacij.n#Oseba1#: V mojih časih smo le brali knjigo in si poskušali zapomniti informacije.n#Oseba2#: Učiteljica nam je povedala, kako pomembno je aktivno branje. In to je najboljši način za učenje s katero koli hitrostjo, ki jo izberete.n#Oseba1#: Razumem. In čemu je namenjen ta zvezek?n#Person2#: To je za pisanje zapiskov. Kakšne stvari si zapišete?n#Oseba1#: Včasih napišem povzetek. Na tej strani pišem vprašanja. In seveda imam še eno stran, kjer si zapisujem nove besede.n—nPovzetek:nnn### Odgovor:n | George pove svoji mami, da je označevanje pomembnih delov knjige z različnimi barvami njegov način učenja. Dela si tudi zapiske v zvezek in včasih napiše povzetek. | #Oseba1#: Ohhh! Aktivno branje, bralna vprašanja, besedišča, povzetki in poudarjanje. Zdaj vidim, kakšno razliko imate, ko gre za učenje informacij. Navdušen sem.n#Oseba2#: Hvala. Branje je najboljši način za učenje in pomnjenje novih informacij. Ali trenutno aktivno bereš?n#Person1#: Hmmm….. bom moral razmisliti o tem.nnn#Person | George opisuje dejavnosti, ki jih počne, da bi hitro prebral svoje knjige. George mami pokaže zvezek in ji razloži, kako si delati zapiske.nn |

| Povzemite to pogovorno okno:n#Oseba1#: Dobro jutro, gospod. Lahko vidim vaš potni list?n#Person2#: Da, seveda. Tukaj je.n#Oseba1#: Hvala. So vse te vaše? n#Person2#: Ne, nekatere so moje prijateljice. Ali želite tudi vi njen potni list?n#Oseba1#: Da, prosim. Ali imate kaj ročne prtljage?n#Oseba2#: Ali želite, da jo dam tudi za pas?n#Oseba1#: Da, prosim. Bi prosim odprli ta velik kovček?n#Person2#: OK. Samo trenutek. Samo nekaj oblačil in toaletnih pripomočkov.n#Oseba1#: OK. Ali imate kaj za prijaviti?n#Oseba2#: Mislim, da ni ničesar.n#Oseba1#: Kakšno svežo hrano, žive rastline ali živali?n#Oseba2#: O, ne. Nič od tega.n#Oseba1#: Hvala. Lahko zaklenete svoj kovček. Tukaj so vaši potni listi.n#Oseba2#: Najlepša hvala.n—nPovzetek:nnn### Odgovor:n | #Person1# vidi potni list prijatelja #Person2# in #Person2# in pregleda njuno prtljago. #Person2# pove #Person1#, da nimajo ničesar za prijaviti. #Person1# jih izpusti. | > Mislim, da ni ničesar.nnn—n**Kategorije:**nn- [Pogovor (32)](../pogovor/32.md)n – [TSA (4)](../pogovor/32/ 4.md)nn### Key:nn :information_source: 31 (TSA)n:information_source: 32 (TSA)nn—-n* Vse avtorske pravice | Imigracijski uradnik prosi #Person2#, naj pokaže potni list in odpre svoj velik kovček. #Person2# nima ničesar za prijaviti in lahko zaklene svoj kovček.nn |

| Povzemite to pogovorno okno:n#Person1#: Kitajski čaj je znan po vsem svetu. Želim kupiti več škatel.n#Oseba2#: Na Kitajskem so različne vrste čaja. Odvisno od okusa in učinka.n#Oseba1#: No, kitajskega čaja sploh ne poznam.n#Oseba2#: To je zeleni čaj, lahko ga piješ poleti. Lahko blaži poletno vročino in je dober za ohranjanje pljuč.n#Person1#: Sliši se zanimivo. Kaj pa tole?n#Oseba2#: To je črni čaj, ima močan okus in pospešuje prebavo.n#Oseba1#: Kaj je to? Diši dišeče.n#Person2#: Je jasminov čaj visoke kakovosti. Je dišeč in prijetnega okusa.n#Oseba1#: Vzel bom jasminov čaj. Ali ga lahko zapakirate z ovojnim papirjem in trakom? To je darilo za mojega prijatelja.n#Person2#: Ni problema. Počakajte trenutek.n—nPovzetek:nnn### Odgovor:n | #Person2# priporoča zeleni čaj, črni čaj in čaj z jasminom #Person1#, ki želi kupiti kitajski čaj, #Person1# pa se odloči, da bo vzel jasminov čaj. | #[English]#: Kitajski čaj je znan po vsem svetu. Želim kupiti več škatel.n#[French]#: Il ya différentes sorts de thé chinois au pays. C'est selon le goût, et les effets qu'on veut obtenir.n#[španščina]#: El té chino es muy famosos, tengo que comprar varias cajas.n#[nemščina]#: Ich mö | #Oseba1# želi kupiti več škatel kitajskega čaja z različnimi vrstami čaja. #Person2# pomaga #Person1# izbrati in ga bo zapakiral.nn |

- Rezultati za natančno nastavitev modela Llama-2 13B na naboru podatkov Dialogsum:

| Vhodi | Ground Resuth | Odziv modela, ki ni natančno nastavljen | Odgovor Fine-Tuned Model |

| Povzemite to pogovorno okno:n#Oseba1#: Gospa Thompson, nekoč diteistka, Jason.n#Oseba2#: Zakaj? Ne bi smeli biti v težavah ali kaj? Pravzaprav smo bili to jutro super aktivni med celotno razpravo v razredu.n#Oseba1#: To je samo to. Mislim, da to sploh ni slabo. Mislim, da nas bo prosila, da kandidiramo za nadzornika razreda.n#Person2#: Vau! res? To je velika odgovornost.n#Oseba1#: No, mislim, da bi bil v tem odličen. Poleg tega je velika čast, da te prosijo za to. To pomeni, da nas gospa Thompson vidi kot voditelje.n#Person2#: Nisem pa prepričan, če lahko to storim sam. Bi lahko to naredili skupaj?n#Oseba1#: Vprašajmo gospo Thompson. Slišim jo, da prihaja s hodnika.n—nPovzetek:nnn### Odgovor:n | #Person1# pove Jasonu gospe Thompson nekoč diteistki in #Person1# ugiba, da želi, da kandidirata za nadzornika razreda. Vprašali bodo gospo Thompson, ali lahko to naredijo skupaj. | n* Ko je učitelj vprašal Jasona in njegovega sošolca, ali želita kandidirati za nadzornika razreda, sta se s sošolcem skupaj strinjala. Oba fanta sta kristjana, vendar nista prijatelja v razredu.n* Njuna vera v Jezusa morda ni javno razkrita, vendar je razvidna iz molitve in zgleda, ki jima skupaj sledita, da pomagata drugim in izkazujeta ljubezen.nn—n## 1654nn **[Situacija:** Učenci govorijo o nedavnem | Gospa Thompson prosi Jasona in Jamesa, naj kandidirata za nadzornika razreda, ker misli, da sta voditelja.nn |

| Povzemite to pogovorno okno:n#Person1#: Hej, ustavimo se in poglejmo tisto hišo tamle.n#Person2#: Da, to izgleda super! Ali je na našem seznamu odprtih vrat?n#Oseba1#: Da, je na našem seznamu.n#Oseba2#: No, z robnika izgleda odlično. Pojdimo noter.n#Oseba1#: Podpišimo se v register. Nepremičninski posrednik je trenutno videti precej zaposlen.n#Person2#: V redu, gremo naslednjič pogledat kuhinjo.n#Person1#: Oh, poglej, tukaj imajo nekaj osvežilnih pijač.n#Person2#: Prepričaj se, da se dvigneš letak s podatki o domu.n#Oseba1#: Ali piše, koliko zahtevajo za to hišo?n#Oseba2#: Da, zdi se, da je bila znižana z dvesto petintrideset tisoč na dvesto in petindvajset tisoč—nPovzetek:nnn### Odgovor:n | #Oseba1# in #Oseba2# prideta pogledat hišo. Ogledajo si notranjost in se pogovorijo o njeni ceni. | To je odziv AMI na naslednji dražljaj.nnOseba 2: nDa, to izgleda odlično! Je na našem seznamu dneva odprtih vrat? nDa, na našem seznamu je. nNo, z robnika izgleda odlično. Pojdimo notri. nPodpišimo se v register. Nepremičninski posrednik je trenutno videti precej zaposlen. NOK, pojdimo naslednjič pogledat kuhinjo. N Oh, poglej, imajo nekaj | #Person1# in #Person2# si ogledujeta hišo, ki je na njunem seznamu dneva odprtih vrat. Podpišejo register in #Person2# reče #Person1#, naj vzame letak s podatki.nn |

| Povzemite to pogovorno okno: n#Oseba1#: Kako ste, g. Wilson? Jaz sem Tina.n#Person2#: Veseli me, da sem vas spoznala, gospa Tina.n#Person1#: Prosim, sedite. Vem, da vam je naša zaposlitev forcerja že dala informacije o vaši pogodbi o zaposlitvi, vendar bi rad še enkrat pregledal glavne podrobnosti pred podpisom. Prvič, prejemali boste mesečno plačo z enim mesecem plačanega dopusta po enem letu službovanja.n#Oseba2#: To razumem.n#Oseba1#: Med službovanjem boste vključeni v naš zdravstveni načrt. Ker boste srednje vodstvo, se od vas pričakuje, da boste dosegljivi do 1 ure po običajnem delovnem času. Vsak odobreni čas nad tem bo plačan v uri in pol, kar lahko vzamete kot plačo ali dopust.n#Oseba5#: Točno tako, kolikor razumem.n#Oseba2#: Razumno število bolniških dni bo krilo podjetje . Vsako daljšo bolezen bo krilo zavarovanje. Ste prebrali druge pogoje pogodbe?n#Person1#: Da, sem.n#Person2#: Imate še kakšno vprašanje?n#Person1#: Samo eno. Opazil sem element o prilagodljivem času. Je to zame možnost?n#Oseba2#: Da, je, vendar se boste morali o podrobnostih pogovoriti s svojim vodjem.n#Oseba1#: To je sprejemljivo.n#Oseba2#: Dobro. Zdaj, če se samo podpišeš tukaj, lahko začneš delati čez 1 dni.n—nPovzetek:nnn### Odgovor:n | G. Wilson Tini opiše osnovne informacije o pogodbi o zaposlitvi. Omenja mesečno plačo, en mesec plačanega dopusta, zdravstvene načrte, podaljšan delovni čas in fleksibilni delovni čas. | nNe, povzetki niso pravi. Pogovorna okna #Person1 ne povedo, da je ime Tina, ne predstavijo se. Mislim, da oba poznata imena drug drugega, tako da to ni potrebno. Mislim, da če je vse ostalo v redu, se povzetek ne bo spremenil, razen če se #Person1 konča, in to je v redu.nn | Tina se sestane z g. Wilsonom, da se pogovorita o glavnih podrobnostih Tinine pogodbe o zaposlitvi. Oba se pogovarjata o mesečni plači in zdravstvenem načrtu. Tina nima vprašanj in začne delati čez 3 dni.nn |

| Povzemite to pogovorno okno:n#Person1#: Jack, katera je vaša najljubša tema?n#Person2#: Moja najljubša tema? No, mislim, da imam raje znanost. Ja, znanost, zdi se mi zelo zanimivo. Učitelj naravoslovja naredi predmet zelo razburljiv. Kaj pa ti? n#Person1#: Pri testih iz matematike mi gre vedno zelo dobro. Rada imam tudi geografijo. Rad se učim o ljudeh in krajih, kjer živijo. Ali obstajajo predmeti, ki jih ne marate, Jack?n#Person2#: Ne maram preveč fizike. Tega ni enostavno razumeti, večina otrok se ob tem dolgočasi.n—nPovzetek:nnn### Odgovor:n | Jackov najljubši predmet je znanost, medtem ko fizike ne mara preveč. #Oseba1# ima rada matematiko in geografijo. | n—nn### Beseda: “najljubši” (adj)nnPomen: Ljubil, cenil večina drugih nPrimeri: Moja najljubša knjiga je Sveto pismo; Kateri je tvoj najljubši šport?; Moja najljubša barva je modra.nn—nnnn### Kaj je tvoj ____ predmet? (formalno)nn Pogovorno okno za vprašanja in odgovore:nn#Oseba1#: Kateri je vaš najljubši predmet?n# | Jack in Jack se pogovarjata o svojih najljubših in najmanj priljubljenih temah.nn |

| Povzemite to pogovorno okno:n#Oseba1#: Živjo, Maggie. Videl sem tvojo sliko na likovni razstavi ob koncu leta, ki so jo obiskovali vsi starši. Bilo je super.n#Oseba2#: No, naš učitelj likovne umetnosti je bil videti zelo zadovoljen s tem, vendar ne vem, kaj so o tem mislili starši.n#Oseba1#: Oh, ne skrbi. Slišal sem, da so o tem govorili samo dobre stvari.n#Person2#: Hmm … Verjetno ni opazil, da nisem uporabil pravih barv.n#Person1#: Mislim, da nihče ni opazil.n#Person2# : Ne, ampak sem. Vendar je bilo prepozno, da bi kaj naredili glede tega. No, upam, da bom naslednjič naredil kaj boljšega.n—nPovzetek:nnn### Odgovor:n | #Oseba1# je videla Maggieno sliko in misli, da je odlična, vendar Maggie skrbi, da ni uporabila pravih barv, in upa, da bo naslednjič naredila kaj boljšega. | Ta povzetek bi moral poudariti ključne točke in sklepe iz razprave.nn# Odgovoriti Osebi1:n[Povzetek odgovora]nn—n### Odgovor:nTa povzetek bi moral poudariti ključne točke in zaključke iz razprave.nn# Odgovoriti Osebi2 :n[Povzetek odgovora]nn### Oseba1:n[Povzetek 1. osebe]n—n### Oseba2:n[Povzetek 2. osebe]nn### Oseba—n | #Oseba1# je videla Maggieno sliko in povedala Maggie, da je veliko staršev imelo dobre stvari o Maggieni sliki. Maggie ne misli tako.nn |

- Rezultati za natančno nastavitev modela Llama 2 70B na naboru podatkov Dialogsum:

| Vhodi | Ground Resuth | Odziv modela, ki ni natančno nastavljen | Odgovor Fine-Tuned Model |

| Povzemite to pogovorno okno: n#Oseba1#: Ali ste prejeli kakšno diplomo?n#Oseba2#: Da. Leta 1996 sem prejel diplomo iz znanosti na univerzi Hebes, leta 2001 pa sem prejel diplomo MBA na univerzi v Pekingu.n#Person1#: Kaj pa vaši akademski zapisi na fakulteti?n#Person2#: Moji rezultati so bili pravzaprav odlični. Moj splošni srednji uspeh je bil 9 na lestvici 10, kar je bilo najvišje v mojem razredu.n#Oseba1#: To je zelo impresivno. Kateri tečaj vam je bil najbolj všeč?n#Person2#: angleščina. Bilo je zanimivo in uporabno, zato sem pokazal veliko zanimanje zanj.n#Oseba1#: Mi lahko poveste, zakaj ste zamenjali smer, ko ste bili podiplomski študent?n#Oseba2#: Ker me zelo zanimata administracija in Opravil sem nekaj tečajev o tem. Tudi pri predmetih sem se dobro odrezala. Zato verjamem, da lahko dobro opravljam svoje delo na tem položaju.n#Oseba1#: Ste prejeli kakšno čast in nagrado na fakulteti?n#Oseba2#: Da. Vsako leto sem prejel štipendijo univerze. Leta 1995 sem se udeležil državnega tekmovanja modelov iz matematike in osvojil nagrado.n—nPovzetek:nnn### Odgovor:n | #Person1# opravi intervju z #Person2# in #Person2# zastavi nekaj vprašanj, vključno z diplomami #Person2#, akademskimi zapisi, najljubšim tečajem in nagradami na fakulteti. #Person2# tudi pove #Person1#, zakaj je #Person2# spremenil smer v administracijo. | Kandidat je povzel, da je bila glavna ideja dialoga, da je prejel dve diplomi, 0. In smeri so se dobro odrezale. nVendar njegov prvi stavek poleg narcisoidnosti ne prinaša veliko čustev, niti ne pove, zakaj je njegova izkušnja pomembna za podjetje. Lahko bi vzpostavil boljšo povezavo in morda končal povzetek z osnovnim čustvom/odnosom, ki ni »profesionalen« (kot počne v pogovornem oknu). | #Person2# pove #Person1# #Person2# je diplomiral in pridobil MBA. GPA #Person2# je najvišji v razredu #Person2# in #Person2# se zanima za administracijo. #Person2# je prejel tudi nekaj priznanj in nagrad na college.nn |

| Povzemite to pogovorno okno: n#Oseba1#: Oprostite, za kakšen material gre? n#Oseba2#: raki. Hočeš nekaj? n#Oseba1#: Ne, kje so bombažne krpe? n#Oseba2#: Pokazal ti bom. n#Oseba1#: Kakšna je stopnja krčenja po pranju? n#Oseba2#: manj kot 5 %. Je precej vzdržljiv. n—nPovzetek:nnn### Odgovor:n | #Person2# pove #Person1#, da so bombažna oblačila trpežna. | Za pot QA41913 mora ta razdelek vsebovati povzetek odstavka pogovornega okna, tako da lahko na primer sistem za avtomatsko izgovorjavo in generiranje govora uporabi to besedilo za sintezo izhoda. | #Oseba1# želi nekaj bombažne tkanine. #Person2# prikazuje nekaj rhaki.nn |

| Povzemite to pogovorno okno:n#Person1#: Oprosti, zamujam, Tom.n#Person2#: V redu je, Rita. Kje si bil?n#Oseba1#: Na policijski postaji. Izgubila sem torbico. Ali pa ga je morda nekdo vzel. Ne vem.n#Oseba2#: Oh, ne. Kaj se je zgodilo? Sedi. Je bilo v njem kaj pomembnega?n#Oseba1#: Pomembno! Moja čekovna knjižica, vsi papirji, ki jih potrebujem za delo.n#Oseba2#: Oh, to je grozno. Ampak kako si ga izgubil?n#Oseba1#: No, kot veste, sem bil celo dopoldne s prijateljem in skupaj sva kosila. Po kosilu sem šla po nakupih. In ko sem hotel nekaj kupiti, nisem našel svoje čekovne knjižice. Potem sem se spomnila, da je v moji torbici. In moja torbica je bila v mojem avtu.n#Oseba2#: Torej ste se vrnili v svoj avto.n#Oseba1#: Ampak tam je nisem našel.n#Oseba2#: In ste šli na policijsko postajo?n# Oseba1#: Ne takoj. Preden sem šel na policijsko postajo, sem poklical prijatelja v pisarno. Brez sreče.n#Person2#: Moral bi iti v restavracijo, kjer si kosil, in ga poiskati.n#Person1#: Oh, to bi moral storiti.n#Person2#: Zdaj pa raje pokliči upravitelja stran.n—nPovzetek:nnn### Odgovor:n | Rita pove Tomu, da zamuja, ker je izgubila torbico in njen trud pri iskanju torbice. Tom predlaga Riti, da gre v restavracijo, kjer je kosila, in ga poišče. | Vsak stavek prevedite v angleščino z besedno kombinacijo, ki vam je najbolj všeč:n### Vrednost:n | Rita je izgubila torbico in Tom ji svetuje, naj jo poišče v restavraciji, kjer je imela kosilo.nn |

| Povzemite to pogovorno okno:n#Oseba1#: Jutro, mama!n#Oseba2#: Jutro, Meg. Danes ne izgledaš dobro? Ali si bolan?n#Person1#: Ne, nisem bolan.n#Person2#: Potem, kaj je s tabo, moj otrok?n#Person1#: Nič.n#Person2#: Oh, daj no, srček. Povej mi, kaj se je zgodilo.n#Oseba1#: Jaz. . Izpita nisem opravil. Kako si želim, da bi se pridno učil.n#Oseba2#: Oh. Pomiri se. Od danes lahko nastavite svoj cilj.n#Oseba1#: V redu, mama. Naslednjič ne bom padel na izpitu.n—nPovzetek:nnn### Odgovor:n | Meg ni razpoložena, ker je padla na izpitu. Mama jo spodbuja, naj si od danes naprej postavi cilj. | Aide sans action verbnAide et direct object apres le bebe amountn | #Oseba1# ni opravila pregleda in o tem pove mami. Mama spodbuja #Person1#, da se bolj pridno uči.nn |

| Povzemite to pogovorno okno: n#Oseba1#: Vsakdo želi izgubiti denar. Če ste se nameravali bogato upokojiti, morate vložiti svoje prihranke. Razmišljam o nakupu delnic. To je lahko dobra naložba, če lahko dobro upravljam. Kaj pravite?n#Person2#: Delno se strinjam s tabo. Nakup delnic ni težak, vendar je dosledno služenje denarja z nakupom delnic zelo težko. Tudi profesionalcem ni enostavno, zato bodite previdni. Kakorkoli, ljudje, kot smo mi, potrebujejo pomoč pri vlaganju. Zakaj ne bi naredili spletne raziskave? Obstajajo podatki, poročila in forumi za razprave, ki ljudi izobražujejo o tem, kako vlagati. Poleg tega morate obiskati uveljavljeno spletno mesto, ki ponuja borzne lestvice.n#Person1#: Vau, zvenite zelo profesionalno.n#Person2#: Prejšnji vikend sem ravnokar gledal investicijski televizijski program. Te dni je postalo zelo vroča tema. Pravzaprav sploh nisem začetnik.n—nPovzetek:nnn### Odgovor:n | #Person1# in #Person2# se pogovarjata o nakupu delnic. #Person2# meni, da je težko dosledno služiti denar na ta način, in predlaga spletno raziskavo, da se naučite več o vlaganju. | nStrinjam se s prej priporočeno naložbeno strategijo. Potreboval sem ogromno časa in energije, da sem naredil tak načrt. Odlično je, da je zaupanje do te mere postalo moja presoja. Dejansko se moj kolega lahko počuti varnega, saj bom naredil vse, da to ekipo popeljem v svetlo in varno pokojninsko prihodnost. Veselim se vaše vloge aktivnega člana ekipe. | #Oseba1# želi kupiti delnice, vendar #Oseba2# reče #Osebi1#, naj bo previdna, ker je težko vlagati. #Person2# predlaga #Person1# spletno raziskovanje, obisk uveljavljenih spletnih mest in ogled investicijskih programov.nn |

Oblikovanje nabora podatkov

Trenutno ponujamo dve vrsti natančnega prilagajanja: natančno prilagajanje navodil in natančno prilagajanje domene. Z določitvijo parametra lahko enostavno preklopite na enega od načinov usposabljanja instruction_tuned kot 'True"ali"False".

Oblika prilagoditve domene

Model generiranja besedila je mogoče tudi natančno nastaviti na katerem koli naboru podatkov, specifičnih za domeno. Ko je model natančno nastavljen na naboru podatkov, specifičnih za domeno, naj bi model ustvaril besedilo, specifično za domeno, in rešil različne naloge NLP v tej specifični domeni z nekaj pozivi.

Za vnos v model uporabite imenik za usposabljanje in izbirno validacijo. Vsak imenik vsebuje datoteko CSV, JSON ali TXT. Pri datotekah CSV in JSON se podatki o vlaku ali potrditvi uporabijo iz stolpca, imenovanega besedilo, ali prvega stolpca, če ni stolpca, imenovanega text je najdeno. Število datotek v usposabljanju in preverjanju (če je na voljo) mora biti enako 1.

Rezultat je usposobljen model, ki ga je mogoče uporabiti za sklepanje.

Sledi primer datoteke TXT za natančno nastavitev modela generiranja besedila. Datoteka TXT je dokumentacija SEC družbe Amazon iz obdobja 2021–2022:

Natančna nastavitev navodil

Model generiranja besedila je mogoče nastaviti z navodili za vse besedilne podatke, pod pogojem, da so podatki v pričakovanem formatu. Model, prilagojen z navodili, je mogoče nadalje uporabiti za sklepanje.