Zaznavanje pristranskosti v podatkih in rezultatih modelov je temeljna zahteva za gradnjo odgovornih modelov umetne inteligence (AI) in strojnega učenja (ML). Na žalost odkrivanje pristranskosti ni lahka naloga za veliko večino zdravnikov zaradi velikega števila načinov, na katere jo je mogoče izmeriti, in različnih dejavnikov, ki lahko prispevajo k pristranskemu rezultatu. Na primer, neuravnoteženo vzorčenje podatkov o usposabljanju lahko povzroči model, ki je manj natančen za nekatere podnabore podatkov. Pristranskost lahko povzroči tudi sam algoritem ML – celo z dobro uravnoteženim naborom podatkov o usposabljanju lahko rezultati dajejo prednost določenim podmnožicam podatkov v primerjavi z drugimi.

Če želite odkriti pristranskost, morate temeljito razumeti različne vrste pristranskosti in pripadajoče metrike pristranskosti. Na primer, v času tega pisanja, Amazon SageMaker Pojasni ponuja 21 različnih meritev, med katerimi lahko izbirate.

V tej objavi uporabljamo primer uporabe napovedi dohodka (napovedovanje dohodkov uporabnikov na podlagi vhodnih funkcij, kot sta izobrazba in število opravljenih ur na teden), da prikažemo različne vrste pristranskosti in ustrezne meritve v SageMaker Clarify. Razvijamo tudi okvir, ki vam pomaga pri odločitvi, katere metrike so pomembne za vašo aplikacijo.

Uvod v SageMaker Clarify

Modeli ML se vse bolj uporabljajo za pomoč pri sprejemanju odločitev na različnih področjih, kot so finančne storitve, zdravstvo, izobraževanje in človeški viri. V mnogih situacijah je pomembno razumeti, zakaj je model ML podal določeno napoved in tudi, ali je na napovedi vplivala pristranskost.

SageMaker Clarify nudi orodja za obe od teh potreb, vendar se v tej objavi osredotočamo le na funkcionalnost zaznavanja pristranskosti. Če želite izvedeti več o razložljivosti, si oglejte Pojasnitev dejstev o ujemanju Bundeslige xGoals z uporabo Amazon SageMaker Clarify.

SageMaker Clarify je del Amazon SageMaker, ki je v celoti upravljana storitev za izdelavo, usposabljanje in uvajanje modelov ML.

Primeri vprašanj o pristranskosti

Za utemeljitev razprave je v nadaljevanju nekaj vzorčnih vprašanj, ki jih graditelji ML in njihovi deležniki morda imajo glede pristranskosti. Seznam vsebuje nekaj splošnih vprašanj, ki so lahko pomembna za več aplikacij ML, pa tudi vprašanj o posebnih aplikacijah, kot je iskanje dokumentov.

Glede na skupine, ki jih zanimajo podatki o usposabljanju (na primer moški v primerjavi z ženskami), se lahko vprašate, katere meritve naj uporabim za odgovor na naslednja vprašanja:

- Ali zastopanost skupine v podatkih o usposabljanju odraža resnični svet?

- Ali ciljne oznake v podatkih o usposabljanju dajejo prednost eni skupini pred drugo, tako da ji dodelijo več pozitivnih oznak?

- Ali ima model različno natančnost za različne skupine?

- Ali ima model v modelu, katerega namen je identificirati kvalificirane kandidate za zaposlitev, enako natančnost za različne skupine?

- Ali v modelu, katerega namen je pridobiti dokumente, pomembne za vhodno poizvedbo, model pridobi ustrezne dokumente iz različnih skupin v enakem razmerju?

V nadaljevanju te objave razvijamo okvir za to, kako razmisliti o odgovorih na ta in druga vprašanja z meritvami, ki so na voljo v SageMaker Clarify.

Primer uporabe in kontekst

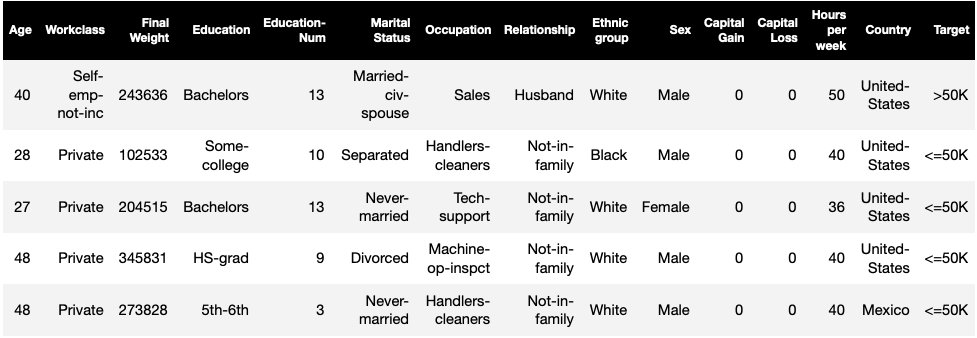

Ta objava uporablja obstoječi primer opravila SageMaker Clarify iz Pravičnost in razložljivost z zvezkom SageMaker Clarify in pojasnjuje ustvarjene metrične vrednosti pristranskosti. Prenosnik usposablja model XGBoost na Nabor podatkov UCI za odrasle (Dua, D. in Graff, C. (2019). UCI Repozitorij strojnega učenja. Irvine, CA: Univerza v Kaliforniji, Šola za informacije in računalništvo).

Naloga ML v tem naboru podatkov je napovedati, ali ima oseba letni dohodek več ali manj kot 50,000 USD. Naslednja tabela prikazuje nekatere primere skupaj z njihovimi funkcijami. Merjenje pristranskosti pri napovedi dohodka je pomembno, saj bi te napovedi lahko uporabili za obveščanje o odločitvah, kot so ponudbe s popusti in ciljno trženje.

Pristranska terminologija

Preden se poglobimo, si oglejmo nekaj bistvenih izrazov. Za celoten seznam izrazov glejte Amazon SageMaker pojasnjuje pogoje za pristranskost in pravičnost.

- label – Ciljna značilnost, ki jo je model ML usposobljen predvideti. An opažena oznaka se nanaša na vrednost oznake, opaženo v podatkih, uporabljenih za usposabljanje ali testiranje modela. A napovedana oznaka je vrednost, ki jo napoveduje model ML. Oznake so lahko binarne in so pogosto kodirane kot 0 in 1. Predvidevamo, da 1 predstavlja ugodno ali pozitivno oznako (na primer dohodek večji ali enak 50,000 USD), 0 pa predstavlja neugodno ali negativno oznako. Oznake so lahko sestavljene tudi iz več kot dveh vrednosti. Tudi v teh primerih ena ali več vrednosti predstavlja ugodne oznake. Zaradi enostavnosti ta objava obravnava samo binarne oznake. Za podrobnosti o ravnanju z oznakami z več kot dvema vrednostma in oznakami z zveznimi vrednostmi (na primer v regresiji) glejte Amazon AI pravičnost in razložljivost.

- Faseta – Stolpec ali značilnost, glede na katero se meri pristranskost. V našem primeru je faseta

sexin ima dve vrednosti:womaninman, kodirano kotfemaleinmalev podatkih (ti podatki so izvlečeni iz popisa iz leta 1994 in uveljavljajo binarno možnost). Čeprav objava obravnava eno faseto z le dvema vrednostma, za bolj zapletene primere, ki vključujejo več faset ali faset z več kot dvema vrednostma, glejte Amazon AI pravičnost in razložljivost. - Pristranskost – Znatno neravnovesje v vhodnih podatkih ali napovedih modela v različnih fasetnih vrednostih. Kaj je "pomembno", je odvisno od vaše prijave. Za večino meritev vrednost 0 ne pomeni neravnovesja. Meritve pristranskosti v SageMaker Clarify so razdeljene v dve kategoriji:

- Predusposabljanje – Če je pristranskost pred vadbo prisotna, kaže samo na neravnovesja v podatkih.

- Posttraining – Pristranskost po treningu dodatno upošteva napovedi modelov.

Oglejmo si vsako kategorijo posebej.

Pristranskost pred treningom

Meritve pristranskosti pred usposabljanjem v SageMaker Clarify odgovarjajo na naslednje vprašanje: Ali imajo vse vrednosti faset enako (ali podobno) zastopanost v podatkih? Pomembno je pregledati podatke za pristranskost pred treningom, ker se lahko prevede v pristranskost po treningu v napovedih modela. Na primer, model, ki je naučen na neuravnoteženih podatkih, kjer se ena fasetna vrednost pojavi zelo redko, lahko kaže bistveno slabšo natančnost za to fasetno vrednost. Enako zastopanost je mogoče izračunati glede na naslednje:

- Celotni podatki o usposabljanju ne glede na oznake

- Podnabor podatkov o usposabljanju samo s pozitivnimi oznakami

- Vsaka etiketa posebej

Naslednja slika prikazuje povzetek, kako posamezna metrika ustreza vsaki od treh kategorij.

Nekatere kategorije so sestavljene iz več kot ene meritve. Osnovne metrike (siva polja) na najpreprostejši način odgovarjajo na vprašanje o pristranskosti v tej kategoriji. Meritve v belih poljih dodatno pokrivajo posebne primere (na primer Simpsonov paradoks) in uporabniške nastavitve (na primer osredotočanje na določene dele populacije pri izračunu napovedne uspešnosti).

Predstavitev vrednosti faset ne glede na oznake

Edina metrika v tej kategoriji je neravnovesje razreda (CI). Cilj te metrike je izmeriti, ali so vse vrednosti faset enako zastopane v podatkih.

CI je razlika v deležu podatkov, ki jih sestavljata dve fasetni vrednosti. V našem primeru nabora podatkov za faseto sex, razčlenitev (prikazana v tortnem grafikonu) kaže, da ženske predstavljajo 32.4 % podatkov o usposabljanju, medtem ko moški predstavljajo 67.6 %. Kot rezultat:

CI = 0.676 - 0.324 = 0.352

Zelo visoko neravnovesje razreda bi lahko privedlo do slabše napovedne uspešnosti za fasetno vrednost z manjšo zastopanostjo.

Predstavitev vrednosti faset samo na ravni pozitivnih oznak

Drug način za merjenje enake zastopanosti je preverjanje, ali vse vrednosti faset vsebujejo podoben delež vzorcev s pozitivnimi opazovanimi oznakami. Pozitivne oznake so sestavljene iz ugodnih rezultatov (na primer odobreno posojilo, izbran za službo), zato ločena analiza pozitivnih oznak pomaga oceniti, ali so ugodne odločitve enakomerno porazdeljene.

V našem vzorčnem naboru podatkov so opazovane oznake razdeljene na pozitivne in negativne vrednosti, kot je prikazano na naslednji sliki.

11.4 % vseh žensk in 31.4 % vseh moških ima pozitivno oznako (temno osenčeno območje v levi in desni vrstici). Razlika v pozitivnih deležih nalepk (DPL) meri to razliko.

DPL = 0.314 - 0.114 = 0.20

Napredna metrika v tej kategoriji, pogojna demografska razlika v oznakah (CDDL), meri razlike v pozitivnih oznakah, vendar jih stratificira glede na drugo spremenljivko. Ta metrika pomaga nadzorovati za Simpsonov paradoks, primer, ko izračun nad celotnimi podatki pokaže pristranskost, vendar pristranskost izgine pri združevanju podatkov glede na nekatere stranske informacije.

O 1973 Študija o sprejemu na UC Berkeley daje primer. Po podatkih so bili moški sprejeti v višji stopnji kot ženske. Na ravni posameznih oddelkov univerze pa so bile ženske sprejete v enakem ali višjem deležu na vsakem oddelku. To opažanje je mogoče pojasniti s Simpsonovim paradoksom, ki je tukaj nastal, ker so se ženske prijavljale na šole, ki so bile bolj konkurenčne. Posledično je bilo na splošno sprejetih manj žensk kot moških, čeprav so bile od šole do šole sprejete s podobno ali višjo stopnjo.

Za več podrobnosti o tem, kako se izračuna CDDL, glejte Amazon AI pravičnost in razložljivost.

Predstavitev vrednosti faset na ravni vsake oznake posebej

Enakost v zastopanosti se lahko meri tudi za vsako posamezno oznako, ne le za pozitivno oznako.

Meritve v tej kategoriji izračunajo razliko v porazdelitvi oznak različnih vrednosti faset. Porazdelitev oznake za vrednost fasete vsebuje vse opažene vrednosti oznake, skupaj z deležem vzorcev z vrednostjo te oznake. Na primer, na sliki, ki prikazuje porazdelitev oznak, ima 88.6 % žensk negativno opazovano oznako in 11.4 % pozitivno opazovano oznako. Tako je porazdelitev oznak za ženske [0.886, 0.114] in za moške [0.686, 0.314].

Osnovna metrika v tej kategoriji, Kullback-Leiblerjeva divergenca (KL), meri to razliko kot:

KL = [0.686 x log(0.686/0.886)] + [0.314 x log(0.314/0.114)] = 0.143

Napredne metrike v tej kategoriji, Jensen-Shannonova divergenca (JS), Lp-norma (LP), Total Variation Distance (TVD) in Kolmogorov-Smirnov (KS), prav tako merijo razliko med porazdelitvami, vendar imajo drugačne matematične lastnosti. Razen v posebnih primerih bodo zagotovili vpoglede, podobne KL. Čeprav je na primer vrednost KL lahko neskončna, ko vrednost fasete ne vsebuje vzorcev z določenimi oznakami (na primer ni moških z negativno oznako), se JS izogiba tem neskončnim vrednostim. Za več podrobnosti o teh razlikah glejte Amazon AI pravičnost in razložljivost.

Razmerje med DPL (kategorija 2) in meritvami, ki temeljijo na distribuciji KL/JS/LP/TVD/KS (kategorija 3)

Meritve, ki temeljijo na distribuciji, so bolj naravno uporabne za nebinarne oznake. Za binarne oznake zaradi dejstva, da se neravnovesje v pozitivni oznaki lahko uporabi za izračun neravnovesja v negativni oznaki, meritve distribucije zagotavljajo enake vpoglede kot DPL. Zato lahko v takih primerih uporabite samo DPL.

Pristranskost po treningu

Meritve pristranskosti po treningu v SageMaker Clarify nam pomagajo odgovoriti na dve ključni vprašanji:

- Ali so vse vrednosti faset predstavljene s podobno stopnjo v pozitivnih (ugodnih) napovedih modela?

- Ali ima model podobno napovedno zmogljivost za vse vrednosti faset?

Naslednja slika prikazuje, kako se meritve preslikajo na vsako od teh vprašanj. Drugo vprašanje je mogoče nadalje razčleniti glede na to, za katero oznako se meri uspešnost.

Enaka zastopanost v napovedih pozitivnega modela

Meritve v tej kategoriji preverjajo, ali vse vrednosti faset vsebujejo podoben delež vzorcev s pozitivno napovedano oznako po modelu. Ta razred metrik je zelo podoben metrikam pred usposabljanjem DPL in CDDL – razlika je le v tem, da ta kategorija upošteva predvidene oznake namesto opazovanih oznak.

V našem vzorčnem naboru podatkov je model 4.5 % vseh žensk pripisal pozitivno oznako, 13.7 % vseh moških pa pozitivno oznako.

Osnovna metrika v tej kategoriji, razlika v pozitivnih deležih v predvidenih oznakah (DPPL), meri razliko v pozitivnih dodelitvah razredov.

DPPL = 0.137 - 0.045 = 0.092

Opazite, kako je v podatkih o usposabljanju večji delež moških imel pozitivno opazovano oznako. Na podoben način je večjemu deležu moških dodeljena pozitivna napovedana oznaka.

Če nadaljujemo z naprednimi metrikami v tej kategoriji, Disparate Impact (DI) meri enako razliko v pozitivnih dodelitvah razredov, vendar namesto razlike izračuna razmerje:

DI = 0.045 / 0.137 = 0.328

Tako DI kot DPPL podajata kvalitativno podobna spoznanja, vendar se v nekaterih vogalih razlikujeta. Na primer, razmerja ponavadi eksplodirajo do zelo velikih številk, če je imenovalec majhen. Vzemimo za primer številki 0.1 in 0.0001. Razmerje je 0.1/0.0001 = 10,000, medtem ko je razlika 0.1 – 0.0001 ≈ 0.1. Za razliko od drugih metrik, pri katerih vrednost 0 ne pomeni pristranskosti, za DI nobena pristranskost ustreza vrednosti 1.

Pogojno demografsko neskladje v predvidenih oznakah (CDDPL) meri neskladje v predstavitvi vrednosti faset v pozitivni oznaki, vendar tako kot metrika pred usposabljanjem CDDL tudi nadzoruje Simpsonov paradoks.

Counterfactual Fliptest (FT) meri, ali podobni vzorci iz dveh fasetnih vrednosti prejmejo podobne odločitve modela. Model, ki dodeljuje različne odločitve dvema vzorcema, ki sta si med seboj podobna, a se razlikujeta v vrednostih faset, bi lahko veljal za pristranskega proti vrednosti fasete, ki bi bila dodeljena neugodni (negativni) oznaki. Glede na prvo fasetno vrednost (ženske) oceni, ali imajo podobni člani z drugo fasetno vrednostjo (moški) drugačno napoved modela. Podobni člani so izbrani na podlagi algoritma k-najbližjega soseda.

Enaka zmogljivost

Napovedi modela imajo lahko podobno zastopanost v pozitivnih oznakah iz različnih fasetnih vrednosti, vendar se lahko uspešnost modela v teh skupinah bistveno razlikuje. V mnogih aplikacijah je lahko zaželena podobna napovedna zmogljivost v različnih fasetnih vrednostih. Meritve v tej kategoriji merijo razliko v napovedni uspešnosti med vrednostmi faset.

Ker je podatke mogoče razrezati na veliko različnih načinov na podlagi opazovanih ali predvidenih oznak, obstaja veliko različnih načinov za merjenje napovedne uspešnosti.

Enaka napovedna zmogljivost ne glede na oznake

Učinkovitost modela lahko upoštevate na celotnih podatkih, ne glede na opazovane ali predvidene oznake – to je splošna natančnost.

Naslednje slike prikazujejo, kako model razvršča vnose iz dveh fasetnih vrednosti v našem primeru nabora podatkov. Resnično negativni (TN) so primeri, kjer sta bili tako opazovana kot predvidena oznaka 0. Lažno pozitivni (FP) so napačne razvrstitve, kjer je bila opazovana oznaka 0, predvidena oznaka pa 1. Resnično pozitivni (TP) in lažno negativni (FN) so opredeljeni podobno.

|

|

Za vsako fasetno vrednost je skupna zmogljivost modela, to je natančnost te fasetne vrednosti:

natančnost = (TN + TP🇧🇷TN + FP + FN + TP)

S to formulo je natančnost za ženske 0.930 in za moške 0.815. To vodi do edine meritve v tej kategoriji, razlike v točnosti (AD):

AD = 0.815 - 0.930 = -0.115

AD = 0 pomeni, da je natančnost za obe skupini enaka. Večje (pozitivne ali negativne) vrednosti pomenijo večje razlike v točnosti.

Enaka učinkovitost samo na pozitivnih etiketah

Analizo delovanja modela lahko omejite samo na pozitivne oznake. Na primer, če se aplikacija nanaša na odkrivanje napak na tekočem traku, je morda zaželeno preveriti, ali so deli brez napak (pozitivna nalepka) različnih vrst (vrednosti faset) razvrščeni kot brez napak z enako stopnjo. Ta količina se imenuje odpoklic ali prava pozitivna stopnja:

Recall = TP / (TP + FN)

V našem primeru nabora podatkov je priklic za ženske 0.389, priklic za moške pa 0.425. To vodi do osnovne metrike v tej kategoriji, razlike v priklicu (RD):

RD = 0.425 - 0.389 = 0.036

Zdaj pa si oglejmo tri napredne metrike v tej kategoriji, poglejmo, katere uporabniške nastavitve kodirajo in kako se razlikujejo od osnovne metrike RD.

Prvič, namesto da bi merili uspešnost na pozitivnih opazovanih oznakah, jo lahko meriš na pozitivnih napovedanih oznakah. Glede na fasetno vrednost, kot so ženske, in vse vzorce s to fasetno vrednostjo, za katere model predvideva, da bodo pozitivni, koliko jih je dejansko pravilno razvrščenih kot pozitivnih? Ta količina se imenuje stopnja sprejemljivosti (AR) ali natančnost:

AR = TP / (TP + FP)

V našem primeru je AR za ženske 0.977, AR za moške pa 0.970. To vodi do razlike v stopnji sprejemljivosti (DAR):

DAR = 0.970 - 0.977 = -0.007

Drug način za merjenje pristranskosti je z združevanjem prejšnjih dveh metrik in merjenjem, koliko več pozitivnih napovedi modeli dodelijo vrednosti vidika v primerjavi z opazovanimi pozitivnimi oznakami. SageMaker Clarify meri to prednost z modelom kot razmerje med številom opazovanih pozitivnih oznak za to fasetno vrednost in številom predvidenih pozitivnih oznak ter jo imenuje pogojno sprejemanje (CA):

CA = (TP + FN🇧🇷TP + FP)

V našem primeru je CA za ženske 2.510, za moške pa 2.283. Razlika v CA vodi do končne metrike v tej kategoriji, razlike v pogojnem sprejemu (DCA):

DCA = 2.283 - 2.510 = -0.227

Enaka uspešnost samo na negativnih etiketah

Na podoben način kot pri pozitivnih oznakah se lahko pristranskost izračuna tudi kot razlika v uspešnosti negativnih etiket. Ločeno upoštevanje negativnih oznak je lahko pomembno v nekaterih aplikacijah. Na primer, v našem primeru odkrivanja napak bi morda želeli odkriti okvarjene dele (negativna oznaka) različnih vrst (vrednost fasete) z enako hitrostjo.

Osnovna metrika v tej kategoriji, specifičnost, je analogna metriki priklica (resnične pozitivne stopnje). Specifičnost izračuna natančnost modela na vzorcih s to fasetno vrednostjo, ki imajo opaženo negativno oznako:

Specifičnost = TN / (TN + FP)

V našem primeru (glejte tabele zmede) je specifičnost za ženske in moške 0.999 oziroma 0.994. Posledično je Specifičnost Razlika (SD) je:

SD = 0.994 - 0.999 = -0.005

Če gremo naprej, tako kot metrika stopnje sprejemljivosti, je analogna količina za negativne oznake – stopnja zavrnitve (RR) –:

RR = TN / (TN + FN)

RR za ženske je 0.927 in za moške 0.791, kar vodi do metrike razlike v stopnji zavrnitve (DRR):

DRR = 0.927 - 0.791 = -0.136

Nazadnje, analog negativne oznake pogojnega sprejemanja, pogojna zavrnitev (CR), je razmerje med številom opazovanih negativnih oznak za to fasetno vrednost in številom predvidenih negativnih oznak:

CR = (TN + FP🇧🇷TN + FN)

CR za ženske je 0.928, za moške pa 0.796. Zadnja metrika v tej kategoriji je razlika v pogojni zavrnitvi (DCR):

DCR = 0.796 - 0.928 = 0.132

Enaka uspešnost na pozitivnih in negativnih etiketah

SageMaker Clarify združuje prejšnji dve kategoriji z upoštevanjem razmerja zmogljivosti modela na pozitivnih in negativnih oznakah. Natančneje, za vsako fasetno vrednost SageMaker Clarify izračuna razmerje med lažno negativnimi (FN) in lažno pozitivnimi (FP). V našem primeru je razmerje FN/FP za ženske 679/10 = 67.9, za moške pa 3678/84 = 43.786. To vodi do metrike enakosti obravnave (TE), ki meri razliko med razmerjem FP/FN:

TE = 67.9 - 43.786 = 24.114

Naslednji posnetek zaslona prikazuje, kako lahko uporabljate SageMaker Clarify z Amazon SageMaker Studio za prikaz vrednosti ter obsegov in kratkih opisov različnih metrik pristranskosti.

Vprašanja o pristranskosti: s katerimi metrikami začeti?

Spomnite se vzorčnih vprašanj o pristranskosti na začetku te objave. Ko ste pregledali meritve iz različnih kategorij, ponovno razmislite o vprašanjih. Za odgovor na prvo vprašanje, ki se nanaša na predstavitve različnih skupin v podatkih o usposabljanju, bi lahko začeli z metriko neravnovesja razreda (CI). Podobno lahko za preostala vprašanja začnete tako, da preučite razliko v pozitivnih deležih nalepk (DPL), razliko v natančnosti (AD), razliko v stopnji sprejemljivosti (DAR) in razliko v priklicu (RD).

Pristranskost brez fasetnih vrednosti

Za lažjo razlago je ta opis metrik po treningu izključil metriko generaliziranega entropijskega indeksa (GE). Ta metrika meri pristranskost brez upoštevanja fasetne vrednosti in je lahko v pomoč pri ocenjevanju porazdelitve napak modela. Za podrobnosti glejte Generalizirana entropija (GE).

zaključek

V tej objavi ste videli, kako 21 različnih metrik v SageMaker Clarify meri pristranskost na različnih stopnjah cevovoda ML. Naučili ste se o različnih metrikah prek primera uporabe napovedi dohodka, kako izbrati metrike za svoj primer uporabe in s katerimi bi lahko začeli.

Začnite svojo odgovorno pot AI z ocenjevanjem pristranskosti v svojih modelih ML z uporabo predstavitvenega zvezka Pravičnost in razložljivost s SageMaker Clarify. Podrobno dokumentacijo za SageMaker Clarify, vključno s formalno definicijo meritev, najdete na Kaj je pravičnost in razložljivost modela za napovedi strojnega učenja. Za odprtokodno izvedbo metrike pristranskosti glejte aws-sagemaker-clarify repozitorij GitHub. Za podrobno razpravo, vključno z omejitvami, glejte Amazon AI pravičnost in razložljivost.

O avtorjih

Bilal Zafar je uporabni znanstvenik pri AWS, ki se ukvarja s poštenostjo, razložljivostjo in varnostjo v strojnem učenju.

Bilal Zafar je uporabni znanstvenik pri AWS, ki se ukvarja s poštenostjo, razložljivostjo in varnostjo v strojnem učenju.

Denis V. Batalov je arhitekt rešitev za AWS, specializiran za strojno učenje. Pri Amazonu je zaposlen od leta 2005. Denis je doktoriral na področju AI. Sledite mu na Twitterju: @dbatalov.

Michele Donini je višja uporabna znanstvenica pri AWS. Vodi skupino znanstvenikov, ki se ukvarjajo z odgovorno umetno inteligenco, njegovi raziskovalni interesi pa so pravičnost algoritmov in razložljivo strojno učenje.

Michele Donini je višja uporabna znanstvenica pri AWS. Vodi skupino znanstvenikov, ki se ukvarjajo z odgovorno umetno inteligenco, njegovi raziskovalni interesi pa so pravičnost algoritmov in razložljivo strojno učenje.

- AI

- ai art

- ai art generator

- imajo robota

- Amazon SageMaker

- Umetna inteligenca

- certificiranje umetne inteligence

- umetna inteligenca v bančništvu

- robot z umetno inteligenco

- roboti z umetno inteligenco

- programska oprema za umetno inteligenco

- Strojno učenje AWS

- blockchain

- blockchain konferenca ai

- coingenius

- pogovorna umetna inteligenca

- kripto konferenca ai

- dall's

- globoko učenje

- strojno učenje

- platon

- platon ai

- Platonova podatkovna inteligenca

- Igra Platon

- PlatoData

- platogaming

- lestvica ai

- sintaksa

- zefirnet