Umetna inteligenca (AI) has created a furor recently with its possibility to revolutionize how people approach and solve different tasks and complex problems. From healthcare to finance, AI and its associated machine-learning models have demonstrated their potential to streamline intricate processes, enhance decision-making patterns and uncover valuable insights.

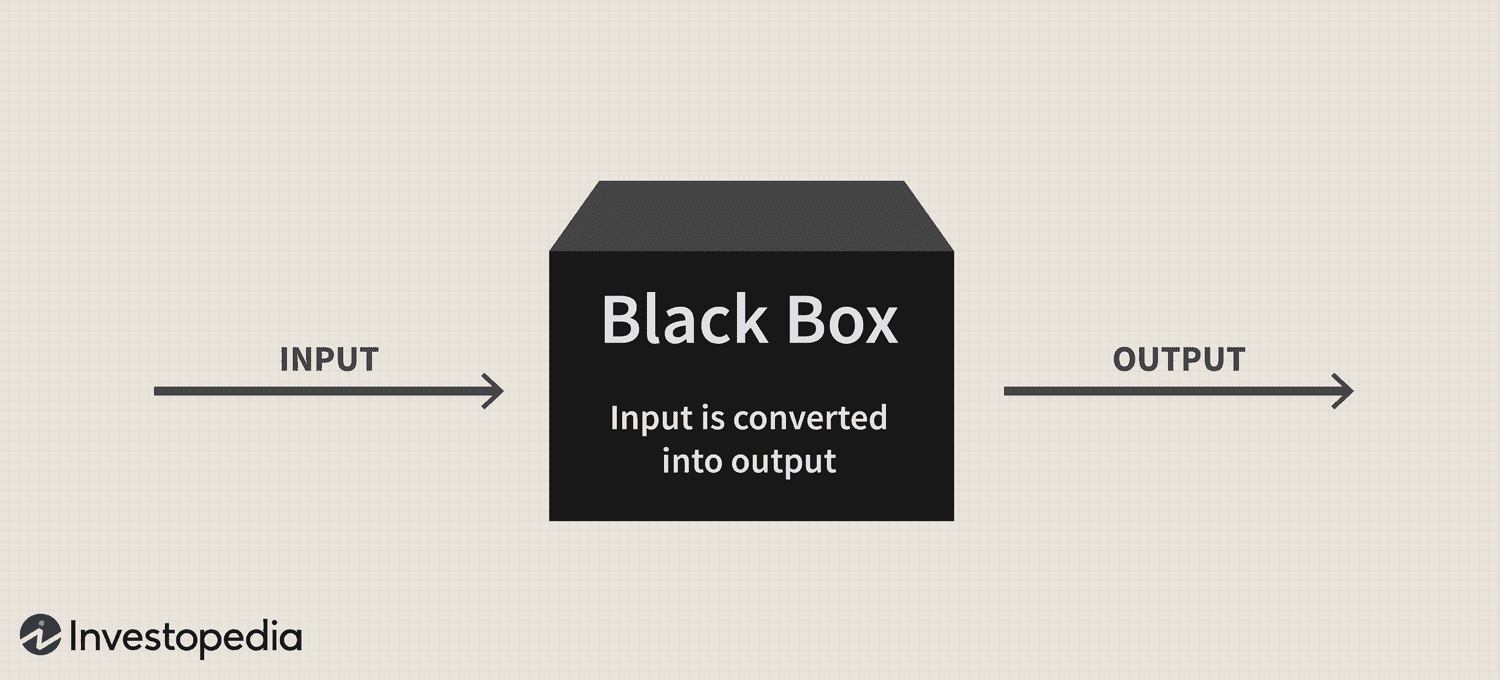

Vendar kljub ogromnemu potencialu tehnologije dolgotrajni problem "črne skrinjice" še naprej predstavlja pomemben izziv za njeno sprejetje, kar postavlja vprašanja o preglednosti in razlagi teh sofisticiranih sistemov.

Na kratko, problem črne skrinjice izhaja iz težav pri razumevanju, kako sistemi AI in modeli strojnega učenja obdelujejo podatke in ustvarjajo napovedi ali odločitve. Ti modeli se pogosto zanašajo na zapletene algoritme, ki ljudem niso zlahka razumljivi, kar vodi v pomanjkanje odgovornosti in zaupanja.

Ker se umetna inteligenca vse bolj vključuje v različne vidike našega življenja, je reševanje tega problema ključnega pomena za zagotavljanje odgovorne in etične uporabe te zmogljive tehnologije.

Črna skrinjica: pregled

Metafora »črne skrinjice« izhaja iz ideje, da sistemi AI in modeli strojnega učenja delujejo na način, ki je skrit pred človeškim razumevanjem, podobno kot vsebina zapečatene, neprozorne škatle. Ti sistemi so zgrajeni na kompleksnih matematičnih modelih in visokodimenzionalnih nizih podatkov, ki ustvarjajo zapletene odnose in vzorce, ki vodijo njihove procese odločanja. Vendar to notranje delovanje ljudem ni lahko dostopno ali razumljivo.

V praktičnem smislu je problem črne skrinjice AI težava pri razvozlavanju razlogov za napovedi ali odločitve sistema AI. Ta težava je še posebej razširjena v modelih globokega učenja, kot so nevronske mreže, kjer več plasti medsebojno povezanih vozlišč obdeluje in preoblikuje podatke na hierarhični način. Zaradi zapletenosti teh modelov in nelinearnih transformacij, ki jih izvajajo, je izredno težko izslediti razloge za njihove rezultate.

Nikita Brudnov, izvršni direktor skupine BR – nadzorne plošče trženjske analitike, ki temelji na umetni inteligenci – je za Cointelegraph povedal, da je lahko pomanjkanje preglednosti v tem, kako modeli umetne inteligence pridejo do določenih odločitev in napovedi, problematično v številnih kontekstih, kot so medicinska diagnoza, finančno odločanje in sodnih postopkov, ki bistveno vplivajo na nadaljnje sprejemanje umetne inteligence.

Revija: Joe Lubin: Resnica o razdelitvi ustanoviteljev ETH in "Crypto Google"

"V zadnjih letih je bilo veliko pozornosti namenjene razvoju tehnik za interpretacijo in razlago odločitev, ki jih sprejmejo modeli AI, kot je ustvarjanje rezultatov pomembnosti funkcij, vizualizacija meja odločitev in prepoznavanje nasprotnih hipotetičnih razlag," je dejal in dodal:

"Vendar so te tehnike še vedno v povojih in ni nobenega zagotovila, da bodo učinkovite v vseh primerih."

Brudnov nadalje verjame, da bodo regulatorji z nadaljnjo decentralizacijo morda zahtevali, da bodo odločitve, ki jih sprejmejo sistemi umetne inteligence, bolj pregledne in odgovorne, da se zagotovi njihova etična veljavnost in splošna poštenost. Predlagal je tudi, da bi lahko potrošniki oklevali pri uporabi izdelkov in storitev, ki jih poganja AI, če ne razumejo, kako delujejo in njihovega postopka odločanja.

James Wo, ustanovitelj DFG – investicijskega podjetja, ki aktivno vlaga v tehnologije, povezane z umetno inteligenco – meni, da vprašanje črne skrinjice ne bo vplivalo na sprejetje v bližnji prihodnosti. Po Wo, večini uporabnikov ni nujno mar, kako delujejo obstoječi modeli AI, in z veseljem preprosto izpeljejo uporabnost iz njih, vsaj za zdaj.

»V srednjeročnem obdobju, ko bo novost teh platform izginila, bo vsekakor več skepticizma glede metodologije črne skrinjice. Vprašanja se bodo povečala tudi, ko bo uporaba umetne inteligence vstopila v kripto in Web3, kjer je treba upoštevati finančne vložke in posledice,« je priznal.

Vpliv na zaupanje in preglednost

Eno področje, kjer lahko pomanjkanje preglednosti bistveno vpliva na zaupanje, je medicinska diagnostika, ki jo poganja umetna inteligenca. Modeli AI lahko na primer analizirajo zapletene zdravstvene podatke v zdravstvu, da ustvarijo diagnoze ali priporočila za zdravljenje. Če pa kliniki in pacienti ne morejo razumeti utemeljitve teh predlogov, lahko dvomijo o zanesljivosti in veljavnosti teh spoznanj. Ta skepticizem lahko nadalje vodi do obotavljanja pri sprejemanju rešitev umetne inteligence, kar lahko ovira napredek pri oskrbi bolnikov in personalizirani medicini.

Na finančnem področju se sistemi AI lahko uporabljajo za kreditno točkovanje, odkrivanje goljufij in oceno tveganja. Vendar lahko težava s črno skrinjico povzroči negotovost glede poštenosti in točnosti teh bonitetnih rezultatov ali razlogov za opozorila o goljufijah, kar omejuje sposobnost tehnologije za digitalizacijo industrije.

Kriptoindustrija se sooča tudi s posledicami problema črne skrinjice. Na primer, digitalna sredstva in tehnologija veriženja blokov temeljijo na decentralizaciji, odprtosti in preverljivosti. Sistemi umetne inteligence, ki jim primanjkuje preglednosti in razlage, tvorijo nepovezanost med pričakovanji uporabnikov in realnostjo rešitev, ki jih poganja umetna inteligenca v tem prostoru.

Regulativni pomisleki

Z regulativnega vidika predstavlja problem črne skrinjice AI edinstven izziv. Za začetek lahko regulatorji zaradi nepreglednosti procesov umetne inteligence vse težje ocenijo skladnost teh sistemov z obstoječimi pravili in smernicami. Poleg tega lahko pomanjkanje preglednosti oteži zmožnost regulatorjev, da razvijejo nove okvire, ki lahko obravnavajo tveganja in izzive, ki jih predstavljajo aplikacije umetne inteligence.

Zakonodajalci se morda trudijo oceniti poštenost, pristranskost in prakse zasebnosti podatkov sistemov umetne inteligence ter njihov potencialni vpliv na pravice potrošnikov in stabilnost trga. Poleg tega se lahko regulatorji brez jasnega razumevanja postopkov odločanja sistemov, ki jih poganja umetna inteligenca, soočijo s težavami pri prepoznavanju potencialnih ranljivosti in zagotavljanju, da so vzpostavljeni ustrezni zaščitni ukrepi za zmanjšanje tveganj.

One notable regulatory development regarding this technology has been the European Union’s Artificial Intelligence Act, which is moving closer to becoming part of the bloc’s statute book after reaching a provisional political agreement on April 27.

V bistvu je cilj zakona o umetni inteligenci ustvariti zaupanja vredno in odgovorno okolje za razvoj umetne inteligence v EU. Zakonodajalci so sprejeli sistem klasifikacije, ki razvršča različne vrste umetne inteligence glede na tveganje: nesprejemljivo, visoko, omejeno in minimalno. Ta okvir je zasnovan tako, da obravnava različne pomisleke, povezane s problemom črne skrinjice AI, vključno z vprašanji glede preglednosti in odgovornosti.

Nezmožnost učinkovitega spremljanja in urejanja sistemov umetne inteligence je že zaostrila odnose med različnimi industrijami in regulativnimi organi.

Early last month, the popular AI chatbot ChatGPT was banned in Italy for 29 days, primarily due to privacy concerns raised by the country’s data protection agency for suspected violations of the EU’s General Data Protection Regulations (GDPR). However, the platform was allowed to resume its services on April 29 after CEO Sam Altman announced that he and his team had taken specific steps to comply with the regulator’s demands, including the revelation of its data processing practices and implementation of its implementation of age-gating measures.

Neustrezna regulacija sistemov umetne inteligence bi lahko zmanjšala zaupanje javnosti v aplikacije umetne inteligence, saj postajajo uporabniki vse bolj zaskrbljeni zaradi inherentnih pristranskosti, netočnosti in etičnih posledic.

Reševanje problema črne skrinjice

Za učinkovito reševanje problema črne skrinjice z umetno inteligenco je bistvenega pomena uporaba kombinacije pristopov, ki spodbujajo preglednost, interpretabilnost in odgovornost. Dve takšni komplementarni strategiji sta razložljivi AI (XAI) in odprtokodni modeli.

XAI je področje raziskav, namenjeno premostitvi vrzeli med kompleksnostjo sistemov umetne inteligence in potrebo po človeški razlagi. XAI se osredotoča na razvoj tehnik in algoritmov, ki lahko zagotovijo človeku razumljive razlage za odločitve, ki jih vodi umetna inteligenca, ter ponujajo vpogled v razloge za te odločitve.

Metode, ki se pogosto uporabljajo v XAI, vključujejo nadomestne modele, analizo pomembnosti lastnosti, analizo občutljivosti in lokalne razlage, ki jih je mogoče razlagati glede na modele. Implementacija XAI v panogah lahko zainteresiranim stranem pomaga bolje razumeti procese, ki jih poganja umetna inteligenca, s čimer poveča zaupanje v tehnologijo in omogoči skladnost z regulativnimi zahtevami.

V tandemu z XAI je lahko spodbujanje sprejemanja odprtokodnih modelov umetne inteligence učinkovita strategija za reševanje problema črne skrinjice. Odprtokodni modeli omogočajo popoln dostop do algoritmov in podatkov, ki poganjajo sisteme umetne inteligence, kar uporabnikom in razvijalcem omogoča, da natančno pregledajo in razumejo osnovne procese.

Ta povečana preglednost lahko pomaga zgraditi zaupanje in spodbuditi sodelovanje med razvijalci, raziskovalci in uporabniki. Poleg tega lahko odprtokodni pristop ustvari bolj robustne, odgovorne in učinkovite sisteme umetne inteligence.

Problem črne skrinjice v kripto prostoru

Problem črne skrinjice ima pomembne posledice za različne vidike kripto prostora, vključno s strategijami trgovanja, tržnimi napovedmi, varnostnimi ukrepi, tokenizacijo in pametnimi pogodbami.

Na področju strategij trgovanja in tržnih napovedi postajajo modeli, ki jih poganja umetna inteligenca, vse bolj priljubljeni, saj si vlagatelji prizadevajo izkoristiti algoritemsko trgovanje. Vendar problem črne skrinjice ovira uporabnike pri razumevanju delovanja teh modelov, zaradi česar je težko oceniti njihovo učinkovitost in morebitna tveganja. Posledično lahko ta nepreglednost povzroči tudi neupravičeno zaupanje v naložbene odločitve, ki jih poganja umetna inteligenca, ali povzroči, da se vlagatelji preveč zanašajo na avtomatizirane sisteme.

Umetna inteligenca bo igrala ključno vlogo pri krepitvi varnostnih ukrepov v ekosistemu blockchain z odkrivanjem goljufivih transakcij in sumljivih dejavnosti. Kljub temu težava s črno skrinjico otežuje postopek preverjanja teh varnostnih rešitev, ki jih poganja AI. Pomanjkanje preglednosti pri odločanju lahko zmanjša zaupanje v varnostne sisteme, kar zbuja pomisleke glede njihove sposobnosti varovanja premoženja in informacij uporabnikov.

Zadnje: Soglasje 2023: Podjetja kažejo zanimanje za Web3 kljub regulativnim izzivom v ZDA

Tokenizacija in pametne pogodbe – dve ključni komponenti ekosistema blockchain – so prav tako priča povečani integraciji umetne inteligence. Vendar lahko težava s črno skrinjico zakrije logiko za žetone, ki jih ustvari umetna inteligenca, ali izvajanje pametne pogodbe.

Ker AI revolucionira različne industrije, postaja reševanje problema črne skrinjice vse bolj pereče. S spodbujanjem sodelovanja med raziskovalci, razvijalci, oblikovalci politik in zainteresiranimi stranmi v industriji je mogoče razviti rešitve za spodbujanje preglednosti, odgovornosti in zaupanja v sisteme umetne inteligence. Zato bo zanimivo videti, kako se bo ta nova tehnološka paradigma še naprej razvijala.

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoAiStream. Podatkovna inteligenca Web3. Razširjeno znanje. Dostopite tukaj.

- Kovanje prihodnosti z Adryenn Ashley. Dostopite tukaj.

- Kupujte in prodajajte delnice podjetij pred IPO s PREIPO®. Dostopite tukaj.

- vir: https://cointelegraph.com/news/ai-s-black-box-problem-challenges-and-solutions-for-a-transparent-future

- :ima

- : je

- :ne

- :kje

- 2023

- 27

- a

- sposobnost

- O meni

- dostop

- dostopen

- odgovornost

- odgovorna

- natančnost

- čez

- Zakon

- aktivno

- dejavnosti

- dodajanje

- Poleg tega

- Naslov

- naslavljanje

- sprejet

- Sprejem

- Sprejetje

- napredek

- vplivajo

- po

- agencija

- Sporazum

- AI

- Zakon o umetni inteligenci

- AI klepet

- Z AI napajanjem

- Cilje

- Opozorila

- algoritmični

- algoritmično trgovanje

- algoritmi

- vsi

- že

- Prav tako

- med

- an

- Analiza

- analitika

- analizirati

- in

- razglasitve

- aplikacije

- pristop

- pristopi

- primerno

- april

- SE

- OBMOČJE

- okoli

- umetni

- Umetna inteligenca

- AS

- vidiki

- ocenjevanje

- Sredstva

- povezan

- At

- pozornosti

- Avtomatizirano

- BE

- postanejo

- postane

- postajajo

- bilo

- zadaj

- meni

- Boljše

- med

- pristranskosti

- pristranskosti

- črna

- blockchain

- blockchain ekosistem

- Blokchain tehnologija

- Organi

- Knjiga

- Meje

- Pasovi

- premostitev

- izgradnjo

- graditi zaupanje

- zgrajena

- podjetja

- by

- CAN

- ne more

- kapitalizirati

- ki

- primeri

- ceo

- nekatere

- izziv

- izzivi

- izziv

- chatbot

- ChatGPT

- možnosti

- Razvrstitev

- klasifikacijski sistem

- jasno

- kliniki

- Cointelegraph

- sodelovanje

- kombinacija

- dopolnilni

- kompleksna

- kompleksnost

- skladnost

- deli

- razumeti

- zaskrbljen

- Skrbi

- Posledice

- Posledično

- Razmislite

- Potrošnik

- Pravice potrošnikov

- Potrošniki

- Vsebina

- kontekstih

- naprej

- se nadaljuje

- Naročilo

- pogodbe

- Core

- bi

- država je

- ustvarjajo

- ustvaril

- kredit

- ključnega pomena

- kripto

- Kripto industrija

- kripto prostor

- Armaturna plošča

- datum

- zasebnost podatkov

- obdelava podatkov

- Varstvo podatkov

- nabori podatkov

- decentralizacija

- Odločitev

- Odločanje

- odločitve

- namenjen

- globoko

- globoko učenje

- vsekakor

- zahteve

- Dokazano

- zasnovan

- Kljub

- Odkrivanje

- Razvoj

- razvili

- Razvijalci

- razvoju

- Razvoj

- drugačen

- težko

- Težave

- Težavnost

- digitalni

- Digitalna sredstva

- digitalizirati

- do

- domena

- dont

- pogon

- 2

- enostavno

- ekosistem

- Učinkovito

- učinkovito

- učinkovitost

- zaposleni

- omogočanje

- okrepi

- izboljšanje

- zagotovitev

- zagotoviti

- Vstopi

- okolje

- bistvena

- ETH

- etično

- EU

- Evropski

- oceniti

- razvijajo

- Primer

- izvedba

- obstoječih

- pričakovanja

- pojasnjujejo

- Obraz

- obrazi

- olajšanje

- pravičnost

- Feature

- financiranje

- finančna

- Firm

- Osredotoča

- za

- predvidljiva

- obrazec

- Spodbujati

- gojenje

- Ustanovitelj

- ustanoviteljev

- Okvirni

- okviri

- goljufija

- odkrivanje goljufij

- goljufiva

- iz

- polno

- funkcija

- nadalje

- Poleg tega

- Prihodnost

- pridobivanje

- vrzel

- GDPR

- splošno

- splošni podatki

- ustvarjajo

- ustvarjajo

- odobri

- skupina

- Garancija

- vodi

- Smernice

- imel

- srečna

- Imajo

- he

- zdravstveno varstvo

- pomoč

- visoka

- ovira

- njegov

- Kako

- Vendar

- HTTPS

- človeškega

- Ljudje

- identifikacijo

- if

- neizmerno

- vpliv

- udarne

- Izvajanje

- izvajanja

- posledice

- Pomembnost

- in

- nezmožnost

- vključujejo

- Vključno

- Povečajte

- povečal

- vedno

- industrij

- Industrija

- Podatki

- inherentno

- vpogledi

- integrirana

- integracija

- Intelligence

- medsebojno povezani

- obresti

- Zanimivo

- v

- naložbe

- Vlagatelji

- Investira

- vprašanje

- Vprašanja

- IT

- Italija

- ITS

- Pomanjkanje

- Zadnja

- zakonodajalci

- plasti

- vodi

- vodi

- učenje

- vsaj

- Pravne informacije

- sodni postopek

- kot

- Limited

- živi

- lokalna

- Logika

- stroj

- strojno učenje

- je

- Znamka

- Izdelava

- Način

- več

- Tržna

- tržne napovedi

- Trženje

- matematični

- Maj ..

- ukrepe

- medicinski

- medicinske podatke

- zdravila

- Metodologija

- morda

- minimalna

- Omiliti

- modeli

- monitor

- mesec

- več

- Poleg tega

- Najbolj

- premikanje

- veliko

- več

- nujno

- Nimate

- omrežij

- nevronske mreže

- Kljub temu

- Novo

- št

- vozlišča

- opazen

- Pojem

- roman

- Novost

- zdaj

- of

- off

- ponujanje

- pogosto

- on

- enkrat

- motno

- open source

- Odprtost

- deluje

- or

- naši

- Splošni

- plačana

- paradigma

- del

- zlasti

- Bolnik

- bolniki

- vzorci

- ljudje

- Izvedite

- Prilagojene

- Kraj

- platforma

- Platforme

- platon

- Platonova podatkovna inteligenca

- PlatoData

- Predvajaj

- politik

- političnih

- Popular

- Priljubljenost

- možnost

- potencial

- potencialno

- močan

- Praktično

- vaje

- Napovedi

- predstaviti

- darila

- prevladujoč

- v prvi vrsti

- zasebnost

- problem

- Težave

- Postopki

- Postopek

- Procesi

- obravnavati

- Izdelki

- spodbujanje

- Spodbujanje

- zaščita

- zagotavljajo

- Začasni

- javnega

- zaupanje javnosti

- vprašanje

- vprašanja

- postavljeno

- dvig

- utemeljitev

- dosegli

- Reality

- kraljestvo

- nedavno

- Pred kratkim

- Priporočila

- o

- Uredi

- Uredba

- predpisi

- Regulatorji

- regulatorni

- povezane

- Razmerja

- zanesljivost

- zanašajo

- posledice

- zahteva

- Zahteve

- Raziskave

- raziskovalci

- odgovorna

- povzroči

- Nadaljuj

- revolucijo

- revolucionira

- pravice

- Tveganje

- Ocena tveganja

- tveganja

- robusten

- vloga

- pravila

- varovala

- Je dejal

- sam

- Sam Altman

- točkovanje

- varnost

- Varnostni ukrepi

- glej

- Seek

- občutljivost

- Storitve

- Kompleti

- Prikaži

- pomemben

- bistveno

- preprosto

- Skepticizem

- pametna

- pametna pogodba

- Pametne pogodbe

- rešitve

- SOLVE

- prefinjeno

- vir

- Vesolje

- specifična

- po delih

- Stabilnost

- interesne skupine

- stati

- stojala

- stebla

- Koraki

- Še vedno

- strategije

- Strategija

- racionalizirati

- Boj

- taka

- sumljiv

- sistem

- sistemi

- Tandem

- Naloge

- skupina

- tech

- tehnike

- Tehnologije

- Tehnologija

- Pogoji

- da

- O

- njihove

- Njih

- Tukaj.

- te

- jih

- ta

- do

- Tokenizacija

- Boni

- Trace

- Trgovanje

- Trgovalni Strategije

- Transakcije

- Transform

- transformacije

- Preglednost

- pregleden

- Zdravljenje

- Zaupajte

- zaupanja

- Resnica

- dva

- Vrste

- Negotovost

- odkrijte

- osnovni

- razumeli

- razumljivo

- razumevanje

- edinstven

- naprej

- us

- uporaba

- uporabnik

- Uporabniki

- pripomoček

- dragocene

- različnih

- Preverjanje

- Kršitve

- ključnega pomena

- Ranljivosti

- je

- Web3

- kdaj

- ki

- bo

- z

- v

- brez

- priča

- wo

- delo

- dela

- let

- zefirnet