Radiološka poročila so izčrpni, dolgi dokumenti, ki opisujejo in interpretirajo rezultate radiološke slikovne preiskave. V tipičnem delovnem procesu radiolog nadzoruje, bere in interpretira slike ter nato jedrnato povzame ključne ugotovitve. Povzetek (oz vtis) je najpomembnejši del poročila, ker zdravnikom in bolnikom pomaga, da se osredotočijo na kritično vsebino poročila, ki vsebuje informacije za klinično odločanje. Ustvarjanje jasnega in vplivnega vtisa vključuje veliko več truda kot preprosto ponavljanje ugotovitev. Celoten postopek je zato naporen, dolgotrajen in nagnjen k napakam. Pogosto traja leta trening zdravnikom, da zberejo dovolj strokovnega znanja pri pisanju jedrnatih in informativnih povzetkov radioloških poročil, kar dodatno poudarja pomen avtomatizacije postopka. Dodatno samodejno ustvarjanje povzemanja ugotovitev poročila je ključnega pomena za radiološko poročanje. Omogoča prevajanje izvidov v človeku berljiv jezik, s čimer pacientom olajša branje dolgih in nejasnih izvidov.

Za rešitev te težave predlagamo uporabo generativne umetne inteligence, vrste umetne inteligence, ki lahko ustvari nove vsebine in ideje, vključno s pogovori, zgodbami, slikami, videi in glasbo. Generativno umetno inteligenco poganjajo modeli strojnega učenja (ML) – zelo veliki modeli, ki so vnaprej usposobljeni za ogromne količine podatkov in se običajno imenujejo osnovni modeli (FM). Nedavni napredek v strojnem jeziku (zlasti izum arhitekture nevronske mreže, ki temelji na transformatorju) je privedel do porasta modelov, ki vsebujejo milijarde parametrov ali spremenljivk. Predlagana rešitev v tej objavi uporablja natančno nastavitev vnaprej usposobljenih velikih jezikovnih modelov (LLM) za pomoč pri ustvarjanju povzetkov na podlagi ugotovitev v radioloških poročilih.

Ta objava prikazuje strategijo za natančno prilagajanje javno dostopnih LLM za nalogo povzemanja radioloških poročil z uporabo storitev AWS. LLM-ji so pokazali izjemne sposobnosti razumevanja in ustvarjanja naravnega jezika ter služijo kot temeljni modeli, ki jih je mogoče prilagoditi različnim področjem in nalogam. Uporaba vnaprej usposobljenega modela ima pomembne prednosti. Zmanjšuje stroške računanja, zmanjšuje ogljične odtise in vam omogoča uporabo najsodobnejših modelov, ne da bi morali usposobiti enega od začetka.

Naša rešitev uporablja FLAN-T5 XL FM, z uporabo Amazon SageMaker JumpStart, ki je središče ML, ki ponuja algoritme, modele in rešitve ML. Pokažemo, kako to doseči z uporabo zvezka v Amazon SageMaker Studio. Natančna nastavitev vnaprej usposobljenega modela vključuje nadaljnje usposabljanje na določenih podatkih za izboljšanje učinkovitosti pri drugačni, a povezani nalogi. Ta rešitev vključuje natančno nastavitev modela FLAN-T5 XL, ki je izboljšana različica T5 (Text-to-Text Transfer Transformer) univerzalni LLM-ji. T5 v nasprotju z BERTI-style modeli, ki lahko izpišejo samo oznako razreda ali razpon vnosa. Natančno je prilagojen za nalogo povzemanja 91,544 radioloških poročil s prostim besedilom, pridobljenih iz Nabor podatkov MIMIC-CXR.

Pregled rešitve

V tem razdelku razpravljamo o ključnih komponentah naše rešitve: izbiri strategije za nalogo, natančnem prilagajanju LLM in ocenjevanju rezultatov. Ilustriramo tudi arhitekturo rešitve in korake za implementacijo rešitve.

Določite strategijo za nalogo

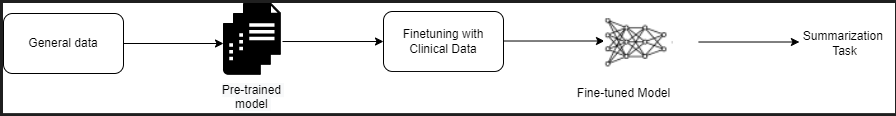

Obstajajo različne strategije za pristop k nalogi avtomatizacije povzemanja kliničnih poročil. Lahko bi na primer uporabili specializirani jezikovni model, ki je bil predhodno usposobljen za klinična poročila iz nič. Druga možnost je, da lahko neposredno prilagodimo javno dostopen splošni jezikovni model za izvedbo klinične naloge. Uporaba natančno nastavljenega domensko-agnostičnega modela bo morda potrebna v nastavitvah, kjer usposabljanje a jezikovni model iz nič je predrago. V tej rešitvi prikazujemo slednji pristop uporabe modela FLAN -T5 XL, ki ga natančno prilagodimo za klinično nalogo povzemanja radioloških poročil. Naslednji diagram prikazuje potek dela modela.

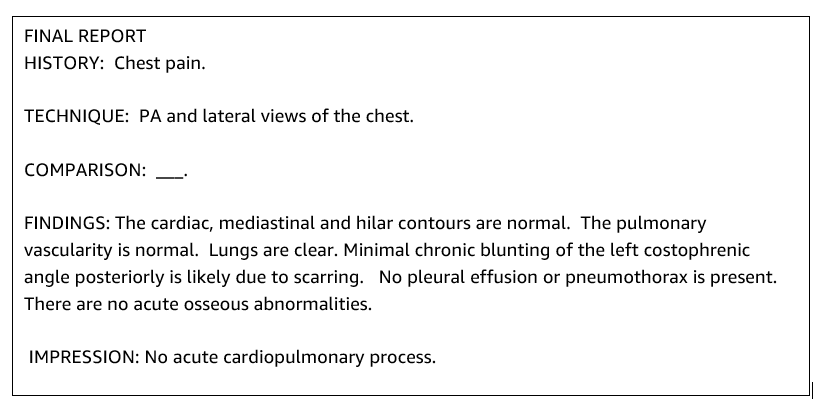

Tipično radiološko poročilo je dobro organizirano in jedrnato. Takšna poročila imajo pogosto tri ključne razdelke:

- Ozadje – Zagotavlja splošne informacije o demografiji pacienta z bistvenimi informacijami o pacientu, klinični anamnezi in ustrezni zdravstveni anamnezi ter podrobnosti o postopkih pregleda

- Ugotovitve – Predstavi podrobno diagnozo in rezultate pregleda

- tiskanje – Jedrnato povzema najpomembnejše ugotovitve ali interpretacijo ugotovitev z oceno pomembnosti in morebitno diagnozo na podlagi opaženih nenormalnosti

Z uporabo razdelka z ugotovitvami v radioloških poročilih rešitev ustvari razdelek z vtisi, ki ustreza povzetku zdravnikov. Naslednja slika je primer radiološkega poročila.

Natančno prilagodite splošni LLM za klinično nalogo

V tej rešitvi natančno nastavimo model FLAN-T5 XL (nastavimo vse parametre modela in jih optimiziramo za nalogo). Model natančno prilagodimo z uporabo nabora podatkov klinične domene MIMIC-CXR, ki je javno dostopen nabor radiografij prsnega koša. Za natančno nastavitev tega modela prek SageMaker Jumpstart je treba zagotoviti označene primere v obliki parov {prompt, completion}. V tem primeru uporabimo pare {Findings, Impression} iz izvirnih poročil v naboru podatkov MIMIC-CXR. Za sklepanje uporabimo poziv, kot je prikazano v naslednjem primeru:

![]()

Model je natančno nastavljen na pospešeno računalništvo ml.p3.16xvelika primerek s 64 virtualnimi procesorji in 488 GiB pomnilnika. Za validacijo je bilo naključno izbranih 5 % nabora podatkov. Pretečeni čas učnega opravila SageMaker s fino nastavitvijo je bil 38,468 sekund (približno 11 ur).

Ocenite rezultate

Ko je usposabljanje končano, je ključnega pomena oceniti rezultate. Za kvantitativno analizo ustvarjenega vtisa uporabljamo RED (Recall-Oriented Understudy for Gisting Evaluation), najpogosteje uporabljena metrika za ocenjevanje povzemanja. Ta metrika primerja samodejno ustvarjen povzetek s povzetkom ali prevodom sklica ali nabora sklicevanj (človeško izdelanega). ROUGE1 se nanaša na prekrivanje unigrami (vsaka beseda) med kandidatom (izhodom modela) in referenčnimi povzetki. ROUGE2 se nanaša na prekrivanje bigrami (dve besedi) med kandidatskim in referenčnim povzetkom. ROUGEL je metrika na ravni stavka in se nanaša na najdaljše skupno podzaporedje (LCS) med dvema deloma besedila. V besedilu ignorira nove vrstice. ROUGELsum je metrika na ravni povzetka. Za to metriko se nove vrstice v besedilu ne prezrejo, ampak se razlagajo kot meje stavka. LCS se nato izračuna med vsakim parom referenčnih in kandidatnih stavkov, nato pa se izračuna union-LCS. Za seštevek teh rezultatov v danem nizu referenčnih in kandidatnih stavkov se izračuna povprečje.

Vodenje in arhitektura

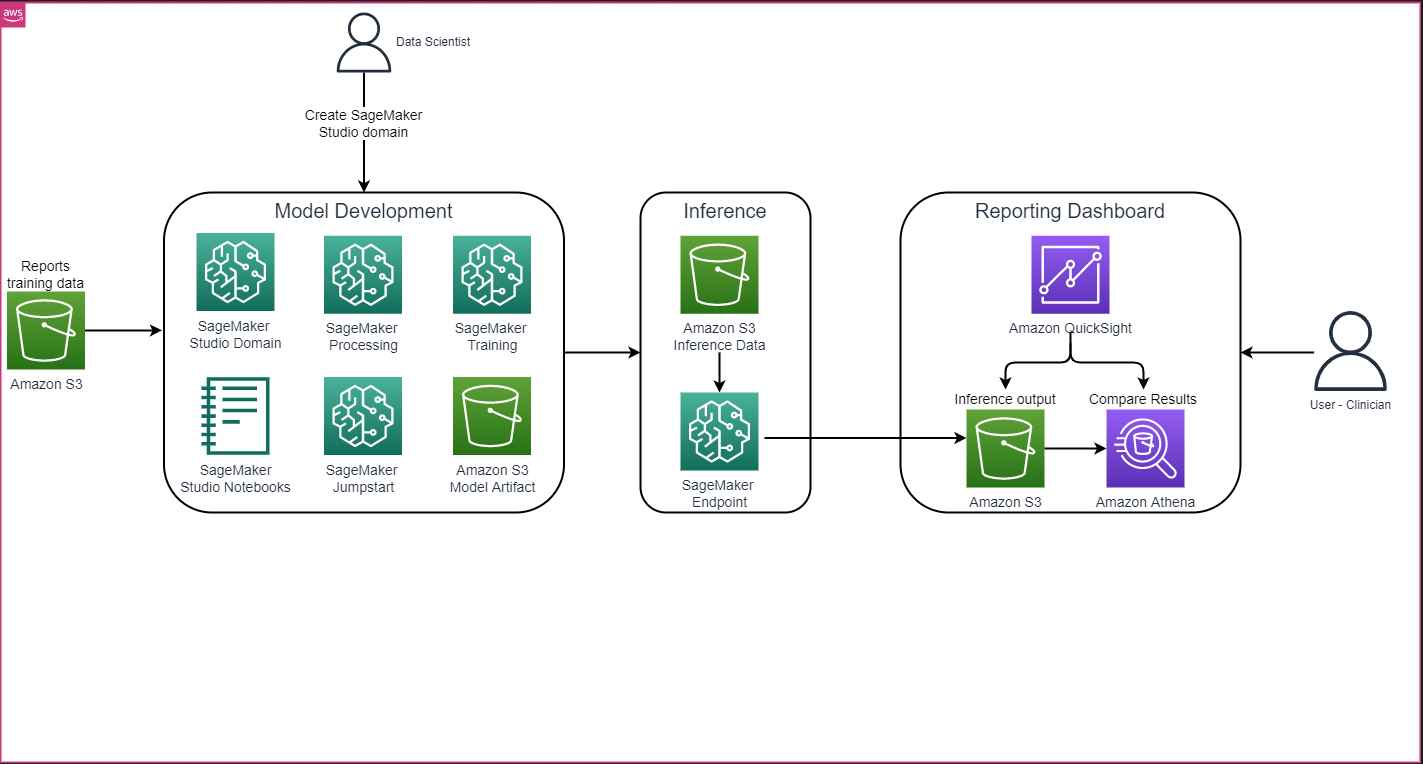

Celotna arhitektura rešitve, kot je prikazana na naslednji sliki, je sestavljena predvsem iz okolja za razvoj modela, ki uporablja SageMaker Studio, uvedbe modela s končno točko SageMaker in nadzorne plošče za poročanje, ki uporablja Amazon QuickSight.

V naslednjih razdelkih prikazujemo natančno nastavitev LLM, ki je na voljo na SageMaker JumpStart za povzemanje domensko specifične naloge prek SDK-ja SageMaker Python. Predvsem razpravljamo o naslednjih temah:

- Koraki za nastavitev razvojnega okolja

- Pregled naborov podatkov radioloških poročil, na katerih je model natančno nastavljen in ovrednoten

- Predstavitev natančne nastavitve modela FLAN-T5 XL s programsko uporabo SageMaker JumpStart s SDK SageMaker Python

- Sklepanje in vrednotenje vnaprej usposobljenih in natančno nastavljenih modelov

- Primerjava rezultatov vnaprej usposobljenega modela in natančno nastavljenih modelov

Rešitev je na voljo v Ustvarjanje vtisa radiološkega poročila z uporabo generativne umetne inteligence z velikim jezikovnim modelom na AWS GitHub repo.

Predpogoji

Za začetek potrebujete AWS račun v katerem lahko uporabite SageMaker Studio. Če ga še nimate, boste morali ustvariti uporabniški profil za SageMaker Studio.

Vrsta primerka za usposabljanje, uporabljena v tej objavi, je ml.p3.16xlarge. Upoštevajte, da tip primerka p3 zahteva povečanje omejitve kvote storitve.

O Nabor podatkov MIMIC CXR je mogoče dostopati prek pogodbe o uporabi podatkov, ki zahteva registracijo uporabnika in dokončanje postopka poverilnice.

Nastavite razvojno okolje

Če želite nastaviti svoje razvojno okolje, ustvarite vedro S3, konfigurirate prenosni računalnik, ustvarite končne točke in razmestite modele ter ustvarite nadzorno ploščo QuickSight.

Ustvari vedro S3

Ustvari vedro S3 se imenuje llm-radiology-bucket za gostovanje naborov podatkov o usposabljanju in vrednotenju. To bo uporabljeno tudi za shranjevanje artefakta modela med razvojem modela.

Konfigurirajte prenosni računalnik

Izvedite naslednje korake:

- Zaženite SageMaker Studio iz konzole SageMaker ali iz Vmesnik ukazne vrstice AWS (AWS CLI).

Za več informacij o vključitvi v domeno glejte Vkrcajte se na domeno Amazon SageMaker.

- Ustvari novo SageMaker Studio prenosni računalnik za čiščenje podatkov poročila in natančno nastavitev modela. Uporabljamo primerek prenosnika ml.t3.medium 2vCPU+4GiB z jedrom Python 3.

- Znotraj prenosnega računalnika namestite ustrezne pakete, kot je npr

nest-asyncio,IPyWidgets(za interaktivne gradnike za prenosnik Jupyter) in SDK za SageMaker Python:

Za sklepanje vnaprej usposobljenih in natančno nastavljenih modelov, ustvarite končno točko in uvedite vsak model v zvezku takole:

- Iz razreda Model ustvarite objekt modela, ki ga je mogoče razmestiti na končno točko HTTPS.

- Ustvarite končno točko HTTPS z vnaprej zgrajenim predmetom modela

deploy()metoda:

Ustvari nadzorno ploščo QuickSight

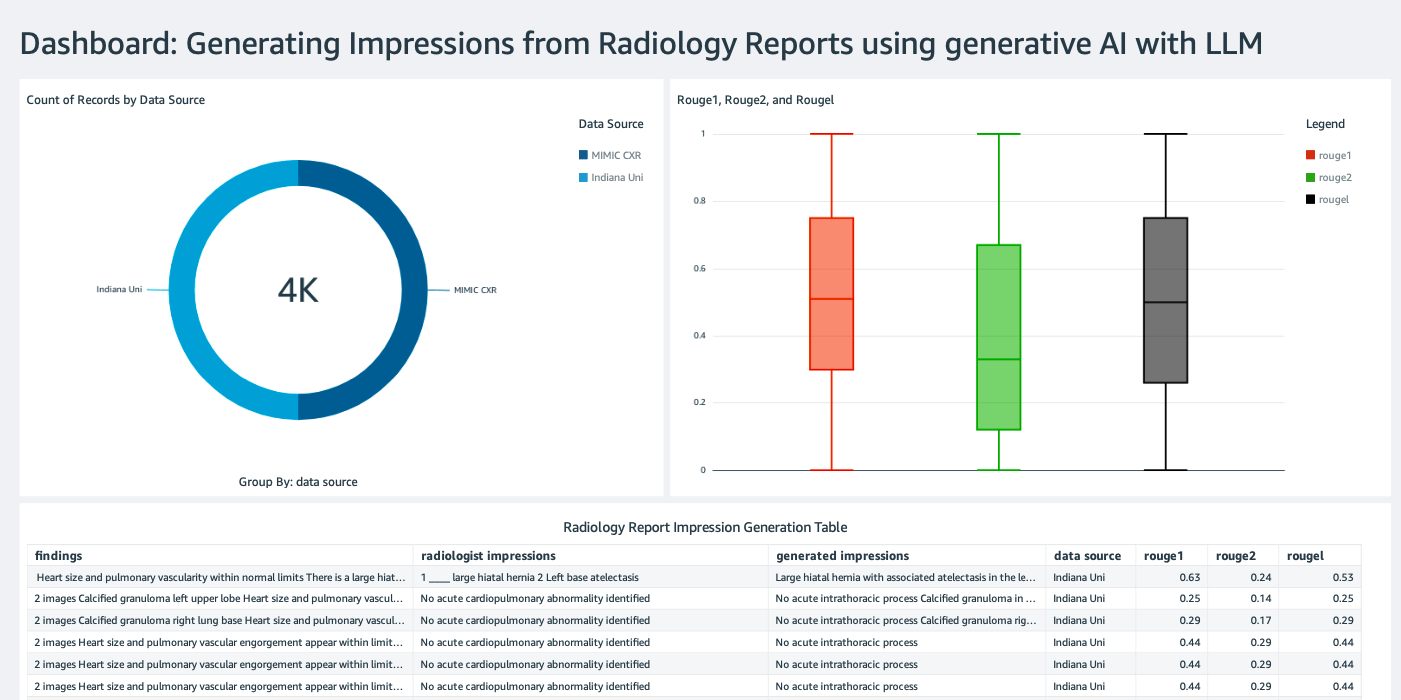

Ustvarite Nadzorna plošča QuickSight z virom podatkov Athena z rezultati sklepanja Preprosta storitev shranjevanja Amazon (Amazon S3) za primerjavo rezultatov sklepanja z osnovno resnico. Naslednji posnetek zaslona prikazuje naš primer nadzorne plošče.

Podatkovni nizi radioloških poročil

Model je zdaj natančno nastavljen, vsi parametri modela so nastavljeni na 91,544 poročilih, prenesenih iz Nabor podatkov MIMIC-CXR v2.0. Ker smo uporabili samo besedilne podatke radiološkega poročila, smo prenesli samo eno stisnjeno datoteko poročila (mimic-cxr-reports.zip) s spletne strani MIMIC-CXR. Zdaj ocenjujemo natančno nastavljen model na 2,000 poročilih (v nadaljevanju dev1 nabor podatkov) iz ločenega držal podmnožico tega nabora podatkov. Uporabljamo še 2,000 radioloških izvidov (v nadaljevanju dev2) za oceno natančno nastavljenega modela iz zbirke rentgenskih slik prsnega koša iz Mreža bolnišnic Univerze Indiana. Vsi nabori podatkov se berejo kot datoteke JSON in naložijo v novo ustvarjeno vedro S3 llm-radiology-bucket. Upoštevajte, da vsi nabori podatkov privzeto ne vsebujejo zaščitenih zdravstvenih informacij (PHI); vsi občutljivi podatki so nadomeščeni s tremi zaporednimi podčrtaji (___) s strani ponudnikov.

Natančno nastavite s SDK SageMaker Python

Za natančno nastavitev, model_id je določeno kot huggingface-text2text-flan-t5-xl s seznama modelov SageMaker JumpStart. The training_instance_type je nastavljen kot ml.p3.16xlarge in inference_instance_type kot ml.g5.2xvelik. Podatki o usposabljanju v formatu JSON se berejo iz vedra S3. Naslednji korak je uporaba izbranega modela_id za ekstrahiranje URI-jev virov SageMaker JumpStart, vključno z image_uri ( Registar elastičnih zabojnikov Amazon (Amazon ECR) URI za sliko Docker), model_uri (predhodno usposobljen model artefakta Amazon S3 URI) in script_uri (skripta usposabljanja):

Poleg tega je izhodna lokacija nastavljena kot mapa znotraj vedra S3.

Samo en hiperparameter, epohe, je spremenjen na 3, vsi ostali pa so nastavljeni kot privzeti:

Meritve usposabljanja, kot je npr eval_loss (za izgubo validacije), loss (za izgubo treninga) in epoch ki jim je treba slediti, so opredeljeni in navedeni:

Uporabljamo URI virov SageMaker JumpStart (image_uri, model_uri, script_uri), identificiran prej, da ustvarite ocenjevalec in ga natančno prilagodite na naboru podatkov za usposabljanje tako, da določite pot S3 nabora podatkov. Razred Estimator zahteva an entry_point parameter. V tem primeru uporablja JumpStart transfer_learning.py. Učno opravilo se ne izvaja, če ta vrednost ni nastavljena.

To usposabljanje lahko traja več ur; zato je priporočljivo, da parameter čakanja nastavite na False in spremljate status opravila usposabljanja na konzoli SageMaker. Uporabi TrainingJobAnalytics funkcija za spremljanje metrik usposabljanja ob različnih časovnih žigih:

Razmestite končne točke sklepanja

Da naredimo primerjave, uvedemo končne točke sklepanja za predhodno usposobljene in natančno nastavljene modele.

Najprej pridobite sklepni URI slike Docker z uporabo model_idin uporabite ta URI za ustvarjanje primerka modela SageMaker vnaprej usposobljenega modela. Razmestite vnaprej usposobljeni model tako, da ustvarite končno točko HTTPS s predhodno zgrajenim objektom modela deploy() metoda. Če želite zagnati sklepanje prek API-ja SageMaker, se prepričajte, da ste posredovali razred Predictor.

Ponovite prejšnji korak, da ustvarite primerek modela SageMaker natančno nastavljenega modela in ustvarite končno točko za razmestitev modela.

Ocenite modele

Najprej nastavite dolžino povzetega besedila, število izhodov modela (naj bo večje od 1, če je treba ustvariti več povzetkov) in število žarkov za iskanje snopa.

Konstruirajte zahtevo za sklepanje kot obremenitev JSON in jo uporabite za poizvedovanje končnih točk za vnaprej usposobljene in natančno nastavljene modele.

Izračunajte agregirano ROUGE zadene (ROUGE1, ROUGE2, ROUGEL, ROUGELsum), kot je opisano prej.

Primerjajte rezultate

Naslednja tabela prikazuje rezultate ocenjevanja za dev1 in dev2 nabori podatkov. Rezultat ocenjevanja na dev1 (2,000 ugotovitev iz poročila o radiologiji MIMIC CXR) kaže izboljšanje skupnega povprečja za približno 38 odstotnih točk. ROUGE1 in ROUGE2 rezultate v primerjavi s predhodno usposobljenim modelom. Za dev2 je opaziti izboljšanje rezultatov ROUGE31 in ROUGE25 za 1 odstotnih točk in 2 odstotnih točk. Na splošno je natančno prilagajanje privedlo do izboljšanja rezultatov ROUGELsum za 38.2 odstotne točke in 31.3 odstotne točke. dev1 in dev2 naborov podatkov oz.

|

Ocenjevanje Podatkovni niz |

Vnaprej usposobljen model | Dodelan model | ||||||

| ROUGE1 | ROUGE2 | ROUGEL | ROUGELsum | ROUGE1 | ROUGE2 | ROUGEL | ROUGELsum | |

dev1 |

0.2239 | 0.1134 | 0.1891 | 0.1891 | 0.6040 | 0.4800 | 0.5705 | 0.5708 |

dev2 |

0.1583 | 0.0599 | 0.1391 | 0.1393 | 0.4660 | 0.3125 | 0.4525 | 0.4525 |

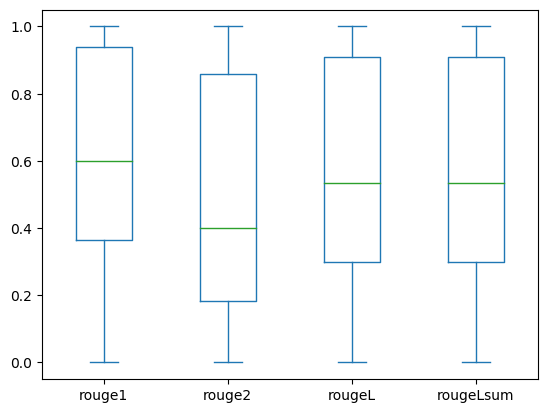

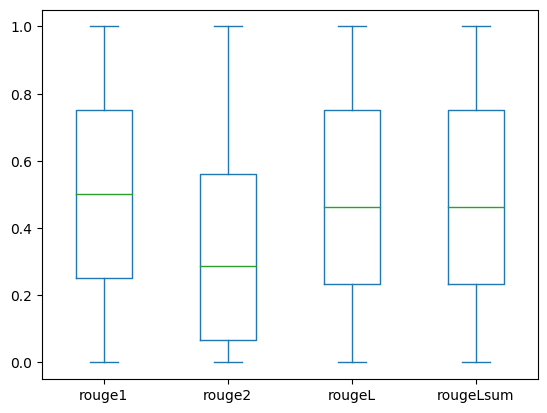

Naslednji okvirni diagrami prikazujejo porazdelitev rezultatov ROUGE za dev1 in dev2 naborov podatkov, ovrednotenih z natančno nastavljenim modelom.

|

|

(The): dev1 |

(b): dev2 |

Naslednja tabela kaže, da imajo rezultati ROUGE za nabore podatkov za vrednotenje približno enako mediano in povprečje in so zato simetrično porazdeljeni.

| Podatkovni nizi | Partitura | Grof | Pomeni | Std odstopanje | Minimalna | 25 % percentil | 50 % percentil | 75 % percentil | največja |

dev1 |

ROUGE1 | 2000.00 | 0.6038 | 0.3065 | 0.0000 | 0.3653 | 0.6000 | 0.9384 | 1.0000 |

| ROUGE 2 | 2000.00 | 0.4798 | 0.3578 | 0.0000 | 0.1818 | 0.4000 | 0.8571 | 1.0000 | |

| ROUGE L | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

| ROUGELsum | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

dev2 |

ROUGE 1 | 2000.00 | 0.4659 | 0.2525 | 0.0000 | 0.2500 | 0.5000 | 0.7500 | 1.0000 |

| ROUGE 2 | 2000.00 | 0.3123 | 0.2645 | 0.0000 | 0.0664 | 0.2857 | 0.5610 | 1.0000 | |

| ROUGE L | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 | |

| ROUGE Lsum | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 |

Čiščenje

Da se izognete prihodnjim stroškom, izbrišite vire, ki ste jih ustvarili z naslednjo kodo:

zaključek

V tej objavi smo pokazali, kako natančno prilagoditi model FLAN-T5 XL za nalogo povzemanja, specifično za klinično domeno, s pomočjo SageMaker Studio. Da bi povečali zaupanje, smo napovedi primerjali z osnovno resnico in ovrednotili rezultate z metriko ROUGE. Dokazali smo, da model, natančno nastavljen za določeno nalogo, vrača boljše rezultate kot model, predhodno usposobljen za generično nalogo NLP. Radi bi poudarili, da fina nastavitev splošnega LLM popolnoma odpravi stroške predhodnega usposabljanja.

Čeprav se tukaj predstavljeno delo osredotoča na poročila o rentgenskem slikanju prsnega koša, ga je mogoče razširiti na večje nabore podatkov z različnimi anatomijami in načini, kot sta MRI in CT, za katera so radiološka poročila lahko bolj zapletena z več ugotovitvami. V takih primerih lahko radiologi ustvarijo vtise po kritičnem vrstnem redu in vključijo priporočila za nadaljnje spremljanje. Poleg tega bi vzpostavitev povratne zanke za to aplikacijo omogočila radiologom, da sčasoma izboljšajo učinkovitost modela.

Kot smo pokazali v tej objavi, natančno nastavljeni model ustvarja vtise za radiološka poročila z visokimi rezultati ROUGE. LLM lahko poskusite natančno prilagoditi na drugih zdravstvenih poročilih, specifičnih za domeno, iz različnih oddelkov.

O avtorjih

Dr. Adewale Akinfaderin je višji podatkovni znanstvenik v zdravstvu in znanostih o življenju pri AWS. Njegovo strokovno znanje je na področju ponovljivih in celovitih metod AI/ML, praktičnih implementacij in pomoči globalnim strankam zdravstvenega varstva pri oblikovanju in razvoju razširljivih rešitev za interdisciplinarne probleme. Ima dve diplomi iz fizike in doktorat iz tehnike.

Dr. Adewale Akinfaderin je višji podatkovni znanstvenik v zdravstvu in znanostih o življenju pri AWS. Njegovo strokovno znanje je na področju ponovljivih in celovitih metod AI/ML, praktičnih implementacij in pomoči globalnim strankam zdravstvenega varstva pri oblikovanju in razvoju razširljivih rešitev za interdisciplinarne probleme. Ima dve diplomi iz fizike in doktorat iz tehnike.

Priya Padate je višji arhitekt partnerskih rešitev z obsežnim strokovnim znanjem na področju zdravstva in znanosti o življenju pri AWS. Priya spodbuja strategije trženja s partnerji in spodbuja razvoj rešitev za pospešitev razvoja, ki temelji na AI/ML. Navdušena je nad uporabo tehnologije za preoblikovanje zdravstvene industrije za doseganje boljših rezultatov oskrbe bolnikov.

Priya Padate je višji arhitekt partnerskih rešitev z obsežnim strokovnim znanjem na področju zdravstva in znanosti o življenju pri AWS. Priya spodbuja strategije trženja s partnerji in spodbuja razvoj rešitev za pospešitev razvoja, ki temelji na AI/ML. Navdušena je nad uporabo tehnologije za preoblikovanje zdravstvene industrije za doseganje boljših rezultatov oskrbe bolnikov.

Ekta Walia Bhullar, PhD, je višji svetovalec za AI/ML v poslovni enoti za strokovne storitve AWS Healthcare and Life Sciences (HCLS). Ima bogate izkušnje z uporabo AI/ML na področju zdravstva, zlasti v radiologiji. Izven službe, ko ne razpravlja o AI v radiologiji, rada teče in planinari.

Ekta Walia Bhullar, PhD, je višji svetovalec za AI/ML v poslovni enoti za strokovne storitve AWS Healthcare and Life Sciences (HCLS). Ima bogate izkušnje z uporabo AI/ML na področju zdravstva, zlasti v radiologiji. Izven službe, ko ne razpravlja o AI v radiologiji, rada teče in planinari.

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Avtomobili/EV, Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- PlatoHealth. Obveščanje o biotehnologiji in kliničnih preskušanjih. Dostopite tukaj.

- ChartPrime. Izboljšajte svojo igro trgovanja s ChartPrime. Dostopite tukaj.

- BlockOffsets. Posodobitev okoljskega offset lastništva. Dostopite tukaj.

- vir: https://aws.amazon.com/blogs/machine-learning/automatically-generate-impressions-from-findings-in-radiology-reports-using-generative-ai-on-aws/

- :ima

- : je

- :ne

- :kje

- $GOR

- 000

- 1

- 100

- 11

- 116

- 125

- 16

- 20

- 22

- 25

- 26%

- 29

- 31

- 36

- 7

- 700

- 8

- 9

- 91

- a

- Sposobna

- O meni

- pospeši

- pospešeno

- dostopna

- doseganje

- Akumulirajte

- Poleg tega

- napredek

- proti

- združevanje

- Sporazum

- AI

- AI / ML

- algoritmi

- vsi

- omogoča

- že

- Prav tako

- skupaj

- Amazon

- Amazon SageMaker

- Amazon Web Services

- zneski

- an

- Analiza

- in

- Še ena

- kaj

- API

- uporaba

- pristop

- približno

- Arhitektura

- SE

- Argument

- AS

- ocenjevanje

- At

- Samodejno

- samodejno

- avtomatizacija

- Na voljo

- povprečno

- izogniti

- AWS

- baza

- temeljijo

- BE

- ker

- pred

- počutje

- Prednosti

- Boljše

- med

- večji

- milijardah

- tako

- Meje

- Pasovi

- obremenitev

- poslovni

- vendar

- by

- se imenuje

- CAN

- Kandidat

- Zmogljivosti

- ogljika

- ki

- primeru

- primeri

- spremenilo

- Stroški

- izbiri

- razred

- čiščenje

- jasno

- klinični

- kliniki

- Koda

- zbirka

- Skupno

- pogosto

- primerjate

- v primerjavi z letom

- dokončanje

- dokončanje

- kompleksna

- deli

- celovito

- računanje

- računalništvo

- zgoščeno

- zaupanje

- zaporedna

- vsebuje

- Konzole

- svetovalec

- vsebujejo

- Posoda

- vsebina

- Vsebina

- kontrast

- pogovorov

- ustreza

- strošek

- drago

- stroški

- bi

- par

- ustvarjajo

- ustvaril

- Ustvarjanje

- kritično

- kritičnost

- po meri

- Stranke, ki so

- Armaturna plošča

- datum

- podatkovni znanstvenik

- nabor podatkov

- Odločanje

- privzeto

- opredeljen

- Stopnja

- Demografski podatki

- izkazati

- Dokazano

- dokazuje,

- oddelki

- razporedi

- razporejeni

- uvajanje

- opisati

- opisano

- podrobno

- Podrobnosti

- Razvoj

- Razvoj

- drugačen

- neposredno

- razpravlja

- razpravljali

- porazdeljena

- distribucija

- Lučki delavec

- Zdravniki

- Dokumenti

- domena

- domen

- dont

- pripravi

- pogon

- diski

- med

- vsak

- prej

- prizadevanje

- bodisi

- odpravlja

- ostalo

- omogočajo

- omogoča

- konec koncev

- Končna točka

- Inženiring

- okrepljeno

- dovolj

- Celotna

- okolje

- epoha

- epohe

- Napaka

- zlasti

- bistvena

- oceniti

- ocenili

- ocenjevanje

- Ocena

- izpit

- Primer

- Primeri

- izvršiti

- razširiti

- izkušnje

- strokovno znanje

- obsežen

- Obširne izkušnje

- ekstrakt

- ne uspe

- false

- povratne informacije

- Slika

- file

- datoteke

- Ugotovitve

- Osredotočite

- Osredotoča

- po

- sledi

- za

- obrazec

- format

- Fundacija

- iz

- funkcija

- nadalje

- Poleg tega

- Prihodnost

- splošno

- glavni namen

- ustvarjajo

- ustvarila

- ustvarja

- generacija

- generativno

- Generativna AI

- dobili

- dana

- Globalno

- Pojdi na trg

- diplomiral

- več

- Igrišče

- Imajo

- ob

- he

- Zdravje

- zdravstvene informacije

- zdravstveno varstvo

- zdravstvena industrija

- pomoč

- pomoč

- Pomaga

- tukaj

- visoka

- poudarjanje

- Pohod

- njegov

- zgodovina

- gostitelj

- URE

- Kako

- Kako

- HTML

- http

- HTTPS

- Hub

- HuggingFace

- človeškega

- ID

- Ideje

- identificirati

- if

- ponazarja

- slika

- slike

- slikanje

- vplivno

- izvajati

- izvedbe

- uvoz

- Pomembno

- izboljšanje

- Izboljšanje

- in

- vključujejo

- Vključno

- Povečajte

- Industrija

- Podatki

- informativni

- vhod

- namestitev

- primer

- interaktivno

- razlago

- v

- Izum

- IT

- Job

- Delovna mesta

- json

- samo

- samo en

- Imejte

- Ključne

- label

- jezik

- velika

- kosilo

- učenje

- Led

- dolžina

- življenje

- Life Sciences

- kot

- všeč mi je

- LIMIT

- vrstica

- Seznam

- Navedeno

- LLM

- nahaja

- kraj aktivnosti

- off

- stroj

- strojno učenje

- Znamka

- Maj ..

- pomeni

- medicinski

- srednje

- Spomin

- Metoda

- Metode

- meritev

- Meritve

- morda

- Minute

- ML

- Model

- modeli

- monitor

- več

- Najbolj

- MRI

- veliko

- več

- Glasba

- morajo

- Ime

- naravna

- Obdelava Natural Language

- potrebno

- Nimate

- mreža

- nevronska mreža

- Novo

- na novo

- Naslednja

- nlp

- prenosnik

- zdaj

- Številka

- predmet

- pridobljeni

- of

- ponujanje

- pogosto

- on

- Na vkrcanje

- ONE

- samo

- optimizacijo

- or

- Da

- izvirno

- Ostalo

- naši

- ven

- rezultatov

- izhod

- zunaj

- več

- Splošni

- preglasijo

- pregled

- pakete

- par

- parov

- parameter

- parametri

- del

- zlasti

- partner

- partnerji

- mimo

- strastno

- pot

- Bolnik

- bolniki

- odstotek

- Izvedite

- performance

- Dr.

- Fizika

- kosov

- platon

- Platonova podatkovna inteligenca

- PlatoData

- Točka

- točke

- Prispevek

- potencial

- poganja

- Praktično

- Napovedi

- Predictor

- predstavljeni

- darila

- v prvi vrsti

- problem

- Težave

- Postopek

- obravnavati

- Proizvedeno

- strokovni

- profil

- predlaga

- predlagano

- zaščiteni

- če

- ponudniki

- zagotavlja

- javno

- Python

- količinsko

- Preberi

- reading

- nedavno

- Priporočila

- priporočeno

- zmanjšuje

- reference

- besedilu

- nanaša

- regularni izraz

- registracija

- povezane

- pomembno

- izjemno

- nadomesti

- poročilo

- Poročanje

- Poročila

- zahteva

- obvezna

- zahteva

- vir

- viri

- oziroma

- REST

- povzroči

- Rezultati

- vrne

- Rise

- Run

- tek

- sagemaker

- Enako

- razširljive

- ZNANOSTI

- Znanstvenik

- praska

- SDK

- Iskalnik

- sekund

- Oddelek

- oddelki

- glej

- izbran

- višji

- občutljiva

- stavek

- ločena

- Storitev

- Storitve

- služijo

- nastavite

- nastavitev

- nastavitve

- je

- shouldnt

- je pokazala,

- pokazale

- Razstave

- Pomen

- pomemben

- Enostavno

- preprosto

- majhna

- So

- Rešitev

- rešitve

- SOLVE

- nekaj

- span

- specializirani

- specifična

- posebej

- določeno

- Začetek

- začel

- state-of-the-art

- Status

- Korak

- Koraki

- Še vedno

- shranjevanje

- trgovina

- zgodbe

- strategije

- Strategija

- studio

- taka

- POVZETEK

- Preverite

- miza

- Bodite

- meni

- Naloga

- Naloge

- Tehnologija

- kot

- da

- O

- Njih

- POTEM

- Tukaj.

- s tem

- zato

- te

- ta

- tisti,

- 3

- skozi

- čas

- do

- tudi

- Teme

- sledenje

- Vlak

- usposabljanje

- prenos

- Transform

- transformator

- prevod

- Resnica

- poskusite

- dva

- tip

- tipičen

- poudarja

- razumevanje

- poenoteno

- Enota

- univerza

- naložili

- uporaba

- Rabljeni

- uporabnik

- uporablja

- uporabo

- potrjevanje

- vrednost

- Vrednote

- različnih

- Popravljeno

- različica

- preko

- Video posnetki

- Virtual

- Počakaj

- je

- we

- web

- spletne storitve

- Spletna stran

- kdaj

- ki

- medtem

- širina

- bo

- z

- v

- brez

- beseda

- besede

- delo

- potek dela

- bi

- pisanje

- x-ray

- let

- Vi

- Vaša rutina za

- zefirnet