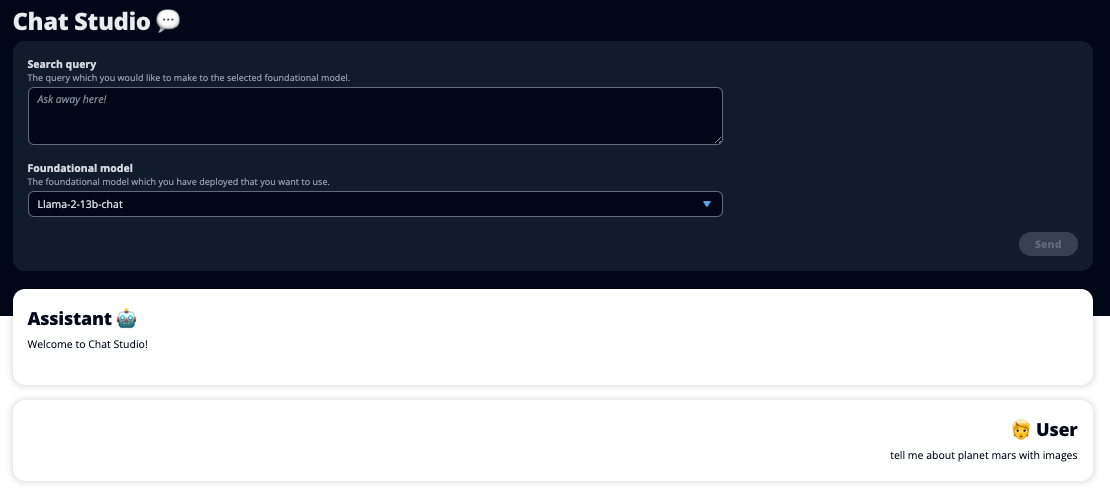

Uvedba ChatGPT in naraščanje priljubljenosti generativne umetne inteligence sta vzbudila domišljijo strank, ki jih zanima, kako lahko to tehnologijo uporabijo za ustvarjanje novih izdelkov in storitev na AWS, kot so podjetniški klepetalni roboti, ki so bolj pogovorni. Ta objava vam pokaže, kako lahko ustvarite spletni uporabniški vmesnik, ki ga imenujemo Chat Studio, za začetek pogovora in interakcijo z osnovnimi modeli, ki so na voljo v Amazon SageMaker JumpStart kot so Llama 2, Stable Diffusion in drugi modeli, ki so na voljo na Amazon SageMaker. Ko uvedete to rešitev, lahko uporabniki hitro začnejo in izkusijo zmogljivosti več temeljnih modelov v pogovornem AI prek spletnega vmesnika.

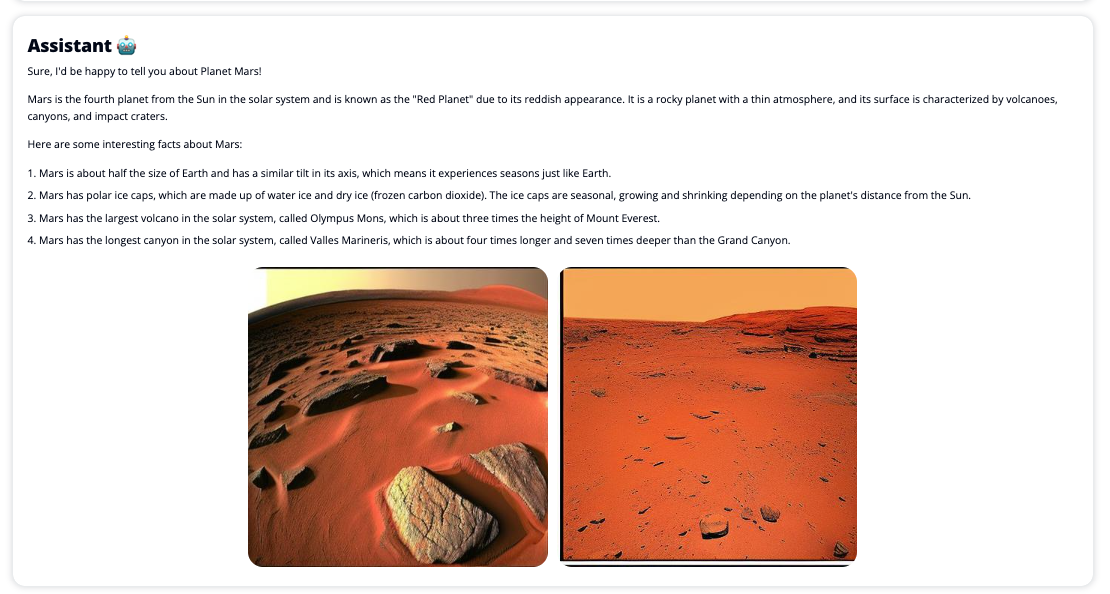

Chat Studio lahko tudi po želji prikliče končno točko modela Stable Diffusion, da vrne kolaž ustreznih slik in videoposnetkov, če uporabnik zahteva prikaz medija. Ta funkcija lahko pomaga izboljšati uporabniško izkušnjo z uporabo medijev kot spremljevalnih sredstev za odgovor. To je samo en primer, kako lahko obogatite Chat Studio z dodatnimi integracijami, da dosežete svoje cilje.

Naslednji posnetki zaslona prikazujejo primere, kako sta videti uporabniška poizvedba in odgovor.

Veliki jezikovni modeli

Generativne AI chatbote, kot je ChatGPT, poganjajo veliki jezikovni modeli (LLM), ki temeljijo na nevronski mreži globokega učenja, ki jo je mogoče učiti na velikih količinah neoznačenega besedila. Uporaba LLM omogoča boljšo pogovorno izkušnjo, ki je zelo podobna interakciji z resničnimi ljudmi, spodbuja občutek povezanosti in izboljša zadovoljstvo uporabnikov.

Modeli temeljev SageMaker

Leta 2021 je Stanfordski inštitut za umetno inteligenco, osredotočeno na človeka, nekatere študije LLM označil za modeli temeljev. Temeljni modeli so vnaprej usposobljeni na velikem in širokem naboru splošnih podatkov in naj bi služili kot osnova za nadaljnje optimizacije v številnih primerih uporabe, od ustvarjanja digitalne umetnosti do večjezične klasifikacije besedil. Ti osnovni modeli so priljubljeni pri strankah, ker usposabljanje novega modela iz nič zahteva čas in je lahko drago. SageMaker JumpStart omogoča dostop do več sto temeljnih modelov, ki jih vzdržujejo odprtokodni in lastniški ponudniki tretjih oseb.

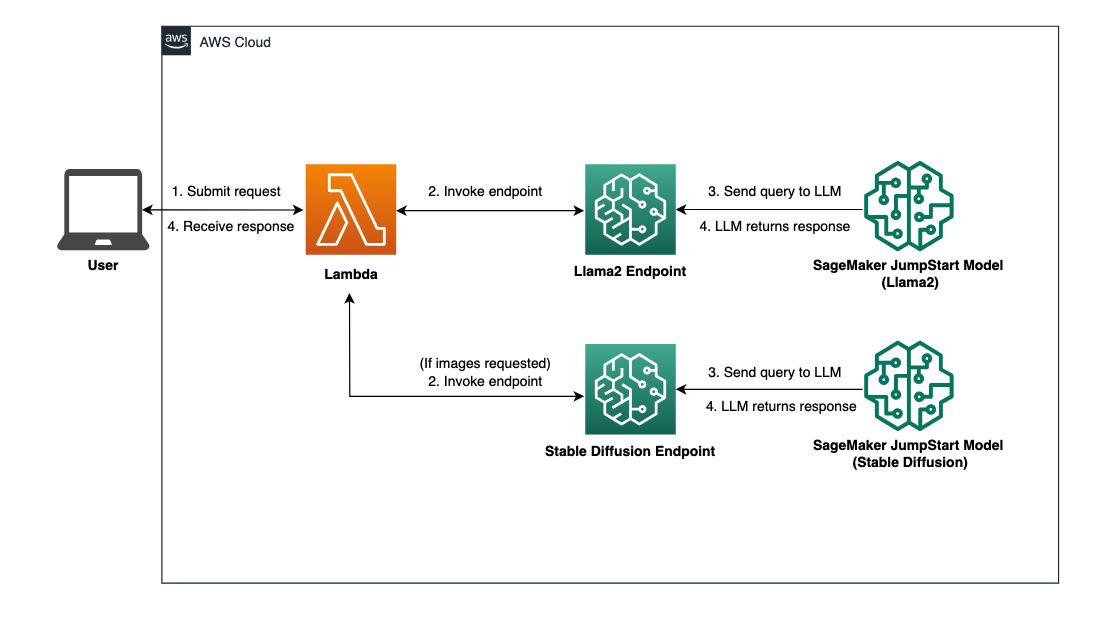

Pregled rešitev

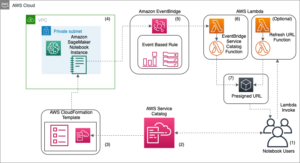

Ta objava se sprehodi skozi potek dela z nizko kodo za uvajanje vnaprej usposobljenih in prilagojenih LLM-jev prek SageMakerja in ustvarjanje spletnega uporabniškega vmesnika za vmesnik z uvedenimi modeli. Pokrivamo naslednje korake:

- Namestite modele temeljev SageMaker.

- uvajanje AWS Lambda in AWS upravljanje identitete in dostopa (IAM) uporaba dovoljenj Oblikovanje oblaka AWS.

- Nastavite in zaženite uporabniški vmesnik.

- Po želji dodajte druge modele temeljev SageMaker. Ta korak razširi zmožnost Chat Studia za interakcijo z dodatnimi modeli temeljev.

- Izbirno namestite aplikacijo z uporabo Ojačaj AWS. Ta korak uvede Chat Studio v splet.

Za pregled arhitekture rešitve glejte naslednji diagram.

Predpogoji

Za sprehod skozi rešitev morate imeti naslednje predpogoje:

- An AWS račun z zadostnimi uporabniškimi pravicami IAM.

npmnameščen v vašem lokalnem okolju. Za navodila o namestitvinpm, nanašati se na Prenos in namestitev Node.js in npm.- Storitvena kvota 1 za ustrezne končne točke SageMaker. Za Llama 2 13b Chat uporabljamo primerek ml.g5.48xlarge, za Stable Diffusion 2.1 pa uporabljamo primerek ml.p3.2xlarge.

Če želite zahtevati povečanje kvote storitev, na Konzola AWS Service Quotas, pojdite na Storitve AWS, SageMakerin zahtevo za povečanje kvote storitev na vrednost 1 za ml.g5.48xlarge za uporabo končne točke in ml.p3.2xlarge za uporabo končne točke.

Odobritev zahteve za kvoto storitve lahko traja nekaj ur, odvisno od razpoložljivosti vrste instance.

Namestite modele temeljev SageMaker

SageMaker je popolnoma upravljana storitev strojnega učenja (ML) za razvijalce, ki z lahkoto hitro sestavijo in učijo modele ML. Izvedite naslednje korake za uvedbo temeljnih modelov Llama 2 13b Chat in Stable Diffusion 2.1 z uporabo Amazon SageMaker Studio:

- Ustvarite domeno SageMaker. Za navodila glejte Vkrcajte se na domeno Amazon SageMaker z uporabo hitre nastavitve.

Domena vzpostavi ves prostor za shranjevanje in vam omogoča dodajanje uporabnikov za dostop do SageMakerja.

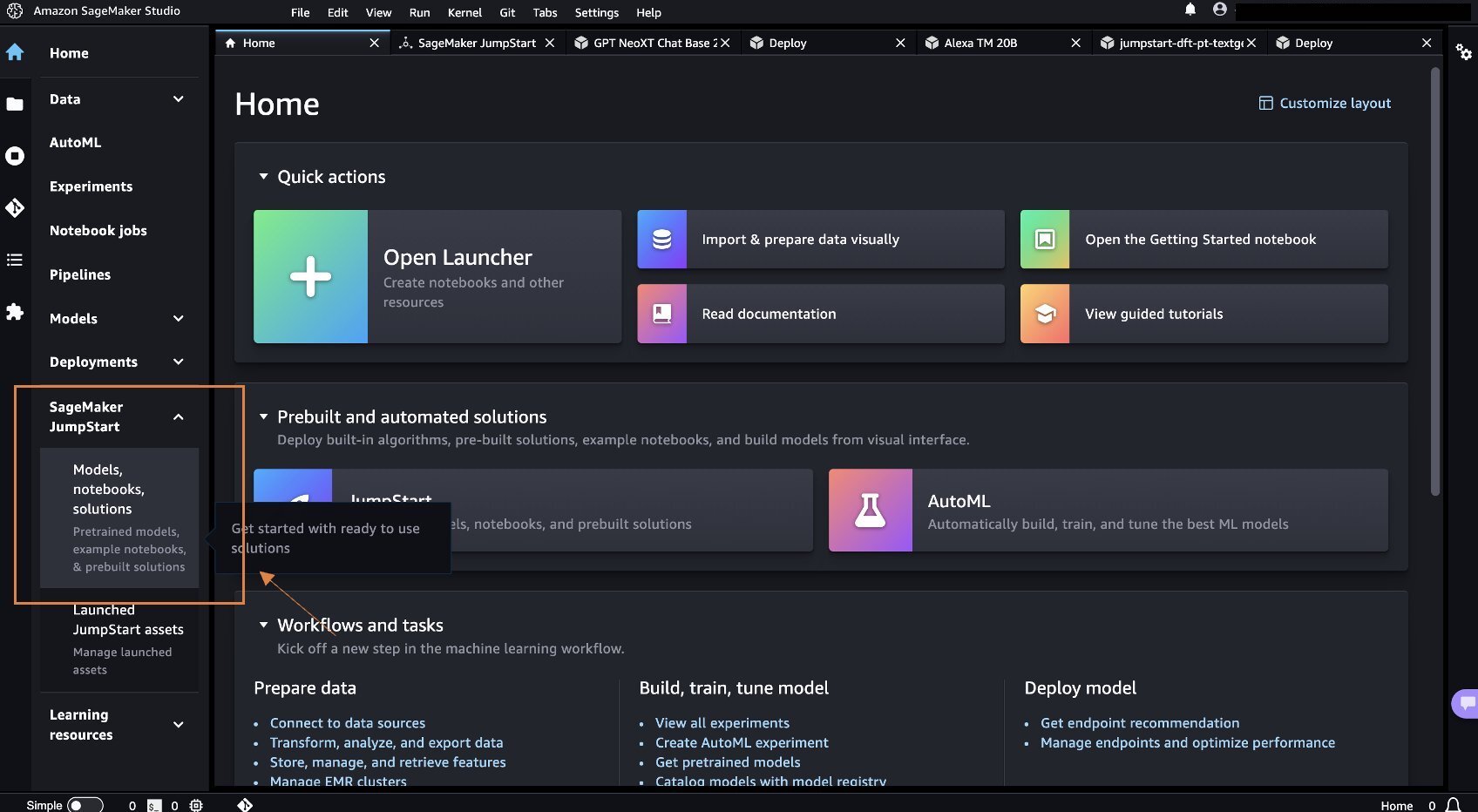

- Na konzoli SageMaker izberite študija v podoknu za krmarjenje in nato izberite Odprti studio.

- Ob zagonu Studia pod SageMaker JumpStart v podoknu za krmarjenje izberite Modeli, zvezki, rešitve.

- V iskalni vrstici poiščite Llama 2 13b Chat.

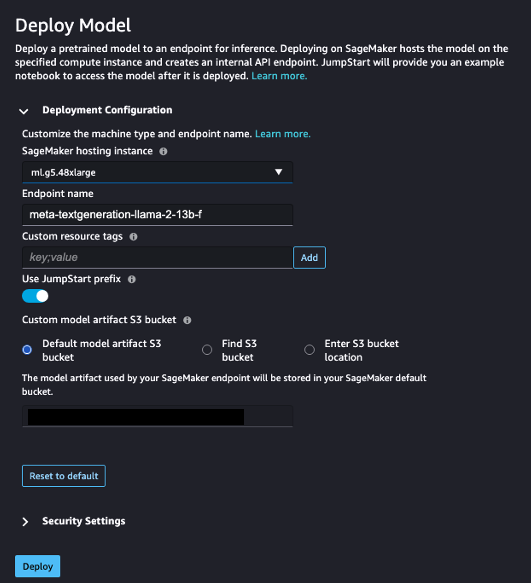

- Pod Konfiguracija uvajanjaZa Primerek gostovanja SageMaker, izberite ml.g5.48xvelik in za Ime končne točke, vnesite

meta-textgeneration-llama-2-13b-f. - Izberite Razporeditev.

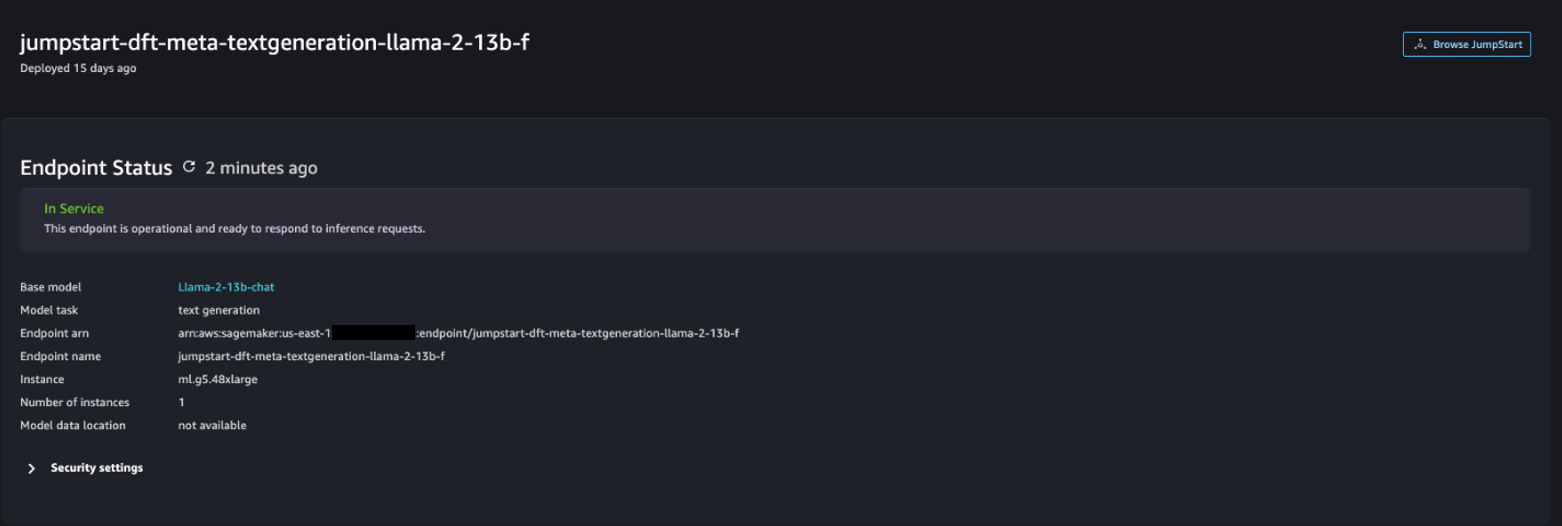

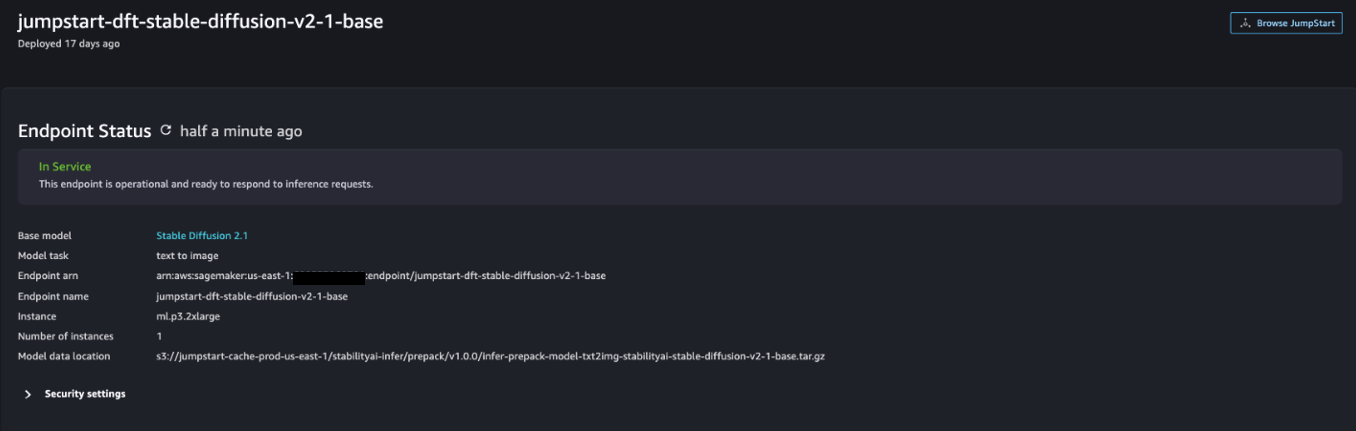

Ko je uvedba uspešna, bi morali biti sposobni videti In Service Status.

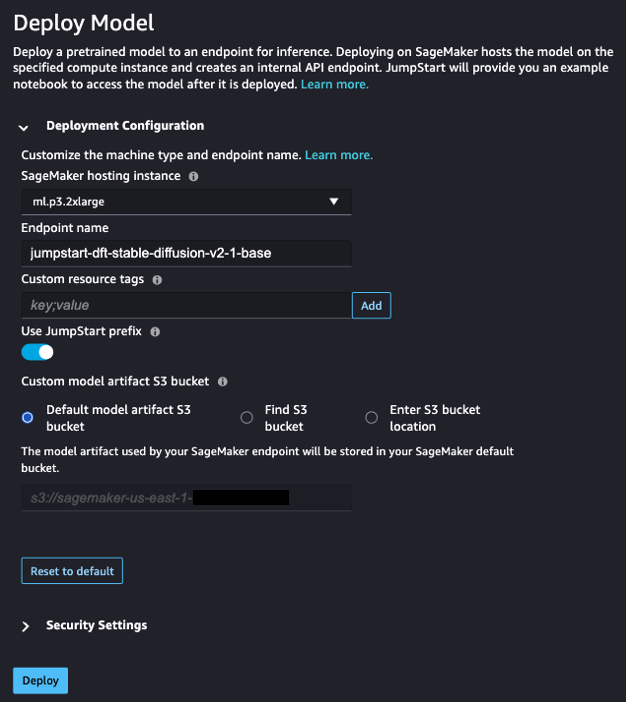

- o Modeli, zvezki, rešitve stran, poiščite Stable Diffusion 2.1.

- Pod Konfiguracija uvajanjaZa Primerek gostovanja SageMaker, izberite ml.p3.2xvelika in za Ime končne točke, vnesite

jumpstart-dft-stable-diffusion-v2-1-base. - Izberite uvajanje.

Ko je uvedba uspešna, bi morali biti sposobni videti In Service Status.

Razmestite dovoljenja Lambda in IAM z uporabo AWS CloudFormation

Ta razdelek opisuje, kako lahko zaženete sklad CloudFormation, ki uvede funkcijo Lambda, ki obdela vašo uporabniško zahtevo in pokliče končno točko SageMaker, ki ste jo uvedli, ter uvede vsa potrebna dovoljenja IAM. Izvedite naslednje korake:

- Pomaknite se na GitHub repozitorij in prenesite predlogo CloudFormation (

lambda.cfn.yaml) na vaš lokalni računalnik. - Na konzoli CloudFormation izberite Ustvari sklad spustni meni in izberite Z novimi viri (standardno).

- o Določite predlogo stran, izberite Naložite datoteko predloge in Izberite datoteko.

- Izberite

lambda.cfn.yamldatoteko, ki ste jo prenesli, nato izberite Naslednji. - o Določite podrobnosti zlaganja vnesite ime sklada in ključ API-ja, ki ste ga pridobili v predpogojih, nato izberite Naslednji.

- o Konfigurirajte možnosti zlaganja stran, izberite Naslednji.

- Preglejte in potrdite spremembe ter izberite Prijave se.

Nastavite spletni uporabniški vmesnik

V tem razdelku so opisani koraki za zagon spletnega uporabniškega vmesnika (ustvarjenega z uporabo Sistem oblikovanja Cloudscape) na vašem lokalnem računalniku:

- Na konzoli IAM se pomaknite do uporabnika

functionUrl. - o Poverilnice izberite jeziček Ustvari ključ za dostop.

- o Dostopajte do ključnih najboljših praks in alternativ stran, izberite Vmesnik ukazne vrstice (CLI) In izberite Naslednji.

- o Nastavite opisno oznako stran, izberite Ustvari ključ za dostop.

- Kopirajte ključ za dostop in skrivni ključ za dostop.

- Izberite Done.

- Pomaknite se na GitHub repozitorij in prenesete

react-llm-chat-studioKoda. - Zaženite mapo v želenem IDE in odprite terminal.

- Pomaknite se na

src/configs/aws.jsonin vnesite ključ za dostop in skrivni ključ za dostop, ki ste ju pridobili. - V terminal vnesite naslednje ukaze:

- Odprto http://localhost:3000 v brskalniku in začnite komunicirati s svojimi modeli!

Če želite uporabljati Chat Studio, izberite temeljni model v spustnem meniju in v besedilno polje vnesite svojo poizvedbo. Če želite skupaj z odgovorom dobiti slike, ustvarjene z umetno inteligenco, dodajte besedno zvezo »s slikami« na konec poizvedbe.

Dodajte druge modele temeljev SageMaker

Zmogljivost te rešitve lahko dodatno razširite tako, da vključite dodatne modele temeljev SageMaker. Ker vsak model pričakuje različne vhodne in izhodne formate, ko prikliče svojo končno točko SageMaker, boste morali napisati nekaj transformacijske kode v funkcijo callSageMakerEndpoints Lambda za vmesnik z modelom.

Ta razdelek opisuje splošne korake in spremembe kode, potrebne za implementacijo dodatnega modela po vaši izbiri. Upoštevajte, da je za korake 6–8 potrebno osnovno znanje jezika Python.

- V SageMaker Studio namestite temeljni model SageMaker po vaši izbiri.

- Izberite SageMaker JumpStart in Zaženi sredstva JumpStart.

- Izberite svojo novo razporejeno končno točko modela in izberite Odprite Beležnico.

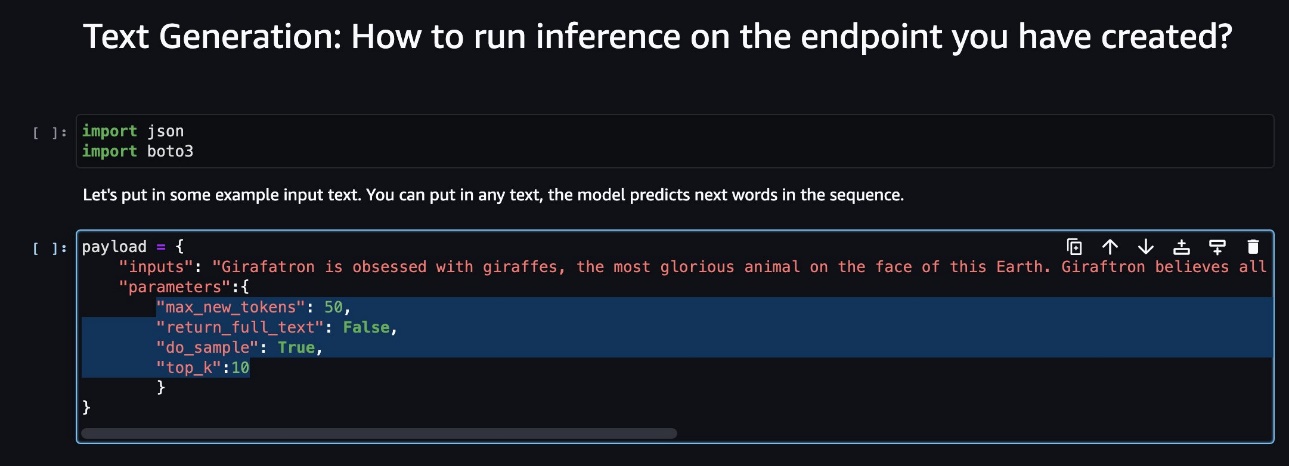

- Na konzoli prenosnega računalnika poiščite parametre tovora.

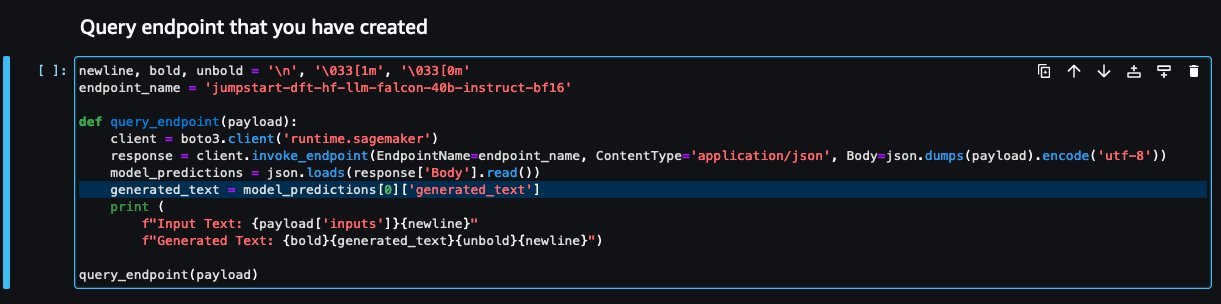

To so polja, ki jih pričakuje novi model, ko prikliče svojo končno točko SageMaker. Naslednji posnetek zaslona prikazuje primer.

- Na konzoli Lambda se pomaknite do

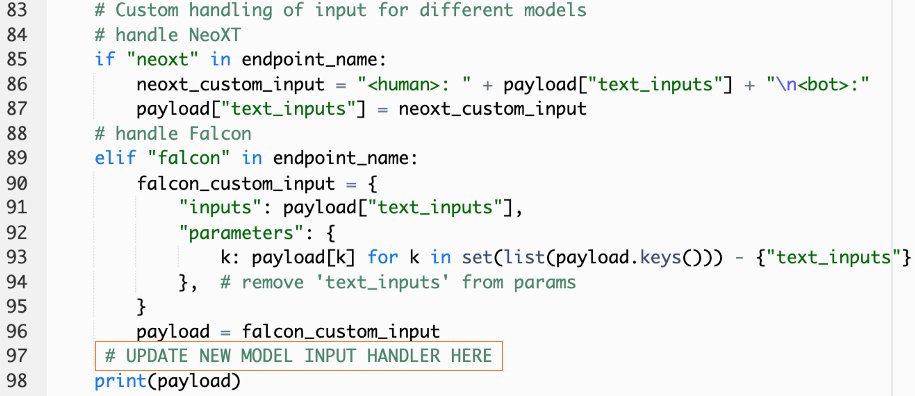

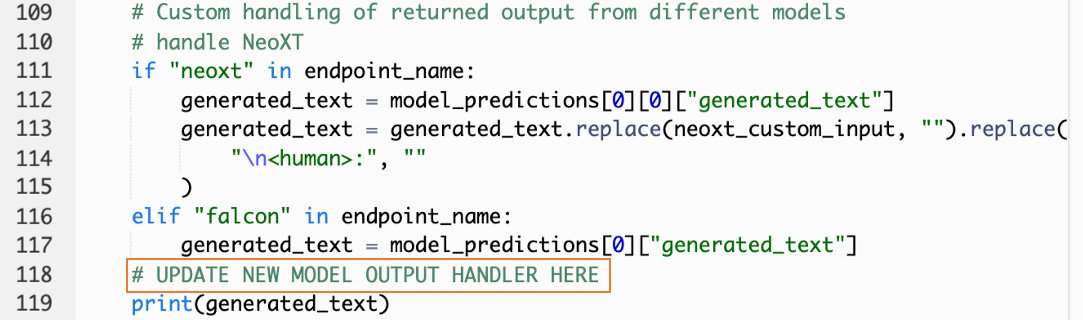

callSageMakerEndpoints. - Dodajte obravnavo vnosa po meri za svoj novi model.

Na naslednjem posnetku zaslona smo preoblikovali vnos za Falcon 40B Instruct BF16 in GPT NeoXT Chat Base 20B FP16. Svojo logiko parametrov po meri lahko vstavite, kot je navedeno, da dodate logiko pretvorbe vnosa s sklicevanjem na parametre koristnega tovora, ki ste jih kopirali.

- Vrnite se na konzolo prenosnega računalnika in poiščite

query_endpoint.

Ta funkcija vam daje idejo, kako preoblikovati izhod modelov, da izluščite končni besedilni odgovor.

- S sklicevanjem na kodo v

query_endpoint, dodajte obravnavo izhoda po meri za vaš novi model.

- Izberite Razporeditev.

- Odprite svoj IDE, zaženite

react-llm-chat-studiokodo in se pomaknite dosrc/configs/models.json. - Dodajte ime modela in končno točko modela ter vnesite parametre tovora iz 4. koraka pod

payloadv naslednji obliki: - Osvežite brskalnik, da začnete komunicirati s svojim novim modelom!

Razmestite aplikacijo z uporabo Amplify

Amplify je celovita rešitev, ki vam omogoča hitro in učinkovito uvajanje vaše aplikacije. V tem razdelku so opisani koraki za uvedbo Chat Studio v Amazon CloudFront distribucijo z uporabo Amplify, če želite svojo aplikacijo deliti z drugimi uporabniki.

- Pomaknite se na

react-llm-chat-studiokodno mapo, ki ste jo ustvarili prej. - V terminal vnesite naslednje ukaze in sledite navodilom za namestitev:

- Inicializirajte nov projekt Amplify z naslednjim ukazom. Vnesite ime projekta, sprejmite privzete konfiguracije in izberite Ključi za dostop do AWS ko vas pozove, da izberete način preverjanja pristnosti.

- Gostite projekt Amplify z naslednjim ukazom. Izberite Amazon CloudFront in S3 ko boste pozvani, da izberete način vtičnika.

- Končno zgradite in razmestite projekt z naslednjim ukazom:

- Ko je uvedba uspešna, odprite navedeni URL v brskalniku in začnite komunicirati s svojimi modeli!

Čiščenje

Če se želite izogniti prihodnjim stroškom, izvedite naslednje korake:

- Izbrišite sklad CloudFormation. Za navodila glejte Brisanje sklada na konzoli AWS CloudFormation.

- Izbrišite končno točko SageMaker JumpStart. Za navodila glejte Izbrišite končne točke in vire.

- Izbrišite domeno SageMaker. Za navodila glejte Izbrišite domeno Amazon SageMaker.

zaključek

V tej objavi smo razložili, kako ustvariti spletni uporabniški vmesnik za povezovanje z LLM-ji, nameščenimi na AWS.

S to rešitvijo lahko sodelujete s svojim LLM in vodite pogovor na uporabniku prijazen način, da preizkusite ali zastavite vprašanja LLM ter po potrebi dobite kolaž slik in videoposnetkov.

To rešitev lahko razširite na različne načine, na primer z integracijo dodatnih modelov temeljev, integrirati z Amazon Kendra da omogočite inteligentno iskanje, ki ga poganja ML, za razumevanje poslovne vsebine in še več!

Vabimo vas k eksperimentiranju različni predhodno usposobljeni LLM, ki so na voljo na AWS, nadgradite ali celo ustvarite svoje LLM v SageMakerju. Sporočite nam svoja vprašanja in ugotovitve v komentarjih in se zabavajte!

O avtorjih

Jarrett Yeo Shan Wei je pridruženi arhitekt oblaka v AWS Professional Services, ki pokriva javni sektor po vsej ASEAN, in je zagovornik pomoči strankam pri posodobitvi in selitvi v oblak. Pridobil je pet certifikatov AWS, na 8. mednarodni konferenci o umetni inteligenci pa je objavil tudi raziskovalno nalogo o sklopih strojev za povečanje gradienta. V prostem času se Jarrett osredotoča na generativno AI sceno v AWS in prispeva k njej.

Jarrett Yeo Shan Wei je pridruženi arhitekt oblaka v AWS Professional Services, ki pokriva javni sektor po vsej ASEAN, in je zagovornik pomoči strankam pri posodobitvi in selitvi v oblak. Pridobil je pet certifikatov AWS, na 8. mednarodni konferenci o umetni inteligenci pa je objavil tudi raziskovalno nalogo o sklopih strojev za povečanje gradienta. V prostem času se Jarrett osredotoča na generativno AI sceno v AWS in prispeva k njej.

Tammy Lim Lee Xin je pridruženi arhitekt v oblaku pri AWS. Uporablja tehnologijo za pomoč strankam pri doseganju želenih rezultatov na njihovi poti sprejemanja oblaka in je navdušena nad AI/ML. Izven službe obožuje potovanja, pohodništvo in preživljanje časa z družino in prijatelji.

Tammy Lim Lee Xin je pridruženi arhitekt v oblaku pri AWS. Uporablja tehnologijo za pomoč strankam pri doseganju želenih rezultatov na njihovi poti sprejemanja oblaka in je navdušena nad AI/ML. Izven službe obožuje potovanja, pohodništvo in preživljanje časa z družino in prijatelji.

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- PlatoHealth. Obveščanje o biotehnologiji in kliničnih preskušanjih. Dostopite tukaj.

- vir: https://aws.amazon.com/blogs/machine-learning/create-a-web-ui-to-interact-with-llms-using-amazon-sagemaker-jumpstart/

- :ima

- : je

- $GOR

- 1

- 10

- 120

- 160

- 2021

- 3000

- 320

- 7

- 8

- 8.

- a

- Sposobna

- O meni

- Sprejmi

- dostop

- potrditi

- čez

- dodajte

- Dodatne

- Sprejetje

- zagovornik

- po

- AI

- AI / ML

- vsi

- omogoča

- skupaj

- Prav tako

- Amazon

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- okrepiti

- an

- in

- API

- uporaba

- odobren

- Arhitektura

- SE

- Umetnost

- umetni

- Umetna inteligenca

- AS

- Asean

- vprašati

- Sredstva

- Sodelavec

- At

- doseženi

- Preverjanje pristnosti

- razpoložljivost

- Na voljo

- izogniti

- AWS

- Oblikovanje oblaka AWS

- Strokovne storitve AWS

- bar

- baza

- temeljijo

- Osnovni

- BE

- ker

- BEST

- najboljše prakse

- Boljše

- povečanje

- Pasovi

- široka

- brskalnik

- izgradnjo

- by

- klic

- poziva

- CAN

- Lahko dobiš

- Zmogljivosti

- zmožnost

- Zajeto

- primeri

- certifikati

- Spremembe

- Stroški

- klepetalnice

- ChatGPT

- izbira

- Izberite

- Razvrstitev

- tesno

- Cloud

- sprejem v oblak

- Koda

- komentarji

- dokončanje

- Konferenca

- konfiguracija

- povezava

- Konzole

- vsebina

- prispeva

- Pogovor

- pogovorni

- pogovorni AI

- Ustrezno

- pokrov

- kritje

- ustvarjajo

- ustvaril

- Ustvarjanje

- radovedna

- po meri

- Stranke, ki so

- datum

- globoko

- globoko učenje

- privzeto

- poda

- Odvisno

- razporedi

- razporejeni

- uvajanja

- uvajanje

- razpolaga

- opis

- Oblikovanje

- želeno

- Podrobnosti

- Razvijalci

- drugačen

- Difuzija

- digitalni

- digitalna umetnost

- prikazano

- distribucija

- domena

- prenesi

- prej

- enostavnost

- učinkovito

- omogočajo

- konec

- Končna točka

- okrepi

- obogatiti

- Vnesite

- Podjetje

- okolje

- Tudi

- Tudi vsak

- Primer

- Primeri

- pričakuje

- drago

- izkušnje

- poskus

- razložiti

- razširiti

- Se razširi

- ekstrakt

- družina

- Feature

- Nekaj

- Področja

- file

- končna

- Najdi

- Ugotovitve

- pet

- Osredotoča

- sledi

- po

- za

- format

- gojenje

- Fundacija

- temeljno

- brezplačno

- prijatelji

- iz

- v celoti

- funkcija

- nadalje

- Prihodnost

- splošno

- splošni podatki

- ustvarjajo

- generativno

- Generativna AI

- dobili

- daje

- Cilji

- Imajo

- he

- pomoč

- pomoč

- njegov

- držite

- gostovanje

- URE

- Kako

- Kako

- HTML

- http

- HTTPS

- Ljudje

- Stotine

- Ideja

- identiteta

- if

- slike

- domišljija

- izvajati

- izboljšalo

- in

- vključujejo

- Povečajte

- naveden

- vhod

- namestitev

- nameščen

- Namestitev

- primer

- Inštitut

- Navodila

- integrirati

- integracije

- Intelligence

- Inteligentna

- interakcijo

- medsebojno delovanje

- interakcije

- vmesnik

- Facebook Global

- v

- povabi

- ITS

- Potovanje

- jpg

- samo

- samo en

- Ključne

- Vedite

- znanje

- jezik

- velika

- kosilo

- začetek

- učenje

- Lee

- Naj

- kot

- vrstica

- Llama

- LLM

- lokalna

- Logika

- Poglej

- izgleda kot

- ljubi

- stroj

- strojno učenje

- upravlja

- Način

- Maj ..

- pomenilo

- mediji

- Srečati

- Meni

- Metoda

- selitev

- ML

- način

- Model

- modeli

- posodobiti

- več

- več

- morajo

- Ime

- Krmarjenje

- ostalo

- potrebno

- Nimate

- mreža

- Živčne

- nevronska mreža

- Novo

- novi izdelki

- na novo

- Vozel

- Node.js

- Upoštevajte

- prenosnik

- pridobljeni

- of

- on

- ONE

- odprite

- open source

- možnosti

- or

- Ostalo

- rezultatov

- izhod

- zunaj

- pregled

- lastne

- Stran

- podokno

- Papir

- parameter

- parametri

- strastno

- Dovoljenja

- platon

- Platonova podatkovna inteligenca

- PlatoData

- vključiti

- Popular

- Priljubljenost

- Prispevek

- poganja

- vaje

- prednostno

- predpogoji

- privilegiji

- Procesi

- Izdelki

- strokovni

- Projekt

- lastniško

- zagotavljajo

- če

- ponudniki

- zagotavlja

- javnega

- objavljeno

- Python

- vprašanja

- Hitri

- hitro

- dvigniti

- območje

- pravo

- glejte

- reference

- pomembno

- zahteva

- zahteva

- obvezna

- Raziskave

- spominja

- viri

- Odgovor

- vrnitev

- Rise

- Run

- sagemaker

- Zadovoljstvo

- Prizor

- praska

- galerija

- Iskalnik

- skrivnost

- Oddelek

- sektor

- glej

- izberite

- Občutek

- služijo

- Storitev

- Storitve

- nastavite

- Kompleti

- nastavitev

- Delite s prijatelji, znanci, družino in partnerji :-)

- je

- shouldnt

- Prikaži

- Razstave

- delček

- Rešitev

- nekaj

- vir

- Poraba

- stabilna

- sveženj

- standardna

- Stanford

- Začetek

- začel

- Status

- Korak

- Koraki

- shranjevanje

- studio

- taka

- dovolj

- Bodite

- meni

- Tehnologija

- Predloga

- terminal

- Test

- besedilo

- Razvrstitev besedil

- da

- O

- njihove

- POTEM

- te

- jih

- tretjih oseb

- ta

- čeprav?

- skozi

- čas

- do

- vrh

- Vlak

- usposobljeni

- usposabljanje

- Transform

- Preoblikovanje

- preoblikovati

- tip

- ui

- pod

- razumevanje

- URL

- us

- Uporaba

- uporaba

- uporabnik

- Uporabniška izkušnja

- Uporabniški vmesnik

- Uporabniku prijazen

- Uporabniki

- uporablja

- uporabo

- vrednost

- različnih

- Video posnetki

- sprehod

- sprehodi

- načini

- we

- web

- spletne storitve

- Kaj

- kdaj

- ki

- WHO

- široka

- Širok spekter

- bo

- želijo

- z

- delo

- potek dela

- pisati

- ja

- Vi

- Vaša rutina za

- zefirnet