Ko organizacije uvajajo modele v proizvodnjo, nenehno iščejo načine za optimizacijo delovanja svojih temeljnih modelov (FM), ki delujejo na najnovejših pospeševalnikih, kot je npr. Sklepanje AWS in grafičnih procesorjev, tako da lahko zmanjšajo svoje stroške in skrajšajo zakasnitev odziva ter tako končnim uporabnikom zagotovijo najboljšo izkušnjo. Vendar nekateri FM ne izkoristijo v celoti pospeševalnikov, ki so na voljo s primerki, na katerih so nameščeni, kar vodi do neučinkovite uporabe virov strojne opreme. Nekatere organizacije uvedejo več FM-jev v isto instanco, da bolje izkoristijo vse razpoložljive pospeševalnike, vendar to zahteva zapleteno orkestracijo infrastrukture, ki je zamudna in jo je težko upravljati. Ko si več FM-jev deli isti primerek, ima vsak FM svoje potrebe po skaliranju in vzorce uporabe, zaradi česar je težko predvideti, kdaj morate dodati ali odstraniti primerke. Na primer, en model se lahko uporablja za napajanje uporabniške aplikacije, kjer lahko uporaba v določenih urah močno naraste, medtem ko ima lahko drug model bolj dosleden vzorec uporabe. Poleg optimizacije stroškov želijo stranke zagotoviti najboljšo izkušnjo končnemu uporabniku z zmanjšanjem zakasnitve. Da bi to naredili, pogosto vzporedno namestijo več kopij FM na terenske zahteve uporabnikov. Ker se izhodi FM lahko gibljejo od enega stavka do več odstavkov, se čas, potreben za dokončanje zahteve za sklepanje, močno razlikuje, kar vodi do nepredvidljivih skokov v zakasnitvi, če so zahteve naključno usmerjene med primerki. Amazon SageMaker zdaj podpira nove zmožnosti sklepanja, ki vam pomagajo zmanjšati stroške uvajanja in zakasnitev.

Zdaj lahko ustvarite končne točke, ki temeljijo na komponentah sklepanja, in uvedete modele strojnega učenja (ML) v končno točko SageMaker. Komponenta sklepanja (IC) abstrahira vaš model ML in vam omogoča, da dodelite CPE, GPE ali AWS nevron pospeševalnike in politike skaliranja na model. Komponente sklepanja ponujajo naslednje prednosti:

- SageMaker bo optimalno namestil in zapakiral modele na primerke ML, da bo povečal izkoristek, kar bo prihranilo stroške.

- SageMaker bo prilagodil velikost vsakega modela navzgor in navzdol glede na vašo konfiguracijo, da bo izpolnil zahteve vaše aplikacije ML.

- SageMaker se bo prilagajal za dinamično dodajanje in odstranjevanje primerkov, da bo zagotovil razpoložljivo zmogljivost, medtem ko bo nedejavno računanje čim manjše.

- Model lahko zmanjšate na nič kopij, da sprostite vire za druge modele. Določite lahko tudi, da bodo pomembni modeli vedno naloženi in pripravljeni za oskrbo prometa.

S temi zmogljivostmi lahko znižate stroške uvajanja modela v povprečju za 50 %. Prihranek stroškov se bo razlikoval glede na vašo delovno obremenitev in prometne vzorce. Vzemimo preprost primer za ponazoritev, kako lahko pakiranje več modelov na eno končno točko poveča izkoristek in prihrani stroške. Recimo, da imate aplikacijo za klepet, ki turistom pomaga razumeti lokalne navade in najboljše prakse, zgrajeno z uporabo dveh različic Llame 2: ena je natančno prilagojena za evropske obiskovalce in druga je natančno prilagojena za ameriške obiskovalce. Pričakujemo promet za evropski model med 00:01–11:59 UTC in ameriški model med 12:00–23:59 UTC. Namesto da bi te modele uvedli na lastnih namenskih instancah, kjer bodo polovico časa mirovali, jih lahko zdaj uvedete na eno končno točko, da prihranite stroške. Ameriški model lahko zmanjšate na nič, ko ni potreben za sprostitev zmogljivosti za evropski model in obratno. To vam omogoča učinkovito uporabo strojne opreme in izogibanje odpadkom. To je preprost primer z uporabo dveh modelov, vendar lahko to zamisel enostavno razširite tako, da zapakirate na stotine modelov na eno samo končno točko, ki se samodejno poveča in zmanjša z vašo delovno obremenitvijo.

V tej objavi vam pokažemo nove zmožnosti končnih točk SageMaker, ki temeljijo na IC. Vodimo vas tudi skozi uvajanje več modelov z uporabo komponent sklepanja in API-jev. Nazadnje podrobno opisujemo nekatere nove zmožnosti opazovanja in kako nastaviti pravilnike o samodejnem skaliranju za vaše modele ter upravljati skaliranje primerkov za vaše končne točke. Modele lahko uvedete tudi prek naše nove poenostavljene, interaktivne uporabniške izkušnje. Podpiramo tudi napredne zmožnosti usmerjanja za optimizacijo zakasnitve in učinkovitosti vaših sklepnih delovnih obremenitev.

Gradniki

Poglejmo si globlje in razumejmo, kako te nove zmogljivosti delujejo. Sledi nekaj nove terminologije za gostovanje SageMaker:

- Komponenta sklepanja – Objekt gostovanja SageMaker, ki ga lahko uporabite za razmestitev modela na končno točko. Komponento sklepanja lahko ustvarite tako, da podate naslednje:

- Model SageMaker ali specifikacija slike in artefaktov modela, združljive s SageMaker.

- Zahteve za računske vire, ki določajo potrebe vsake kopije vašega modela, vključno z jedri CPE, pomnilnikom gostitelja in številom pospeševalnikov.

- Kopija modela – Kopija izvajalnega okolja komponente sklepanja, ki je zmožna streči zahtevam.

- Samodejno skaliranje upravljanega primerka – Zmogljivost gostovanja SageMaker za povečanje ali zmanjšanje števila računskih primerkov, ki se uporabljajo za končno točko. Merjenje primerkov se odziva na skaliranje komponent sklepanja.

Če želite ustvariti novo komponento sklepanja, lahko podate sliko vsebnika in artefakt modela ali pa uporabite modele SageMaker, ki ste jih morda že ustvarili. Določiti morate tudi zahteve za računalniške vire, kot je število jeder gostiteljskega procesorja, pomnilnik gostitelja ali število pospeševalnikov, ki jih mora zagnati vaš model.

Ko razmestite komponento sklepanja, lahko podate MinCopies da zagotovite, da je model že naložen v količini, ki jo zahtevate, pripravljen za izpolnitev zahtev.

Imate tudi možnost, da svoje pravilnike nastavite tako, da se kopije komponente sklepanja zmanjšajo na nič. Na primer, če nimate obremenitve, ki teče proti IC, bo kopija modela razložena. To lahko sprosti vire, ki jih je mogoče nadomestiti z aktivnimi delovnimi obremenitvami za optimizacijo uporabe in učinkovitosti vaše končne točke.

Ko se zahteve za sklepanje povečajo ali zmanjšajo, se lahko število kopij vaših IC-jev poveča ali zmanjša glede na vaše pravilnike o samodejnem skaliranju. SageMaker bo skrbel za namestitev, da optimizira pakiranje vaših modelov glede na razpoložljivost in ceno.

Poleg tega, če omogočite samodejno skaliranje upravljanih primerkov, bo SageMaker prilagodil računske primerke glede na število komponent sklepanja, ki jih je treba naložiti v določenem času, da služijo prometu. SageMaker bo razširil instance in zapakiral vaše instance in komponente sklepanja, da bo optimiziral stroške in hkrati ohranil zmogljivost modela. Čeprav priporočamo uporabo upravljanega skaliranja instance, imate tudi možnost, da sami upravljate skaliranje, če se tako odločite, prek samodejnega skaliranja aplikacije.

SageMaker bo znova uravnotežil komponente sklepanja in zmanjšal primerke, če jih komponente sklepanja ne potrebujejo več, ter prihranil vaše stroške.

Predstavitev API-jev

SageMaker je predstavil novo entiteto, imenovano InferenceComponent. To loči podrobnosti gostovanja modela ML od same končne točke. The InferenceComponent vam omogoča, da določite ključne lastnosti za gostovanje modela, kot je model SageMaker, ki ga želite uporabiti, ali podrobnosti vsebnika in artefakte modela. Določite tudi število kopij samih komponent za uvedbo in število potrebnih pospeševalnikov (GPE, Inf ali Trn) ali CPE (vCPE). To vam omogoča večjo prilagodljivost pri uporabi ene končne točke za poljubno število modelov, ki jih nameravate vanjo namestiti v prihodnosti.

Oglejmo si klice API-ja Boto3 za ustvarjanje končne točke s komponento sklepanja. Upoštevajte, da obstaja nekaj parametrov, ki jih obravnavamo kasneje v tej objavi.

Sledi primer kode za CreateEndpointConfig:

Sledi primer kode za CreateEndpoint:

Sledi primer kode za CreateInferenceComponent:

Ta ločitev od InferenceComponent do končne točke zagotavlja prilagodljivost. Na isti infrastrukturi lahko gostite več modelov in jih dodate ali odstranite, ko se spremenijo vaše zahteve. Vsak model je mogoče po potrebi posodobiti neodvisno. Poleg tega lahko modele prilagodite svojim poslovnim potrebam. InferenceComponent omogoča tudi nadzor nad zmogljivostjo na model. Z drugimi besedami, lahko določite, koliko kopij vsakega modela želite gostiti. To predvidljivo skaliranje vam pomaga izpolniti posebne zahteve glede zakasnitve za vsak model. Na splošno, InferenceComponent vam daje veliko več nadzora nad gostujočimi modeli.

V naslednji tabeli prikazujemo vzporedno primerjavo pristopa na visoki ravni za ustvarjanje in priklic končne točke brez InferenceComponent in InferenceComponent. Upoštevajte, da je CreateModel() zdaj neobvezen za končne točke, ki temeljijo na IC.

| Korak | Končne točke na podlagi modela | Končne točke na podlagi sklepanja |

| 1 | Ustvarimodel(…) | CreateEndpointConfig(…) |

| 2 | CreateEndpointConfig(…) | Ustvari končno točko (…) |

| 3 | Ustvari končno točko (…) | CreateInferenceComponent(…) |

| 4 | InvokeEndpoint(…) | InvokeEndpoint(InferneceComponentName='value'…) |

Uvedba InferenceComponent allows you to scale at a model level. See Delve into instance and IC auto scaling for more details on how InferenceComponent works with auto scaling.

Ko prikličete končno točko SageMaker, lahko zdaj določite nov parameter InferenceComponentName zadeti želeno InferenceComponentName. SageMaker bo obravnaval usmerjanje zahteve do instance, ki gosti zahtevano InferenceComponentName. Glej naslednjo kodo:

SageMaker privzeto uporablja naključno usmerjanje zahtev do primerkov, ki podpirajo vašo končno točko. Če želite omogočiti usmerjanje najmanj odprtih zahtev, lahko nastavite strategijo usmerjanja v konfiguraciji končne točke RoutingConfig:

Najmanj odprte zahteve usmerjajo poti do določenih primerkov, ki imajo več zmogljivosti za obdelavo zahtev. To bo zagotovilo bolj enakomerno uravnoteženje obremenitve in uporabo virov.

Poleg CreateInferenceComponent, so zdaj na voljo naslednji API-ji:

DescribeInferenceComponentDeleteInferenceComponentUpdateInferenceComponentListInferenceComponents

Dnevniki in meritve InferenceComponent

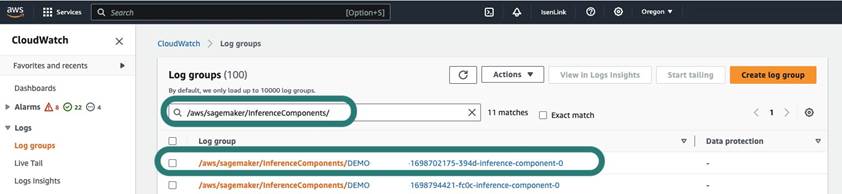

InferenceComponent logi se nahajajo v /aws/sagemaker/InferenceComponents/<InferenceComponentName>. Vsi dnevniki, poslani v stderr in stdout v vsebniku, so poslani v te dnevnike amazoncloudwatch.

Z uvedbo končnih točk, ki temeljijo na IC, imate zdaj možnost ogleda dodatnih metrik primerkov, metrik komponent sklepanja in metrik klicev.

Za primerke SageMaker lahko zdaj sledite GPUReservation in CPUReservation metrike za ogled virov, rezerviranih za končno točko na podlagi komponent sklepanja, ki ste jih razmestili. Te metrike vam lahko pomagajo določiti vašo končno točko in pravilnike o samodejnem skaliranju. Ogledate si lahko tudi združene metrike, povezane z vsemi modeli, razporejenimi na končno točko.

SageMaker razkrije tudi metrike na ravni komponente sklepanja, ki lahko prikaže bolj podroben pogled na uporabo virov za komponente sklepanja, ki ste jih razmestili. To vam omogoča, da dobite vpogled v to, koliko skupne uporabe virov, kot je npr GPUUtilizationNormalized in GPUMemoryUtilizationNormalized za vsako komponento sklepanja, ki ste jo razmestili in ima lahko nič ali veliko kopij.

Nazadnje, SageMaker zagotavlja meritve klicev, ki zdaj agregatno sledijo klicem za komponente sklepanja (Invocations) ali na primerljivo kopijo (InvocationsPerCopy)

Za izčrpen seznam meritev glejte Meritve priklica končne točke SageMaker.

Samodejno skaliranje na ravni modela

Za implementacijo vedenja samodejnega skaliranja, ki smo ga opisali, pri ustvarjanju konfiguracije končne točke SageMaker in komponente sklepanja določite začetno število primerkov oziroma začetno število kopij modela. Ko ustvarite končno točko in ustrezne IC, morate za uporabo samodejnega skaliranja na ravni IC najprej registrirati cilj skaliranja in nato povezati politiko skaliranja z IC.

Pri izvajanju politike skaliranja uporabljamo SageMakerInferenceComponentInvocationsPerCopy, ki je nova metrika, ki jo je predstavil SageMaker. Zajame povprečno število klicev na kopijo modela na minuto.

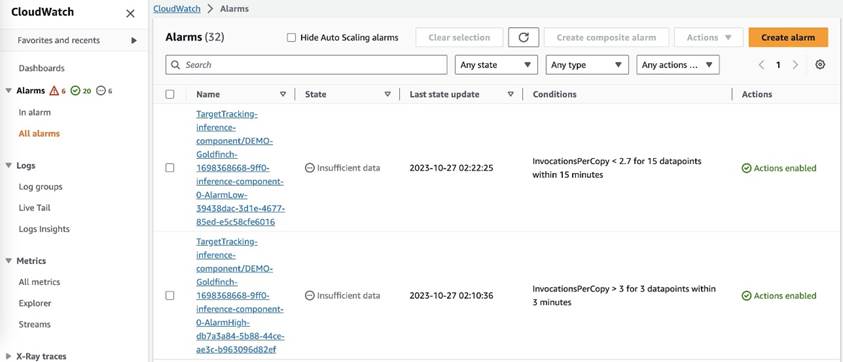

Ko nastavite pravilnik skaliranja, SageMaker ustvari dva alarma CloudWatch za vsak cilj samodejnega skaliranja: enega za sprožitev skaliranja, če je v alarmu 3 minute (tri 1-minutne podatkovne točke), in enega za sprožitev skaliranja, če je alarm 15 minut (15 1-minutnih podatkovnih točk), kot je prikazano na naslednjem posnetku zaslona. Čas za sprožitev dejanja skaliranja je običajno 1–2 minuti daljši od teh minut, ker končna točka potrebuje čas, da objavi meritve v CloudWatch, in prav tako potrebuje čas za AutoScaling reagirati. Obdobje ohlajanja je čas v sekundah po zaključku dejavnosti povečanja ali povečanja, preden se lahko začne druga dejavnost povečanja. Če je ohlajanje po obsegu krajše od časa posodobitve končne točke, nima učinka, ker končne točke SageMaker ni mogoče posodobiti, ko je v Posodabljanje Status.

Upoštevajte, da se morate pri nastavljanju samodejnega skaliranja na ravni IC prepričati, da je MaxInstanceCount enak ali manjši od največjega števila IC-jev, ki jih ta končna točka lahko obravnava. Na primer, če je vaša končna točka konfigurirana samo za en primerek v konfiguraciji končne točke in lahko ta primerek gosti največ štiri kopije modela, potem MaxInstanceCount mora biti enako ali manjše od 4. Lahko pa uporabite tudi zmožnost upravljanega samodejnega skaliranja, ki ga nudi SageMaker, za samodejno skaliranje števila primerkov na podlagi zahtevanega števila kopij modela, da zadostite potrebi po več računalniških virih. Naslednji delček kode prikazuje, kako nastaviti skaliranje upravljanega primerka med ustvarjanjem konfiguracije končne točke. Na ta način, ko samodejno skaliranje na ravni IC zahteva večje število instanc za gostovanje kopij modela, bo SageMaker samodejno zmanjšal število instanc, da bo skaliranje na ravni IC uspešno.

Uporabite lahko več pravilnikov samodejnega skaliranja za isto končno točko, kar pomeni, da boste lahko uporabili tradicionalni pravilnik samodejnega skaliranja za končne točke, ustvarjene z IC-ji, in povečali in zmanjšali na podlagi drugih meritev končne točke. Za več informacij glejte Optimizirajte svoje uvedbe strojnega učenja s samodejnim skaliranjem na Amazon SageMaker. Vendar, čeprav je to mogoče, še vedno priporočamo uporabo skaliranja upravljane instance, namesto da sami upravljate skaliranje.

zaključek

V tej objavi smo predstavili novo funkcijo v sklepanju SageMaker, ki vam bo pomagala povečati izrabo računalniških primerkov, prilagoditi na stotine modelov in optimizirati stroške, hkrati pa zagotavljati predvidljivo delovanje. Poleg tega smo zagotovili predstavitev API-jev in vam pokazali, kako konfigurirati in uvesti komponente sklepanja za vaše delovne obremenitve.

Podpiramo tudi napredne zmogljivosti usmerjanja da optimizirate zakasnitev in zmogljivost vaših sklepnih delovnih obremenitev. SageMaker vam lahko pomaga optimizirati delovne obremenitve sklepanja glede stroškov in zmogljivosti ter vam zagotovi razdrobljenost na ravni modela za upravljanje. Ustvarili smo a komplet zvezkov ki vam bo pokazal, kako razmestiti tri različne modele z uporabo različnih vsebnikov in uporabo politik samodejnega skaliranja v GitHubu. Spodbujamo vas, da začnete z prenosnim računalnikom 1 in se še danes lotite novih zmogljivosti gostovanja SageMaker!

O avtorjih

James Park je arhitekt rešitev pri Amazon Web Services. Sodeluje z Amazon.com pri oblikovanju, gradnji in uvajanju tehnoloških rešitev na AWS, posebej pa ga zanimata umetna inteligenca in strojno učenje. V prostem času uživa v iskanju novih kultur, novih izkušenj in spremljanju najnovejših tehnoloških trendov. Najdete ga na LinkedIn.

James Park je arhitekt rešitev pri Amazon Web Services. Sodeluje z Amazon.com pri oblikovanju, gradnji in uvajanju tehnoloških rešitev na AWS, posebej pa ga zanimata umetna inteligenca in strojno učenje. V prostem času uživa v iskanju novih kultur, novih izkušenj in spremljanju najnovejših tehnoloških trendov. Najdete ga na LinkedIn.

Melanie Li, PhD, je višji strokovnjak za AI/ML TAM pri AWS s sedežem v Sydneyju v Avstraliji. Pomaga poslovnim strankam zgraditi rešitve z uporabo najsodobnejših orodij AI/ML na AWS in zagotavlja smernice za arhitekturo in implementacijo rešitev ML z najboljšimi praksami. V prostem času rada raziskuje naravo in preživlja čas z družino in prijatelji.

Melanie Li, PhD, je višji strokovnjak za AI/ML TAM pri AWS s sedežem v Sydneyju v Avstraliji. Pomaga poslovnim strankam zgraditi rešitve z uporabo najsodobnejših orodij AI/ML na AWS in zagotavlja smernice za arhitekturo in implementacijo rešitev ML z najboljšimi praksami. V prostem času rada raziskuje naravo in preživlja čas z družino in prijatelji.

Marc Karp je arhitekt ML pri ekipi Amazon SageMaker Service. Osredotoča se na pomoč strankam pri načrtovanju, uvajanju in upravljanju delovnih obremenitev ML v velikem obsegu. V prostem času rad potuje in raziskuje nove kraje.

Marc Karp je arhitekt ML pri ekipi Amazon SageMaker Service. Osredotoča se na pomoč strankam pri načrtovanju, uvajanju in upravljanju delovnih obremenitev ML v velikem obsegu. V prostem času rad potuje in raziskuje nove kraje.

Alan Tan je višji produktni vodja pri podjetju SageMaker, ki vodi prizadevanja za sklepanje velikih modelov. Navdušen je nad uporabo strojnega učenja na področju analitike. Izven dela uživa na prostem.

Alan Tan je višji produktni vodja pri podjetju SageMaker, ki vodi prizadevanja za sklepanje velikih modelov. Navdušen je nad uporabo strojnega učenja na področju analitike. Izven dela uživa na prostem.

Raghu Ramesha je višji arhitekt rešitev ML pri ekipi storitve Amazon SageMaker. Osredotoča se na pomoč strankam pri izgradnji, uvajanju in selitvi proizvodnih delovnih obremenitev ML na SageMaker v velikem obsegu. Specializiran je za področje strojnega učenja, umetne inteligence in računalniškega vida ter ima magisterij iz računalništva na UT Dallas. V prostem času rada potuje in fotografira.

Raghu Ramesha je višji arhitekt rešitev ML pri ekipi storitve Amazon SageMaker. Osredotoča se na pomoč strankam pri izgradnji, uvajanju in selitvi proizvodnih delovnih obremenitev ML na SageMaker v velikem obsegu. Specializiran je za področje strojnega učenja, umetne inteligence in računalniškega vida ter ima magisterij iz računalništva na UT Dallas. V prostem času rada potuje in fotografira.

Rupinder Grewal je Sr Ai/ML Specialist Solutions Architect pri AWS. Trenutno se osredotoča na streženje modelov in MLO na SageMakerju. Pred to vlogo je delal kot inženir strojnega učenja za gradnjo in gostovanje modelov. Izven službe rad igra tenis in kolesari po gorskih poteh.

Rupinder Grewal je Sr Ai/ML Specialist Solutions Architect pri AWS. Trenutno se osredotoča na streženje modelov in MLO na SageMakerju. Pred to vlogo je delal kot inženir strojnega učenja za gradnjo in gostovanje modelov. Izven službe rad igra tenis in kolesari po gorskih poteh.

Dhawal Patel je glavni arhitekt strojnega učenja pri AWS. Sodeloval je z organizacijami, od velikih podjetij do srednje velikih zagonskih podjetij, pri problemih, povezanih s porazdeljenim računalništvom in umetno inteligenco. Osredotoča se na poglobljeno učenje, vključno s področja NLP in računalniškega vida. Strankam pomaga doseči visoko zmogljivo sklepanje o modelih na SageMakerju.

Dhawal Patel je glavni arhitekt strojnega učenja pri AWS. Sodeloval je z organizacijami, od velikih podjetij do srednje velikih zagonskih podjetij, pri problemih, povezanih s porazdeljenim računalništvom in umetno inteligenco. Osredotoča se na poglobljeno učenje, vključno s področja NLP in računalniškega vida. Strankam pomaga doseči visoko zmogljivo sklepanje o modelih na SageMakerju.

Saurabh Trikande je višji produktni vodja za Amazon SageMaker Inference. Navdušen je nad delom s strankami in ga motivira cilj demokratizacije strojnega učenja. Osredotoča se na ključne izzive, povezane z uvajanjem kompleksnih aplikacij ML, modelov ML z več najemniki, optimizacijo stroškov in zagotavljanjem dostopnosti uvajanja modelov globokega učenja. V prostem času Saurabh uživa v pohodništvu, spoznavanju inovativnih tehnologij, spremlja TechCrunch in preživlja čas s svojo družino.

Saurabh Trikande je višji produktni vodja za Amazon SageMaker Inference. Navdušen je nad delom s strankami in ga motivira cilj demokratizacije strojnega učenja. Osredotoča se na ključne izzive, povezane z uvajanjem kompleksnih aplikacij ML, modelov ML z več najemniki, optimizacijo stroškov in zagotavljanjem dostopnosti uvajanja modelov globokega učenja. V prostem času Saurabh uživa v pohodništvu, spoznavanju inovativnih tehnologij, spremlja TechCrunch in preživlja čas s svojo družino.

Lakshmi Ramakrishnan je glavni inženir v skupini za platformo Amazon SageMaker Machine Learning (ML) v AWS in zagotavlja tehnično vodstvo za izdelek. Več kot 9 let je delal v več inženirskih vlogah v Amazonu. Diplomiral je iz informacijske tehnologije na Nacionalnem inštitutu za tehnologijo v Karnataki v Indiji in magistriral iz računalništva na Univerzi v Minnesoti Twin Cities.

Lakshmi Ramakrishnan je glavni inženir v skupini za platformo Amazon SageMaker Machine Learning (ML) v AWS in zagotavlja tehnično vodstvo za izdelek. Več kot 9 let je delal v več inženirskih vlogah v Amazonu. Diplomiral je iz informacijske tehnologije na Nacionalnem inštitutu za tehnologijo v Karnataki v Indiji in magistriral iz računalništva na Univerzi v Minnesoti Twin Cities.

David Nigenda je višji inženir za razvoj programske opreme v ekipi Amazon SageMaker, ki trenutno dela na izboljšanju delovnih tokov produkcijskega strojnega učenja in uvaja nove funkcije sklepanja. V prostem času poskuša biti v koraku s svojimi otroki.

David Nigenda je višji inženir za razvoj programske opreme v ekipi Amazon SageMaker, ki trenutno dela na izboljšanju delovnih tokov produkcijskega strojnega učenja in uvaja nove funkcije sklepanja. V prostem času poskuša biti v koraku s svojimi otroki.

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- PlatoHealth. Obveščanje o biotehnologiji in kliničnih preskušanjih. Dostopite tukaj.

- vir: https://aws.amazon.com/blogs/machine-learning/reduce-model-deployment-costs-by-50-on-average-using-sagemakers-latest-features/

- :ima

- : je

- :ne

- :kje

- $GOR

- 1

- 10

- 100

- 114

- 12

- 13

- 15%

- 150

- 16

- 22

- 360

- 362

- 500

- 7

- 9

- a

- sposobnost

- Sposobna

- O meni

- povzetki

- pospeševalniki

- dostopen

- Po

- Doseči

- Ukrep

- aktivna

- dejavnost

- dodajte

- dodajanje

- Poleg tega

- Dodatne

- Poleg tega

- Naslov

- napredno

- po

- proti

- agregat

- AI

- AI / ML

- Alan

- Alarm

- vsi

- omogočajo

- omogoča

- že

- Prav tako

- Čeprav

- vedno

- Amazon

- Amazon SageMaker

- Amazon Web Services

- Amazon.com

- Ameriška

- znesek

- an

- analitika

- in

- Še ena

- kaj

- API

- API-ji

- uporaba

- aplikacije

- Uporabi

- Uporaba

- pristop

- SE

- OBMOČJE

- umetni

- Umetna inteligenca

- AS

- Sodelavec

- povezan

- At

- Avstralija

- avto

- samodejno

- razpoložljivost

- Na voljo

- povprečno

- izogniti

- AWS

- podloga

- temeljijo

- BE

- ker

- pred

- vedenje

- Prednosti

- BEST

- najboljše prakse

- Boljše

- med

- izgradnjo

- Building

- zgrajena

- poslovni

- vendar

- by

- se imenuje

- poziva

- CAN

- Zmogljivosti

- zmožnost

- lahko

- kapaciteta

- ujame

- nekatere

- izzivi

- izziv

- spremenite

- Izberite

- Mesta

- Koda

- COM

- Primerjava

- dokončanje

- Zaključi

- kompleksna

- komponenta

- deli

- celovito

- Izračunajte

- računalnik

- Računalništvo

- Računalniška vizija

- računalništvo

- konfiguracija

- konfigurirano

- dosledno

- nenehno

- porabijo

- Posoda

- Zabojniki

- nadzor

- Core

- Ustrezno

- strošek

- prihranki pri stroških

- stroški

- bi

- ustvarjajo

- ustvaril

- ustvari

- Ustvarjanje

- Oblikovanje

- Trenutno

- Stranke, ki so

- carinski

- Dallas

- datum

- podatkovne točke

- Datum

- zmanjša

- namenjen

- globoko

- globoko učenje

- globlje

- privzeto

- opredeliti

- Stopnja

- potopite

- Demokratiziranje

- dokazuje,

- Odvisno

- razporedi

- razporejeni

- uvajanja

- uvajanje

- razmestitve

- opisano

- Oblikovanje

- želeno

- Podatki

- Podrobnosti

- Ugotovite,

- Razvoj

- drugačen

- težko

- porazdeljena

- porazdeljeno računalništvo

- do

- domen

- dont

- navzdol

- med

- dinamično

- vsak

- enostavno

- učinek

- učinkovitosti

- učinkovito

- prizadevanja

- omogočajo

- omogočena

- omogoča

- spodbujanje

- Končna točka

- inženir

- Inženiring

- zagotovitev

- Podjetje

- podjetja

- entiteta

- enako

- Evropski

- Primer

- pričakovati

- izkušnje

- Doživetja

- raziskuje

- Raziskovati

- razširiti

- družina

- Feature

- Lastnosti

- Polje

- Najdi

- prva

- prilagodljivost

- Osredotoča

- po

- za

- Fundacija

- štiri

- brezplačno

- prijatelji

- iz

- v celoti

- Poleg tega

- Prihodnost

- dobili

- gif

- GitHub

- Daj

- dana

- daje

- Cilj

- GPU

- Grafične kartice

- zrnat

- Navodila

- Pol

- ročaj

- roke

- strojna oprema

- Imajo

- he

- pomoč

- pomoč

- Pomaga

- jo

- visoka

- na visoki ravni

- ga

- njegov

- hit

- drži

- gostitelj

- gostila

- gostovanje

- URE

- Kako

- Kako

- Vendar

- http

- HTTPS

- Stotine

- Ideja

- Mirovanje

- if

- ilustrirajte

- slika

- izvajati

- izvajanja

- Pomembno

- izboljšanju

- in

- V drugi

- Vključno

- Povečajte

- neodvisno

- india

- neučinkovit

- Podatki

- informacijska tehnologija

- Infrastruktura

- začetna

- inovativne

- inovativne tehnologije

- primer

- Namesto

- Inštitut

- Intelligence

- interaktivno

- obresti

- v

- Uvedeno

- Predstavitev

- IT

- ITS

- sam

- jpg

- Imejte

- vzdrževanje

- Ključne

- otroci

- velika

- Velika podjetja

- nazadnje

- Latenca

- pozneje

- Zadnji

- začetek

- Vodstvo

- vodi

- učenje

- vsaj

- Stopnja

- kot

- Seznam

- Llama

- obremenitev

- lokalna

- nahaja

- več

- Poglej

- si

- ljubi

- stroj

- strojno učenje

- Znamka

- Izdelava

- upravljanje

- upravlja

- upravljanje

- upravitelj

- upravljanje

- več

- mojster

- poveljnika

- Povečajte

- največja

- Maj ..

- pomeni

- Srečati

- Spomin

- meritev

- Meritve

- selitev

- minimalna

- min

- Minute

- ML

- MLOps

- Model

- modeli

- več

- motivirani

- Mountain

- veliko

- več

- nacionalni

- Narava

- Nimate

- potrebna

- potrebe

- Novo

- nlp

- št

- Upoštevajte

- prenosnik

- zdaj

- Številka

- predmet

- of

- ponudba

- pogosto

- on

- ONE

- samo

- na

- Optimizirajte

- optimizacijo

- Možnost

- or

- orkestracijo

- organizacije

- Ostalo

- naši

- ven

- na prostem

- izhodi

- zunaj

- Neporavnani

- več

- Splošni

- lastne

- Pack

- vzporedno

- parameter

- parametri

- zlasti

- strastno

- Vzorec

- vzorci

- za

- performance

- Obdobje

- Dr.

- fotografija

- Kraj

- umestitve

- Mesta

- Načrt

- platforma

- platon

- Platonova podatkovna inteligenca

- PlatoData

- igranje

- točke

- politike

- politika

- mogoče

- Prispevek

- moč

- vaje

- napovedati

- Predvidljivo

- ohranjanje

- , ravnateljica

- Predhodna

- Težave

- Postopek

- Izdelek

- produktni vodja

- proizvodnja

- Lastnosti

- zagotavljajo

- če

- zagotavlja

- zagotavljanje

- objavijo

- Količina

- naključno

- območje

- obsegu

- Reagirajo

- reagira

- pripravljen

- rebalans

- Priporočamo

- zmanjša

- zmanjšanje

- glejte

- Registracija

- povezane

- odstrani

- odstranjevanje

- nadomesti

- zahteva

- zahteva

- zahteva

- obvezna

- Zahteve

- zahteva

- pridržane

- vir

- viri

- oziroma

- Odgovor

- vloga

- vloge

- poti

- usmerjanje

- Run

- tek

- runtime

- sagemaker

- Sklep SageMaker

- Enako

- Shrani

- Prihranki

- pravijo,

- Lestvica

- luske

- skaliranje

- Znanost

- sekund

- glej

- iskanju

- višji

- poslan

- stavek

- služijo

- Storitev

- Storitve

- služijo

- nastavite

- nastavitev

- več

- Delite s prijatelji, znanci, družino in partnerji :-)

- je

- shouldnt

- Prikaži

- je pokazala,

- pokazale

- bistveno

- Enostavno

- poenostavljeno

- sam

- sit

- Velikosti

- manj

- delček

- So

- Software

- Razvoj programske opreme

- rešitve

- nekaj

- specialist

- specializirano

- specifična

- specifikacija

- preživeti

- Poraba

- spike

- konice

- Začetek

- Ustanavljanjem

- state-of-the-art

- Status

- ostati

- Še vedno

- Strategija

- uspešno

- taka

- dobavo

- podpora

- Podpira

- Preverite

- sydney

- miza

- Bodite

- meni

- ciljna

- skupina

- TechCrunch

- tehnični

- Tehnologije

- Tehnologija

- tenis

- terminologija

- kot

- da

- O

- Območje

- Prihodnost

- njihove

- Njih

- POTEM

- Tukaj.

- te

- jih

- ta

- tisti,

- 3

- skozi

- čas

- do

- orodja

- sledenje

- tradicionalna

- Prometa

- Potovanje

- Trends

- sprožijo

- twin

- dva

- razumeli

- univerza

- nepredvidljivo

- Nadgradnja

- posodobljeno

- Uporaba

- uporaba

- Rabljeni

- uporabnik

- Uporabniška izkušnja

- Uporabniki

- uporablja

- uporabo

- navadno

- UTC

- uporabiti

- vice

- Poglej

- Vizija

- Obiskovalci

- sprehod

- walkthrough

- želeli

- Odpadki

- način..

- načini

- we

- web

- spletne storitve

- Dobro

- kdaj

- medtem ko

- ki

- medtem

- bo

- z

- brez

- besede

- delo

- delal

- delovnih tokov

- deluje

- deluje

- let

- Vi

- Vaša rutina za

- sami

- zefirnet

- nič