I dag Amazon SageMaker meddelade stöd för Grid sök efter automatisk modelljustering, vilket ger användarna en ytterligare strategi för att hitta den bästa hyperparameterkonfigurationen för din modell.

Amazon SageMaker automatisk modellinställning hittar den bästa versionen av en modell genom att köra många träningsjobb på din datauppsättning med hjälp av en område hyperparametrar som du anger. Sedan väljer den hyperparametervärdena som resulterar i en modell som presterar bäst, mätt med a metriska som du väljer.

För att hitta de bästa hyperparametervärdena för din modell, stöder Amazon SageMaker automatisk modellinställning flera strategier, inklusive Bayesian (Standard), Slumpmässig sök och Hyperband.

Rutnätssökning

Grid-sökning utforskar uttömmande konfigurationerna i rutnätet av hyperparametrar som du definierar, vilket gör att du kan få insikter i de mest lovande hyperparameterkonfigurationerna i ditt rutnät och deterministiskt reproducera dina resultat över olika trimkörningar. Rutnätssökning ger dig mer förtroende för att hela hyperparametersökningsutrymmet har utforskats. Denna fördel kommer med en avvägning eftersom det är beräkningsmässigt dyrare än Bayesian och slumpmässig sökning om ditt huvudmål är att hitta den bästa hyperparameterkonfigurationen.

Rutnätssökning med Amazon SageMaker

I Amazon SageMaker använder du Grid-sökning när ditt problem kräver att du har den optimala hyperparameterkombinationen som maximerar eller minimerar ditt objektiva mått. Ett vanligt användningsfall där kunden använder Grid Search är när modellens noggrannhet och reproducerbarhet är viktigare för ditt företag än utbildningskostnaden som krävs för att få den.

För att aktivera Grid Search i Amazon SageMaker, ställ in Strategy fält till Grid när du skapar ett trimjobb, enligt följande:

Dessutom kräver Grid Search att du definierar ditt sökutrymme (kartesiskt rutnät) som ett kategoriskt intervall av diskreta värden i din jobbdefinition med hjälp av CategoricalParameterRanges nyckel under ParameterRanges parameter, enligt följande:

Observera att vi inte specificerar MaxNumberOfTrainingJobs för Rutnätssökning i jobbdefinitionen eftersom detta bestäms för dig utifrån antalet kategorikombinationer. När du använder slumpmässig och Bayesiansk sökning anger du MaxNumberOfTrainingJobs parameter som ett sätt att styra trimningsjobbkostnaden genom att definiera en övre gräns för beräkning. Med Grid search, värdet av MaxNumberOfTrainingJobs (nu valfritt) ställs automatiskt in som antalet kandidater för rutnätssökningen i Beskriv HyperParameterTuningJob form. Detta låter dig utforska ditt önskade rutnät av hyperparametrar uttömmande. Dessutom accepterar jobbdefinitionen för Grid Search endast diskreta kategoriska intervall och kräver ingen definition av kontinuerliga eller heltalsintervall eftersom varje värde i rutnätet anses vara diskret.

Rutnätssökningsexperiment

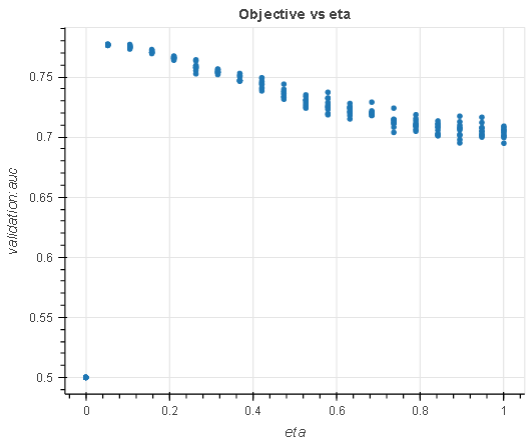

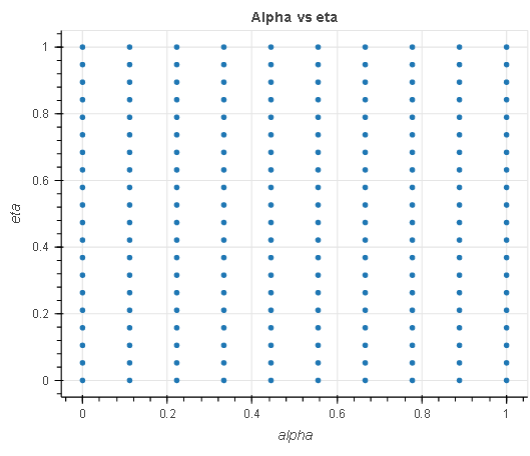

I detta experiment, med en regressionsuppgift, söker vi efter de optimala hyperparametrarna inom ett sökutrymme på 200 hyperparametrar, 20 eta och 10 alpha allt från 0.1 till 1. Vi använder datauppsättning för direkt marknadsföring för att ställa in en regressionsmodell.

- eta: Krympning i stegstorlek används i uppdateringar för att förhindra överpassning. Efter varje förstärkningssteg kan du direkt få vikten av nya funktioner. De

etaparametern krymper faktiskt funktionsvikterna för att göra förstärkningsprocessen mer konservativ. - alfa: L1 regulariseringsterm på vikter. Att öka detta värde gör modellerna mer konservativa.

|

|

Diagrammet till vänster visar en analys av eta hyperparameter i förhållande till det objektiva måttet och visar hur rutnätssökning har uttömt hela sökutrymmet (rutnätet) i X-axlarna innan den bästa modellen returneras. På samma sätt analyserar diagrammet till höger de två hyperparametrarna i ett enda kartesiskt utrymme för att visa att alla punkter i rutnätet valdes under inställningen.

Experimentet ovan visar att Grid-sökningens uttömmande karaktär garanterar ett optimalt urval av hyperparameter givet det definierade sökutrymmet. Det visar också att du kan reproducera ditt sökresultat över tuning iterationer, allt annat lika.

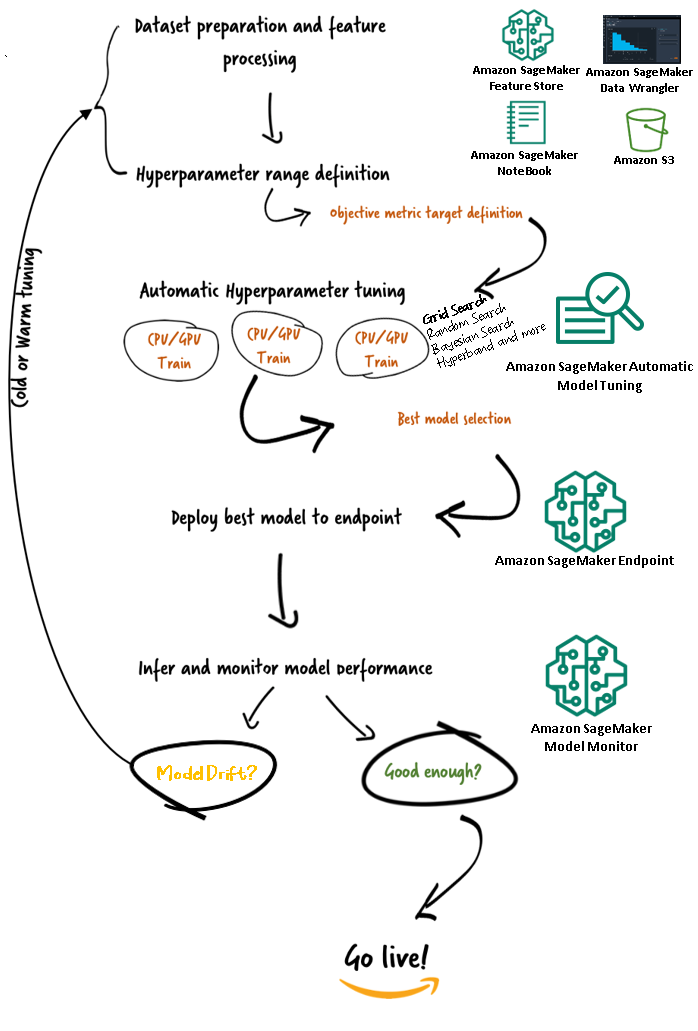

Amazon SageMaker Automatic Model Tuning-arbetsflöden (AMT)

Med Amazon SageMaker automatisk modellinställning kan du hitta den bästa versionen av din modell genom att köra träningsjobb på din datauppsättning med flera sökstrategier, såsom Bayesian, Random Search, Grid Search och Hyperband. Med automatisk modellinställning kan du minska tiden för att ställa in en modell genom att automatiskt söka efter den bästa hyperparameterkonfigurationen inom de hyperparameterintervall som du anger.

Nu när vi har granskat fördelen med att använda Grid-sökning i Amazon SageMaker AMT, låt oss ta en titt på AMT:s arbetsflöden och förstå hur allt hänger ihop i SageMaker.

Slutsats

I det här inlägget diskuterade vi hur du nu kan använda sökstrategin Grid för att hitta den bästa modellen och dess förmåga att deterministiskt reproducera resultat över olika inställningsjobb. Vi diskuterade avvägningen när du använder rutnätssökning jämfört med andra strategier, och hur det låter dig utforska vilka regioner i hyperparameterutrymmena som är mest lovande och reproducera dina resultat deterministiskt.

För att lära dig mer om automatisk modellinställning, besök Produktsida och teknisk dokumentation.

Om författaren

Doug Mbaya är en Senior Partner Solution arkitekt med fokus på data och analys. Doug arbetar nära med AWS-partners och hjälper dem att integrera data- och analyslösningar i molnet.

Doug Mbaya är en Senior Partner Solution arkitekt med fokus på data och analys. Doug arbetar nära med AWS-partners och hjälper dem att integrera data- och analyslösningar i molnet.

- Avancerat (300)

- AI

- ai konst

- ai art generator

- har robot

- Amazon SageMaker

- artificiell intelligens

- artificiell intelligenscertifiering

- artificiell intelligens inom bankväsendet

- artificiell intelligens robot

- robotar med artificiell intelligens

- programvara för artificiell intelligens

- AWS maskininlärning

- blockchain

- blockchain konferens ai

- coingenius

- konversationskonstnärlig intelligens

- kryptokonferens ai

- dalls

- djupt lärande

- du har google

- maskininlärning

- plato

- plato ai

- Platon Data Intelligence

- Platon spel

- PlatonData

- platogaming

- skala ai

- syntax

- zephyrnet