Från nystartade företag till företag, organisationer av alla storlekar börjar med generativ AI. De vill dra nytta av generativ AI och översätta farten från betaversioner, prototyper och demos till verkliga produktivitetsvinster och innovationer. Men vad behöver organisationer för att föra in generativ AI i företaget och göra det verkligt? När vi pratar med kunder berättar de för oss att de behöver säkerhet och integritet, skala och pris-prestanda, och viktigast av allt teknik som är relevant för deras verksamhet. Vi är glada över att kunna tillkännage nya funktioner och tjänster idag för att tillåta stora och små organisationer att använda generativ AI på kreativa sätt, bygga nya applikationer och förbättra hur de fungerar. På AWS är vi hyperfokuserade på att hjälpa våra kunder på några sätt:

- Gör det enkelt att bygga generativa AI-applikationer med inbyggd säkerhet och integritet

- Fokusera på den mest prestanda, lågkostnadsinfrastrukturen för generativ AI så att du kan träna dina egna modeller och köra slutsatser i skala

- Tillhandahåller generativa AI-drivna applikationer för företaget för att förändra hur arbetet utförs

- Aktivera data som din differentiator för att anpassa grundmodeller (FM) och göra dem till experter på ditt företag, din data och ditt företag

För att hjälpa ett brett spektrum av organisationer att bygga differentierade generativa AI-upplevelser, har AWS arbetat hand i hand med våra kunder, inklusive BBVA, Thomson Reuters, United Airlines, Philips och LexisNexis Legal & Professional. Och med de nya funktionerna som lanseras idag ser vi fram emot ökad produktivitet, förbättrat kundengagemang och mer personliga upplevelser som kommer att förändra hur företag får jobbet gjort.

Tillkännage den allmänna tillgängligheten för Amazon Bedrock, det enklaste sättet att bygga generativa AI-applikationer med säkerhet och integritet inbyggd

Kunderna är entusiastiska och optimistiska över värdet som generativ AI kan tillföra företaget. De dyker djupt in i tekniken för att lära sig stegen de behöver ta för att bygga ett generativt AI-system i produktion. Medan de senaste framstegen inom generativ AI har fångat stor uppmärksamhet, har många företag inte kunnat ta del av denna omvandling. Kunder berättar för oss att de behöver ett urval av modeller, säkerhets- och integritetsgarantier, en data-först-metod, kostnadseffektiva sätt att köra modeller och funktioner som snabb konstruktion, retrieval augmented generation (RAG), agenter och mer för att skapa skräddarsydda applikationer . Det är därför den 13 april 2023, meddelade vi Amazonas berggrund, det enklaste sättet att bygga och skala generativa AI-applikationer med grundmodeller. Amazon Bedrock är en helt hanterad tjänst som erbjuder ett urval av högpresterande grundmodeller från ledande leverantörer som AI21 Labs, Anthropic, Cohere, Meta, Stability AI och Amazon, tillsammans med en bred uppsättning möjligheter som kunder behöver för att bygga generativ AI applikationer, förenkla utvecklingen med bibehållen integritet och säkerhet. Dessutom, som en del av en nyligen tillkännagett strategiskt samarbete, kommer alla framtida FM:s från Anthropic att vara tillgängliga inom Amazon Bedrock med tidig tillgång till unika funktioner för modellanpassning och finjusteringsmöjligheter.

Sedan april har vi sett på egen hand hur startups som Coda, Hurone AIoch Nexxiot; stora företag som adidas, GoDaddy, Clariant och Broadridge; och partners gillar Accenture, BCG, Leidos och Mission Cloud använder redan Amazon Bedrock för att säkert bygga generativa AI-applikationer över branscher. Oberoende mjukvaruleverantörer (ISV) gillar Salesforce integrerar nu säkert med Amazon Bedrock för att göra det möjligt för sina kunder att driva generativa AI-applikationer. Kunder tillämpar generativ AI på nya användningsfall; till exempel arbetade Lonely Planet, ett ledande resemediaföretag, med vår Generativt AI Innovation Center att introducera en skalbar AI-plattform som organiserar bokinnehåll på några minuter för att leverera sammanhållna, mycket exakta reserekommendationer, vilket minskar kostnaderna för generering av resplaner med nästan 80 %. Och sedan dess har vi fortsatt att lägga till nya funktioner, som agenter för Amazon Bedrock, samt stöd för nya modeller, som Cohere och de senaste modellerna från Anthropic, för att erbjuda våra kunder fler valmöjligheter och göra det lättare att skapa generativ AI- baserade applikationer. Agents for Bedrock är en game changer, vilket gör att LLM:er kan slutföra komplexa uppgifter baserat på dina egna data och API: er, privat, säkert, med installation på några minuter (ingen utbildning eller finjustering krävs).

Idag är vi glada över att dela med oss av nya tillkännagivanden som gör det lättare att föra generativ AI till din organisation:

- Allmän tillgänglighet för Amazon Bedrock för att hjälpa ännu fler kunder att bygga och skala generativa AI-applikationer

- Utökat modellval med Lama 2 (kommer inom de närmaste veckorna) och Amazon Titan-inbäddningar ger kunderna större valmöjligheter och flexibilitet att hitta rätt modell för varje användningsfall och driver RAG för bättre resultat

- Amazon Bedrock är en HIPAA-kvalificerad tjänst och kan användas i enlighet med GDPR, vilket gör att ännu fler kunder kan dra nytta av generativ AI

- Provisionerad genomströmning för att säkerställa en konsekvent användarupplevelse även under högtrafik

Med den allmänna tillgängligheten av Amazon Bedrock kommer fler kunder att få tillgång till Bedrocks omfattande möjligheter. Kunder kan enkelt experimentera med en mängd olika FM:er, anpassa dem privat med sina data med hjälp av tekniker som finjustering och RAG, och skapa hanterade agenter som utför komplexa affärsuppgifter – från bokning av resor och bearbetning av försäkringsanspråk till att skapa annonskampanjer och hantera inventering – allt utan att skriva någon kod. Eftersom Amazon Bedrock är serverlöst behöver kunderna inte hantera någon infrastruktur, och de kan säkert integrera och distribuera generativa AI-funktioner i sina applikationer med hjälp av de AWS-tjänster som de redan är bekanta med.

För det andra har modellval varit en hörnsten i det som gör Amazon Bedrock till en unik, differentierad tjänst för våra kunder. Så här tidigt i antagandet av generativ AI finns det ingen enskild modell som låser upp hela värdet av generativ AI, och kunderna behöver förmågan att arbeta med en rad högpresterande modeller. Vi är glada över att tillkännage den allmänna tillgängligheten av Amazon Titan Embeddings och kommer inom de närmaste veckorna av Llama 2, Metas nästa generations stora språkmodell (LLM) – ansluter sig till befintliga modellleverantörer AI21 Labs, Anthropic, Cohere, Stability AI och Amazon för att ytterligare utöka utbudet och flexibiliteten för kunderna. Amazon Bedrock är den första fullt hanterade generativa AI-tjänsten som erbjuder Llama 2, Metas nästa generations LLM, genom ett hanterat API. Llama 2-modellerna kommer med betydande förbättringar jämfört med de ursprungliga Llama-modellerna, inklusive att de tränas på 40 % mer data och har en längre kontextlängd på 4,000 2 tokens för att fungera med större dokument. Optimerade för att ge ett snabbt svar på AWS-infrastruktur, Llama 2-modellerna tillgängliga via Amazon Bedrock är idealiska för dialoganvändningsfall. Kunder kan nu bygga generativa AI-applikationer som drivs av Llama 13 70B och XNUMXB parametermodeller, utan att behöva konfigurera och hantera någon infrastruktur.

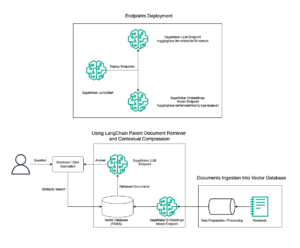

Amazon Titan FMs är en familj av modeller skapade och förtränade av AWS på stora datamängder, vilket gör dem till kraftfulla funktioner för allmänna ändamål byggda för att stödja en mängd olika användningsfall. Den första av dessa modeller som är allmänt tillgängliga för kunder, Amazon Titan Embeddings, är en LLM som konverterar text till numeriska representationer (känd som inbäddningar) för att driva RAG-användningsfall. FM:er är väl lämpade för en mängd olika uppgifter, men de kan bara svara på frågor baserade på lärdomar från träningsdata och kontextuell information i en prompt, vilket begränsar deras effektivitet när svar kräver aktuell kunskap eller proprietär data. Data är skillnaden mellan en allmän generativ AI-applikation och en som verkligen känner din verksamhet och din kund. För att utöka FM-svar med ytterligare data vänder sig många organisationer till RAG, en populär modellanpassningsteknik där en FM ansluter till en kunskapskälla som den kan referera för att utöka sina svar. För att komma igång med RAG behöver kunder först tillgång till en inbäddningsmodell för att konvertera sina data till vektorer som gör att FM lättare kan förstå den semantiska innebörden och sambanden mellan data. Att bygga en inbäddningsmodell kräver enorma mängder data, resurser och ML-expertis, vilket gör att RAG är utom räckhåll för många organisationer. Amazon Titan Embeddings gör det enklare för kunder att komma igång med RAG för att utöka kraften hos vilken FM som helst med deras egen data. Amazon Titan Embeddings stöder mer än 25 språk och en kontextlängd på upp till 8,192 1,536 tokens, vilket gör den väl lämpad att arbeta med enstaka ord, fraser eller hela dokument baserat på kundens användningsfall. Modellen returnerar utdatavektorer med XNUMX XNUMX dimensioner, vilket ger den en hög grad av noggrannhet, samtidigt som den optimerar för låg latens, kostnadseffektiva resultat. Med nya modeller och möjligheter är det enkelt att använda din organisations data som en strategisk tillgång för att anpassa grundmodeller och bygga mer differentierade upplevelser.

För det tredje, eftersom den data som kunderna vill använda för anpassning är så värdefull IP behöver de den för att förbli säker och privat. Med säkerhet och integritet inbyggd sedan dag ett kan Amazon Bedrock-kunder lita på att deras data förblir skyddade. Ingen av kundens data används för att träna de ursprungliga bas-FM:erna. All data krypteras i vila och under överföring. Och du kan förvänta dig samma AWS-åtkomstkontroller som du har med alla andra AWS-tjänster. Idag är vi glada över att bygga vidare på denna grund och introducera nya säkerhets- och styrningsmöjligheter – Amazon Bedrock är nu en HIPAA-kvalificerad tjänst och kan användas i enlighet med GDPR, vilket gör att ännu fler kunder kan dra nytta av generativ AI. Nya styrningsmöjligheter inkluderar integration med amazoncloudwatch att spåra användningsstatistik och bygga anpassade instrumentpaneler och integration med AWS CloudTrail för att övervaka API-aktivitet och felsöka problem. Dessa nya styrnings- och säkerhetsfunktioner hjälper organisationer att låsa upp potentialen hos generativ AI, även i starkt reglerade branscher, och se till att data förblir skyddade.

Slutligen är vissa perioder på året, som helgdagar, avgörande för att kunderna ska se till att deras användare kan få oavbruten service från applikationer som drivs av generativ AI. Under dessa perioder vill kunderna säkerställa att deras tjänst är tillgänglig för alla sina kunder oavsett efterfrågan. Amazon Bedrock tillåter nu kunder att reservera genomströmning (i termer av tokens bearbetade per minut) för att upprätthålla en konsekvent användarupplevelse även under högtrafik.

Tillsammans kommer de nya funktionerna och modellerna som vi tillkännagav idag för Amazon Bedrock att accelerera hur snabbt företag kan bygga mer personliga applikationer och förbättra de anställdas produktivitet. I samverkan med våra pågående investeringar i ML-infrastruktur är Amazon Bedrock den bästa platsen för kunder att bygga och skala generativa AI-applikationer.

För att hjälpa kunder att snabbt komma igång med dessa nya funktioner, lägger vi till en ny generativ AI-utbildning för Amazon Bedrock till vår samling av digitala, on-demand utbildningar. Amazon Bedrock – Komma igång är en gratis digital kurs i egen takt som introducerar eleverna till tjänsten. Denna 60-minuterskurs kommer att introducera utvecklare och teknisk publik till Amazon Bedrocks fördelar, funktioner, användningsfall och tekniska koncept.

Tillkännage Amazon CodeWhisperers anpassningsförmåga för att generera mer relevanta kodrekommendationer utifrån din organisations kodbas

På AWS bygger vi kraftfulla nya applikationer som förändrar hur våra kunder får arbete gjort med generativ AI. I april 2023 tillkännagav vi den allmänna tillgängligheten för Amazon Code Whisperer, en AI-kodningskompanjon som hjälper utvecklare att bygga mjukvaruapplikationer snabbare genom att tillhandahålla kodförslag på 15 språk, baserat på naturliga språkkommentarer och kod i en utvecklares integrerade utvecklarmiljö (IDE). CodeWhisperer har tränats på miljarder rader med allmänt tillgänglig kod för att hjälpa utvecklare att bli mer produktiva i en mängd olika uppgifter. Vi har specialutbildade CodeWhisperer på Amazon-kod av hög kvalitet, inklusive AWS API:er och bästa praxis, för att hjälpa utvecklare att bli ännu snabbare och mer exakt generera kod som interagerar med AWS-tjänster som Amazon Elastic Compute Cloud (Amazon EC2), Amazon enkel lagringstjänst (Amazon S3), och AWS Lambda. Kunder från Accenture till Persistent till Bundesliga har använt CodeWhisperer för att göra sina utvecklare mer produktiva.

Många kunder vill också att CodeWhisperer ska inkludera sina egna interna API:er, bibliotek, bästa praxis och arkitektoniska mönster i sina förslag, så att de kan påskynda utvecklingen ännu mer. Idag kan AI-kodningskompanjoner inte inkludera dessa API:er i sina kodförslag eftersom de vanligtvis är utbildade i allmänt tillgänglig kod och därför inte är medvetna om ett företags interna kod. Till exempel, för att bygga en funktion för en e-handelswebbplats som listar varor i en kundvagn, måste utvecklare hitta och förstå befintlig intern kod, till exempel API:et som tillhandahåller beskrivningen av varor, så att de kan visa beskrivningen i kundvagnen . Utan en kodningskompanjon som kan föreslå den korrekta, interna koden för dem, måste utvecklare ägna timmar åt att gräva igenom sin interna kodbas och dokumentation för att slutföra sitt arbete. Även efter att utvecklare har lyckats hitta rätt resurser måste de lägga mer tid på att granska koden för att se till att den följer deras företags bästa praxis.

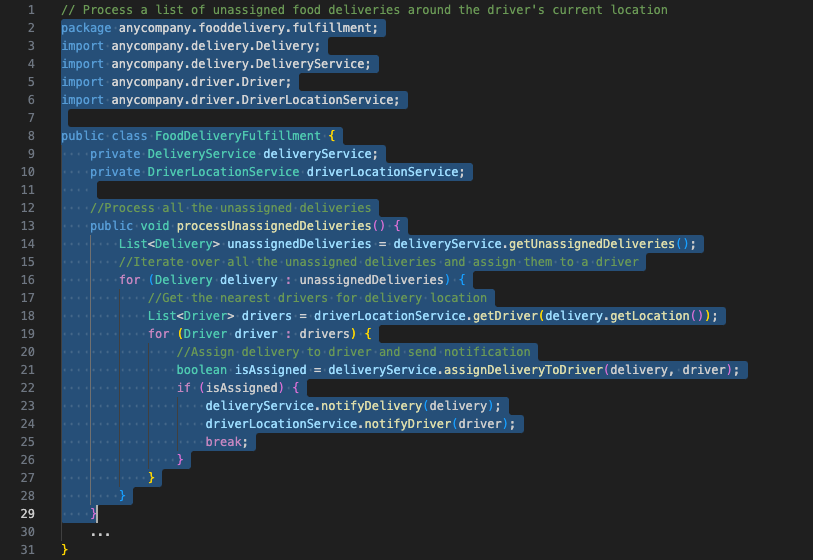

Idag är vi glada över att kunna presentera en ny Amazon CodeWhisperer anpassningsförmåga, vilket gör att CodeWhisperer kan generera ännu bättre förslag än tidigare, eftersom det nu kan inkludera dina interna API:er, bibliotek, bästa praxis och arkitektoniska mönster. Denna funktion använder de senaste modellerna och teknikerna för kontextanpassning och kommer att vara tillgänglig i förhandsvisning snart som en del av en ny CodeWhisperer Enterprise Tier. Med denna förmåga kan du säkert ansluta dina privata arkiv till CodeWhisperer och med några få klick anpassa CodeWhisperer för att generera rekommendationer i realtid som inkluderar din interna kodbas. Till exempel, med en CodeWhisperer-anpassning, kan en utvecklare som arbetar i ett matleveransföretag be CodeWhisperer att ge rekommendationer som inkluderar specifik kod relaterad till företagets interna tjänster, till exempel "Bearbeta en lista över icke tilldelade matleveranser runt förarens nuvarande plats." Tidigare kunde CodeWhisperer inte känna till de korrekta interna API:erna för "otilldelade matleveranser" eller "förarens nuvarande plats" eftersom detta inte är allmänt tillgänglig information. Nu, när den väl har anpassats till företagets interna kodbas, förstår CodeWhisperer avsikten, bestämmer vilka interna och offentliga API:er som är bäst lämpade för uppgiften och genererar kodrekommendationer för utvecklaren. CodeWhisperers anpassningsförmåga kan spara timmar på att söka och ändra sparsamt dokumenterad kod och hjälper utvecklare som är nya på företaget snabbare.

I följande exempel, efter att ha skapat en privat anpassning, får AnyCompany (ett matleveransföretag) utvecklare CodeWhisperer-kodrekommendationer som inkluderar deras interna API:er och bibliotek.

Vi genomförde en nyligen genomförd studie med Beständig, ett globalt tjänste- och lösningsföretag som levererar digitala ingenjörs- och företagsmoderniseringstjänster till kunder, för att mäta produktivitetsfördelarna med CodeWhisperers anpassningsförmåga. Persistent fann att utvecklare som använder anpassningsförmågan kunde slutföra sina kodningsuppgifter upp till 28 % snabbare i genomsnitt än utvecklare som använder standard CodeWhisperer.

Vi designade denna anpassningsförmåga med integritet och säkerhet i främsta rummet. Administratörer kan enkelt hantera åtkomst till en privat anpassning från AWS Management Console, så att endast specifika utvecklare har åtkomst. Administratörer kan också säkerställa att endast arkiv som uppfyller deras standarder är kvalificerade för användning i en CodeWhisperer-anpassning. Att använda högkvalitativa arkiv hjälper CodeWhisperer att komma med förslag som främjar säkerhet och bästa praxis för kodkvalitet. Varje anpassning är helt isolerad från andra kunder och ingen av de anpassningar som byggts med denna nya förmåga kommer att användas för att träna FM-underliggande CodeWhisperer, skydda kundernas värdefulla immateriella rättigheter.

Tillkännager förhandsvisningen av generativa BI-författarfunktioner i Amazon QuickSight för att hjälpa affärsanalytiker att enkelt skapa och anpassa visuella bilder med kommandon på naturliga språk

AWS har haft ett uppdrag att demokratisera tillgången till insikter för alla användare i organisationen. Amazon QuickSight, vår unified business intelligence (BI)-tjänst byggd för molnet, gör att insikter kan delas mellan alla användare i organisationen. Med QuickSight har vi använt generativa modeller för att driva Amazon QuickSight Q, som gör det möjligt för alla användare att ställa frågor om sina data med naturligt språk, utan att behöva skriva SQL-frågor eller lära sig ett BI-verktyg, sedan 2020. I juli 2023 meddelade att vi främjar den tidiga innovationen i QuickSight Q med de nya LLM-funktionerna för att tillhandahålla generativa BI-funktioner i QuickSight. Nuvarande QuickSight-kunder som BMW Group och Traeger Grills ser fram emot att ytterligare öka produktiviteten hos sina analytiker med hjälp av generativ BI-författarupplevelse.

Idag är vi glada över att göra dessa LLM-funktioner tillgängliga i förhandsvisning med Generativa BI-instrumentpanelsförfattarfunktioner för affärsanalytiker. De nya generativa BI-författarfunktionerna utökar den naturliga språkfrågan i QuickSight Q utöver att svara på välstrukturerade frågor (som "vilka är de 10 bästa produkterna som säljs i Kalifornien?") för att hjälpa analytiker att snabbt skapa anpassningsbara bilder från frågefragment (som t.ex. "topp 10 produkter"), förtydliga avsikten med en fråga genom att ställa uppföljningsfrågor, förfina visualiseringar och göra komplexa beräkningar. Affärsanalytiker beskriver helt enkelt det önskade resultatet och QuickSight genererar övertygande bilder som enkelt kan läggas till i en instrumentpanel eller rapport med ett enda klick. QuickSight Q erbjuder också relaterade frågor för att hjälpa analytiker att klargöra tvetydiga fall när flera datafält matchar deras fråga. När analytikern har den första visualiseringen kan de lägga till komplexa beräkningar, ändra diagramtyper och förfina bilder med hjälp av naturliga språkuppmaningar. De nya generativa BI-författarfunktionerna i QuickSight Q gör det snabbt och enkelt för affärsanalytiker att skapa övertygande bilder och minskar tiden för att leverera de insikter som behövs för att informera datadrivna beslut i stor skala.

Skapa bilder med hjälp av generativa BI-funktioner i Amazon QuickSight

Generativa AI-verktyg och funktioner för alla företag

Dagens tillkännagivanden öppnar generativ AI för alla kunder. Med säkerhet och integritet i företagsklass, val av ledande FM:er, en data-först-strategi och en högpresterande, kostnadseffektiv infrastruktur, litar organisationer på att AWS driver sina innovationer med generativa AI-lösningar i varje lager av stacken. Vi har sett spännande innovation från Bridgewater Associates till Omnicom till Asurion till Rocket Mortgage, och med dessa nya tillkännagivanden ser vi fram emot nya användningsfall och tillämpningar av tekniken för att öka produktiviteten. Det här är bara början – över hela teknikstacken förnyar vi oss med nya tjänster och kapaciteter som byggts för din organisation för att hjälpa dig att hantera några av dina största utmaningar och förändra hur vi arbetar.

Resurser

Om du vill veta mer, kolla in följande resurser:

Om författaren

Swami Sivasubramanian är vice vd för data- och maskininlärning på AWS. I denna roll övervakar Swami alla AWS-databas-, analys- och AI- och maskininlärningstjänster. Hans teams uppdrag är att hjälpa organisationer att få sin data att fungera med en komplett, end-to-end datalösning för att lagra, komma åt, analysera och visualisera och förutsäga.

Swami Sivasubramanian är vice vd för data- och maskininlärning på AWS. I denna roll övervakar Swami alla AWS-databas-, analys- och AI- och maskininlärningstjänster. Hans teams uppdrag är att hjälpa organisationer att få sin data att fungera med en komplett, end-to-end datalösning för att lagra, komma åt, analysera och visualisera och förutsäga.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://aws.amazon.com/blogs/machine-learning/announcing-new-tools-to-help-every-business-embrace-generative-ai/

- : har

- :är

- :inte

- :var

- $UPP

- 000

- 1

- 10

- 100

- 13

- 15%

- 2020

- 2023

- 25

- 7

- 8

- a

- förmåga

- Able

- Om oss

- accelerera

- Accenture

- tillgång

- noggrannhet

- exakt

- tvärs

- aktivitet

- Ad

- lägga till

- lagt till

- tillsats

- Annat

- Dessutom

- Adidas

- administratörer

- Antagande

- framsteg

- Efter

- medel

- AI

- AI och maskininlärning

- AI-plattform

- AI-utbildning

- AI-powered

- flygbolag

- Alla

- tillåter

- tillåta

- tillåter

- längs

- redan

- också

- amason

- Amazon Code Whisperer

- Amazon EC2

- Amazon QuickSight

- Amazon Web Services

- mängder

- an

- analytiker

- analytiker

- analytics

- analysera

- och

- Meddela

- meddelade

- Meddelanden

- Vi presenterar

- Antropisk

- vilken som helst

- api

- API: er

- Ansökan

- tillämpningar

- Tillämpa

- tillvägagångssätt

- April

- arkitektoniska

- ÄR

- runt

- AS

- be

- be

- tillgång

- At

- uppmärksamhet

- målgrupper

- augmented

- författarskap

- tillgänglighet

- tillgänglig

- genomsnitt

- medveten

- AWS

- bas

- baserat

- BBVA

- BCG

- BE

- därför att

- varit

- innan

- Där vi får lov att vara utan att konstant prestera,

- fördel

- Fördelarna

- BÄST

- bästa praxis

- Bättre

- mellan

- Bortom

- Stor

- miljarder

- BMW

- boken

- bokning

- lyft

- föra

- bred

- Broadridge

- SLUTRESULTAT

- Byggnad

- byggt

- företag

- business intelligence

- företag

- men

- by

- beräkningar

- kalifornien

- Kampanjer

- KAN

- Kan få

- kapacitet

- kapacitet

- kapabel

- kapitalisera

- fångas

- Vid

- fall

- vissa

- utmaningar

- byta

- Växlare

- Diagram

- ta

- val

- hävdar

- klick

- cloud

- koda

- kodbas

- Kodning

- sammanhängande

- komma

- kommande

- kommentarer

- Företag

- följeslagare

- följeslagare

- företag

- Företagets

- övertygande

- fullborda

- fullständigt

- komplex

- Efterlevnad

- omfattande

- Compute

- Begreppen

- konsert

- genomfördes

- Kontakta

- ansluter

- konsekvent

- innehåll

- sammanhang

- kontextuella

- fortsatte

- kontroller

- konvertera

- hörnstenen

- korrekt

- Pris

- kostnadseffektiv

- Kostar

- Kurs

- skapa

- skapas

- Skapa

- Kreativ

- kritisk

- Aktuella

- kund

- Kundförlovning

- Kunder

- anpassningsbar

- anpassning

- skräddarsy

- kundanpassad

- instrumentbräda

- instrumentpaneler

- datum

- data driven

- Databas

- datauppsättningar

- dag

- beslut

- djup

- Examen

- leverera

- Leveranser

- leverera

- leverans

- Efterfrågan

- DEMOKRATISERA

- demos

- distribuera

- beskriva

- beskrivning

- utformade

- önskas

- bestämd

- Utvecklare

- utvecklare

- Utveckling

- dialog

- Skillnaden

- differentierad

- differentierare

- digital

- dimensioner

- Visa

- do

- dokumentation

- dokument

- gjort

- inte

- under

- varje

- Tidig

- lättare

- enklaste

- lätt

- lätt

- e-handel

- effektivitet

- berättigad

- inbäddning

- omfamna

- Anställd

- möjliggöra

- möjliggör

- krypterad

- början till slut

- ingrepp

- Teknik

- förbättra

- förbättrad

- säkerställa

- Företag

- företagsklass

- företag

- Hela

- Miljö

- Även

- Varje

- exempel

- exciterade

- spännande

- exekvera

- befintliga

- expanderande

- förvänta

- erfarenhet

- Erfarenheter

- experimentera

- expert

- expertis

- förlänga

- bekant

- familj

- SNABB

- snabbare

- Leverans

- Funktioner

- få

- Fält

- hitta

- änden

- Förnamn

- Flexibilitet

- efter

- följer

- livsmedelsproduktion

- matleverans

- För

- förgrunden

- Framåt

- hittade

- fundament

- Fri

- från

- fullständigt

- ytterligare

- främja

- framtida

- resultat

- lek

- spel-växlare

- GDPR

- Allmänt

- allmänhet

- generera

- genererar

- generera

- generering

- generativ

- Generativ AI

- skaffa sig

- få

- gif

- ger

- Ge

- Välgörenhet

- styrning

- större

- Grupp

- Har

- har

- hjälpa

- hjälpa

- hjälper

- Hög

- högpresterande

- hög kvalitet

- höggradigt

- hans

- semester

- ÖPPETTIDER

- Hur ser din drömresa ut

- Hur vi arbetar

- html

- http

- HTTPS

- idealisk

- förbättras

- förbättringar

- förbättra

- in

- innefattar

- Inklusive

- ökande

- oberoende

- industrier

- underrätta

- informationen

- informeras

- Infrastruktur

- inledande

- nyskapande

- Innovation

- innovationer

- insikter

- försäkring

- integrera

- integrerade

- Integrera

- integrering

- intellektuella

- immateriella rättigheter

- Intelligens

- uppsåt

- interagerar

- inre

- in

- införa

- Introducerar

- Investeringar

- IP

- isolerat

- problem

- IT

- artikel

- DESS

- sammanfogning

- jpg

- Juli

- bara

- Vet

- kunskap

- känd

- vet

- Labs

- språk

- Språk

- Large

- Stora företag

- större

- största

- senaste

- lanserades

- lager

- ledande

- LÄRA SIG

- inlärning

- Adress

- Längd

- LexisNexis

- bibliotek

- tycka om

- begränsande

- rader

- Lista

- listor

- Lama

- LLM

- läge

- längre

- se

- du letar

- Låg

- Maskinen

- maskininlärning

- bibehålla

- upprätthålla

- göra

- GÖR

- Framställning

- hantera

- förvaltade

- ledning

- hantera

- många

- massiv

- Match

- betyder

- mäta

- Media

- Möt

- meta

- Metrics

- minut

- minuter

- Mission

- ML

- modell

- modeller

- Momentum

- Övervaka

- mer

- Inteckning

- mest

- multipel

- Natural

- nästan

- Behöver

- behövs

- Nya

- Nya funktioner

- Nästa

- nästa generation

- Nej

- Ingen

- nu

- of

- erbjudanden

- Erbjudanden

- on

- On-Demand

- Ombord

- gång

- ONE

- pågående

- endast

- öppet

- Optimistiska

- optimerad

- optimera

- or

- organisation

- organisationer

- organiserar

- ursprungliga

- Övriga

- vår

- ut

- Resultat

- produktion

- över

- egen

- parameter

- del

- partner

- mönster

- Topp

- för

- perioder

- personlig

- fraser

- Plats

- planet

- plattform

- plato

- Platon Data Intelligence

- PlatonData

- Populära

- potentiell

- kraft

- drivs

- den mäktigaste

- praxis

- förutse

- Premier

- VD

- Förhandsvisning

- tidigare

- privatpolicy

- Integritet och säkerhet

- privat

- Bearbetad

- bearbetning

- Produktion

- produktiv

- produktivitet

- Produkter

- professionell

- främja

- egenskapen

- proprietary

- skyddad

- skydda

- prototyper

- ge

- leverantörer

- ger

- tillhandahålla

- allmän

- publicly

- Syftet

- sätta

- sätta

- kvalitet

- sökfrågor

- fråga

- frågor

- snabbt

- område

- nå

- verklig

- verkliga världen

- realtid

- senaste

- rekommendationer

- minska

- reducerande

- förfina

- Oavsett

- reglerad

- reglerade industrier

- relaterad

- Förhållanden

- relevanta

- förblir

- resterna

- rapport

- kräver

- Obligatorisk

- Kräver

- Reserv

- Resurser

- Svara

- respons

- svar

- REST

- Resultat

- återgår

- reviewing

- höger

- Raket

- Roll

- Körning

- Salesforce

- Samma

- Save

- skalbar

- Skala

- söka

- säkra

- säkert

- säkerhet

- sett

- Server

- service

- Tjänster

- in

- inställning

- Dela

- delas

- Gå och Handla

- signifikant

- Enkelt

- förenkla

- helt enkelt

- eftersom

- enda

- storlekar

- Small

- So

- Mjukvara

- säljs

- lösning

- Lösningar

- några

- snart

- Källa

- speciellt

- specifik

- fart

- spendera

- spent

- Stabilitet

- stapel

- standard

- standarder

- igång

- Startups

- Steg

- förvaring

- lagra

- Strategisk

- Läsa på

- sådana

- stödja

- Stöder

- säker

- system

- tackla

- Ta

- Diskussion

- uppgift

- uppgifter

- tech

- Teknisk

- tekniker

- Teknologi

- tala

- villkor

- text

- än

- den där

- Smakämnen

- deras

- Dem

- sedan

- Där.

- Dessa

- de

- detta

- Genom

- genomströmning

- djur

- tid

- tid

- gånger

- titan

- till

- i dag

- tokens

- verktyg

- verktyg

- topp

- Top 10

- spår

- trafik

- Tåg

- tränad

- Utbildning

- Förvandla

- Transformation

- transitering

- Översätt

- färdas

- verkligen

- Litar

- SVÄNG

- typer

- typiskt

- underliggande

- förstå

- förstår

- enhetlig

- unika

- United

- låsa

- låser upp

- us

- Användning

- användning

- användningsfall

- Begagnade

- Användare

- Användarupplevelse

- användare

- användningar

- med hjälp av

- Värdefulla

- värde

- mängd

- försäljare

- via

- vice

- Vice President

- visualisering

- visualisera

- visuella

- vill

- Sätt..

- sätt

- we

- webb

- webbservice

- Webbplats

- veckor

- VÄL

- były

- Vad

- när

- som

- medan

- VEM

- varför

- bred

- Brett utbud

- utbredd

- kommer

- med

- inom

- utan

- ord

- Arbete

- arbetade

- arbetssätt

- skulle

- skriva

- skrivning

- år

- Om er

- Din

- zephyrnet