Maskininlärning (ML) hjälper organisationer att öka intäkterna, driva affärstillväxt och minska kostnaderna genom att optimera kärnverksamhetens funktioner över flera vertikaler, såsom efterfrågeprognoser, kreditvärdering, prissättning, förutsäga kundavgång, identifiera näst bästa erbjudanden, förutsäga sena leveranser och förbättra tillverkningskvaliteten. Traditionella ML-utvecklingscykler tar månader och kräver knappa kunskaper inom datavetenskap och ML-teknik. Analytikers idéer för ML-modeller sitter ofta i långa eftersläpningar i väntan på datavetenskapsteamets bandbredd, medan datavetare fokuserar på mer komplexa ML-projekt som kräver deras fulla kompetens.

För att hjälpa till att bryta detta dödläge har vi gjort det introducerade Amazon SageMaker Canvas, en kodfri ML-lösning som kan hjälpa företag att påskynda leveransen av ML-lösningar ner till timmar eller dagar. SageMaker Canvas gör det möjligt för analytiker att enkelt använda tillgänglig data i datasjöar, datalager och operativa datalager; bygga ML-modeller; och använd dem för att göra förutsägelser interaktivt och för batchpoäng på bulkdatauppsättningar – allt utan att skriva en enda kodrad.

I det här inlägget visar vi hur SageMaker Canvas möjliggör samarbete mellan datavetare och affärsanalytiker, vilket uppnår snabbare time to market och accelererar utvecklingen av ML-lösningar. Analytiker får sin egen no-code ML-arbetsyta i SageMaker Canvas, utan att behöva bli en ML-expert. Analytiker kan sedan dela sina modeller från Canvas med några få klick, som datavetare kommer att kunna arbeta med i Amazon SageMaker Studio, en heltäckande ML-integrerad utvecklingsmiljö (IDE). Genom att arbeta tillsammans kan affärsanalytiker ta med sig sin domänkunskap och resultaten av experimentet, medan datavetare effektivt kan skapa pipelines och effektivisera processen.

Låt oss djupdyka i hur arbetsflödet skulle se ut.

Affärsanalytiker bygger en modell och delar den sedan

För att förstå hur SageMaker Canvas förenklar samarbetet mellan affärsanalytiker och datavetare (eller ML-ingenjörer), närmar vi oss först processen som affärsanalytiker. Innan du börjar, se Tillkännager Amazon SageMaker Canvas – en visuell maskininlärningsförmåga utan kod för affärsanalytiker för instruktioner om att bygga och testa modellen med SageMaker Canvas.

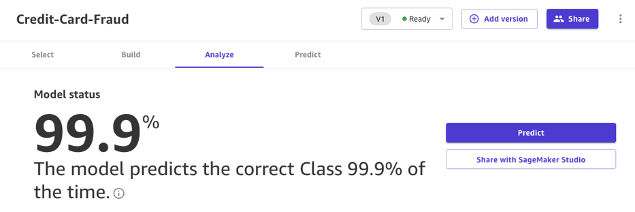

För det här inlägget använder vi en modifierad version av Datauppsättning för upptäckt av kreditkortsbedrägerier från Kaggle, en välkänd datauppsättning för ett binärt klassificeringsproblem. Datauppsättningen är ursprungligen mycket obalanserad – den har väldigt få poster som klassificeras som en negativ klass (anomala transaktioner). Oavsett målfunktionsdistribution kan vi fortfarande använda denna datauppsättning, eftersom SageMaker Canvas hanterar denna obalans när den tränar och ställer in en modell automatiskt. Denna datauppsättning består av cirka 9 miljoner celler. Du kan också ladda ner en reducerad version av denna datauppsättning. Datauppsättningsstorleken är mycket mindre, omkring 500,000 0 celler, eftersom den har undersamplats slumpmässigt och sedan översamplats med SMOTE-tekniken för att säkerställa att så lite information som möjligt går förlorad under denna process. Att köra ett helt experiment med denna reducerade datauppsättning kostar dig $XNUMX under SageMaker Canvas Free Tier.

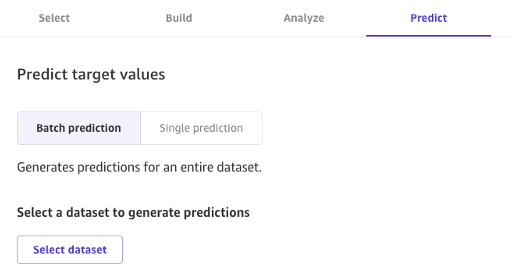

Efter att modellen har byggts kan analytiker använda den för att göra förutsägelser direkt i Canvas för antingen individuella förfrågningar eller för en hel indatauppsättning i bulk.

Modeller byggda med Canvas Standard Build kan också enkelt delas med ett klick på en knapp med datavetare och ML-ingenjörer som använder SageMaker Studio. Detta gör att en dataforskare kan validera prestandan för modellen du har byggt och ge feedback. ML-ingenjörer kan hämta din modell och integrera den med befintliga arbetsflöden och produkter som är tillgängliga för ditt företag och dina kunder. Observera att det i skrivande stund inte är möjligt att dela en modell byggd med Canvas Quick Build eller en tidsserieprognosmodell.

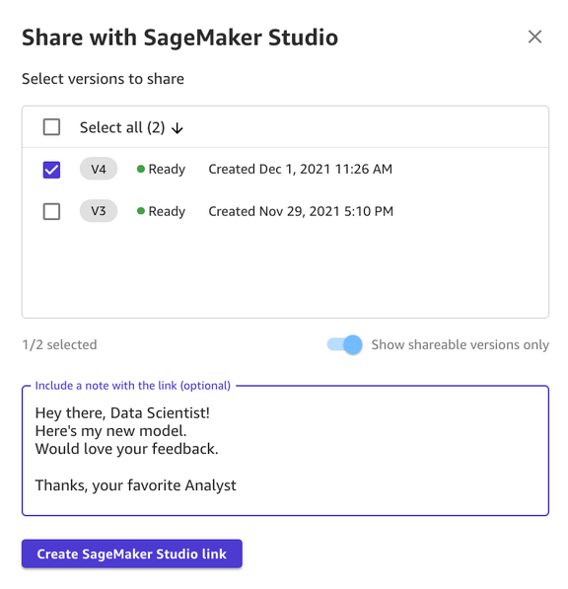

Att dela en modell via Canvas UI är enkelt:

- Välj en modell på sidan som visar modellerna som du har skapat.

- Välja Dela.

- Välj en eller flera versioner av modellen som du vill dela.

- Alternativt kan du inkludera en anteckning som ger mer sammanhang om modellen eller den hjälp du letar efter.

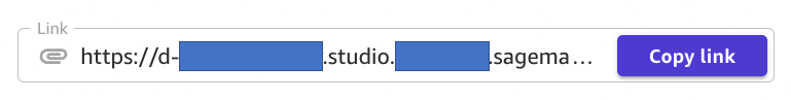

- Välja Skapa SageMaker Studio Link.

- Kopiera den genererade länken.

Och det är allt! Du kan nu dela länken med dina kollegor via Slack, e-post eller någon annan metod som du föredrar. Dataforskaren måste vara i samma SageMaker Studio-domän för att få åtkomst till din modell, så se till att så är fallet med din organisations administratör.

Dataforskare får tillgång till modellinformationen från SageMaker Studio

Låt oss nu spela rollen som en datavetare eller ML-ingenjör och se saker ur deras synvinkel med SageMaker Studio.

Länken som delas av analytikern tar oss till SageMaker Studio, den första molnbaserade IDE för end-to-end ML-arbetsflödet.

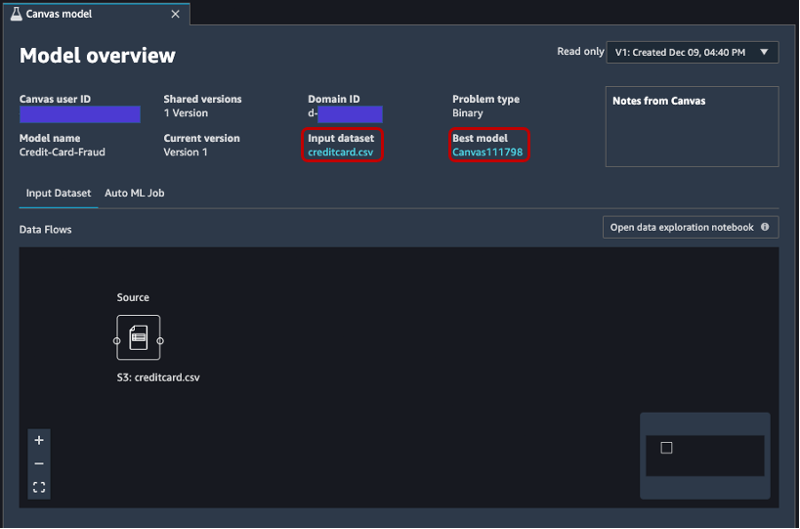

Fliken öppnas automatiskt och visar en översikt över modellen skapad av analytikern i SageMaker Canvas. Du kan snabbt se modellens namn, ML-problemtypen, modellversionen och vilken användare som skapat modellen (under fältet Canvas användar-ID). Du har också tillgång till detaljer om indatadataset och den bästa modellen som SageMaker kunde producera. Vi kommer att fördjupa oss i det senare i inlägget.

På Indatauppsättning fliken, kan du också se dataflödet från källan till indatauppsättningen. I det här fallet används bara en datakälla och inga kopplingsåtgärder har tillämpats, så en enda källa visas. Du kan analysera statistik och detaljer om datamängden genom att välja Öppna anteckningsboken för datautforskning. Den här anteckningsboken låter dig utforska de data som var tillgängliga innan du tränade modellen och innehåller en analys av målvariabeln, ett urval av indata, statistik och beskrivningar av kolumner och rader, samt annan användbar information för dataforskaren att veta mer om datasetet. För att lära dig mer om denna rapport, se Datautforskningsrapport.

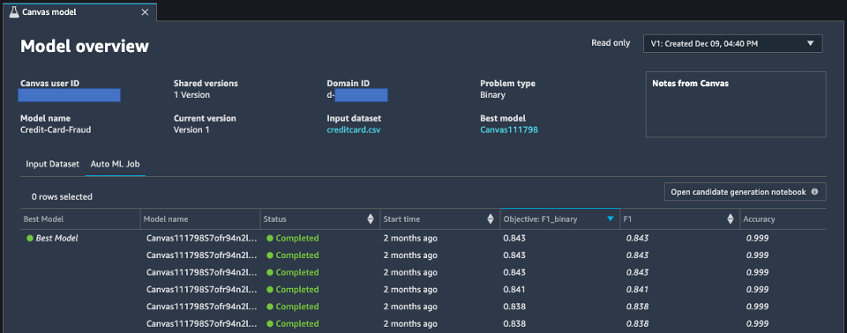

Efter att ha analyserat indatadataset, låt oss gå vidare till den andra fliken i modellöversikten, AutoML jobb. Den här fliken innehåller en beskrivning av AutoML-jobbet när du valde alternativet Standardbygg i SageMaker Canvas.

AutoML-tekniken under SageMaker Canvas eliminerar de tunga lyften av att bygga ML-modeller. Den bygger, tränar och justerar automatiskt den bästa ML-modellen baserat på dina data genom att använda ett automatiserat tillvägagångssätt, samtidigt som du kan behålla full kontroll och synlighet. Denna synlighet på de genererade kandidatmodellerna samt hyperparametrarna som används under AutoML-processen finns i anteckningsbok för kandidatgenerering, som är tillgänglig på den här fliken.

Smakämnen AutoML jobb Fliken innehåller också en lista över alla modeller som byggts som en del av AutoML-processen, sorterade efter F1-målmåttet. För att lyfta fram den bästa modellen av de lanserade utbildningsjobben används en tagg med en grön cirkel i Bästa modellen kolumn. Du kan också enkelt visualisera andra mätvärden som används under tränings- och utvärderingsfasen, såsom noggrannhetspoäng och Area Under the Curve (AUC). För att lära dig mer om de modeller som du kan träna under ett AutoML-jobb och de mätvärden som används för att utvärdera den tränade modellens prestanda, se Modellstöd, mätvärden och validering.

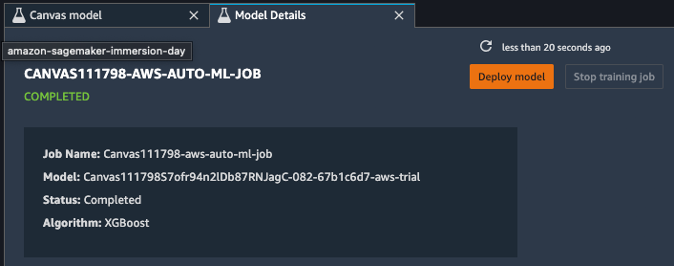

För att lära dig mer om modellen kan du nu högerklicka på den bästa modellen och välja Öppna i modelldetaljer. Alternativt kan du välja Bästa modellen länken överst på Modellöversikt avsnitt som du först besökte.

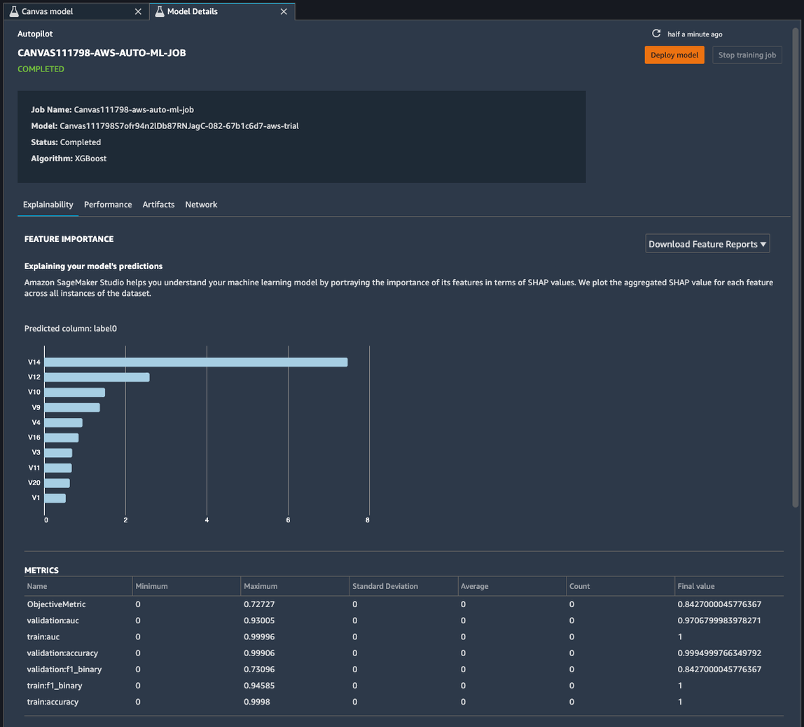

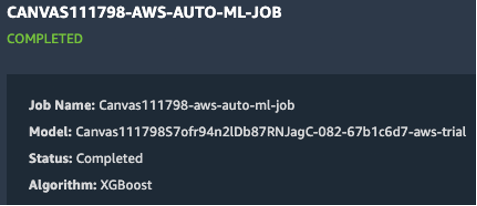

Sidan med modelldetaljer innehåller en uppsjö av användbar information om den modell som presterade bäst med denna indata. Låt oss först fokusera på sammanfattningen högst upp på sidan. Det föregående exemplet visar att, av hundratals modellträningskörningar, presterade en XGBoost-modell bäst på indatauppsättningen. När detta skrivs kan SageMaker Canvas träna tre typer av ML-algoritmer: linjär inlärare, XGBoost och en multilayer perceptron (MLP), var och en med en mängd olika förbearbetningspipelines och hyperparametrar. För att lära dig mer om varje algoritm, se sida med stödda algoritmer.

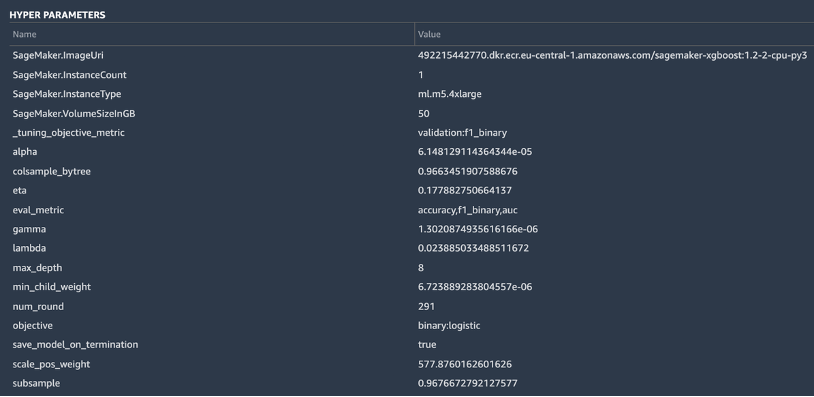

SageMaker innehåller även en förklarande funktionalitet tack vare en skalbar och effektiv implementering av KernelSHAP, baserat på konceptet med ett Shapley-värde från området för kooperativ spelteori som tilldelar varje funktion ett betydelsevärde för en viss förutsägelse. Detta möjliggör insyn i hur modellen kom fram till sina förutsägelser, och det är mycket användbart att definiera funktionsviktighet. En fullständig förklaringsrapport inklusive funktionsviktighet kan laddas ner i PDF-, anteckningsbok- eller rådataformat. I den rapporten visas en bredare uppsättning mätvärden samt en fullständig lista över hyperparametrar som används under AutoML-jobbet. För att lära dig mer om hur SageMaker tillhandahåller integrerade förklaringsverktyg för AutoML-lösningar och standard-ML-algoritmer, se Använd integrerade förklaringsverktyg och förbättra modellkvaliteten med Amazon SageMaker Autopilot.

Slutligen visar de andra flikarna i den här vyn information om prestandadetaljer (förvirringsmatris, precisionsåterkallningskurva, ROC-kurva), artefakter som används för inmatningar och genereras under AutoML-jobbet och nätverksdetaljer.

Vid denna tidpunkt har dataforskaren två val: direkt distribuera modellen, eller skapa en utbildningspipeline som kan schemaläggas eller utlösas manuellt eller automatiskt. Följande avsnitt ger några insikter om båda alternativen.

Distribuera modellen direkt

Om dataforskaren är nöjd med resultaten från AutoML-jobbet kan de distribuera modellen direkt från Modellinformation sida. Det är lika enkelt som att välja Implementera modell bredvid modellnamnet.

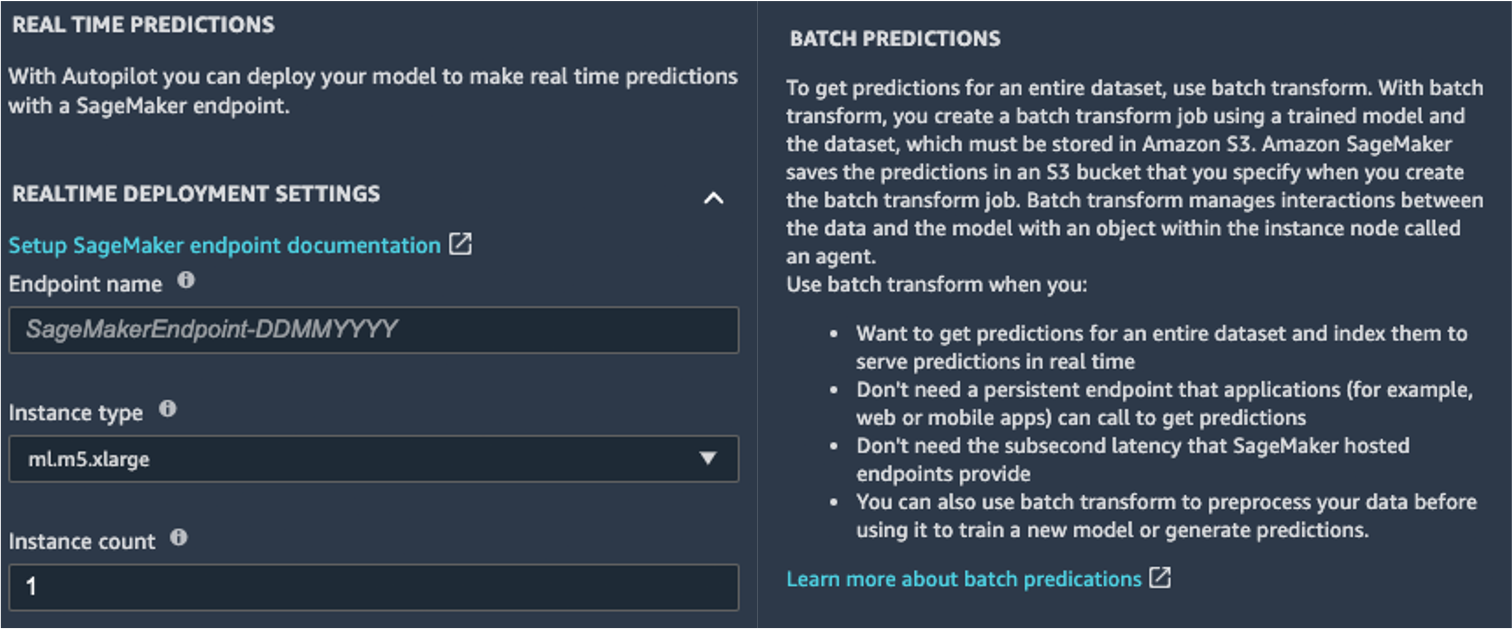

SageMaker visar dig två alternativ för distribution: en slutpunkt i realtid, driven av Amazon SageMaker-slutpunkter, och batch-inferens, drivs av Amazon SageMaker batch-transformation.

SageMaker tillhandahåller också andra sätt för slutledning. För att lära dig mer, se Distribuera modeller för slutledning.

För att aktivera realtidsförutsägelseläget ger du helt enkelt slutpunkten ett namn, en instanstyp och en instansräkning. Eftersom den här modellen inte kräver tunga beräkningsresurser kan du använda en CPU-baserad instans med ett initialt antal 1. Du kan lära dig mer om de olika typerna av instanser som finns tillgängliga och deras specifikationer på Prissida för Amazon SageMaker (i Prissättning på begäran väljer du Realtidsinferens flik). Om du inte vet vilken instans du ska välja för din implementering kan du också be SageMaker att hitta den bästa för dig enligt dina KPI:er genom att använda SageMaker Inference Recommender. Du kan också tillhandahålla ytterligare valfria parametrar, angående huruvida du vill fånga förfrågnings- och svarsdata till eller från slutpunkten. Detta kan visa sig vara användbart om du planerar övervakar din modell. Du kan också välja vilket innehåll du vill tillhandahålla som en del av ditt svar – oavsett om det bara är förutsägelsen eller förutsägelsesannolikheten, sannolikheten för alla klasser och måletiketterna.

För att köra ett batchpoängjobb och få förutsägelser för en hel uppsättning indata på en gång, kan du starta batchtransformeringsjobbet från AWS Management Console eller via SageMaker Python SDK. För att lära dig mer om batchtransformering, se Använd Batch Transform och exempelanteckningsböckerna.

Definiera en utbildningspipeline

ML-modeller kan mycket sällan, om någonsin, betraktas som statiska och oföränderliga, eftersom de glider från baslinjen de har tränats på. Verkliga data utvecklas över tiden, och fler mönster och insikter dyker upp ur dem, som kanske eller kanske inte fångas upp av den ursprungliga modellen som tränats på historiska data. För att lösa detta problem kan du sätta upp en träningspipeline som automatiskt tränar om dina modeller med den senaste tillgängliga data.

När man definierar denna pipeline är ett av alternativen för datavetaren att återigen använda AutoML för träningspipelinen. Du kan starta ett AutoML-jobb programmatiskt genom att anropa create_auto_ml_job() API från AWS Boto3 SDK. Du kan ringa denna operation från en AWS Lambda funktion inom en AWS stegfunktioner arbetsflöde, eller från en LambdaStep in Amazon SageMaker-rörledningar.

Alternativt kan dataforskaren använda kunskapen, artefakterna och hyperparametrarna som erhålls från AutoML-jobbet för att definiera en komplett utbildningspipeline. Du behöver följande resurser:

- Algoritmen som fungerade bäst för användningsfallet – Du har redan fått denna information från sammanfattningen av den Canvas-genererade modellen. För detta användningsfall är det den inbyggda XGBoost-algoritmen. För instruktioner om hur du använder SageMaker Python SDK för att träna XGBoost-algoritmen med SageMaker, se Använd XGBoost med SageMaker Python SDK.

- Hyperparametrarna som härleds av AutoML-jobbet – Dessa finns i Förklarbarhet sektion. Du kan använda dem som indata när du definierar träningsjobbet med SageMaker Python SDK.

- Funktionsteknikkoden som finns i avsnittet Artefakter – Du kan använda den här koden både för att förbearbeta data före träning (till exempel via Amazon SageMaker Processing), eller före slutledning (till exempel som en del av en SageMaker-inferenspipeline).

Du kan kombinera dessa resurser som en del av en SageMaker-pipeline. Vi utelämnar implementeringsdetaljerna i det här inlägget – håll utkik efter mer innehåll som kommer om detta ämne.

Slutsats

SageMaker Canvas låter dig använda ML för att generera förutsägelser utan att behöva skriva någon kod. En affärsanalytiker kan självständigt börja använda den med lokala datauppsättningar, såväl som data som redan lagrats på Amazon enkel lagringstjänst (Amazon S3), Amazon RedShift, eller Snowflake. Med bara några få klick kan de förbereda och sammanfoga sina datauppsättningar, analysera uppskattad noggrannhet, verifiera vilka kolumner som har effekt, träna den bäst presterande modellen och generera nya individuella eller batch-förutsägelser, allt utan att behöva anlita en expert dataforskare. Sedan kan de, efter behov, dela modellen med ett team av datavetare eller MLOps-ingenjörer, som importerar modellerna till SageMaker Studio, och arbetar tillsammans med analytikern för att leverera en produktionslösning.

Affärsanalytiker kan självständigt få insikter från sina data utan att ha en examen i ML och utan att behöva skriva en enda rad kod. Dataforskare kan nu få ytterligare tid att arbeta med mer utmanande projekt som bättre kan använda deras omfattande kunskap om AI och ML.

Vi tror att detta nya samarbete öppnar dörren till att bygga många fler kraftfulla ML-lösningar för ditt företag. Du har nu analytiker som producerar värdefulla affärsinsikter, samtidigt som de låter datavetare och ML-ingenjörer hjälpa till att förfina, finjustera och utöka efter behov.

Ytterligare resurser

- För att lära dig mer om hur SageMaker ytterligare kan hjälpa affärsanalytiker, se Amazon SageMaker för affärsanalytiker.

- För att ta reda på mer om hur SageMaker låter datavetare utveckla, träna och distribuera sina ML-modeller, kolla in Amazon SageMaker för dataforskare.

- För mer information om hur SageMaker kan hjälpa MLOps-ingenjörer att effektivisera ML-livscykeln med MLOps, se Amazon SageMaker för MLOps-ingenjörer.

Om författarna

Davide Gallitelli är en specialistlösningsarkitekt för AI/ML i EMEA-regionen. Han är baserad i Bryssel och har ett nära samarbete med kunder i hela Benelux. Han har varit utvecklare sedan han var väldigt ung, började koda vid 7 års ålder. Han började lära sig AI/ML på universitetet och har blivit kär i det sedan dess.

Davide Gallitelli är en specialistlösningsarkitekt för AI/ML i EMEA-regionen. Han är baserad i Bryssel och har ett nära samarbete med kunder i hela Benelux. Han har varit utvecklare sedan han var väldigt ung, började koda vid 7 års ålder. Han började lära sig AI/ML på universitetet och har blivit kär i det sedan dess.

Mark Roy är en huvudsaklig maskininlärningsarkitekt för AWS, som hjälper kunderna att designa och bygga AI / ML-lösningar. Marks arbete täcker ett brett spektrum av ML-användningsfall, med ett primärt intresse för datorsyn, djupinlärning och skalning av ML över hela företaget. Han har hjälpt företag i många branscher, inklusive försäkringar, finansiella tjänster, media och underhållning, sjukvård, verktyg och tillverkning. Mark har sex AWS-certifieringar, inklusive ML-specialcertifiering. Innan Mark började på AWS var han arkitekt, utvecklare och teknologiledare i över 25 år, inklusive 19 år inom finansiella tjänster.

Mark Roy är en huvudsaklig maskininlärningsarkitekt för AWS, som hjälper kunderna att designa och bygga AI / ML-lösningar. Marks arbete täcker ett brett spektrum av ML-användningsfall, med ett primärt intresse för datorsyn, djupinlärning och skalning av ML över hela företaget. Han har hjälpt företag i många branscher, inklusive försäkringar, finansiella tjänster, media och underhållning, sjukvård, verktyg och tillverkning. Mark har sex AWS-certifieringar, inklusive ML-specialcertifiering. Innan Mark började på AWS var han arkitekt, utvecklare och teknologiledare i över 25 år, inklusive 19 år inom finansiella tjänster.

- Myntsmart. Europas bästa bitcoin- och kryptobörs.

- Platoblockchain. Web3 Metaverse Intelligence. Kunskap förstärkt. FRI TILLGÅNG.

- CryptoHawk. Altcoin radar. Gratis provperiod.

- Källa: https://aws.amazon.com/blogs/machine-learning/build-share-deploy-how-business-analysts-and-data-scientists-achieve-faster-time-to-market-using-no- code-ml-and-amazon-sagemaker-canvas/

- "

- 000

- 100

- 7

- 9

- Om oss

- accelerera

- accelererande

- tillgång

- Enligt

- tvärs

- Annat

- administration

- AI

- algoritm

- algoritmer

- Alla

- tillåta

- redan

- amason

- analys

- analytiker

- api

- tillvägagångssätt

- OMRÅDE

- runt

- Automatiserad

- tillgänglig

- AWS

- Baslinje

- blir

- BÄST

- gränsen

- bryssel

- SLUTRESULTAT

- Byggnad

- bygger

- inbyggd

- företag

- Ring

- fall

- certifiering

- val

- Circle

- klassificering

- koda

- samverkan

- Kolumn

- kommande

- Företag

- företag

- komplex

- Compute

- begrepp

- förvirring

- innehåller

- innehåll

- kontroll

- kooperativ

- Kärna

- Kostar

- kredit

- kurva

- Kunder

- datum

- datavetenskap

- datavetare

- leverans

- Efterfrågan

- distribuera

- utplacering

- Designa

- Detektering

- utveckla

- Utvecklare

- Utveckling

- olika

- fördelning

- inte

- domän

- ner

- lätt

- effektiv

- Slutpunkt

- ingenjör

- Teknik

- Ingenjörer

- Företag

- Underhållning

- Miljö

- beräknad

- exempel

- experimentera

- utforskning

- förlänga

- snabbare

- Leverans

- återkoppling

- finansiella

- finansiella tjänster

- Förnamn

- flöda

- Fokus

- efter

- format

- bedrägeri

- Fri

- full

- fungera

- funktionalitet

- lek

- generera

- få

- Ge

- Grön

- Tillväxt

- har

- hälso-och sjukvård

- hjälpa

- hjälper

- Markera

- höggradigt

- historisk

- innehar

- Hur ser din drömresa ut

- How To

- HTTPS

- Hundratals

- vikt

- förbättra

- innefattar

- Inklusive

- Öka

- individuellt

- industrier

- informationen

- insikter

- försäkring

- integrera

- integrerade

- intresse

- IT

- Jobb

- Lediga jobb

- delta

- kunskap

- Etiketter

- senaste

- lansera

- LÄRA SIG

- inlärning

- linje

- LINK

- Lista

- liten

- lokal

- Lång

- du letar

- älskar

- Maskinen

- maskininlärning

- ledning

- manuellt

- Produktion

- markera

- marknad

- Matris

- Media

- Metrics

- miljon

- ML

- modell

- modeller

- månader

- flytta

- nät

- anteckningsbok

- Erbjudanden

- öppnas

- Verksamhet

- Alternativet

- Tillbehör

- beställa

- organisation

- organisationer

- Övriga

- prestanda

- föreställningar

- fas

- planering

- Spela

- Synvinkel

- möjlig

- den mäktigaste

- förutsägelse

- Förutsägelser

- prissättning

- primär

- Principal

- Problem

- process

- producera

- Produktion

- Produkter

- projekt

- ge

- ger

- dra

- kvalitet

- snabbt

- område

- Raw

- realtid

- minska

- rapport

- kräver

- Resurser

- respons

- Resultat

- intäkter

- Körning

- rinnande

- skalbar

- skalning

- Vetenskap

- Forskare

- vetenskapsmän

- sDK

- vald

- Serier

- Tjänster

- in

- Dela

- delas

- Enkelt

- SEX

- Storlek

- färdigheter

- slak

- So

- Lösningar

- LÖSA

- starta

- igång

- statistik

- förvaring

- lagrar

- studio

- stödja

- Målet

- grupp

- Teknologi

- Testning

- källan

- hela

- tid

- tillsammans

- verktyg

- topp

- traditionell

- Utbildning

- tåg

- Transaktioner

- Förvandla

- Öppenhet

- ui

- förstå

- universitet

- us

- användning

- värde

- utsikt

- synlighet

- syn

- Vad

- om

- VEM

- inom

- utan

- Arbete

- arbetade

- arbetssätt

- fungerar

- skrivning

- år