När en kund har en produktionsklar intelligent dokumentbehandling (IDP) arbetsbelastning, får vi ofta förfrågningar om en välarbetad granskning. För att bygga en företagslösning måste utvecklarresurser, kostnad, tid och användarupplevelse balanseras för att uppnå önskat affärsresultat. De AWS välarkitekterade ramverk tillhandahåller ett systematiskt sätt för organisationer att lära sig operativa och arkitektoniska bästa praxis för att designa och driva pålitliga, säkra, effektiva, kostnadseffektiva och hållbara arbetsbelastningar i molnet.

IDP Well-Architected Custom Lens följer AWS Well-Architected Framework och granskar lösningen med sex pelare med granulariteten hos ett specifikt AI eller maskininlärning (ML) och ger vägledning för att ta itu med vanliga utmaningar. IDP-välbyggda anpassade objektiv i Välbyggt verktyg innehåller frågor om var och en av pelarna. Genom att svara på dessa frågor kan du identifiera potentiella risker och lösa dem genom att följa din förbättringsplan.

Det här inlägget fokuserar på Prestanda Effektivitet pelare av IDP-arbetsbelastningen. Vi dyker djupt ner i att designa och implementera lösningen för att optimera för genomströmning, latens och övergripande prestanda. Vi börjar med att diskutera några vanliga indikatorer på att du bör genomföra en välarchiterad granskning och introducerar de grundläggande tillvägagångssätten med designprinciper. Sedan går vi igenom varje fokusområde ur ett tekniskt perspektiv.

För att följa med i detta inlägg bör du känna till de tidigare inläggen i den här serien (del 1 och del 2) och riktlinjerna i Vägledning för intelligent dokumentbehandling på AWS. Dessa resurser introducerar vanliga AWS-tjänster för IDP-arbetsbelastningar och föreslagna arbetsflöden. Med denna kunskap är du nu redo att lära dig mer om att producera din arbetsbörda.

Vanliga indikatorer

Följande är vanliga indikatorer på att du bör genomföra en välstrukturerad ramgranskning för pelaren Performance Efficiency:

- Hög latens – När latensen för optisk teckenigenkänning (OCR), enhetsigenkänning eller arbetsflödet från slut till slut tar längre tid än ditt tidigare riktmärke, kan detta vara en indikator på att arkitekturdesignen inte täcker belastningstestning eller felhantering.

- Frekvent strypning – Du kan uppleva strypning av AWS-tjänster som amazontext på grund av begärandegränser. Detta innebär att arkitekturen behöver justeras genom att granska arkitekturens arbetsflöde, synkron och asynkron implementering, beräkning av transaktioner per sekund (TPS) med mera.

- Felsökningssvårigheter – När det finns ett dokumentprocessfel kanske du inte har ett effektivt sätt att identifiera var felet finns i arbetsflödet, vilken tjänst det är relaterat till och varför felet uppstod. Detta innebär att systemet saknar insyn i loggar och fel. Överväg att se över loggningsdesignen för telemetridata och lägga till infrastruktur som kod (IaC), såsom pipelines för dokumentbearbetning, till lösningen.

| indikatorer | Beskrivning | Arkitektonisk klyfta |

| Hög latens | OCR, enhetsigenkänning eller end-to-end arbetsflödeslatens överstiger tidigare benchmark |

|

| Frekvent strypning | Strypning av AWS-tjänster som Amazon Textract på grund av begärandegränser |

|

| Svårt att felsöka | Ingen insyn i plats, orsak och orsak till dokumentbearbetningsfel |

|

Designprinciper

I det här inlägget diskuterar vi tre designprinciper: delegering av komplexa AI-uppgifter, IaC-arkitekturer och serverlösa arkitekturer. När du stöter på en avvägning mellan två implementeringar kan du återgå till designprinciperna med din organisations affärsprioriteringar så att du kan fatta beslut effektivt.

- Delegera komplexa AI-uppgifter – Du kan möjliggöra snabbare AI-antagande i din organisation genom att överföra ML-modellutvecklingens livscykel till hanterade tjänster och dra fördel av modellutvecklingen och infrastrukturen som tillhandahålls av AWS. Istället för att kräva att dina datavetenskaps- och IT-team bygger och underhåller AI-modeller, kan du använda förutbildade AI-tjänster som kan automatisera uppgifter åt dig. Detta gör att dina team kan fokusera på arbete med högre värde som skiljer din verksamhet åt, medan molnleverantören hanterar komplexiteten i att träna, implementera och skala AI-modellerna.

- IaC-arkitekturer – När du kör en IDP-lösning innehåller lösningen flera AI-tjänster för att utföra hela arbetsflödet kronologiskt. Du kan utforma lösningen med arbetsflödespipelines med hjälp av AWS stegfunktioner för att förbättra feltolerans, parallell bearbetning, synlighet och skalbarhet. Dessa fördelar kan göra det möjligt för dig att optimera användningen och kostnaderna för underliggande AI-tjänster.

- Server arkitekturer – IDP är ofta en händelsedriven lösning, initierad av användaruppladdningar eller schemalagda jobb. Lösningen kan skalas ut horisontellt genom att höja samtalspriserna för AI-tjänsterna, AWS Lambdaoch andra inblandade tjänster. Ett serverlöst tillvägagångssätt ger skalbarhet utan att överprovisionera resurser, vilket förhindrar onödiga utgifter. Övervakningen bakom den serverlösa designen hjälper till att upptäcka prestandaproblem.

Figur 1. Fördelen med att tillämpa designprinciper.

Med dessa tre designprinciper i åtanke kan organisationer skapa en effektiv grund för AI/ML-adoption på molnplattformar. Genom att delegera komplexitet, implementera motståndskraftig infrastruktur och designa för skala kan organisationer optimera sina AI/ML-lösningar.

I de följande avsnitten diskuterar vi hur man kan hantera vanliga utmaningar när det gäller tekniska fokusområden.

Fokusområden

När vi granskar prestandaeffektiviteten granskar vi lösningen från fem fokusområden: arkitekturdesign, datahantering, felhantering, systemövervakning och modellövervakning. Med dessa fokusområden kan du genomföra en arkitekturgranskning från olika aspekter för att förbättra effektiviteten, observerbarheten och skalbarheten för de tre komponenterna i ett AI/ML-projekt, data, modell eller affärsmål.

Arkitekturdesign

Genom att gå igenom frågorna i detta fokusområde kommer du att granska det befintliga arbetsflödet för att se om det följer bästa praxis. Det föreslagna arbetsflödet ger ett gemensamt mönster som organisationer kan följa och förhindrar trial-and-error-kostnader.

Baserat på föreslagen arkitektur, följer arbetsflödet de sex stegen datainsamling, klassificering, extrahering, anrikning, granskning och validering samt konsumtion. I de vanliga indikatorerna vi diskuterade tidigare kommer två av tre från arkitekturdesignproblem. Detta beror på att när du startar ett projekt med ett improviserat tillvägagångssätt kan du möta projektbegränsningar när du försöker anpassa din infrastruktur till din lösning. Med arkitekturdesigngranskningen kan den improviserade designen frikopplas som etapper, och var och en av dem kan omvärderas och ordnas om.

Du kan spara tid, pengar och arbete genom att implementera klassificeringar i ditt arbetsflöde, och dokument går till nedströmsapplikationer och API:er baserat på dokumenttyp. Detta förbättrar dokumentprocessens observerbarhet och gör lösningen enkel att underhålla när du lägger till nya dokumenttyper.

Datahantering

Prestanda för en IDP-lösning inkluderar latens, genomströmning och användarupplevelsen från slut till slut. Hur man hanterar dokumentet och dess extraherade information i lösningen är nyckeln till datakonsistens, säkerhet och integritet. Dessutom måste lösningen hantera höga datavolymer med låg latens och hög genomströmning.

När du går igenom frågorna i detta fokusområde kommer du att granska dokumentarbetsflödet. Detta inkluderar dataintag, dataförbehandling, konvertering av dokument till dokumenttyper som accepteras av Amazon Textract, hantering av inkommande dokumentströmmar, dirigering av dokument efter typ och implementering av åtkomstkontroll och lagringspolicyer.

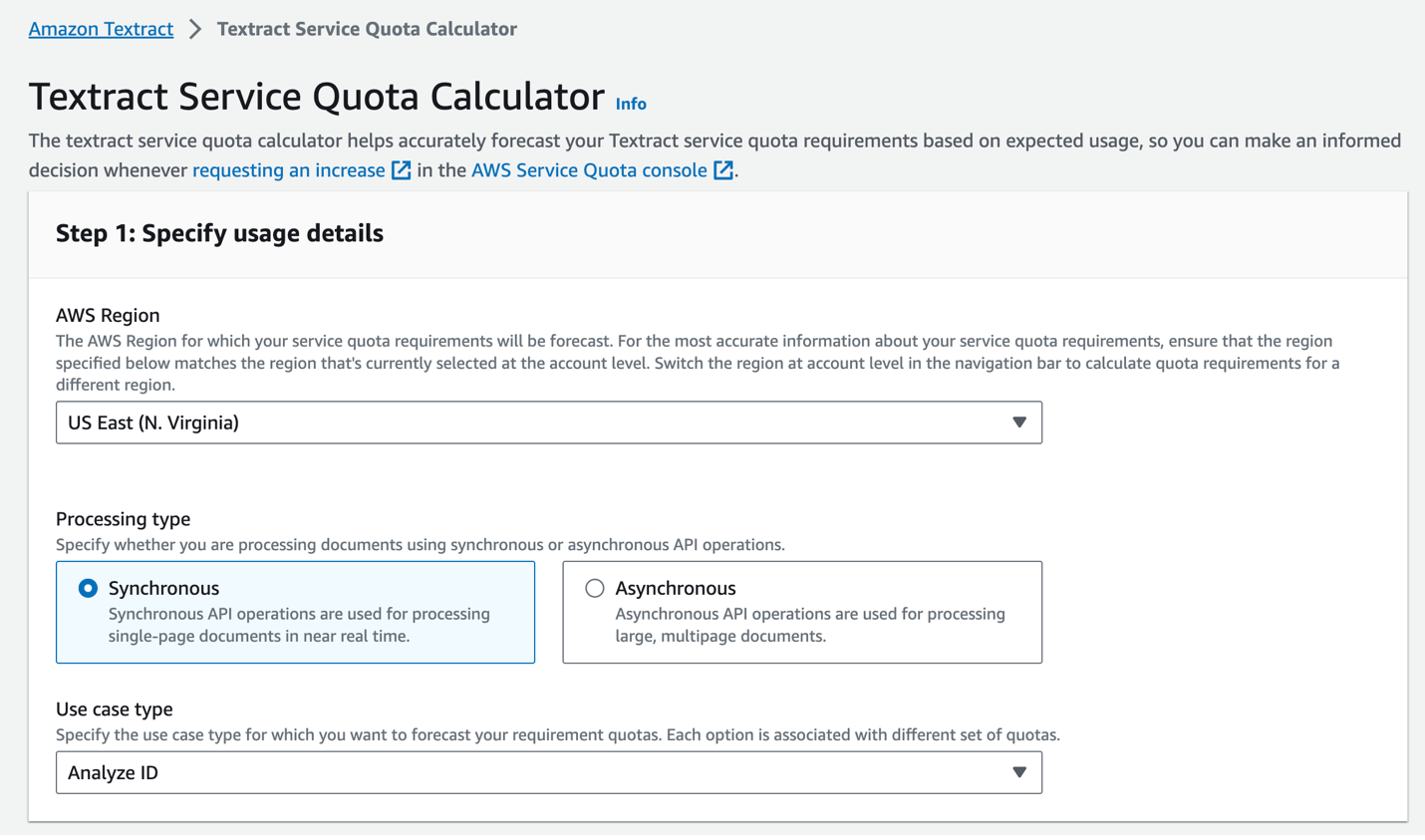

Genom att till exempel lagra ett dokument i de olika bearbetade faserna kan du vända bearbetningen till föregående steg om det behövs. Datalivscykeln säkerställer tillförlitlighet och efterlevnad för arbetsbelastningen. Genom att använda Amazon Textract Service Quots Calculator (se följande skärmdump), asynkrona funktioner på Amazon Textract, Lambda, Step Functions, Amazon enkel kötjänst (Amazon SQS), och Amazon enkel meddelandetjänst (Amazon SNS), organisationer kan automatisera och skala dokumentbearbetningsuppgifter för att möta specifika behov av arbetsbelastning.

Figur 2. Amazon Textract Service Quota Calculator.

Felhantering

Robust felhantering är avgörande för att spåra dokumentprocessens status, och det ger driftteamet tid att reagera på eventuella onormala beteenden, såsom oväntade dokumentvolymer, nya dokumenttyper eller andra oplanerade problem från tredjepartstjänster. Ur organisationens perspektiv kan korrekt felhantering förbättra systemets drifttid och prestanda.

Du kan dela upp felhanteringen i två nyckelaspekter:

- AWS-tjänstkonfiguration – Du kan implementera logik för ett nytt försök med exponentiell backoff för att hantera övergående fel som strypning. När du börjar bearbeta genom att anropa en asynkron Start*-operation, som t.ex StartDocumentTextDetection, kan du ange att slutförandestatusen för begäran publiceras till ett SNS-ämne i NotificationChannel konfiguration. Detta hjälper dig att undvika strypningsgränser för API-anrop på grund av polling av Get* API:erna. Du kan även implementera larm i amazoncloudwatch och utlöses för att varna när ovanliga felsteg uppstår.

- Förbättring av felrapport – Detta inkluderar detaljerade meddelanden med en lämplig detaljnivå per feltyp och beskrivningar av felhanteringssvar. Med rätt felhanteringskonfiguration kan systemen bli mer motståndskraftiga genom att implementera vanliga mönster som att automatiskt försöka återuppta intermittenta fel, använda strömbrytare för att hantera kaskadfel och övervakningstjänster för att få insikt i fel. Detta gör att lösningen kan balansera mellan gränser för återförsök och förhindrar oändliga kretsslingor.

Modellövervakning

Prestandan hos ML-modeller övervakas med avseende på försämring över tid. När data och systemförhållanden förändras spåras modellens prestanda- och effektivitetsmått för att säkerställa att omskolning utförs vid behov.

ML-modellen i ett IDP-arbetsflöde kan vara en OCR-modell, enhetsigenkänningsmodell eller klassificeringsmodell. Modellen kan komma från en AWS AI-tjänst, en modell med öppen källkod Amazon SageMaker, Amazonas berggrund, eller andra tjänster från tredje part. Du måste förstå begränsningarna och användningsfallen för varje tjänst för att kunna identifiera sätt att förbättra modellen med mänsklig feedback och förbättra tjänstens prestanda över tid.

Ett vanligt tillvägagångssätt är att använda tjänsteloggar för att förstå olika nivåer av noggrannhet. Dessa loggar kan hjälpa datavetenskapsteamet att identifiera och förstå eventuella behov av modellomskolning. Din organisation kan välja omskolningsmekanismen – den kan vara kvartalsvis, månadsvis eller baserad på vetenskapliga mätvärden, till exempel när noggrannheten sjunker under en given tröskel.

Målet med övervakningen är inte bara att upptäcka problem, utan att stänga slingan för att kontinuerligt förfina modeller och hålla IDP-lösningen presterande när den yttre miljön utvecklas.

Systemövervakning

När du har implementerat IDP-lösningen i produktionen är det viktigt att övervaka nyckeltal och automatiseringsprestanda för att identifiera förbättringsområden. Mätvärdena bör inkludera affärsmått och tekniska mätvärden. Detta gör att företaget kan utvärdera systemets prestanda, identifiera problem och göra förbättringar av modeller, regler och arbetsflöden över tid för att öka automationshastigheten för att förstå den operativa effekten.

På affärssidan är mätvärden som extraktionsnoggrannhet för viktiga områden, övergripande automatiseringshastighet som anger procentandelen dokument som behandlas utan mänsklig inblandning och genomsnittlig bearbetningstid per dokument av största vikt. Dessa affärsmått hjälper till att kvantifiera slutanvändarnas upplevelse och effektivitetsvinster.

Tekniska mätvärden inklusive fel- och undantagsfrekvenser som inträffar under hela arbetsflödet är viktiga att spåra ur ett tekniskt perspektiv. Den tekniska statistiken kan också övervaka på varje nivå från ände till slut och ge en heltäckande bild av en komplex arbetsbelastning. Du kan dela upp mätvärdena i olika nivåer, till exempel lösningsnivå, arbetsflödesnivå från slut till slut, nivå på dokumenttyp, dokumentnivå, nivå för enhetsigenkänning och OCR-nivå.

Nu när du har gått igenom alla frågor i denna pelare kan du bedöma de andra pelarna och utveckla en förbättringsplan för din IDP-arbetsbelastning.

Slutsats

I det här inlägget diskuterade vi vanliga indikatorer som du kan behöva för att utföra en Well-Architected Framework-granskning för Performance Efficiency-pelaren för din IDP-arbetsbelastning. Vi gick sedan igenom designprinciper för att ge en överblick på hög nivå och diskutera lösningsmålet. Genom att följa dessa förslag med hänvisning till IDP Well-Architected Custom Lens och genom att granska frågorna efter fokusområde, bör du nu ha en projektförbättringsplan.

Om författarna

Mia Chang är en ML Specialist Solutions Architect för Amazon Web Services. Hon arbetar med kunder i EMEA och delar bästa praxis för att köra AI/ML-arbetsbelastningar i molnet med sin bakgrund inom tillämpad matematik, datavetenskap och AI/ML. Hon fokuserar på NLP-specifika arbetsbelastningar och delar med sig av sin erfarenhet som konferenstalare och bokförfattare. På fritiden tycker hon om att vandra, brädspel och brygga kaffe.

Mia Chang är en ML Specialist Solutions Architect för Amazon Web Services. Hon arbetar med kunder i EMEA och delar bästa praxis för att köra AI/ML-arbetsbelastningar i molnet med sin bakgrund inom tillämpad matematik, datavetenskap och AI/ML. Hon fokuserar på NLP-specifika arbetsbelastningar och delar med sig av sin erfarenhet som konferenstalare och bokförfattare. På fritiden tycker hon om att vandra, brädspel och brygga kaffe.

Brijesh Pati är en Enterprise Solutions Architect på AWS. Hans primära fokus är att hjälpa företagskunder att använda molnteknik för sina arbetsbelastningar. Han har en bakgrund inom applikationsutveckling och företagsarkitektur och har arbetat med kunder från olika branscher som sport, finans, energi och professionella tjänster. Hans intressen inkluderar serverlösa arkitekturer och AI/ML.

Brijesh Pati är en Enterprise Solutions Architect på AWS. Hans primära fokus är att hjälpa företagskunder att använda molnteknik för sina arbetsbelastningar. Han har en bakgrund inom applikationsutveckling och företagsarkitektur och har arbetat med kunder från olika branscher som sport, finans, energi och professionella tjänster. Hans intressen inkluderar serverlösa arkitekturer och AI/ML.

Rui Cardoso är en partnerlösningsarkitekt på Amazon Web Services (AWS). Han fokuserar på AI/ML och IoT. Han arbetar med AWS Partners och stöttar dem i att utveckla lösningar i AWS. När han inte jobbar tycker han om att cykla, vandra och lära sig nya saker.

Rui Cardoso är en partnerlösningsarkitekt på Amazon Web Services (AWS). Han fokuserar på AI/ML och IoT. Han arbetar med AWS Partners och stöttar dem i att utveckla lösningar i AWS. När han inte jobbar tycker han om att cykla, vandra och lära sig nya saker.

Tim Condello är en senior arkitekt för artificiell intelligens (AI) och maskininlärning (ML) specialistlösningar på Amazon Web Services (AWS). Hans fokus är naturlig språkbehandling och datorseende. Tim tycker om att ta kundidéer och omvandla dem till skalbara lösningar.

Tim Condello är en senior arkitekt för artificiell intelligens (AI) och maskininlärning (ML) specialistlösningar på Amazon Web Services (AWS). Hans fokus är naturlig språkbehandling och datorseende. Tim tycker om att ta kundidéer och omvandla dem till skalbara lösningar.

Sherry Ding är en senior arkitekt för artificiell intelligens (AI) och maskininlärning (ML) specialistlösningar på Amazon Web Services (AWS). Hon har lång erfarenhet av maskininlärning med en doktorsexamen i datavetenskap. Hon arbetar främst med kunder i den offentliga sektorn med olika AI/ML-relaterade affärsutmaningar, och hjälper dem att påskynda sin maskininlärningsresa i AWS-molnet. När hon inte hjälper kunder tycker hon om utomhusaktiviteter.

Sherry Ding är en senior arkitekt för artificiell intelligens (AI) och maskininlärning (ML) specialistlösningar på Amazon Web Services (AWS). Hon har lång erfarenhet av maskininlärning med en doktorsexamen i datavetenskap. Hon arbetar främst med kunder i den offentliga sektorn med olika AI/ML-relaterade affärsutmaningar, och hjälper dem att påskynda sin maskininlärningsresa i AWS-molnet. När hon inte hjälper kunder tycker hon om utomhusaktiviteter.

Suyin Wang är en AI/ML Specialist Solutions Architect på AWS. Hon har en tvärvetenskaplig utbildningsbakgrund inom maskininlärning, finansiell informationstjänst och ekonomi, tillsammans med många års erfarenhet av att bygga datavetenskap och maskininlärningsapplikationer som löste verkliga affärsproblem. Hon tycker om att hjälpa kunder att identifiera rätt affärsfrågor och bygga rätt AI/ML-lösningar. På fritiden älskar hon att sjunga och laga mat.

Suyin Wang är en AI/ML Specialist Solutions Architect på AWS. Hon har en tvärvetenskaplig utbildningsbakgrund inom maskininlärning, finansiell informationstjänst och ekonomi, tillsammans med många års erfarenhet av att bygga datavetenskap och maskininlärningsapplikationer som löste verkliga affärsproblem. Hon tycker om att hjälpa kunder att identifiera rätt affärsfrågor och bygga rätt AI/ML-lösningar. På fritiden älskar hon att sjunga och laga mat.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://aws.amazon.com/blogs/machine-learning/build-well-architected-idp-solutions-with-a-custom-lens-part-4-performance-efficiency/

- : har

- :är

- :inte

- :var

- 1

- 10

- 100

- 32

- 7

- 8

- a

- Om Oss

- accelerera

- accepterade

- tillgång

- noggrannhet

- Uppnå

- aktiviteter

- tillsats

- Dessutom

- adress

- justerat

- anta

- Antagande

- Fördel

- fördelar

- AI

- AI-modeller

- AI-tjänster

- AI / ML

- Varna

- rikta

- Alla

- tillåter

- längs

- också

- amason

- amazontext

- Amazon Web Services

- Amazon Web Services (AWS)

- an

- och

- och infrastruktur

- vilken som helst

- api

- API: er

- Ansökan

- Application Development

- tillämpningar

- tillämpas

- Tillämpa

- tillvägagångssätt

- tillvägagångssätt

- lämpligt

- arkitektoniska

- arkitektur

- ÄR

- OMRÅDE

- områden

- konstgjord

- artificiell intelligens

- Konstgjord intelligens (AI)

- AS

- aspekter

- bedöma

- assist

- At

- Författaren

- automatisera

- automatiskt

- Automation

- genomsnitt

- undvika

- AWS

- bakgrund

- Balansera

- balanserad

- baserat

- BE

- därför att

- beteenden

- bakom

- nedan

- riktmärke

- fördel

- BÄST

- bästa praxis

- mellan

- ombord

- Brädspel

- boken

- Ha sönder

- SLUTRESULTAT

- Byggnad

- företag

- men

- by

- beräkning

- Ring

- anropande

- Samtal

- KAN

- fånga

- Vid

- fall

- Orsak

- utmaningar

- byta

- karaktär

- karaktärigenkänning

- Välja

- klassificering

- stängning

- cloud

- koda

- Kaffe

- komma

- Gemensam

- företag

- fullbordan

- komplex

- Komplexiteten

- Efterlevnad

- komponenter

- omfattande

- dator

- Datavetenskap

- Datorsyn

- villkor

- Genomför

- Konferens

- konfiguration

- Tänk

- konsumtion

- innehåller

- kontinuerligt

- kontroll

- omvandling

- Pris

- kostnadseffektiv

- Kostar

- täcka

- kritisk

- beställnings

- kund

- Kunder

- datum

- datahantering

- datavetenskap

- beslut

- frikopplat

- djup

- Examen

- distribuera

- utplacera

- Designa

- konstruktionsprinciper

- design

- önskas

- detalj

- detaljerad

- utveckla

- Utvecklare

- utveckla

- Utveckling

- olika

- svårigheter

- diskutera

- diskuteras

- diskutera

- Dyk

- dokumentera

- dokumentprocessen

- dokument

- inte

- ner

- Droppar

- grund

- varje

- Tidigare

- Ekonomi

- Utbildning

- Effektiv

- effektivt

- effektivitet

- effektiv

- EMEA

- möjliggöra

- änden

- början till slut

- energi

- Teknik

- förbättra

- Förbättrar

- berikning

- säkerställa

- säkerställer

- Företag

- enhet

- Miljö

- fel

- fel

- väsentlig

- etablera

- utvärdera

- utvecklas

- exempel

- överstiger

- undantag

- befintliga

- kostnader

- erfarenhet

- exponentiell

- omfattande

- Omfattande erfarenhet

- extern

- extraktion

- Misslyckande

- misslyckanden

- bekant

- snabbare

- Funktioner

- återkoppling

- Fält

- Figur

- finansiering

- finansiella

- finansiell information

- fem

- Fokus

- fokuserar

- fokusering

- följer

- efter

- följer

- För

- fundament

- Ramverk

- Fri

- från

- funktioner

- grundläggande

- Få

- resultat

- Games

- ges

- Go

- Målet

- kommer

- vägleda

- riktlinjer

- hantera

- Handtag

- Arbetsmiljö

- Har

- he

- hjälpa

- hjälpa

- hjälper

- här

- Hög

- högnivå

- hans

- vågrätt

- Hur ser din drömresa ut

- How To

- html

- http

- HTTPS

- humant

- idéer

- identifiera

- if

- Inverkan

- genomföra

- genomförande

- implementeringar

- genomföra

- med Esport

- förbättra

- förbättring

- förbättringar

- in

- innefattar

- innefattar

- Inklusive

- Inkommande

- Öka

- ökande

- Indikator

- indikatorer

- industrier

- informationen

- Infrastruktur

- initieras

- insikt

- Intelligens

- Intelligent

- Intelligent dokumentbehandling

- intressen

- ingripande

- in

- införa

- involverade

- iot

- problem

- IT

- DESS

- Lediga jobb

- resa

- jpg

- bara

- Ha kvar

- Nyckel

- kunskap

- arbetskraft

- språk

- Latens

- LÄRA SIG

- inlärning

- Nivå

- nivåer

- livscykel

- tycka om

- begränsningar

- gränser

- läsa in

- belägen

- läge

- skogsavverkning

- Logiken

- längre

- älskar

- Låg

- Maskinen

- maskininlärning

- huvudsakligen

- bibehålla

- göra

- GÖR

- hantera

- förvaltade

- ledning

- matematik

- Maj..

- betyder

- Möt

- meddelanden

- Metrics

- emot

- ML

- modell

- modeller

- pengar

- Övervaka

- övervakas

- övervakning

- månad

- mer

- multipel

- måste

- Natural

- Naturlig språkbehandling

- Behöver

- behövs

- behov

- Nya

- anmälan

- nu

- inträffade

- förekommande

- OCR

- of

- Ofta

- on

- öppet

- öppen källkod

- drift

- drift

- operativa

- optisk teckenigenkänning

- Optimera

- or

- beställa

- organisation

- organisationer

- Övriga

- ut

- Resultat

- över

- övergripande

- Översikt

- Parallell

- Yttersta

- del

- partnern

- partner

- Mönster

- mönster

- för

- procentuell

- Utföra

- prestanda

- utfört

- utför

- perspektiv

- phd

- Pelare

- pelare

- Planen

- Plattformar

- plato

- Platon Data Intelligence

- PlatonData

- Strategier

- Inlägg

- inlägg

- potentiell

- praxis

- förebyggande

- förhindrar

- föregående

- primär

- Principerna

- privatpolicy

- problem

- process

- Bearbetad

- bearbetning

- Produktion

- professionell

- projektet

- rätt

- ge

- förutsatt

- leverantör

- ger

- tillhandahålla

- allmän

- publicerade

- frågor

- Betygsätta

- rates

- snarare

- Reagera

- redo

- verkliga världen

- Anledningen

- motta

- erkännande

- referens

- förfina

- om

- Hälsningar

- relaterad

- tillförlitlighet

- pålitlig

- rapport

- begära

- förfrågningar

- elastisk

- Lös

- Resurser

- svar

- retentionstid

- vända

- översyn

- Granskad

- reviewing

- höger

- risker

- routing

- regler

- rinnande

- Save

- skalbarhet

- skalbar

- Skala

- skalning

- planerad

- Schemalagda jobb

- Vetenskap

- Andra

- sektioner

- sektor

- säkra

- säkerhet

- se

- senior

- Serier

- Server

- service

- Tjänster

- inställning

- aktier

- hon

- skall

- sida

- Enkelt

- SEX

- So

- lösning

- Lösningar

- några

- Källa

- Högtalare

- specialist

- specifik

- spikar

- Sporter

- stadier

- starta

- status

- Steg

- misslyckande

- okomplicerad

- strömmar

- sådana

- stödja

- hållbart

- system

- System

- tackla

- tar

- tar

- uppgifter

- grupp

- lag

- Teknisk

- Tekniken

- Testning

- än

- den där

- Smakämnen

- deras

- Dem

- sedan

- Dessa

- saker

- tredje part

- detta

- tre

- tröskelvärde

- Genom

- hela

- genomströmning

- tim

- tid

- till

- tolerans

- ämne

- tps

- spår

- Spårning

- Utbildning

- Transaktioner

- försöker

- Vrida

- två

- Typ

- typer

- underliggande

- förstå

- Oväntat

- onödig

- upptid

- Användning

- användning

- användningsfall

- Användare

- Användarupplevelse

- med hjälp av

- godkännande

- olika

- utsikt

- synlighet

- syn

- volymer

- vs

- promenerade

- Sätt..

- sätt

- we

- webb

- webbservice

- när

- som

- medan

- varför

- kommer

- med

- utan

- Arbete

- arbetade

- arbetsflöde

- arbetsflöden

- arbetssätt

- fungerar

- år

- Om er

- Din

- zephyrnet