Med personligt innehåll som är mer sannolikt att driva kundernas engagemang, strävar företag kontinuerligt efter att tillhandahålla skräddarsytt innehåll baserat på deras kunds profil och beteende. Rekommendationssystem i synnerhet försöker förutsäga vilken preferens en slutanvändare skulle ge en vara. Några vanliga användningsfall inkluderar produktrekommendationer i onlinebutiker, anpassa nyhetsbrev, generera rekommendationer för musikspellistor eller till och med upptäcka liknande innehåll på onlinemedietjänster.

Det kan dock vara utmanande att skapa ett effektivt rekommendationssystem på grund av komplexiteten i modellträning, val av algoritmer och plattformshantering. Amazon Anpassa gör det möjligt för utvecklare att förbättra kundernas engagemang genom personliga produkt- och innehållsrekommendationer utan att behöva expertis inom maskininlärning (ML). Utvecklare kan börja engagera kunder direkt genom att använda infångad data om användarbeteende. Bakom kulisserna undersöker Amazon Personalize denna data, identifierar vad som är meningsfullt, väljer rätt algoritmer, tränar och optimerar en personaliseringsmodell som är anpassad för din data och ger rekommendationer via en API-slutpunkt.

Även om rekommendationer i realtid kan hjälpa till att öka engagemanget och tillfredsställelsen, kan det ibland inte krävas, och att utföra detta i grupp på en schemalagd basis kan helt enkelt vara ett mer kostnadseffektivt och hanterbart alternativ.

Det här inlägget visar hur du använder AWS-tjänster för att inte bara skapa rekommendationer utan också operationalisera en batch-rekommendationspipeline. Vi går igenom end-to-end-lösningen utan en enda kodrad. Vi diskuterar två ämnen i detalj:

Lösningsöversikt

I den här lösningen använder vi Filmlinser dataset. Denna datauppsättning innehåller 86,000 2,113 betyg av filmer från XNUMX XNUMX användare. Vi försöker använda denna data för att generera rekommendationer för var och en av dessa användare.

Dataförberedelse är mycket viktigt för att säkerställa att vi får kundbeteendedata i ett format som är redo för Amazon Personalize. Arkitekturen som beskrivs i det här inlägget använder AWS Glue, en serverlös dataintegrationstjänst, för att utföra omvandlingen av rådata till ett format som är redo för Amazon Personalize att konsumera. Lösningen använder Amazon Personalize för att skapa batch-rekommendationer för alla användare genom att använda en batch-slutledning. Vi använder sedan ett Step Functions-arbetsflöde så att det automatiserade arbetsflödet kan köras genom att anropa Amazon Personalize APIs på ett repeterbart sätt.

Följande diagram visar denna lösning.

Vi kommer att bygga denna lösning med följande steg:

- Bygg ett datatransformationsjobb för att transformera vår rådata med AWS Glue.

- Bygg en Amazon Personalize-lösning med den transformerade datamängden.

- Bygg ett arbetsflöde för stegfunktioner för att orkestrera genereringen av batch-slutledningar.

Förutsättningar

Du behöver följande för denna genomgång:

Bygg ett datatransformationsjobb för att transformera rådata med AWS Glue

Med Amazon Personalize måste indata ha ett specifikt schema och filformat. Data från interaktioner mellan användare och objekt måste vara i CSV-format med specifika kolumner, medan listan över användare som du vill generera rekommendationer för måste vara i JSON-format. I det här avsnittet använder vi AWS Glue Studio för att omvandla rå indata till de strukturer och format som krävs för Amazon Personalize.

AWS Glue Studio tillhandahåller ett grafiskt gränssnitt som är designat för att enkelt skapa och köra extrahera, transformera och ladda (ETL) jobb. Du kan visuellt skapa arbetsbelastningar för datatransformation genom enkla dra-och-släpp-operationer.

Vi förbereder först våra källdata i Amazon enkel lagringstjänst (Amazon S3), sedan transformerar vi data utan kod.

- På Amazon S3-konsolen skapar du en S3-hink med tre mappar: rå, transformerad och kurerad.

- ladda ner MovieLens dataset och ladda upp den okomprimerade filen med namnet user_ratingmovies-timestamp.dat till din hink under råmappen.

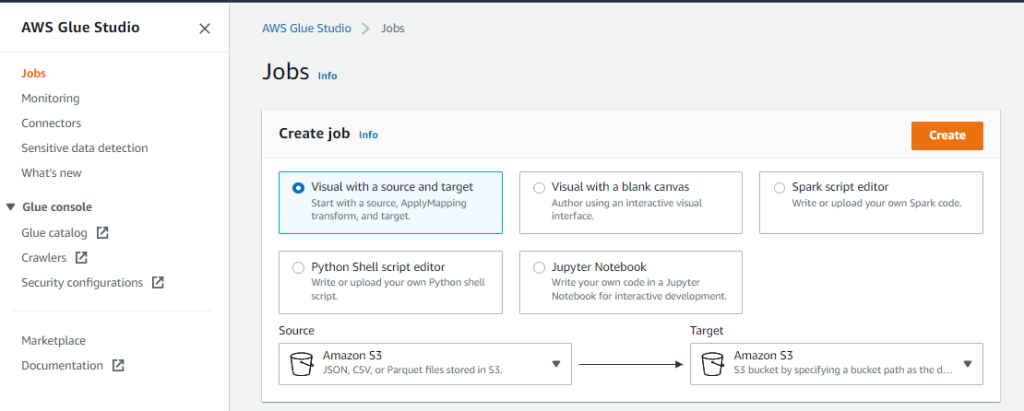

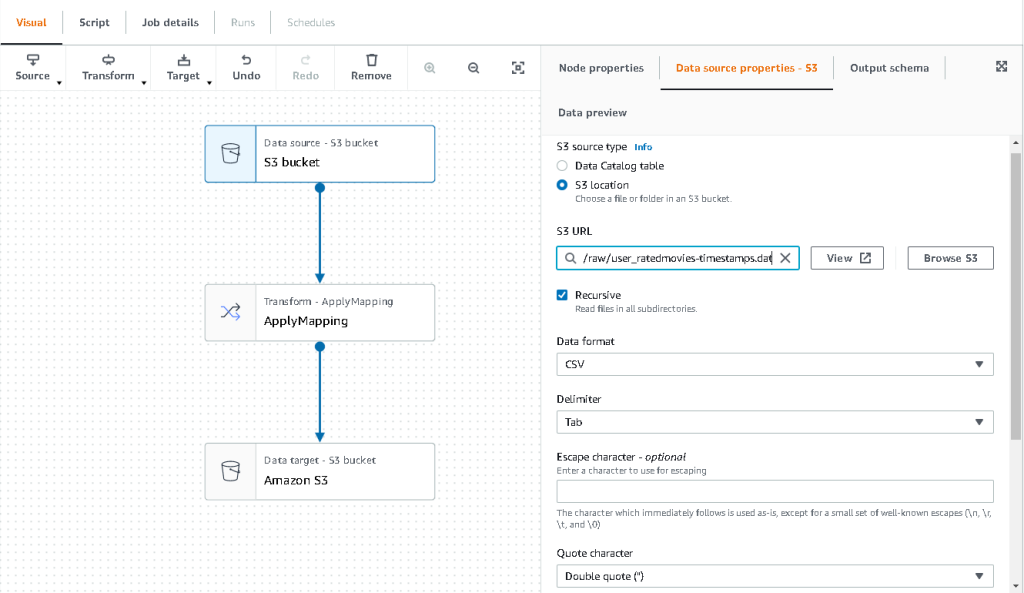

- Välj på AWS Glue Studio-konsolen Lediga jobb i navigeringsfönstret.

- Välja Visual med en källa och målOch välj sedan Skapa.

- Välj den första noden som anropas Datakälla – S3-hink. Det är här vi specificerar våra indata.

- På Datakällans egenskaper fliken, välj S3-plats och bläddra till din uppladdade fil.

- För Dataformatväljer CSVOch för avgränsareväljer Fliken.

- Vi kan välja fliken Utdataschema för att verifiera att schemat har slutit kolumnerna korrekt.

- Om schemat inte matchar dina förväntningar, välj Redigera för att redigera schemat.

Därefter transformerar vi dessa data för att följa schemakraven för Amazon Personalize.

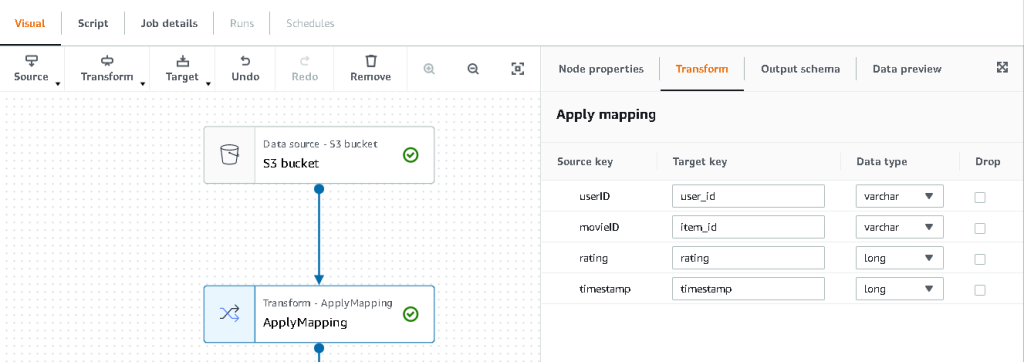

- Välj Transformera – Tillämpa mappning nod och på Förvandla uppdaterar du målnyckeln och datatyperna.

Amazon Personalize förväntar sig åtminstone följande struktur för interaktionsdataset:

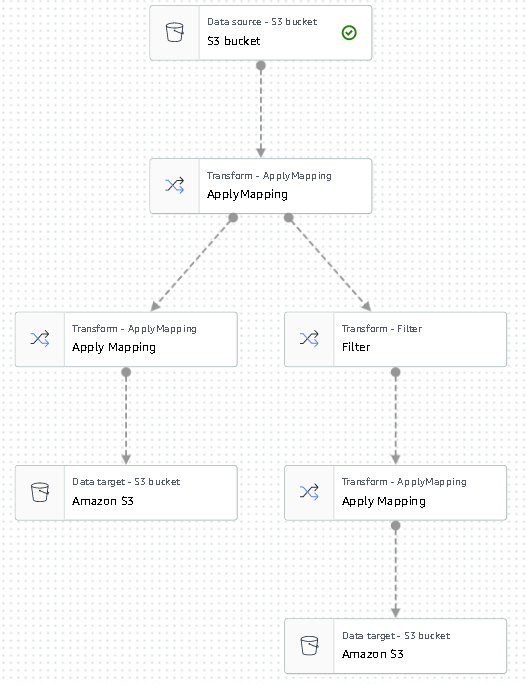

I det här exemplet utesluter vi de dåligt betygsatta filmerna i datasetet.

- För att göra det, ta bort den sista noden som heter S3-hinken och lägg till en filternod på Förvandla fliken.

- Välja Lägg till tillstånd och filtrera bort data där betyg < 3.5.

Vi skriver nu tillbaka utdata till Amazon S3.

- Expandera Målet menyn och välj Amazon S3.

- För S3 Målplats, välj mappen som heter

transformed. - Välja CSV som formatet och suffixet Målplats med

interactions/.

Därefter matar vi ut en lista över användare som vi vill få rekommendationer för.

- Välj ApplyMapping noden igen och expandera sedan Förvandla menyn och välj ApplyMapping.

- Släpp alla fält utom

user_idoch byt namn på det fältet tilluserId. Amazon Personalize förväntar sig att det fältet ska namnges användar ID. - Expandera Målet menyn igen och välj Amazon S3.

- Välj den här gången JSON som format, och välj sedan den transformerade S3-mappen och suffix den med

batch_users_input/.

Detta ger en JSON lista över användare som input för Amazon Personalize. Vi bör nu ha ett diagram som ser ut som följande.

Vi är nu redo att köra vårt transformationsjobb.

- På IAM-konsolen skapar du en roll som kallas glue-service-role och bifogar följande hanterade policyer:

AWSGlueServiceRoleAmazonS3FullAccess

För mer information om hur du skapar IAM-tjänstroller, se Skapa en roll för att delegera behörigheter till en AWS-tjänst.

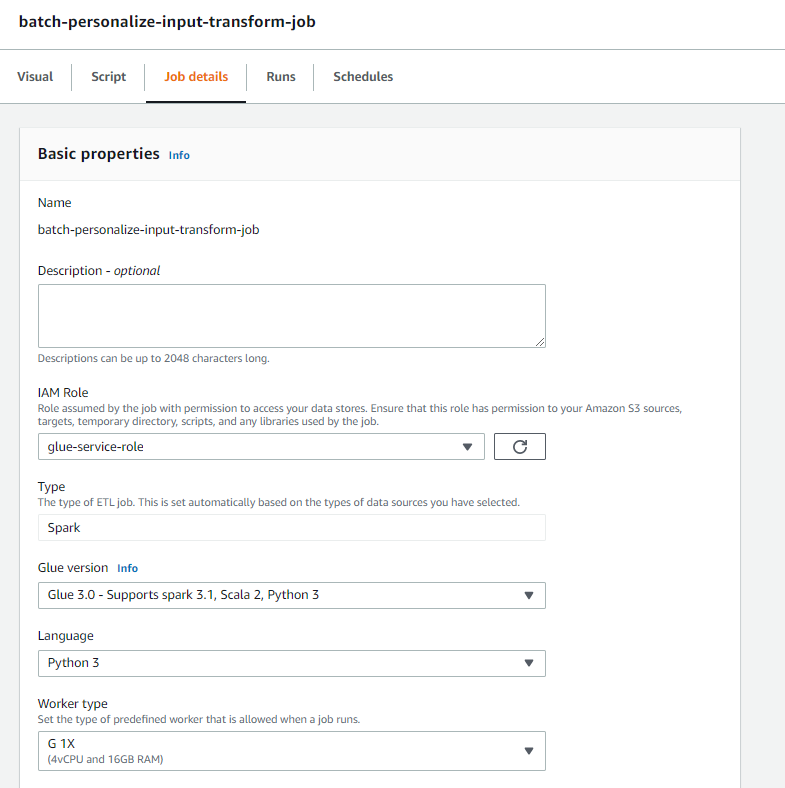

- Navigera tillbaka till ditt AWS Glue Studio-jobb och välj Jobb detaljer fliken.

- Ställ in jobbnamnet som

batch-personalize-input-transform-job. - Välj den nyskapade IAM-rollen.

- Behåll standardvärdena för allt annat.

- Välja Save.

- När du är redo, välj Körning och övervaka jobbet i Körs fliken.

- När jobbet är klart, navigera till Amazon S3-konsolen för att verifiera att din utdatafil har skapats.

Vi har nu format vår data till det format och den struktur som Amazon Personalize kräver. Den transformerade datamängden ska ha följande fält och format:

- Interaktionsdatasätt – CSV-format med fält

USER_ID,ITEM_ID,TIMESTAMP - Användardatauppsättning – JSON-format med element

userId

Bygg en Amazon Personalize-lösning med den transformerade datamängden

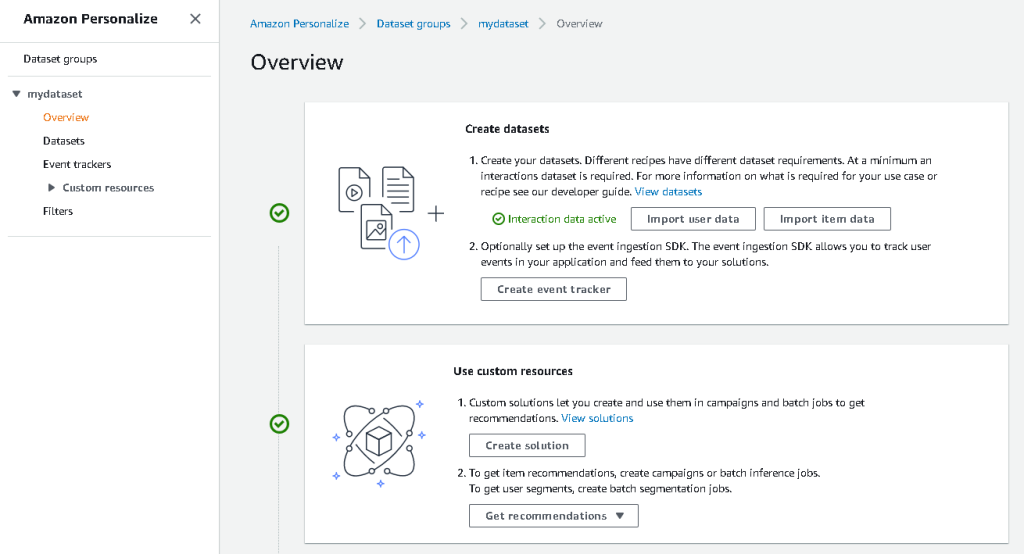

Med vår interaktionsdatauppsättning och användarindata i rätt format kan vi nu skapa vår Amazon Personalize-lösning. I det här avsnittet skapar vi vår datauppsättningsgrupp, importerar våra data och skapar sedan ett batch slutledningsjobb. En datasetgrupp organiserar resurser i behållare för Amazon Personalize-komponenter.

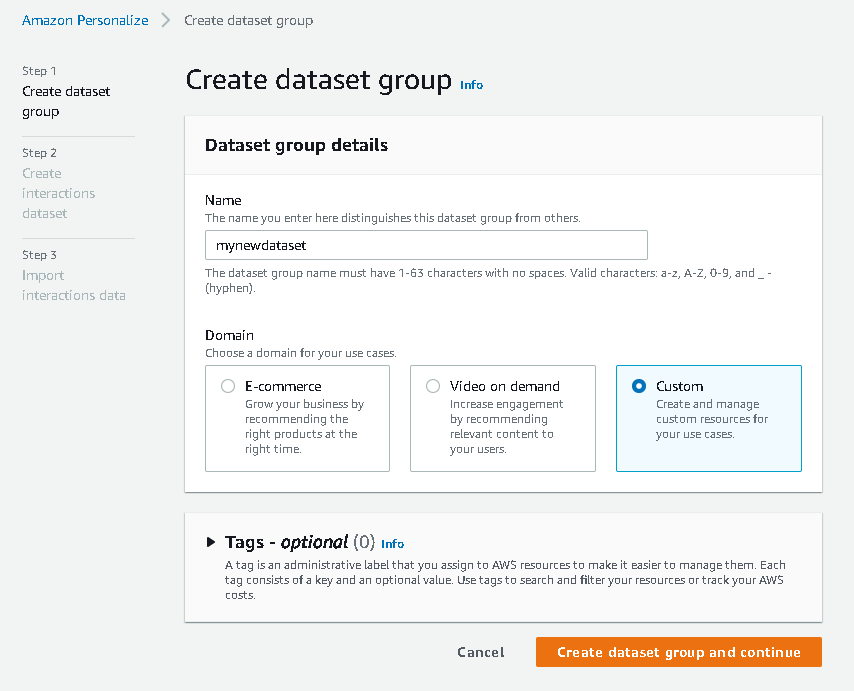

- Välj på Amazon Personalize-konsolen Skapa datagrupp.

- För Domän, Välj Custom.

- Välja Skapa datauppsättningsgrupp och fortsätt.

Skapa sedan interaktionsdataset.

Vi importerar nu interaktionsdata som vi hade skapat tidigare.

- Navigera till S3-bucket där vi skapade vår interaktions-CSV-datauppsättning.

- På behörigheter lägg till följande åtkomstpolicy för bucket så att Amazon Personalize har åtkomst. Uppdatera policyn för att inkludera ditt segmentnamn.

Navigera tillbaka till Amazon Personalize och välj Skapa ditt datauppsättningsimportjobb. Vår interaktionsdatauppsättning bör nu importeras till Amazon Personalize. Vänta tills importjobbet är klart med statusen Aktiv innan du fortsätter till nästa steg. Detta bör ta cirka 8 minuter.

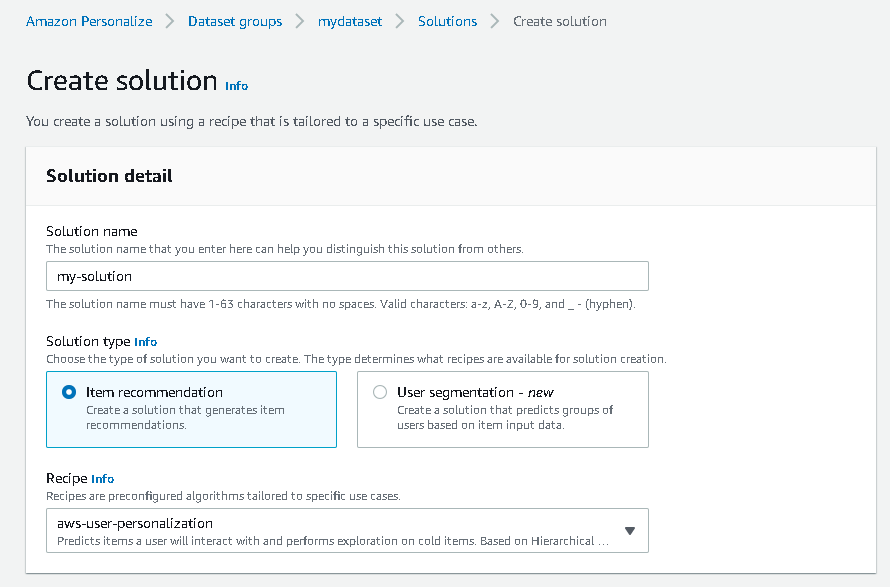

- Välj på Amazon Personalize-konsolen Översikt i navigeringsfönstret och välj Skapa lösning.

- Ange ett lösningsnamn.

- För Lösningstypväljer Artikelrekommendation.

- För Receptet, Välj den

aws-user-personalizationrecept. - Välja Skapa och träna lösning.

Lösningen tränar nu mot interaktionsdatasetet som importerades med receptet för användaranpassning. Övervaka statusen för denna process under Lösningsversioner. Vänta tills det är klart innan du fortsätter. Detta bör ta cirka 20 minuter.

Vi skapar nu vårt batch-inferensjobb, som genererar rekommendationer för var och en av användarna som finns i JSON-ingången.

- I navigeringsfönstret, under Anpassade resurserväljer Batch inferensjobb.

- Ange ett jobbnamn och för Lösning, välj den lösning som skapats tidigare.

- Välja Skapa partiinferensjobb.

- För Indatakonfiguration, ange S3-vägen där

batch_users_inputfilen finns.

Det här är JSON-filen som innehåller userId.

- För Konfiguration av utdata bana, välj den kurerade sökvägen i S3.

- Välja Skapa partiinferensjobb.

Denna process tar cirka 30 minuter. När jobbet är klart sparas rekommendationer för var och en av användarna som anges i användarinmatningsfilen på S3-utgångsplatsen.

Vi har framgångsrikt genererat en uppsättning rekommendationer för alla våra användare. Vi har dock bara implementerat lösningen med hjälp av konsolen än så länge. För att se till att denna batch-inferencing körs regelbundet med den senaste uppsättningen data, måste vi bygga ett orkestreringsarbetsflöde. I nästa avsnitt visar vi dig hur du skapar ett orkestreringsarbetsflöde med hjälp av Step Functions.

Bygg ett arbetsflöde för stegfunktioner för att orkestrera arbetsflödet för batch slutledning

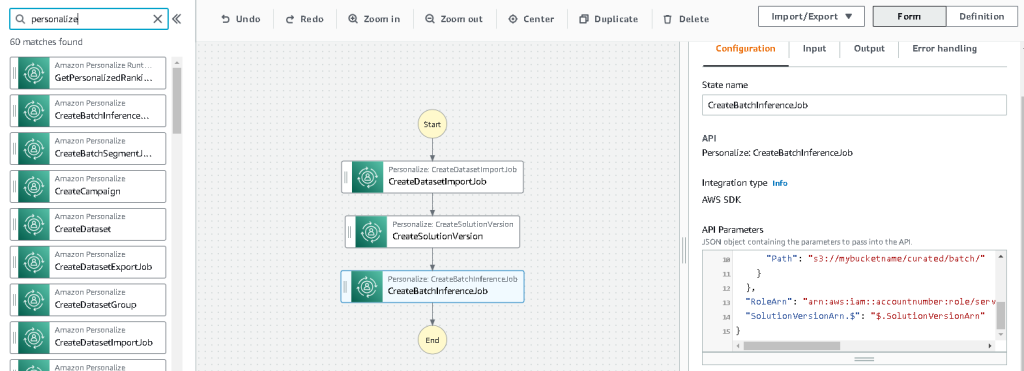

Utför följande steg för att orkestrera din pipeline:

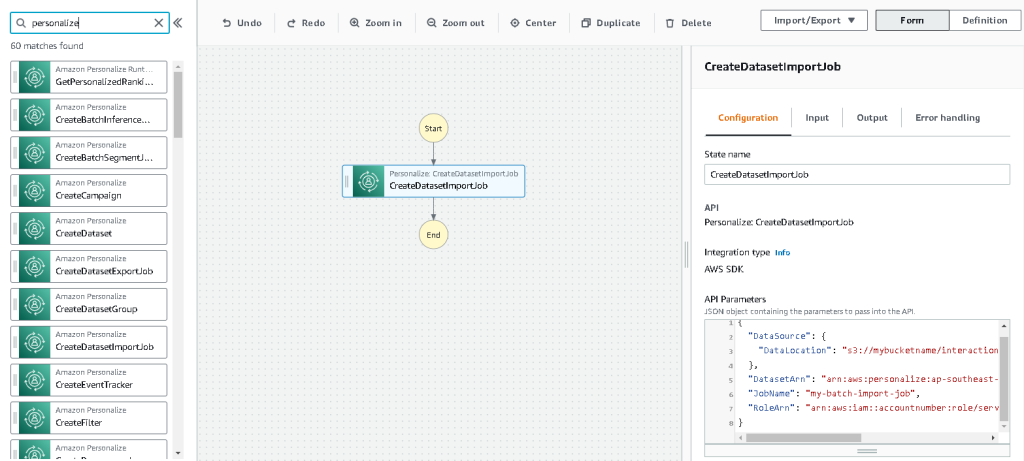

- Välj på Step Functions-konsolen Skapa State Machine.

- Välja Designa ditt arbetsflöde visuelltOch välj sedan Nästa.

- Dra

CreateDatasetImportJobnod från vänster (du kan söka efter denna nod i sökrutan) till duken. - Välj noden och du bör se konfigurations-API-parametrarna till höger. Spela in ARN.

- Ange dina egna värden i API-parametrar textruta.

Detta kallar CreateDatasetImportJob API med de parametervärden som du anger.

- Dra

CreateSolutionVersionnod på duken. - Uppdatera API-parametrarna med ARN för lösningen som du noterade.

Detta skapar en ny lösningsversion med nyimporterade data genom att anropa CreateSolutionVersion API.

- Dra

CreateBatchInferenceJobnod på arbetsytan och uppdatera på liknande sätt API-parametrarna med relevanta värden.

Se till att du använder $.SolutionVersionArn syntax för att hämta ARN-parametern för lösningsversionen från föregående steg. Dessa API-parametrar skickas till CreateBatchInferenceJob API.

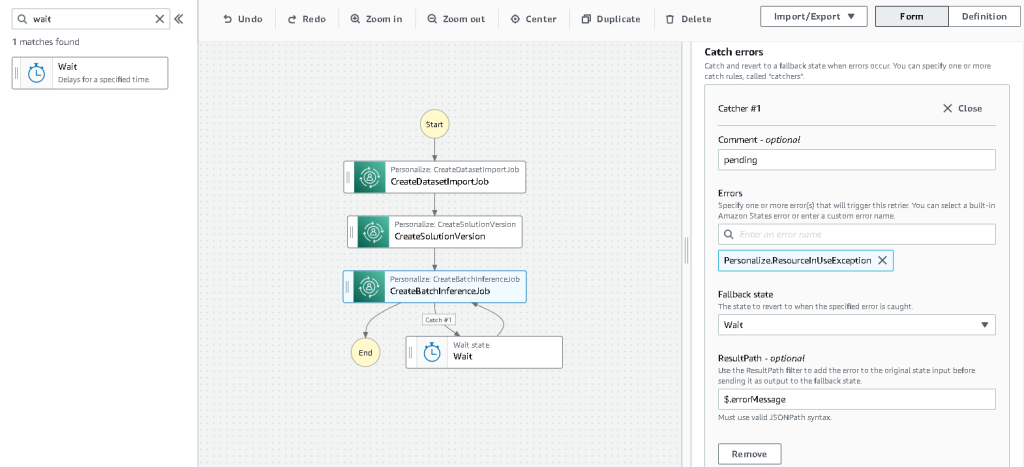

Vi måste bygga en väntelogik i arbetsflödet Step Functions för att se till att rekommendationssatsen slutledningsjobbet avslutas innan arbetsflödet slutförs.

- Hitta och dra i en väntanod.

- I konfigurationen för Vänta, ange 300 sekunder.

Detta är ett godtyckligt värde; du bör ändra denna väntetid enligt ditt specifika användningsfall.

- Välj

CreateBatchInferenceJobnoden igen och navigera till Felhantering fliken. - För brottning fel, stiga på

Personalize.ResourceInUseException. - För Reservtillståndväljer Vänta.

Detta steg gör det möjligt för oss att regelbundet kontrollera statusen för jobbet och det lämnar slingan först när jobbet är klart.

- För Resultatväg, stiga på

$.errorMessage.

Detta innebär i praktiken att när undantaget "resurs i bruk" tas emot, väntar jobbet i x sekunder innan det försöker igen med samma ingångar.

- Välja Save, och välj sedan Starta utförandet.

Vi har framgångsrikt orkestrerat vår batchrekommendationspipeline för Amazon Personalize. Som ett valfritt steg kan du använda Amazon EventBridge att schemalägga en utlösare av detta arbetsflöde regelbundet. För mer information, se EventBridge (CloudWatch Events) för stegfunktioners exekveringsstatusändringar.

Städa upp

För att undvika framtida avgifter, radera resurserna som du skapade för den här genomgången.

Slutsats

I det här inlägget visade vi hur man skapar en batchrekommendationspipeline genom att använda en kombination av AWS Glue, Amazon Personalize och Step Functions, utan att behöva en enda rad kod eller ML-erfarenhet. Vi använde AWS Glue för att förbereda vår data till det format som Amazon Personalize kräver. Sedan använde vi Amazon Personalize för att importera data, skapa en lösning med ett användaranpassningsrecept och skapa ett batch slutledningsjobb som genererar en standard på 25 rekommendationer för varje användare, baserat på tidigare interaktioner. Vi orkestrerade sedan dessa steg med hjälp av Step Functions så att vi kan köra dessa jobb automatiskt.

För steg att överväga härnäst är användarsegmentering ett av de nyare recepten i Amazon Personalize, som du kanske vill utforska för att skapa användarsegment för varje rad med indata. För mer information, se Få batchrekommendationer och användarsegment.

Om författaren

Maxine Wee är en AWS Data Lab Solutions Architect. Maxine arbetar med kunder i deras användningsfall, designar lösningar för att lösa deras affärsproblem och guidar dem genom att bygga skalbara prototyper. Inför sin resa med AWS hjälpte Maxine kunder att implementera BI-, datalagrings- och datasjöprojekt i Australien.

- Avancerat (300)

- AI

- ai konst

- ai art generator

- har robot

- Amazon Anpassa

- artificiell intelligens

- artificiell intelligenscertifiering

- artificiell intelligens inom bankväsendet

- artificiell intelligens robot

- robotar med artificiell intelligens

- programvara för artificiell intelligens

- AWS-lim

- AWS maskininlärning

- blockchain

- blockchain konferens ai

- coingenius

- konversationskonstnärlig intelligens

- kryptokonferens ai

- dalls

- djupt lärande

- du har google

- maskininlärning

- plato

- plato ai

- Platon Data Intelligence

- Platon spel

- PlatonData

- platogaming

- skala ai

- syntax

- Teknisk instruktion

- zephyrnet