Företag försöker utnyttja potentialen hos Machine Learning (ML) för att lösa komplexa problem och förbättra resultat. Tills nyligen krävde att bygga och distribuera ML-modeller djupa nivåer av tekniska och kodningsfärdigheter, inklusive justering av ML-modeller och underhåll av operativa pipelines. Sedan introduktionen 2021, Amazon SageMaker Canvas har gjort det möjligt för affärsanalytiker att bygga, distribuera och använda en mängd olika ML-modeller – inklusive tabeller, datorseende och bearbetning av naturligt språk – utan att skriva en rad kod. Detta har påskyndat företagens förmåga att tillämpa ML för att använda fall som tidsserieprognoser, förutsägelse av kundförlust, sentimentanalys, upptäckt av industrifel och många andra.

Som meddelades den Oktober 5, 2023, utökade SageMaker Canvas sitt stöd för modeller till grundmodeller (FM) – stora språkmodeller som används för att generera och sammanfatta innehåll. Med Release den 12 oktober 2023SageMaker Canvas låter användare ställa frågor och få svar som är grundade i deras företagsdata. Detta säkerställer att resultaten är kontextspecifika, vilket öppnar upp för ytterligare användningsfall där no-code ML kan tillämpas för att lösa affärsproblem. Till exempel kan företagsteam nu formulera svar som överensstämmer med en organisations specifika ordförråd och principer, och kan snabbare söka efter långa dokument för att få svar som är specifika och grundade på innehållet i dessa dokument. Allt detta innehåll utförs på ett privat och säkert sätt, vilket säkerställer att all känslig data nås med korrekt styrning och skydd.

För att komma igång konfigurerar och fyller en molnadministratör Amazon Kendra indexerar med företagsdata som datakällor för SageMaker Canvas. Canvas-användare väljer indexet där deras dokument finns och kan skapa idéer, undersöka och utforska med vetskapen om att resultatet alltid kommer att backas upp av deras sanningskällor. SageMaker Canvas använder toppmoderna FM-apparater från Amazonas berggrund och Amazon SageMaker JumpStart. Konversationer kan startas med flera FM sida vid sida, jämföra utdata och verkligen göra generativ AI tillgänglig för alla.

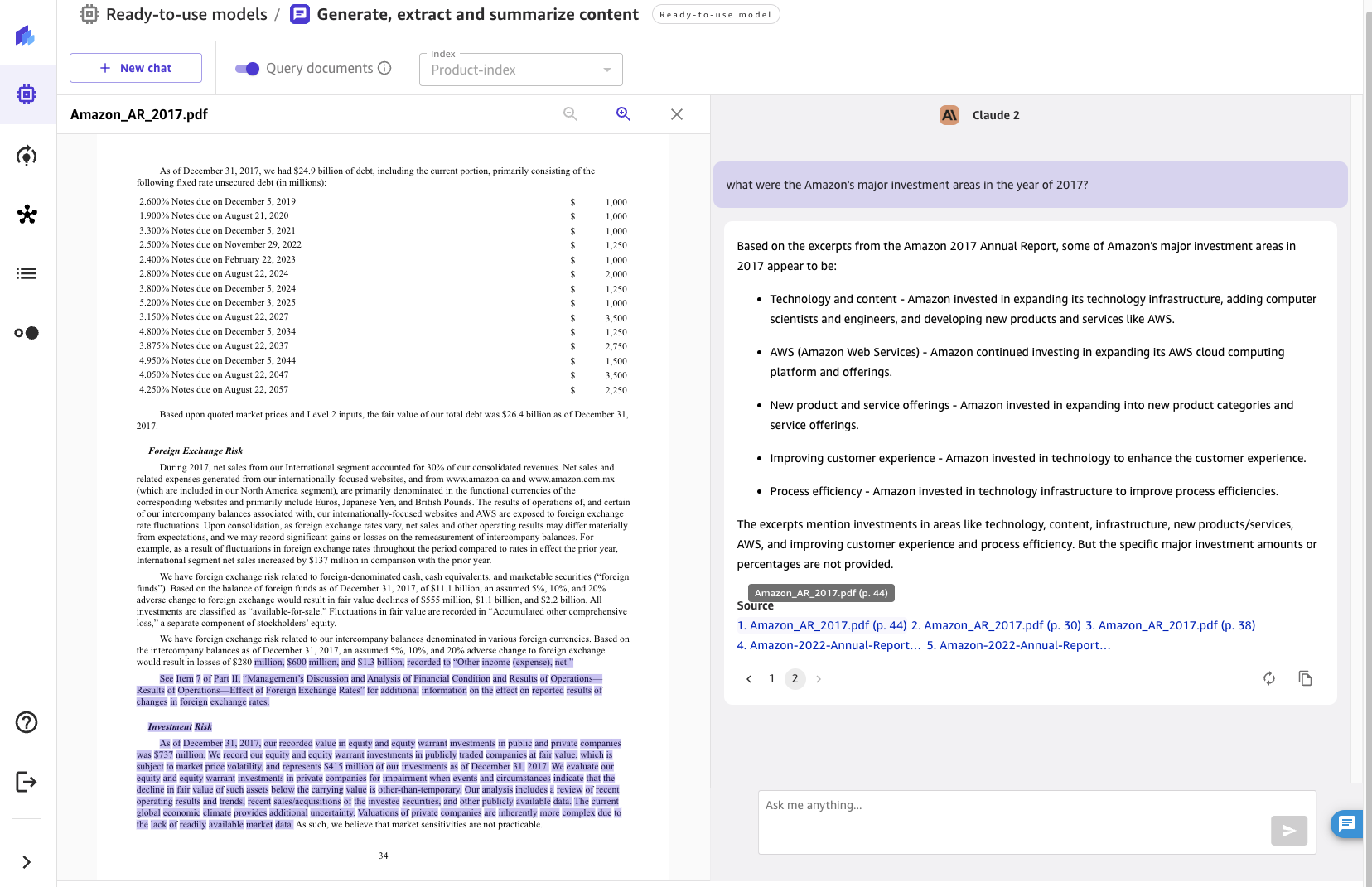

I det här inlägget kommer vi att granska den nyligen släppta funktionen, diskutera arkitekturen och presentera en steg-för-steg-guide för att göra det möjligt för SageMaker Canvas att fråga efter dokument från din kunskapsbas, som visas i följande skärmdump.

Lösningsöversikt

Grundmodeller kan framkalla hallucinationer – svar som är generiska, vaga, orelaterade eller faktiskt felaktiga. Retrieval Augmented Generation (RAG) är ett ofta använt tillvägagångssätt för att minska hallucinationer. RAG-arkitekturer används för att hämta data utanför en FM, som sedan används för att utföra inlärning i sammanhanget för att svara på användarens fråga. Detta säkerställer att FM kan använda data från en pålitlig kunskapsbas och använda den kunskapen för att svara på användarnas frågor, vilket minskar risken för hallucinationer.

Med RAG kan data utanför FM och som används för att utöka användarmeddelanden komma från flera olika datakällor, såsom dokumentarkiv, databaser eller API:er. Det första steget är att konvertera dina dokument och eventuella användarfrågor till ett kompatibelt format för att utföra semantisk relevanssökning. För att göra formaten kompatibla konverteras en dokumentsamling eller kunskapsbibliotek och användarinlämnade frågor till numeriska representationer med hjälp av inbäddningsmodeller.

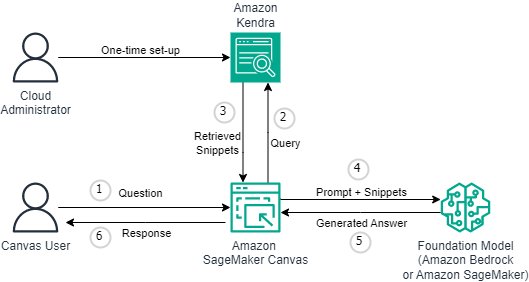

Med denna utgåva tillhandahålls RAG-funktionalitet på ett kodfritt och sömlöst sätt. Företag kan berika chattupplevelsen i Canvas med Amazon Kendra som det underliggande kunskapshanteringssystemet. Följande diagram illustrerar lösningsarkitekturen.

Att ansluta SageMaker Canvas till Amazon Kendra kräver en engångsinstallation. Vi beskriver installationsprocessen i detalj i Konfigurera Canvas för att söka efter dokument. Om du inte redan har konfigurerat din SageMaker-domän, se Ombord på Amazon SageMaker Domain.

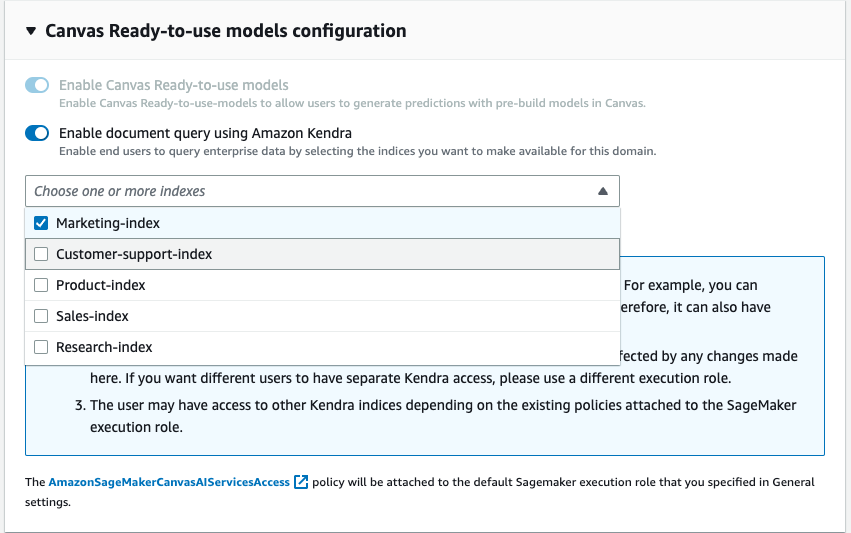

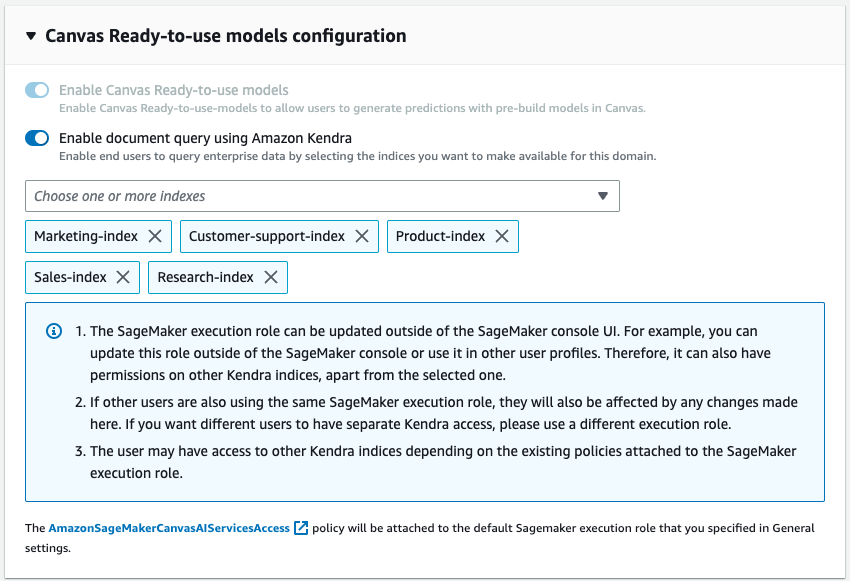

Som en del av domänkonfigurationen kan en molnadministratör välja ett eller flera Kendra-index som affärsanalytikern kan fråga när han interagerar med FM via SageMaker Canvas.

Efter att Kendra-indexen är hydratiserade och konfigurerade använder affärsanalytiker dem med SageMaker Canvas genom att starta en ny chatt och välja "Fråga dokument". SageMaker Canvas kommer sedan att hantera den underliggande kommunikationen mellan Amazon Kendra och valfri FM för att utföra följande operationer:

- Fråga Kendra-indexen med frågan som kommer från användaren.

- Hämta utdragen (och källorna) från Kendra-index.

- Konstruera uppmaningen med utdragen med den ursprungliga frågan så att grundmodellen kan generera ett svar från de hämtade dokumenten.

- Ge det genererade svaret till användaren, tillsammans med referenser till de sidor/dokument som användes för att formulera svaret.

Konfigurera Canvas för att söka efter dokument

I det här avsnittet går vi igenom stegen för att ställa in Canvas för att söka efter dokument som serveras genom Kendra-index. Du bör ha följande förutsättningar:

- SageMaker-domäninställning – Ombord på Amazon SageMaker Domain

- Skapa en Kendra index (eller mer än en)

- Ställ in Kendra Amazon S3-kontakten – följ anvisningarna Amazon S3-kontakt – och ladda upp PDF-filer och andra dokument till Amazon S3-hinken som är kopplad till Kendra-indexet

- Ställ in IAM så att Canvas har lämpliga behörigheter, inklusive de som krävs för att anropa Amazon Bedrock och/eller SageMaker-slutpunkter – följ Ställ in Canvas Chat dokumentation

Nu kan du uppdatera domänen så att den kan komma åt önskade index. På SageMaker-konsolen, för den givna domänen, välj Redigera under fliken Domäninställningar. Aktivera växeln "Aktivera frågedokument med Amazon Kendra" som finns i steget Canvas Settings. När det är aktiverat väljer du ett eller flera Kendra-index som du vill använda med Canvas.

Det är allt som behövs för att konfigurera Canvas frågedokumentfunktion. Användare kan nu hoppa in i en chatt inom Canvas och börja använda kunskapsbaserna som har kopplats till domänen genom Kendra-indexen. Upprätthållarna av kunskapsbasen kan fortsätta att uppdatera sanningens källa och med synkroniseringsförmågan i Kendra kommer chattanvändarna automatiskt att kunna använda den uppdaterade informationen på ett sömlöst sätt.

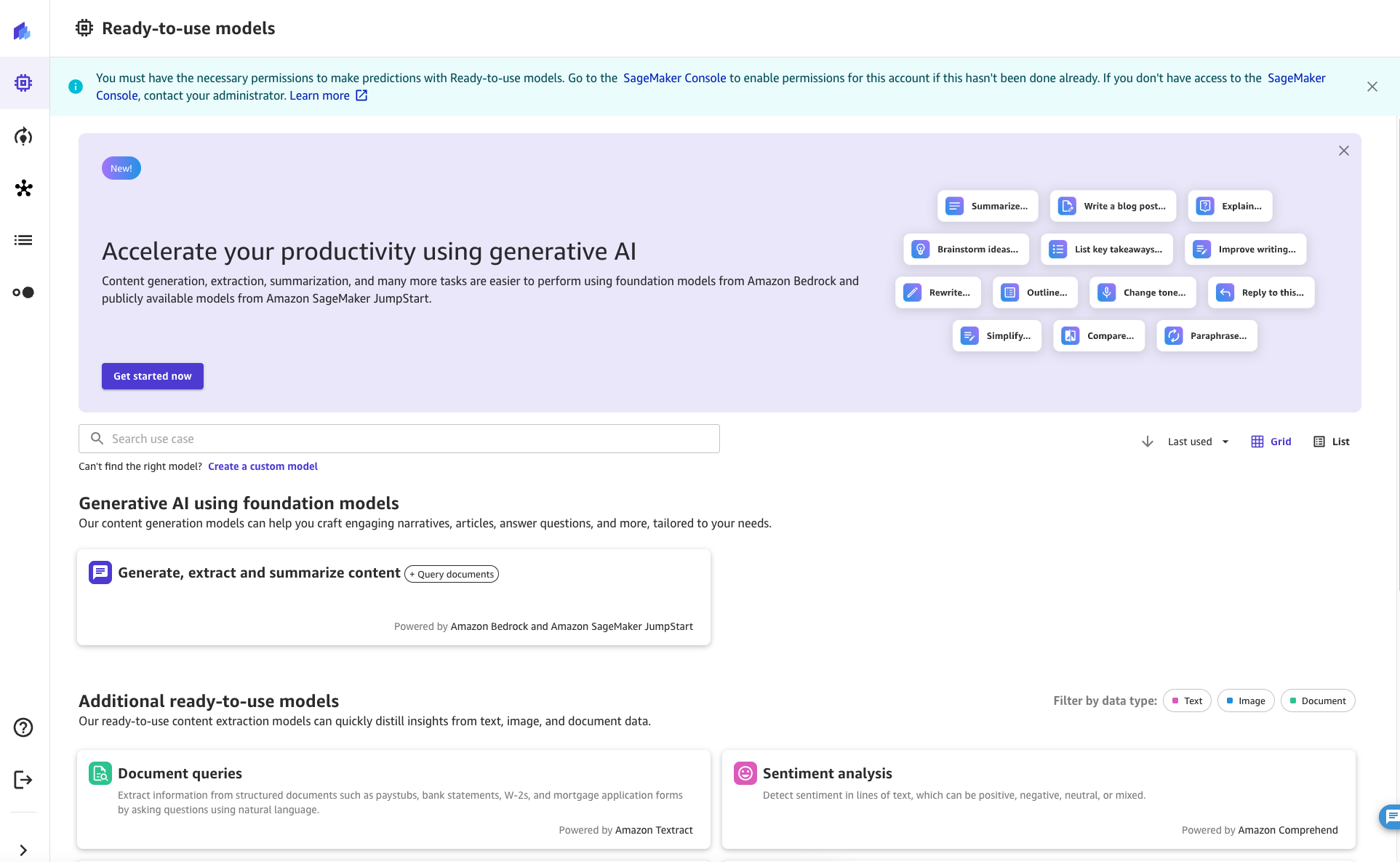

Använda funktionen Fråga dokument för chatt

Som SageMaker Canvas-användare kan funktionen Query Documents nås från en chatt. För att starta chattsessionen, klicka eller sök efter knappen "Generera, extrahera och sammanfatta innehåll" från fliken Klara att använda modeller i SageMaker Canvas.

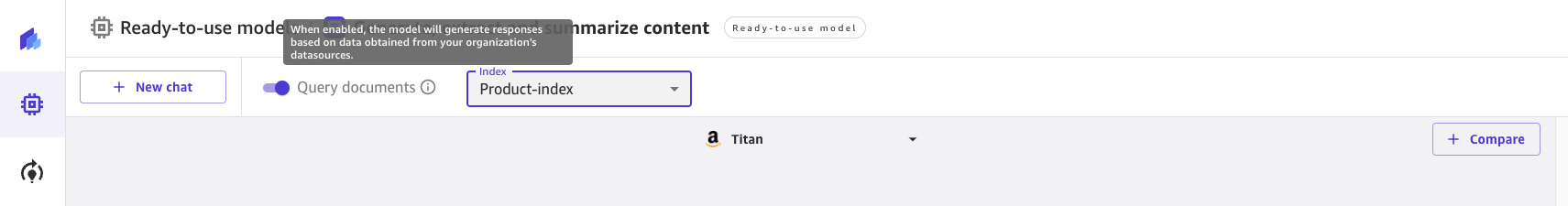

Väl där kan du slå på och stänga av frågedokument med reglaget längst upp på skärmen. Kolla in informationsuppmaningen för att lära dig mer om funktionen.

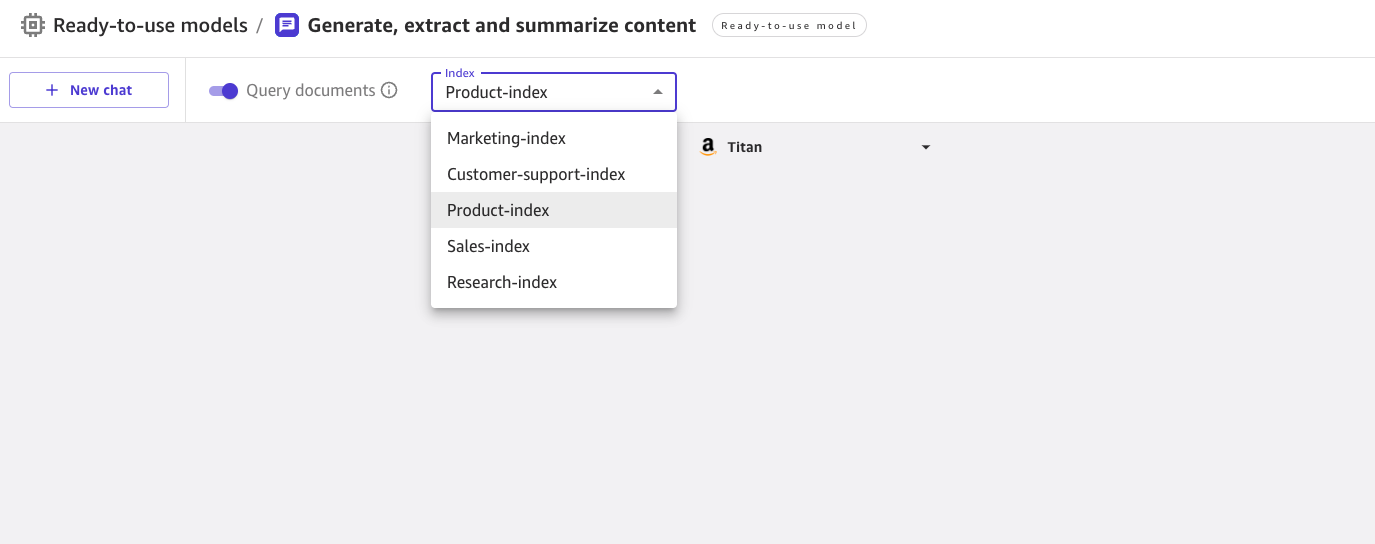

När Query Documents är aktiverat kan du välja bland en lista med Kendra-index som har aktiverats av molnadministratören.

Du kan välja ett index när du startar en ny chatt. Du kan sedan ställa en fråga i UX med kunskap som automatiskt hämtas från det valda indexet. Observera att efter att en konversation har startat mot ett specifikt index, är det inte möjligt att byta till ett annat index.

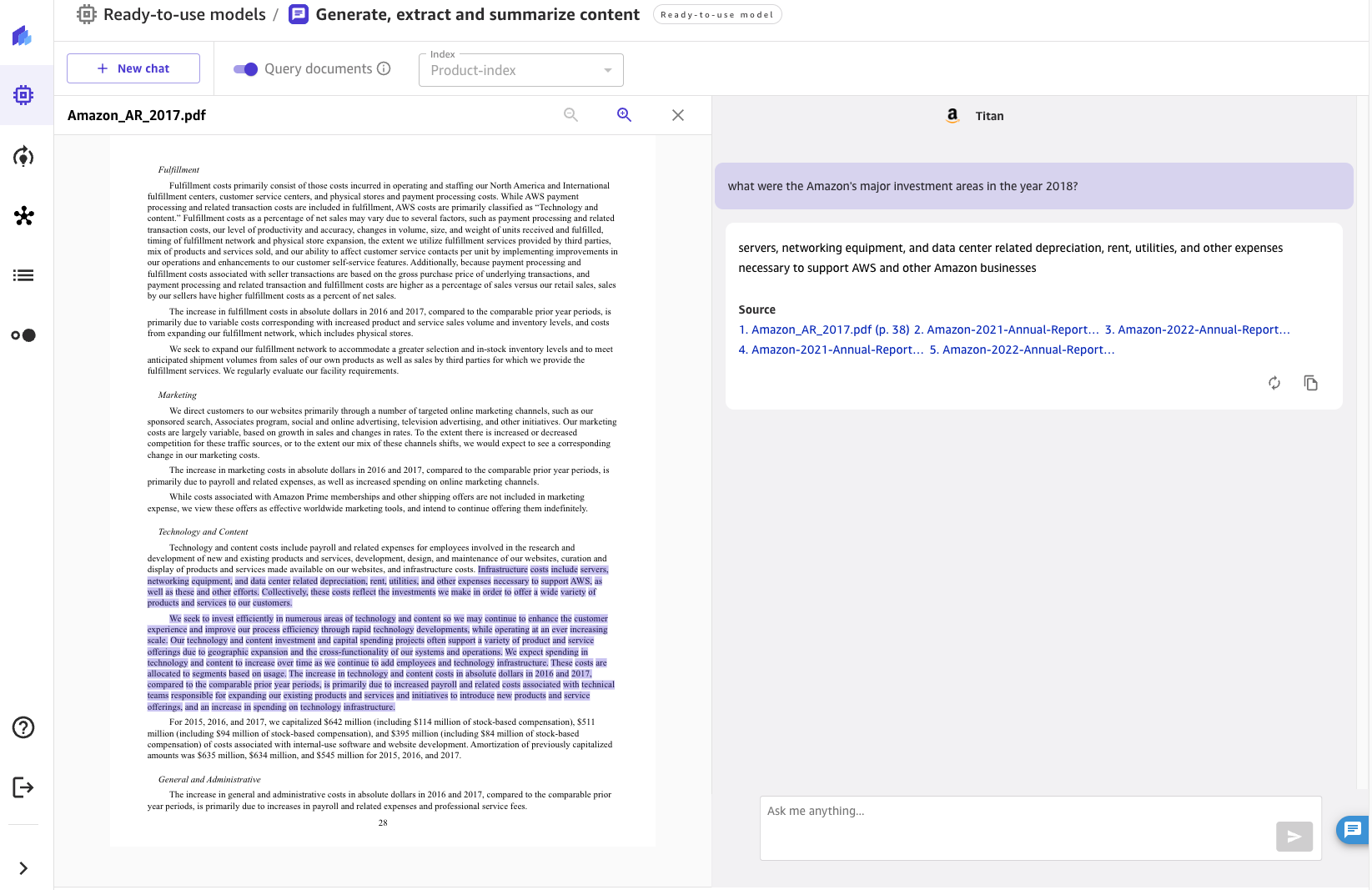

För de frågor som ställs kommer chatten att visa svaret som genererats av FM tillsammans med källdokumenten som bidrog till att generera svaret. När du klickar på något av källdokumenten öppnar Canvas en förhandsgranskning av dokumentet och markerar det utdrag som används av FM.

Slutsats

Conversational AI har en enorm potential att förvandla kunders och anställdas upplevelse genom att förse en människoliknande assistent med naturliga och intuitiva interaktioner som:

- Utför forskning om ett ämne eller sök och bläddra i organisationens kunskapsbas

- Sammanfatta mängder innehåll för att snabbt samla in insikter

- Söka efter enheter, sentiment, PII och andra användbara data och öka affärsvärdet av ostrukturerat innehåll

- Skapa utkast för dokument och affärskorrespondens

- Skapa kunskapsartiklar från olika interna källor (incidenter, chattloggar, wikis)

Den innovativa integrationen av chattgränssnitt, kunskapsinhämtning och FM:er gör det möjligt för företag att ge korrekta, relevanta svar på användarfrågor genom att använda sin domänkunskap och sanningskällor.

Genom att koppla SageMaker Canvas till kunskapsbaser i Amazon Kendra kan organisationer behålla sin egenutvecklade data i sin egen miljö samtidigt som de drar nytta av de senaste FM-funktionerna för naturligt språk. Med lanseringen av SageMaker Canvas Query Documents-funktion gör vi det enkelt för alla företag att använda LLM:er och deras företagskunskap som en källa till sanning för att skapa en säker chattupplevelse. All denna funktionalitet är tillgänglig i ett no-code format, vilket gör att företag kan undvika att hantera repetitiva och icke-specialiserade uppgifter.

För att lära dig mer om SageMaker Canvas och hur det hjälper till att göra det enklare för alla att börja med Machine Learning, kolla in SageMaker Canvas tillkännagivande. Läs mer om hur SageMaker Canvas hjälper till att främja samarbete mellan datavetare och affärsanalytiker genom att läsa Bygg, dela och distribuera inlägg. Slutligen, för att lära dig hur du skapar ditt eget Retrieval Augmented Generation-arbetsflöde, se SageMaker JumpStart RAG.

Referensprojekt

Lewis, P., Perez, E., Piktus, A., Petroni, F., Karpukhin, V., Goyal, N., Küttler, H., Lewis, M., Yih, W., Rocktäschel, T., Riedel, S., Kiela, D. (2020). Retrieval-Augmented Generation för kunskapsintensiva NLP-uppgifter. Framsteg inom neurologiska informationsbehandlingssystem, 33, 9459-9474.

Om författarna

Davide Gallitelli är Senior Specialist Solutions Architect för AI/ML. Han är baserad i Bryssel och har ett nära samarbete med kunder över hela världen som vill ta till sig Low-Code/No-Code Machine Learning-teknologier och Generativ AI. Han har varit utvecklare sedan han var väldigt ung, började koda vid 7 års ålder. Han började lära sig AI/ML på universitetet och har blivit kär i det sedan dess.

Davide Gallitelli är Senior Specialist Solutions Architect för AI/ML. Han är baserad i Bryssel och har ett nära samarbete med kunder över hela världen som vill ta till sig Low-Code/No-Code Machine Learning-teknologier och Generativ AI. Han har varit utvecklare sedan han var väldigt ung, började koda vid 7 års ålder. Han började lära sig AI/ML på universitetet och har blivit kär i det sedan dess.

Bilal Alam är Enterprise Solutions Architect på AWS med fokus på Financial Services-branschen. De flesta dagar hjälper Bilal kunder med att bygga, lyfta och säkra deras AWS-miljö för att distribuera deras mest kritiska arbetsbelastningar. Han har lång erfarenhet av Telco, nätverk och mjukvaruutveckling. På senare tid har han tittat på att använda AI/ML för att lösa affärsproblem.

Bilal Alam är Enterprise Solutions Architect på AWS med fokus på Financial Services-branschen. De flesta dagar hjälper Bilal kunder med att bygga, lyfta och säkra deras AWS-miljö för att distribuera deras mest kritiska arbetsbelastningar. Han har lång erfarenhet av Telco, nätverk och mjukvaruutveckling. På senare tid har han tittat på att använda AI/ML för att lösa affärsproblem.

Pashmeen Mistry är Senior Product Manager på AWS. Utanför jobbet gillar Pashmeen äventyrliga vandringar, fotografering och att umgås med sin familj.

Pashmeen Mistry är Senior Product Manager på AWS. Utanför jobbet gillar Pashmeen äventyrliga vandringar, fotografering och att umgås med sin familj.

Dan Sinnreich är senior produktchef på AWS, som hjälper till att demokratisera maskininlärning med låg kod/ingen kod. Före AWS byggde och kommersialiserade Dan Enterprise SaaS-plattformar och tidsseriemodeller som används av institutionella investerare för att hantera risker och konstruera optimala portföljer. Utanför jobbet kan han hittas som spelar hockey, dykning och läser science fiction.

Dan Sinnreich är senior produktchef på AWS, som hjälper till att demokratisera maskininlärning med låg kod/ingen kod. Före AWS byggde och kommersialiserade Dan Enterprise SaaS-plattformar och tidsseriemodeller som används av institutionella investerare för att hantera risker och konstruera optimala portföljer. Utanför jobbet kan han hittas som spelar hockey, dykning och läser science fiction.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://aws.amazon.com/blogs/machine-learning/empower-your-business-users-to-extract-insights-from-company-documents-using-amazon-sagemaker-canvas-generative-ai/

- : har

- :är

- :inte

- :var

- ][s

- $UPP

- 100

- 12

- 2020

- 2021

- 2023

- 225

- 7

- a

- förmåga

- Able

- Om oss

- accelererad

- tillgång

- Accessed

- tillgänglig

- exakt

- Annat

- anta

- Efter

- mot

- ålder

- AI

- AI / ML

- Alla

- tillåta

- längs

- redan

- alltid

- amason

- Amazon Kendra

- Amazon SageMaker

- Amazon SageMaker Canvas

- Amazon Web Services

- bland

- an

- analys

- analytiker

- analytiker

- och

- meddelade

- Annan

- svara

- vilken som helst

- API: er

- tillämpas

- Ansök

- tillvägagångssätt

- lämpligt

- arkitektur

- ÄR

- runt

- artiklar

- AS

- be

- Assistent

- associerad

- At

- förstärka

- augmented

- automatiskt

- tillgänglig

- undvika

- AWS

- dragen tillbaka

- bas

- baserat

- BE

- varit

- Där vi får lov att vara utan att konstant prestera,

- gynnar

- mellan

- bryssel

- SLUTRESULTAT

- Byggnad

- byggt

- företag

- företag

- Knappen

- by

- anropande

- KAN

- canvas

- kapacitet

- kapacitet

- fånga

- fall

- ta

- val

- Välja

- klick

- nära

- cloud

- koda

- Kodning

- samverkan

- samling

- komma

- kommande

- Kommunikation

- företag

- jämförande

- kompatibel

- komplex

- dator

- Datorsyn

- konfiguration

- konfigurerad

- Anslutning

- konsekvent

- Konsol

- konstruera

- innehåll

- innehåll

- fortsätta

- bidrog

- Konversation

- konversationer

- konvertera

- konverterad

- skapa

- kritisk

- kund

- Kunder

- datum

- databaser

- Dagar

- djup

- DEMOKRATISERA

- distribuera

- utplacera

- beskriva

- önskas

- detalj

- Detektering

- Utvecklare

- Utveckling

- diskutera

- disparat

- dykning

- dokumentera

- dokument

- domän

- e

- lättare

- lätt

- inbäddning

- Anställd

- ge

- möjliggöra

- aktiverad

- möjliggör

- berika

- säkerställer

- säkerställa

- Företag

- företag

- enheter

- Miljö

- alla

- exempel

- expanderade

- erfarenhet

- utforska

- omfattande

- Omfattande erfarenhet

- extern

- extrahera

- Fallen

- familj

- Leverans

- Fiktion

- Filer

- Slutligen

- finansiella

- finansiella tjänster

- Förnamn

- Fokus

- följer

- efter

- För

- format

- Foster

- hittade

- fundament

- ofta

- från

- funktionalitet

- samla

- generera

- genereras

- generera

- generering

- generativ

- Generativ AI

- skaffa sig

- ges

- globen

- styrning

- styra

- Arbetsmiljö

- sele

- Har

- he

- hjälpa

- hjälper

- belysa

- vandringar

- hans

- Hur ser din drömresa ut

- How To

- html

- http

- HTTPS

- if

- illustrerar

- enorma

- förbättra

- in

- Inklusive

- ökande

- index

- index

- index

- industriell

- industrin

- informationen

- innovativa

- insikter

- Institutionell

- institutionella investerare

- integrering

- interagera

- interaktioner

- gränssnitt

- inre

- in

- Beskrivning

- intuitiv

- För Investerare

- IT

- DESS

- jpg

- hoppa

- Ha kvar

- Menande

- kunskap

- Kunskapshantering

- språk

- Large

- lansera

- LÄRA SIG

- inlärning

- Lets

- nivåer

- Lewis

- Bibliotek

- linje

- Lista

- du letar

- älskar

- Maskinen

- maskininlärning

- upprätthålla

- göra

- Framställning

- hantera

- ledning

- chef

- sätt

- många

- ML

- modell

- modeller

- mer

- mest

- multipel

- Natural

- Naturlig språkbehandling

- behövs

- nätverk

- neurala

- Nya

- nlp

- nu

- of

- sänkt

- on

- gång

- ONE

- öppning

- öppnas

- operativa

- Verksamhet

- optimala

- or

- organisationer

- ursprungliga

- Övriga

- Övrigt

- ut

- utfall

- produktion

- utgångar

- utanför

- egen

- del

- Utföra

- utfört

- behörigheter

- fotografi

- Bild

- Plattformar

- plato

- Platon Data Intelligence

- PlatonData

- i

- portföljer

- möjlig

- Inlägg

- potentiell

- kraft

- förutsägelse

- förutsättningar

- presentera

- Förhandsvisning

- föregående

- privat

- problem

- process

- bearbetning

- producera

- Produkt

- produktchef

- rätt

- proprietary

- ge

- förutsatt

- tillhandahålla

- sökfrågor

- fråga

- frågor

- snabbt

- snabbt

- Läsning

- nyligen

- minska

- reducerande

- hänvisa

- referenser

- frigöra

- frigörs

- relevanta

- repetitiva

- Obligatorisk

- Kräver

- forskning

- respons

- svar

- Resultat

- översyn

- Risk

- s

- SaaS

- skyddsåtgärder

- sagemaker

- Vetenskap

- Science Fiction

- vetenskapsmän

- screen

- sömlös

- Sök

- §

- säkra

- säkring

- Seek

- vald

- väljer

- senior

- känslig

- känsla

- känslor

- eras

- Tjänster

- session

- in

- inställning

- inställningar

- inställning

- Dela

- skall

- show

- visas

- eftersom

- färdigheter

- So

- Mjukvara

- mjukvaruutveckling

- lösning

- Lösningar

- LÖSA

- Källa

- kommer från

- Källor

- specialist

- specifik

- Spendera

- starta

- igång

- Starta

- state-of-the-art

- Steg

- Steg

- Fortfarande

- sådana

- sammanfatta

- stödja

- Växla

- system

- uppgifter

- lag

- Teknisk

- Tekniken

- Telco

- grundsatser

- än

- den där

- Smakämnen

- den information

- källan

- deras

- Dem

- sedan

- Där.

- detta

- de

- Genom

- tid

- till

- topp

- ämne

- Förvandla

- verkligen

- betrodd

- trimma

- SVÄNG

- under

- underliggande

- universitet

- tills

- TIDSENLIG

- Uppdatering

- upplyftande

- användning

- Begagnade

- Användare

- användare

- användningar

- med hjälp av

- ux

- värde

- mängd

- mycket

- syn

- volymer

- W

- gå

- vill

- var

- we

- webb

- webbservice

- były

- när

- som

- medan

- kommer

- med

- inom

- utan

- Arbete

- arbetsflöde

- fungerar

- skrivning

- Om er

- ung

- Din

- zephyrnet