Ökningen av sociala aktiviteter online som sociala nätverk eller onlinespel är ofta full av fientligt eller aggressivt beteende som kan leda till oönskade manifestationer av hatretorik, nätmobbning eller trakasserier. Till exempel erbjuder många onlinespelcommunities röstchattfunktionalitet för att underlätta kommunikationen mellan sina användare. Även om röstchatt ofta stöder vänliga skämt och trash talking, kan det också leda till problem som hatretorik, nätmobbning, trakasserier och bedrägerier. Att flagga skadligt språk hjälper organisationer att hålla konversationer civila och upprätthålla en säker och inkluderande onlinemiljö för användare att skapa, dela och delta fritt. Idag förlitar sig många företag enbart på mänskliga moderatorer för att granska giftigt innehåll. Det är dock dyrt att skala mänskliga moderatorer för att möta dessa behov med tillräcklig kvalitet och hastighet. Som ett resultat riskerar många organisationer att utsättas för höga användarförluster, skada på rykte och böter. Dessutom påverkas moderatorer ofta psykologiskt av att granska det giftiga innehållet.

Amazon Transcribe är en automatisk taligenkänningstjänst (ASR) som gör det enkelt för utvecklare att lägga till tal-till-text-funktioner till sina applikationer. Idag är vi glada att meddela Detektion av toxicitet för transkribering av Amazon, en maskininlärningsfunktion (ML) som använder både ljud- och textbaserade signaler för att identifiera och klassificera röstbaserat giftigt innehåll i sju kategorier, inklusive sexuella trakasserier, hatretorik, hot, övergrepp, svordomar, förolämpningar och grafiskt språk. . Förutom text använder Toxicity Detection talsignaler som toner och tonhöjd för att finslipa på giftiga avsikter i tal.

Detta är en förbättring från standardsystem för innehållsmoderering som är utformade för att fokusera endast på specifika termer, utan att ta hänsyn till avsikter. De flesta företag har en SLA på 7–15 dagar för att granska innehåll som rapporterats av användare eftersom moderatorer måste lyssna på långa ljudfiler för att utvärdera om och när konversationen blev giftig. Med Amazon Transcribe Toxicity Detection granskar moderatorer endast den specifika delen av ljudfilen som flaggats för giftigt innehåll (mot hela ljudfilen). Innehållet som mänskliga moderatorer måste granska minskas med 95 %, vilket gör det möjligt för kunder att reducera sin SLA till bara några timmar, samt göra det möjligt för dem att proaktivt moderera mer innehåll utöver vad som flaggats av användarna. Det kommer att göra det möjligt för företag att automatiskt upptäcka och moderera innehåll i stor skala, tillhandahålla en säker och inkluderande onlinemiljö och vidta åtgärder innan det kan orsaka användarmissbruk eller skada på rykte. Modellerna som används för upptäckt av giftigt innehåll underhålls av Amazon Transcribe och uppdateras regelbundet för att bibehålla noggrannhet och relevans.

I det här inlägget får du lära dig hur du:

- Identifiera skadligt innehåll i tal med Amazon Transcribe Toxicity Detection

- Använd Amazon Transcribe-konsolen för toxicitetsdetektering

- Skapa ett transkriptionsjobb med toxicitetsdetektering med hjälp av AWS-kommandoradsgränssnitt (AWS CLI) och Python SDK

- Använd Amazon Transcribe toxicity detection API-svaret

Upptäck toxicitet i ljudchatt med Amazon Transcribe Toxicity Detection

Amazon Transcribe erbjuder nu en enkel, ML-baserad lösning för att flagga skadligt språk i talade konversationer. Den här funktionen är särskilt användbar för sociala medier, spel och allmänna behov, vilket eliminerar behovet för kunder att tillhandahålla sin egen data för att träna ML-modellen. Toxicitetsdetektion klassificerar giftigt ljudinnehåll i följande sju kategorier och ger en konfidenspoäng (0–1) för varje kategori:

- Hädelser – Tal som innehåller ord, fraser eller akronymer som är oartigt, vulgärt eller stötande.

- Hattal – Tal som kritiserar, förolämpar, fördömer eller avhumaniserar en person eller grupp på grundval av en identitet (som ras, etnicitet, kön, religion, sexuell läggning, förmåga och nationellt ursprung).

- Sexuell – Tal som indikerar sexuellt intresse, aktivitet eller upphetsning med direkta eller indirekta referenser till kroppsdelar, fysiska egenskaper eller sex.

- förolämpningar – Tal som inkluderar förnedrande, förödmjukande, hånande, förolämpande eller förringande språk. Denna typ av språk betecknas också som mobbning.

- Våld eller hot – Tal som inkluderar hot som försöker orsaka smärta, skada eller fientlighet mot en person eller grupp.

- Grafisk – Tal som använder visuellt beskrivande och obehagligt levande bilder. Denna typ av språk är ofta avsiktligt mångsidigt för att förstärka en mottagares obehag.

- Trakasserier eller kränkande – Tal avsett att påverka mottagarens psykiska välbefinnande, inklusive förnedrande och objektiverande termer.

Du kan komma åt Toxicity Detection antingen via Amazon Transcribe-konsolen eller genom att anropa API:erna direkt med hjälp av AWS CLI eller AWS SDK:er. På Amazon Transcribe-konsolen kan du ladda upp ljudfilerna du vill testa för toxicitet och få resultat med bara några klick. Amazon Transcribe kommer att identifiera och kategorisera giftigt innehåll, såsom trakasserier, hatretorik, sexuellt innehåll, våld, förolämpningar och svordomar. Amazon Transcribe ger också en konfidenspoäng för varje kategori, vilket ger värdefulla insikter om innehållets toxicitetsnivå. Toxicitetsdetektion är för närvarande tillgänglig i Amazon Transcribes standard-API för batchbearbetning och stöder amerikansk engelska.

Genomgång av Amazon Transcribe-konsolen

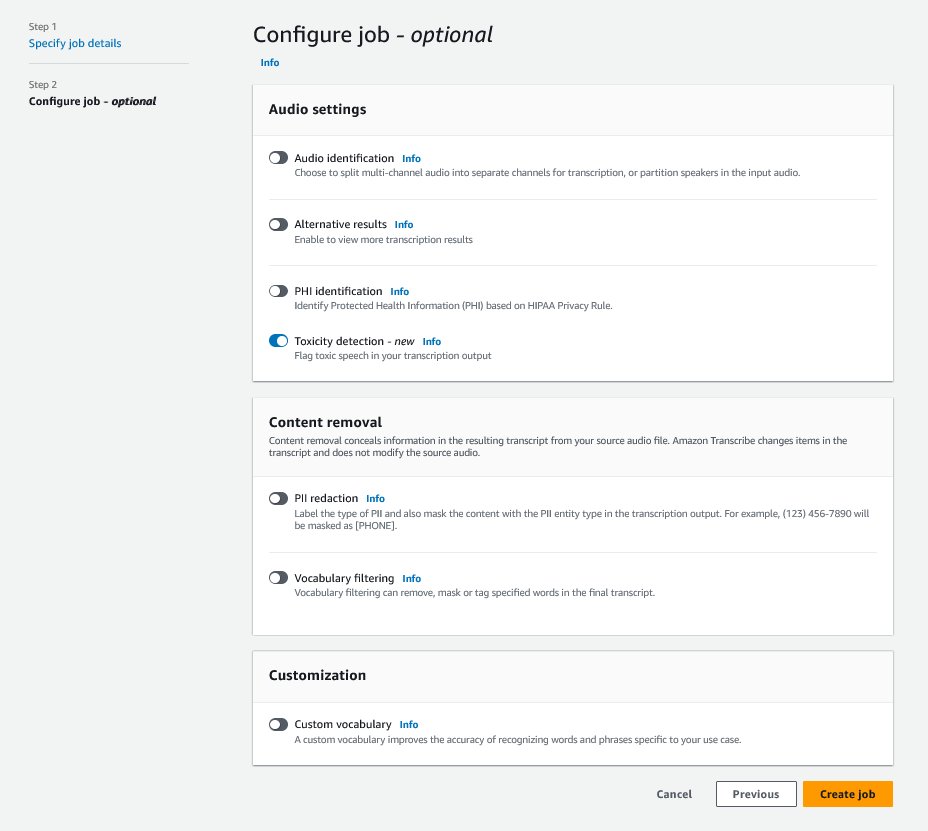

För att komma igång, logga in på AWS Management Console och gå till Amazon Transcribe. För att skapa ett nytt transkriptionsjobb måste du ladda upp dina inspelade filer till en Amazon enkel lagringstjänst (Amazon S3) hink innan de kan bearbetas. På sidan för ljudinställningar, som visas i följande skärmdump, aktivera Detektion av toxicitet och fortsätt med att skapa det nya jobbet. Amazon Transcribe kommer att bearbeta transkriptionsjobbet i bakgrunden. Allt eftersom jobbet fortskrider kan du förvänta dig att statusen ändras till AVSLUTAD när processen är klar.

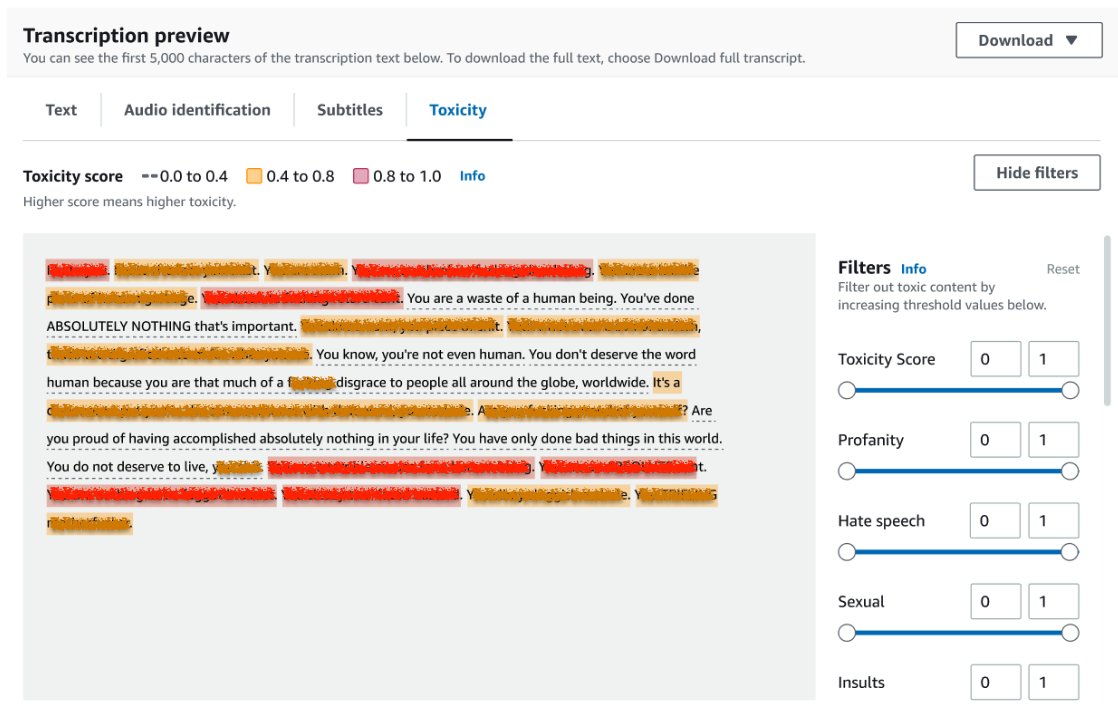

För att granska resultatet av ett transkriptionsjobb, välj jobbet från jobblistan för att öppna det. Scrolla ner till Förhandsgranskning av transkription avsnitt för att kontrollera resultaten på Toxicitet flik. Användargränssnittet visar färgkodade transkriptionssegment för att indikera graden av toxicitet, bestämt av konfidenspoängen. För att anpassa displayen kan du använda växlingslisterna i filter rutan. Dessa staplar låter dig justera tröskelvärdena och filtrera toxicitetskategorierna därefter.

Följande skärmdump har täckt delar av transkriptionstexten på grund av närvaron av känslig eller giftig information.

Transkriptions-API med en begäran om toxicitetsdetektering

I det här avsnittet guidar vi dig genom att skapa ett transkriptionsjobb med toxicitetsdetektering med hjälp av programmeringsgränssnitt. Om ljudfilen inte redan finns i en S3-hink, ladda upp den för att säkerställa åtkomst via Amazon Transcribe. I likhet med att skapa ett transkriptionsjobb på konsolen måste du ange följande parametrar när du anropar jobbet:

- TranscriptionJobName – Ange ett unikt jobbnamn.

- MediaFileUri – Ange URI-platsen för ljudfilen på Amazon S3. Amazon Transcribe stöder följande ljudformat: MP3, MP4, WAV, FLAC, AMR, OGG eller WebM

- Språkkod - Satt till

en-US. När detta skrivs stöder Toxicity Detection endast amerikansk engelska. - Toxicitetskategorier - Skicka

ALLvärde för att inkludera alla stödda toxicitetsdetektionskategorier.

Följande är exempel på att starta ett transkriptionsjobb med toxicitetsdetektering aktiverad med Python3:

Du kan anropa samma transkriptionsjobb med toxicitetsdetektering med följande AWS CLI-kommando:

Transkriptions-API med toxicitetsdetektionssvar

JSON-utdata för Amazon Transcribe toxicitetsdetektering kommer att inkludera transkriptionsresultaten i resultatfältet. Aktivering av toxicitetsdetektering lägger till ett extra fält som kallas toxicityDetection under resultatfältet. toxicityDetection innehåller en lista över transkriberade objekt med följande parametrar:

- text – Den råtranskriberade texten

- giftighet – En konfidenspoäng för upptäckt (ett värde mellan 0–1)

- kategorier – En konfidenspoäng för varje kategori av giftigt tal

- starttid – Detekteringens startposition i ljudfilen (sekunder)

- sluttid – Slutpositionen för detektering i ljudfilen (sekunder)

Följande är ett exempel på ett förkortat toxicitetsdetektionssvar som du kan ladda ner från konsolen:

Sammanfattning

I det här inlägget gav vi en översikt över den nya Amazon Transcribe Toxicity Detection-funktionen. Vi beskrev också hur du kan analysera JSON-utgången för toxicitetsdetektering. För mer information, kolla in Amazon Transcribe-konsolen och prova Transcription API med Toxicity Detection.

Amazon Transcribe Toxicity Detection är nu tillgängligt i följande AWS-regioner: USA East (Ohio), USA East (N. Virginia), USA West (Oregon), Asia Pacific (Sydney), Europa (Irland) och Europa (London). Om du vill veta mer, besök Amazon Transcribe.

Läs mer om innehållsmoderering på AWS och vårt innehållsmoderering ML användningsfall. Ta första steget mot effektivisera din innehållsmoderering med AWS.

Om författaren

Lana Zhang är en Senior Solutions Architect på AWS WWSO AI Services-teamet, specialiserat på AI och ML för innehållsmoderering, datorseende och naturlig språkbehandling. Med sin expertis är hon dedikerad till att marknadsföra AWS AI/ML-lösningar och hjälpa kunder att transformera sina affärslösningar inom olika branscher, inklusive sociala medier, spel, e-handel och reklam och marknadsföring.

Lana Zhang är en Senior Solutions Architect på AWS WWSO AI Services-teamet, specialiserat på AI och ML för innehållsmoderering, datorseende och naturlig språkbehandling. Med sin expertis är hon dedikerad till att marknadsföra AWS AI/ML-lösningar och hjälpa kunder att transformera sina affärslösningar inom olika branscher, inklusive sociala medier, spel, e-handel och reklam och marknadsföring.

Sumit Kumar är Sr Product Manager, Technical på AWS AI Language Services-teamet. Han har 10 års erfarenhet av produktledning inom en mängd olika domäner och brinner för AI/ML. Utanför jobbet älskar Sumit att resa och tycker om att spela cricket och grästennis.

Sumit Kumar är Sr Product Manager, Technical på AWS AI Language Services-teamet. Han har 10 års erfarenhet av produktledning inom en mängd olika domäner och brinner för AI/ML. Utanför jobbet älskar Sumit att resa och tycker om att spela cricket och grästennis.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Fordon / elbilar, Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- BlockOffsets. Modernisera miljökompensation ägande. Tillgång här.

- Källa: https://aws.amazon.com/blogs/machine-learning/flag-harmful-language-in-spoken-conversations-with-amazon-transcribe-toxicity-detection/

- : har

- :är

- :inte

- 10

- 100

- 16

- 17

- 20

- 24

- 7

- 95%

- a

- förmåga

- Om oss

- missbruk

- tillgång

- i enlighet med detta

- Redovisning

- noggrannhet

- tvärs

- Handling

- aktiviteter

- aktivitet

- lägga till

- Dessutom

- Lägger

- reklam

- aggressiv

- AI

- AI-tjänster

- AI / ML

- Alla

- tillåter

- redan

- också

- Även

- amason

- Amazon Transcribe

- Amazon Web Services

- bland

- an

- och

- Meddela

- api

- API: er

- tillämpningar

- ÄR

- AS

- asien

- Asiens pacific

- bistå

- At

- nötning

- audio

- Automat

- automatiskt

- tillgänglig

- AWS

- bakgrund

- barer

- grund

- BE

- blev

- därför att

- innan

- beteende

- mellan

- Bortom

- kropp

- båda

- Ha sönder

- mobbning

- företag

- by

- kallas

- anropande

- KAN

- kapacitet

- kategorier

- Kategori

- Orsak

- byta

- ta

- Välja

- klassificera

- Kommunikation

- samhällen

- Företag

- fullborda

- Avslutade

- dator

- Datorsyn

- förtroende

- Konsol

- innehåller

- innehåll

- Konversation

- konversationer

- omfattas

- skapa

- Skapa

- kricket

- kritiserar

- För närvarande

- Kunder

- skräddarsy

- datum

- Dagar

- dedicerad

- beskriven

- utformade

- upptäcka

- Detektering

- bestämd

- utvecklare

- rikta

- direkt

- Visa

- flera

- domäner

- ner

- ladda ner

- grund

- e-handel

- varje

- öster

- lätt

- antingen

- eliminera

- möjliggöra

- aktiverad

- möjliggör

- änden

- Engelska

- säkerställa

- ange

- företag

- Hela

- Miljö

- speciellt

- etnicitet

- Europa

- utvärdera

- exempel

- exempel

- exciterade

- förvänta

- dyra

- erfarenhet

- expertis

- extra

- främja

- vänd

- Misslyckades

- Leverans

- få

- fält

- Fil

- Filer

- filtrera

- ändarna

- Förnamn

- flaggad

- Fokus

- efter

- För

- vänliga

- från

- funktionalitet

- Gaming

- Kön

- Allmänt

- skaffa sig

- Go

- Går

- Grafisk

- Grupp

- styra

- skadliga

- Har

- he

- hjälper

- här

- här.

- Hög

- ÖPPETTIDER

- Hur ser din drömresa ut

- How To

- Men

- html

- http

- HTTPS

- humant

- identifiera

- Identitet

- if

- påverkade

- importera

- förbättring

- in

- innefattar

- innefattar

- Inklusive

- Inkludering

- Öka

- indikerar

- pekar på

- industrier

- informationen

- insikter

- Förolämpning

- avsedd

- uppsåt

- Avsikt

- avsiktligt

- intresse

- gränssnitt

- in

- irland

- IT

- artikel

- Jobb

- jpg

- json

- bara

- Ha kvar

- språk

- leda

- LÄRA SIG

- inlärning

- Nivå

- linje

- Lista

- läge

- london

- älskar

- Maskinen

- maskininlärning

- bibehålla

- GÖR

- ledning

- chef

- många

- Marknadsföring

- Media

- Möt

- ML

- modell

- modeller

- måttfullhet

- mer

- mest

- måste

- namn

- nationell

- Natural

- Naturlig språkbehandling

- Behöver

- behov

- nätverk

- Nya

- nu

- of

- erbjudanden

- Ofta

- Ohio

- on

- nätet

- onlinespel

- endast

- öppet

- Verksamhet

- or

- Oregon

- organisationer

- ursprung

- vår

- ut

- produktion

- utanför

- Översikt

- egen

- stilla havet

- sida

- Smärta

- parametrar

- delta

- reservdelar till din klassiker

- passera

- brinner

- personen

- fraser

- fysisk

- Tonhöjd

- plato

- Platon Data Intelligence

- PlatonData

- i

- del

- placera

- Inlägg

- Närvaron

- problem

- process

- Bearbetad

- bearbetning

- Produkt

- produktledning

- produktchef

- HÄDELSER

- Programmering

- främja

- ge

- förutsatt

- ger

- tillhandahålla

- Python

- kvalitet

- Lopp

- rates

- Raw

- redo

- erkännande

- registreras

- minska

- Minskad

- referenser

- regioner

- regulatorer

- relevans

- religion

- förlita

- Rapporterad

- respons

- resultera

- Resultat

- översyn

- reviewing

- Risk

- säker

- Samma

- Skala

- skalning

- bedrägerier

- göra

- rulla

- sdks

- sekunder

- §

- söker

- segmentet

- segment

- senior

- känslig

- service

- Tjänster

- in

- inställningar

- sju

- Sex

- Sexuell

- Dela

- hon

- visas

- Visar

- signera

- liknande

- Enkelt

- Social hållbarhet

- sociala medier

- Sociala nätverk

- enbart

- lösning

- Lösningar

- specialiserat

- specifik

- tal

- Taligenkänning

- tal-till-text

- fart

- talat

- standard

- starta

- igång

- Starta

- status

- Steg

- förvaring

- sådana

- tillräcklig

- Som stöds

- Stöder

- sydney

- System

- Ta

- tala

- grupp

- Teknisk

- villkor

- testa

- den där

- Smakämnen

- deras

- Dem

- Dessa

- de

- detta

- hot

- Genom

- tid

- till

- i dag

- mot

- mot

- Tåg

- omvandla

- färdas

- sann

- prova

- Typ

- ui

- under

- unika

- oönskad

- uppdaterad

- us

- användning

- Begagnade

- Användare

- användare

- användningar

- med hjälp av

- Värdefulla

- värde

- mängd

- via

- Våld

- Virginia

- syn

- Besök

- Röst

- vs

- vulgär

- vänta

- vill

- we

- webb

- webbservice

- VÄL

- väster

- när

- medan

- kommer

- med

- utan

- ord

- Arbete

- skrivning

- år

- ännu

- Om er

- Din

- zephyrnet