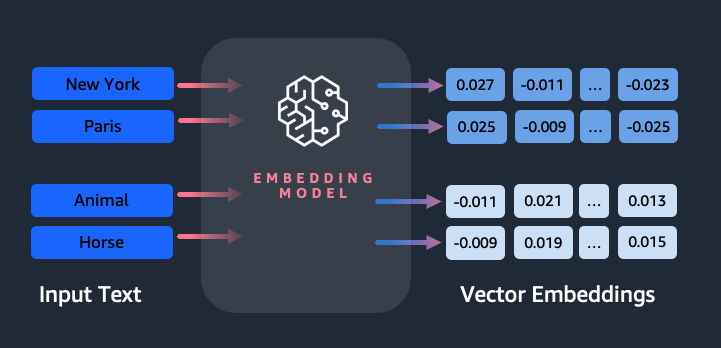

Inbäddningar spelar en nyckelroll i naturlig språkbehandling (NLP) och maskininlärning (ML). Textinbäddning hänvisar till processen att omvandla text till numeriska representationer som finns i ett högdimensionellt vektorrum. Denna teknik uppnås genom användning av ML-algoritmer som möjliggör förståelsen av datas betydelse och sammanhang (semantiska relationer) och inlärning av komplexa relationer och mönster inom data (syntaktiska relationer). Du kan använda de resulterande vektorrepresentationerna för ett brett spektrum av tillämpningar, såsom informationshämtning, textklassificering, naturlig språkbehandling och många andra.

Amazon Titan textinbäddningar är en textinbäddningsmodell som omvandlar text på naturligt språk – som består av enstaka ord, fraser eller till och med stora dokument – till numeriska representationer som kan användas för att driva användningsfall som sökning, personalisering och klustring baserat på semantisk likhet.

I det här inlägget diskuterar vi Amazon Titan Text Embeddings-modellen, dess funktioner och exempel på användningsfall.

Några nyckelbegrepp inkluderar:

- Numerisk representation av text (vektorer) fångar semantik och relationer mellan ord

- Rich inbäddningar kan användas för att jämföra textlikhet

- Flerspråkig textinbäddning kan identifiera betydelse på olika språk

Hur omvandlas ett stycke text till en vektor?

Det finns flera tekniker för att omvandla en mening till en vektor. En populär metod är att använda ordinbäddningsalgoritmer, som Word2Vec, GloVe eller FastText, och sedan aggregera ordinbäddningar för att bilda en vektorrepresentation på meningsnivå.

Ett annat vanligt tillvägagångssätt är att använda stora språkmodeller (LLM), som BERT eller GPT, som kan tillhandahålla kontextualiserade inbäddningar för hela meningar. Dessa modeller är baserade på djupinlärningsarkitekturer som Transformers, som kan fånga kontextuell information och relationer mellan ord i en mening mer effektivt.

Varför behöver vi en inbäddningsmodell?

Vektorinbäddningar är grundläggande för att LLM:er ska förstå språkets semantiska grader, och gör det också möjligt för LLM:er att prestera bra på nedströms NLP-uppgifter som sentimentanalys, namngiven enhetsigenkänning och textklassificering.

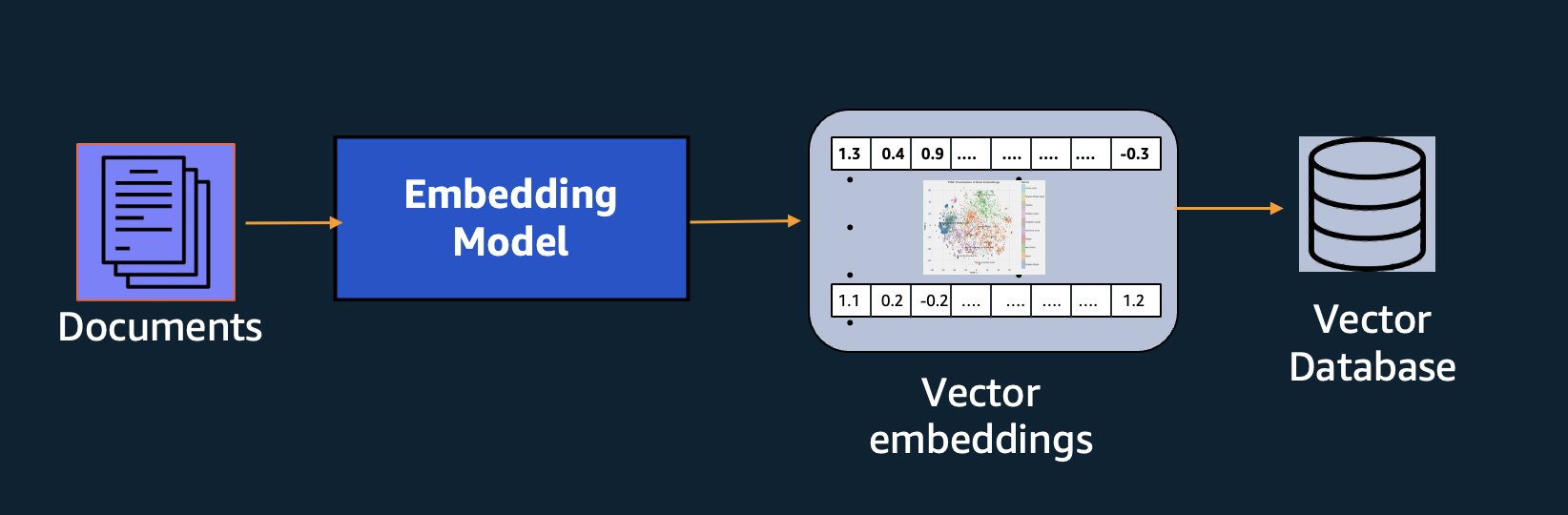

Förutom semantisk sökning kan du använda inbäddningar för att utöka dina meddelanden för mer exakta resultat genom Retrieval Augmented Generation (RAG) – men för att kunna använda dem måste du lagra dem i en databas med vektorfunktioner.

Amazon Titan Text Embeddings-modellen är optimerad för texthämtning för att möjliggöra RAG-användningsfall. Det gör det möjligt för dig att först konvertera din textdata till numeriska representationer eller vektorer och sedan använda dessa vektorer för att exakt söka efter relevanta passager från en vektordatabas, så att du kan få ut det mesta av din egen data i kombination med andra grundmodeller.

Eftersom Amazon Titan Text Embeddings är en hanterad modell på Amazonas berggrund, det erbjuds som en helt serverlös upplevelse. Du kan använda den antingen via Amazon Bedrock REST API eller AWS SDK. De nödvändiga parametrarna är texten som du vill generera inbäddningar av och modelID parameter, som representerar namnet på Amazon Titan Text Embeddings-modellen. Följande kod är ett exempel som använder AWS SDK för Python (Boto3):

Utgången kommer att se ut ungefär som följande:

Hänvisa till Amazon Bedrock boto3-installation för mer information om hur du installerar de nödvändiga paketen, anslut till Amazon Bedrock och anropa modeller.

Funktioner hos Amazon Titan Text Inbäddningar

Med Amazon Titan Text Embeddings kan du mata in upp till 8,000 XNUMX tokens, vilket gör den väl lämpad att arbeta med enstaka ord, fraser eller hela dokument baserat på ditt användningsfall. Amazon Titan returnerar utdatavektorer med dimension 1536, vilket ger den en hög grad av noggrannhet, samtidigt som den optimerar för låg latens, kostnadseffektiva resultat.

Amazon Titan Text Embeddings stöder att skapa och fråga inbäddningar för text på över 25 olika språk. Det betyder att du kan tillämpa modellen på dina användningsfall utan att behöva skapa och underhålla separata modeller för varje språk du vill stödja.

Att ha en enda inbäddningsmodell tränad på många språk ger följande viktiga fördelar:

- Bredare räckvidd – Genom att stödja över 25 språk direkt kan du utöka räckvidden för dina applikationer till användare och innehåll på många internationella marknader.

- Konsekvent prestanda – Med en enhetlig modell som täcker flera språk får du konsekventa resultat över språk istället för att optimera separat per språk. Modellen är holistiskt tränad så att du får fördelen över språken.

- Flerspråkig frågestöd – Amazon Titan Text Inbäddningar gör det möjligt att fråga textinbäddningar på något av de språk som stöds. Detta ger flexibilitet att hämta semantiskt liknande innehåll på flera språk utan att vara begränsad till ett enda språk. Du kan bygga applikationer som frågar efter och analyserar flerspråkig data med samma enhetliga inbäddningsutrymme.

När detta skrivs stöds följande språk:

- arabiska

- Förenklad kinesiska)

- kinesiska

- tjeckiska

- Dutch

- Engelska

- franska

- tyska

- Hebreiska

- hindi

- italienska

- japanska

- kannada

- koreanska

- malayalam

- marathi

- polska

- portugisiska

- ryska

- spanska

- svenska

- Filippinsk tagalog

- tamil

- telugu

- turkiska

Använda Amazon Titan Text Inbäddningar med LangChain

Langkedja är ett populärt ramverk med öppen källkod att arbeta med generativ AI modeller och stödjande tekniker. Den innehåller en BedrockEmbeddings klient som bekvämt omsluter Boto3 SDK med ett abstraktionslager. De BedrockEmbeddings klienten låter dig arbeta med text och inbäddningar direkt, utan att känna till detaljerna i JSON-förfrågan eller svarsstrukturer. Följande är ett enkelt exempel:

Du kan också använda LangChain's BedrockEmbeddings klient tillsammans med Amazon Bedrock LLM-klienten för att förenkla implementering av RAG, semantisk sökning och andra inbäddningsrelaterade mönster.

Använd fodral för inbäddningar

Även om RAG för närvarande är det mest populära användningsfallet för att arbeta med inbäddningar, finns det många andra användningsfall där inbäddningar kan tillämpas. Följande är några ytterligare scenarier där du kan använda inbäddningar för att lösa specifika problem, antingen på egen hand eller i samarbete med en LLM:

- Frågor och svar – Inbäddningar kan hjälpa till att stödja gränssnitt för frågor och svar genom RAG-mönstret. Generering av inbäddningar i kombination med en vektordatabas gör att du kan hitta nära matchningar mellan frågor och innehåll i ett kunskapsförråd.

- Personliga rekommendationer – I likhet med frågor och svar kan du använda inbäddningar för att hitta semesterdestinationer, högskolor, fordon eller andra produkter baserat på de kriterier som användaren tillhandahåller. Detta kan ha formen av en enkel lista med matchningar, eller så kan du använda en LLM för att behandla varje rekommendation och förklara hur den uppfyller användarens kriterier. Du kan också använda detta tillvägagångssätt för att skapa anpassade "10 bästa" artiklar för en användare baserat på deras specifika behov.

- Datahantering – När du har datakällor som inte mappar rent till varandra, men du har textinnehåll som beskriver dataposten, kan du använda inbäddningar för att identifiera potentiella dubbletter av poster. Du kan till exempel använda inbäddningar för att identifiera dubbletter av kandidater som kan använda olika formatering, förkortningar eller till och med ha översatta namn.

- Rationalisering av applikationsportföljen – När man vill anpassa applikationsportföljer mellan ett moderbolag och ett förvärv är det inte alltid självklart var man ska börja hitta potentiell överlappning. Kvaliteten på konfigurationshanteringsdata kan vara en begränsande faktor, och det kan vara svårt att koordinera mellan team för att förstå applikationslandskapet. Genom att använda semantisk matchning med inbäddningar kan vi göra en snabb analys över applikationsportföljer för att identifiera högpotentiala kandidatansökningar för rationalisering.

- Innehållsgruppering – Du kan använda inbäddningar för att underlätta gruppering av liknande innehåll i kategorier som du kanske inte känner till i förväg. Låt oss till exempel säga att du hade en samling av kundmeddelanden eller produktrecensioner online. Du kan skapa inbäddningar för varje objekt och sedan köra igenom dessa inbäddningar k- betyder klustring för att identifiera logiska grupperingar av kundproblem, produktberöm eller klagomål eller andra teman. Du kan sedan generera fokuserade sammanfattningar från dessa grupperingars innehåll med hjälp av en LLM.

Semantisk sökning exempel

I vår exempel på GitHub, visar vi ett enkelt sökprogram för inbäddningar med Amazon Titan Text Embeddings, LangChain och Streamlit.

Exemplet matchar en användares fråga med de närmaste posterna i en vektordatabas i minnet. Vi visar sedan dessa matchningar direkt i användargränssnittet. Detta kan vara användbart om du vill felsöka en RAG-applikation eller direkt utvärdera en inbäddningsmodell.

För enkelhetens skull använder vi in-memory FAISS databas för att lagra och söka efter inbäddningsvektorer. I ett verkligt scenario i stor skala, kommer du sannolikt att vilja använda ett beständigt datalager som vektormotor för Amazon OpenSearch Serverless eller pgvektor tillägg för PostgreSQL.

Prova några uppmaningar från webbapplikationen på olika språk, till exempel följande:

- Hur kan jag övervaka min användning?

- Hur kan jag anpassa modeller?

- Vilka programmeringsspråk kan jag använda?

- Kommentera mes données sont-elles sécurisées ?

- 私のデータはどのように保護されていますか?

- Quais fornecedores de modelos estão disponíveis por meio do Berggrund?

- I welchen Regionen är Amazon Bedrock tillgänglig?

- 有哪些级别的支持?

Observera att även om källmaterialet var på engelska, matchades frågorna på andra språk med relevanta poster.

Slutsats

Textgenereringsförmågan hos grundmodeller är mycket spännande, men det är viktigt att komma ihåg att förståelse av text, att hitta relevant innehåll från en mängd kunskap och att skapa kopplingar mellan passager är avgörande för att uppnå det fulla värdet av generativ AI. Vi kommer att fortsätta att se nya och intressanta användningsfall för inbäddningar dyka upp under de kommande åren när dessa modeller fortsätter att förbättras.

Nästa steg

Du kan hitta ytterligare exempel på inbäddningar som bärbara datorer eller demoapplikationer i följande workshops:

Om författarna

Jason Stehle är Senior Solutions Architect på AWS, baserad i New England-området. Han arbetar med kunder för att anpassa AWS-kapaciteten till deras största affärsutmaningar. Utanför jobbet ägnar han tid åt att bygga saker och titta på serietidningsfilmer med sin familj.

Jason Stehle är Senior Solutions Architect på AWS, baserad i New England-området. Han arbetar med kunder för att anpassa AWS-kapaciteten till deras största affärsutmaningar. Utanför jobbet ägnar han tid åt att bygga saker och titta på serietidningsfilmer med sin familj.

Nitin Eusebius är Sr. Enterprise Solutions Architect på AWS, erfaren inom mjukvaruteknik, Enterprise Architecture och AI/ML. Han brinner djupt för att utforska möjligheterna med generativ AI. Han samarbetar med kunder för att hjälpa dem att bygga väldesignade applikationer på AWS-plattformen och är dedikerad till att lösa tekniska utmaningar och hjälpa till med deras molnresa.

Nitin Eusebius är Sr. Enterprise Solutions Architect på AWS, erfaren inom mjukvaruteknik, Enterprise Architecture och AI/ML. Han brinner djupt för att utforska möjligheterna med generativ AI. Han samarbetar med kunder för att hjälpa dem att bygga väldesignade applikationer på AWS-plattformen och är dedikerad till att lösa tekniska utmaningar och hjälpa till med deras molnresa.

Raj Pathak är en huvudlösningsarkitekt och teknisk rådgivare till stora Fortune 50-företag och medelstora finansiella tjänster (FSI) i Kanada och USA. Han är specialiserad på maskininlärningsapplikationer som generativ AI, naturlig språkbehandling, intelligent dokumentbearbetning och MLOps.

Raj Pathak är en huvudlösningsarkitekt och teknisk rådgivare till stora Fortune 50-företag och medelstora finansiella tjänster (FSI) i Kanada och USA. Han är specialiserad på maskininlärningsapplikationer som generativ AI, naturlig språkbehandling, intelligent dokumentbearbetning och MLOps.

Mani Khanuja är en teknisk ledare – Generativa AI-specialister, författare till boken – Applied Machine Learning and High Performance Computing on AWS, och medlem i styrelsen för Women in Manufacturing Education Foundation Board. Hon leder maskininlärningsprojekt (ML) inom olika domäner som datorseende, naturlig språkbehandling och generativ AI. Hon hjälper kunder att bygga, träna och implementera stora maskininlärningsmodeller i stor skala. Hon talar i interna och externa konferenser som re:Invent, Women in Manufacturing West, YouTube webinars och GHC 23. På fritiden gillar hon att gå långa löpturer längs stranden.

Mani Khanuja är en teknisk ledare – Generativa AI-specialister, författare till boken – Applied Machine Learning and High Performance Computing on AWS, och medlem i styrelsen för Women in Manufacturing Education Foundation Board. Hon leder maskininlärningsprojekt (ML) inom olika domäner som datorseende, naturlig språkbehandling och generativ AI. Hon hjälper kunder att bygga, träna och implementera stora maskininlärningsmodeller i stor skala. Hon talar i interna och externa konferenser som re:Invent, Women in Manufacturing West, YouTube webinars och GHC 23. På fritiden gillar hon att gå långa löpturer längs stranden.

Mark Roy är en huvudarkitekt för maskininlärning för AWS, som hjälper kunder att designa och bygga AI/ML-lösningar. Marks arbete täcker ett brett spektrum av ML-användningsfall, med ett primärt intresse för datorseende, djupinlärning och skalning av ML över hela företaget. Han har hjälpt företag inom många branscher, inklusive försäkring, finansiella tjänster, media och underhållning, hälsovård, allmännyttiga företag och tillverkning. Mark innehar sex AWS-certifieringar, inklusive ML Specialty Certification. Innan han började på AWS var Mark arkitekt, utvecklare och teknikledare i över 25 år, inklusive 19 år inom finansiella tjänster.

Mark Roy är en huvudarkitekt för maskininlärning för AWS, som hjälper kunder att designa och bygga AI/ML-lösningar. Marks arbete täcker ett brett spektrum av ML-användningsfall, med ett primärt intresse för datorseende, djupinlärning och skalning av ML över hela företaget. Han har hjälpt företag inom många branscher, inklusive försäkring, finansiella tjänster, media och underhållning, hälsovård, allmännyttiga företag och tillverkning. Mark innehar sex AWS-certifieringar, inklusive ML Specialty Certification. Innan han började på AWS var Mark arkitekt, utvecklare och teknikledare i över 25 år, inklusive 19 år inom finansiella tjänster.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://aws.amazon.com/blogs/machine-learning/getting-started-with-amazon-titan-text-embeddings/

- : har

- :är

- :inte

- :var

- $UPP

- 000

- 10

- 100

- 12

- 121

- 125

- 19

- 23

- 25

- 50

- 7

- 8

- a

- Om oss

- abstraktion

- Acceptera

- noggrannhet

- exakt

- exakt

- uppnås

- uppnå

- förvärv

- tvärs

- Dessutom

- Annat

- Fördel

- rådgivare

- aggregerande

- framåt

- AI

- AI / ML

- algoritmer

- rikta

- Alla

- tillåter

- tillåta

- tillåter

- längs

- vid sidan av

- också

- alltid

- amason

- Amazon Web Services

- an

- analys

- analysera

- och

- svara

- vilken som helst

- Ansökan

- tillämpningar

- tillämpas

- Ansök

- tillvägagångssätt

- arkitektur

- arkitekturer

- ÄR

- OMRÅDE

- artiklar

- AS

- bistå

- At

- förstärka

- augmented

- Författaren

- tillgänglig

- AWS

- baserat

- BE

- Beach

- Där vi får lov att vara utan att konstant prestera,

- Fördelarna

- mellan

- ombord

- styrelse

- kropp

- boken

- Box

- SLUTRESULTAT

- Byggnad

- företag

- men

- by

- KAN

- Kanada

- kandidat

- kandidater

- kapacitet

- fånga

- fångar

- Vid

- fall

- kategorier

- certifiering

- certifieringar

- utmaningar

- klassificering

- klient

- Stäng

- cloud

- klustring

- koda

- de samarbetar

- samling

- högskolor

- kombination

- Gemensam

- Företag

- företag

- jämföra

- klagomål

- komplex

- dator

- Datorsyn

- databehandling

- Begreppen

- oro

- konferenser

- konfiguration

- Kontakta

- anslutning

- Anslutningar

- konsekvent

- innehåll

- sammanhang

- kontextuella

- fortsätta

- bekvämt

- konvertera

- konverterad

- samarbete

- samordnande

- kostnadseffektiv

- kunde

- beläggning

- Täcker

- skapa

- Skapa

- kriterier

- avgörande

- För närvarande

- beställnings

- kund

- Kunder

- skräddarsy

- datum

- Databas

- de

- dedicerad

- djup

- djupt lärande

- djupt

- definiera

- Examen

- demo

- demonstrera

- distribuera

- beskriver

- Designa

- destinationer

- detaljer

- Utvecklare

- olika

- svårt

- Dimensionera

- direkt

- Direktörer

- diskutera

- Visa

- do

- dokumentera

- dokument

- domäner

- inte

- varje

- Utbildning

- effektivt

- antingen

- e

- inbäddning

- framträda

- möjliggöra

- möjliggör

- Motor

- Teknik

- England

- Engelska

- Företag

- Underhållning

- Hela

- helt

- enhet

- utvärdera

- Även

- exempel

- exempel

- spännande

- Bygga ut

- erfarenhet

- erfaren

- Förklara

- Utforska

- förlängning

- extern

- främja

- faktor

- familj

- Funktioner

- få

- finansiella

- finansiella tjänster

- hitta

- finna

- Förnamn

- Flexibilitet

- fokuserade

- efter

- För

- formen

- Förmögenhet

- fundament

- Ramverk

- Fri

- från

- full

- grundläggande

- generera

- generering

- generativ

- Generativ AI

- skaffa sig

- få

- Ge

- handske

- Go

- störst

- hade

- Har

- he

- hälso-och sjukvård

- hjälpa

- hjälpte

- hjälpa

- hjälper

- här

- Hög

- hans

- innehar

- Hur ser din drömresa ut

- How To

- html

- HTTPS

- i

- identifiera

- if

- genomföra

- importera

- med Esport

- förbättra

- in

- I andra

- innefattar

- innefattar

- Inklusive

- industrier

- informationen

- ingång

- installera

- istället

- institutioner

- försäkring

- Intelligent

- Intelligent dokumentbehandling

- intresse

- intressant

- Gränssnitt

- gränssnitt

- inre

- Internationell

- in

- IT

- DESS

- sammanfogning

- resa

- jpg

- json

- Nyckel

- Vet

- Menande

- kunskap

- liggande

- språk

- Språk

- Large

- lager

- leda

- ledare

- Leads

- inlärning

- Låt

- tycka om

- sannolikt

- gillar

- begränsande

- Lista

- LLM

- logisk

- Lång

- se

- du letar

- Maskinen

- maskininlärning

- bibehålla

- göra

- Framställning

- förvaltade

- ledning

- Produktion

- många

- karta

- markera

- Marks

- Marknader

- matchas

- tändstickor

- matchande

- Materialet

- me

- betyder

- betyder

- Media

- medlem

- metod

- kanske

- ML

- MLOps

- modell

- modeller

- Övervaka

- mer

- mest

- Mest populär

- Filmer

- multipel

- my

- namn

- Som heter

- namn

- Natural

- Naturlig språkbehandling

- Behöver

- behöver

- behov

- Nya

- Nästa

- nlp

- Uppenbara

- of

- erbjuds

- on

- ONE

- nätet

- öppet

- öppen källkod

- optimerad

- optimera

- or

- beställa

- Övriga

- Övrigt

- vår

- ut

- produktion

- utanför

- över

- överlappning

- egen

- paket

- parade

- parameter

- parametrar

- moderbolag

- passager

- brinner

- Mönster

- mönster

- för

- Utföra

- prestanda

- personalisering

- fraser

- bit

- plattform

- plato

- Platon Data Intelligence

- PlatonData

- Spela

- snälla du

- Populära

- AV

- portfölj

- portföljer

- Möjligheterna

- Inlägg

- PostgreSQL

- potentiell

- kraft

- primär

- Principal

- Skriva ut

- Innan

- problem

- process

- bearbetning

- Produkt

- Recensioner

- Produkter

- Programmering

- programmeringsspråk

- projekt

- prompter

- proprietary

- ge

- förutsatt

- ger

- Python

- kvalitet

- sökfrågor

- fråga

- fråga

- frågor

- Snabbt

- trasa

- område

- RE

- nå

- verkliga världen

- erkännande

- Rekommendation

- rekommendationer

- post

- register

- hänvisar

- Förhållanden

- relevanta

- ihåg

- Repository

- representation

- representerar

- begära

- Obligatorisk

- respons

- REST

- begränsad

- resulterande

- Resultat

- hämtning

- återgår

- Omdömen

- Roll

- Körning

- kör

- s

- Samma

- säga

- Skala

- skalning

- scenario

- scenarier

- sDK

- Sök

- se

- semantisk

- semantik

- senior

- mening

- känsla

- separat

- Server

- Tjänster

- hon

- liknande

- Enkelt

- enkelhet

- förenklade

- förenkla

- enda

- SEX

- So

- Mjukvara

- mjukvaruutveckling

- Lösningar

- LÖSA

- Lösa

- några

- något

- Källa

- Källor

- Utrymme

- talar

- specialister

- specialiserat

- Specialitet

- specifik

- starta

- igång

- Stater

- lagra

- strukturer

- sådana

- stödja

- Som stöds

- Stödjande

- Stöder

- Ta

- uppgifter

- lag

- tech

- Teknisk

- Tekniken

- tekniker

- Tekniken

- Teknologi

- tala

- text

- Textklassificering

- den där

- Smakämnen

- källan

- deras

- Dem

- teman

- sedan

- Där.

- Dessa

- saker

- detta

- de

- fastän?

- Genom

- tid

- titan

- till

- tokens

- traditionell

- Tåg

- tränad

- transformatorer

- omvandla

- förstå

- förståelse

- enhetlig

- United

- USA

- Användning

- användning

- användningsfall

- Begagnade

- användbara

- Användare

- Användargränssnitt

- användare

- med hjälp av

- verktyg

- semester

- värde

- olika

- fordon

- mycket

- via

- syn

- vill

- var

- tittar

- we

- webb

- webbapplikation

- webbservice

- Webbseminarier

- VÄL

- były

- väster

- när

- som

- medan

- bred

- Brett utbud

- kommer

- med

- inom

- utan

- Kvinnor

- ord

- ord

- Arbete

- arbetssätt

- fungerar

- Workshops

- skulle

- skriva

- skrivning

- år

- Om er

- Din

- Youtube

- zephyrnet