Video Googles största AI-språkmodell hjälper robotar att vara mer flexibla i att förstå och tolka mänskliga kommandon, enligt webbjättens senaste forskning.

Maskiner svarar vanligtvis bäst på mycket specifika krav – öppna förfrågningar kan ibland kasta bort dem och leda till resultat som användarna inte hade i åtanke. Människor lär sig att interagera med robotar på ett stelbent sätt, som att ställa frågor på ett visst sätt för att få önskat svar.

Googles senaste system, kallat PaLM-SayCan, lovar dock att bli smartare. Den fysiska enheten från Everyday Robots – en startup baserad på Google X – har kameror för ögon i huvudet och en arm med en tång instoppad bakom sin långa raka kropp, som sitter ovanpå en uppsättning hjul.

Du kan se roboten i aktion i videon nedan:

Frågar roboten något i stil med "Jag har precis tränat, kan du ge mig ett hälsosamt mellanmål?" kommer att knuffa den till att hämta ett äpple. "PaLM-SayCan [är] ett tolkningsbart och allmänt tillvägagångssätt för att utnyttja kunskap från språkmodeller som gör det möjligt för en robot att följa textinstruktioner på hög nivå för att utföra fysiskt grundade uppgifter," forskare från Googles hjärnteam förklarade.

Google introducerade sin största språkmodell Handflatan i april i år. PaLM tränades på data som skrapats från internet, men istället för att sprida öppna textsvar anpassades systemet för att generera en lista med instruktioner som roboten skulle följa.

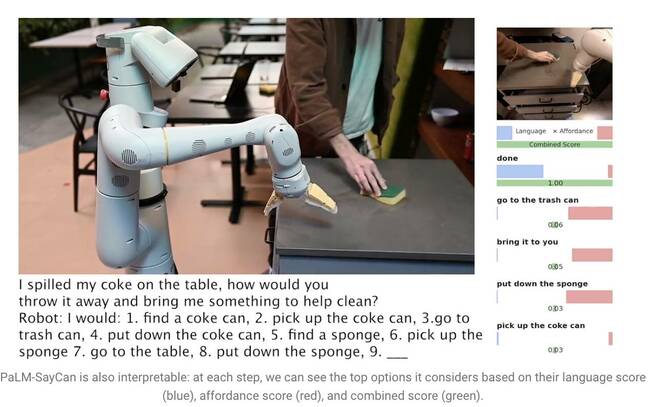

Genom att säga "Jag spillde min Cola på bordet, hur skulle du slänga den och ge mig något att hjälpa till med att städa?", uppmanar PaLM att förstå frågan och skapa en lista med steg som roboten kan följa för att slutföra uppgiften, som att gå över. att plocka upp burken, slänga den i en soptunna och få en svamp.

Stora språkmodeller (LLM) som PaLM förstår dock inte innebörden av något de säger. Av denna anledning tränade forskarna en separat modell med hjälp av förstärkningsinlärning för att grunda abstrakt språk till visuella representationer och handlingar. På så sätt lär sig roboten att associera ordet "cola" med en bild av en kolsyrad drycksburk.

PaLM-SayCan lär sig även så kallade ”affordance-funktioner” – en metod som rangordnar möjligheten att genomföra en specifik åtgärd givna objekt i sin omgivning. Roboten är mer benägen att plocka upp en svamp än en dammsugare, till exempel om den upptäcker en svamp men inget vakuum i närheten av den.

"Vår metod, SayCan, extraherar och utnyttjar kunskapen inom LLMs i fysiskt grundade uppgifter," förklarade teamet i en uppsats. "LLM (Say) tillhandahåller en uppgiftsgrundande för att fastställa användbara åtgärder för ett högnivåmål och de inlärda affordance-funktionerna (Can) tillhandahåller en världsomfattande grund för att avgöra vad som är möjligt att utföra på planen. Vi använder förstärkningsinlärning (RL) som ett sätt att lära oss språkbetingade värdefunktioner som ger möjligheter till vad som är möjligt i världen.”

För att förhindra att roboten avviker från uppgiften är den tränad att välja åtgärder från endast 101 olika instruktioner. Google tränade den att anpassa sig till ett kök – PaLM-SayCan kan få snacks, drycker och utföra enkla städuppgifter. Forskarna tror att LLM är det första steget för att få robotar att utföra mer komplexa uppgifter på ett säkert sätt med abstrakta instruktioner.

"Våra experiment med ett antal verkliga robotuppgifter visar förmågan att planera och slutföra abstrakta, naturliga språkinstruktioner med lång horisont med en hög framgångsfrekvens. Vi tror att PaLM-SayCans tolkningsmöjligheter möjliggör säker verklig användarinteraktion med robotar”, avslutade de. ®

- AI

- ai konst

- ai art generator

- har robot

- artificiell intelligens

- artificiell intelligenscertifiering

- artificiell intelligens inom bankväsendet

- artificiell intelligens robot

- robotar med artificiell intelligens

- programvara för artificiell intelligens

- blockchain

- blockchain konferens ai

- coingenius

- konversationskonstnärlig intelligens

- kryptokonferens ai

- dalls

- djupt lärande

- du har google

- maskininlärning

- plato

- plato ai

- Platon Data Intelligence

- Platon spel

- PlatonData

- platogaming

- skala ai

- syntax

- Registret

- zephyrnet