Anmärkningsvärda språng i hjärn-dator-gränssnittsteknik som skulle kunna återställa mer naturalistisk kommunikation till människor som lever med förlamning har beskrivits i två nya tidningar i Natur. Båda experimentsystemen har visat förmågan att avkoda hjärnaktivitet till tal snabbare, mer exakt och med ett större ordförråd än befintliga alternativ.

Hjärnkirurg Edward Chang från University of California, San Francisco (UCSF) har arbetat med gränssnittsteknologier mellan hjärna och dator i mer än ett decennium. I tidigare arbete visade hans team att det var möjligt, med hjälp av ett implantat, att avkoda hjärnsignalerna från en 30-årig man till text som hade drabbats av en hjärnstamstroke 15 år tidigare.

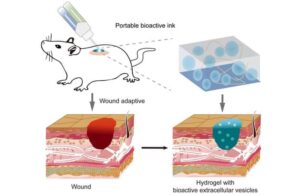

Deras senaste studie har gått ett steg längre, förverkligande av en neuroprotes som inte bara kan översätta hjärnaktivitet till full talrikdom, utan också ansiktsrörelserna som skulle åtfölja en sådan konversation. Tillsammans har dessa två världsförsta prestationer gjort det möjligt för en kvinna med svår förlamning – även resultatet av en hjärnstamstroke – att prata via en digital avatar. Talet syntetiseras via en algoritm och anpassas för att låta som hon brukade, baserat på en inspelning från innan hennes stroke.

"Vårt mål är att återställa ett fullständigt, förkroppsligat sätt att kommunicera, vilket verkligen är det mest naturliga sättet för oss att prata med andra. Dessa framsteg för oss mycket närmare att göra detta till en riktig lösning för patienter”, säger Chang i ett pressmeddelande.

Forskarnas enhet har formen av en papperstunn rektangel med 253 elektroder som de implanterade över den del av patientens hjärna som är involverad i tal. Dessa elektroder fångar upp de neurala signaler som – om det inte varit för stroken – skulle ha aktiverat muskler i hennes ansikte, käke, struphuvud och tunga.

Impulserna tolkades via djupinlärningsmodeller som tränades under flera veckor genom att patienten fick upprepa olika fraser från en 1024-ords vokabulär. Istället för att lära sig enskilda ord, verkade systemen istället på fonem – de mindre underenheterna av tal som är analoga med bokstäver i det skrivna ordet.

Teamet fann att AI-systemet bara behövde lära sig 39 fonem för att dechiffrera vilket ord som helst på engelska – vilket gör att det kan arbeta med 78 ord per minut (wpm), en betydande förbättring jämfört med alternativ som ögonblickssystem (vanligtvis tenderar människor att att tala vid cirka 110–150 wpm; ögonblicksenheter tenderar att endast möjliggöra 5–15 wpm.)

Systemet samlade fem gånger färre fel än det tidigare toppmoderna gränssnittet vid avkodning av tal – med endast en 4.9 % ordfelfrekvens vid avkodning av meningar från en 50-frasuppsättning – även om detta ökade till en 25 % felfrekvens med ett stort ordförråd på över 1000 ord. När den syntetiska röstutgången användes, påträffades en ordfelfrekvens på 28 % med en uppsättning av 529 fraser.

Förste författare Sean Metzger, en bioingenjör vid UCSF, säger: "Noggrannheten, hastigheten och ordförrådet är avgörande. Det är det som ger en användare potentialen att med tiden kommunicera nästan lika snabbt som vi gör och att ha mycket mer naturalistiska och normala konversationer.”

I själva verket, konstaterar forskarna, kan den digitala avataren röra sin käke, läppar och tunga och återge en mängd olika uttryck, inklusive lycka, sorg och överraskning. "När försökspersonen först använde det här systemet för att tala och flytta avatarens ansikte samtidigt, visste jag att detta skulle bli något som skulle ha en verklig inverkan", säger UCSF-student. Kaylo Littlejohn.

För närvarande behöver patienten vara direkt ansluten till hjärn-dator-gränssnittet. För framtiden arbetar teamet dock med att utveckla en trådlös version.

Medan Chang och hans team avkodade tal från ett stort antal celler över hela talbarken med hjälp av en stor uppsättning elektroder, neurokirurg Jaimie Henderson från Stanford University och hans kollegor tog ett annat tillvägagångssätt - att bara fästa fyra små sensorer, som var och en innehåller en kvadratisk uppsättning av 64 elektroder, i två talrelaterade hjärnregioner hos en patient med amyotrofisk lateralskleros (ALS).

Mottagaren är Pat Bennett, en före detta HR-direktör som fick diagnosen den progressiva neurodegenerativa sjukdomen 2012. Medan ALS ofta först manifesterar sig i kroppens periferi som ett resultat av försämring av ryggmärgen, började tillståndet för Bennett i hennes hjärnstammar, vilket gör att hon fortfarande kan utföra många uppgifter men inte kan använda musklerna i hennes läppar, tunga, struphuvud och käkar för att tala tydligt.

Hjärna-dator-gränssnitt: skräddarsy neuroteknik för att förbättra patienternas liv

Fyra månader och 25 fyra timmar långa AI-träningspass senare omvandlas Bennetts tänkta tal till ord på en datorskärm med en hastighet av 62 wpm. När det var begränsat till ett ordförråd på 50 ord var systemets felfrekvens 9.1 %, vilket ökade till endast 23.8 % med ett omfattande ordförråd på 125,000 XNUMX ord.

"Vi har visat att du kan avkoda avsett tal genom att spela in aktivitet från ett mycket litet område på hjärnans yta", avslutar Henderson.

Sumner Norman – berättar en biologisk ingenjör vid California Institute of Technology som inte var inblandad i de två studierna Fysikvärlden att dessa framsteg är "en tour de force i teknisk och klinisk excellens". Han tillade att båda studierna är en "underbar demonstration" av hur neuroteknologier kan återställa funktionsförmågan för den oförhindrade.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://physicsworld.com/a/high-performance-brain-implants-restore-communication-to-those-who-cannot-speak/

- : har

- :är

- :inte

- $UPP

- 000

- 125

- 15 år

- 15%

- 160

- 2012

- 23

- 25

- 39

- 9

- a

- förmåga

- Able

- åtfölja

- prestationer

- noggrannhet

- exakt

- tvärs

- aktivitet

- lagt till

- framsteg

- framsteg

- AI

- algoritm

- tillåts

- tillåta

- nästan

- också

- alternativ

- Även

- an

- och

- vilken som helst

- tillvägagångssätt

- ÄR

- OMRÅDE

- runt

- array

- AS

- be

- At

- försökte

- Författaren

- Avatar

- baserat

- BE

- varit

- innan

- började

- Berger

- båda

- Hjärna

- Hjärnaktivitet

- föra

- men

- by

- kalifornien

- KAN

- kan inte

- kapacitet

- Celler

- chang

- klart

- klick

- Klinisk

- närmare

- kollegor

- kommunicera

- Kommunikation

- omfattande

- dator

- datorskärm

- datorer

- tillstånd

- anslutna

- Konversation

- konversationer

- konverterad

- omvandling

- kunde

- Kurs

- avgörande

- årtionde

- Dechiffrera

- avkodning

- demonstreras

- beskriven

- utveckla

- anordning

- enheter

- olika

- digital

- direkt

- Direktör

- Sjukdom

- do

- varje

- Tidigare

- Edward

- möjliggöra

- ingrepp

- ingenjör

- Engelska

- Hela

- fel

- fel

- befintliga

- erfaren

- experimentell

- uttryck

- Ansikte

- ansikts

- Faktum

- SNABB

- snabbare

- färre

- Förnamn

- fem

- För

- kraft

- formen

- Tidigare

- hittade

- Francisco

- från

- full

- fungera

- framtida

- ger

- Målet

- kommer

- borta

- hade

- Har

- he

- här

- högpresterande

- hans

- Hur ser din drömresa ut

- Men

- hr

- HTTPS

- i

- bild

- Inverkan

- förbättra

- förbättring

- in

- Inklusive

- ökat

- ökande

- individuellt

- informationen

- istället

- Institute

- avsedd

- Gränssnitt

- gränssnitt

- in

- involverade

- fråga

- IT

- DESS

- käftar

- jpg

- bara

- Large

- större

- senare

- senaste

- språng

- LÄRA SIG

- inlärning

- lämnar

- tycka om

- levande

- Framställning

- många

- max-bredd

- modeller

- månader

- mer

- mest

- flytta

- rörelser

- mycket

- Natural

- Natur

- behövs

- behov

- neurala

- Noah

- normala

- antal

- of

- Ofta

- on

- endast

- öppet

- driva

- drivs

- Övrigt

- produktion

- över

- papper

- Patienten

- patienter

- Personer

- Utföra

- personlig

- fraser

- Fysik

- Fysikvärlden

- plato

- Platon Data Intelligence

- PlatonData

- möjlig

- potentiell

- presentera

- tryck

- föregående

- progressiv

- Betygsätta

- snarare

- verklig

- verkligen

- senaste

- inspelning

- region

- regioner

- upprepa

- forskning

- forskare

- återställa

- begränsad

- resultera

- San

- San Francisco

- säger

- screen

- sensor

- session

- sessioner

- in

- flera

- svår

- hon

- visas

- signaler

- signifikant

- Small

- mindre

- lösning

- något

- ljud

- tala

- tal

- fart

- kvadrat

- stanford

- Stanford University

- state-of-the-art

- .

- stammen

- Steg

- Steve

- Fortfarande

- student

- studier

- Läsa på

- ämne

- sådana

- yta

- överraskning

- syntetisk

- system

- System

- tar

- Diskussion

- Tandem

- uppgifter

- grupp

- Teknisk

- Tekniken

- Teknologi

- berättar

- text

- än

- den där

- Smakämnen

- Framtiden

- Dessa

- de

- detta

- de

- miniatyr

- tid

- gånger

- till

- tillsammans

- tog

- Tour

- tränad

- Översätt

- sann

- två

- typiskt

- oförmögen

- universitet

- University of California

- us

- användning

- Begagnade

- Användare

- med hjälp av

- mängd

- version

- mycket

- via

- Röst

- var

- Sätt..

- we

- veckor

- były

- Vad

- när

- som

- medan

- VEM

- trådlös

- med

- kvinna

- ord

- ord

- Arbete

- arbetssätt

- världen

- skulle

- skriven

- år

- Om er

- zephyrnet