I den dynamiska världen av streaming på Amazon Music, varje sökning efter en låt, podcast eller spellista innehåller en historia, en stämning eller en flod av känslor som väntar på att avslöjas. Dessa sökningar fungerar som en inkörsport till nya upptäckter, omhuldade upplevelser och bestående minnen. Sökfältet handlar inte bara om att hitta en låt; det handlar om de miljontals aktiva användare som börjar sin personliga resa in i den rika och mångfaldiga värld som Amazon Music har att erbjuda.

Att leverera en överlägsen kundupplevelse för att omedelbart hitta musiken som användare söker efter kräver en plattform som är både smart och lyhörd. Amazon Music använder kraften hos AI för att åstadkomma detta. Det är dock svårt att optimera kundupplevelsen samtidigt som kostnaderna för utbildning och slutledning av AI-modeller som driver sökfältets möjligheter, som stavningskontroll och vektorsökning i realtid, svårt under högtrafik.

Amazon SageMaker tillhandahåller en komplett uppsättning tjänster som gör att Amazon Music kan bygga, träna och distribuera på AWS-molnet med minimal ansträngning. Genom att ta hand om de odifferentierade tunga lyften låter SageMaker dig fokusera på att arbeta med dina maskininlärningsmodeller (ML) och inte oroa dig för saker som infrastruktur. Som en del av modellen för delat ansvar ser SageMaker till att tjänsterna de tillhandahåller är tillförlitliga, prestanda och skalbara, samtidigt som du ser till att tillämpningen av ML-modellerna utnyttjar de möjligheter som SageMaker tillhandahåller på bästa sätt.

I det här inlägget går vi igenom resan Amazon Music tog för att optimera prestanda och kostnader med SageMaker och NVIDIA Triton Inference Server och TensorRT. Vi dyker djupt ner i att visa hur den till synes enkla, men ändå intrikata sökfältet fungerar, vilket säkerställer en obruten resa in i Amazon Musics universum med lite till noll frustrerande stavfelsförseningar och relevanta sökresultat i realtid.

Amazon SageMaker och NVIDIA: Levererar snabb och exakt vektorsökning och stavningskontroll

Amazon Music erbjuder ett stort bibliotek med över 100 miljoner låtar och miljontals poddavsnitt. Det kan dock vara svårt att hitta rätt låt eller podcast, särskilt om du inte känner till den exakta titeln, artisten eller albumnamnet, eller om sökfrågan är väldigt bred, till exempel "nyhetspoddsändningar".

Amazon Music har tagit ett tvådelat tillvägagångssätt för att förbättra sök- och hämtningsprocessen. Det första steget är att introducera vektorsökning (även känd som inbäddningsbaserad hämtning), en ML-teknik som kan hjälpa användare att hitta det mest relevanta innehållet de letar efter genom att använda semantik för innehållet. Det andra steget innebär att introducera en transformatorbaserad stavningskorrigeringsmodell i sökstacken. Detta kan vara särskilt användbart när du söker efter musik, eftersom användare kanske inte alltid vet den exakta stavningen av en låttitel eller artistnamn. Stavningskorrigering kan hjälpa användare att hitta den musik de letar efter även om de gör ett stavfel i sin sökfråga.

Att introducera transformatormodeller i en sök- och hämtningspipeline (i fråga om inbäddningsgenerering som behövs för vektorsökning och den generativa Seq2Seq Transformer-modellen i stavningskorrigering) kan leda till en betydande ökning av den totala latensen, vilket påverkar kundupplevelsen negativt. Därför blev det en högsta prioritet för oss att optimera inferensfördröjningen i realtid för modeller för vektorsökning och stavningskorrigering.

Amazon Music och NVIDIA har gått samman för att ge den bästa möjliga kundupplevelsen till sökfältet, genom att använda SageMaker för att implementera både snabba och exakta stavningskontrollfunktioner och semantiska sökförslag i realtid med vektorsökningsbaserade tekniker. Lösningen inkluderar användning av SageMaker-värd som drivs av G5-instanser som använder NVIDIA A10G Tensor Core GPU, SageMaker-stödda NVIDIA Triton Inference Server Container och NVIDIA TensorRT modellformat. Genom att minska inferensfördröjningen för stavningskontrollmodellen till 25 millisekunder vid topptrafik, och minska inbäddningsfördröjningen för sökfrågor med 63 % i genomsnitt och kostnaden med 73 % jämfört med CPU-baserad slutledning, har Amazon Music höjt sökfältets prestanda.

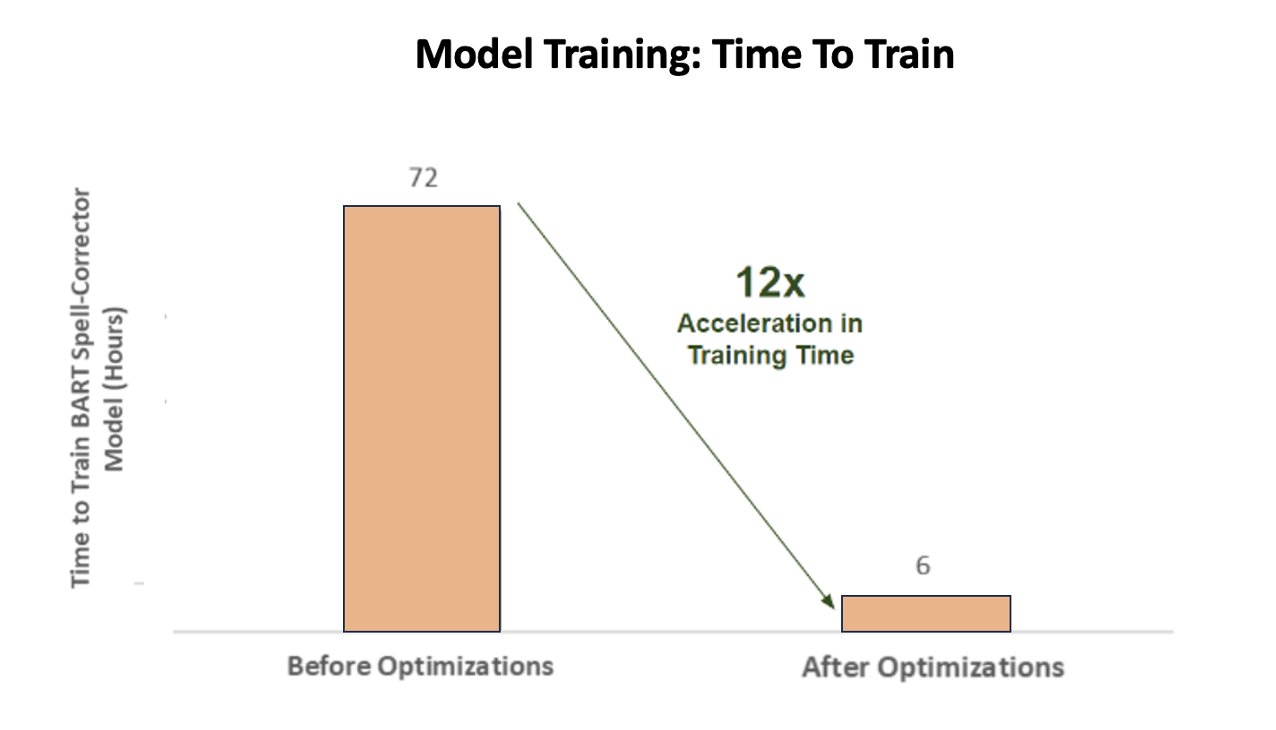

Dessutom, när man tränade AI-modellen för att leverera exakta resultat, uppnådde Amazon Music en enorm 12-faldig acceleration i träningstid för sin BART-sekvens-till-sekvens-stavningskorrigeringsmodell, vilket sparade både tid och pengar genom att optimera deras GPU-användning.

Amazon Music samarbetade med NVIDIA för att prioritera kundsökningsupplevelsen och skapa ett sökfält med väloptimerad stavningskontroll och vektorsökfunktioner. I de följande avsnitten delar vi mer om hur dessa optimeringar organiserades.

Optimera träning med NVIDIA Tensor Core GPU:er

Att få tillgång till en NVIDIA Tensor Core GPU för utbildning i stora språkmodeller är inte tillräckligt för att fånga dess verkliga potential. Det finns viktiga optimeringssteg som måste ske under träning för att fullt ut maximera GPU:ns utnyttjande. Men en underutnyttjad GPU kommer utan tvekan att leda till ineffektiv användning av resurser, förlängd utbildningstid och ökade driftskostnader.

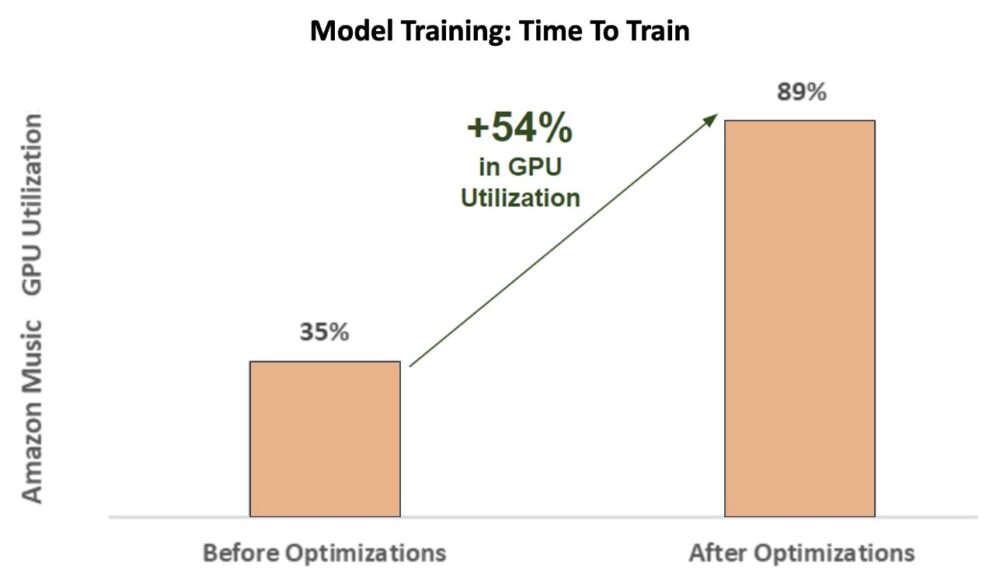

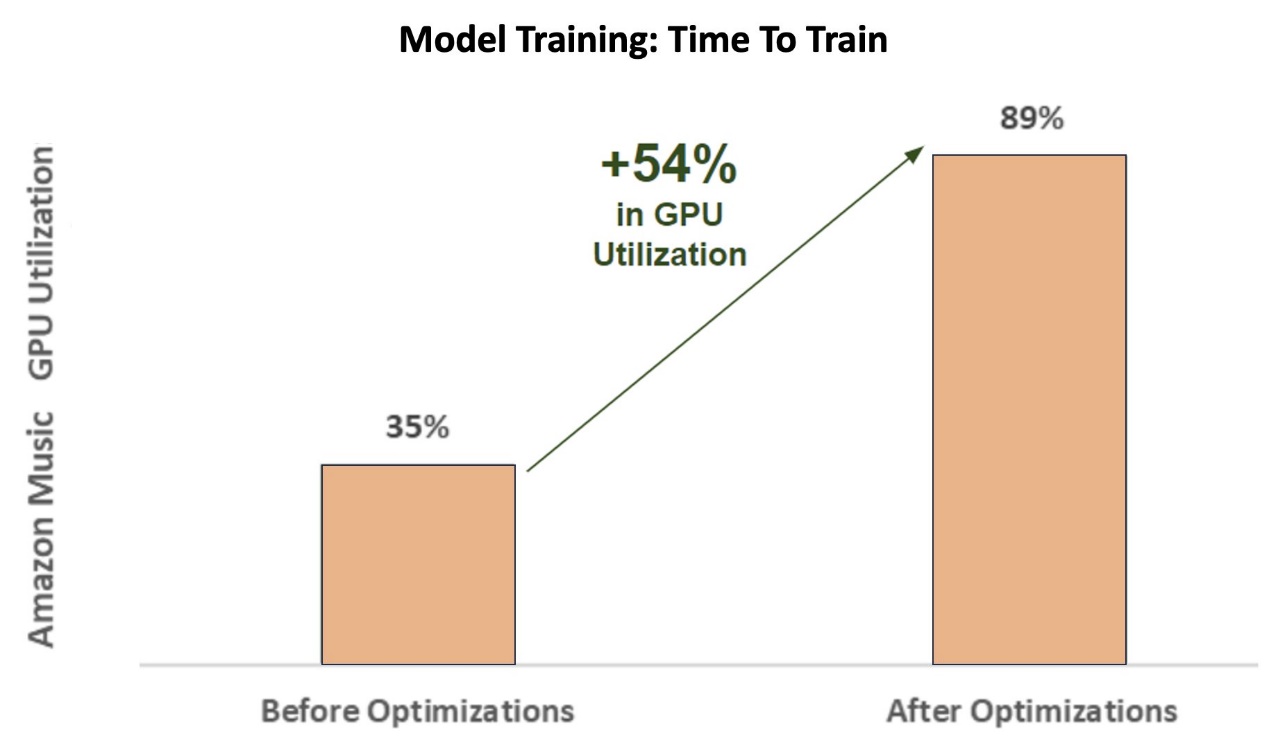

Under de inledande faserna av träningen stavningskorrigeraren BART (bart-bas) transformatormodell på en SageMaker ml.p3.24xlarge-instans (8 NVIDIA V100 Tensor Core GPUs), Amazon Musics GPU-användning var cirka 35 %. För att maximera fördelarna med NVIDIA GPU-accelererad utbildning, stödde AWS- och NVIDIA-lösningsarkitekter Amazon Music för att identifiera områden för optimeringar, särskilt kring batchstorlek och precisionsparametrar. Dessa två avgörande parametrar påverkar effektiviteten, hastigheten och noggrannheten i träningsmodeller för djupinlärning.

De resulterande optimeringarna gav en ny och förbättrad V100 GPU-användning, stabil på cirka 89 %, vilket drastiskt minskade Amazon Musics träningstid från 3 dagar till 5–6 timmar. Genom att byta batchstorlek från 32 till 256 och använda optimeringstekniker som att köra automatisk blandad precisionsträning istället för att bara använda FP32-precision kunde Amazon Music spara både tid och pengar.

Följande diagram illustrerar ökningen med 54 % i procentenheter i GPU-användning efter optimeringar.

Följande figur illustrerar accelerationen i träningstid.

Denna ökning av batchstorlek gjorde det möjligt för NVIDIA GPU att behandla betydligt mer data samtidigt över flera Tensor Cores, vilket resulterade i accelererad träningstid. Det är dock viktigt att upprätthålla en känslig balans med minnet, eftersom större batchstorlekar kräver mer minne. Både att öka batchstorleken och använda blandad precision kan vara avgörande för att låsa upp kraften hos NVIDIA Tensor Core GPU:er.

Efter att modellen tränats för att konvergens, var det dags att optimera för slutledningsdistribution på Amazon Musics sökfält.

Stavningskorrigering: BART-modell slutledning

Med hjälp av SageMaker G5-instanser och NVIDIA Triton Inference Server (en mjukvara för öppen källkod), samt NVIDIA TensorRT, en SDK för högpresterande djupinlärningsinferens som inkluderar en slutledningsoptimerare och körtid, begränsar Amazon Music deras stavningskontroll BART (bart-bas) modellserverns slutledningsfördröjning till bara 25 millisekunder vid topptrafik. Detta inkluderar omkostnader som lastbalansering, förbearbetning, modellinferens och efterbearbetningstider.

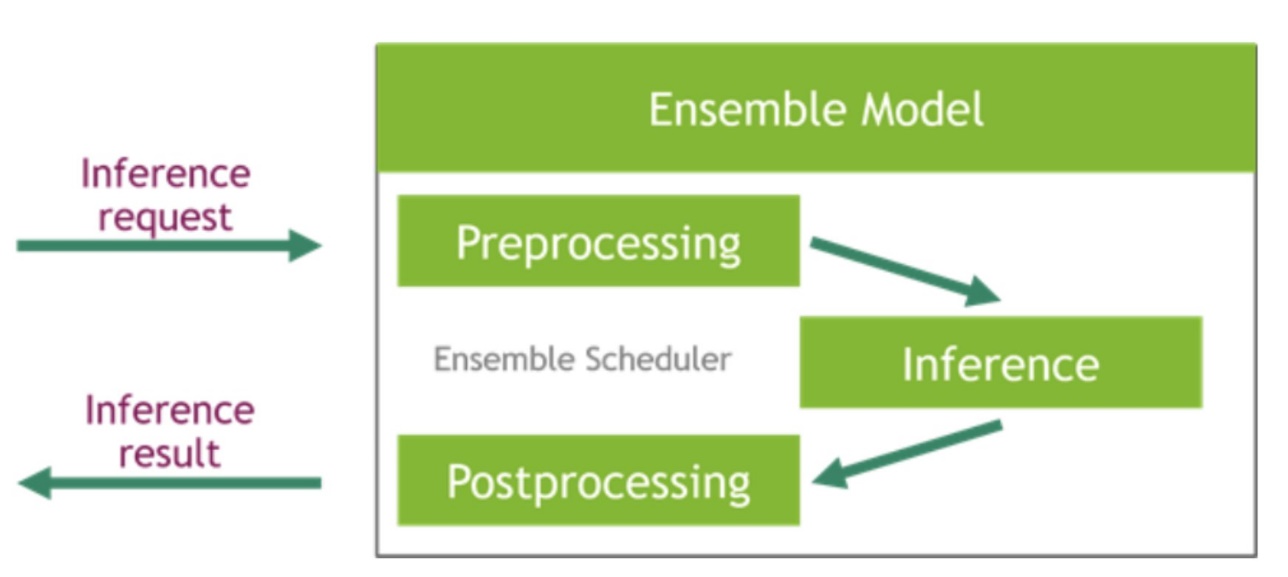

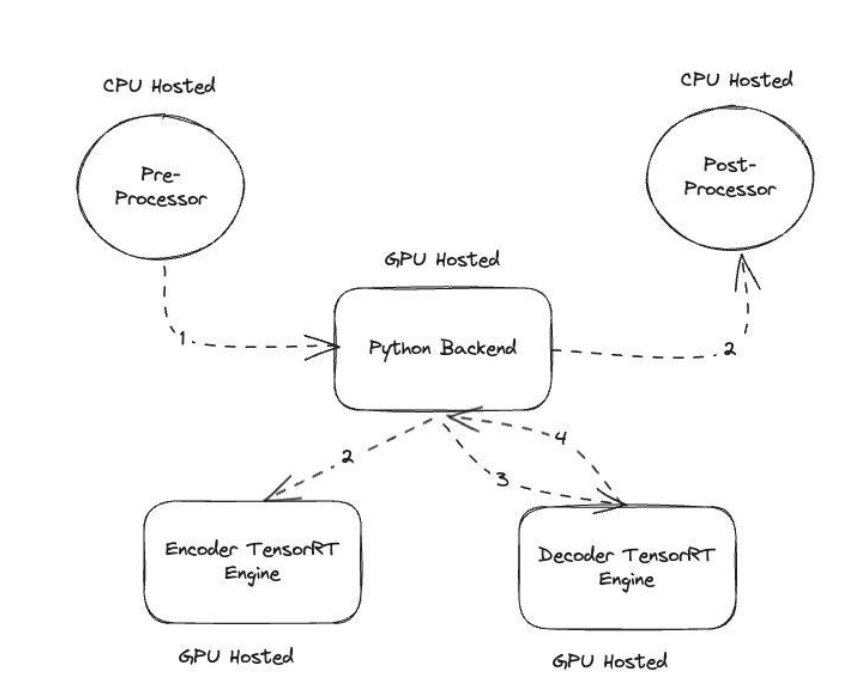

NVIDIA Triton Inference Server tillhandahåller två olika typer av backends: en för värdmodeller på GPU och en Python-backend där du kan ta med din egen anpassade kod som ska användas i förbearbetnings- och efterbearbetningsstegen. Följande figur illustrerar modellensembleschema.

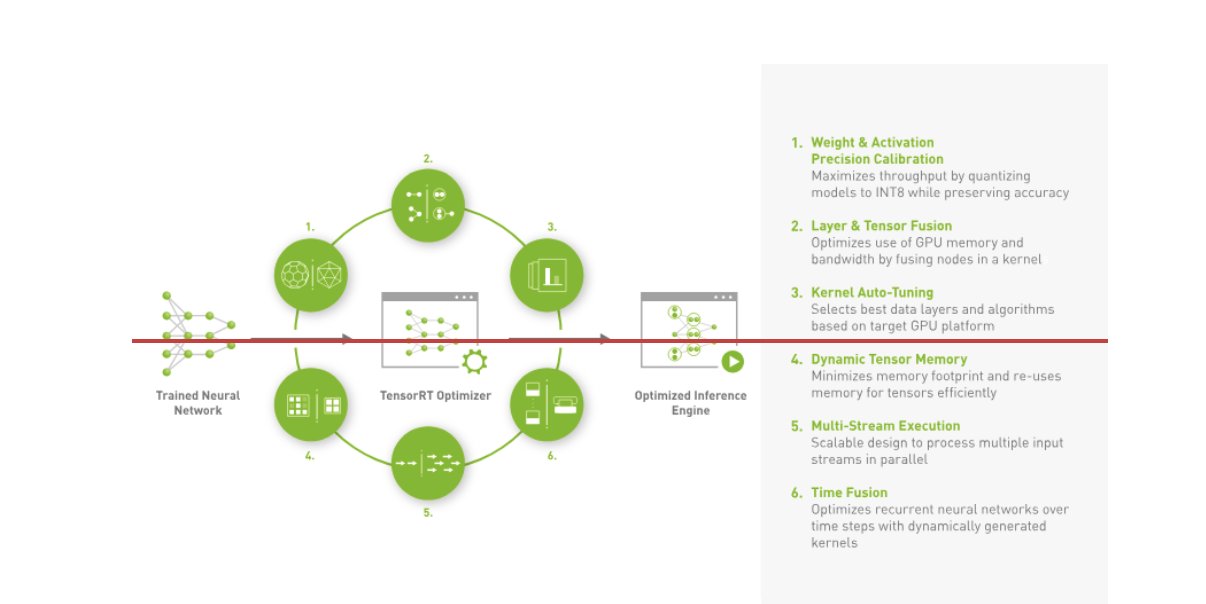

Amazon Music byggde sin BART slutledningspipeline genom att köra både förbearbetnings- (texttokenisering) och efterbearbetningssteg (tokens till text) på CPU:er, medan modellexekveringssteget körs på NVIDIA A10G Tensor Core GPU:er. En Python-backend sitter i mitten av förbearbetnings- och efterbearbetningsstegen och ansvarar för att kommunicera med de TensorRT-konverterade BART-modellerna samt kodar-/avkodarnätverken. TensorRT ökar inferensprestandan med precisionskalibrering, lager- och tensorfusion, kärnautojustering, dynamiskt tensorminne, multiströmskörning och tidsfusion.

Följande figur illustrerar högnivådesignen av nyckelmodulerna som utgör stavningskorrigerarens BART-modell slutledningspipeline.

Vektorsökning: Fråga inbäddning av generationssats BERT-modellinferencing

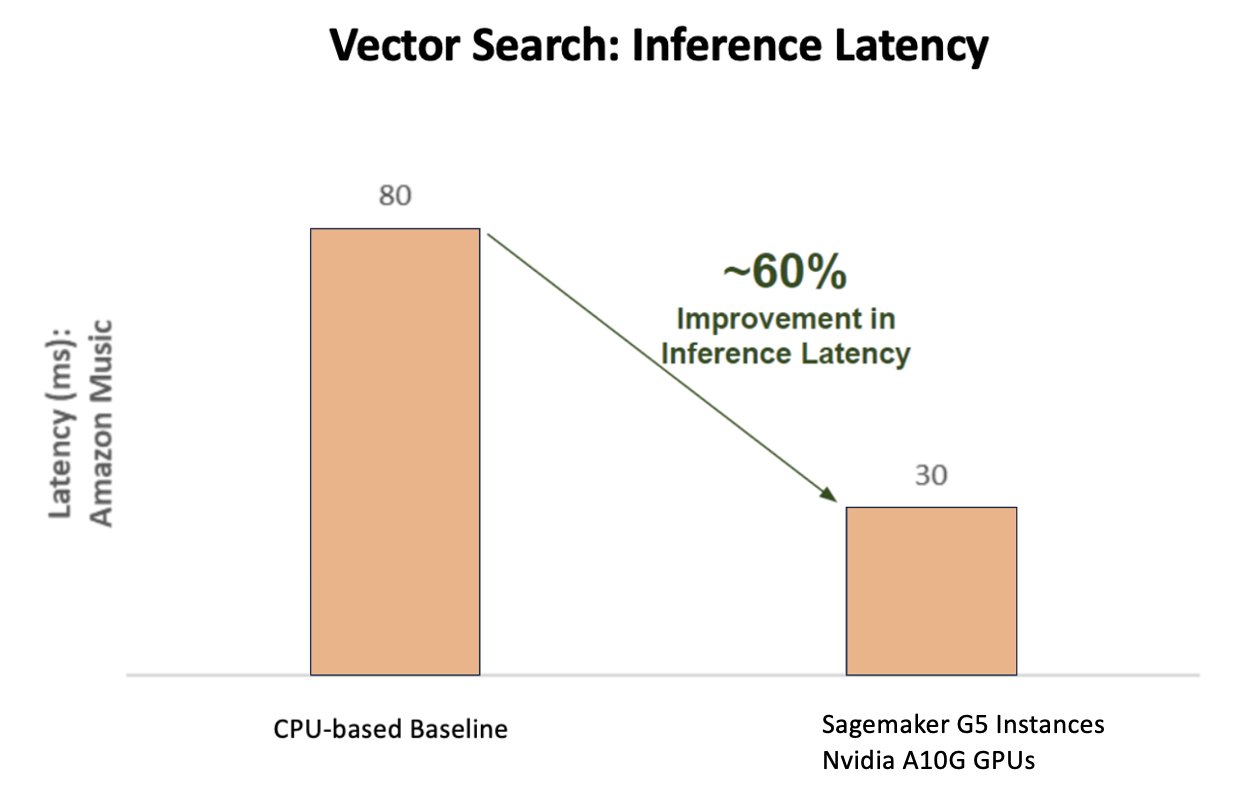

Följande diagram illustrerar 60 % förbättring i latens (som tjänar p90 800–900 TPS) när du använder NVIDIA AI Inference Platform jämfört med en CPU-baserad baslinje.

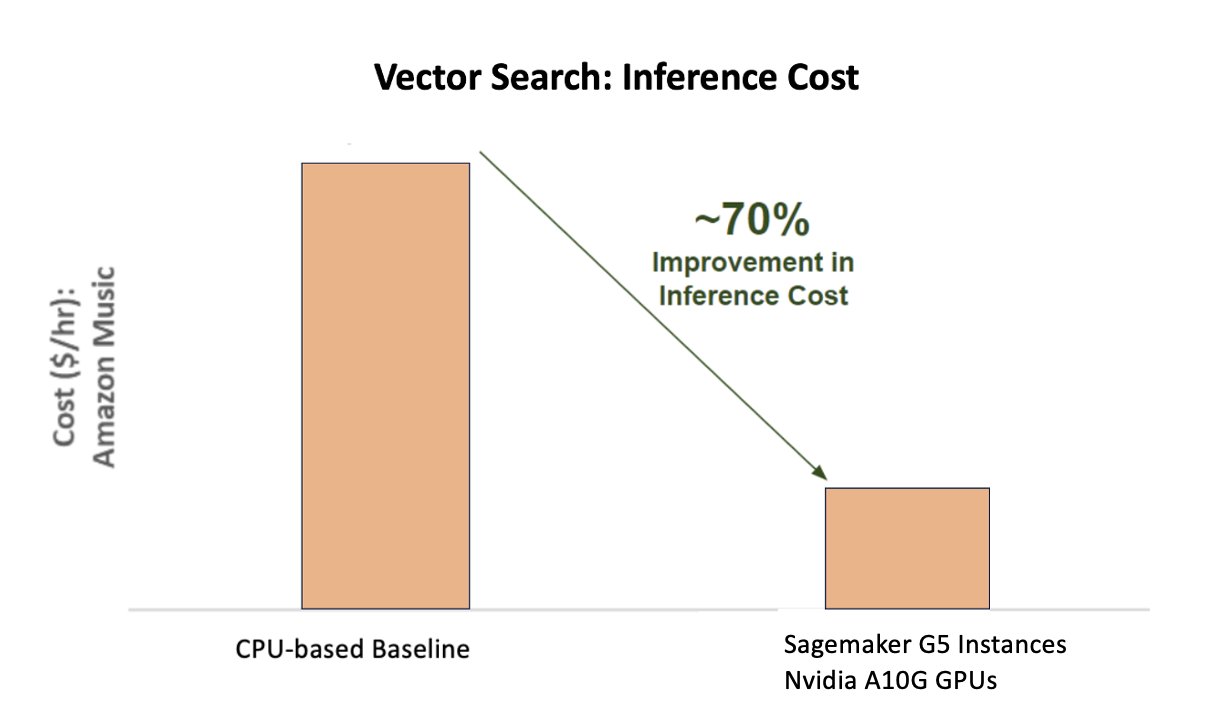

Följande diagram visar en kostnadsförbättring på 70 % när du använder NVIDIA AI Inference Platform jämfört med en CPU-baserad baslinje.

Följande figur illustrerar en SDK för högpresterande djupinlärningsinferens. Den inkluderar en djupinlärningsinferensoptimerare och körtid som ger låg latens och hög genomströmning för inferensapplikationer.

För att uppnå dessa resultat experimenterade Amazon Music med flera olika Triton-implementeringsparametrar med hjälp av Triton modellanalysator, ett verktyg som hjälper till att hitta den bästa NVIDIA Triton-modellkonfigurationen för att distribuera effektiv slutledning. För att optimera modellinferens erbjuder Triton funktioner som dynamisk batchning och samtidig modellexekvering, och har ramstöd för andra flexibilitetsmöjligheter. Den dynamiska batchningen samlar inferensförfrågningar och grupperar dem sömlöst i kohorter för att maximera genomströmningen, allt samtidigt som man säkerställer realtidssvar för Amazon Music-användare. Möjligheten för samtidig modellexekvering förbättrar inferensprestandan ytterligare genom att lagra flera kopior av modellen på samma GPU. Slutligen, genom att använda Triton modellanalysator, kunde Amazon Music noggrant finjustera den dynamiska batchningen och modellera parametrarna för samtidighetsinferensvärd för att hitta optimala inställningar som maximerar slutledningsprestanda med hjälp av simulerad trafik.

Slutsats

Genom att optimera konfigurationer med Triton Inference Server och TensorRT på SageMaker kunde Amazon Music uppnå enastående resultat för både tränings- och slutledningspipelines. SageMaker-plattformen är den heltäckande öppna plattformen för produktions-AI, som ger snabb tid till värde och mångsidighet för att stödja alla större AI-användningsfall för både hårdvara och mjukvara. Genom att optimera V100 GPU-användningen för träning och byte från CPU:er till G5-instanser med hjälp av NVIDIA A10G Tensor Core GPU:er, samt genom att använda optimerad NVIDIA-mjukvara som Triton Inference Server och TensorRT, kan företag som Amazon Music spara tid och pengar samtidigt som de ökar prestanda i båda utbildning och slutsatser, direkt översatt till en bättre kundupplevelse och lägre driftskostnader.

SageMaker hanterar de odifferentierade tunga lyften för ML-träning och hosting, vilket gör att Amazon Music kan leverera pålitliga, skalbara ML-operationer över både hårdvara och mjukvara.

Vi uppmuntrar dig att kontrollera att dina arbetsbelastningar är optimerade med SageMaker genom att alltid utvärdera dina val av hårdvara och mjukvara för att se om det finns sätt att uppnå bättre prestanda med minskade kostnader.

För att lära dig mer om NVIDIA AI i AWS, se följande:

Om författarna

Siddharth Sharma är en maskininlärningsteknikledare på Science & Modeling-teamet på Amazon Music. Han är specialiserad på sökning, hämtning, rankning och NLP-relaterade modelleringsproblem. Siddharth har en rik bakgrund som arbetar med storskaliga maskininlärningsproblem som är latenskänsliga, t.ex. annonsinriktning, multimodal hämtning, sökfrågeförståelse etc. Innan Siddharth arbetade på Amazon Music, arbetade Siddharth på företag som Meta, Walmart Labs, Rakuten om e-handelscentrerade ML-problem. Siddharth tillbringade tidiga delar av sin karriär med att arbeta med bay area ad-tech startups.

Siddharth Sharma är en maskininlärningsteknikledare på Science & Modeling-teamet på Amazon Music. Han är specialiserad på sökning, hämtning, rankning och NLP-relaterade modelleringsproblem. Siddharth har en rik bakgrund som arbetar med storskaliga maskininlärningsproblem som är latenskänsliga, t.ex. annonsinriktning, multimodal hämtning, sökfrågeförståelse etc. Innan Siddharth arbetade på Amazon Music, arbetade Siddharth på företag som Meta, Walmart Labs, Rakuten om e-handelscentrerade ML-problem. Siddharth tillbringade tidiga delar av sin karriär med att arbeta med bay area ad-tech startups.

Tarun Sharma är en Software Development Manager som leder Amazon Music Search Relevance. Hans team av forskare och ML-ingenjörer ansvarar för att tillhandahålla kontextuellt relevanta och personliga sökresultat till Amazon Music-kunder.

Tarun Sharma är en Software Development Manager som leder Amazon Music Search Relevance. Hans team av forskare och ML-ingenjörer ansvarar för att tillhandahålla kontextuellt relevanta och personliga sökresultat till Amazon Music-kunder.

James Park är en lösningsarkitekt på Amazon Web Services. Han arbetar med Amazon.com för att designa, bygga och distribuera tekniklösningar på AWS och har ett särskilt intresse för AI och maskininlärning. På fritiden tycker han om att söka nya kulturer, nya upplevelser och att hålla sig uppdaterad med de senaste tekniktrenderna. Du kan hitta honom på LinkedIn.

James Park är en lösningsarkitekt på Amazon Web Services. Han arbetar med Amazon.com för att designa, bygga och distribuera tekniklösningar på AWS och har ett särskilt intresse för AI och maskininlärning. På fritiden tycker han om att söka nya kulturer, nya upplevelser och att hålla sig uppdaterad med de senaste tekniktrenderna. Du kan hitta honom på LinkedIn.

Kshitiz Gupta är lösningsarkitekt på NVIDIA. Han tycker om att utbilda molnkunder om GPU AI-teknikerna NVIDIA har att erbjuda och hjälpa dem med att accelerera deras maskininlärning och djupinlärning. Utanför jobbet tycker han om att springa, vandra och titta på vilda djur.

Kshitiz Gupta är lösningsarkitekt på NVIDIA. Han tycker om att utbilda molnkunder om GPU AI-teknikerna NVIDIA har att erbjuda och hjälpa dem med att accelerera deras maskininlärning och djupinlärning. Utanför jobbet tycker han om att springa, vandra och titta på vilda djur.

Jiahong Liu är en lösningsarkitekt på Cloud Service Provider-teamet på NVIDIA. Han hjälper kunder att ta till sig maskininlärning och AI-lösningar som utnyttjar NVIDIAs accelererade datoranvändning för att hantera deras utbildnings- och slutledningsutmaningar. På sin fritid tycker han om origami, gör-det-själv-projekt och att spela basket.

Jiahong Liu är en lösningsarkitekt på Cloud Service Provider-teamet på NVIDIA. Han hjälper kunder att ta till sig maskininlärning och AI-lösningar som utnyttjar NVIDIAs accelererade datoranvändning för att hantera deras utbildnings- och slutledningsutmaningar. På sin fritid tycker han om origami, gör-det-själv-projekt och att spela basket.

Tugrul Konuk är senior lösningsarkitekt på NVIDIA, specialiserad på storskalig utbildning, multimodal djupinlärning och högpresterande vetenskaplig datoranvändning. Före NVIDIA arbetade han inom energibranschen med fokus på att utveckla algoritmer för beräkningsavbildning. Som en del av sin doktorsexamen arbetade han med fysikbaserad djupinlärning för numeriska simuleringar i stor skala. På fritiden tycker han om att läsa, spela gitarr och piano.

Tugrul Konuk är senior lösningsarkitekt på NVIDIA, specialiserad på storskalig utbildning, multimodal djupinlärning och högpresterande vetenskaplig datoranvändning. Före NVIDIA arbetade han inom energibranschen med fokus på att utveckla algoritmer för beräkningsavbildning. Som en del av sin doktorsexamen arbetade han med fysikbaserad djupinlärning för numeriska simuleringar i stor skala. På fritiden tycker han om att läsa, spela gitarr och piano.

Rohil Bhargava är en produktmarknadschef på NVIDIA, fokuserad på att distribuera NVIDIA-applikationsramverk och SDK:er på specifika CSP-plattformar.

Rohil Bhargava är en produktmarknadschef på NVIDIA, fokuserad på att distribuera NVIDIA-applikationsramverk och SDK:er på specifika CSP-plattformar.

Eliuth Triana Isaza är en Developer Relations Manager på NVIDIA som ger Amazons AI MLOps, DevOps, Scientists och AWS tekniska experter möjlighet att bemästra NVIDIAs datorstack för att accelerera och optimera Generative AI Foundation-modeller som sträcker sig från datakurering, GPU-utbildning, modellinferens och produktionsinstallation på AWS GPU-instanser . Dessutom är Eliuth en passionerad mountainbike-, skid-, tennis- och pokerspelare.

Eliuth Triana Isaza är en Developer Relations Manager på NVIDIA som ger Amazons AI MLOps, DevOps, Scientists och AWS tekniska experter möjlighet att bemästra NVIDIAs datorstack för att accelerera och optimera Generative AI Foundation-modeller som sträcker sig från datakurering, GPU-utbildning, modellinferens och produktionsinstallation på AWS GPU-instanser . Dessutom är Eliuth en passionerad mountainbike-, skid-, tennis- och pokerspelare.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://aws.amazon.com/blogs/machine-learning/how-amazon-music-uses-sagemaker-with-nvidia-to-optimize-ml-training-and-inference-performance-and-cost/

- : har

- :är

- :inte

- :var

- $UPP

- 100

- 12

- 25

- 32

- 35%

- 7

- 8

- a

- Able

- Om Oss

- accelererad

- accelererande

- acceleration

- tillgång

- åstadkomma

- noggrannhet

- exakt

- Uppnå

- uppnås

- tvärs

- aktiv

- Dessutom

- adress

- Anta

- annonser

- påverkar

- Efter

- AI

- AI-modeller

- ai användningsfall

- Album

- algoritmer

- Alla

- tillåter

- tillåts

- tillåta

- tillåter

- också

- alltid

- amason

- Amazon Web Services

- Amazon.com

- an

- och

- Ansökan

- tillämpningar

- tillvägagångssätt

- arkitekter

- ÄR

- OMRÅDE

- områden

- runt

- konstnär

- AS

- bistå

- assist

- At

- genomsnitt

- AWS

- backend

- Balansera

- balansering

- bar

- baserat

- Baslinje

- Basketboll

- bukt

- BE

- blev

- därför att

- Fördelarna

- BÄST

- Bättre

- öka

- boostar

- båda

- föra

- bred

- SLUTRESULTAT

- byggt

- by

- KAN

- kapacitet

- kapacitet

- fånga

- vilken

- Karriär

- försiktigt

- fall

- utmaningar

- utmanande

- Diagram

- ta

- omhuldade

- val

- klienter

- cloud

- koda

- COM

- komma

- kommunicera

- Företag

- jämfört

- beräkningar

- databehandling

- konkurrent

- konfiguration

- Behållare

- innehåll

- Konvergens

- Kärna

- Pris

- Kostar

- farkoster

- kritisk

- avgörande

- CSP

- curation

- beställnings

- kund

- kundupplevelse

- Kunder

- datum

- Datum

- Dagar

- minskade

- djup

- djupt lärande

- fördröjningar

- leverera

- leverera

- levererar

- Efterfrågan

- distribuera

- utplacera

- utplacering

- Designa

- Utvecklare

- utveckla

- Utveckling

- olika

- svårt

- direkt

- Dyk

- flera

- diy

- inte

- drastiskt

- under

- dynamisk

- e

- e-handel

- Tidig

- utbilda

- effektivitet

- effektiv

- ansträngning

- förhöjd

- inbäddning

- känslor

- utnyttjande

- ge

- aktiverad

- uppmuntra

- början till slut

- energi

- Ingenjörer

- Förbättrar

- tillräckligt

- säkerställa

- speciellt

- etc

- utvärdering

- Även

- Varje

- utförande

- erfarenhet

- Erfarenheter

- experter

- SNABB

- Funktioner

- Figur

- Slutligen

- hitta

- finna

- Förnamn

- Flexibilitet

- översvämning

- Fokus

- fokuserade

- fokusering

- efter

- För

- format

- fundament

- Ramverk

- ramar

- från

- frustrerande

- fullständigt

- funktionaliteter

- ytterligare

- sammansmältning

- nätbryggan

- generering

- generativ

- Generativ AI

- GPU

- GPUs

- Handtag

- hända

- hårdvara

- Har

- he

- tung

- tunga lyft

- hjälpa

- hjälp

- hjälper

- Hög

- högnivå

- högpresterande

- honom

- hans

- innehar

- värd

- ÖPPETTIDER

- Hur ser din drömresa ut

- Men

- html

- HTTPS

- identifiera

- if

- illustrerar

- Imaging

- genomföra

- med Esport

- förbättra

- förbättras

- förbättring

- in

- innefattar

- Öka

- ökat

- ökande

- industrin

- ineffektiv

- påverka

- Infrastruktur

- inledande

- exempel

- Omedelbart

- istället

- intresse

- in

- införa

- införa

- IT

- DESS

- resa

- jpg

- bara

- Nyckel

- Snäll

- Vet

- känd

- Labs

- språk

- Large

- storskalig

- större

- bestående

- Latens

- senaste

- lager

- leda

- ledande

- LÄRA SIG

- inlärning

- Hävstång

- Bibliotek

- lyft

- tycka om

- gränser

- läsa in

- du letar

- Låg

- lägre

- Maskinen

- maskininlärning

- bibehålla

- större

- göra

- GÖR

- chef

- hantera

- Marknadsföring

- Master

- Maximera

- Maj..

- Minnen

- Minne

- meta

- Mitten

- miljon

- miljoner

- millisekunder

- minimum

- misstag

- blandad

- ML

- MLOps

- modell

- modellering

- modeller

- Moduler

- pengar

- mer

- mest

- Berg

- flera

- multipel

- Musik

- måste

- namn

- behövs

- negativt

- nätverk

- Nya

- nlp

- Nvidia

- of

- erbjudanden

- Erbjudanden

- on

- ONE

- endast

- öppet

- öppen källkod

- drift

- operativa

- Verksamhet

- optimala

- optimering

- Optimera

- optimerad

- optimera

- or

- iscensatt

- beställa

- Övriga

- ut

- utanför

- utestående

- över

- övergripande

- egen

- parametrar

- del

- särskilt

- särskilt

- samarbetar

- brinner

- Topp

- procentuell

- prestanda

- personlig

- personlig

- phd

- rörledning

- plattform

- Plattformar

- plato

- Platon Data Intelligence

- PlatonData

- Spelaren

- i

- podcast

- Podcasts

- Punkt

- poker

- möjlig

- Inlägg

- potentiell

- kraft

- drivs

- Precision

- Innan

- Prioritera

- prioritet

- problem

- process

- Produkt

- Produktion

- projekt

- ge

- leverantör

- ger

- tillhandahålla

- Python

- Snabbt

- Rankning

- Läsning

- realtid

- reducerande

- hänvisa

- relaterad

- relationer

- relevans

- relevanta

- pålitlig

- förfrågningar

- Kräver

- Resurser

- svar

- ansvaret

- ansvarig

- mottaglig

- resulterande

- Resultat

- Rik

- höger

- rinnande

- kör

- runtime

- sagemaker

- Samma

- Save

- sparande

- skalbar

- Skala

- Vetenskap

- vetenskaplig

- vetenskapsmän

- sDK

- sdks

- sömlöst

- Sök

- sök

- söka

- Andra

- sektioner

- se

- söker

- till synes

- semantik

- senior

- känslig

- mening

- tjänar

- server

- service

- Leverantör

- Tjänster

- portion

- in

- inställningar

- flera

- Dela

- delas

- Visar

- signifikant

- signifikant

- Enkelt

- sitter

- Storlek

- storlekar

- smarta

- Mjukvara

- mjukvaruutveckling

- lösning

- Lösningar

- låt

- Källa

- spänning

- specialiserat

- specialiserat

- specifik

- fart

- BOKSTAVERA

- stavning

- spent

- stapel

- Starta

- Startups

- vistas

- stadig

- Steg

- Steg

- Historia

- streaming

- sådana

- överlägsen

- stödja

- Som stöds

- säker

- tagen

- tar

- targeting

- grupp

- tech

- Teknisk

- Tekniken

- tekniker

- Tekniken

- Teknologi

- text

- den där

- Smakämnen

- deras

- Dem

- Där.

- därför

- Dessa

- de

- saker

- detta

- Genom

- genomströmning

- tid

- gånger

- Titel

- till

- tillsammans

- tokenization

- tokens

- tog

- verktyg

- topp

- tps

- trafik

- Tåg

- tränad

- Utbildning

- transformator

- Trender

- Triton

- sann

- två

- förståelse

- otvivelaktigt

- Universum

- upplåsning

- avtäckt

- us

- användning

- Begagnade

- användare

- användningar

- med hjälp av

- Använda

- värde

- Omfattande

- mångsidighet

- mycket

- väntar

- gå

- Walmart

- var

- tittar

- sätt

- we

- webb

- webbservice

- VÄL

- były

- när

- medan

- medan

- kommer

- med

- Arbete

- arbetade

- arbetssätt

- fungerar

- världen

- oro

- ännu

- gav

- Om er

- Din

- zephyrnet