Detta är ett gästinlägg medförfattare av Nafi Ahmet Turgut, Hasan Burak Yel och Damla Şentürk från Getir.

Etablerat i 2015, fört har positionerat sig som banbrytare inom området för ultrasnabb matleverans. Detta innovativa teknikföretag har revolutionerat leveranssegmentet för sista milen med sitt övertygande utbud av "livsmedel på några minuter." Med närvaro i Turkiet, Storbritannien, Nederländerna, Tyskland och USA har Getir blivit en multinationell kraft att räkna med. Idag representerar varumärket Getir ett diversifierat konglomerat som omfattar nio olika vertikaler, som alla arbetar synergistiskt under ett enda paraply.

I det här inlägget förklarar vi hur vi byggde en komplett produktkategoriförutsägelsepipeline för att hjälpa kommersiella team genom att använda Amazon SageMaker och AWS-batch, vilket minskar modellutbildningens varaktighet med 90 %.

Att förstå vårt befintliga produktsortiment på ett detaljerat sätt är en avgörande utmaning som vi, tillsammans med många företag, står inför på dagens snabba och konkurrensutsatta marknad. En effektiv lösning på detta problem är förutsägelsen av produktkategorier. En modell som genererar ett omfattande kategoriträd tillåter våra kommersiella team att jämföra vår befintliga produktportfölj mot våra konkurrenters, vilket erbjuder en strategisk fördel. Därför är vår centrala utmaning att skapa och implementera en korrekt produktkategoriförutsägelsemodell.

Vi utnyttjade de kraftfulla verktyg som tillhandahålls av AWS för att tackla denna utmaning och effektivt navigera i det komplexa området maskininlärning (ML) och prediktiv analys. Våra ansträngningar ledde till det framgångsrika skapandet av en produktkategoriförutsägelsepipeline, som kombinerar styrkorna hos SageMaker och AWS Batch.

Denna förmåga med prediktiv analys, särskilt den korrekta prognosen för produktkategorier, har visat sig vara ovärderlig. Det gav våra team kritiska datadrivna insikter som optimerade lagerhantering, förbättrade kundinteraktioner och stärkte vår marknadsnärvaro.

Metoden vi förklarar i det här inlägget sträcker sig från den inledande fasen av insamling av funktioner till den slutliga implementeringen av prediktionspipelinen. En viktig aspekt av vår strategi har varit användningen av SageMaker och AWS Batch för att förfina förutbildade BERT-modeller för sju olika språk. Dessutom vår sömlösa integration med AWS:s objektlagringstjänst Amazon enkel lagringstjänst (Amazon S3) har varit nyckeln till att effektivt lagra och komma åt dessa raffinerade modeller.

SageMaker är en helt hanterad ML-tjänst. Med SageMaker kan datavetare och utvecklare snabbt och enkelt bygga och träna ML-modeller och sedan direkt distribuera dem i en produktionsklar värdmiljö.

Som en helt hanterad tjänst hjälper AWS Batch dig att köra batchberäkningar av alla skala. AWS Batch tillhandahåller automatiskt beräkningsresurser och optimerar arbetsbelastningsfördelningen baserat på kvantiteten och omfattningen av arbetsbelastningarna. Med AWS Batch finns det inget behov av att installera eller hantera batchberäkningsprogram, så du kan fokusera din tid på att analysera resultat och lösa problem. Vi använde GPU-jobb som hjälper oss att köra jobb som använder en instanss GPU:er.

Översikt över lösningen

Fem personer från Getirs datavetenskapsteam och infrastrukturteam arbetade tillsammans i detta projekt. Projektet avslutades på en månad och distribuerades till produktion efter en veckas testning.

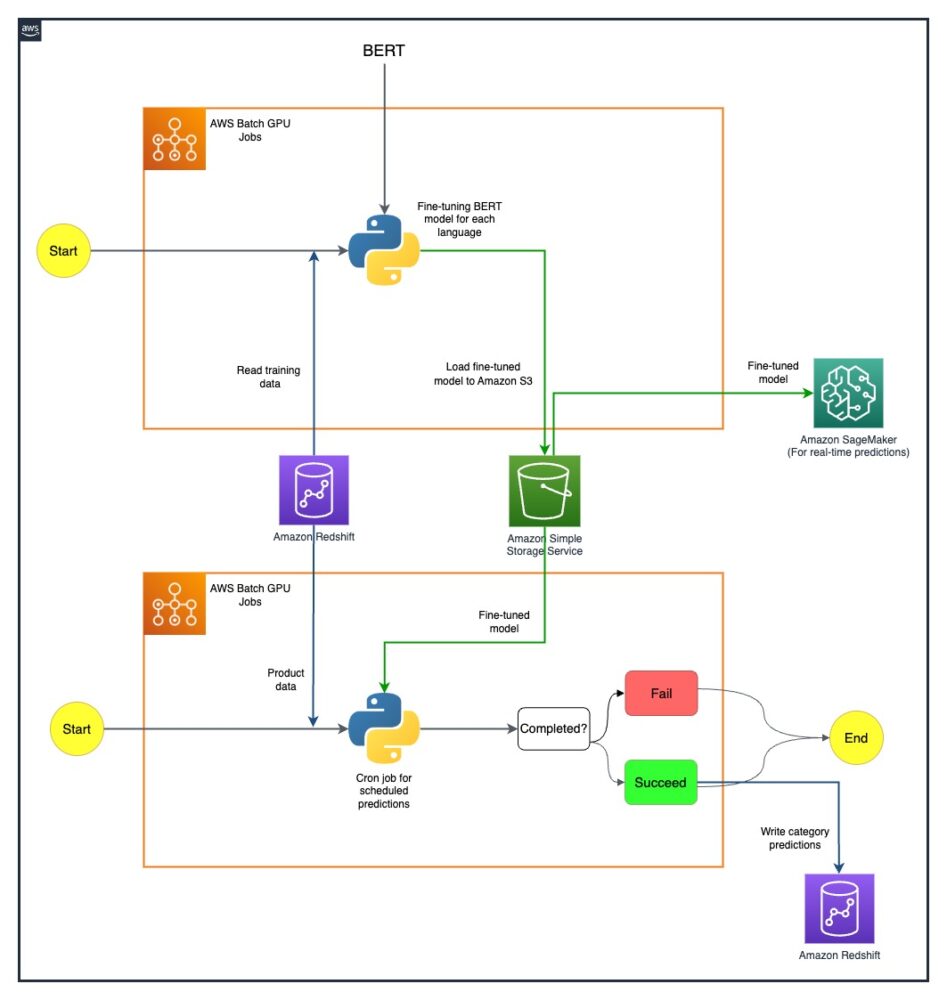

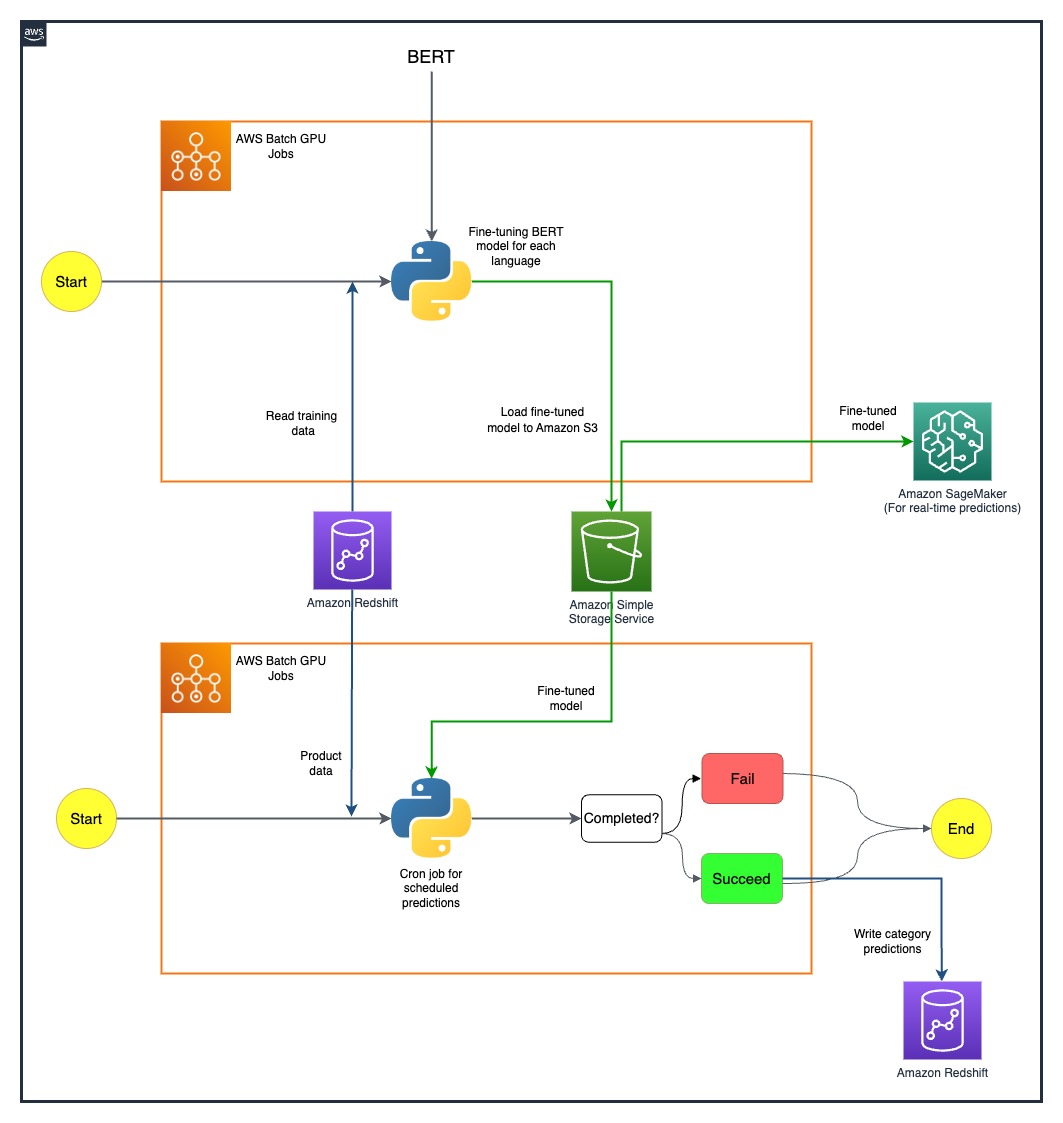

Följande diagram visar lösningens arkitektur.

Modellpipelinen körs separat för varje land. Arkitekturen inkluderar två AWS Batch GPU cron-jobb för varje land, som körs enligt definierade scheman.

Vi övervann vissa utmaningar genom att strategiskt distribuera SageMaker och AWS Batch GPU-resurser. Processen som används för att lösa varje svårighet beskrivs i följande avsnitt.

Finjustera flerspråkiga BERT-modeller med AWS Batch GPU-jobb

Vi sökte en lösning för att stödja flera språk för vår mångsidiga användarbas. BERT-modeller var ett självklart val på grund av deras etablerade förmåga att effektivt hantera komplexa naturliga språkuppgifter. För att skräddarsy dessa modeller efter våra behov, utnyttjade vi kraften i AWS genom att använda GPU-instansjobb med en nod. Detta gjorde det möjligt för oss att finjustera förtränade BERT-modeller för vart och ett av de sju språk vi behövde support för. Genom denna metod säkerställde vi hög precision i att förutsäga produktkategorier och övervinna eventuella språkbarriärer.

Effektiv modelllagring med Amazon S3

Vårt nästa steg var att ta itu med modelllagring och hantering. För detta valde vi Amazon S3, känd för sin skalbarhet och säkerhet. Genom att lagra våra finjusterade BERT-modeller på Amazon S3 kunde vi ge enkel åtkomst till olika team inom vår organisation, vilket avsevärt effektiviserade vår distributionsprocess. Detta var en avgörande aspekt för att uppnå smidighet i vår verksamhet och en sömlös integration av våra ML-insatser.

Skapa en prediktionspipeline från början till slut

En effektiv pipeline krävdes för att utnyttja våra förutbildade modeller på bästa sätt. Vi distribuerade först dessa modeller på SageMaker, en åtgärd som möjliggjorde realtidsförutsägelser med låg latens, vilket förbättrade vår användarupplevelse. För större batchförutsägelser, som var lika viktiga för vår verksamhet, använde vi AWS Batch GPU-jobb. Detta säkerställde en optimal användning av våra resurser, vilket gav oss en perfekt balans mellan prestanda och effektivitet.

Utforska framtida möjligheter med SageMaker MMEs

När vi fortsätter att utvecklas och söka effektivitet i vår ML-pipeline, är en väg vi gärna vill utforska att använda SageMaker multi-model endpoints (MME) för att distribuera våra finjusterade modeller. Med MME:er kan vi potentiellt effektivisera distributionen av olika finjusterade modeller, säkerställa effektiv modellhantering samtidigt som vi drar nytta av SageMakers inbyggda funktioner som skuggvarianter, automatisk skalning och amazoncloudwatch integration. Denna utforskning ligger i linje med vår ständiga strävan efter att förbättra våra prediktiva analysmöjligheter och tillhandahålla överlägsna upplevelser till våra kunder.

Slutsats

Vår framgångsrika integration av SageMaker och AWS Batch har inte bara tagit itu med våra specifika utmaningar utan också avsevärt ökat vår operativa effektivitet. Genom implementeringen av en sofistikerad produktkategoriförutsägelsepipeline kan vi ge våra kommersiella team datadrivna insikter och därigenom underlätta mer effektivt beslutsfattande.

Våra resultat säger mycket om vår metods effektivitet. Vi har uppnått en prediktionsnoggrannhet på 80 % över alla fyra nivåer av kategorigranularitet, vilket spelar en viktig roll för att forma produktsortimentet för varje land vi betjänar. Denna precisionsnivå utökar vår räckvidd bortom språkbarriärer och säkerställer att vi tillgodoser vår mångsidiga användarbas med största noggrannhet.

Genom att strategiskt använda schemalagda AWS Batch GPU-jobb har vi dessutom kunnat minska vår modellutbildningstid med 90 %. Denna effektivitet har ytterligare effektiviserat våra processer och stärkt vår operativa smidighet. Effektiv modelllagring med Amazon S3 har spelat en avgörande roll i denna prestation och balanserat både realtids- och batchförutsägelser.

För mer information om hur du kommer igång med att bygga dina egna ML-pipelines med SageMaker, se Amazon SageMaker-resurser. AWS Batch är ett utmärkt alternativ om du letar efter en billig, skalbar lösning för att köra batchjobb med låga driftskostnader. För att komma igång, se Komma igång med AWS Batch.

Om författarna

Nafi Ahmet Turgut avslutade sin masterexamen i elektro- och elektronikteknik och arbetade som forskare. Hans fokus var att bygga maskininlärningsalgoritmer för att simulera nervösa nätverksavvikelser. Han började på Getir 2019 och arbetar för närvarande som Senior Data Science & Analytics Manager. Hans team ansvarar för att designa, implementera och underhålla end-to-end maskininlärningsalgoritmer och datadrivna lösningar för Getir.

Nafi Ahmet Turgut avslutade sin masterexamen i elektro- och elektronikteknik och arbetade som forskare. Hans fokus var att bygga maskininlärningsalgoritmer för att simulera nervösa nätverksavvikelser. Han började på Getir 2019 och arbetar för närvarande som Senior Data Science & Analytics Manager. Hans team ansvarar för att designa, implementera och underhålla end-to-end maskininlärningsalgoritmer och datadrivna lösningar för Getir.

Hasan Burak Yel tog sin kandidatexamen i elektro- och elektronikteknik vid Boğaziçi University. Han arbetade på Turkcell, främst fokuserat på tidsserieprognoser, datavisualisering och nätverksautomation. Han började på Getir 2021 och arbetar för närvarande som Data Science & Analytics Manager med ansvar för sök-, rekommendations- och tillväxtdomäner.

Hasan Burak Yel tog sin kandidatexamen i elektro- och elektronikteknik vid Boğaziçi University. Han arbetade på Turkcell, främst fokuserat på tidsserieprognoser, datavisualisering och nätverksautomation. Han började på Getir 2021 och arbetar för närvarande som Data Science & Analytics Manager med ansvar för sök-, rekommendations- och tillväxtdomäner.

Damla Şentürk tog sin kandidatexamen i datateknik vid Galatasaray University. Hon fortsätter sin masterexamen i datateknik vid Boğaziçi universitet. Hon började på Getir 2022 och har arbetat som Data Scientist. Hon har arbetat med kommersiella, försörjningskedjan och upptäcktsrelaterade projekt.

Damla Şentürk tog sin kandidatexamen i datateknik vid Galatasaray University. Hon fortsätter sin masterexamen i datateknik vid Boğaziçi universitet. Hon började på Getir 2022 och har arbetat som Data Scientist. Hon har arbetat med kommersiella, försörjningskedjan och upptäcktsrelaterade projekt.

Esra Kayabalı är en Senior Solutions Architect på AWS, specialiserad på analysdomänen, inklusive datalager, datasjöar, big data-analys, batch- och realtidsdataströmning och dataintegration. Hon har 12 års erfarenhet av mjukvaruutveckling och arkitektur. Hon brinner för att lära sig och lära ut molnteknik.

Esra Kayabalı är en Senior Solutions Architect på AWS, specialiserad på analysdomänen, inklusive datalager, datasjöar, big data-analys, batch- och realtidsdataströmning och dataintegration. Hon har 12 års erfarenhet av mjukvaruutveckling och arkitektur. Hon brinner för att lära sig och lära ut molnteknik.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://aws.amazon.com/blogs/machine-learning/how-getir-reduced-model-training-durations-by-90-with-amazon-sagemaker-and-aws-batch/

- : har

- :är

- :inte

- 100

- 12

- 2015

- 2019

- 2021

- 2022

- 7

- a

- förmåga

- Able

- Om Oss

- tillgång

- åtkomst

- noggrannhet

- exakt

- uppnås

- uppnåendet

- uppnå

- tvärs

- Handling

- Dessutom

- adress

- adresserad

- Fördel

- Efter

- mot

- algoritmer

- Justerar

- Alla

- tillåts

- tillåter

- längs

- också

- amason

- Amazon SageMaker

- Amazon Web Services

- an

- analytics

- analys

- och

- och infrastruktur

- abnormiteter

- vilken som helst

- arkitektur

- ÄR

- AS

- aspekt

- sortiment

- At

- bil

- automatiskt

- Automation

- Avenue

- AWS

- Balansera

- balansering

- barriärer

- bas

- baserat

- BE

- blir

- varit

- riktmärke

- gynnar

- BÄST

- Bortom

- Stor

- Stora data

- ökat

- båda

- varumärke

- SLUTRESULTAT

- Byggnad

- byggt

- företag

- men

- by

- KAN

- kapacitet

- kapacitet

- aktiverade

- kategorier

- Kategori

- tillgodose

- centrala

- kedja

- utmanar

- utmaningar

- val

- cloud

- kombinerar

- kommersiella

- företag

- övertygande

- konkurrenskraftig

- konkurrenter

- Avslutade

- komplex

- omfattande

- Compute

- dator

- Datorteknik

- databehandling

- konglomerat

- fortsätta

- fortsätter

- kontinuerlig

- land

- skapande

- kritisk

- avgörande

- För närvarande

- kund

- Kunder

- datum

- Data Analytics

- datavetenskap

- datavetare

- datavisualisering

- data driven

- Beslutsfattande

- definierade

- Examen

- leverans

- distribuera

- utplacerade

- utplacera

- utplacering

- design

- detaljerad

- utvecklare

- Utveckling

- olika

- Svårighet

- direkt

- fördelning

- flera

- diversifierad

- domän

- domäner

- grund

- varaktighet

- varje

- lätt

- Effektiv

- effektivt

- effektivitet

- effektiviteter

- effektivitet

- effektiv

- effektivt

- enkelt

- ansträngningar

- Elektronik

- ge

- aktiverad

- encompassing

- början till slut

- Teknik

- förbättrad

- förbättra

- säker

- säkerställer

- säkerställa

- Miljö

- lika

- etablerade

- utvecklas

- utmärkt

- befintliga

- erfarenhet

- Erfarenheter

- Förklara

- utforskning

- utforska

- sträcker

- Ansikte

- underlättande

- snabb

- Leverans

- fält

- slutlig

- Förnamn

- Fokus

- fokuserade

- efter

- För

- kraft

- Prognos

- fyra

- från

- fullständigt

- ytterligare

- framtida

- samla

- genererar

- Tyskland

- skaffa sig

- GPU

- GPUs

- uppgradera

- Tillväxt

- Gäst

- gäst inlägg

- hantera

- Har

- he

- hjälpa

- hjälper

- här

- Hög

- hans

- värd

- Hur ser din drömresa ut

- How To

- html

- http

- HTTPS

- if

- genomförande

- genomföra

- med Esport

- viktig aspekt

- in

- innefattar

- Inklusive

- informationen

- Infrastruktur

- inledande

- innovativa

- insikter

- installera

- exempel

- integrering

- interaktioner

- in

- ovärderlig

- lager

- Inventory Management

- IT

- DESS

- sig

- Lediga jobb

- fogade

- jpg

- Angelägen

- Nyckel

- känd

- sjöar

- språk

- Språk

- Latens

- inlärning

- Led

- Nivå

- nivåer

- tycka om

- du letar

- Låg

- låg kostnad

- Maskinen

- maskininlärning

- huvudsakligen

- upprätthålla

- göra

- hantera

- förvaltade

- ledning

- chef

- sätt

- många

- marknad

- master

- metod

- Metodik

- minuter

- ML

- modell

- modeller

- Månad

- mer

- multinationell

- multipel

- nativ

- Natural

- Navigera

- Behöver

- behov

- Nederländerna

- nät

- Nästa

- nio

- Nej

- objektet

- Uppenbara

- of

- erbjuda

- on

- ONE

- endast

- operativa

- Verksamhet

- optimala

- optimerad

- optimerar

- Alternativet

- or

- beställa

- organisation

- vår

- övervinna

- egen

- särskilt

- brinner

- Personer

- perfekt

- prestanda

- fas

- rörledning

- plato

- Platon Data Intelligence

- PlatonData

- spelat

- spelar

- portfölj

- placerad

- Möjligheterna

- Inlägg

- potentiell

- potentiellt

- kraft

- den mäktigaste

- Precision

- förutsäga

- förutsägelse

- Förutsägelser

- Predictive Analytics

- Närvaron

- Problem

- problem

- process

- processer

- Produkt

- Produktion

- projektet

- projekt

- beprövade

- ge

- förutsatt

- tillhandahålla

- utförandet

- mängd

- snabbt

- intervall

- nå

- realtid

- data i realtid

- mottagna

- Rekommendation

- minska

- Minskad

- reducerande

- förfina

- raffinerade

- representerar

- Obligatorisk

- forskning

- Resurser

- ansvaret

- ansvarig

- Resultat

- revolution

- Roll

- Körning

- rinnande

- sagemaker

- skalbarhet

- skalbar

- Skala

- skalning

- planerad

- Vetenskap

- Forskare

- vetenskapsmän

- sömlös

- Sök

- sektioner

- säkerhet

- se

- Seek

- segmentet

- vald

- senior

- Serier

- tjänar

- service

- Tjänster

- in

- sju

- skugga

- formning

- hon

- Visar

- signifikant

- Enkelt

- singularis

- So

- Mjukvara

- mjukvaruutveckling

- lösning

- Lösningar

- Lösa

- några

- sofistikerade

- eftersträvas

- tala

- specialiserad

- specifik

- igång

- Stater

- Steg

- förvaring

- misslyckande

- Strategisk

- Strategiskt

- Strategi

- streaming

- effektivisera

- strömlinjeformad

- rationalisering

- förstärkt

- styrkor

- framgångsrik

- överlägsen

- leverera

- leveranskedjan

- stödja

- tackla

- skräddarsydd

- uppgifter

- Undervisning

- grupp

- lag

- tech

- Teknikföretag

- Tekniken

- Testning

- den där

- Smakämnen

- Nederländerna

- Storbritannien

- deras

- Dem

- sedan

- vari

- därför

- Dessa

- detta

- Genom

- tid

- Tidsföljder

- till

- i dag

- dagens

- tillsammans

- verktyg

- vägvisare

- Tåg

- Utbildning

- träd

- Turkiet

- två

- Uk

- paraply

- under

- United

- USA

- universitet

- us

- användning

- Begagnade

- Användare

- Användarupplevelse

- med hjälp av

- utnyttjas

- yttersta

- olika

- vertikaler

- visualisering

- avgörande

- volymer

- var

- we

- webb

- webbservice

- vecka

- były

- som

- medan

- med

- inom

- arbetade

- arbetssätt

- fungerar

- år

- Om er

- Din

- zephyrnet