Beskrivning

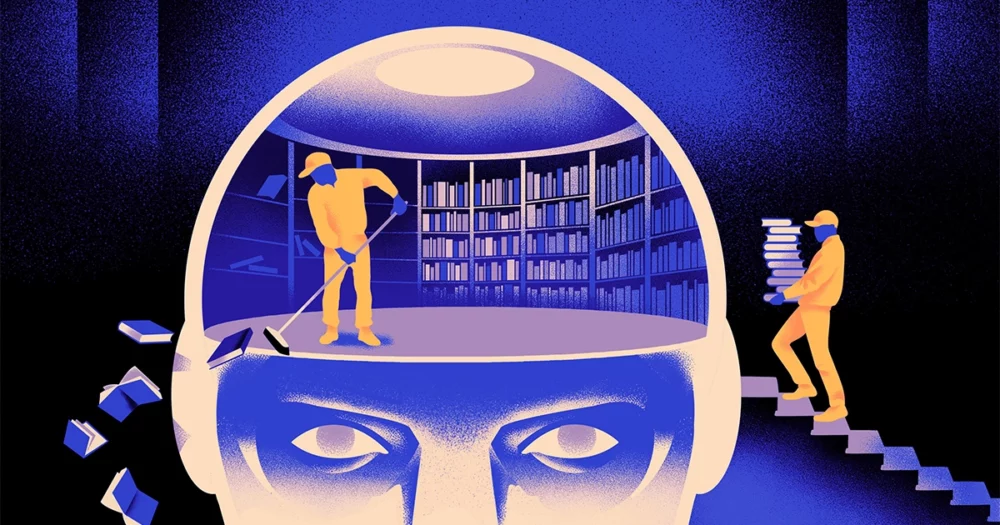

Ett team av datavetare har skapat en smidigare, mer flexibel typ av maskininlärningsmodell. Tricket: Den måste med jämna mellanrum glömma vad den vet. Och även om detta nya tillvägagångssätt inte kommer att ersätta de enorma modellerna som ligger bakom de största apparna, kan det avslöja mer om hur dessa program förstår språk.

Den nya forskningen markerar "ett betydande framsteg på området", sa Jea Kwon, en AI-ingenjör vid Institutet för grundläggande vetenskap i Sydkorea.

AI-språkmotorerna som används idag drivs till största delen av Artificiellt nervsystem. Varje "neuron" i nätverket är en matematisk funktion som tar emot signaler från andra sådana neuroner, kör vissa beräkningar och skickar signaler vidare genom flera lager av neuroner. Inledningsvis är informationsflödet mer eller mindre slumpmässigt, men genom träning förbättras informationsflödet mellan neuroner när nätverket anpassar sig till träningsdata. Om en AI-forskare vill skapa en tvåspråkig modell, till exempel, skulle hon träna modellen med en stor hög med text från båda språken, som skulle anpassa kopplingarna mellan neuroner på ett sådant sätt att texten relateras till ett språk med motsvarande ord i den andra.

Men den här träningsprocessen kräver mycket datorkraft. Om modellen inte fungerar särskilt bra, eller om användarens behov ändras senare, är det svårt att anpassa den. "Säg att du har en modell som har 100 språk, men tänk dig att ett språk du vill inte omfattas av," sa Mikel Artetxe, en medförfattare till den nya forskningen och grundare av AI-startupen Reka. "Du kan börja om från början, men det är inte idealiskt."

Artetxe och hans kollegor har försökt kringgå dessa begränsningar. Några år sedan, tränade Artetxe och andra ett neuralt nätverk på ett språk, och raderade sedan vad det visste om byggstenarna i ord, så kallade tokens. Dessa lagras i det första lagret av det neurala nätverket, som kallas inbäddningsskiktet. De lämnade alla andra lager i modellen ifred. Efter att ha raderat tokens för det första språket, tränade de om modellen på det andra språket, vilket fyllde inbäddningsskiktet med nya tokens från det språket.

Även om modellen innehöll felaktig information fungerade omskolningen: Modellen kunde lära sig och bearbeta det nya språket. Forskarna förmodade att medan det inbäddade lagret lagrade information som är specifik för de ord som används i språket, lagrade de djupare nivåerna i nätverket mer abstrakt information om begreppen bakom mänskliga språk, vilket sedan hjälpte modellen att lära sig det andra språket.

"Vi lever i samma värld. Vi konceptualiserar samma saker med olika ord” på olika språk, sa Yihong Chen, huvudförfattaren till den senaste tidningen. ”Det är därför du har samma resonemang på hög nivå i modellen. Ett äpple är något sött och saftigt, istället för bara ett ord.”

Beskrivning

Även om detta glömska tillvägagångssätt var ett effektivt sätt att lägga till ett nytt språk till en redan utbildad modell, var omskolningen fortfarande krävande - det krävde mycket språklig data och processorkraft. Chen föreslog en justering: Istället för att träna, radera inbäddningsskiktet och sedan träna om, bör de periodiskt återställa inbäddningsskiktet under den första träningsomgången. "Genom att göra detta, blir hela modellen van vid att återställa," sa Artetxe. "Det betyder att när du vill utöka modellen till ett annat språk är det lättare, för det är vad du har gjort."

Forskarna tog en vanlig språkmodell som heter Roberta, tränade den med hjälp av deras periodiska glömma-teknik och jämförde den med samma modells prestanda när den tränades med den vanliga, icke-förglömliga metoden. Glömsmodellen gick något sämre än den konventionella och fick poängen 85.1 jämfört med 86.1 på ett vanligt mått på språknoggrannhet. Sedan tränade de om modellerna på andra språk, med mycket mindre datamängder på endast 5 miljoner tokens, snarare än de 70 miljarder de använde under den första utbildningen. Noggrannheten för standardmodellen minskade till 53.3 i genomsnitt, men den glömda modellen sjönk bara till 62.7.

Glömsmodellen klarade sig också mycket bättre om teamet införde beräkningsgränser under omskolningen. När forskarna minskade träningslängden från 125,000 5,000 steg till bara 57.8 37.2, minskade noggrannheten för den glömska modellen till XNUMX i genomsnitt, medan standardmodellen sjönk till XNUMX, vilket inte är bättre än slumpmässiga gissningar.

Beskrivning

Teamet drog slutsatsen att periodisk glömning verkar göra modellen bättre på att lära sig språk generellt. "Eftersom [de] fortsätter att glömma och lära sig om under träningen blir det lättare att lära nätverket något nytt senare," sa Evgenii Nikishin, en forskare vid Mila, ett forskningscenter för djupinlärning i Quebec. Det tyder på att när språkmodeller förstår ett språk så gör de det på en djupare nivå än bara betydelsen av enskilda ord.

Tillvägagångssättet liknar hur våra egna hjärnor fungerar. ”Människans minne i allmänhet är inte särskilt bra på att korrekt lagra stora mängder detaljerad information. Istället tenderar människor att komma ihåg kärnan i våra upplevelser, abstrahera och extrapolera”, sa Benjamin Levy, en neuroforskare vid University of San Francisco. "Att aktivera AI med mer mänskliga processer, som adaptiv glömma, är ett sätt att få dem till mer flexibel prestanda."

Utöver vad det kan säga om hur förståelse fungerar, hoppas Artetxe att mer flexibla bortglömda språkmodeller också kan hjälpa till att föra de senaste AI-genombrotten till fler språk. Även om AI-modeller är bra på att hantera spanska och engelska, två språk med gott om utbildningsmaterial, är modellerna inte så bra med hans modersmål baskiska, det lokala språket som är specifikt för nordöstra Spanien. "De flesta modeller från stora teknikföretag gör det inte bra," sa han. "Att anpassa befintliga modeller till baskiska är vägen att gå."

Chen ser också fram emot en värld där fler AI-blommor blommar. ”Jag tänker på en situation där världen inte behöver en enda stor språkmodell. Vi har så många, säger hon. "Om det finns en fabrik som tillverkar språkmodeller behöver du den här typen av teknik. Den har en basmodell som snabbt kan anpassa sig till nya domäner.”

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://www.quantamagazine.org/how-selective-forgetting-can-help-ai-learn-better-20240228/

- : har

- :är

- :inte

- :var

- ][s

- 000

- 1

- 100

- 125

- 7

- 70

- 8

- a

- Om Oss

- SAMMANDRAG

- noggrannhet

- exakt

- anpassa

- adaptiv

- anpassar sig

- lägga till

- Dessutom

- avancera

- Efter

- AI

- AI-modeller

- Alla

- ensam

- redan

- också

- mängder

- an

- och

- Annan

- Apple

- tillvägagångssätt

- appar

- ÄR

- AS

- At

- Författaren

- genomsnitt

- bas

- grundläggande

- därför att

- blir

- varit

- bakom

- Bättre

- mellan

- Stor

- stor teknik

- störst

- Miljarder

- Block

- Bloom

- båda

- genombrott

- föra

- Byggnad

- men

- by

- beräkningar

- kallas

- KAN

- Centrum

- byta

- chen

- kringgå

- Medförfattare

- kollegor

- Gemensam

- vanligen

- Företag

- jämfört

- beräkningar

- dator

- databehandling

- beräkningskraft

- Begreppen

- ingås

- Anslutningar

- innehöll

- konventionell

- kunde

- omfattas

- skapa

- skapas

- Klipp

- datum

- datauppsättningar

- minskade

- djup

- djupt lärande

- djupare

- krävande

- detaljerad

- DID

- olika

- do

- inte

- gör

- domäner

- inte

- tappade

- under

- varje

- lättare

- Effektiv

- inbäddning

- ingenjör

- Motorer

- Engelska

- Hela

- Motsvarande

- exempel

- befintliga

- Erfarenheter

- förlänga

- fabrik

- få

- fält

- fyllda

- Förnamn

- flexibel

- flöda

- För

- Framåt

- grundare

- Francisco

- från

- fungera

- Allmänt

- allmänhet

- skaffa sig

- GitHub

- Go

- god

- Arbetsmiljö

- Hård

- Har

- he

- hjälpa

- hjälpte

- högnivå

- hans

- hoppas

- Hur ser din drömresa ut

- HTTPS

- stor

- humant

- människolik

- Människa

- idealisk

- if

- bild

- ålagts

- förbättrar

- in

- individuellt

- informationen

- inledande

- initialt

- istället

- Institute

- IT

- bara

- Ha kvar

- Snäll

- vet

- korea

- språk

- Språk

- Large

- senare

- senaste

- lager

- skikt

- leda

- LÄRA SIG

- inlärning

- vänster

- Längd

- mindre

- Nivå

- nivåer

- tycka om

- begränsningar

- gränser

- lever

- lokal

- UTSEENDE

- Lot

- Maskinen

- maskininlärning

- magasinet

- göra

- Framställning

- många

- material

- matematisk

- betydelser

- betyder

- mäta

- Minne

- kanske

- miljon

- modell

- modeller

- mer

- för det mesta

- mycket

- multipel

- måste

- nativ

- Behöver

- behov

- nät

- neurala

- neurala nätverk

- nervceller

- Nya

- Nej

- of

- on

- ONE

- endast

- or

- Övriga

- Övrigt

- vår

- över

- egen

- Papper

- prestanda

- periodisk

- plato

- Platon Data Intelligence

- PlatonData

- plunged

- kraft

- drivs

- process

- processer

- bearbetning

- Process kraft

- Program

- Quantamagazin

- Quebec

- snabbt

- slumpmässig

- snarare

- erhåller

- mottagande

- senaste

- ihåg

- Obligatorisk

- forskning

- forskaren

- forskare

- avslöjar

- rund

- kör

- Nämnda

- Samma

- San

- San Francisco

- säga

- Vetenskap

- vetenskapsmän

- göra

- repa

- Andra

- verkar

- selektiv

- sänder

- uppsättningar

- hon

- skall

- signaler

- signifikant

- liknande

- Situationen

- mindre

- So

- några

- något

- Söder

- Sydkorea

- Spanien

- spanska

- specifik

- standard

- starta

- start

- Steg

- Fortfarande

- lagras

- misslyckande

- sådana

- Föreslår

- söt

- tar

- Undervisning

- grupp

- tech

- Tech företag

- Tekniken

- Teknologi

- Tend

- text

- än

- den där

- Smakämnen

- den information

- världen

- deras

- Dem

- sedan

- Dessa

- de

- saker

- Tänkande

- detta

- fastän?

- Genom

- till

- i dag

- tokens

- tog

- Tåg

- tränad

- Utbildning

- knep

- försökte

- justera

- två

- förstå

- förståelse

- universitet

- användning

- Begagnade

- med hjälp av

- mycket

- vill

- vill

- var

- Sätt..

- we

- webp

- VÄL

- Vad

- när

- som

- medan

- varför

- med

- ord

- ord

- Arbete

- arbetade

- fungerar

- världen

- sämre

- skulle

- år

- Om er

- zephyrnet