I en allt mer datacentrerad värld måste företag fokusera på att samla in både värdefull fysisk information och generera den information som de behöver men som inte enkelt kan fånga upp. Dataåtkomst, reglering och efterlevnad är en ökande källa till friktion för innovation inom analys och artificiell intelligens (AI).

För starkt reglerade sektorer som finansiella tjänster, hälsovård, biovetenskap, fordon, robotteknik och tillverkning är problemet ännu större. Det orsakar hinder för systemdesign, datadelning (internt och externt), intäktsgenerering, analys och maskininlärning (ML).

Syntetisk data är ett verktyg som hanterar många datautmaningar, särskilt AI och analysfrågor som integritetsskydd, regelefterlevnad, tillgänglighet, databrist och partiskhet. Detta inkluderar även datadelning och tid till data (och därmed tid till marknad).

Syntetisk data genereras algoritmiskt. Det speglar statistiska egenskaper och mönster från källdata. Men viktigast av allt innehåller den inga känsliga, privata eller personliga datapunkter.

Du ställer frågor om den syntetiska datan och får samma svar som du skulle få från den verkliga datan.

I vår tidigare inlägg, vi visade hur man använder kontradiktoriska nätverk som Generative Adversarial Networks (GANS) för att generera datauppsättningar i tabellform för att förbättra utbildningen i kreditbedrägerimodeller.

För företagsintressenter att anta syntetiska data för sina ML- och analysprojekt är det absolut nödvändigt att inte bara se till att den genererade syntetiska informationen passar syftet och de förväntade nedströmstillämpningarna, utan också för att de ska kunna mäta och demonstrera kvaliteten på den genererade datan.

Med ökande juridiska och etiska skyldigheter för att bevara integriteten, är en av syntetiska datas styrkor möjligheten att ta bort känslig och original information under dess syntes. Därför behöver vi, förutom kvalitet, mätvärden för att utvärdera risken för eventuella privata informationsläckor och bedöma att genereringsprocessen inte "minner" eller kopierar någon av originaldata.

För att uppnå allt detta kan vi kartlägga kvaliteten på syntetisk data i dimensioner, som hjälper användarna, intressenterna och oss att bättre förstå den genererade datan.

De tre dimensionerna av kvalitetsutvärdering av syntetisk data

Den syntetiska data som genereras mäts mot tre nyckeldimensioner:

- Fidelity

- Verktyget

- Integritetspolicy

Det här är några av frågorna om genererad syntetisk data som bör besvaras av en kvalitetsrapport för syntetisk data:

- Hur lik är denna syntetiska data jämfört med den ursprungliga träningsuppsättningen?

- Hur användbar är denna syntetiska data för våra nedströmsapplikationer?

- Har någon information läckt från den ursprungliga träningsdatan till den syntetiska datan?

- Har någon data som anses vara känslig i den verkliga världen (från andra datamängder som inte används för att träna modellen) oavsiktligt syntetiserats av vår modell?

Mätvärdena som översätter var och en av dessa dimensioner för slutanvändarna är något flexibla. När allt kommer omkring kan data som ska genereras variera i termer av distributioner, storlek och beteenden. De ska också vara lätta att förstå och tolka.

I slutändan måste mätvärdena vara helt datadrivna och inte kräva några förkunskaper eller domänspecifik information. Men om användaren vill tillämpa specifika regler och begränsningar som är tillämpliga på en specifik affärsdomän, bör de kunna definiera dem under syntesprocessen för att säkerställa att den domänspecifika troheten uppfylls.

Vi tittar på var och en av dessa mätvärden mer i detalj i följande avsnitt.

Mätvärden för att förstå trohet

I alla datavetenskapliga projekt måste vi förstå om en viss provpopulation är relevant för det problem som vi löser. På samma sätt, för processen att bedöma relevansen av den syntetiska data som genereras, måste vi utvärdera den i termer av trohet jämfört med originalet.

Visuella representationer av dessa mätvärden gör dem lättare att förstå. Vi kunde illustrera om kardinaliteten och förhållandet mellan kategorier respekterades, korrelationerna mellan de olika variablerna bibehölls, och så vidare.

Att visualisera data hjälper inte bara till att utvärdera kvaliteten på den syntetiska data, utan passar också in som ett av de första stegen i datavetenskapens livscykel för en bättre förståelse av data.

Låt oss dyka in i några trohetsmått mer i detalj.

Undersökande statistiska jämförelser

Inom de explorativa statistiska jämförelserna utforskas egenskaperna hos de ursprungliga och syntetiska datamängderna med hjälp av viktiga statistiska mått, såsom medelvärde, median, standardavvikelse, distinkta värden, saknade värden, minima, maxima, kvartilintervall för kontinuerliga funktioner och antalet av poster per kategori, saknade värden per kategori och de flesta förekommande tecken för kategoriska attribut.

Denna jämförelse bör utföras mellan den ursprungliga datauppsättningen för håll-out och de syntetiska data. Denna utvärdering skulle avslöja om de jämförda datamängderna är statistiskt lika. Om de inte är det, kommer vi att ha en förståelse för vilka funktioner och åtgärder som är olika. Du bör överväga att träna om och regenerera de syntetiska data med olika parametrar om en signifikant skillnad noteras.

Detta test fungerar som en första screening för att säkerställa att den syntetiska datan har rimlig trohet mot den ursprungliga datamängden och därför med fördel kan genomgå mer rigorösa tester.

Histogram likhet poäng

Histogrammets likhetspoäng mäter varje funktions marginalfördelningar av de syntetiska och ursprungliga datamängderna.

Likhetspoängen är avgränsad mellan noll och ett, med ett poäng på ett som indikerar att de syntetiska datafördelningarna perfekt överlappar fördelningarna av originaldata.

En poäng nära ett skulle ge användarna förtroende för att holdout-datauppsättningen och den syntetiska datauppsättningen är statistiskt lika.

Poäng för ömsesidig information

Den ömsesidiga informationspoängen mäter det ömsesidiga beroendet av två funktioner, numeriska eller kategoriska, och indikerar hur mycket information som kan erhållas från en funktion genom att observera en annan.

Ömsesidig information kan mäta icke-linjära samband, vilket ger en mer omfattande förståelse av den syntetiska datakvaliteten eftersom den låter oss förstå omfattningen av variabelns relationsbevarande.

Ett poäng på ett indikerar att det ömsesidiga beroendet mellan funktioner har fångats perfekt i den syntetiska datan.

Korrelationspoäng

Korrelationspoängen mäter hur väl korrelationerna i den ursprungliga datamängden har fångats i den syntetiska datan.

Korrelationer mellan två eller flera kolumner är extremt viktiga för ML-applikationer, som hjälper till att avslöja sambanden mellan funktioner och målvariabeln och hjälper till att skapa en vältränad modell.

Korrelationspoängen är avgränsad mellan noll och ett, med ett poäng på ett indikerar att korrelationerna har matchats perfekt.

Till skillnad från strukturerad tabelldata, som vi vanligtvis stöter på i dataproblem, har vissa typer av strukturerad data ett särskilt beteende där tidigare observationer har en sannolikhet att påverka följande observation. Dessa är kända som tidsserier eller sekventiell data – till exempel en datauppsättning med timmätningar av rumstemperatur.

Detta beteende innebär att det finns ett krav på att definiera vissa mätvärden som specifikt kan mäta kvaliteten på dessa tidsseriedatauppsättningar

Autokorrelation och partiell autokorrelationspoäng

Även om den liknar korrelation, visar autokorrelation förhållandet mellan en tidsserie vid dess nuvarande värde när den relaterar till dess tidigare värden. Att ta bort effekterna av föregående tidsfördröjningar ger partiell autokorrelation. Därför mäter autokorrelationspoängen hur väl den syntetiska datan har fångat de signifikanta autokorrelationerna, eller partiella korrelationerna, från den ursprungliga datamängden.

Mätvärden för att förstå nytta

Nu kan vi statistiskt ha insett att den syntetiska datan liknar den ursprungliga datamängden. Dessutom måste vi också bedöma hur väl det syntetiserade datasetet klarar sig på vanliga datavetenskapliga problem när de tränas på flera ML-algoritmer.

Använder följande verktyg mätvärden, strävar vi efter att bygga förtroende för att vi faktiskt kan uppnå prestanda på nedströmsapplikationer när det gäller hur originaldata har presterat.

Förutsägelsepoäng

Att mäta prestanda för syntetisk data jämfört med den ursprungliga verkliga data kan göras genom ML-modeller. Nedströmsmodellpoängen fångar kvaliteten på syntetiska data genom att jämföra prestandan hos ML-modeller som tränats på både syntetiska och ursprungliga datamängder och validerats på undanhållna testdata från den ursprungliga datamängden. Detta ger en Träna Synthetic Test Real (TSTR) poäng och en Train Real Test Real (TRTR) poäng respektive.

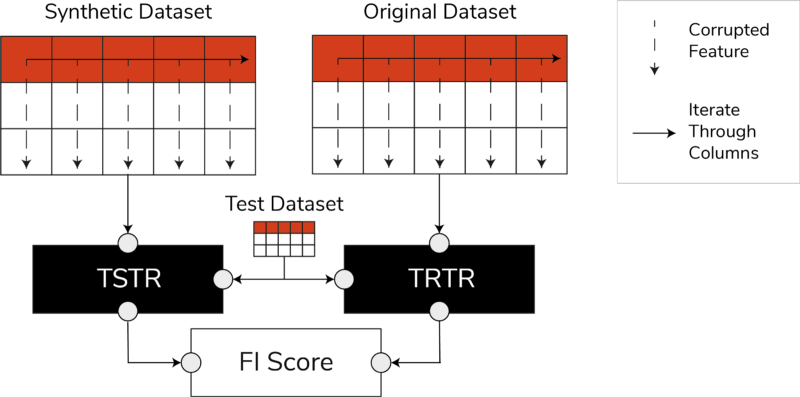

TSTR, TRTR-poäng och Feature Importance Score (Bild av författare)

Poängen innehåller ett brett utbud av de mest pålitliga ML-algoritmerna för antingen regression eller klassificeringsuppgifter. Genom att använda flera klassificerare och regressorer säkerställs att poängen är mer generaliserbar över de flesta algoritmer, så att den syntetiska data kan anses vara användbar i framtiden.

I slutändan, om TSTR-poängen och TRTR-poängen är jämförbara, indikerar detta att den syntetiska data har den kvalitet som ska användas för att träna effektiva ML-modeller för verkliga tillämpningar.

Funktionens betydelsepoäng

I hög grad relaterat till förutsägelsepoängen, utökar funktionen betydelse (FI) poängen den genom att lägga till tolkningsbarhet till TSTR- och TRTR-poängen.

F1-poängen jämför förändringarna och stabiliteten i egenskapens betydelseordning erhållen med förutsägelsepoängen. En syntetisk uppsättning data anses vara av hög användbarhet om den ger samma ordningsföljd av egenskapsviktighet som den ursprungliga verkliga datan.

QScore

För att vara säker på att en modell som tränas på vår nygenererade data kommer att ge samma svar på samma frågor som en modell tränad med originaldata använder vi Qscore. Detta mäter nedströmsprestandan för den syntetiska datan genom att köra många slumpmässiga aggregeringsbaserade frågor på både syntetiska och ursprungliga (och kvarhållna) datamängder.

Tanken här är att båda dessa frågor ska ge liknande resultat.

En hög QScore säkerställer att nedströmsapplikationer som använder fråge- och aggregeringsoperationer kan ge nästan lika värde som den ursprungliga datamängden.

Mätvärden för att förstå sekretess

Med privatpolicy bestämmelser som redan finns på plats är det en etisk skyldighet och ett lagkrav att se till att känslig information skyddas.

Innan denna syntetiska data kan delas fritt och användas för nedströmsapplikationer måste vi överväga integritetsmåtten som kan hjälpa intressenten att förstå var den genererade syntetiska informationen står jämfört med den ursprungliga informationen när det gäller omfattningen av läckt information. Dessutom måste vi fatta kritiska beslut om hur den syntetiska datan kan delas och användas.

Exakt matchresultat

En direkt och intuitiv utvärdering av integritet är att leta efter kopior av den verkliga informationen bland de syntetiska posterna. Den exakta matchpoängen räknar antalet riktiga rekord som kan hittas bland den syntetiska uppsättningen.

Poängen ska vara noll, vilket anger att ingen verklig information finns som den är i den syntetiska datan. Detta mått fungerar som en screeningmekanism innan vi utvärderar ytterligare sekretessmått.

Grannarnas integritetspoäng

Dessutom mäter grannarnas integritetspoäng förhållandet mellan syntetiska poster som kan vara för nära i likhet med de riktiga. Detta betyder att även om de inte är direkta kopior, är de potentiella punkter för integritetsläckage och en källa till användbar information för slutledningsattacker.

Poängen beräknas genom att utföra en högdimensionell sökning av närmaste grannar på syntetiska data överlappade med originaldata.

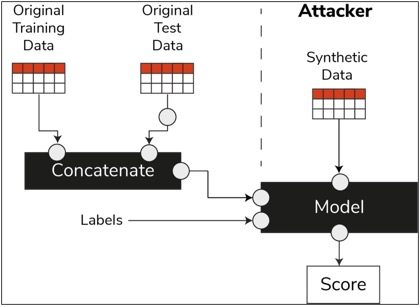

Resultat för medlemskap

I datavetenskapens livscykel, när en modell väl har tränats, behöver den inte längre tillgång till träningsproverna och kan göra förutsägelser om osynliga data. På liknande sätt, i vårt fall, när synthesizermodellen har tränats, kan prover av syntetiska data genereras utan behov av originaldata.

Genom en typ av attack kallas "medlemskap slutledningsattack", kan angripare försöka avslöja data som användes för att skapa syntetiska data, utan att ha tillgång till originaldata. Detta resulterar i en kompromiss av integritet.

Medlemsinferenspoängen mäter sannolikheten för att en medlemskapattack ska lyckas.

En låg poäng tyder på genomförbarheten av slutsatsen att en viss post var en medlem av den träningsdatauppsättning som ledde till skapandet av syntetiska data. Med andra ord kan attackerna sluta sig till detaljer om en enskild post och därigenom äventyra integriteten.

Ett högt resultat för medlemskap indikerar att det är osannolikt att en angripare kommer att avgöra om en viss post var en del av den ursprungliga datamängden som användes för att skapa syntetiska data. Detta betyder också att ingen individs information äventyras genom de syntetiska uppgifterna.

Hållout-konceptet

En viktig bästa praxis som vi måste följa är att se till att den syntetiska informationen är tillräckligt generell och inte överensstämmer med originaldatan som den tränades på. I typiska datavetenskapliga flöden, medan vi bygger ML-modeller som en Random Forest-klassificerare, lägger vi undan testdata, tränar modellerna med hjälp av träningsdata och utvärderar mätvärdena på osynliga testdata.

På liknande sätt, för syntetiska data, håller vi undan ett urval av originaldata – allmänt kallade en hold-out-datauppsättning eller osedda undanhållna testdata – och utvärderar den genererade syntetiska datan mot datauppsättningen för hold-out.

Holdout-datauppsättningen förväntas vara en representation av den ursprungliga datan, men den syns inte när den syntetiska datan genererades. Därför är det viktigt att ha liknande poäng för alla mätvärden när man jämför originalet med kvarhållet och de syntetiska datamängderna.

När liknande poäng erhålls kan vi fastställa att de syntetiska datapunkterna inte är ett resultat av memorering av de ursprungliga datapunkterna, samtidigt som vi behåller samma trohet och användbarhet.

Avslutande tankar

Världen börjar förstå den strategiska betydelsen av syntetisk data. Som datavetare och datageneratorer är det vår plikt att bygga upp förtroende för den syntetiska data som vi genererar och se till att det är för ett ändamål.

Syntetisk data håller på att utvecklas till ett måste i utvecklingsverktyget för datavetenskap. MIT Technology Review har noterade syntetisk data som en av 2022 års banbrytande teknologier. Vi kan inte föreställa oss att bygga utmärkt värde AI-modeller utan syntetisk data, hävdar Gartner.

Enligt McKinsey, syntetisk data minimerar kostnader och barriärer som du annars skulle ha när du utvecklar algoritmer eller får tillgång till data.

Generering av syntetisk data handlar om att känna till nedströmsapplikationerna och förstå avvägningarna mellan de olika dimensionerna för kvaliteten på syntetisk data.

Sammanfattning

Som användare av syntetiska data är det viktigt att definiera sammanhanget för användningsfallet för vilket varje prov av syntetiska material kommer att användas i framtiden. Precis som med verkliga data, är kvaliteten på den syntetiska datan beroende av det avsedda användningsfallet, såväl som de parametrar som valts för syntetisering.

Till exempel är det användbart att behålla extremvärden i syntetiska data som i originaldata för ett användningsfall för upptäckt av bedrägeri. Det är dock inte användbart i ett sjukvårdsanvändningsfall med integritetsproblem, eftersom extremvärden i allmänhet kan vara informationsläckage.

Dessutom finns det en avvägning mellan trohet, användbarhet och integritet. Data kan inte optimeras för alla tre samtidigt. Dessa mätvärden gör det möjligt för intressenterna att prioritera vad som är väsentligt för varje användningsfall och hantera förväntningar från genererad syntetisk data.

I slutändan, när vi ser värdena för varje mätvärde och när de uppfyller förväntningarna, kan intressenter vara säkra på de lösningar som de bygger med hjälp av syntetiska data.

Användningsfallen för strukturerade syntetiska data täcker ett brett spektrum av tillämpningar från testdata för mjukvaruutveckling till att skapa syntetiska kontrollarmar i kliniska prövningar.

Nå ut för att utforska dessa möjligheter eller bygg en PoC för att visa värdet.

Faris Haddad är Data & Insights Lead i AABG Strategic Pursuits-teamet. Han hjälper företag att framgångsrikt bli datadrivna.

Faris Haddad är Data & Insights Lead i AABG Strategic Pursuits-teamet. Han hjälper företag att framgångsrikt bli datadrivna.

- Avancerat (300)

- AI

- ai konst

- ai art generator

- har robot

- Amazon maskininlärning

- artificiell intelligens

- artificiell intelligenscertifiering

- artificiell intelligens inom bankväsendet

- artificiell intelligens robot

- robotar med artificiell intelligens

- programvara för artificiell intelligens

- AWS maskininlärning

- blockchain

- blockchain konferens ai

- coingenius

- konversationskonstnärlig intelligens

- kryptokonferens ai

- dalls

- djupt lärande

- du har google

- maskininlärning

- plato

- plato ai

- Platon Data Intelligence

- Platon spel

- PlatonData

- platogaming

- skala ai

- syntax

- Teknisk instruktion

- zephyrnet