Vi har utbildat och öppnar upp ett neuralt nät som heter Whisper som närmar sig robusthet och noggrannhet på mänsklig nivå för engelsk taligenkänning.

Visa kod

Visa modellkort

Viska exempel:

Whisper är ett automatiskt taligenkänningssystem (ASR) utbildat på 680,000 XNUMX timmars flerspråkig och multitaskövervakad data som samlats in från webben. Vi visar att användningen av en så stor och mångsidig datauppsättning leder till förbättrad robusthet mot accenter, bakgrundsljud och tekniskt språk. Dessutom möjliggör det transkription på flera språk, samt översättning från dessa språk till engelska. Vi är modeller med öppen källa och slutledningskod för att fungera som en grund för att bygga användbara applikationer och för vidare forskning om robust talbehandling.

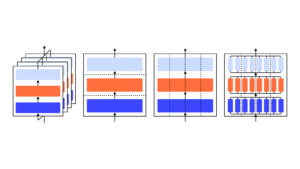

Whisper-arkitekturen är en enkel end-to-end-metod, implementerad som en encoder-decoder-transformator. Ingångsljud delas upp i 30-sekundersbitar, omvandlas till ett log-Mel-spektrogram och skickas sedan till en kodare. En avkodare är tränad att förutsäga motsvarande texttext, blandad med speciella tokens som styr den enstaka modellen att utföra uppgifter som språkidentifiering, tidsstämplar på frasnivå, flerspråkig taltranskription och till engelska talöversättning.

Andra befintliga tillvägagångssätt använder ofta mindre, mer nära parade ljud-text-utbildningsdatauppsättningar, eller använd bred men oövervakad ljudförträning. Eftersom Whisper tränades på en stor och mångsidig datauppsättning och inte finjusterades till någon specifik, slår den inte modeller som är specialiserade på LibriSpeech-prestanda, ett berömt konkurrensrikt riktmärke inom taligenkänning. Men när vi mäter Whispers nollskottsprestanda över många olika datauppsättningar finner vi att den är mycket mer robust och gör 50 % färre fel än dessa modeller.

Ungefär en tredjedel av Whispers ljuddatauppsättning är icke-engelska, och den får växelvis uppgiften att transkribera på originalspråket eller översätta till engelska. Vi tycker att detta tillvägagångssätt är särskilt effektivt för att lära sig tal till text översättning och överträffar den övervakade SOTA på CoVoST2 till engelsk översättning zero-shot.

Vi hoppas att Whispers höga noggrannhet och användarvänlighet gör det möjligt för utvecklare att lägga till röstgränssnitt till en mycket bredare uppsättning applikationer. Kolla in papper, modellkortoch koda för att lära dig mer detaljer och prova Whisper.

- AI

- ai konst

- ai art generator

- har robot

- artificiell intelligens

- artificiell intelligenscertifiering

- artificiell intelligens inom bankväsendet

- artificiell intelligens robot

- robotar med artificiell intelligens

- programvara för artificiell intelligens

- blockchain

- blockchain konferens ai

- coingenius

- konversationskonstnärlig intelligens

- kryptokonferens ai

- dalls

- djupt lärande

- du har google

- maskininlärning

- OpenAI

- plato

- plato ai

- Platon Data Intelligence

- Platon spel

- PlatonData

- platogaming

- forskning

- skala ai

- syntax

- zephyrnet