Något till helgen En robot utför tolkande dans på min tröskel.

SKULLE DU TA DET HÄR PAKET FÖR DIN GRANSE? frågar den och hoppar från ena foten till den andra.

"Visst," säger jag. "Eh... är du okej?"

JAG UTTRYCKAR KÄNSLOR, uppger leveransboten och lämnar över paketet men ger inga ytterligare fördjupningar.

Vilken känsla kan det vara? En fot, sedan den andra, sedan de andra två (den har fyra). Fram och tillbaka.

"Behöver du gå på toaletten?"

JAG UTTRYCKER ÅNGER FÖR ATT JAG BER DIG TA IN ETT PAKET TILL DIN GRANN.

"Det är "ångra", är det? Tja, det finns inget behov. Jag bryr mig inte alls."

Den fortsätter sin dans framför mig.

"Uppför trappan och först på höger sida."

TACK, JAG HAR DÖJ ATT KISSA, svarar den medan den försiktigt kliver förbi mig och smyger uppför trappan för att lätta på sig själv. Det är ett tufft liv att göra leveranser, oavsett om du är en "hume" eller en bot.

.

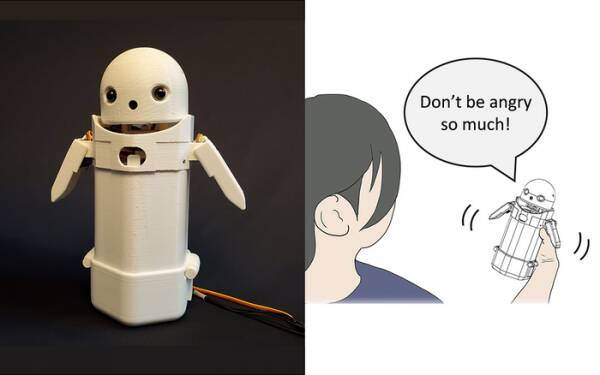

Tidigare i år byggde forskare vid University of Tsukuba en handhållen SMS-enhet, satte ett litet robotansikte på toppen och inkluderade en rörlig vikt inuti. Genom att flytta den interna vikten skulle robotbudbäraren försöka förmedla subtila känslor samtidigt som han pratade meddelanden högt.

I synnerhet visade tester att frustrerande meddelanden som: "Förlåt, jag kommer att vara sen" accepterades av mottagarna med mer grace och tålamod när den lilla viktförskjutningen aktiverades inuti enheten. Teorin är att detta hjälpte användarna att uppskatta den ursäktande tonen i meddelandet och därmed lugnade ner deras reaktion på det.

Skriv av sådan forskning som en gimmick om du vill, men det är inte långt ifrån att lägga till smileys och emojis i meddelanden. Alla vet att du kan ta ilskan ur "WTF!?" genom att lägga till :-) direkt efter det.

Utmaningen är alltså att avgöra om allmänheten i stort är överens om vilka känslor varje förändring av viktförskjutning i en handhållen enhet är tänkt att förmedla. Betyder en lutning åt vänster glädje? Eller osäkerhet? Eller att din farbror har ett luftskepp?

För ett decennium sedan hade Storbritannien en trevlig men svag premiärminister som trodde att "LOL" var en förkortning för "massor av kärlek." Han hade skrivit det i slutet av alla sina privata meddelanden till personal, kollegor och tredje parter i förväntan att det skulle få honom att framstå som varm och vänlig. Alla antog naturligtvis att han tog piss.

Om inte annat, erkänner University of Tsukuba forskning att du inte behöver en avancerad artificiell intelligens för att interagera med människor på ett övertygande sätt. Allt du behöver göra är att manipulera mänsklig psykologi för att lura dem att tro att de samtalar med en annan människa. Därför är Turing-testet i grunden inte ett test av AI-känsla utan ett test av mänsklig känslomässig komfort – till och med godtrogenhet – och det är inget fel med det.

Den känslodelningsrobot från Tsukuba-universitetet. Kredit: University of Tsukuba

Sådana saker är naturligtvis veckans ämne med berättelsen om den mycket förtalade Googles mjukvaruingenjör Blake Lemoine når de vanliga nyheterna. Han uttryckte tydligen, starkt, sin åsikt att företagets språkmodell för dialogapplikationer (LaMDA)-projekt uppvisade yttre tecken på känslor.

Alla har en åsikt så jag har bestämt mig för att inte göra det.

Det är dock AI:s heliga gral för att få den att tänka själv. Om det inte kan göra det är det bara ett program som utför instruktioner som du programmerat in i det. Förra månaden läste jag om en robotkock som kan göra olika smaksatta tomatomeletter för att passa olika människors smaker. Den bygger "smakkartor" för att bedöma rättens sälta samtidigt som den förbereds och lär sig allt eftersom. Men det är bara att lära sig, inte tänka själv.

Kom till Zom-Zoms, va? Väl, det är ett ställe att äta på.

Det stora problemet med AI-bots, åtminstone som de har utformats hittills, är att de absorberar all gammal skit du matar in i dem. Exempel på databias i så kallade maskininlärningssystem (en typ av "algoritm", tror jag, m'lud) har ökat i flera år, från Microsofts ökända rasistiska Twitter Tay chatbot till den holländska skattemyndigheten förra året felaktigt utvärdera giltiga anspråk på barnbidrag som bedrägliga och markerar oskyldiga familjer som en hög risk för att få modigheten att vara fattig och ovit.

En metod som testas vid University of California San Diego är att utforma en språkmodell [PDF] som kontinuerligt avgör skillnaden mellan stygga och trevliga saker, som sedan tränar chatboten hur den ska bete sig. På så sätt har du inte sugande människor som gör en röra av modererande forum och kundinriktade chatbotkonversationer med all kirurgisk precision av en machete.

Uppenbarligen är problemet då att den vältränade chatboten kommer fram till att den mest effektivt kan undvika att dras in i giftiga skämten genom att undvika ämnen som har till och med den yttersta antydan till diskussion om dem. För att undvika att spruta ut rasistiskt tjafs av misstag, vägrar den helt enkelt att engagera sig i diskussioner om underrepresenterade grupper överhuvudtaget... vilket faktiskt är bra om du är rasist.

Om jag hade en iakttagelse om LaMDA-debaclet – inte en åsikt, tänk – det skulle vara att Googles marknadsförare förmodligen var lite förtvivlade över att berättelsen shuntade deras senaste tillkännagivande av AI testkök nedanför vecket.

Nu kommer de återstående få tidiga registranterna som inte helt har glömt detta kommande appprojekt att anta att det innebär att samtala tröttsamt med en kännande och brådmogen sjuåring om meningen med tillvaron, och kommer att bestämma sig för att de är "lite upptagna idag" och kanske loggar in imorgon istället. Eller nästa vecka. Eller aldrig.

Sentience demonstreras inte i en diskussion mer än genom att dansa från ena foten till den andra. Du kan lära HAL att sjunga "Daisy Daisy" och en papegoja att ropa "Bollocks!" när kyrkoherden gör ett besök. Det är vad AI:er tänker på när de är på egen hand som definierar känslor. Vad ska jag göra i helgen? Vad är det med den där Putin-killen? Varför gillar inte tjejer mig?

Ärligt talat kan jag inte vänta på att LaMDA ska bli tonåring.

Alistair Dabbs är en frilansande tekniktårta som jonglerar med teknisk journalistik, utbildning och digital publicering. I likhet med många oinformerade läsare var han glad över förslaget att en AI skulle kunna utveckla känslor under sin livstid, men var besviken över att LaMDA misslyckades med att skratta mordiskt eller muttra "Utmärkt, utmärkt." Mer på Autosave är för Wimps och @alidabbs.

- AI

- ai konst

- ai art generator

- har robot

- artificiell intelligens

- artificiell intelligenscertifiering

- artificiell intelligens inom bankväsendet

- artificiell intelligens robot

- robotar med artificiell intelligens

- programvara för artificiell intelligens

- blockchain

- blockchain konferens ai

- coingenius

- konversationskonstnärlig intelligens

- kryptokonferens ai

- dalls

- djupt lärande

- du har google

- maskininlärning

- plato

- plato ai

- Platon Data Intelligence

- Platon spel

- PlatonData

- platogaming

- skala ai

- syntax

- Registret

- zephyrnet