Under de senaste åren har onlineutbildningsplattformar sett en ökad användning av och en ökning av efterfrågan på videobaserad inlärning eftersom det erbjuder ett effektivt medium för att engagera elever. För att expandera till internationella marknader och adressera en kulturellt och språkligt mångfaldig befolkning, tittar företag också på att diversifiera sina utbildningserbjudanden genom att lokalisera innehåll till flera språk. Dessa företag letar efter pålitliga och kostnadseffektiva sätt att lösa sina lokaliseringsanvändningsfall.

Lokalisering av innehåll innefattar främst att översätta originalröster till nya språk och lägga till visuella hjälpmedel som undertexter. Traditionellt är denna process kostsam, manuell och tar mycket tid, inklusive att arbeta med lokaliseringsspecialister. Med kraften i AWS maskininlärning (ML) tjänster som t.ex Amazon Transcribe, Amazon Translateoch Amazon Polly, kan du skapa en hållbar och kostnadseffektiv lokaliseringslösning. Du kan använda Amazon Transcribe för att skapa en transkription av dina befintliga ljud- och videoströmmar och sedan översätta denna transkription till flera språk med Amazon Translate. Du kan sedan använda Amazon Polly, en text-till-tal-tjänst, för att konvertera den översatta texten till naturligt klingande mänskligt tal.

Nästa steg i lokaliseringen är att lägga till undertexter till innehållet, vilket kan förbättra tillgängligheten och förståelsen och hjälpa tittarna att förstå videorna bättre. Att skapa undertexter på videoinnehåll kan vara utmanande eftersom det översatta talet inte stämmer överens med den ursprungliga talets timing. Denna synkronisering mellan ljud och undertexter är en viktig uppgift att överväga eftersom den kan koppla bort publiken från ditt innehåll om de inte är synkroniserade. Amazon Polly erbjuder en lösning på denna utmaning genom att möjliggöra talmärken, som du kan använda för att skapa en undertextfil som kan synkroniseras med den genererade talutgången.

I det här inlägget granskar vi en lokaliseringslösning som använder AWS ML-tjänster där vi använder en original engelsk video och konverterar den till spanska. Vi fokuserar också på att använda talmärken för att skapa en synkroniserad undertextfil på spanska.

Lösningsöversikt

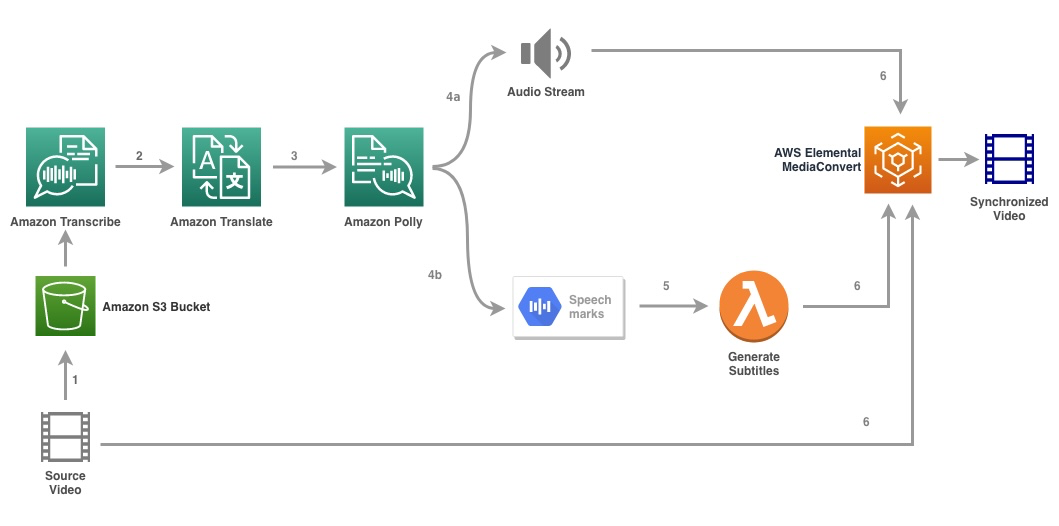

Följande diagram illustrerar lösningsarkitekturen.

Lösningen tar en videofil och målspråksinställningarna som indata och använder Amazon Transcribe för att skapa en transkription av videon. Vi använder sedan Amazon Translate för att översätta transkriptet till målspråket. Den översatta texten tillhandahålls som en input till Amazon Polly för att generera ljudströmmen och talmärken på målspråket. Amazon Polly återvänder utmatning av talmärken i en radavgränsad JSON-ström, som innehåller fälten som tid, typ, start, slut och värde. Värdet kan variera beroende på vilken typ av talmärke som efterfrågas i inmatningen, t.ex SSML, viseme, ord eller mening. För vårt exempel begärde vi att typ av talmärke as word. Med det här alternativet delar Amazon Polly upp en mening i sina enskilda ord i meningen och deras start- och sluttider i ljudströmmen. Med denna metadata bearbetas sedan talmärkena för att generera undertexterna för motsvarande ljudström som genereras av Amazon Polly.

Slutligen använder vi AWS Elemental MediaConvert för att återge den slutliga videon med det översatta ljudet och motsvarande undertexter.

Följande video visar det slutliga resultatet av lösningen:

AWS stegfunktioner arbetsflöde

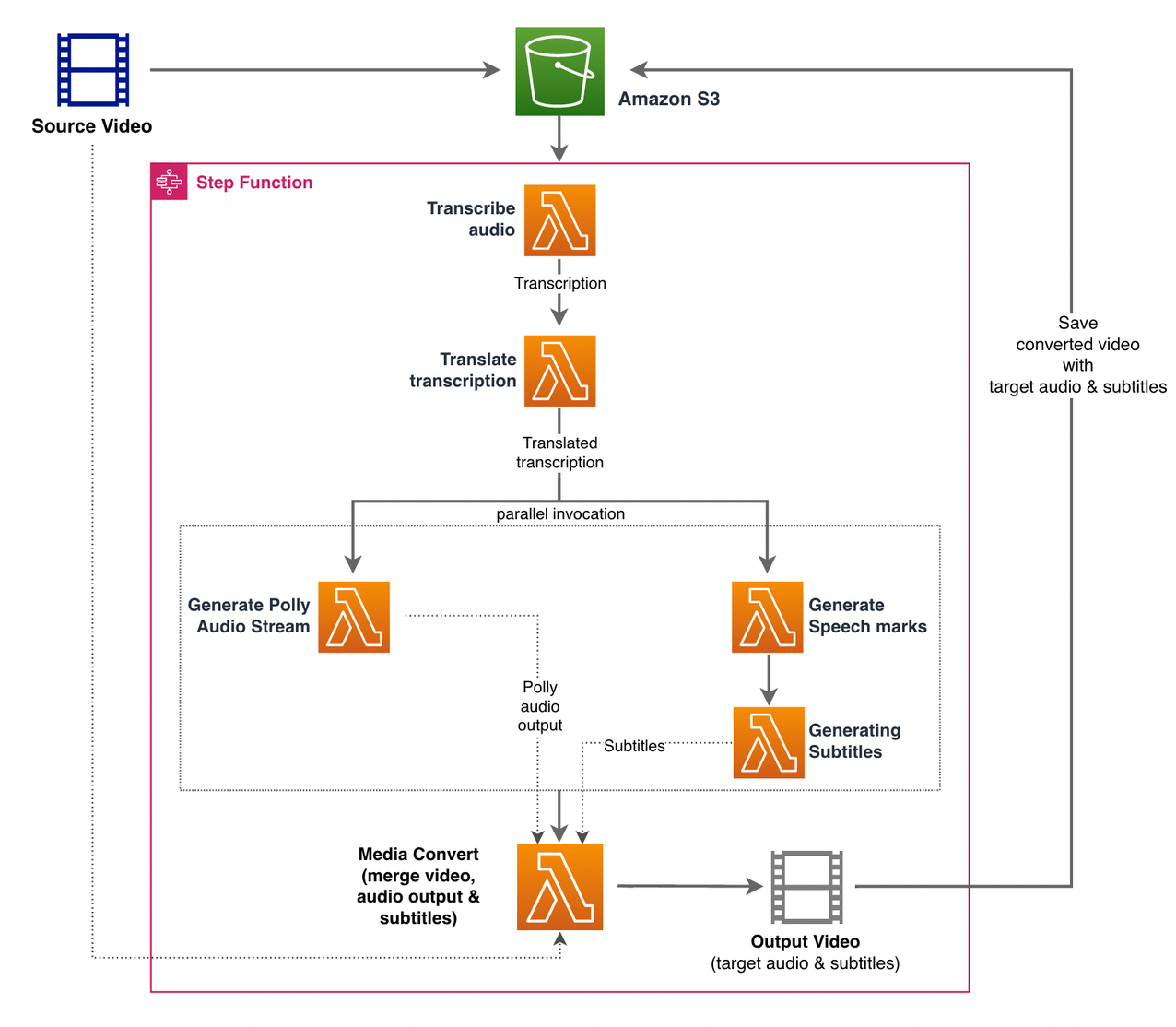

Vi använder AWS stegfunktioner att orkestrera denna process. Följande figur visar en vy på hög nivå av arbetsflödet för stegfunktioner (vissa steg har utelämnats från diagrammet för bättre tydlighet).

Arbetsflödesstegen är följande:

- En användare laddar upp källvideofilen till en Amazon enkel lagringstjänst (Amazon S3) hink.

- Smakämnen S3 händelseavisering utlöser AWS Lambda fungera state_machine.py (visas inte i diagrammet), vilket anropar tillståndsmaskinen för stegfunktioner.

- Det första steget, Transkribera ljud, anropar Lambda-funktionen transcribe.py, som använder Amazon Transcribe för att generera en transkription av ljudet från källvideon.

Följande exempelkod visar hur man skapar ett transkriptionsjobb med Amazon Transcribe Boto3 Python SDK:

När jobbet är klart sparas utdatafilerna i S3-hinken och processen fortsätter till nästa steg för att översätta innehållet.

- Smakämnen Översätt transkription steg anropar Lambda-funktionen translate.py som använder Amazon Translate för att översätta avskriften till målspråket. Här använder vi den synkrona/realtidsöversättningen med hjälp av översätt_text fungera:

Synkron översättning har begränsningar för dokumentstorleken den kan översätta; När detta skrivs är den inställd på 5,000 XNUMX byte. För större dokumentstorlekar, överväg att använda en asynkron väg för att skapa jobbet med start_text_translation_job och kontrollera status via beskriv_text_översättningsjobb.

- Nästa steg är ett Steg Funktioner Parallell stat, där vi skapar parallella grenar i vår statsmaskin.

- I den första grenen anropar vi lambdafunktionen lambdafunktionen generera_polly_audio.py för att generera vår Amazon Polly-ljudström:

Här använder vi start_speech_synthesis_task metod för Amazon Polly Python SDK för att utlösa talsyntesuppgiften som skapar Amazon Polly-ljudet. Vi ställer in

OutputFormattillmp3, som säger åt Amazon Polly att generera en ljudström för detta API-anrop. - I den andra grenen anropar vi Lambda-funktionen generera_speech_marks.py för att generera talmärken:

- I den första grenen anropar vi lambdafunktionen lambdafunktionen generera_polly_audio.py för att generera vår Amazon Polly-ljudström:

- Vi använder återigen start_speech_synthesis_task metod men specificera

OutputFormattilljson, som säger åt Amazon Polly att generera talmärken för detta API-anrop.

I nästa steg i den andra grenen anropar vi Lambda-funktionen generera_undertexter.py, som implementerar logiken för att generera en undertextfil från utmatningen av talmärken.

Den använder Python-modulen i filen webvtt_utils.py. Den här modulen har flera verktygsfunktioner för att skapa undertextfilen; en sådan metod get_phrases_from_speechmarks är ansvarig för att analysera speech marks-filen. Talmärkens JSON-struktur ger bara starttiden för varje ord individuellt. För att skapa den undertextning som krävs för SRT-filen, skapar vi först fraser med cirka n (där n=10) ord från listan över ord i speech marks-filen. Sedan skriver vi dem i SRT-filformatet, tar starttiden från det första ordet i frasen, och för sluttiden använder vi starttiden för ordet (n+1) och subtraherar det med 1 för att skapa den sekvenserade posten . Följande funktion skapar fraserna som förberedelse för att skriva dem till SRT-filen:

- Det sista steget, Medie Konvertera, anropar Lambda-funktionen create_mediaconvert_job.py att kombinera ljudströmmen från Amazon Polly och undertextfilen med källvideofilen för att generera den slutliga utdatafilen, som sedan lagras i en S3-hink. Detta steg använder

MediaConvert, en filbaserad videoomkodningstjänst med funktioner i sändningsklass. Den låter dig enkelt skapa video-on-demand-innehåll och kombinerar avancerade video- och ljudfunktioner med ett enkelt webbgränssnitt. Även här använder vi Python Boto3 SDK för att skapa enMediaConvertjobb:

Förutsättningar

Innan du börjar måste du ha följande förutsättningar:

Distribuera lösningen

Utför följande steg för att distribuera lösningen med AWS CDK:

- Klona Repository:

- För att säkerställa att AWS CDK är det stövlar, kör kommandot

cdk bootstrapfrån roten av förvaret: - Ändra arbetskatalogen till roten av förvaret och kör följande kommando:

Som standard är målljudinställningarna inställda på amerikansk spanska (es-US). Om du planerar att testa det med ett annat målspråk, använd följande kommando:

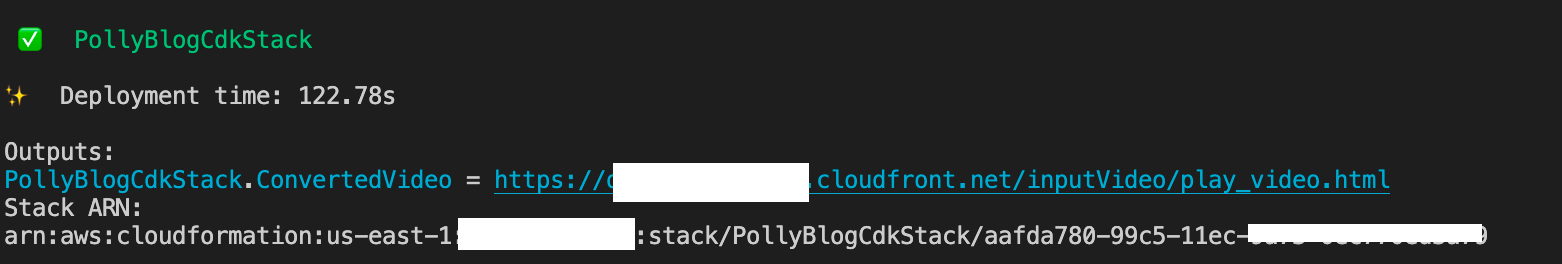

Processen tar några minuter att slutföra, varefter den visar en länk som du kan använda för att visa målvideofilen med översatt ljud och översatta undertexter.

Testa lösningen

För att testa denna lösning använde vi en liten del av följande AWS re:Invent 2017-video från YouTube, där Amazon Transcribe först introducerades. Du kan också testa lösningen med din egen video. Originalspråket för vår testvideo är engelska. När du distribuerar den här lösningen kan du ange målljudinställningarna eller så kan du använda standardinställningarna för målljud, som använder spanska för att generera ljud och undertexter. Lösningen skapar en S3-hink som kan användas för att ladda upp videofilen till.

- På Amazon S3-konsolen, navigera till hinken

PollyBlogBucket.

- Välj hink, navigera till

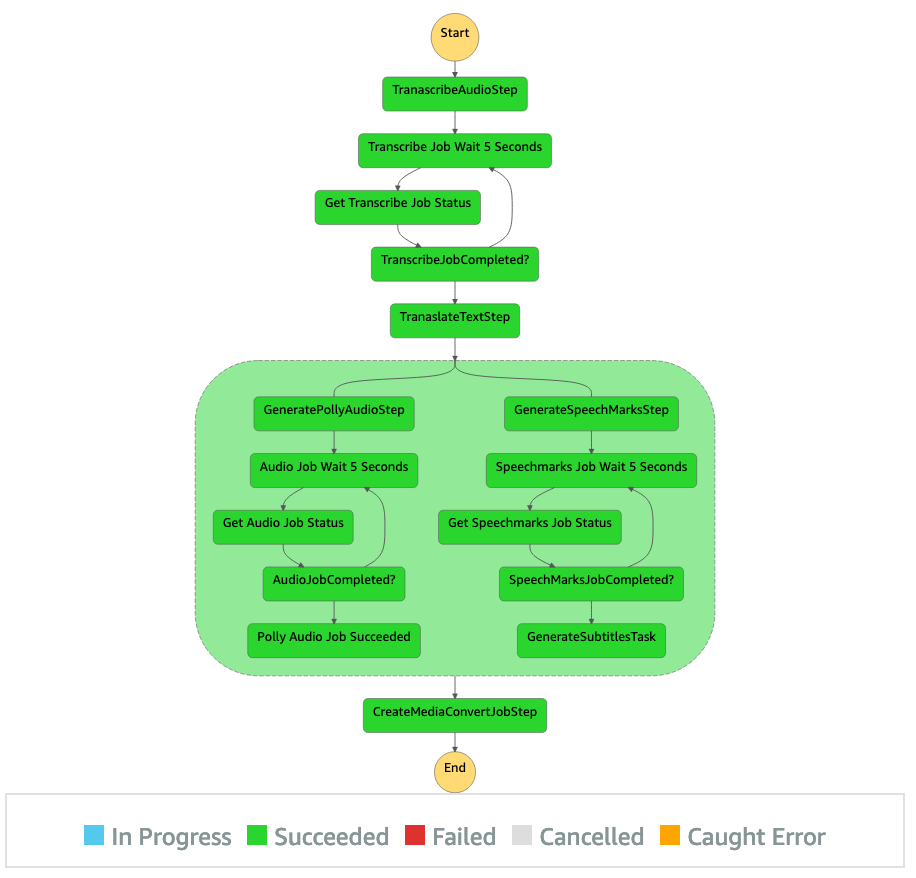

/inputVideokatalogen och ladda upp videofilen (lösningen testas med videor av typen mp4). Vid denna tidpunkt utlöser ett S3-händelsemeddelande Lambda-funktionen, som startar tillståndsmaskinen. - På Step Functions-konsolen bläddrar du till tillståndsmaskinen (

ProcessAudioWithSubtitles). - Välj en av körningarna av tillståndsmaskinen för att lokalisera Grafinspektör.

Detta visar körresultaten för varje stat. Arbetsflödet för Stegfunktioner tar några minuter att slutföra, varefter du kan verifiera om alla steg har slutförts.

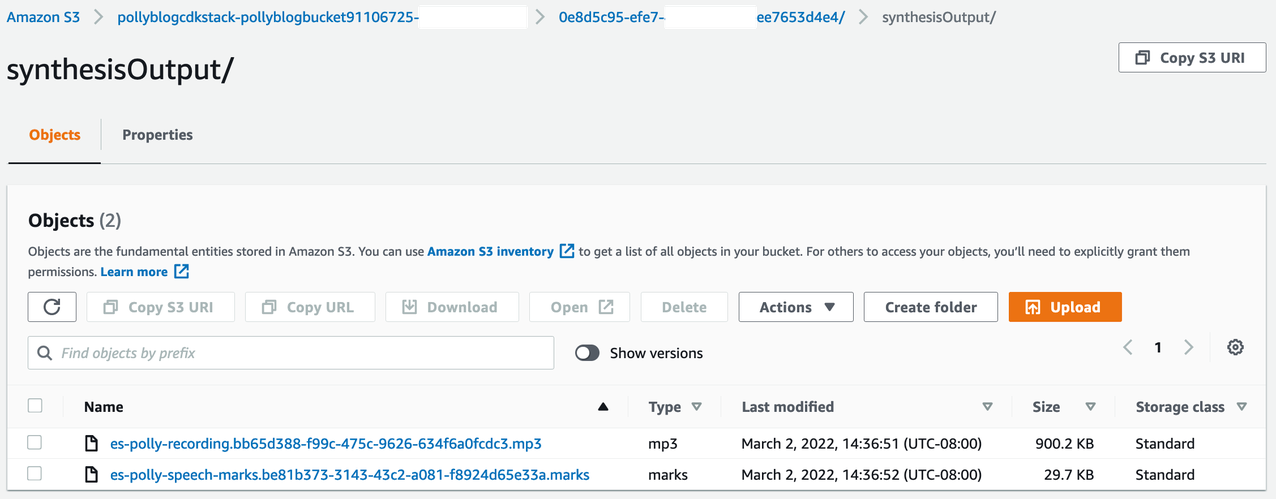

Granska utgången

För att granska utdata, öppna Amazon S3-konsolen och kontrollera om ljudfilen (.mp3) och talmärkesfilen (.marks) är lagrade i S3-hinken under <ROOT_S3_BUCKET>/<UID>/synthesisOutput/.

Följande är ett exempel på talmarkeringsfilen som genereras från den översatta texten:

I denna utgång är varje del av texten uppdelad i termer av talmärken:

- tid – Tidsstämpeln i millisekunder från början av motsvarande ljudström

- Typ – Typen av talmärke (mening, ord, viseme eller SSML)

- starta – Förskjutningen i byte (inte tecken) för början av objektet i inmatningstexten (exklusive visememärken)

- änden – Förskjutningen i byte (inte tecken) av objektets ände i inmatningstexten (exklusive visemmärken)

- värde – Enstaka ord i meningen

Den genererade undertextfilen skrivs tillbaka till S3-hinken. Du hittar filen under <ROOT_S3_BUCKET>/<UID>/subtitlesOutput/. Inspektera undertextfilen; innehållet ska likna följande text:

Efter att undertextfilen och ljudfilen har genererats skapas den slutliga källvideofilen med MediaConvert. Kontrollera MediaConvert-konsolen för att verifiera om jobbstatusen är COMPLETE.

När MediaConvert-jobbet är klart genereras den slutliga videofilen och sparas tillbaka till S3-hinken, som finns under <ROOT_S3_BUCKET>/<UID>/convertedAV/.

Som en del av denna distribution distribueras den slutliga videon via en Amazon CloudFront (CDN) länk och visas i terminalen eller i AWS molnformation konsol.

Öppna URL:en i en webbläsare för att se originalvideon med ytterligare alternativ för ljud och undertexter. Du kan verifiera att det översatta ljudet och undertexterna är synkroniserade.

Slutsats

I det här inlägget diskuterade vi hur man skapar nya språkversioner av videofiler utan behov av manuell intervention. Innehållsskapare kan använda denna process för att synkronisera ljud och undertexter på sina videor och nå en global publik.

Du kan enkelt integrera detta tillvägagångssätt i dina egna produktionspipelines för att hantera stora volymer och skala efter dina behov. Amazon Polly använder Neural TTS (NTTS) att producera naturliga och mänskliga text-till-tal-röster. Det stöder också genererar tal från SSML, vilket ger dig ytterligare kontroll över hur Amazon Polly genererar tal från den tillhandahållna texten. Amazon Polly tillhandahåller också en en mängd olika röster på flera språk för att stödja dina behov.

Kom igång med AWS maskininlärningstjänster genom att besöka Produktsida, eller hänvisa till Amazon Machine Learning Solutions Lab sida där du kan samarbeta med experter för att ta fram maskininlärningslösningar till din organisation.

Ytterligare resurser

För mer information om tjänsterna som används i den här lösningen, se följande:

Om författarna

Reagan Rosario arbetar som lösningsarkitekt på AWS med fokus på utbildningsteknikföretag. Han älskar att hjälpa kunder att bygga skalbara, högt tillgängliga och säkra lösningar i AWS-molnet. Han har mer än ett decenniums erfarenhet av att arbeta i en mängd olika teknikroller, med fokus på mjukvaruteknik och arkitektur.

Reagan Rosario arbetar som lösningsarkitekt på AWS med fokus på utbildningsteknikföretag. Han älskar att hjälpa kunder att bygga skalbara, högt tillgängliga och säkra lösningar i AWS-molnet. Han har mer än ett decenniums erfarenhet av att arbeta i en mängd olika teknikroller, med fokus på mjukvaruteknik och arkitektur.

Anil Kodali är en lösningsarkitekt med Amazon Web Services. Han arbetar med AWS EdTech-kunder och vägleder dem med arkitektoniska bästa praxis för att migrera befintliga arbetsbelastningar till molnet och designa nya arbetsbelastningar med molnet först. Innan han började med AWS arbetade han med stora återförsäljare för att hjälpa dem med deras molnmigrering.

Anil Kodali är en lösningsarkitekt med Amazon Web Services. Han arbetar med AWS EdTech-kunder och vägleder dem med arkitektoniska bästa praxis för att migrera befintliga arbetsbelastningar till molnet och designa nya arbetsbelastningar med molnet först. Innan han började med AWS arbetade han med stora återförsäljare för att hjälpa dem med deras molnmigrering.

Prasanna Saraswathi Krishnan är en lösningsarkitekt med Amazon Web Services och arbetar med EdTech-kunder. Han hjälper dem att driva sin molnarkitektur och datastrategi med hjälp av bästa praxis. Hans bakgrund är inom distribuerad datoranvändning, big data-analys och datateknik. Han brinner för maskininlärning och naturlig språkbehandling.

Prasanna Saraswathi Krishnan är en lösningsarkitekt med Amazon Web Services och arbetar med EdTech-kunder. Han hjälper dem att driva sin molnarkitektur och datastrategi med hjälp av bästa praxis. Hans bakgrund är inom distribuerad datoranvändning, big data-analys och datateknik. Han brinner för maskininlärning och naturlig språkbehandling.

- AI

- ai konst

- ai art generator

- har robot

- Amazon ML Solutions Lab

- Amazon Polly

- Amazon Transcribe

- Amazon Translate

- artificiell intelligens

- artificiell intelligenscertifiering

- artificiell intelligens inom bankväsendet

- artificiell intelligens robot

- robotar med artificiell intelligens

- programvara för artificiell intelligens

- AWS maskininlärning

- blockchain

- blockchain konferens ai

- coingenius

- konversationskonstnärlig intelligens

- kryptokonferens ai

- dalls

- djupt lärande

- du har google

- maskininlärning

- plato

- plato ai

- Platon Data Intelligence

- Platon spel

- PlatonData

- platogaming

- skala ai

- syntax

- zephyrnet