Att kunna avkoda hjärnvågor skulle kunna hjälpa patienter som har förlorat förmågan att tala att kommunicera igen, och kan i slutändan ge nya sätt för människor att interagera med datorer. Nu har Metaforskare visat att de kan se vilka ord någon är hörsel med hjälp av inspelningar från icke-invasiva hjärnskanningar.

Vår förmåga att sondera humant hjärnaktiviteten har förbättrats avsevärt under de senaste decennierna eftersom forskare har utvecklat en mängd olika hjärn-datorgränssnitt (BCI) teknologier som kan ge ett fönster in i våra tankar och avsikter.

De mest imponerande resultaten har kommit från invasiva inspelningsenheter, som implanterar elektroder direkt i hjärnan gray materia, kombinerat med AI som kan lära sig att tolkat hjärnans signaler. Under senare år har detta madet är möjligt att avkoda hela meningar från någons neurala aktivitet med 97 procents noggrannhet, och översättningsförsök handskriftsrörelser direkt i text vid jämförbara hastighetertill att sms:a.

Men att behöva implantera elektroder i någons hjärna har uppenbara nackdelar. Dessa riskfyllda procedurer är endast medicinskt motiverade för patienter som behöver hjärninspelning för att hjälpa till att lösa andra medicinska problem, såsom epilepsi. Och neurala sonder försämras med tiden, vilket ökar möjligheten att behöva byta ut dem regelbundet.

Det var därför forskare vid Metas forskningsavdelning för AI bestämde sig för att undersöka om de kunde uppnå liknande mål utan att kräva en farlig hjärnoperationy. I ett papper publiceras på förtrycksservern arXiv, teamet rapporterade att de har utvecklat ett AI-system som kan förutsäga vilka ord någon lyssnar på baserat på hjärnaktivitet som registrerats med hjälp av icke-invasiv hjärn-dator gränssnitt.

"Det är uppenbarligen extremt invasivt att stoppa in en elektrod i någons hjärna, säger Jean Remi King, forskare vid Facebook Artificial Intelligence Research (FAIR) Lab, berättade TID. "Så vi ville prova att använda icke-invasiva inspelningar av hjärnaktivitet. Och målet var att bygga ett AI-system som kan avkoda hjärnans svar på talade berättelser.”

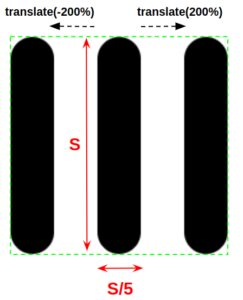

Forskarna förlitade sig på fyra redan existerande datauppsättningar för hjärnaktivitet som samlats in från 169 personer när de lyssnade på inspelningar av människor som pratade. Varje frivillig registrerades med antingen magneto-encefalografi (MEG) eller elektroencefalografi (EEG), som använder olika typer av sensorer för att fånga upp den elektriska aktiviteten i hjärnan från utsidan av skallen.

Deras tillvägagångssätt innebärd dela upp hjärnan och ljuddata till tre-andra långa utdrag och matar in det i ett neuralt nätverk som sedan tittared för mönster som cOuld koppla ihop de två. Efter att ha tränat AI:n på många timmar med denna data, testade de den sedan på tidigare osynliga data.

Systemet presterade bäst på en av MEG-datauppsättningarna, där det uppnådde en topp-10-noggrannhet på 72.5 procent. Det betyder att när det rankades 10 ord med högst sannolikhet att vara kopplade till hjärnvågsegmentet var det korrekta ordet där 72.5 procent av tiden.

Det kanske inte låter bra, men det är viktigt att komma ihåg att det valde från ett potentiellt ordförråd på 793 ord. Systemet fick 67.2 procent på den andra MEG-datauppsättningen, men klarade sig mindre bra på EEG-datauppsättningarna och fick topp-10 noggrannheter på endast 31.4 och 19.1.

Uppenbarligen är detta fortfarande långt ifrån ett praktiskt system, men det representerar betydande framsteg i ett svårt problem. Icke-invasiva BCI:er har mycket sämre signal-brus-förhållanden, så att dechiffrera neural aktivitet på detta sätt är utmanande, men om det lyckas kan det resultera i en mycket mer allmänt användbar teknologi.

Inte alla är dock övertygade om att det är ett lösbart problem. Thomas Knopfel från Imperial College London berättade New Scientist att försöka undersöka tankar med dessa icke-invasiva metoder var som "försöker streama en HD-film över gammaldags analoga telefonmodem”, och ifrågasatte om sådana tillvägagångssätt någonsin kommer att nå praktiska noggrannhetsnivåer.

Företag som Elon Musks Neuralink satsar också på att vi så småningom kommer att komma över vår bråkighet kring invasiva tillvägagångssätt när tekniken förbättras, vilket öppnar dörren för vanliga människor som får hjärnimplantat.

Men forskningen från teamet på Meta är i ett mycket tidigt skede, och det finns gott om utrymme för förbättringar. Och de kommersiella möjligheterna för alla som kan knäcka icke-invasiv hjärnskanning kommer sannolikt att ge massor av motivation för att försöka.