Att välja ut separata objekt i en visuell scen verkar intuitivt för oss, men maskiner kämpar med denna uppgift. Nu har en ny AI-modell från Meta utvecklat en bred idé om vad ett objekt är, vilket gör att det kan separera objekt även om det aldrig har sett dem tidigare.

Det kan verka som en ganska prosaisk datorseendeuppgift, men att kunna analysera en bild och räkna ut var ett objekt slutar och ett annat börjar är en ganska grundläggande färdighet, utan vilken en mängd mer komplicerade uppgifter skulle vara olösliga.

"Objektsegmentering" är inget nytt; AI-forskare har arbetat med det i flera år. Men vanligtvis har att bygga dessa modeller varit en tidskrävande process som kräver massor av mänskliga kommentarer av bilder och betydande datorresurser. Och typiskt sett var de resulterande modellerna mycket specialiserade för särskilda användningsfall.

Men nu har forskare på Meta avslöjat Segment Anything Model (SAM), som kan skära ut vilket objekt som helst i vilken scen som helst, oavsett om det har sett något liknande tidigare. Modellen kan också göra detta som svar på en mängd olika uppmaningar, från textbeskrivning till musklick eller till och med eyetracking-data.

"SAM har lärt sig en allmän uppfattning om vad objekt är, och det kan generera masker för vilket objekt som helst i vilken bild eller vilken video som helst", skrev forskarna i en blogg inlägg. "Vi tror att möjligheterna är breda och vi är glada över de många potentiella användningsfallen som vi inte ens har föreställt oss ännu."

Nyckeln till utvecklingen av modellen var en massiv ny datamängd med 1.1 miljarder segmenteringsmasker, som hänvisar till regioner i en bild som har isolerats och kommenterats för att ange att de innehåller ett visst objekt. Den skapades genom en kombination av manuell mänsklig kommentar av bilder och automatiserade processer, och är den överlägset största samlingen av denna typ som har samlats hittills.

Genom att träna på en så massiv datauppsättning säger Metas forskare att de har utvecklat ett allmänt koncept för vad ett objekt är, vilket gör att det kan segmentera saker som det inte ens har sett tidigare. Denna förmåga att generalisera fick forskarna att kalla SAM en "grundmodell", en kontroversiell term används för att beskriva andra massiva förtränade modeller som t.ex OpenAI:s GPT serie, vars kapacitet förmodligen är så generell att de kan användas som grunden för en mängd applikationer.

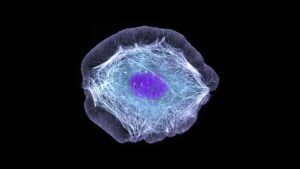

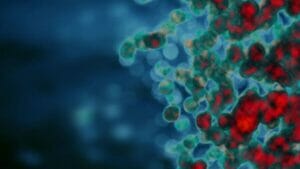

Bildsegmentering är definitivt en nyckelingrediens i ett brett utbud av datorseende uppgifter. Om du inte kan separera de olika komponenterna i en scen är det svårt att göra något mer komplicerat med den. I sin blogg säger forskarna att det kan visa sig vara ovärderligt vid video- och bildredigering, eller hjälpa till med analys av vetenskapliga bilder.

Kanske mer relevant för företagets metaversa ambitioner ger de en demo av hur det kan användas tillsammans med ett virtual reality-headset för att välja specifika objekt baserat på användarens blick. De säger också att det potentiellt skulle kunna kopplas ihop med en stor språkmodell för att skapa ett multimodalt system som kan förstå både det visuella och textmässiga innehållet på en webbsida.

Möjligheten att hantera ett brett utbud av uppmaningar gör systemet extra flexibelt. I en för vatten. genom att demonstrera den nya modellen visar företaget att det efter att ha analyserat en bild kan uppmanas att separera specifika objekt genom att helt enkelt klicka på dem med en muspekare, skriva in vad det är du vill segmentera, eller bara dela upp hela bilden i separata objekt.

Och viktigast av allt är att företaget öppnar både modellen och datasetet för forskningsändamål så att andra kan bygga vidare på deras arbete. Detta är samma tillvägagångssätt som företaget tog med sin LLaMA-storspråkiga modell, vilket ledde till att det snabbt blev det läckte på nätet och sporrar a våg av experiment av hobbyister och hackare.

Huruvida samma sak kommer att hända med SAM återstår att se, men hur som helst är det en gåva till AI-forskargemenskapen som kan påskynda framstegen med en mängd viktiga datorseendeproblem.

Image Credit: Meta ai

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- Platoblockchain. Web3 Metaverse Intelligence. Kunskap förstärkt. Tillgång här.

- Källa: https://singularityhub.com/2023/04/10/metas-new-ai-can-identify-and-remove-objects-in-images/

- :är

- $UPP

- 1

- a

- förmåga

- Able

- accelerera

- Efter

- AI

- ai forskning

- tillåta

- tillåter

- ambitioner

- analys

- analys

- och

- Annan

- tillämpningar

- tillvägagångssätt

- ÄR

- AS

- sammansatta

- At

- Automatiserad

- baserat

- BE

- innan

- Där vi får lov att vara utan att konstant prestera,

- tro

- Miljarder

- Blogg

- Breaking

- bred

- SLUTRESULTAT

- Byggnad

- by

- KAN

- kapacitet

- fall

- samling

- kombination

- samfundet

- företag

- Företagets

- komplicerad

- komponenter

- dator

- Datorsyn

- databehandling

- begrepp

- betydande

- innehålla

- innehåll

- kunde

- skapa

- skapas

- kredit

- Klipp

- datum

- Datum

- behandla

- definitivt

- beskriva

- beskrivning

- utvecklade

- Utveckling

- olika

- antingen

- slutar

- Hela

- Även

- exciterade

- ganska

- flexibel

- För

- Stiftelser

- från

- grundläggande

- Allmänt

- generera

- present

- hackare

- hända

- Hård

- Har

- headset

- hjälpa

- höggradigt

- värd

- Hur ser din drömresa ut

- HTTPS

- humant

- Tanken

- bild

- bilder

- med Esport

- in

- intuitiv

- ovärderlig

- isolerat

- IT

- DESS

- Nyckel

- språk

- Large

- största

- lärt

- Led

- tycka om

- Lama

- Maskiner

- GÖR

- manuell

- många

- Masker

- massiv

- meta

- Metavers

- kanske

- modell

- modeller

- mer

- mest

- Nya

- Begrepp

- objektet

- objekt

- of

- on

- ONE

- Övriga

- Övrigt

- sida

- parade

- särskilt

- särskilt

- plocka

- plato

- Platon Data Intelligence

- PlatonData

- Möjligheterna

- potentiell

- potentiellt

- pretty

- problem

- process

- processer

- Framsteg

- Bevisa

- ge

- syfte

- område

- snabbt

- Verkligheten

- hänvisar

- Oavsett

- regioner

- resterna

- forskning

- forskare

- Resurser

- respons

- resulterande

- Sam

- Samma

- scen

- vetenskaplig

- verkar

- segmentet

- segmentering

- separat

- Serier

- Visar

- helt enkelt

- skicklighet

- So

- specialiserad

- specifik

- Kamp

- sådana

- system

- uppgift

- uppgifter

- den där

- Smakämnen

- deras

- Dem

- Dessa

- saker

- Genom

- tidskrävande

- till

- Utbildning

- typiskt

- förstå

- avtäckt

- us

- användning

- mängd

- Video

- Virtuell

- Virtual reality

- syn

- Sätt..

- webb

- Vad

- om

- som

- bred

- Brett utbud

- kommer

- med

- utan

- Arbete

- träna

- arbetade

- skulle

- år

- Om er

- zephyrnet