Globalt har det skett en accelererad övergång mot friktionsfria digitala användarupplevelser. Oavsett om det handlar om att registrera sig på en webbplats, göra transaktioner online eller helt enkelt logga in på ditt bankkonto, försöker organisationer aktivt att minska friktionen som deras kunder upplever samtidigt som de förbättrar sina åtgärder för säkerhet, efterlevnad och bedrägeriförebyggande. Skiftet mot friktionsfria användarupplevelser har gett upphov till ansiktsbaserade biometriska identitetsverifieringslösningar som syftar till att svara på frågan "Hur verifierar man en person i den digitala världen?"

Det finns två viktiga fördelar med ansiktsbiometri när det gäller frågor om identifiering och autentisering. För det första är det en praktisk teknik för användarna: det finns inget behov av att komma ihåg ett lösenord, hantera utmaningar med flera faktorer, klicka på verifieringslänkar eller lösa CAPTCHA-pussel. För det andra uppnås en hög säkerhetsnivå: identifiering och autentisering på basis av ansiktsbiometri är säker och mindre känslig för bedrägerier och attacker.

I det här inlägget dyker vi ner i de två primära användningsfallen för identitetsverifiering: onboarding och autentisering. Sedan dyker vi ner i de två nyckelmåtten som används för att utvärdera ett biometriskt systems noggrannhet: falsk matchningsfrekvens (även känd som falsk acceptansfrekvens) och falsk icke-matchningsfrekvens (även känd som falsk avvisningsfrekvens). Dessa två mått används i stor utsträckning av organisationer för att utvärdera noggrannhet och felfrekvens för biometriska system. Slutligen diskuterar vi ett ramverk och bästa praxis för att utföra en utvärdering av en identitetsverifieringstjänst.

Se medföljande Jupyter anteckningsbok som går igenom alla steg som nämns i det här inlägget.

Användningsfall: Onboarding och autentisering

Det finns två primära användningsfall för biometriska lösningar: användarintroduktion (ofta kallad verifiering) och autentisering (ofta kallad identifiering). Onboarding innebär en-till-en-matchning av ansikten mellan två bilder, till exempel att jämföra en selfie med ett pålitligt identifieringsdokument som ett körkort eller pass. Autentisering, å andra sidan, innebär en-till-många-sökning av ett ansikte mot en lagrad samling ansikten, till exempel genomsökning av en samling av anställdas ansikten för att se om en anställd har behörighet till en viss våning i en byggnad.

Noggrannhetsprestandan för användningsfall för onboarding och autentisering mäts av de falska positiva och falska negativa felen som den biometriska lösningen kan göra. Ett likhetspoäng (som sträcker sig från 0 % betyder ingen matchning till 100 % betyder perfekt matchning) används för att bestämma en match eller ett icke-matchande beslut. Ett falskt positivt uppstår när lösningen anser att bilder av två olika individer är samma person. Ett falskt negativt å andra sidan betyder att lösningen ansåg två bilder av samma person vara olika.

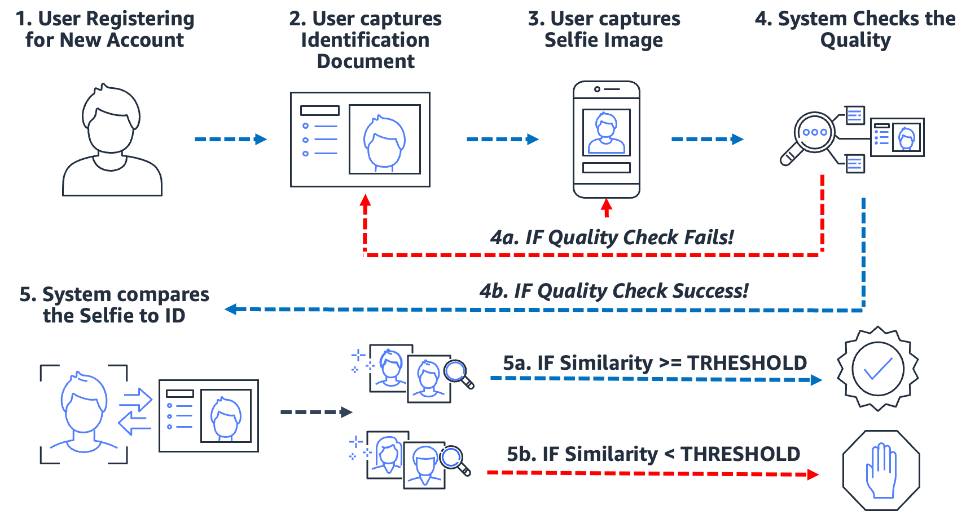

Onboarding: En-till-en-verifiering

Biometriskt baserade onboardingprocesser både förenklar och säkrar processen. Viktigast av allt, det förbereder organisationen och kunden för en nästan friktionsfri onboard-upplevelse. För att göra detta måste användarna helt enkelt visa upp en bild av någon form av pålitlig identifieringshandling som innehåller användarens ansikte (som körkort eller pass) samt ta en selfiebild under introduktionsprocessen. Efter att systemet har dessa två bilder jämför det helt enkelt ansiktena i de två bilderna. När likheten är större än en angiven tröskel, då har du en matchning; annars har du en icke-match. Följande diagram beskriver processen.

Tänk på exemplet med Julie, en ny användare som öppnar ett digitalt bankkonto. Lösningen uppmanar henne att ta en bild av sitt körkort (steg 2) och ta en selfie (steg 3). Efter att systemet kontrollerat kvaliteten på bilderna (steg 4), jämför det ansiktet i selfien med ansiktet på körkortet (en-till-en-matchning) och ett likhetspoäng (steg 5) tas fram. Om likhetspoängen är mindre än den erforderliga likhetströskeln, avvisas instigningsförsöket av Julie. Detta är vad vi kallar en falsk icke-matchning eller falsk avvisning: lösningen ansåg två bilder av samma person vara olika. Å andra sidan, om likhetspoängen var större än den nödvändiga likheten, anser lösningen att de två bilderna är samma person eller en matchning.

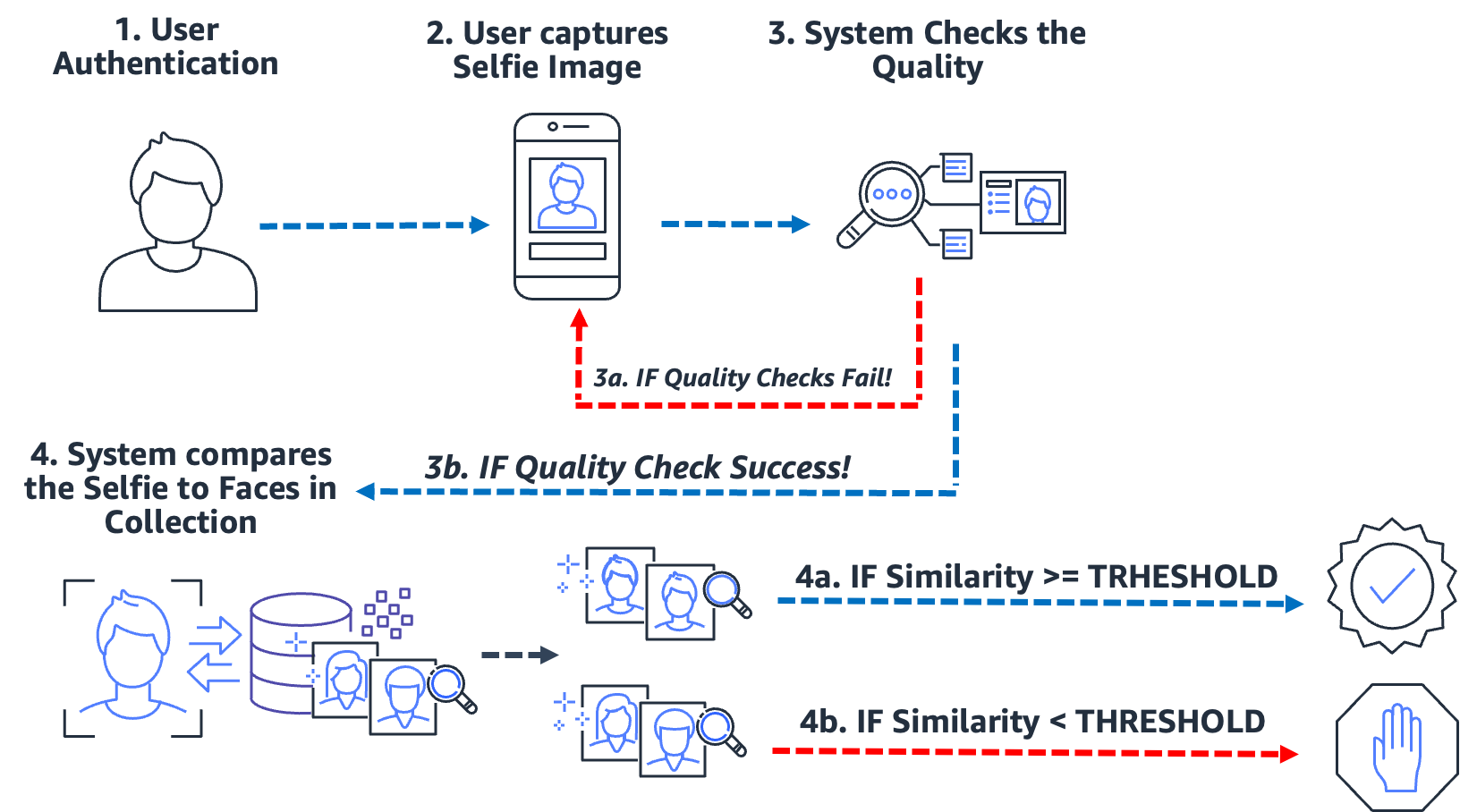

Autentisering: En-till-många-identifiering

Från att gå in i en byggnad, till att checka in i en kiosk, till att uppmana en användare att göra en selfie för att verifiera sin identitet, den här typen av noll-till-låg-friktion-autentisering via ansiktsigenkänning har blivit vanligt för många organisationer. Istället för att utföra bild-till-bild-matchning tar detta användningsfall för autentisering en enda bild och jämför den med en sökbar samling bilder för en potentiell matchning. I ett typiskt autentiseringsfall uppmanas användaren att ta en selfie, som sedan jämförs med ansikten som lagras i samlingen. Resultatet av sökningen ger noll, en eller flera potentiella matchningar med motsvarande likhetspoäng och externa identifierare. Om ingen matchning returneras, är användaren inte autentiserad; Men förutsatt att sökningen ger en eller flera matchningar, fattar systemet autentiseringsbeslutet baserat på likhetspoäng och externa identifierare. Om likhetspoängen överstiger den erforderliga likhetströskeln och den externa identifieraren matchar den förväntade identifieraren, så autentiseras (matchas) användaren. Följande diagram beskriver ett exempel på en ansiktsbaserad biometrisk autentiseringsprocess.

Tänk på exemplet med Jose, en leveransförare för gigekonomi. Leveranstjänsten autentiserar leveransförare genom att uppmana föraren att ta en selfie innan en leverans påbörjas med hjälp av företagets mobilapplikation. Ett problem för tjänsteleverantörer inom spelningsekonomin är att dela jobb; i huvudsak delar två eller flera användare samma konto för att kunna spela systemet. För att bekämpa detta använder många leveranstjänster en kamera i bilen för att ta bilder (steg 2) av föraren vid slumpmässiga tidpunkter under en leverans (för att säkerställa att leveransföraren är den auktoriserade föraren). I det här fallet tar Jose inte bara en selfie i början av sin förlossning, utan en kamera i bilen tar bilder av honom under förlossningen. Systemet utför kvalitetskontroller (steg 3) och söker (steg 4) i samlingen av registrerade förare för att verifiera förarens identitet. Om en annan drivrutin upptäcks kan gig-ekonomins leveranstjänst undersöka ytterligare.

En falsk matchning (falsk positiv) uppstår när lösningen ansåg att två eller flera bilder av olika personer var samma person. I vårt användningsfall, anta att José istället för den auktoriserade föraren låter sin bror Miguel ta en av hans leveranser åt honom. Om lösningen felaktigt matchar Miguels selfie med bilderna av Jose, uppstår en falsk matchning (falsk positiv).

För att bekämpa potentialen för falska matchningar rekommenderar vi att samlingarna innehåller flera bilder av varje ämne. Det är vanligt att indexera betrodda identifieringsdokument som innehåller ett ansikte, en selfie vid tidpunkten för ombordstigning och selfies från de senaste identifieringskontrollerna. Att indexera flera bilder av ett motiv ger möjligheten att aggregera likhetspoängen över returnerade ansikten, och därigenom förbättra identifieringens noggrannhet. Dessutom används externa identifierare för att begränsa risken för ett falskt godkännande. Ett exempel på affärsregel kan se ut så här:

OM aggregerad likhetspoäng >= nödvändig likhetströskel OCH extern identifierare == förväntad identifierare Autentisera DÅ

Viktiga biometriska noggrannhetsmått

I ett biometriskt system är vi intresserade av falsk matchningsfrekvens (FMR) och falsk icke-matchningsfrekvens (FNMR) baserat på likhetspoängen från ansiktsjämförelser och sökningar. Oavsett om det är ett användningsfall för onboarding eller autentisering, beslutar biometriska system att acceptera eller avvisa matchningar av en användares ansikte baserat på likhetspoängen för två eller flera bilder. Liksom alla beslutssystem kommer det att finnas fel där systemet felaktigt accepterar eller avvisar ett försök till onboarding eller autentisering. Som en del av att utvärdera din identitetsverifieringslösning måste du utvärdera systemet vid olika likhetströsklar för att minimera falska matchningar och falska icke-matchningar, samt jämföra dessa fel mot kostnaden för att göra felaktiga avslag och accepteringar. Vi använder FMR och FNMR som våra två nyckelmått för att utvärdera ansiktsbiometriska system.

Falsk icke-matchningsfrekvens

När identitetsverifieringssystemet inte korrekt identifierar eller auktoriserar en äkta användare uppstår en falsk icke-matchning, även känd som ett falskt negativt. Falsk non-match rate (FNMR) är ett mått på hur benäget systemet är att felaktigt identifiera eller auktorisera en äkta användare.

FNMR uttrycks som en procentandel av fall där ett onboarding- eller autentiseringsförsök görs, där användarens ansikte felaktigt avvisas (ett falskt negativt resultat) eftersom likhetspoängen ligger under den föreskrivna tröskeln.

En sann positiv (TP) är när lösningen anser att två eller flera bilder av samma person är desamma. Det vill säga likheten i jämförelsen eller sökningen ligger över den erforderliga likhetströskeln.

Ett falskt negativt (FN) är när lösningen anser att två eller flera bilder av samma person är olika. Det vill säga likheten i jämförelsen eller sökningen ligger under den nödvändiga likhetströskeln.

Formeln för FNMR är:

FNMR = Falskt negativt antal / (True Positive Count + False Negative Count)

Anta till exempel att vi har 10,000 100 äkta autentiseringsförsök men 9,900 nekas eftersom deras likhet med referensbilden eller samlingen faller under den angivna likhetströskeln. Här har vi 100 1.0 sanna positiva och XNUMX falska negativa, därför är vår FNMR XNUMX %

FNMR = 100 / (9900 + 100) eller 1.0 %

Falsk matchningsfrekvens

När ett identitetsverifieringssystem felaktigt identifierar eller auktoriserar en obehörig användare som äkta, uppstår en falsk matchning, även känd som en falsk positiv. Den falska matchningsfrekvensen (FMR) är ett mått på hur benäget systemet är att felaktigt identifiera eller auktorisera en obehörig användare. Det mäts med antalet falska positiva erkännanden eller autentiseringar dividerat med det totala antalet identifieringsförsök.

Ett falskt positivt uppstår när lösningen anser att två eller flera bilder av olika personer är samma person. Det vill säga likhetspoängen för jämförelsen eller sökningen ligger över den erforderliga likhetströskeln. I huvudsak identifierar eller auktoriserar systemet felaktigt en användare när det borde ha avvisat deras identifierings- eller autentiseringsförsök.

Formeln för FMR är:

FMR = False Positive Count / (Totalt antal försök)

Anta till exempel att vi har 100,000 100 autentiseringsförsök men 100 falska användare är felaktigt auktoriserade eftersom deras likhet med referensbilden eller samlingen faller över den angivna likhetströskeln. Här har vi 0.01 falska positiva, därför är vår FMR XNUMX%

FMR = 100 / (100,000 0.01) eller XNUMX %

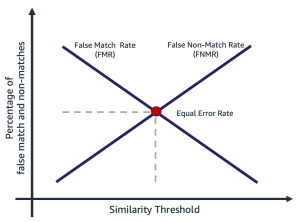

Frekvens för falsk matchning kontra falsk icke-matchningsfrekvens

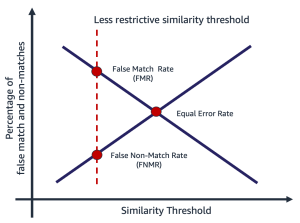

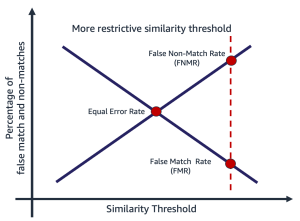

Falsk matchningsfrekvens och falsk icke-matchningsfrekvens står i motsats till varandra. När likhetströskeln ökar, minskar potentialen för en falsk matchning, medan potentialen för en falsk icke-matchning ökar. Ett annat sätt att tänka på denna avvägning är att när likhetströskeln ökar, blir lösningen mer restriktiv, vilket gör färre låga likhetsmatchningar. Till exempel är det vanligt att användningsfall som involverar allmän säkerhet och säkerhet sätter en tröskel för matchningslikhet ganska hög (99 och högre). Alternativt kan en organisation välja en mindre restriktiv likhetströskel (90 och högre), där påverkan av friktion för användaren är viktigare. Följande diagram illustrerar dessa avvägningar. Utmaningen för organisationer är att hitta en tröskel som minimerar både FMR och FNMR baserat på dina organisations- och applikationskrav.

Att välja en likhetströskel beror på affärsapplikationen. Anta till exempel att du vill begränsa kundfriktionen under onboarding (en mindre restriktiv likhetströskel, som visas i följande figur till vänster). Här kanske du har en lägre erforderlig likhetströskel, och är villig att acceptera risken att gå ombord på användare där förtroendet för matchningen mellan deras selfie och körkort är lägre. Anta däremot att du vill säkerställa att endast auktoriserade användare kommer in i ett program. Här kan du arbeta vid en ganska restriktiv likhetströskel (som visas i bilden till höger).

|

|

Steg för att beräkna falsk matchning och icke-matchning

Det finns flera sätt att beräkna dessa två mätvärden. Följande är ett relativt enkelt tillvägagångssätt för att dela upp stegen i att samla äkta bildpar, skapa en bedragarparning (bilder som inte borde matcha), och slutligen använda en sond för att loopa över de förväntade matchande och icke-matchande bildparen, fånga resulterande likhet. Stegen är som följer:

- Samla ett äkta exempelbildset. Vi rekommenderar att börja med en uppsättning bildpar och tilldela en extern identifierare, som används för att göra en officiell matchavgörande. Paret består av följande bilder:

- Källbild – Din betrodda källbild, till exempel ett körkort.

- Målbild – Din selfie eller bild du ska jämföra med.

- Samla en bilduppsättning av bedragare. Dessa är par av bilder där källan och målet inte matchar. Detta används för att bedöma FMR (sannolikheten att systemet felaktigt kommer att matcha ansiktena på två olika användare). Du kan skapa en bedragare bilduppsättning med bildparen genom att skapa en kartesisk produkt av bilderna och sedan filtrera och sampla resultatet.

- Undersök de äkta och bedragare matchningsuppsättningarna genom att gå över bildparen, jämföra källan och bedragarmålet och fånga den resulterande likheten.

- Beräkna FMR och FNMR genom att beräkna de falska positiva och falska negativa vid olika minimilikhetströsklar.

Du kan bedöma kostnaden för FMR och FNMR vid olika likhetströsklar i förhållande till din ansökans behov.

Steg 1: Samla äkta bildparprover

Att välja ett representativt urval av bildpar att utvärdera är avgörande när man utvärderar en identitetsverifieringstjänst. Det första steget är att identifiera en äkta uppsättning bildpar. Dessa är kända käll- och målbilder av en användare. Den äkta bildparningen används för att bedöma FNMR, i huvudsak sannolikheten att systemet inte matchar två ansikten på samma person. En av de första frågorna som ofta ställs är "Hur många bildpar behövs?" Svaret är att det beror på ditt användningsfall, men den allmänna vägledningen är följande:

- Mellan 100–1,000 XNUMX bildpar ger ett mått på genomförbarheten

- Upp till 10,000 XNUMX bildpar är tillräckligt stort för att mäta variationer mellan bilder

- Mer än 10,000 XNUMX bildpar ger ett mått på driftkvalitet och generaliserbarhet

Mer data är alltid bättre; Använd dock som utgångspunkt minst 1,000 10,000 bildpar. Det är dock inte ovanligt att använda mer än XNUMX XNUMX bildpar för att nollställa en acceptabel FNMR eller FMR för ett givet affärsproblem.

Följande är ett exempel på bildparmappningsfil. Vi använder bildparmappningsfilen för att driva resten av utvärderingsprocessen.

| EXTERNAL_ID | KÄLLA | MÅL | TEST |

| 9055 | 9055_M0.jpeg | 9055_M1.jpeg | äkta |

| 19066 | 19066_M0.jpeg | 19066_M1.jpeg | äkta |

| 11396 | 11396_M0.jpeg | 11396_M1.jpeg | äkta |

| 12657 | 12657_M0.jpeg | 12657_M1.jpeg | äkta |

| . | . | . | . |

Steg 2: Skapa ett bedragare bildpar in

Nu när du har en fil med äkta bildpar kan du skapa en kartesisk produkt av mål- och källbilder där de externa identifierarna inte fungerar. Detta ger källa-till-mål-par som inte borde matcha. Denna parning används för att bedöma FMR, i huvudsak sannolikheten att systemet kommer att matcha ansiktet på en användare med ansiktet på en annan användare.

| extern_id | KÄLLA | MÅL | TEST |

| 114192 | 114192_4M49.jpeg | 307107_00M17.jpeg | Bedragare |

| 105300 | 105300_04F42.jpeg | 035557_00M53.jpeg | Bedragare |

| 110771 | 110771_3M44.jpeg | 120381_1M33.jpeg | Bedragare |

| 281333 | 281333_04F35.jpeg | 314769_01M17.jpeg | Bedragare |

| 40081 | 040081_2F52.jpeg | 326169_00F32.jpeg | Bedragare |

| . | . | . | . |

Steg 3: Undersök de äkta och falska bildparseten

Med hjälp av ett drivrutinsprogram tillämpar vi Amazon-erkännande Jämför Faces API över bildparen och fånga likheten. Du kan också fånga ytterligare information som pose, kvalitet och andra resultat av jämförelsen. Likhetspoängen används för att beräkna antalet falska matchningar och icke-matchningar i följande steg.

I följande kodavsnitt tillämpar vi CompareFaces API på alla bildpar och fyller i alla likhetspoäng i en tabell:

Kodavsnittet ger följande utdata.

| EXTERNAL_ID | KÄLLA | MÅL | TEST | LIKHET |

| 9055 | 9055_M0.jpeg | 9055_M1.jpeg | äkta | 98.3 |

| 19066 | 19066_M0.jpeg | 19066_M1.jpeg | äkta | 94.3 |

| 11396 | 11396_M0.jpeg | 11396_M1.jpeg | äkta | 96.1 |

| . | . | . | . | . |

| 114192 | 114192_4M49.jpeg | 307107_00M17.jpeg | Bedragare | 0.0 |

| 105300 | 105300_04F42.jpeg | 035557_00M53.jpeg | Bedragare | 0.0 |

| 110771 | 110771_3M44.jpeg | 120381_1M33.jpeg | Bedragare | 0.0 |

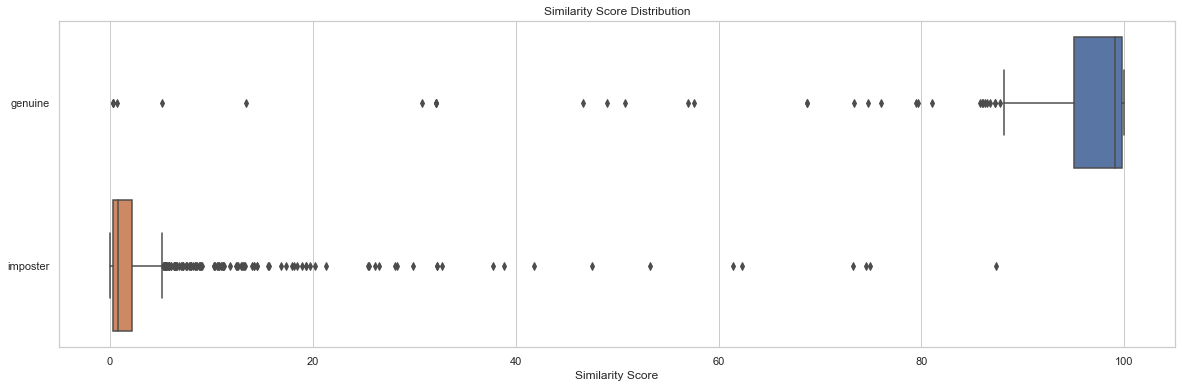

Distributionsanalys av likhetspoäng genom test är en utgångspunkt för att förstå likhetspoängen efter bildpar. Följande kodavsnitt och utdatadiagram visar ett enkelt exempel på fördelningen av likhetspoäng efter testuppsättning samt resulterande beskrivande statistik:

| testa | räkna | min | max | betyda | median | std |

| verklig | 204 | 0.2778 | 99.9957 | 91.7357 | 99.0961 | 19.9097 |

| bedragare | 1020 | 0.0075 | 87.3893 | 2.8111 | 0.8330 | 7.3496 |

I det här exemplet kan vi se att medel- och medianlikheten för äkta ansiktspar var 91.7 och 99.1, medan för bedragarparen var 2.8 respektive 0.8. Som förväntat visar detta de höga likhetspoängen för äkta bildpar och låga likhetspoäng för bedragare bildpar.

Steg 4: Beräkna FMR och FNMR vid olika likhetströskelnivåer

I det här steget beräknar vi andelen falsk matchning och icke-matchning vid olika tröskelvärden för likhet. För att göra detta går vi helt enkelt igenom likhetströsklar (till exempel 90–100). Vid varje vald likhetströskel beräknar vi vår förvirringsmatris som innehåller sanna positiva, sanna negativa, falska positiva och falska negativa räkningar, som används för att beräkna FMR och FNMR vid varje vald likhet.

| Faktisk | |||

| förutspått | |||

| . | Match | Ingen match | |

| >= vald likhet | TP | FP | |

| < vald likhet | FN | TN | |

För att göra detta skapar vi en funktion som returnerar de falska positiva och negativa siffrorna och går igenom en rad likhetspoäng (90–100):

Följande tabell visar resultaten av räkningarna vid varje likhetströskel.

| Likhetströskel | TN | FN | TP | FP | FNMR | FMR |

| 80 | 1019 | 22 | 182 | 1 | 0.1% | 0.1% |

| 85 | 1019 | 23 | 181 | 1 | 0.11% | 0.1% |

| 90 | 1020 | 35 | 169 | 0 | 0.12% | 0.0% |

| 95 | 1020 | 51 | 153 | 0 | 0.2% | 0.0% |

| 96 | 1020 | 53 | 151 | 0 | 0.25% | 0.0% |

| 97 | 1020 | 60 | 144 | 0 | 0.3% | 0.0% |

| 98 | 1020 | 75 | 129 | 0 | 0.4% | 0.0% |

| 99 | 1020 | 99 | 105 | 0 | 0.5% | 0.0% |

Hur påverkar likhetströskeln andelen falska icke-matchningar?

Anta att vi har 1,000 10 äkta användarintroduktionsförsök och att vi avvisar 95 av dessa försök baserat på en nödvändig minsta likhet på 10 % för att betraktas som en matchning. Här avvisar vi 1.0 äkta onboardingförsök (falskt negativ) eftersom deras likhet faller under den specificerade minsta nödvändiga likhetströskeln. I det här fallet är vår FNMR XNUMX %.

| Faktisk | |||

| förutspått | |||

| . | Match | Ingen match | |

| >= 95% likhet | 990 | 0 | |

| < 95 % likhet | 10 | 0 | |

| . | Totalt | 1,000 | . |

FNMR = Falskt negativt antal / (True Positive Count + False Negative Count)

FNMR = 10 / (990 + 10) eller 1.0 %

Anta däremot att istället för att ha 1,000 990 äkta användare ombord, har vi 10 äkta användare och 95 bedragare (falskt positivt). Med en minsta likhet på 1,000 %, anta att vi accepterar alla 1 XNUMX användare som äkta. Här skulle vi ha XNUMX% FMR.

| Faktisk | ||||

| förutspått | ||||

| . | Match | Ingen match | Totalt | |

| >= 95% likhet | 990 | 10 | 1,000 | |

| < 95 % likhet | 0 | 0 | . | |

FMR = False Positive Count / (Totalt antal försök)

FMR = 10 / (1,000 1.0) eller XNUMX %

Bedöma kostnader för FMR och FNMR vid onboarding

I ett användningsfall för onboarding är kostnaden för en falsk icke-matchning (ett avslag) vanligtvis förknippat med ytterligare användarfriktion eller förlust av en registrering. Anta till exempel, i vårt bankanvändningsfall, att Julie presenterar två bilder av sig själv men felaktigt avvisas vid tidpunkten för introduktionen eftersom likheten mellan de två bilderna faller under den valda likheten (en falsk icke-matchning). Finansinstitutet kan riskera att förlora Julie som potentiell kund, eller så kan det orsaka Julie ytterligare friktion genom att kräva att hon utför åtgärder för att bevisa sin identitet.

Omvänt, anta att de två bilderna av Julie är av olika människor och att Julies onboarding borde ha avvisats. I det fall då Julie är felaktigt accepterad (en falsk matchning), är kostnaden och risken för finansinstitutet helt annorlunda. Det kan finnas regulatoriska frågor, risk för bedrägerier och andra risker i samband med finansiella transaktioner.

Ansvarsfull användning

Artificiell intelligens (AI) tillämpad genom maskininlärning (ML) kommer att vara en av de mest transformerande teknologierna i vår generation, som tar itu med några av mänsklighetens mest utmanande problem, ökar mänsklig prestation och maximerar produktiviteten. Ansvarsfull användning av dessa tekniker är nyckeln till att främja fortsatt innovation. AWS har åtagit sig att utveckla rättvisa och korrekta AI- och ML-tjänster och ge dig de verktyg och vägledning som behövs för att bygga AI- och ML-applikationer på ett ansvarsfullt sätt.

När du anammar och ökar din användning av AI och ML, erbjuder AWS flera resurser baserade på vår erfarenhet för att hjälpa dig med ansvarsfull utveckling och användning av AI och ML:

Bästa metoder och vanliga misstag att undvika

I det här avsnittet diskuterar vi följande bästa praxis:

- Använd ett tillräckligt stort urval av bilder

- Undvik öppen källkod och syntetiska ansiktsdatauppsättningar

- Undvik manuell och syntetisk bildmanipulation

- Kontrollera bildkvaliteten vid utvärderingstillfället och över tid

- Övervaka FMR och FNMR över tid

- Använd en människa i slingan recension

- Håll dig uppdaterad med Amazon Rekognition

Använd ett tillräckligt stort urval av bilder

Använd ett tillräckligt stort men rimligt urval av bilder. Vad är en rimlig urvalsstorlek? Det beror på affärsproblemet. Om du är en arbetsgivare och har 10,000 10,000 anställda som du vill autentisera, är det förmodligen rimligt att använda alla 5,000 20,000 bilder. Anta dock att du är en organisation med miljontals kunder som du vill ha med. I det här fallet räcker det nog att ta ett representativt urval av kunder som XNUMX XNUMX–XNUMX XNUMX. Här är lite vägledning om urvalsstorleken:

- En provstorlek på 100 – 1,000 XNUMX bildpar bevisar genomförbarhet

- En provstorlek på 1,000 – 10,000 XNUMX bildpar är användbart för att mäta variationer mellan bilder

- En provstorlek på 10,000 – 1 miljon bildpar ger ett mått på driftkvalitet och generaliserbarhet

Nyckeln med att sampla bildpar är att säkerställa att provet ger tillräckligt med variation över populationen av ansikten i din applikation. Du kan utöka ditt urval och testning ytterligare till att inkludera demografisk information som hudton, kön och ålder.

Undvik öppen källkod och syntetiska ansiktsdatauppsättningar

Det finns dussintals kurerade uppsättningar av ansiktsbilder med öppen källkod såväl som häpnadsväckande realistiska syntetiska ansiktsuppsättningar som ofta används i forskning och för att studera genomförbarhet. Utmaningen är att dessa datauppsättningar i allmänhet inte är användbara för 99 % av verkliga användningsfall bara för att de inte är representativa för kamerorna, ansikten och kvaliteten på bilderna som din applikation sannolikt kommer att stöta på i naturen. Även om de är användbara för applikationsutveckling, generaliserar inte noggrannhetsmåtten för dessa bilduppsättningar till vad du kommer att stöta på i din egen applikation. Istället rekommenderar vi att du börjar med ett representativt urval av verkliga bilder från din lösning, även om exempelbildsparen är små (under 1,000 XNUMX).

Undvik manuell och syntetisk bildmanipulation

Det finns ofta kantfall som folk är intresserade av att förstå. Saker som bildfångstkvalitet eller förvirring av specifika ansiktsdrag är alltid av intresse. Till exempel får vi ofta frågor om hur ålder och bildkvalitet påverkar ansiktsigenkänning. Du kan helt enkelt syntetiskt åldra ett ansikte eller manipulera bilden för att få motivet att se äldre ut, eller manipulera bildkvaliteten, men detta översätts inte bra till verklig åldrande av bilder. Istället är vår rekommendation att samla ett representativt urval av verkliga edge-fall du är intresserad av att testa.

Kontrollera bildkvaliteten vid utvärderingstillfället och över tid

Kamera- och applikationsteknik förändras ganska snabbt över tiden. Som en bästa praxis rekommenderar vi att du övervakar bildkvaliteten över tid. Från storleken på ansikten som tagits (med hjälp av begränsningsrutor), till ljusstyrkan och skärpan i en bild, till posituren för ett ansikte, såväl som potentiella förvirringar (hattar, solglasögon, skägg och så vidare), alla dessa bilder och ansiktsdrag förändras över tiden.

Övervaka FNMR och FMR över tid

Förändringar sker, oavsett om det är bilderna, applikationen eller likhetströskelvärdena som används i applikationen. Det är viktigt att regelbundet övervaka antalet falska matchningar och icke-matchningar över tid. Förändringar i hastigheterna (även subtila förändringar) kan ofta peka på uppströms utmaningar med applikationen eller hur applikationen används. Ändringar av likhetströsklar och affärsregler som används för att fatta beslut om att acceptera eller avvisa kan ha stor inverkan på användarupplevelser för onboarding och autentisering.

Använd en människa i slingan recension

Identitetsverifieringssystem fattar automatiska beslut om matchning och icke-matchning baserat på likhetströsklar och affärsregler. Förutom regulatoriska och interna efterlevnadskrav är en viktig process i alla automatiserade beslutssystem att använda mänskliga granskare som en del av den löpande övervakningen av beslutsprocessen. Mänsklig tillsyn av dessa automatiserade beslutssystem ger validering och kontinuerliga förbättringar samt transparens i den automatiserade beslutsprocessen.

Håll dig uppdaterad med Amazon Rekognition

Amazon Recognition faces-modellen uppdateras regelbundet (vanligtvis årligen) och finns för närvarande på version 6. Denna uppdaterade version gjorde viktiga förbättringar av noggrannhet och indexering. Det är viktigt att hålla dig uppdaterad med nya modellversioner och förstå hur du använder dessa nya versioner i din identitetsverifieringsapplikation. När nya versioner av Amazon Rekognition-ansiktsmodellen lanseras är det god praxis att köra din identitetsverifieringsutvärderingsprocess igen och avgöra eventuella effekter (positiva och negativa) på dina falska matchningar och icke-matchningar.

Slutsats

Det här inlägget diskuterar nyckelelementen som behövs för att utvärdera prestandaaspekten av din identitetsverifieringslösning i termer av olika noggrannhetsmått. Men noggrannhet är bara en av de många dimensioner som du behöver utvärdera när du väljer en viss innehållsmodereringstjänst. Det är viktigt att du inkluderar andra parametrar, såsom tjänstens totala funktionsuppsättning, användarvänlighet, befintliga integrationer, integritet och säkerhet, anpassningsalternativ, skalbarhetsimplikationer, kundservice och prissättning.

För att lära dig mer om identitetsverifiering i Amazon Rekognition, besök Identitetsverifiering med Amazon Rekognition.

Om författarna

Mike Ames är en datavetare som blivit specialist på lösningar för identitetsverifiering, med lång erfarenhet av att utveckla maskininlärning och AI-lösningar för att skydda organisationer från bedrägerier, slöseri och missbruk. På fritiden kan du hitta honom på vandring, mountainbike eller leka freebee med sin hund Max.

Mike Ames är en datavetare som blivit specialist på lösningar för identitetsverifiering, med lång erfarenhet av att utveckla maskininlärning och AI-lösningar för att skydda organisationer från bedrägerier, slöseri och missbruk. På fritiden kan du hitta honom på vandring, mountainbike eller leka freebee med sin hund Max.

Amit Gupta är senior AI Services Solutions Architect på AWS. Han brinner för att möjliggöra för kunder med väl utformade maskininlärningslösningar i stor skala.

Amit Gupta är senior AI Services Solutions Architect på AWS. Han brinner för att möjliggöra för kunder med väl utformade maskininlärningslösningar i stor skala.

Zuhayr Raghib är en AI Services Solutions Architect på AWS. Han är specialiserad på tillämpad AI/ML och brinner för att göra det möjligt för kunder att använda molnet för att förnya sig snabbare och transformera sina verksamheter.

Zuhayr Raghib är en AI Services Solutions Architect på AWS. Han är specialiserad på tillämpad AI/ML och brinner för att göra det möjligt för kunder att använda molnet för att förnya sig snabbare och transformera sina verksamheter.

Marcel Pividal är en Sr. AI Services Solutions Architect i den världsomspännande specialistorganisationen. Marcel har mer än 20 års erfarenhet av att lösa affärsproblem genom teknik för fintechs, betalningsleverantörer, läkemedel och statliga myndigheter. Hans nuvarande fokusområden är riskhantering, bedrägeriförebyggande och identitetsverifiering.

Marcel Pividal är en Sr. AI Services Solutions Architect i den världsomspännande specialistorganisationen. Marcel har mer än 20 års erfarenhet av att lösa affärsproblem genom teknik för fintechs, betalningsleverantörer, läkemedel och statliga myndigheter. Hans nuvarande fokusområden är riskhantering, bedrägeriförebyggande och identitetsverifiering.

- AI

- ai konst

- ai art generator

- har robot

- Amazon-erkännande

- artificiell intelligens

- artificiell intelligenscertifiering

- artificiell intelligens inom bankväsendet

- artificiell intelligens robot

- robotar med artificiell intelligens

- programvara för artificiell intelligens

- AWS maskininlärning

- bästa praxis

- blockchain

- blockchain konferens ai

- coingenius

- konversationskonstnärlig intelligens

- kryptokonferens ai

- dalls

- djupt lärande

- du har google

- maskininlärning

- plato

- plato ai

- Platon Data Intelligence

- Platon spel

- PlatonData

- platogaming

- skala ai

- syntax

- zephyrnet