Amazon SageMaker gör det enkelt att distribuera modeller för maskininlärning (ML) för realtidsinferens och erbjuder ett brett urval av ML-instanser som spänner över processorer och acceleratorer som t.ex. AWS slutledning. Som en helt hanterad tjänst kan du skala dina modellinstallationer, minimera slutledningskostnader och hantera dina modeller mer effektivt i produktionen med minskad operativ börda. En SageMaker slutpunkt i realtid består av en HTTPs-slutpunkt och ML-instanser som distribueras över flera tillgänglighetszoner för hög tillgänglighet. SageMaker applikations automatisk skalning kan dynamiskt justera antalet ML-instanser som tillhandahålls för en modell som svar på förändringar i arbetsbelastningen. Slutpunkten fördelar inkommande förfrågningar enhetligt till ML-instanser med hjälp av en round-robin-algoritm.

När ML-modeller som distribueras på instanser tar emot API-anrop från ett stort antal klienter, kan en slumpmässig fördelning av förfrågningar fungera mycket bra när det inte finns mycket variation i dina förfrågningar och svar. Men i system med generativa AI-arbetsbelastningar kan förfrågningar och svar vara extremt varierande. I dessa fall är det ofta önskvärt att lastbalansera genom att överväga kapaciteten och utnyttjandet av instansen snarare än slumpmässig lastbalansering.

I det här inlägget diskuterar vi SageMakers routingstrategi för minst utestående förfrågningar (LOR) och hur den kan minimera latensen för vissa typer av realtidsinferensarbetsbelastningar genom att ta hänsyn till kapaciteten och användningen av ML-instanser. Vi pratar om dess fördelar jämfört med standardruttmekanismen och hur du kan aktivera LOR för dina modellinstallationer. Slutligen presenterar vi en jämförande analys av latensförbättringar med LOR jämfört med standardroutingstrategin för slumpmässig routing.

SageMaker LOR-strategi

Som standard har SageMaker-slutpunkter en slumpmässig routingstrategi. SageMaker stöder nu en LOR-strategi, som gör det möjligt för SageMaker att optimalt dirigera förfrågningar till den instans som är bäst lämpad för att betjäna den begäran. SageMaker gör detta möjligt genom att övervaka belastningen av instanserna bakom din slutpunkt, och modellerna eller slutledningskomponenterna som distribueras på varje instans.

Följande interaktiva diagram visar standardroutingpolicyn där förfrågningar som kommer till modellens slutpunkter vidarebefordras på ett slumpmässigt sätt till ML-instanserna.

Följande interaktiva diagram visar routingstrategin där SageMaker kommer att dirigera begäran till den instans som har minst antal utestående förfrågningar.

I allmänhet fungerar LOR-routing bra för grundmodeller eller generativa AI-modeller när din modell svarar på hundratals millisekunder till minuter. Om ditt modellsvar har lägre latens (upp till hundratals millisekunder) kan du dra mer nytta av slumpmässig routing. Oavsett vilket rekommenderar vi att du testar och identifierar den bästa routingalgoritmen för dina arbetsbelastningar.

Hur man ställer in SageMaker routingstrategier

SageMaker låter dig nu ställa in RoutingStrategy parameter när du skapar EndpointConfiguration för slutpunkter. Den annorlunda RoutingStrategy värden som stöds av SageMaker är:

LEAST_OUTSTANDING_REQUESTSRANDOM

Följande är ett exempel på implementering av en modell på en slutpunkt för slutledning som har LOR aktiverat:

- Skapa slutpunktskonfigurationen genom att ställa in

RoutingStrategyasLEAST_OUTSTANDING_REQUESTS: - Skapa slutpunkten med hjälp av slutpunktskonfigurationen (ingen förändring):

Prestanda resultat

Vi körde prestandabenchmarking för att mäta slut-till-ände slutledningslatens och genomströmning av codegen2-7B modell värd på ml.g5.24xl-instanser med standardrouting och smarta routingslutpunkter. CodeGen2-modellen tillhör familjen autoregressiva språkmodeller och genererar körbar kod när de ges engelska uppmaningar.

I vår analys ökade vi antalet ml.g5.24xl-instanser bakom varje endpoint för varje testkörning när antalet samtidiga användare ökade, vilket visas i följande tabell.

| Testa | Antal samtidiga användare | Antal instanser |

| 1 | 4 | 1 |

| 2 | 20 | 5 |

| 3 | 40 | 10 |

| 4 | 60 | 15 |

| 5 | 80 | 20 |

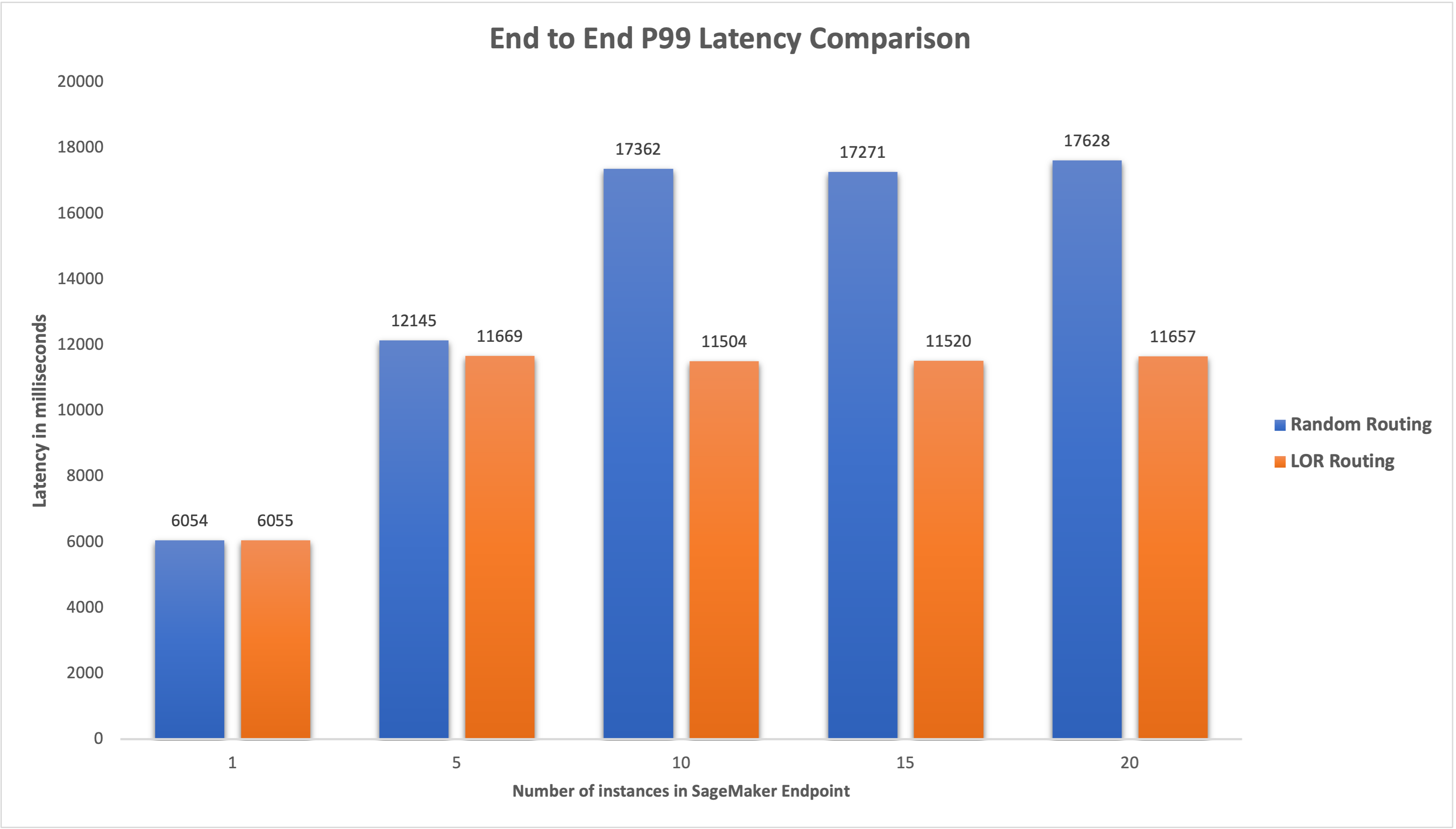

Vi mätte end-to-end P99-latensen för båda endpoints och observerade en 4–33 % förbättring i latens när antalet instanser ökades från 5 till 20, som visas i följande graf.

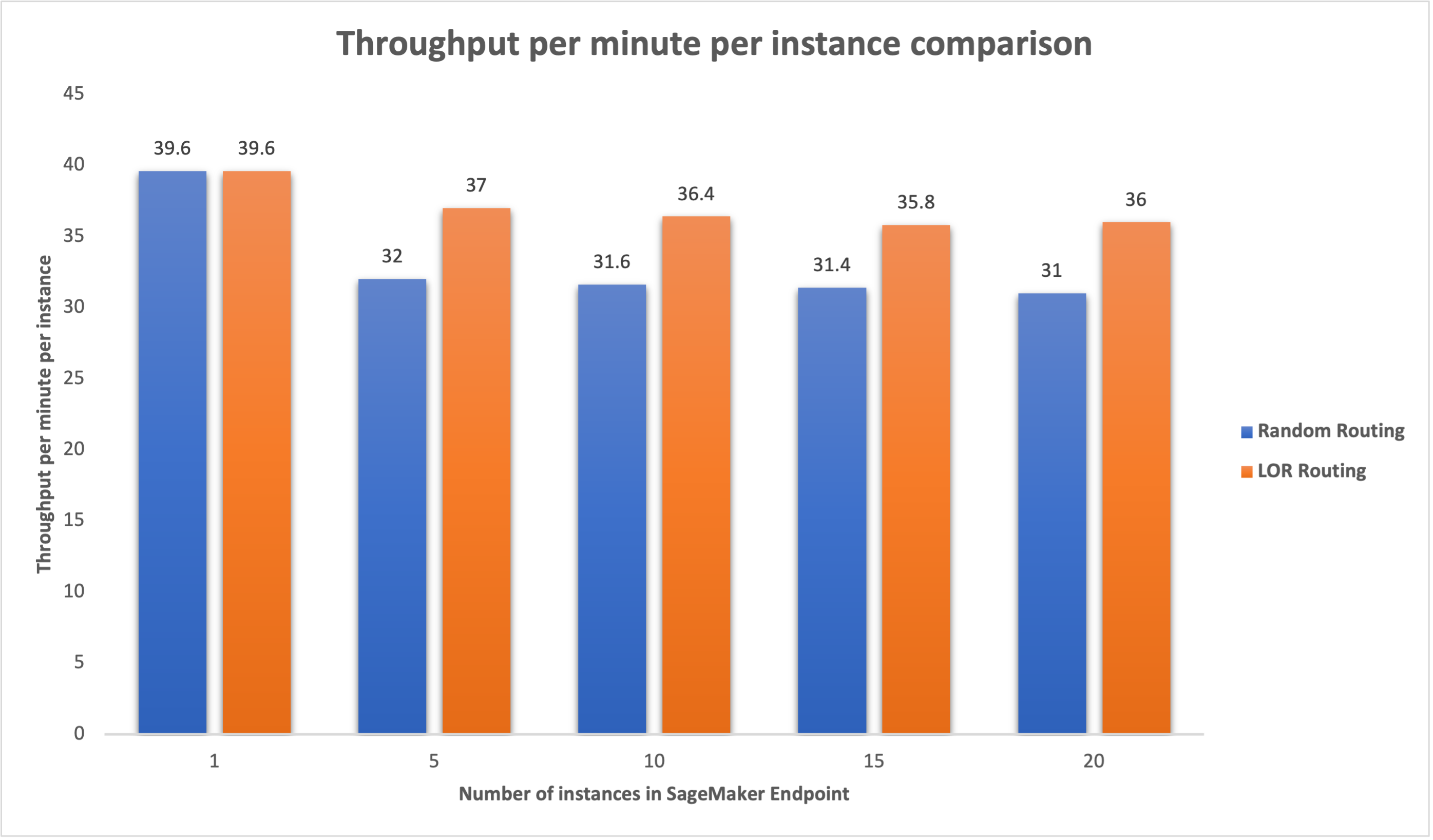

På liknande sätt observerade vi en 15–16 % förbättring av genomströmningen per minut per instans när antalet instanser ökades från 5 till 20.

Detta illustrerar att smart routing kan förbättra trafikfördelningen mellan ändpunkterna, vilket leder till förbättringar i änd-till-ände latens och total genomströmning.

Slutsats

I det här inlägget förklarade vi SageMakers routingstrategier och det nya alternativet för att aktivera LOR-routing. Vi förklarade hur du aktiverar LOR och hur det kan gynna dina modellinstallationer. Våra prestandatester visade latens- och genomströmningsförbättringar under realtidsinferencing. För att lära dig mer om SageMakers routingfunktioner, se dokumentation. Vi uppmuntrar dig att utvärdera dina slutledningsarbetsbelastningar och avgöra om du är optimalt konfigurerad med routingstrategin.

Om författarna

James Park är en lösningsarkitekt på Amazon Web Services. Han arbetar med Amazon.com för att designa, bygga och distribuera tekniklösningar på AWS och har ett särskilt intresse för AI och maskininlärning. På fritiden tycker han om att söka nya kulturer, nya upplevelser och att hålla sig uppdaterad med de senaste tekniktrenderna. Du kan hitta honom på LinkedIn.

James Park är en lösningsarkitekt på Amazon Web Services. Han arbetar med Amazon.com för att designa, bygga och distribuera tekniklösningar på AWS och har ett särskilt intresse för AI och maskininlärning. På fritiden tycker han om att söka nya kulturer, nya upplevelser och att hålla sig uppdaterad med de senaste tekniktrenderna. Du kan hitta honom på LinkedIn.

Venugopal Pai är lösningsarkitekt på AWS. Han bor i Bengaluru, Indien, och hjälper digitala kunder att skala och optimera sina applikationer på AWS.

Venugopal Pai är lösningsarkitekt på AWS. Han bor i Bengaluru, Indien, och hjälper digitala kunder att skala och optimera sina applikationer på AWS.

David Nigenda är en senior mjukvaruutvecklingsingenjör i Amazon SageMaker-teamet, som för närvarande arbetar med att förbättra arbetsflöden för maskininlärning i produktionen, samt lanserar nya inferensfunktioner. På fritiden försöker han hålla jämna steg med sina barn.

David Nigenda är en senior mjukvaruutvecklingsingenjör i Amazon SageMaker-teamet, som för närvarande arbetar med att förbättra arbetsflöden för maskininlärning i produktionen, samt lanserar nya inferensfunktioner. På fritiden försöker han hålla jämna steg med sina barn.

Deepti Ragha är en mjukvaruutvecklingsingenjör i Amazon SageMaker-teamet. Hennes nuvarande arbete fokuserar på att bygga funktioner för att effektivt vara värd för maskininlärningsmodeller. På fritiden tycker hon om att resa, vandra och odla växter.

Deepti Ragha är en mjukvaruutvecklingsingenjör i Amazon SageMaker-teamet. Hennes nuvarande arbete fokuserar på att bygga funktioner för att effektivt vara värd för maskininlärningsmodeller. På fritiden tycker hon om att resa, vandra och odla växter.

Alan Tan är en Senior Product Manager hos SageMaker, som leder arbetet med att slutföra stora modeller. Han brinner för att tillämpa maskininlärning på analysområdet. Utanför jobbet tycker han om att vara utomhus.

Alan Tan är en Senior Product Manager hos SageMaker, som leder arbetet med att slutföra stora modeller. Han brinner för att tillämpa maskininlärning på analysområdet. Utanför jobbet tycker han om att vara utomhus.

Dhawal Patel är en huvudarkitekt för maskininlärning på AWS. Han har arbetat med organisationer som sträcker sig från stora företag till medelstora startups med problem relaterade till distribuerad datoranvändning och artificiell intelligens. Han fokuserar på djupinlärning inklusive NLP- och Computer Vision-domäner. Han hjälper kunder att uppnå högpresterande modellslutningar på SageMaker.

Dhawal Patel är en huvudarkitekt för maskininlärning på AWS. Han har arbetat med organisationer som sträcker sig från stora företag till medelstora startups med problem relaterade till distribuerad datoranvändning och artificiell intelligens. Han fokuserar på djupinlärning inklusive NLP- och Computer Vision-domäner. Han hjälper kunder att uppnå högpresterande modellslutningar på SageMaker.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://aws.amazon.com/blogs/machine-learning/minimize-real-time-inference-latency-by-using-amazon-sagemaker-routing-strategies/

- : har

- :är

- :inte

- :var

- $UPP

- 1

- 100

- 125

- 150

- 17

- 1870

- 20

- 7

- 9

- a

- Able

- Om oss

- acceleratorer

- Uppnå

- tvärs

- AI

- AI-modeller

- Alan

- algoritm

- tillåter

- amason

- Amazon SageMaker

- Amazon Web Services

- Amazon.com

- bland

- an

- analys

- analytics

- och

- api

- tillämpningar

- Tillämpa

- ÄR

- OMRÅDE

- konstgjord

- artificiell intelligens

- AS

- At

- bil

- tillgänglighet

- AWS

- Balansera

- balansering

- BE

- bakom

- tillhör

- benchmarking

- fördel

- Fördelarna

- BÄST

- båda

- bred

- SLUTRESULTAT

- Byggnad

- belastning

- men

- by

- Samtal

- KAN

- Kapacitet

- fall

- vissa

- byta

- Förändringar

- klienter

- koda

- COM

- kommande

- komponenter

- dator

- Datorsyn

- databehandling

- konkurrent

- konfiguration

- konfigurerad

- övervägande

- med tanke på

- består

- Kostar

- Skapa

- Aktuella

- För närvarande

- Kunder

- Datum

- djup

- djupt lärande

- Standard

- distribuera

- utplacerade

- utplacering

- distributioner

- Designa

- Bestämma

- Utveckling

- olika

- diskutera

- distribueras

- distribuerad databehandling

- fördelning

- domäner

- under

- dynamiskt

- varje

- effektivt

- effektivt

- ansträngningar

- möjliggöra

- aktiverad

- uppmuntra

- början till slut

- Slutpunkt

- ingenjör

- Engelska

- företag

- utvärdera

- exempel

- Erfarenheter

- förklarade

- extremt

- familj

- Funktioner

- Slutligen

- hitta

- fokuserar

- efter

- För

- grundläggande

- från

- fullständigt

- Allmänt

- genererar

- generativ

- Generativ AI

- gif

- ges

- diagram

- Odling

- Har

- he

- hjälper

- här

- Hög

- honom

- hans

- värd

- värd

- Hur ser din drömresa ut

- How To

- html

- HTTPS

- Hundratals

- identifiera

- if

- illustrerar

- förbättra

- förbättring

- förbättringar

- förbättra

- in

- Inklusive

- Inkommande

- ökat

- indien

- exempel

- Intelligens

- interaktiva

- intresse

- in

- IT

- DESS

- jpg

- Ha kvar

- barn

- språk

- Large

- Stora företag

- Latens

- senaste

- lansera

- ledande

- LÄRA SIG

- inlärning

- t minst

- Bor

- läsa in

- Lot

- lägre

- Maskinen

- maskininlärning

- GÖR

- hantera

- förvaltade

- chef

- sätt

- Maj..

- mäta

- mekanism

- millisekunder

- minut

- minuter

- ML

- modell

- modeller

- övervakning

- mer

- multipel

- Nya

- nlp

- Nej

- nu

- antal

- of

- Erbjudanden

- Ofta

- on

- operativa

- Optimera

- Alternativet

- or

- organisationer

- vår

- ut

- utomhus

- utanför

- utestående

- över

- övergripande

- parameter

- särskilt

- brinner

- för

- prestanda

- Växter

- plato

- Platon Data Intelligence

- PlatonData

- policy

- möjlig

- Inlägg

- presentera

- Principal

- problem

- Produkt

- produktchef

- Produktion

- prompter

- slumpmässig

- som sträcker sig

- snarare

- realtid

- motta

- rekommenderar

- Minskad

- hänvisa

- Oavsett

- relaterad

- begära

- förfrågningar

- respons

- svar

- Rutt

- routing

- Körning

- sagemaker

- Skala

- söker

- Val

- senior

- tjänar

- service

- Tjänster

- in

- inställning

- hon

- visade

- visas

- Visar

- smarta

- Mjukvara

- mjukvaruutveckling

- Lösningar

- spänning

- Startups

- vistas

- okomplicerad

- strategier

- Strategi

- sådana

- Som stöds

- Stöder

- System

- bord

- tar

- Diskussion

- grupp

- Teknologi

- testa

- tester

- än

- den där

- Smakämnen

- Området

- deras

- Där.

- Dessa

- detta

- genomströmning

- tid

- till

- trafik

- Traveling

- Trender

- typer

- användare

- med hjälp av

- Värden

- variabel

- mycket

- syn

- we

- webb

- webbservice

- VÄL

- były

- när

- som

- medan

- kommer

- med

- Arbete

- arbetade

- arbetsflöden

- arbetssätt

- fungerar

- Om er

- Din

- zephyrnet

- zoner