Genererad med Midjourney

NeurIPS 2023-konferensen, som hölls i den pulserande staden New Orleans från 10 till 16 december, hade en särskild tonvikt på generativ AI och stora språkmodeller (LLMs). I ljuset av de senaste banbrytande framstegen på detta område var det ingen överraskning att dessa ämnen dominerade diskussionerna.

Ett av kärnteman för årets konferens var strävan efter effektivare AI-system. Forskare och utvecklare letar aktivt efter sätt att konstruera AI som inte bara lär sig snabbare än nuvarande LLM:er utan också har förbättrade resonemangsmöjligheter samtidigt som de förbrukar färre datorresurser. Denna strävan är avgörande i kapplöpningen mot att uppnå artificiell allmän intelligens (AGI), ett mål som verkar alltmer uppnåeligt inom en överskådlig framtid.

De inbjudna samtalen på NeurIPS 2023 var en återspegling av dessa dynamiska och snabbt föränderliga intressen. Presentatörer från olika sfärer av AI-forskning delade med sig av sina senaste prestationer och gav ett fönster till banbrytande AI-utveckling. I den här artikeln fördjupar vi oss i dessa samtal, extraherar och diskuterar de viktigaste takeaways och lärdomarna, som är avgörande för att förstå nuvarande och framtida landskap av AI-innovation.

NextGenAI: Delusion of Scaling and the Future of Generative AI

In hans talBjörn Ommer, chef för Computer Vision & Learning Group vid Ludwig Maximilian University i München, delade hur hans labb kom till att utveckla stabil diffusion, några lärdomar de lärde sig från denna process och den senaste utvecklingen, inklusive hur vi kan blanda diffusionsmodeller med flödesmatchning, återvinningsförstärkning och LoRA-approximationer, bland annat.

Viktiga takeaways:

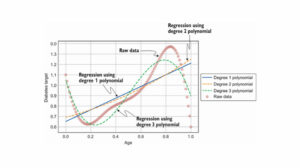

- I en ålder av Generativ AI flyttade vi från fokus på perception i synmodeller (dvs objektigenkänning) till att förutsäga de saknade delarna (t.ex. bild- och videogenerering med diffusionsmodeller).

- I 20 år var datorseendet fokuserat på benchmarkforskning, vilket bidrog till att fokusera på de mest framträdande problemen. I Generativ AI har vi inga riktmärken att optimera för, vilket öppnade fältet för alla att gå i sin egen riktning.

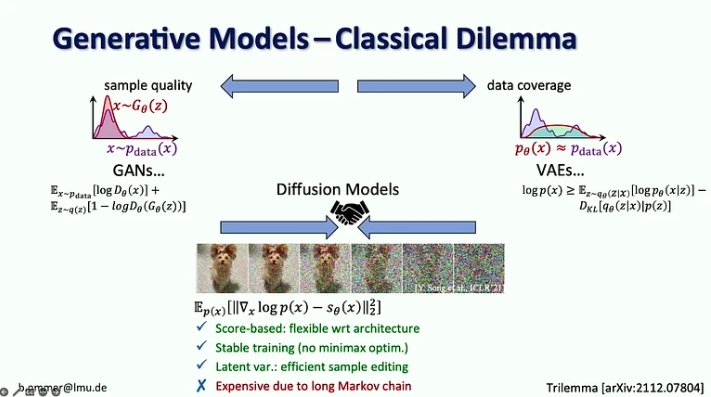

- Diffusionsmodeller kombinerar fördelarna med tidigare generativa modeller genom att vara poängbaserade med en stabil träningsprocedur och effektiv provredigering, men de är dyra på grund av sin långa Markov-kedja.

- Utmaningen med starka sannolikhetsmodeller är att de flesta bitarna går in i detaljer som knappast kan märkas av det mänskliga ögat, medan kodning av semantik, som betyder mest, bara tar några få bitar. Enbart skalning skulle inte lösa det här problemet eftersom efterfrågan på datorresurser växer 9 gånger snabbare än utbudet av GPU.

- Den föreslagna lösningen är att kombinera styrkorna hos Diffusionsmodeller och ConvNets, särskilt effektiviteten hos faltningar för att representera lokala detaljer och uttrycksfullheten hos diffusionsmodeller för långväga sammanhang.

- Björn Ommer föreslår också att man använder ett flödesmatchande tillvägagångssätt för att möjliggöra högupplöst bildsyntes från små latenta diffusionsmodeller.

- Ett annat tillvägagångssätt för att öka effektiviteten i bildsyntes är att fokusera på scenkomposition samtidigt som man använder återvinningsförstärkning för att fylla i detaljerna.

- Slutligen introducerade han iPoke-metoden för kontrollerad stokastisk videosyntes.

Om detta djupgående innehåll är användbart för dig, prenumerera på vår AI-e-postlista att bli varnade när vi släpper nytt material.

Ansvarsfull AIs många ansikten

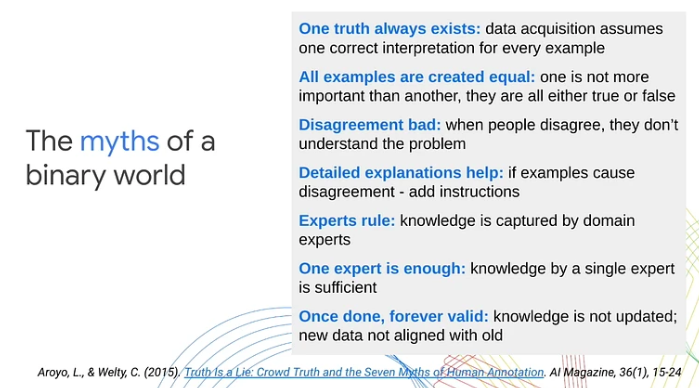

In hennes presentation, Lora Aroyo, forskare vid Google Research, framhöll en viktig begränsning i traditionella metoder för maskininlärning: deras beroende av binära kategoriseringar av data som positiva eller negativa exempel. Denna alltför förenkling, hävdade hon, förbiser den komplexa subjektiviteten som är inneboende i verkliga scenarier och innehåll. Genom olika användningsfall visade Aroyo hur oklarheter i innehållet och den naturliga variansen i mänskliga åsikter ofta leder till oundvikliga meningsskiljaktigheter. Hon betonade vikten av att behandla dessa meningsskiljaktigheter som meningsfulla signaler snarare än bara brus.

Här är viktiga tips från föredraget:

- Oenighet mellan mänskliga laboratorier kan vara produktiv. Istället för att behandla alla svar som antingen korrekta eller felaktiga, introducerade Lora Aroyo "sanning genom oenighet", ett tillvägagångssätt för fördelningssanning för att bedöma datas tillförlitlighet genom att utnyttja bedömarnas oenighet.

- Datakvalitet är svårt även med experter eftersom experter är lika oeniga som crowdlabers. Dessa meningsskiljaktigheter kan vara mycket mer informativa än svar från en enda expert.

- I säkerhetsutvärderingsuppgifter är experter oense om 40 % av exemplen. Istället för att försöka lösa dessa meningsskiljaktigheter måste vi samla in fler sådana exempel och använda dem för att förbättra modellerna och utvärderingsmåtten.

- Lora Aroyo presenterade också sina Säkerhet med mångfald metod för att granska uppgifterna i termer av vad i den och vem som har kommenterat den.

- Denna metod producerade en referensdatauppsättning med variation i LLM-säkerhetsbedömningar över olika demografiska grupper av bedömare (totalt 2.5 miljoner betyg).

- För 20 % av konversationerna var det svårt att avgöra om chatbot-svaret var säkert eller osäkert, eftersom det fanns ungefär lika många respondenter som stämplade dem som antingen säkra eller osäkra.

- Mångfalden av bedömare och data spelar en avgörande roll vid utvärdering av modeller. Att misslyckas med att erkänna det breda utbudet av mänskliga perspektiv och den oklarhet som finns i innehållet kan hindra anpassningen av maskininlärningsprestanda till verkliga förväntningar.

- 80 % av AI-säkerhetsinsatserna är redan ganska bra, men de återstående 20 % kräver en fördubbling av ansträngningen för att ta itu med kantfall och alla varianter i mångfaldens oändliga utrymme.

Koherensstatistik, egengenererad erfarenhet och varför unga människor är mycket smartare än nuvarande AI

In hennes samtal, Linda Smith, en framstående professor vid Indiana University Bloomington, utforskade ämnet gleshet med data i inlärningsprocesser för spädbarn och små barn. Hon fokuserade specifikt på objektigenkänning och namninlärning, och grävde ner sig i hur statistiken över självgenererade upplevelser av spädbarn erbjuder potentiella lösningar på utmaningen med datagleshet.

Viktiga takeaways:

- Vid tre års ålder har barn utvecklat förmågan att vara engångslärare inom olika områden. På mindre än 16,000 1,000 vakna timmar fram till sin fjärde födelsedag lyckas de lära sig över XNUMX XNUMX objektkategorier, bemästra syntaxen i sitt modersmål och ta till sig de kulturella och sociala nyanserna i sin miljö.

- Dr. Linda Smith och hennes team upptäckte tre principer för mänskligt lärande som gör att barn kan fånga så mycket från så sparsam data:

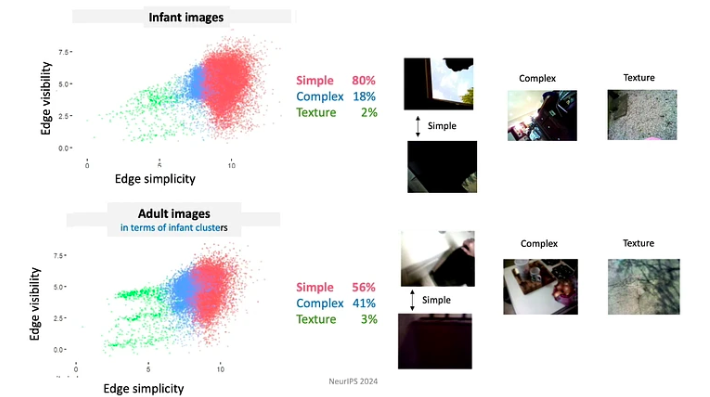

- Eleverna kontrollerar input, från ögonblick till ögonblick formar och strukturerar de input. Till exempel, under de första månaderna av sitt liv, tenderar bebisar att titta mer på föremål med enkla kanter.

- Eftersom spädbarn ständigt utvecklas i sina kunskaper och förmågor, följer de en mycket begränsad läroplan. Den data de utsätts för är organiserad på djupt betydelsefulla sätt. Till exempel spenderar barn under 4 månader mest tid på att titta på ansikten, ungefär 15 minuter per timme, medan de äldre än 12 månader fokuserar främst på händerna och observerar dem i ungefär 20 minuter per timme.

- Inlärningsavsnitt består av en serie sammanlänkade upplevelser. Rumsliga och tidsmässiga korrelationer skapar koherens, vilket i sin tur underlättar bildandet av bestående minnen från engångshändelser. Till exempel, när de presenteras med ett slumpmässigt urval av leksaker, fokuserar barn ofta på några få "favorit" leksaker. De engagerar sig med dessa leksaker med hjälp av repetitiva mönster, vilket hjälper till att snabbare lära sig föremålen.

- Övergående (arbets)minnen kvarstår längre än den sensoriska ingången. Egenskaper som förbättrar inlärningsprocessen inkluderar multimodalitet, associationer, prediktiva relationer och aktivering av tidigare minnen.

- För snabb inlärning behöver du en allians mellan mekanismerna som genererar data och mekanismerna som lär sig.

Skissning: kärnverktyg, inlärningsförstärkning och adaptiv robusthet

Jelani Nelson, professor i elektroteknik och datavetenskap vid UC Berkeley, introducerade begreppet "dataskisser" – en minneskomprimerad representation av en datauppsättning som fortfarande gör det möjligt att svara på användbara frågor. Även om föredraget var ganska tekniskt, gav det en utmärkt översikt över några grundläggande skissverktyg, inklusive de senaste framstegen.

Viktiga takeaways:

- CountSketch, kärnskissverktyget, introducerades först 2002 för att ta itu med problemet med "heavy hiters", och rapporterade en liten lista över de vanligaste föremålen från den givna strömmen av föremål. CountSketch var den första kända sublinjära algoritmen som användes för detta ändamål.

- Två icke-strömmande tillämpningar av tunga slagare inkluderar:

- Interiör punktbaserad metod (IPM) som ger en asymptotiskt snabbaste kända algoritm för linjär programmering.

- HyperAttention-metod som tar itu med den beräkningsutmaning som den växande komplexiteten hos långa sammanhang som används i LLM:er.

- Mycket nyligen arbete har fokuserats på att designa skisser som är robusta för adaptiv interaktion. Huvudtanken är att använda insikter från adaptiv dataanalys.

Beyond Scaling Panel

Denna bra panel på stora språkmodeller modererades av Alexander Rush, docent vid Cornell Tech och forskare vid Hugging Face. De andra deltagarna var:

- Aakanksha Chowdhery – forskare på Google DeepMind med forskningsintressen inom system, LLM-förträning och multimodalitet. Hon var en del av teamet som utvecklade PaLM, Gemini och Pathways.

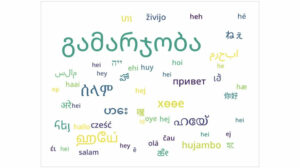

- Angela Fan – Forskare vid Meta Generative AI med forskningsintressen inom anpassning, datacenter och flerspråkighet. Hon deltog i utvecklingen av Llama-2 och Meta AI Assistant.

- Percy Liang – Professor vid Stanford som forskar om kreatörer, öppen källkod och generativa agenter. Han är direktör för Center for Research on Foundation Models (CRFM) i Stanford och grundaren av Together AI.

Diskussionen fokuserade på fyra nyckelämnen: (1) arkitekturer och ingenjörskonst, (2) data och anpassning, (3) utvärdering och transparens och (4) skapare och bidragsgivare.

Här är några av tipsen från denna panel:

- Att träna nuvarande språkmodeller är inte i sig svårt. Den största utmaningen med att träna en modell som Llama-2-7b ligger i infrastrukturkraven och behovet av att koordinera mellan flera GPU:er, datacenter etc. Men om antalet parametrar är tillräckligt litet för att tillåta träning på en enda GPU, även en student kan hantera det.

- Medan autoregressiva modeller vanligtvis används för textgenerering och diffusionsmodeller för att generera bilder och videor, har det gjorts experiment med att vända på dessa tillvägagångssätt. Specifikt, i Gemini-projektet, används en autoregressiv modell för bildgenerering. Det har också gjorts utforskningar av att använda diffusionsmodeller för textgenerering, men dessa har ännu inte visat sig vara tillräckligt effektiva.

- Med tanke på den begränsade tillgängligheten av engelskspråkiga data för träningsmodeller undersöker forskare alternativa tillvägagångssätt. En möjlighet är att träna multimodala modeller på en kombination av text, video, bilder och ljud, med förväntningen att färdigheter som lärts från dessa alternativa modaliteter kan överföras till text. Ett annat alternativ är användningen av syntetiska data. Det är viktigt att notera att syntetisk data ofta smälter in i verklig data, men denna integration är inte slumpmässig. Text som publiceras online genomgår vanligtvis mänsklig kuration och redigering, vilket kan ge ytterligare värde för modellutbildning.

- Öppna grundmodeller ses ofta som fördelaktiga för innovation men potentiellt skadliga för AI-säkerhet, eftersom de kan utnyttjas av illvilliga aktörer. Dr. Percy Liang menar dock att öppna modeller också bidrar positivt till säkerheten. Han menar att de genom att vara tillgängliga ger fler forskare möjligheter att bedriva AI-säkerhetsforskning och att se över modellerna för potentiella sårbarheter.

- Idag kräver annoteringsdata betydligt mer expertis inom annoteringsdomänen jämfört med för fem år sedan. Men om AI-assistenter presterar som förväntat i framtiden kommer vi att få mer värdefull feedback från användare, vilket minskar beroendet av omfattande data från annotatorer.

System för grundmodeller och grundmodeller för system

In det här samtalet, Christopher Ré, docent vid institutionen för datavetenskap vid Stanford University, visar hur grundmodeller förändrade de system vi bygger. Han utforskar också hur man effektivt bygger grundmodeller, lånar insikter från databassystemforskning och diskuterar potentiellt mer effektiva arkitekturer för grundmodeller än Transformer.

Här är de viktigaste tipsen från detta föredrag:

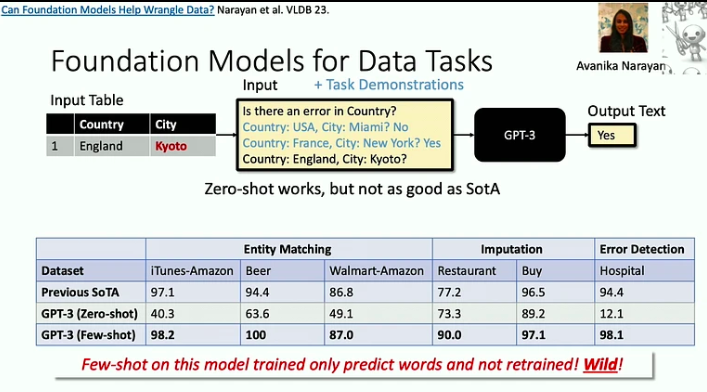

- Grundmodeller är effektiva för att ta itu med problem med "död med 1000 nedskärningar", där varje enskild uppgift kan vara relativt enkel, men den stora bredden och mångfalden av uppgifter utgör en betydande utmaning. Ett bra exempel på detta är datarensningsproblemet, som LLMs nu kan hjälpa till att lösa mycket mer effektivt.

- När acceleratorerna blir snabbare framträder minnet ofta som en flaskhals. Detta är ett problem som databasforskare har ägnat sig åt i decennier, och vi kan anta några av deras strategier. Till exempel, tillvägagångssättet Flash Attention minimerar input-output-flöden genom blockering och aggressiv sammansmältning: när vi kommer åt en bit information utför vi så många operationer som möjligt på den.

- Det finns en ny klass av arkitekturer, rotade i signalbehandling, som kan vara effektivare än Transformer-modellen, särskilt vid hantering av långa sekvenser. Signalbehandling erbjuder stabilitet och effektivitet, vilket lägger grunden för innovativa modeller som S4.

Online förstärkningsinlärning i digitala hälsointerventioner

In hennes samtal, Susan Murphy, professor i statistik och datavetenskap vid Harvard University, delade med sig av de första lösningarna på några av de utmaningar de står inför när de utvecklar online RL-algoritmer för användning i digitala hälsointerventioner.

Här är några tips från presentationen:

- Dr Susan Murphy diskuterade två projekt som hon har arbetat med:

- HeartStep, där aktiviteter har föreslagits baserat på data från smartphones och bärbara trackers, och

- Oralytics för munhälsocoaching, där interventioner baserades på engagemangsdata från en elektronisk tandborste.

- När forskare utvecklar en beteendepolicy för en AI-agent måste forskarna se till att den är autonom och genomförbart kan implementeras i det bredare hälso- och sjukvårdssystemet. Detta innebär att säkerställa att den tid som krävs för en individs engagemang är rimlig och att de rekommenderade åtgärderna är både etiskt sunda och vetenskapligt rimliga.

- De främsta utmaningarna med att utveckla en RL-agent för digitala hälsointerventioner inkluderar att hantera höga ljudnivåer, eftersom människor lever sina liv och kanske inte alltid kan svara på meddelanden, även om de vill, samt hantera starka, fördröjda negativa effekter .

Som du kan se har NeurIPS 2023 gett en lysande inblick i framtiden för AI. De inbjudna samtalen belyste en trend mot mer effektiva, resursmedvetna modeller och utforskandet av nya arkitekturer bortom traditionella paradigm.

Tycker du om den här artikeln? Registrera dig för fler AI-forskningsuppdateringar.

Vi meddelar dig när vi släpper fler sammanfattande artiklar som den här.

Relaterad

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://www.topbots.com/neurips-2023-invited-talks/

- : har

- :är

- :inte

- :var

- $UPP

- 000

- 1

- 10

- 10:e

- 11

- 12

- 12 månader

- 125

- 13

- 14

- 15%

- 154

- 16

- 16:e

- 17

- 20

- 20 år

- 2023

- 32

- 35%

- 41

- 58

- 7

- 70

- 710

- 8

- 9

- a

- förmåga

- Able

- Om oss

- acceleratorer

- tillgång

- tillgänglig

- resultat

- uppnå

- bekräfta

- tvärs

- åtgärder

- aktivering

- aktivt

- aktiviteter

- aktörer

- adaptiv

- lägga till

- Annat

- adress

- adresser

- adresse

- anta

- framsteg

- fördelar

- ålder

- Recensioner

- medel

- aggressiv

- AGI

- sedan

- AI

- AI-assistent

- ai forskning

- AI-system

- AIDS

- Alexander

- algoritm

- algoritmer

- uppriktning

- Alla

- Alliance

- tillåter

- ensam

- redan

- också

- alternativ

- Även

- alltid

- Tvetydighet

- bland

- an

- analys

- och

- Annan

- vilken som helst

- tillämpningar

- tillvägagångssätt

- tillvägagångssätt

- cirka

- ÄR

- argued

- argumenterar

- Artikeln

- artiklar

- konstgjord

- konstgjord allmän intelligens

- AS

- bedöma

- Assistent

- assistenter

- Associate

- föreningar

- sortiment

- At

- uppnåe

- uppmärksamhet

- audio

- autonom

- tillgänglighet

- baserat

- BE

- därför att

- blir

- varit

- beteende

- Där vi får lov att vara utan att konstant prestera,

- riktmärke

- riktmärken

- fördelaktigt

- Berkeley

- mellan

- Bortom

- Blandning

- blandningar

- blockering

- upplåning

- båda

- bredd

- bredare

- SLUTRESULTAT

- men

- by

- kom

- KAN

- kapacitet

- fånga

- fall

- kategorier

- Centrum

- Centers

- kedja

- utmanar

- utmaningar

- ändrats

- chatbot

- Barn

- Christopher

- Stad

- klass

- Rengöring

- coaching

- samla

- kombination

- kombinera

- jämfört

- komplex

- Komplexiteten

- sammansättning

- beräkningar

- dator

- Datavetenskap

- Datorsyn

- databehandling

- begrepp

- Genomför

- Konferens

- konstruera

- tidskrävande

- innehåll

- sammanhang

- kontexter

- kontinuerligt

- bidra

- contributors

- kontroll

- kontrolleras

- konversationer

- samordna

- Kärna

- cornell

- korrekt

- korrelationer

- kunde

- skapa

- skaparna

- folkmassa

- avgörande

- kultur

- curation

- Aktuella

- Curriculum

- allra senaste

- datum

- dataanalys

- datacenter

- Databas

- som handlar om

- årtionden

- December

- beslutar

- Deepmind

- Försenad

- gräva

- Efterfrågan

- krav

- demografiska

- demonstreras

- Avdelning

- design

- detalj

- detaljer

- utveckla

- utvecklade

- utvecklare

- utveckla

- Utveckling

- utvecklingen

- svårt

- Diffusion

- digital

- Digital hälsa

- riktning

- Direktör

- upptäckt

- diskuteras

- diskutera

- diskussion

- diskussioner

- Distingerad

- Mångfald

- domän

- domäner

- dominerade

- inte

- fördubbling

- dr

- grund

- under

- dynamisk

- e

- varje

- kant

- Effektiv

- effekter

- effektivitet

- effektiv

- effektivt

- ansträngning

- ansträngningar

- antingen

- Elektronisk

- framträder

- vikt

- betonade

- möjliggöra

- möjliggör

- kodning

- engagera

- ingrepp

- Teknik

- förbättra

- förbättrad

- tillräckligt

- säkerställa

- säkerställa

- Miljö

- lika

- speciellt

- väsentlig

- etc

- utvärdering

- utvärdering

- Även

- händelser

- alla

- utvecklas

- utvecklas

- exempel

- exempel

- utmärkt

- förväntan

- förväntningar

- förväntat

- dyra

- erfarenhet

- Erfarenheter

- experiment

- expert

- expertis

- experter

- utnyttjas

- utforskning

- utforskas

- utforskar

- Utforska

- utsatta

- omfattande

- ögat

- Ansikte

- ytorna

- underlättar

- inte

- fläkt

- snabbare

- snabbast

- återkoppling

- få

- färre

- fält

- fylla

- Förnamn

- fem

- Blixt

- flöda

- flöden

- Fokus

- fokuserade

- följer

- För

- förutsebar

- bildning

- fundament

- grundare

- fyra

- Fjärde

- frekvent

- ofta

- från

- grundläggande

- sammansmältning

- framtida

- tvillingarna

- Allmänt

- allmän intelligens

- generera

- generera

- generering

- generativ

- Generativ AI

- ges

- ger

- Glimt

- Go

- Målet

- god

- GPU

- GPUs

- banbrytande

- Grupp

- Gruppens

- Odling

- hade

- Arbetsmiljö

- händer

- skadliga

- Utnyttja

- Harvard

- Harvard Universitet

- Har

- he

- huvud

- Hälsa

- hälso-och sjukvård

- tung

- Held

- hjälpa

- hjälpte

- här

- Hög

- hög upplösning

- Markerad

- höggradigt

- hindra

- hans

- timme

- ÖPPETTIDER

- Hur ser din drömresa ut

- How To

- Men

- http

- HTTPS

- humant

- Människa

- i

- Tanken

- if

- Illuminating

- bild

- bilder

- genomföras

- vikt

- med Esport

- förbättra

- in

- djupgående

- innefattar

- ingår

- Inklusive

- ökande

- alltmer

- individuellt

- oundviklig

- Oändlig

- informationen

- informativ

- Infrastruktur

- inneboende

- inneboende

- Innovation

- innovativa

- ingång

- insikter

- exempel

- istället

- integrering

- Intelligens

- interaktion

- sammankopplade

- intressen

- interventioner

- in

- introducerade

- inbjudna

- IT

- artikel

- jpg

- domar

- Nyckel

- Vet

- kunskap

- känd

- lab

- märkning

- landskap

- språk

- Large

- bestående

- senaste

- om

- leda

- ledande

- LÄRA SIG

- lärt

- studerande

- inlärning

- lär

- Legacy

- mindre

- Lärdomar

- Låt

- nivåer

- ligger

- ljus

- tycka om

- sannolikhet

- begränsning

- Begränsad

- linda

- Lista

- Bor

- LLM

- lokal

- Lång

- längre

- se

- du letar

- Maskinen

- maskininlärning

- utskick

- Huvudsida

- hantera

- hantera

- många

- Master

- matchande

- Materialet

- Betyder Något

- max-bredd

- Maj..

- meningsfull

- mekanismer

- Minnen

- Minne

- bara

- meddelanden

- meta

- metod

- Metrics

- kanske

- miljon

- minimerar

- minuter

- saknas

- modell

- modeller

- ögonblick

- månader

- mer

- mer effektiv

- mest

- rörd

- mycket

- multipel

- måste

- namn

- nativ

- Natural

- Behöver

- negativ

- Nya

- New Orleans

- Nej

- Brus

- Ingen

- Notera

- roman

- nu

- nyanser

- antal

- objektet

- objekt

- of

- erbjudanden

- erbjuda

- Erbjudanden

- Ofta

- äldre

- on

- ONE

- nätet

- endast

- öppet

- öppen källkod

- öppnade

- Verksamhet

- möjligheter

- Optimera

- Alternativet

- or

- Munhälsa

- Organiserad

- orleans

- Övriga

- Andra deltagare

- Övrigt

- vår

- över

- Översikt

- egen

- palm

- panel

- paradigm

- parametrar

- del

- deltagare

- deltog

- särskilt

- särskilt

- reservdelar till din klassiker

- Tidigare

- vägar

- mönster

- Personer

- för

- varseblivning

- Utföra

- prestanda

- perspektiv

- bit

- plato

- Platon Data Intelligence

- PlatonData

- plausibel

- spelar

- policy

- pose

- positiv

- positivt

- besitter

- Möjligheten

- möjlig

- potentiell

- potentiellt

- förutsäga

- presentera

- presentation

- presenteras

- föregående

- primärt

- primär

- Principerna

- Problem

- problem

- förfaranden

- process

- processer

- bearbetning

- producerad

- produktiv

- Professor

- djupt

- Programmering

- projektet

- projekt

- framträdande

- egenskaper

- beprövade

- ge

- förutsatt

- publicerade

- Syftet

- utförandet

- kvalitet

- sökfrågor

- quest

- ganska

- Lopp

- slumpmässig

- område

- snabb

- snabbt

- snarare

- betyg

- verklig

- verkliga världen

- rimlig

- motta

- mottagna

- senaste

- erkännande

- rekommenderas

- reducerande

- reflektion

- relationer

- relativt

- frigöra

- tillförlitlighet

- tillit

- Återstående

- repetitiva

- Rapportering

- representation

- representerar

- kräver

- Obligatorisk

- Krav

- forskning

- forskaren

- forskare

- Lös

- Resurser

- Svara

- svarande

- respons

- svar

- ansvarig

- översyn

- robusta

- Roll

- rotade

- ungefär

- rusa

- säker

- Säkerhet

- skalning

- scenarier

- scen

- Vetenskap

- VETENSKAPER

- Forskare

- se

- söker

- verkar

- sett

- semantik

- Serier

- formning

- delas

- hon

- Visar

- signera

- Signal

- signaler

- signifikant

- signifikant

- Enkelt

- enda

- färdigheter

- Small

- smartare

- smartphones

- So

- Social hållbarhet

- lösning

- Lösningar

- LÖSA

- några

- ljud

- Källa

- Utrymme

- rumsliga

- specifikt

- spendera

- Stabilitet

- stabil

- stanford

- Stanford University

- statistik

- Fortfarande

- strategier

- ström

- styrkor

- stark

- strukturering

- sådana

- Föreslår

- SAMMANFATTNING

- leverera

- överraskning

- Susan

- syntax

- syntes

- syntetisk

- syntetiska data

- system

- System

- takeaways

- tar

- Diskussion

- Talks

- uppgift

- uppgifter

- grupp

- tech

- Teknisk

- Tend

- villkor

- text

- än

- den där

- Smakämnen

- Framtiden

- deras

- Dem

- teman

- Där.

- Dessa

- de

- detta

- de

- tre

- Genom

- tid

- till

- tillsammans

- verktyg

- verktyg

- TOPPBOTS

- ämne

- ämnen

- Totalt

- mot

- Trackers

- traditionell

- Utbildning

- överföring

- transformator

- Öppenhet

- behandling

- Trend

- sanningen

- försöker

- SVÄNG

- två

- typiskt

- under

- genomgår

- förståelse

- universitet

- Uppdateringar

- användning

- Begagnade

- användare

- med hjälp av

- vanligen

- utnyttjas

- Värdefulla

- värde

- mängd

- olika

- levande

- Video

- Video

- synpunkter

- syn

- sårbarheter

- W3

- var

- sätt

- we

- wearable

- VÄL

- były

- Vad

- när

- närhelst

- medan

- om

- som

- medan

- VEM

- varför

- bred

- Brett utbud

- kommer

- fönster

- önskar

- med

- Arbete

- arbetssätt

- Fel

- år

- ännu

- Om er

- ung

- zephyrnet