Beskrivning

Algoritmer för artificiell intelligens kan inte fortsätta växa i sin nuvarande takt. Algoritmer som djupa neurala nätverk - som är löst inspirerade av hjärnan, med flera lager av artificiella neuroner kopplade till varandra via numeriska värden som kallas vikter - blir större för varje år. Men nuförtiden håller hårdvaruförbättringarna inte längre jämna steg med den enorma mängd minne och bearbetningskapacitet som krävs för att köra dessa enorma algoritmer. Snart kan storleken på AI-algoritmer träffa en vägg.

Och även om vi skulle kunna fortsätta att skala upp hårdvaran för att möta kraven från AI, finns det ett annat problem: att köra dem på traditionella datorer slösar enormt mycket energi. De höga koldioxidutsläppen som genereras av att köra stora AI-algoritmer är redan skadliga för miljön, och det kommer bara att bli värre när algoritmerna blir allt mer gigantiska.

En lösning, kallad neuromorphic computing, tar inspiration från biologiska hjärnor för att skapa energieffektiva konstruktioner. Tyvärr, även om dessa chips kan överträffa digitala datorer när det gäller att spara energi, har de saknat den beräkningskraft som behövs för att driva ett betydande djupt neuralt nätverk. Det har gjort dem lätta för AI-forskare att förbise.

Det ändrades äntligen i augusti, då Weier Wan, H.-S. Philip Wong, Gert Cauwenberghs och deras kollegor avslöjade ett nytt neuromorft chip kallas NeuRRAM som inkluderar 3 miljoner minnesceller och tusentals neuroner inbyggda i sin hårdvara för att köra algoritmer. Den använder en relativt ny typ av minne som kallas resistivt RAM, eller RRAM. Till skillnad från tidigare RRAM-chips är NeuRRAM programmerad att fungera på ett analogt sätt för att spara mer energi och utrymme. Även om det digitala minnet är binärt - lagrar antingen en 1 eller en 0 - kan analoga minnesceller i NeuRRAM-chippet var och en lagra flera värden längs ett helt kontinuerligt område. Det gör att chippet kan lagra mer information från massiva AI-algoritmer på samma mängd chiputrymme.

Som ett resultat kan det nya chippet fungera lika bra som digitala datorer på komplexa AI-uppgifter som bild- och taligenkänning, och författarna hävdar att det är upp till 1,000 XNUMX gånger mer energieffektivt, vilket öppnar upp möjligheten för små chip att köra allt mer komplicerade algoritmer inom små enheter som tidigare var olämpliga för AI som smarta klockor och telefoner.

Forskare som inte är involverade i arbetet har blivit djupt imponerade av resultaten. "Denna tidning är ganska unik," sa Zhongrui Wang, en mångårig RRAM-forskare vid University of Hong Kong. "Den ger bidrag på olika nivåer - på enhetsnivå, på kretsarkitekturnivå och på algoritmnivå."

Skapa nya minnen

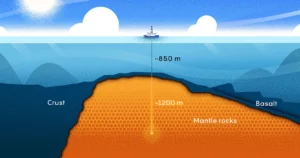

I digitala datorer orsakas de enorma mängderna energi som går till spillo när de kör AI-algoritmer av ett enkelt och allestädes närvarande designfel som gör varje enskild beräkning ineffektiv. Vanligtvis placeras en dators minne - som innehåller data och numeriska värden som det knarrar under beräkningen - på moderkortet bort från processorn, där beräkningen sker.

För informationen som strömmar genom processorn, "det är ungefär som att du spenderar åtta timmar på pendlingen, men du gör två timmars arbete", sa Wan, en datavetare tidigare vid Stanford University som nyligen flyttade till AI-starten Aizip.

Beskrivning

Att fixa det här problemet med nya allt-i-ett-chips som placerar minne och beräkning på samma plats verkar enkelt. Det är också närmare hur våra hjärnor sannolikt bearbetar information, eftersom många neuroforskare tror att beräkning sker inom populationer av neuroner, medan minnen bildas när synapserna mellan neuroner stärker eller försvagar deras kopplingar. Men att skapa sådana enheter har visat sig svårt, eftersom nuvarande former av minne är oförenliga med tekniken i processorer.

Datavetare utvecklade för årtionden sedan materialen för att skapa nya chips som utför beräkningar där minnet lagras - en teknik som kallas compute-in-memory. Men med traditionella digitala datorer som presterade så bra, förbises dessa idéer i årtionden.

"Det arbetet, precis som de flesta vetenskapliga arbeten, var typ bortglömt", säger Wong, professor vid Stanford.

Faktum är att första sådan anordning går tillbaka till åtminstone 1964, när elektroingenjörer vid Stanford upptäckte att de kunde manipulera vissa material, kallade metalloxider, för att slå på och av deras förmåga att leda elektricitet. Det är viktigt eftersom ett materials förmåga att växla mellan två tillstånd utgör ryggraden för traditionell minneslagring. I digitalt minne motsvarar ett tillstånd med hög spänning typiskt en 1 och låg spänning en 0.

För att få en RRAM-enhet att växla tillstånd, applicerar du en spänning över metallelektroder som är anslutna till två ändar av metalloxiden. Normalt är metalloxider isolatorer, vilket innebär att de inte leder elektricitet. Men med tillräckligt med spänning byggs strömmen upp, som så småningom trycker igenom materialets svaga punkter och formar en väg till elektroden på andra sidan. När strömmen väl har brutit igenom kan den flyta fritt längs den vägen.

Wong liknar den här processen vid blixtnedslag: När tillräckligt med laddning byggs upp i ett moln, hittar den snabbt en väg med låg motståndskraft och blixten slår ner. Men till skillnad från blixten, vars väg försvinner, förblir vägen genom metalloxiden, vilket betyder att den förblir ledande på obestämd tid. Och det är möjligt att radera den ledande banan genom att lägga en annan spänning på materialet. Så forskare kan växla ett RRAM mellan två tillstånd och använda dem för att lagra digitalt minne.

Midcentury-forskare insåg inte potentialen för energieffektiv datoranvändning, och de behövde det inte ännu med de mindre algoritmerna de arbetade med. Det dröjde till tidigt 2000-tal, med upptäckten av nya metalloxider, för forskare att inse möjligheterna.

Wong, som arbetade på IBM då, minns att en prisbelönt kollega som arbetade med RRAM medgav att han inte helt förstod fysiken inblandade. "Om han inte förstår det," minns Wong att han tänkte, "kanske jag inte borde försöka förstå det."

Men 2004 meddelade forskare vid Samsung Electronics att de hade framgångsrikt integrerat RRAM-minne byggt ovanpå ett traditionellt datorchip, vilket tyder på att ett compute-in-memory chip äntligen kan vara möjligt. Wong bestämde sig för att åtminstone försöka.

Compute-in-Memory Chips för AI

I mer än ett decennium arbetade forskare som Wong med att bygga upp RRAM-teknik till den punkt där den på ett tillförlitligt sätt kunde hantera kraftfulla datoruppgifter. Runt 2015 började datavetare inse den enorma potentialen hos dessa energieffektiva enheter för stora AI-algoritmer, som började ta fart. Det året, forskare vid University of California, Santa Barbara visade att RRAM-enheter kunde göra mer än att bara lagra minne på ett nytt sätt. De skulle kunna utföra grundläggande datoruppgifter själva - inklusive de allra flesta beräkningar som äger rum inom ett neurala nätverks artificiella neuroner, som är enkla matrismultiplikationsuppgifter.

I NeuRRAM-chippet är kiselneuroner inbyggda i hårdvaran, och RRAM-minnescellerna lagrar vikterna - de värden som representerar styrkan i förbindelserna mellan neuroner. Och eftersom NeuRRAM-minnescellerna är analoga, representerar vikterna som de lagrar hela intervallet av motståndstillstånd som uppstår medan enheten växlar mellan ett lågresistans till ett högresistanstillstånd. Detta möjliggör ännu högre energieffektivitet än vad digitalt RRAM-minne kan uppnå eftersom chippet kan köra många matrisberäkningar parallellt – snarare än i låssteg efter varandra, som i de digitala bearbetningsversionerna.

Men eftersom analog bearbetning fortfarande ligger decennier efter digital bearbetning, finns det fortfarande många problem att reda ut. En är att analoga RRAM-chips måste vara ovanligt exakta eftersom brister på det fysiska chipet kan introducera variabilitet och brus. (För traditionella kretsar, med endast två tillstånd, spelar dessa ofullkomligheter inte alls lika stor roll.) Det gör det betydligt svårare för analoga RRAM-enheter att köra AI-algoritmer, med tanke på att noggrannheten för att till exempel känna igen en bild kommer att bli lidande om RRAM-enhetens ledande tillstånd är inte exakt detsamma varje gång.

"När vi tittar på en belysningsbana är den annorlunda varje gång," sa Wong. "Så som ett resultat av det uppvisar RRAM en viss grad av stokasticitet - varje gång du programmerar dem är något annorlunda." Wong och hans kollegor bevisade att RRAM-enheter kan lagra kontinuerliga AI-vikter och fortfarande vara lika exakta som digitala datorer om algoritmerna är tränade för att vänja sig vid bruset de möter på chippet, ett framsteg som gjorde det möjligt för dem att producera NeuRRAM-chippet.

Beskrivning

En annan viktig fråga som de var tvungna att lösa var den flexibilitet som behövdes för att stödja olika neurala nätverk. Tidigare var chipdesigners tvungna att rada upp de små RRAM-enheterna i ett område bredvid större kiselneuroner. RRAM-enheterna och neuronerna var fastanslutna utan programmerbarhet, så beräkningen kunde bara utföras i en enda riktning. För att stödja neurala nätverk med dubbelriktad beräkning var extra ledningar och kretsar nödvändiga, vilket ökade energi- och utrymmesbehovet.

Så Wongs team designade en ny chiparkitektur där RRAM-minnesenheterna och kiselneuronerna blandades ihop. Denna lilla ändring av designen minskade den totala ytan och sparade energi.

"Jag tyckte [arrangemanget] var riktigt vackert," sa Melika Payvand, en neuromorf forskare vid Swiss Federal Institute of Technology Zürich. "Jag anser definitivt att det är ett banbrytande arbete."

Under flera år arbetade Wongs team med medarbetare för att designa, tillverka, testa, kalibrera och köra AI-algoritmer på NeuRRAM-chippet. De övervägde att använda andra nya typer av minne som också kan användas i ett compute-in-memory-chip, men RRAM hade en fördel på grund av dess fördelar i analog programmering och eftersom det var relativt lätt att integrera med traditionellt datormaterial.

Deras senaste resultat representerar det första RRAM-chippet som kan köra så stora och komplexa AI-algoritmer – en bedrift som tidigare bara varit möjlig i teoretiska simuleringar. "När det kommer till äkta kisel saknades den förmågan," sa Anup Das, en datavetare vid Drexel University. "Detta arbete är den första demonstrationen."

"Digitala AI-system är flexibla och exakta, men storleksordningar mindre effektiva", säger Cauwenberghs. Nu, sa Cauwenberghs, har deras flexibla, exakta och energieffektiva analoga RRAM-chip "överbryggt gapet för första gången."

Uppskalning

Teamets design håller NeuRRAM-chippet litet – precis som en fingernagel – samtidigt som det klämmer 3 miljoner RRAM-minnesenheter som kan fungera som analoga processorer. Och även om det kan köra neurala nätverk minst lika bra som digitala datorer gör, kan chippet också (och för första gången) köra algoritmer som utför beräkningar i olika riktningar. Deras chip kan mata in en spänning till raderna i RRAM-matrisen och läsa utdata från kolumnerna som är standard för RRAM-chips, men det kan också göra det bakåt från kolumnerna till raderna, så det kan användas i neurala nätverk som fungerar med data som flödar i olika riktningar.

Precis som med själva RRAM-tekniken har detta länge varit möjligt, men ingen tänkte på att göra det. "Varför tänkte vi inte på det här innan?" frågade Payvand. "I efterhand vet jag inte."

"Detta öppnar faktiskt upp för många andra möjligheter," sa Das. Som exempel nämnde han förmågan hos ett enkelt system att köra de enorma algoritmer som behövs för flerdimensionella fysiksimuleringar eller självkörande bilar.

Ändå är storleken ett problem. De största neurala nätverken innehåller nu miljarder vikter, inte de miljoner som finns i de nya chipsen. Wong planerar att skala upp genom att stapla flera NeuRRAM-chips ovanpå varandra.

Det kommer att vara lika viktigt att hålla energikostnaderna låga i framtida enheter, eller att skala ner dem ytterligare. Ett sätt att ta sig dit är genom kopiera hjärnan ännu närmare att anta kommunikationssignalen som används mellan verkliga neuroner: den elektriska spiken. Det är en signal som avfyras från en neuron till en annan när skillnaden i spänningen mellan insidan och utsidan av cellen når en kritisk tröskel.

"Det finns stora utmaningar där," sa Tony Kenyon, en nanoteknologiforskare vid University College London. "Men vi kanske fortfarande vill gå i den riktningen, för ... chansen är stor att du kommer att få större energieffektivitet om du använder mycket glesa spikar." Att köra algoritmer som spetsar på det nuvarande NeuRRAM-chippet skulle sannolikt kräva en helt annan arkitektur, men Kenyon noterade.

För nu har energieffektiviteten som teamet uppnått när de körde stora AI-algoritmer på NeuRRAM-chippet skapat nytt hopp om att minnesteknologier kan representera framtiden för datoranvändning med AI. Kanske kommer vi en dag till och med att kunna matcha den mänskliga hjärnans 86 miljarder neuroner och de biljoner synapser som förbinder dem utan att ta slut på ström.