Beskrivning

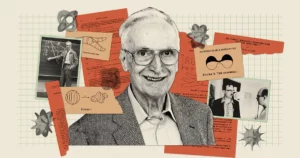

Artificiell intelligens verkar kraftfullare än någonsin, med chatbots som Bard och ChatGPT som kan producera kusligt mänsklig text. Men trots alla sina talanger låter dessa bots fortfarande forskare undra: Gör sådana modeller förstår faktiskt vad säger de? "Det är klart att vissa tror att de gör det", sa AI-pionjären Geoff Hinton i en senaste konversationen med Andrew Ng, "och vissa människor tror att de bara är stokastiska papegojor."

Denna suggestiva fras kommer från en 2021 papper medförfattare av Emily Bender, en beräkningslingvist vid University of Washington. Det tyder på att stora språkmodeller (LLM) – som utgör grunden för moderna chatbots – genererar text endast genom att kombinera information de redan har sett "utan någon hänvisning till mening", skrev författarna, vilket gör en LLM till "en stokastisk papegoja."

Dessa modeller driver många av dagens största och bästa chatbots, så Hinton hävdade att det är dags att avgöra omfattningen av vad de förstår. Frågan är för honom mer än akademisk. "Så länge vi har dessa meningsskiljaktigheter", sa han till Ng, "kommer vi inte att kunna komma till enighet om faror."

Ny forskning kan ha antydningar om ett svar. En teori utvecklad av Sanjeev Arora från Princeton University och Anirudh Goyal, en forskare vid Google DeepMind, föreslår att den största av dagens LLM inte är stokastiska papegojor. Författarna hävdar att när dessa modeller blir större och tränas på mer data, förbättrar de individuella språkrelaterade förmågor och utvecklar även nya genom att kombinera färdigheter på ett sätt som antyder förståelse - kombinationer som inte var sannolikt att existera i träningsdatan. .

Detta teoretiska tillvägagångssätt, som ger ett matematiskt bevisbart argument för hur och varför en LLM kan utveckla så många förmågor, har övertygat experter som Hinton och andra. Och när Arora och hans team testade några av dess förutsägelser fann de att dessa modeller betedde sig nästan exakt som förväntat. Av allt att döma har de gjort ett starkt argument för att de största LLM:erna inte bara pekar på vad de har sett tidigare.

"[De] kan inte bara härma vad som har setts i träningsdata," sa Sébastien Bubeck, en matematiker och datavetare vid Microsoft Research som inte var en del av arbetet. "Det är den grundläggande insikten."

Mer data, mer kraft

Uppkomsten av oväntade och olika förmågor i LLMs, det är rättvist att säga, kom som en överraskning. Dessa förmågor är inte en självklar konsekvens av hur systemen byggs och tränas. En LLM är ett massivt artificiellt neuralt nätverk som förbinder enskilda artificiella neuroner. Dessa anslutningar är kända som modellens parametrar, och deras antal anger LLM:s storlek. Utbildning innebär att ge LLM en mening med det sista ordet skymt, till exempel "Bränsle kostar en arm och en ___." LLM förutsäger en sannolikhetsfördelning över hela dess ordförråd, så om den kan, säg, tusen ord, förutsäger den tusen sannolikheter. Den väljer sedan det mest sannolika ordet för att slutföra meningen - förmodligen "ben".

Inledningsvis kan LLM välja ord dåligt. Träningsalgoritmen beräknar sedan en förlust - avståndet, i något högdimensionellt matematiskt utrymme, mellan LLM:s svar och det faktiska ordet i den ursprungliga meningen - och använder denna förlust för att justera parametrarna. Nu, givet samma mening, kommer LLM att beräkna en bättre sannolikhetsfördelning och dess förlust kommer att bli något lägre. Algoritmen gör detta för varje mening i träningsdatan (möjligen miljarder meningar), tills LLM:s totala förlust sjunker till acceptabla nivåer. En liknande process används för att testa LLM på meningar som inte ingick i träningsdatan.

En tränad och testad LLM, när den presenteras med en ny textprompt, kommer att generera det mest sannolika nästa ordet, lägga till det till prompten, generera ett annat nästa ord och fortsätta på detta sätt, vilket ger ett till synes sammanhängande svar. Ingenting i utbildningsprocessen tyder på att större LLMs, byggda med fler parametrar och träningsdata, också borde förbättras vid uppgifter som kräver resonemang för att besvara.

Men det gör de. Tillräckligt stora LLM:er visar förmågor - från att lösa elementära matematiska problem till att svara på frågor om vad som händer i andras sinnen - som mindre modeller inte har, även om de alla är tränade på liknande sätt.

"Var kom den [förmågan] ifrån?" undrade Arora. "Och kan det komma från bara nästa ords förutsägelse?"

Koppla färdigheter till text

Arora slog sig ihop med Goyal för att besvara sådana frågor analytiskt. "Vi försökte komma med en teoretisk ram för att förstå hur uppkomsten händer," sa Arora.

Duon vände sig till matematiska objekt som kallas slumpmässiga grafer. En graf är en samling punkter (eller noder) förbundna med linjer (eller kanter), och i en slumpmässig graf dikteras närvaron av en kant mellan två valfria noder slumpmässigt - säg av en myntvändning. Myntet kan vara partisk, så att det kommer upp i huvudet med viss sannolikhet p. Om myntet kommer upp för ett givet par av noder, bildas en kant mellan dessa två noder; annars förblir de oanslutna. Som värdet av p förändringar kan graferna visa plötsliga övergångar i deras egenskaper. Till exempel när p överskrider en viss tröskel, isolerade noder — de som inte är anslutna till någon annan nod — försvinner plötsligt.

Arora och Goyal insåg att slumpmässiga grafer, som ger upphov till oväntade beteenden efter att de når vissa trösklar, kan vara ett sätt att modellera beteendet hos LLM:er. Neurala nätverk har blivit nästan för komplexa att analysera, men matematiker har studerat slumpmässiga grafer under lång tid och har utvecklat olika verktyg för att analysera dem. Kanske kan slumpmässig grafteori ge forskare ett sätt att förstå och förutsäga de till synes oväntade beteenden hos stora LLM:er.

Forskarna bestämde sig för att fokusera på "bipartita" grafer, som innehåller två typer av noder. I deras modell representerar en typ av nod bitar av text - inte enskilda ord utan bitar som kan vara ett stycke till några sidor långa. Dessa noder är arrangerade i en rak linje. Under dem, på en annan rad, finns den andra uppsättningen noder. Dessa representerar de färdigheter som behövs för att förstå ett visst stycke text. Varje färdighet kan vara nästan vad som helst. Kanske representerar en nod en LLM:s förmåga att förstå ordet "eftersom", som innehåller en uppfattning om kausalitet; en annan kan representera att kunna dela två tal; ännu en annan kan representera förmågan att upptäcka ironi. "Om du förstår att texten är ironisk, vänder många saker," sa Arora. "Det är relevant för att förutsäga ord."

För att vara tydlig, är LLM inte utbildade eller testade med färdigheter i åtanke; de är bara byggda för att förbättra förutsägelsen nästa ord. Men Arora och Goyal ville förstå LLMs utifrån de färdigheter som kan krävas för att förstå en enskild text. En koppling mellan en färdighetsnod och en textnod, eller mellan flera färdighetsnoder och en textnod, betyder att LLM behöver dessa färdigheter för att förstå texten i den noden. Dessutom kan flera textstycken dra från samma färdighet eller uppsättning färdigheter; till exempel skulle en uppsättning färdighetsnoder som representerar förmågan att förstå ironi ansluta till de många textnoder där ironi förekommer.

Utmaningen nu var att koppla dessa tvådelade grafer till faktiska LLM:er och se om graferna kunde avslöja något om uppkomsten av kraftfulla förmågor. Men forskarna kunde inte lita på någon information om utbildning eller testning av faktiska LLMs - företag som OpenAI eller DeepMind offentliggör inte sin utbildning eller testdata. Arora och Goyal ville också förutsäga hur LLMs kommer att bete sig när de blir ännu större, och det finns ingen sådan information tillgänglig för kommande chatbots. Det fanns dock en viktig del av information som forskarna kunde komma åt.

Sedan 2021 har forskare som studerar prestandan hos LLM och andra neurala nätverk sett en universell egenskap dyka upp. De märkte att när en modell blir större, oavsett om den är i storlek eller mängd träningsdata, minskar dess förlust på testdata (skillnaden mellan förutspådda och korrekta svar på nya texter, efter träning) på ett mycket specifikt sätt. Dessa observationer har kodifierats till ekvationer som kallas neurala skalningslagar. Så Arora och Goyal utformade sin teori för att inte bero på data från någon enskild LLM, chatbot eller uppsättning tränings- och testdata, utan på den universella lagen som dessa system förväntas följa: förlusten som förutsägs av skalningslagar.

Kanske, resonerade de, var förbättrad prestanda - mätt med neurala skalningslagar - relaterad till förbättrade färdigheter. Och dessa förbättrade färdigheter skulle kunna definieras i deras tvådelade grafer genom anslutningen av färdighetsnoder till textnoder. Att etablera denna länk - mellan neurala skalningslagar och tvådelade grafer - var nyckeln som skulle tillåta dem att fortsätta.

Skala upp färdigheter

Forskarna började med att anta att det finns en hypotetisk tvådelad graf som motsvarar en LLM:s beteende på testdata. För att förklara förändringen i LLM:s förlust på testdata, föreställde de sig ett sätt att använda grafen för att beskriva hur LLM får färdigheter.

Ta till exempel färdigheten "förstår ironi." Denna idé representeras med en färdighetsnod, så forskarna tittar för att se vilka textnoder denna färdighetsnod ansluter till. Om nästan alla dessa anslutna textnoder är framgångsrika – vilket betyder att LLM:s förutsägelser om texten som representeras av dessa noder är mycket exakta – så är LLM kompetent i just denna färdighet. Men om mer än en viss bråkdel av färdighetsnodens anslutningar går till misslyckade textnoder, då misslyckas LLM med denna färdighet.

Denna koppling mellan dessa tvådelade grafer och LLMs gjorde det möjligt för Arora och Goyal att använda verktygen för slumpmässig grafteorin för att analysera LLM-beteende genom proxy. Att studera dessa grafer avslöjade vissa samband mellan noderna. Dessa relationer översattes i sin tur till ett logiskt och testbart sätt att förklara hur stora modeller fick de färdigheter som krävs för att uppnå sina oväntade förmågor.

Arora och Goyal förklarade först ett nyckelbeteende: varför större LLM:er blir skickligare än sina mindre motsvarigheter på individuella färdigheter. De började med den lägre testförlusten som förutspåddes av de neurala skalningslagarna. I en graf representeras denna lägre testförlust av ett fall i andelen misslyckade testnoder. Så det finns färre misslyckade testnoder totalt sett. Och om det finns färre misslyckade testnoder, då finns det färre kopplingar mellan misslyckade testnoder och färdighetsnoder. Därför är ett större antal färdighetsnoder kopplade till framgångsrika testnoder, vilket tyder på en växande kompetens i färdigheter för modellen. "En mycket liten minskning av förlusten ger upphov till att maskinen skaffar sig kompetens för dessa färdigheter," sa Goyal.

Därefter hittade paret ett sätt att förklara en större modells oväntade förmågor. När en LLMs storlek ökar och dess testförlust minskar, utvecklar slumpmässiga kombinationer av färdighetsnoder kopplingar till individuella textnoder. Detta tyder på att LLM också blir bättre på att använda mer än en färdighet åt gången och börjar generera text med hjälp av flera färdigheter – kombinerar, säg, förmågan att använda ironi med en förståelse av ordet ”eftersom” – även om dessa exakta kombinationer av färdigheter fanns inte i någon text i träningsdatan.

Föreställ dig till exempel en LLM som redan kan använda en färdighet för att generera text. Om du skalar upp LLM:s antal parametrar eller träningsdata med en storleksordning kommer den att bli lika kompetent att generera text som kräver två färdigheter. Gå upp ytterligare en storleksordning och LLM kan nu utföra uppgifter som kräver fyra färdigheter samtidigt, igen med samma kompetensnivå. Större LLM:er har fler sätt att sätta ihop färdigheter, vilket leder till en kombinatorisk explosion av förmågor.

Och när en LLM skalas upp blir möjligheten att den stött på alla dessa kombinationer av färdigheter i träningsdatan allt mer osannolik. Enligt reglerna för slumpmässig grafteorin, uppstår varje kombination från ett slumpmässigt urval av möjliga färdigheter. Så om det finns cirka 1,000 1,000 underliggande individuella färdighetsnoder i grafen och du vill kombinera fyra färdigheter, så finns det cirka 1 XNUMX till fjärde potensen - det vill säga XNUMX biljon - möjliga sätt att kombinera dem.

Arora och Goyal ser detta som ett bevis på att de största LLM:erna inte bara förlitar sig på kombinationer av färdigheter de såg i sina träningsdata. Bubeck håller med. "Om en LLM verkligen kan utföra dessa uppgifter genom att kombinera fyra av dessa tusen färdigheter, då måste det vara generalisering," sa han. Det betyder att det med stor sannolikhet inte är en stokastisk papegoja.

Verklig kreativitet?

Men Arora och Goyal ville gå bortom teorin och testa deras påstående att LLM:er blir bättre på att kombinera fler färdigheter, och därmed på att generalisera, när deras storlek och träningsdata ökar. Tillsammans med andra kollegor, de utformade en metod kallas "skill-mix" för att utvärdera en LLM:s förmåga att använda flera färdigheter för att generera text.

För att testa en LLM bad teamet den att generera tre meningar om ett slumpmässigt valt ämne som illustrerade några slumpmässigt valda färdigheter. Till exempel bad de GPT-4 (LLM som driver den mest kraftfulla versionen av ChatGPT) att skriva om dueller – i princip svärdsstrider. Dessutom bad de den att visa färdigheter inom fyra områden: självbetjänande partiskhet, metafor, statistisk syllogism och allmänkunskapsfysik. GPT-4 svarade med: ”Min seger i denna dans med stål [metafor] är lika säker som ett objekts fall till marken [fysik]. Som en känd duellist är jag till sin natur kvick, precis som de flesta andra [statistisk syllogism] av mitt rykte. Nederlag? Endast möjligt på grund av ett ojämnt slagfält, inte min otillräcklighet [selvtjänande partiskhet]." När GPT-4 blev ombedd att kontrollera dess utdata reducerade den till tre meningar.

Beskrivning

"Det är inte Hemingway eller Shakespeare," sa Arora, men teamet är övertygat om att det bevisar deras poäng: Modellen kan generera text som den omöjligen kunde ha sett i träningsdata, och visar färdigheter som stämmer överens med vad vissa skulle hävda är förståelse. GPT-4 klarar till och med färdighetsblandningstester som kräver sex färdigheter cirka 10 % till 15 % av tiden, sa han, och producerar textstycken som är statistiskt omöjliga att ha funnits i träningsdatan.

Teamet automatiserade också processen genom att få GPT-4 att utvärdera sin egen produktion, tillsammans med den från andra LLM:er. Arora sa att det är rättvist för modellen att utvärdera sig själv eftersom den inte har minne, så den kommer inte ihåg att den ombads att generera just den text som den ombeds att utvärdera. Yasaman Bahri, en forskare på Google DeepMind som arbetar på grunden för AI, tycker att det automatiserade tillvägagångssättet är "mycket enkelt och elegant."

När det gäller teorin är det sant att det gör några antaganden, sa Bubeck, men "dessa antaganden är inte på något sätt galna." Han var också imponerad av experimenten. "Vad [teamet] bevisar teoretiskt, och också bekräftar empiriskt, är att det finns sammansättningsgeneralisering, vilket betyder att [LLMs] kan sätta ihop byggstenar som aldrig har satts ihop," sa han. "Detta är för mig kärnan i kreativitet."

Arora tillägger att arbetet inte säger något om riktigheten i det som LLM skriver. "Faktum är att det argumenterar för originalitet," sa han. ”De här sakerna har aldrig funnits i världens utbildningskorpus. Ingen har någonsin skrivit detta. Det måste hallucinera."

Ändå tror Hinton att arbetet ligger till att vila frågan om LLM:er är stokastiska papegojor. "Det är den mest rigorösa metoden jag har sett för att visa att GPT-4 är mycket mer än bara en stokastisk papegoja," sa han. "De visar övertygande att GPT-4 kan generera text som kombinerar färdigheter och ämnen på sätt som nästan säkert inte förekom i träningsdata." (Vi nådde Bender för hennes perspektiv på det nya verket, men hon avböjde att kommentera, med hänvisning till brist på tid.)

Och faktiskt, som matematiken förutsäger, överträffar GPT-4:s prestanda vida den hos dess mindre föregångare, GPT-3.5 – i en utsträckning som skrämde Arora. "Det är förmodligen inte bara jag", sa han. "Många tyckte att det var lite kusligt hur mycket GPT-4 var bättre än GPT-3.5, och det hände inom ett år. Betyder det att vi om ett år kommer att ha en liknande förändring av den storleken? jag vet inte. Bara OpenAI vet.”

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://www.quantamagazine.org/new-theory-suggests-chatbots-can-understand-text-20240122/

- : har

- :är

- :inte

- :var

- ][s

- $UPP

- 000

- 1

- 15%

- 2021

- a

- förmågor

- förmåga

- Able

- Om oss

- tvärt

- akademiska

- godtagbart

- tillgång

- Enligt

- konton

- noggrannhet

- exakt

- Uppnå

- ACM

- förvärvande

- faktiska

- lägga till

- Lägger

- Efter

- igen

- instämmer

- AI

- algoritm

- Alla

- tillåter

- tillåts

- nästan

- längs

- redan

- också

- mängd

- an

- analysera

- och

- Andrew

- Annan

- svara

- svar

- svar

- vilken som helst

- något

- tillvägagångssätt

- cirka

- ÄR

- områden

- argumenterar

- argued

- Argumentet

- ARM

- anordnad

- konstgjord

- AS

- antaganden

- At

- Författarna

- Automatiserad

- tillgänglig

- grundläggande

- I grund och botten

- grund

- Battlefield

- BE

- därför att

- blir

- blir

- varit

- innan

- beteende

- beteenden

- Där vi får lov att vara utan att konstant prestera,

- tro

- nedan

- BÄST

- Bättre

- mellan

- Bortom

- förspänning

- partisk

- Stor

- större

- störst

- miljarder

- Bit

- Block

- botar

- Byggnad

- byggt

- men

- by

- beräkna

- beräknar

- kallas

- kom

- KAN

- kan inte

- kapabel

- Vid

- vissa

- säkerligen

- utmanar

- byta

- Förändringar

- chatbot

- chatbots

- ChatGPT

- ta

- Välja

- valda

- patentkrav

- klar

- kodifierade

- SAMMANHÄNGANDE

- Coin

- kollegor

- samling

- kombination

- kombinationer

- kombinera

- kombinerar

- kombinera

- komma

- kommer

- kommentar

- Företag

- behörig

- fullborda

- komplex

- förstå

- beräkningar

- dator

- säker

- Kontakta

- anslutna

- anslutning

- Anslutningar

- ansluter

- Konsensus

- Följaktligen

- innehålla

- fortsätta

- övertygad

- korrekt

- motsvarar

- Kostar

- kunde

- motsvarigheter

- galet

- kreativitet

- avgörande

- dansa

- faror

- datum

- beslutade

- minskar

- Deepmind

- definierade

- demonstrera

- betecknar

- bero

- beskriva

- utformade

- upptäcka

- Bestämma

- utveckla

- utvecklade

- Dikterad

- DID

- Skillnaden

- försvinna

- Visa

- visning

- avstånd

- fördelning

- flera

- dela

- do

- gör

- inte

- gör

- inte

- ner

- dra

- Droppar

- grund

- duo

- varje

- kant

- framträda

- uppkomst

- tillräckligt

- Hela

- ekvationer

- huvudsak

- upprättandet

- utvärdera

- Även

- NÅGONSIN

- Varje

- exakt

- exempel

- överstiger

- existerar

- finns

- förväntat

- experiment

- experter

- Förklara

- förklarade

- Explosionen

- utsträckning

- Faktum

- Misslyckades

- misslyckas

- verkligt

- Höst

- långt

- få

- färre

- slagsmål

- fynd

- Förnamn

- Flip

- Fokus

- För

- formen

- former

- kommande

- hittade

- Stiftelser

- fyra

- Fjärde

- fraktion

- Ramverk

- från

- vunnits

- resultat

- generera

- generera

- skaffa sig

- få

- Ge

- ges

- ger

- Ge

- Go

- kommer

- diagram

- grafer

- större

- Marken

- Odling

- hänt

- händer

- Har

- he

- huvuden

- här

- höggradigt

- honom

- tips

- hans

- Hur ser din drömresa ut

- Men

- HTTPS

- människolik

- i

- Tanken

- if

- inbillade

- omöjligt

- imponerad

- förbättra

- förbättras

- in

- inkorporerar

- Öka

- Ökar

- alltmer

- ja

- individuellt

- informationen

- inneboende

- insikt

- exempel

- Intelligens

- in

- ironi

- isolerat

- IT

- DESS

- sig

- bara

- Nyckel

- Vet

- känd

- vet

- Brist

- språk

- Large

- större

- största

- Efternamn

- Lag

- Lagar

- Lays

- Leads

- Lämna

- Nivå

- nivåer

- tycka om

- sannolikt

- linje

- rader

- LINK

- liten

- LLM

- logisk

- Lång

- länge sedan

- se

- förlust

- Lot

- lägre

- Maskinen

- gjord

- magasinet

- göra

- GÖR

- sätt

- många

- massiv

- matte

- matematisk

- matematiskt

- Maj..

- kanske

- me

- betyda

- betyder

- betyder

- Möt

- Minne

- bara

- metod

- Microsoft

- kanske

- emot

- sinnen

- modell

- modeller

- Modern Konst

- mer

- Dessutom

- mest

- mycket

- multipel

- måste

- my

- nödvändigt för

- behövs

- behov

- nät

- nätverk

- neurala

- neurala nätverk

- neurala nätverk

- nervceller

- aldrig

- Nya

- Nästa

- Nej

- nod

- noder

- inget

- Begrepp

- nu

- antal

- nummer

- talrik

- objekt

- skyms

- Uppenbara

- of

- on

- gång

- ONE

- ettor

- endast

- OpenAI

- Yttrande

- or

- beställa

- ursprungliga

- originalitet

- Övriga

- Övrigt

- annat

- ut

- produktion

- över

- övergripande

- egen

- sidor

- par

- parametrar

- del

- särskilt

- Förbi

- Personer

- Utföra

- prestanda

- kanske

- perspektiv

- Fysik

- Picks

- bit

- bitar

- pionjär

- plato

- Platon Data Intelligence

- PlatonData

- Punkt

- poäng

- Möjligheten

- möjlig

- eventuellt

- kraft

- den mäktigaste

- befogenheter

- företrädare

- förutse

- förutsagda

- förutsäga

- förutsägelse

- Förutsägelser

- Förutspår

- Närvaron

- presentera

- presenteras

- Princeton

- förmodligen

- problem

- Fortsätt

- process

- producerande

- bevis

- bevisbar

- bevisar

- ger

- ombud

- allmän

- sätta

- sätta

- Quantamagazin

- fråga

- frågor

- slumpmässig

- kommit fram till

- insåg

- verkligen

- Minskad

- reduktion

- referens

- relaterad

- Förhållanden

- relevanta

- förlita

- förblir

- ihåg

- känd

- svar

- representerar

- representerade

- representerar

- representerar

- rykte

- kräver

- Obligatorisk

- Kräver

- forskning

- forskaren

- forskare

- REST

- avslöjar

- avslöjade

- rigorös

- Rise

- regler

- Nämnda

- Samma

- såg

- säga

- säger

- Skala

- skalning

- Forskare

- se

- till synes

- verkar

- sett

- känsla

- mening

- in

- hon

- skall

- show

- liknande

- Liknande

- Enkelt

- enda

- SEX

- Storlek

- skicklighet

- skicklig

- färdigheter

- mindre

- So

- Lösa

- några

- något

- Utrymme

- specifik

- igång

- statistisk

- Fortfarande

- rakt

- stark

- Studerar

- framgångsrik

- sådana

- plötslig

- Föreslår

- överraskning

- svärd

- System

- talanger

- uppgifter

- grupp

- teamed

- testa

- testade

- Testning

- tester

- text

- än

- den där

- Smakämnen

- Grafen

- deras

- Dem

- sedan

- teoretiska

- Teorin

- Där.

- därför

- Dessa

- de

- saker

- tänker

- detta

- de

- fastän?

- tusen

- tre

- tröskelvärde

- Således

- tid

- till

- dagens

- tillsammans

- alltför

- verktyg

- ämne

- ämnen

- toronto

- tränad

- Utbildning

- övergångar

- Biljon

- sann

- försöker

- SVÄNG

- vände

- justera

- två

- Typ

- typer

- underliggande

- förstå

- förståelse

- Oväntat

- Universell

- universitet

- osannolik

- tills

- användning

- Begagnade

- användningar

- med hjälp av

- värde

- olika

- version

- mycket

- seger

- vill

- ville

- var

- washington

- Sätt..

- sätt

- we

- webp

- były

- Vad

- när

- om

- som

- VEM

- varför

- kommer

- med

- inom

- undrar

- ord

- ord

- Arbete

- fungerar

- Världens

- skulle

- skriva

- skriven

- skrev

- år

- ännu

- Om er

- zephyrnet