GTC Nvidias efterlängtade Hopper H100-acceleratorer kommer att börja levereras senare nästa månad i OEM-byggda HGX-system, sa kiseljätten vid sitt GPU Technology Conference (GTC)-evenemang idag.

De som väntar på att få tag på Nvidias DGX H100-system får dock vänta till någon gång under första kvartalet nästa år. DGX är Nvidias serie av arbetsstationer och servrar som använder sina GPU:er och sammankopplingar, och HGX-system är partnertillverkade servrar som återigen använder Nv:s teknologi.

Och medan Nvidia hysar sin Hopper-arkitektur i datacentret, kommer det mesta av företagspaketet som tillkännagavs denna vecka inte att få chipsjättens flaggskeppsarkitektur någon gång snart.

På kanten verkar Nvidia nöjd med att få ett helt liv från sin Ampere-arkitektur.

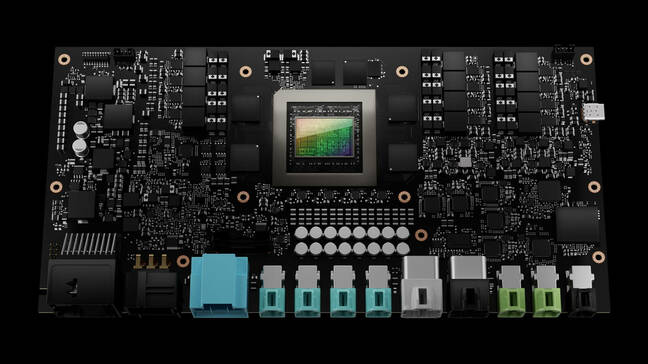

Idag presenterade Nvidia nästa generations edge AI och robotikplattform som den kallar IGX.

Nvidias IGX-plattform är ett systemkort i full storlek byggt kring ett Orin Industrial-system på modul

IGX är en "allt-i-ett-datorplattform för att påskynda utbyggnaden av realtids intelligenta maskiner och medicinsk utrustning," sa Kimberly Powell, veep of healthcare på Nvidia. I sin kärna är systemet i huvudsak en utökad version av Nvidias tidigare tillkännagivna Jetson AGX Orin-modul, meddelade detta vår.

"IGX är ett komplett system med Nvidia Orin-robotprocessorn, Ampere tensor-core GPU, ConnectX streaming I/O-processor, en funktionell säkerhetsö och säkerhetsmikrokontroller-enhet eftersom fler och fler robotar och människor kommer att arbeta i samma miljö ," tillade hon.

När det gäller prestanda är det inte mycket nytt här. Vi får höra att plattformen är baserad på ett Orin industrisystem på modul med 64 GB minne som är jämförbar i prestanda med AGX Orin-modulen som lanserades tidigare i år. Det systemet innehöll 32 GB minne, en octacore Arm Cortex A78AE CPU och Ampere-baserad GPU.

IGX får ett integrerat ConnectX-7 NIC för höghastighetsanslutning genom två 200 Gbps-gränssnitt. Kortet verkar också ha ett komplett komplement av M.2-lagring, PCIe-platser och minst en äldre PCI-plats för expansion.

Nvidia siktar på IGX-plattformen mot en mängd olika användningsfall för AI och robotik inom sjukvård, tillverkning och logistik, där konfidentialitet eller latens gör mer centraliserade system opraktiska.

Liksom AGX Orin kompletteras systemet av Nvidias AI Enterprise-programsvit och Fleet Command-plattform för driftsättning och hantering.

En av de första applikationerna av IGX-plattformen kommer att använda Nvidias bildplattform för robotik.

"Nvidia Clara Holoscan är vårt applikationsramverk som ligger ovanpå IGX för medicinsk utrustning och avbildningsrobotledningar," förklarade Powell.

Tre leverantörer av medicintekniska produkter – Activ Surgical, Moon Surgical och Proximinie – planerar att använda IGX och Clara Holoscan för att driva sina kirurgiska robotar och telenärvaroplattformar. IGX Orin-utvecklarsatser är planerade att levereras i början av nästa år med produktionssystem tillgängliga från ADLink, Advantech, Dedicated Computing, Kontron, MBX och Onyx för att nämna en handfull.

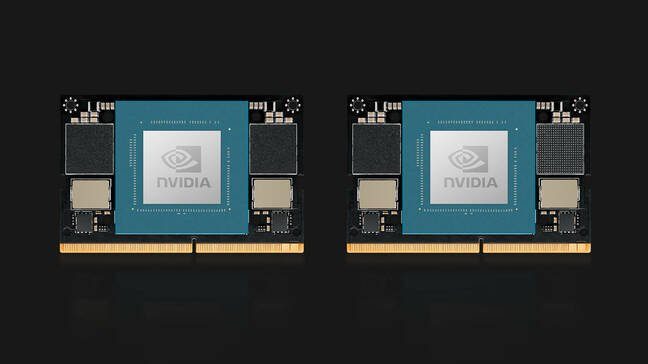

På ämnet Orin presenterade Nvidia också sina Jetson Orin Nano-beräkningsmoduler. Orin Nano är tillgänglig i två konfigurationer vid lanseringen, inklusive en 8GB-version som kan 40 TOPS av AI-inferencing och en nedskärningsversion med 4GB minne som kan 20 TOPS.

Liksom tidigare Jetson-moduler använder Orin Nano en stiftkompatibel kantkontakt som påminner om den som används för bärbar SODIMM-minne och förbrukar mellan 5W och 15W beroende på applikation och SKU. Nvidias Jetson Orin Nano-moduler är tillgängliga i januari från $199.

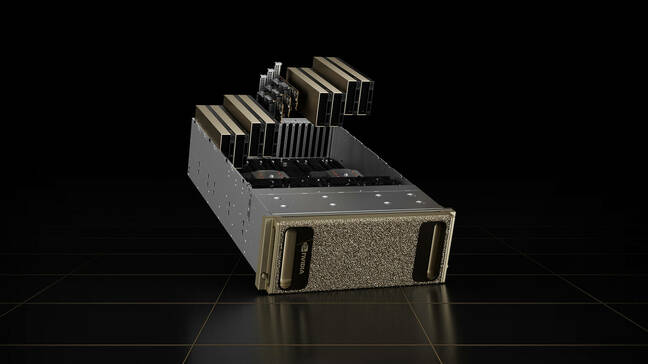

En OVX-uppdatering

Nvidias OVX-servrar, som är designade för att köra dess Omniverse-plattform, kommer inte heller att köras på Hopper.

Företagets andra generationens visualisering och digitala twinning-system är istället utrustade med åtta L40 GPU:er. Korten är baserade på företagets nästa generations Ada Lovelace-arkitektur och har Nvidias tredje generationens strålspårningskärnor och fjärde generationens Tensor Cores.

GPU:erna åtföljs av ett par Ice Lake Intel Xeon Platinum 8362-processorer, för totalt 128 processortrådar på upp till 3.6 GHz.

Beräkningssystemet åtföljs av tre ConnectX-7 NIC, som var och en klarar av 400 Gbps genomströmning och 16 TB NVMe-lagring. Medan systemet är tillgängligt som individuella noder, föreställer sig Nvidia att systemet distribueras som en del av vad det kallar en OVX SuperPod, som innehåller 32 system anslutna med företagets 51.2 Tbps Spectrum-3-switchar.

Andra generationens system kommer att vara tillgängliga från Lenovo, Supermicro och Inspur från 2023. I framtiden planerar Nvidia att utöka tillgängligheten av systemen till ytterligare partners.

Hoppade upp på Drive Thor

Det enda kitet som tillkännagavs på GTC den här veckan som får Nvidias Hopper-arkitektur är Drive Thors autonoma fordonsdatorsystem.

Drive Thor ersätter Nvidias Atlan-plattform på sin färdplan för 2025 och lovar att leverera 2,000 XNUMX TOPS av slutledningsprestanda när den lanseras.

"Drive Thor kommer packad med banbrytande funktioner som introduceras i vår Grace CPU, vår Hopper GPU och vår nästa generations GPU-arkitektur," sa Danny Shapiro, VP för Automotive på Nvidia, till en pressträff. Han sa att Drive Thor är utformad för att förena litanien av datorsystem som driver moderna bilar till en enda centraliserad plattform.

"Titta på dagens avancerade förarassistanssystem – parkering, förarövervakning, kameraspeglar, digitala instrumentkluster, infotainmentsystem – de finns alla på olika datorer fördelade i hela fordonet", sa han. ”År 2025 kommer dock dessa funktioner inte längre att vara separata datorer. Snarare kommer Drive Thor att göra det möjligt för tillverkare att effektivt konsolidera dessa funktioner till ett enda system."

För att klara av all information som strömmar från bilsensorer har chippet multi-compute-domän isolering, vilket Nvidia säger tillåter chipet att köra samtidiga kritiska processer utan avbrott.

Tekniken gör det också möjligt för chipet att köra flera operativsystem samtidigt för att passa de olika fordonsapplikationerna. Till exempel kan bilens kärnoperativsystem köras på Linux, medan infotainmentsystemet kan köra QNX eller Android.

Det är dock okänt när vi kan få se tekniken i aktion. Som det ser ut är alla tre av Nvidias lanseringspartner – Zeekr, Xpeng och QCraft – baserade i Kina. ®

- AI

- ai konst

- ai art generator

- har robot

- artificiell intelligens

- artificiell intelligenscertifiering

- artificiell intelligens inom bankväsendet

- artificiell intelligens robot

- robotar med artificiell intelligens

- programvara för artificiell intelligens

- blockchain

- blockchain konferens ai

- coingenius

- konversationskonstnärlig intelligens

- kryptokonferens ai

- dalls

- djupt lärande

- du har google

- maskininlärning

- plato

- plato ai

- Platon Data Intelligence

- Platon spel

- PlatonData

- platogaming

- skala ai

- syntax

- Registret

- zephyrnet