Datavetenskap och datateknikteam tillbringar en betydande del av sin tid i dataförberedelsefasen av en livscykel för maskininlärning (ML) och utför dataurval, rengöring och transformationssteg. Det är ett nödvändigt och viktigt steg i alla ML-arbetsflöden för att generera meningsfulla insikter och förutsägelser, eftersom data av dålig eller låg kvalitet avsevärt minskar relevansen av de härledda insikterna.

Datateknikteam är traditionellt ansvariga för intag, konsolidering och omvandling av rådata för nedströmskonsumtion. Datavetare behöver ofta göra ytterligare bearbetning av data för domänspecifika ML-användningsfall som naturligt språk och tidsserier. Till exempel kan vissa ML-algoritmer vara känsliga för saknade värden, glesa funktioner eller extremvärden och kräver särskild hänsyn. Även i de fall där datasetet är i gott skick kan datavetare vilja omvandla funktionsfördelningarna eller skapa nya funktioner för att maximera insikterna som erhålls från modellerna. För att uppnå dessa mål måste datavetare förlita sig på datateknikteam för att tillgodose begärda ändringar, vilket resulterar i beroende och förseningar i modellutvecklingsprocessen. Alternativt kan datavetenskapsteam välja att utföra dataförberedelser och funktionsteknik internt med hjälp av olika programmeringsparadigm. Det kräver dock en investering av tid och ansträngning i installation och konfiguration av bibliotek och ramverk, vilket inte är idealiskt eftersom den tiden kan användas bättre för att optimera modellprestanda.

Amazon SageMaker Data Wrangler förenklar dataförberedelsen och funktionsutvecklingsprocessen, vilket minskar tiden det tar att aggregera och förbereda data för ML från veckor till minuter genom att tillhandahålla ett enda visuellt gränssnitt för datavetare att välja, rengöra och utforska sina datauppsättningar. Data Wrangler erbjuder över 300 inbyggda datatransformationer för att normalisera, transformera och kombinera funktioner utan att behöva skriva någon kod. Du kan importera data från flera datakällor, som t.ex Amazon Simple Storage Service (Amazon S3), Amazonas Athena, Amazon RedShiftoch Snöflinga. Du kan nu också använda Databrickor som en datakälla i Data Wrangler för att enkelt förbereda data för ML.

Databricks Lakehouse-plattformen kombinerar de bästa delarna av datasjöar och datalager för att leverera tillförlitlighet, stark styrning och prestanda hos datalager med öppenhet, flexibilitet och maskininlärningsstöd från datasjöar. Med Databricks som datakälla för Data Wrangler kan du nu snabbt och enkelt ansluta till Databricks, interaktivt söka efter data som lagras i Databricks med hjälp av SQL och förhandsgranska data innan import. Dessutom kan du sammanfoga dina data i Databricks med data lagrade i Amazon S3 och data som efterfrågas via Amazon Athena, Amazon Redshift och Snowflake för att skapa rätt datauppsättning för ditt ML-användningsfall.

I det här inlägget transformerar vi Lending Club Loan-datauppsättningen med hjälp av Amazon SageMaker Data Wrangler för användning i ML-modellutbildning.

Lösningsöversikt

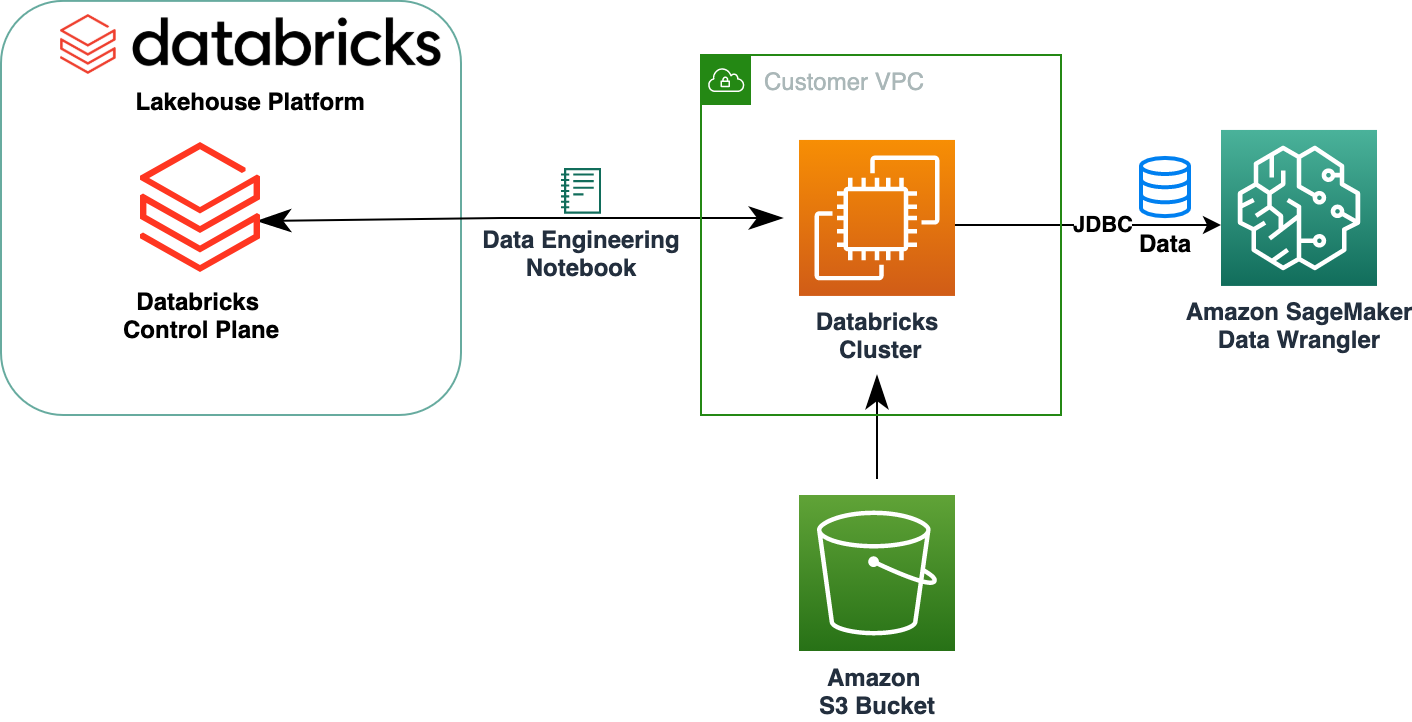

Följande diagram illustrerar vår lösningsarkitektur.

Databasen Lending Club Loan innehåller fullständiga lånedata för alla lån utfärdade under 2007–2011, inklusive aktuell lånestatus och senaste betalningsinformation. Den har 39,717 22 rader, 3 funktionskolumner och XNUMX måletiketter.

För att omvandla vår data med Data Wrangler genomför vi följande steg på hög nivå:

- Ladda ner och dela upp datasetet.

- Skapa ett Data Wrangler-flöde.

- Importera data från Databricks till Data Wrangler.

- Importera data från Amazon S3 till Data Wrangler.

- Gå med i data.

- Tillämpa transformationer.

- Exportera datauppsättningen.

Förutsättningar

Inlägget förutsätter att du har ett körande Databricks-kluster. Om ditt kluster körs på AWS, kontrollera att du har följande konfigurerade:

Databricks-inställning

- An instansprofil med nödvändiga behörigheter för att komma åt en S3-hink

- A hinkpolicy med nödvändiga behörigheter för mål S3-skopan

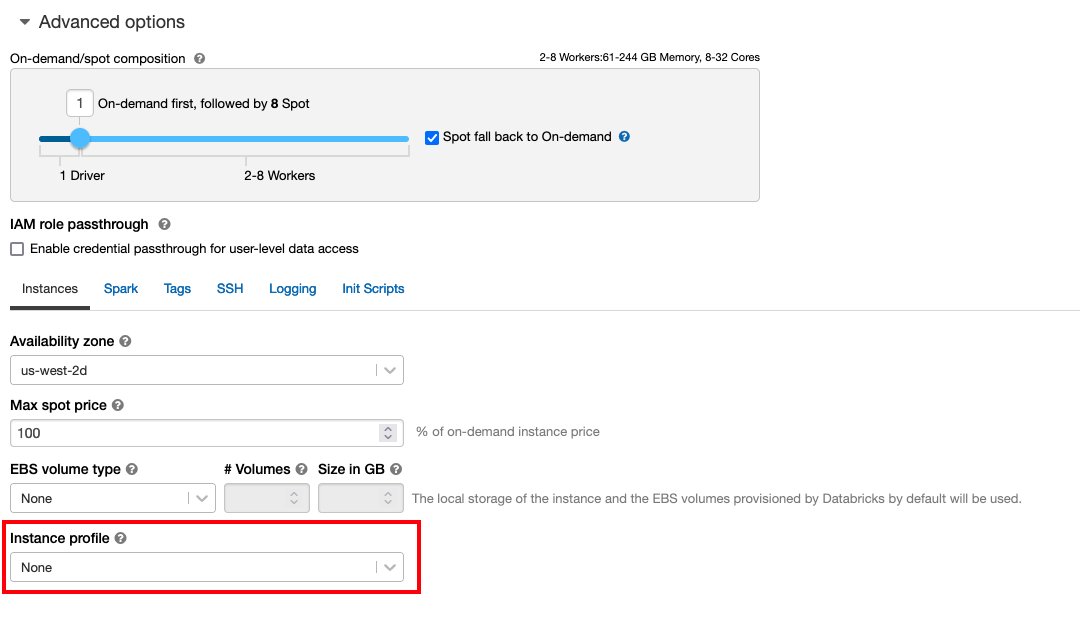

Följ Säker åtkomst till S3-hinkar med hjälp av instansprofiler för det erforderliga AWS identitets- och åtkomsthantering (IAM)-roller, S3-segmentpolicy och Databricks-klusterkonfiguration. Se till att Databricks-klustret är konfigurerat med rätt Instance Profile, vald under de avancerade alternativen, för att komma åt önskad S3-skopa.

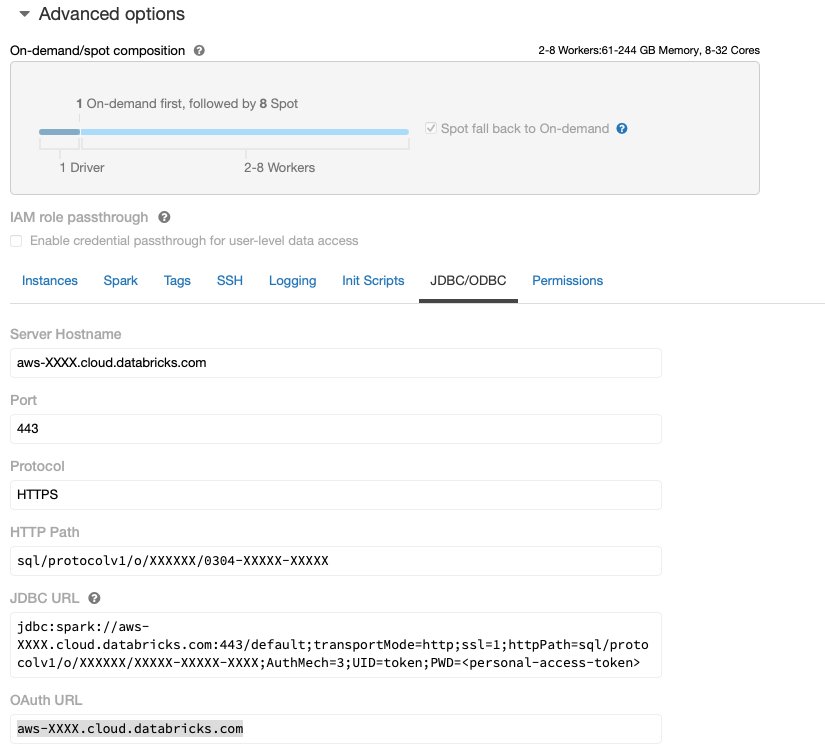

Efter att Databricks-klustret är igång med nödvändig åtkomst till Amazon S3 kan du hämta JDBC URL från ditt Databricks-kluster för att användas av Data Wrangler för att ansluta till det.

Hämta JDBC URL

Utför följande steg för att hämta JDBC-URL:

- I Databricks navigerar du till klustergränssnittet.

- Välj ditt kluster.

- På konfiguration fliken, välj Avancerade alternativ.

- Enligt Avancerade alternativ, Välj den JDBC/ODBC fliken.

- Kopiera JDBC URL.

Se till att ersätta din personliga åtkomst token i webbadressen.

Data Wrangler-inställning

Det här steget förutsätter att du har tillgång till Amazon SageMaker, en instans av Amazon SageMaker Studio, och en Studio-användare.

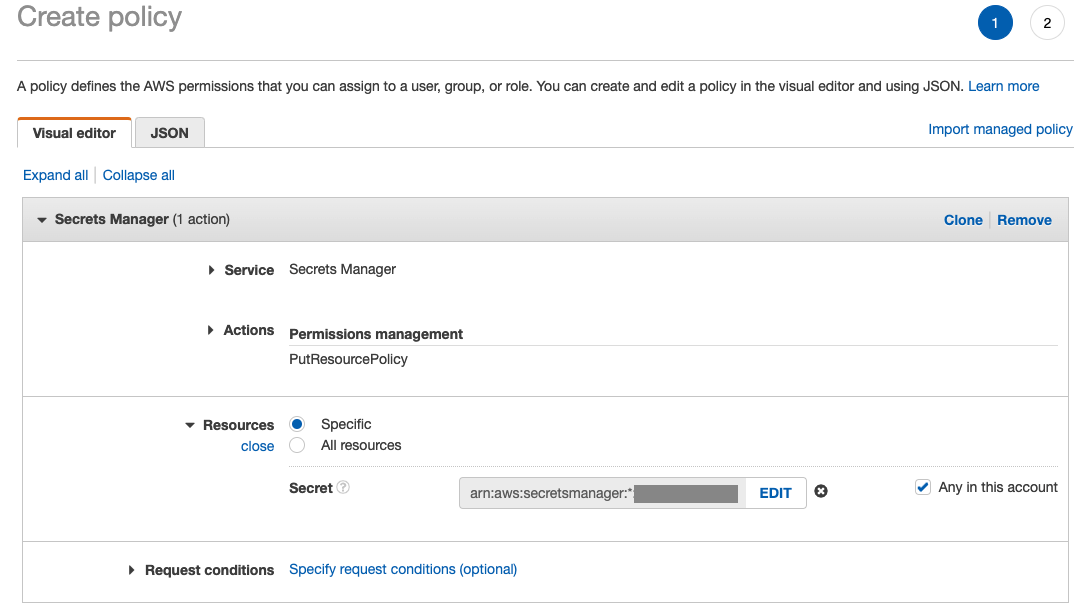

För att tillåta åtkomst till Databricks JDBC-anslutningen från Data Wrangler, kräver Studio-användaren följande behörighet:

secretsmanager:PutResourcePolicy

Följ stegen nedan för att uppdatera IAM-exekveringsrollen som tilldelats Studio-användaren med ovanstående behörighet, som administrativ IAM-användare.

- Välj på IAM-konsolen roller i navigeringsfönstret.

- Välj rollen som tilldelats din Studio-användare.

- Välja Lägg till behörigheter.

- Välja Skapa inline policy.

- För Service, välj Secrets Manager.

- On Handlingarväljer Åtkomstnivå.

- Välja Behörighetshantering.

- Välja PutResourcePolicy.

- För Resurserväljer Specifik och välj Alla på det här kontot.

Ladda ner och dela upp datasetet

Du kan börja med laddar ner datasetet. I demonstrationssyfte delar vi upp datasetet genom att kopiera funktionskolumnerna id, emp_title, emp_length, home_owneroch annual_inc att skapa en andra lån_2.csv fil. Vi tar bort de ovan nämnda kolumnerna från den ursprungliga lånefilen förutom id kolumn och byt namn på originalfilen till lån_1.csv. Ladda upp lån_1.csv fil till Databrickor för att skapa en tabell loans_1 och lån_2.csv i en S3 hink.

Skapa ett Data Wrangler-flöde

För information om Data Wrangler-förutsättningar, se Kom igång med Data Wrangler.

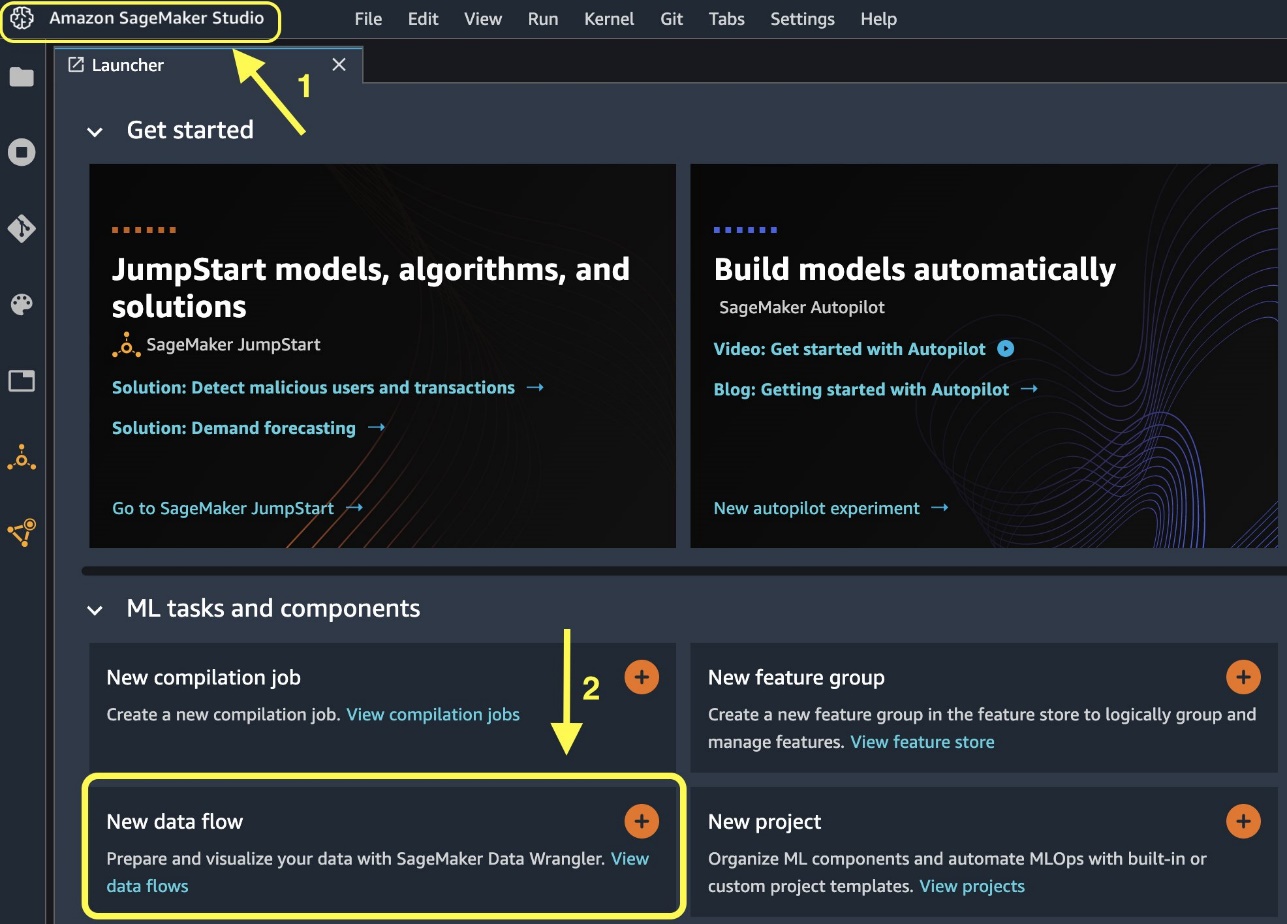

Låt oss komma igång med att skapa ett nytt dataflöde.

- På studiokonsolen, på Fil meny, välj Nya.

- Välja Data Wrangler-flöde.

- Byt namn på flödet efter önskemål.

Alternativt kan du skapa ett nytt dataflöde från startprogrammet.

Det kan ta några minuter att skapa ett nytt flöde. Efter att flödet har skapats ser du Importera datum sida.

Importera data från Databricks till Data Wrangler

Därefter satte vi upp Databricks (JDBC) som en datakälla i Data Wrangler. För att importera data från Databricks måste vi först lägga till Databricks som en datakälla.

- På Importera datum fliken i ditt Data Wrangler-flöde, välj Lägg till datakälla.

- Välj på rullgardinsmenyn Databricks (JDBC).

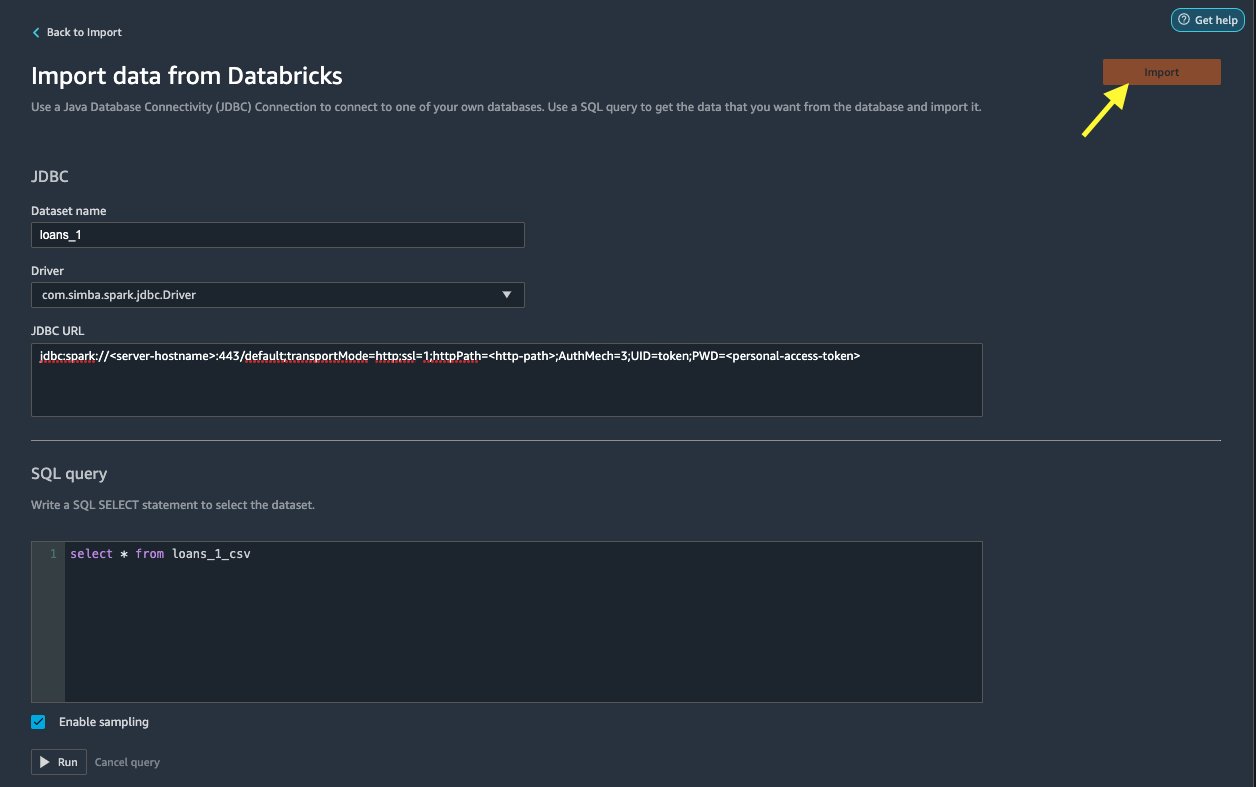

På Importera data från Databricks sida anger du dina klusterdetaljer.

- För Datasetnamn, ange ett namn som du vill använda i flödesfilen.

- För Chaufför, välj drivrutinen

com.simba.spark.jdbc.Driver. - För JDBC URL, ange webbadressen till ditt Databricks-kluster som du fick tidigare.

URL:en ska likna följande format jdbc:spark://<serve- hostname>:443/default;transportMode=http;ssl=1;httpPath=<http- path>;AuthMech=3;UID=token;PWD=<personal-access-token>.

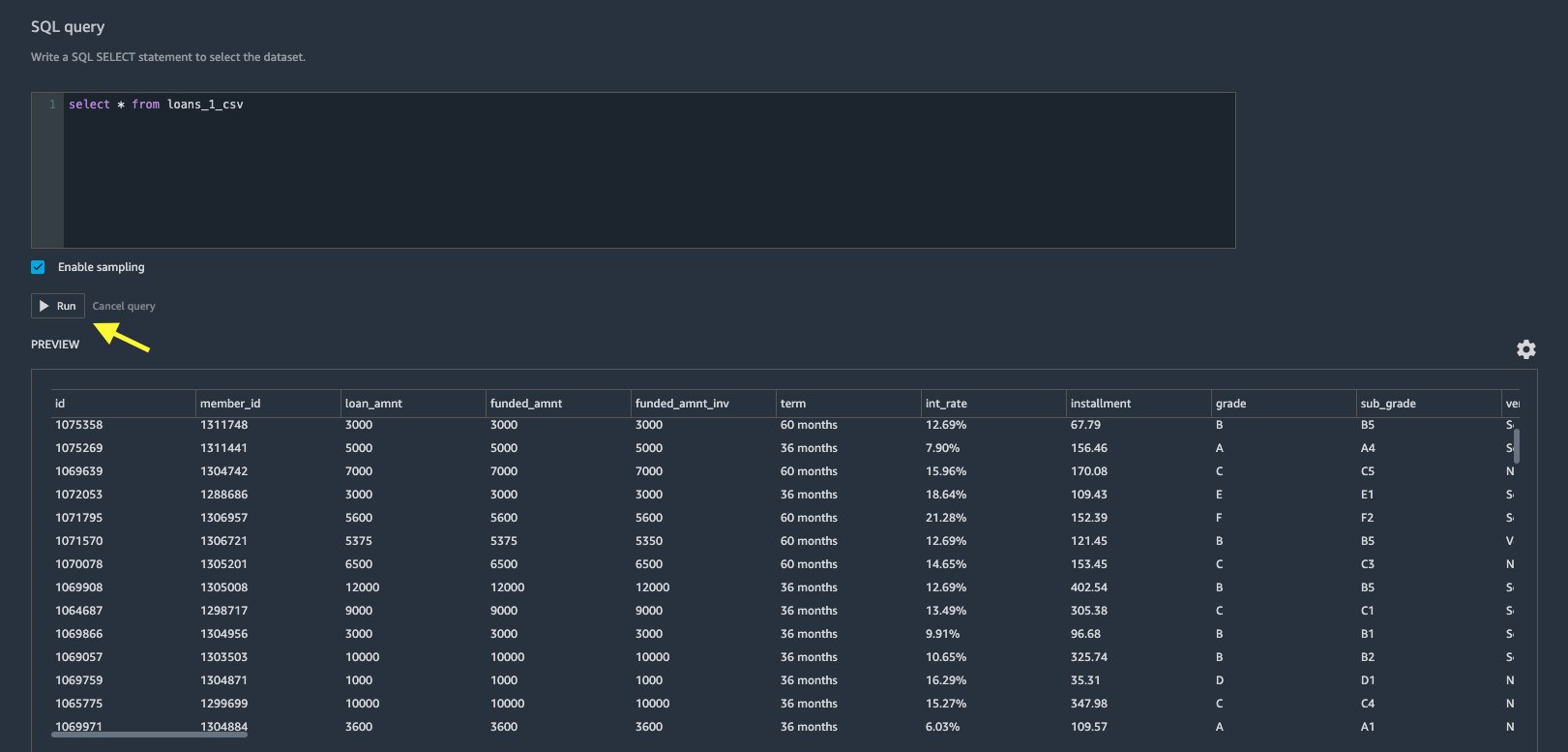

- Ange följande SQL SELECT-sats i SQL-frågeredigeraren:

Om du valde ett annat tabellnamn när du laddade upp data till Databricks, ersätt loans_1 i ovanstående SQL-fråga i enlighet med detta.

I SQL-fråga avsnittet i Data Wrangler, kan du fråga vilken tabell som helst som är ansluten till JDBC Databricks-databasen. Den förvalda Aktivera provtagning inställningen hämtar de första 50,000 XNUMX raderna i din datauppsättning som standard. Avmarkera beroende på datauppsättningens storlek Aktivera provtagning kan resultera i längre importtid.

- Välja Körning.

Att köra frågan ger en förhandsvisning av din Databricks-datauppsättning direkt i Data Wrangler.

Data Wrangler ger flexibiliteten att sätta upp flera samtidiga anslutningar till det ena Databricks-klustret eller flera kluster om det behövs, vilket möjliggör analys och förberedelse av kombinerade datauppsättningar.

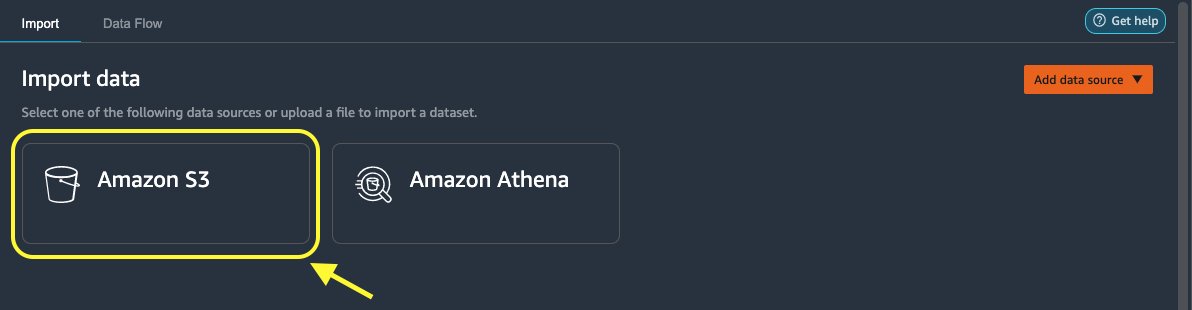

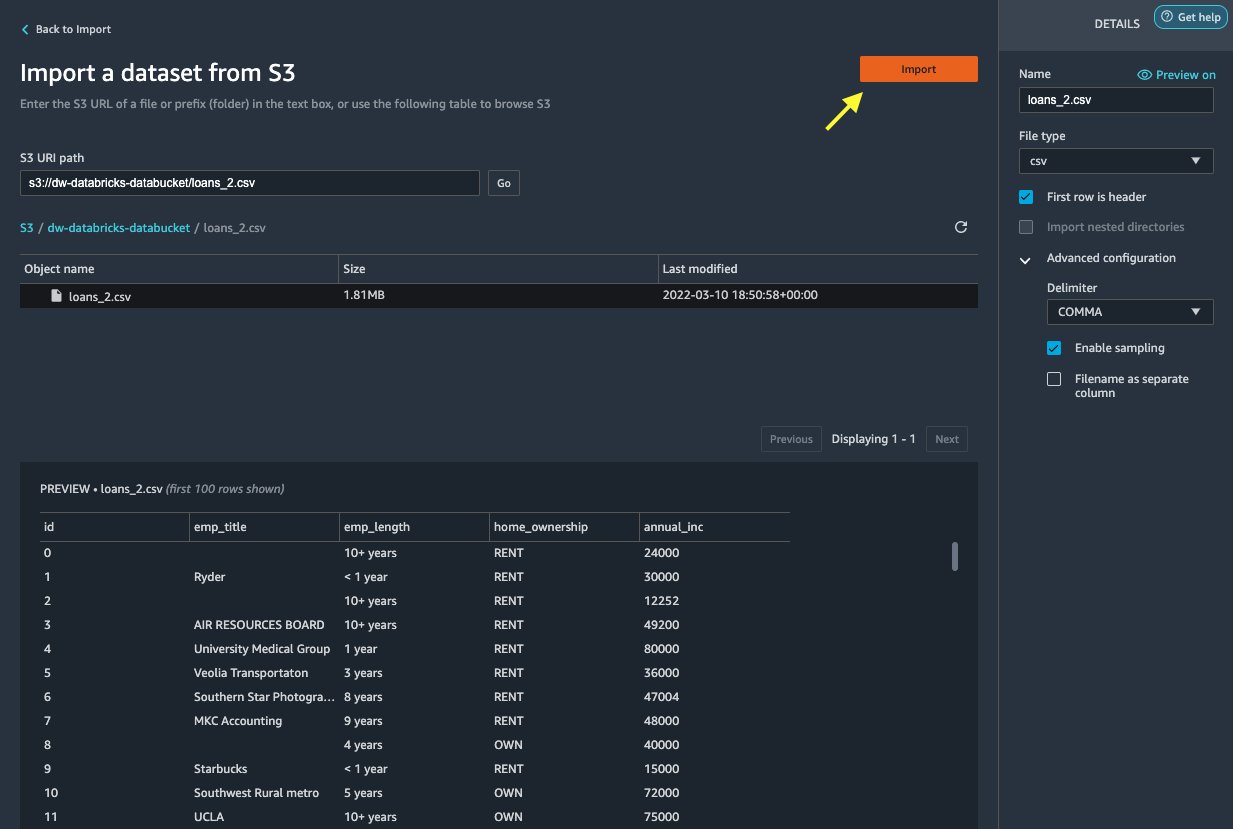

Importera data från Amazon S3 till Data Wrangler

Låt oss sedan importera loan_2.csv fil från Amazon S3.

När du väljer CSV-filen kan du förhandsgranska data.

- I Detaljer välj Avancerad konfiguration att försäkra sig Aktivera provtagning är vald och KOMMATECKEN är vald för avgränsare.

- Välja Importera.

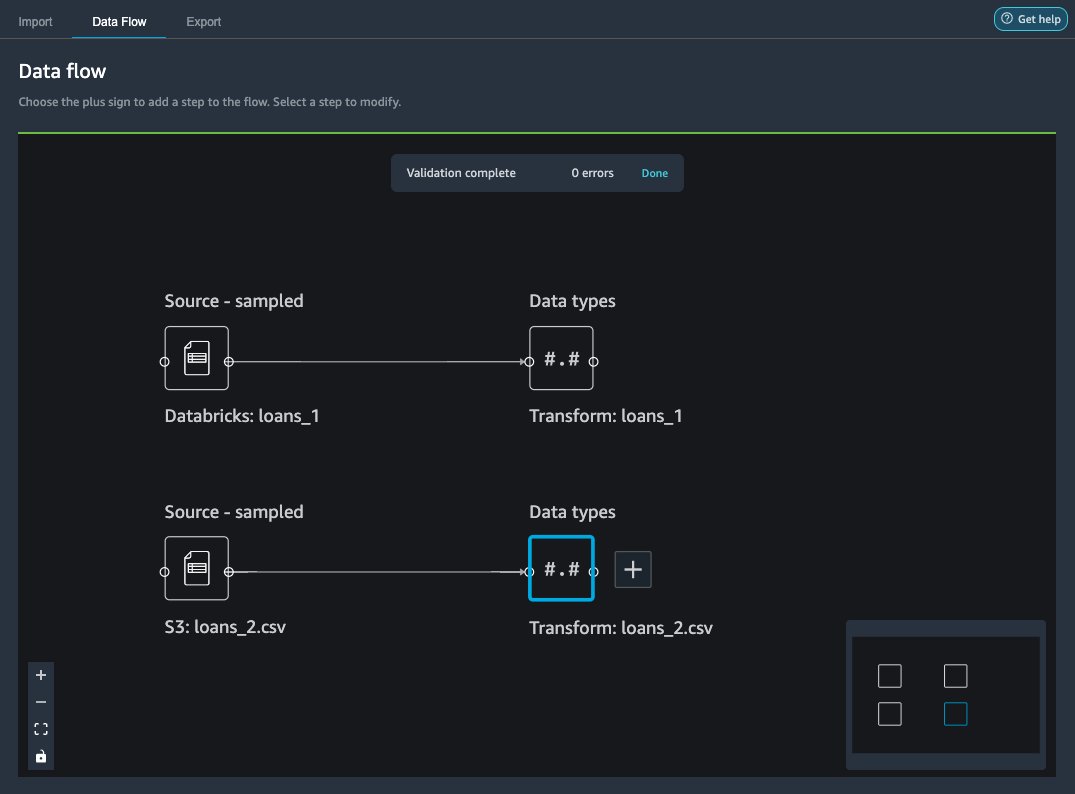

Efter loans_2.csv datauppsättningen har importerats framgångsrikt, dataflödesgränssnittet visar både Databricks JDBC- och Amazon S3-datakällor.

Gå med i data

Nu när vi har importerat data från Databricks och Amazon S3, låt oss sammanfoga datamängderna med hjälp av en gemensam unik identifierarkolumn.

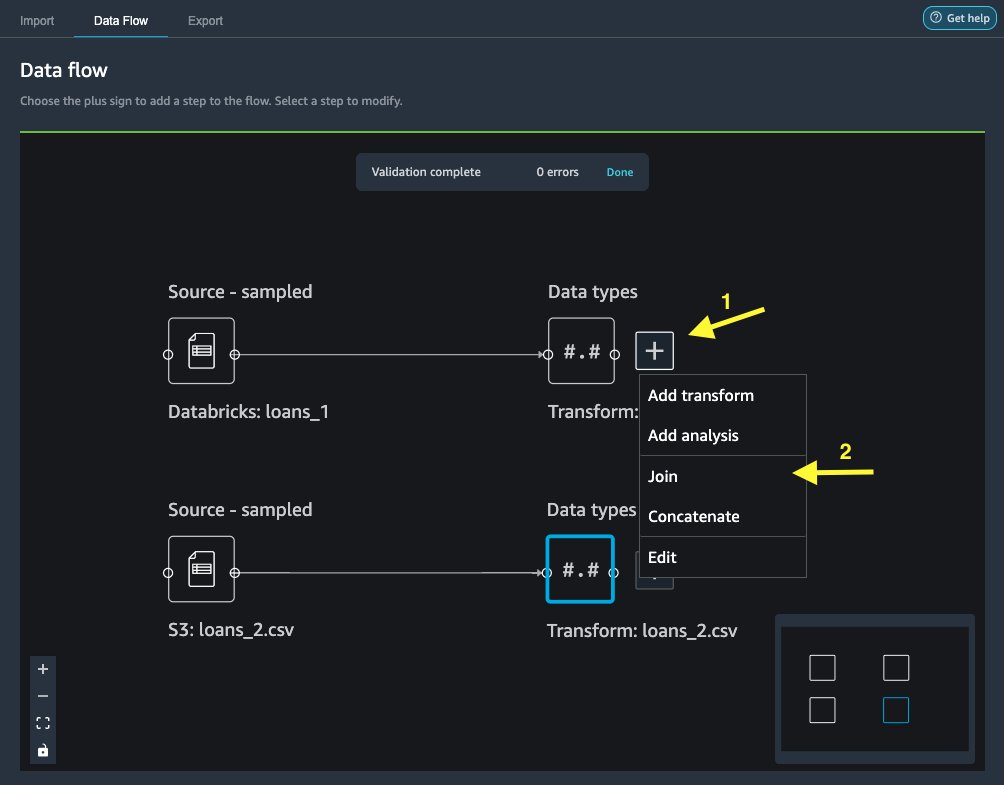

- På Data flöde flik, för Datatyper, välj plustecknet för

loans_1. - Välja Ansluta sig.

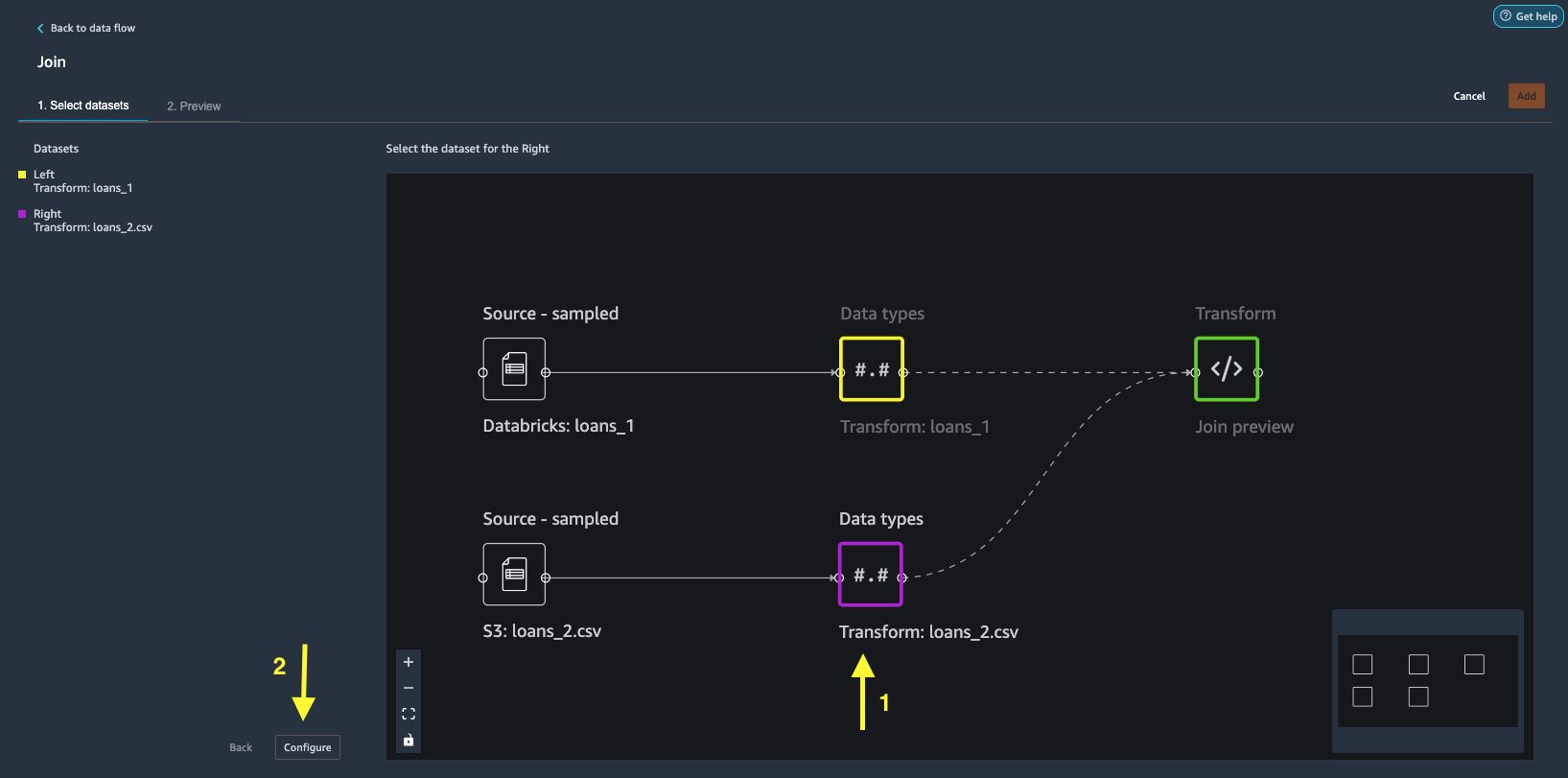

- Välj

loans_2.csvfil som Höger datasätt. - Välja Inställd för att ställa in anslutningskriterierna.

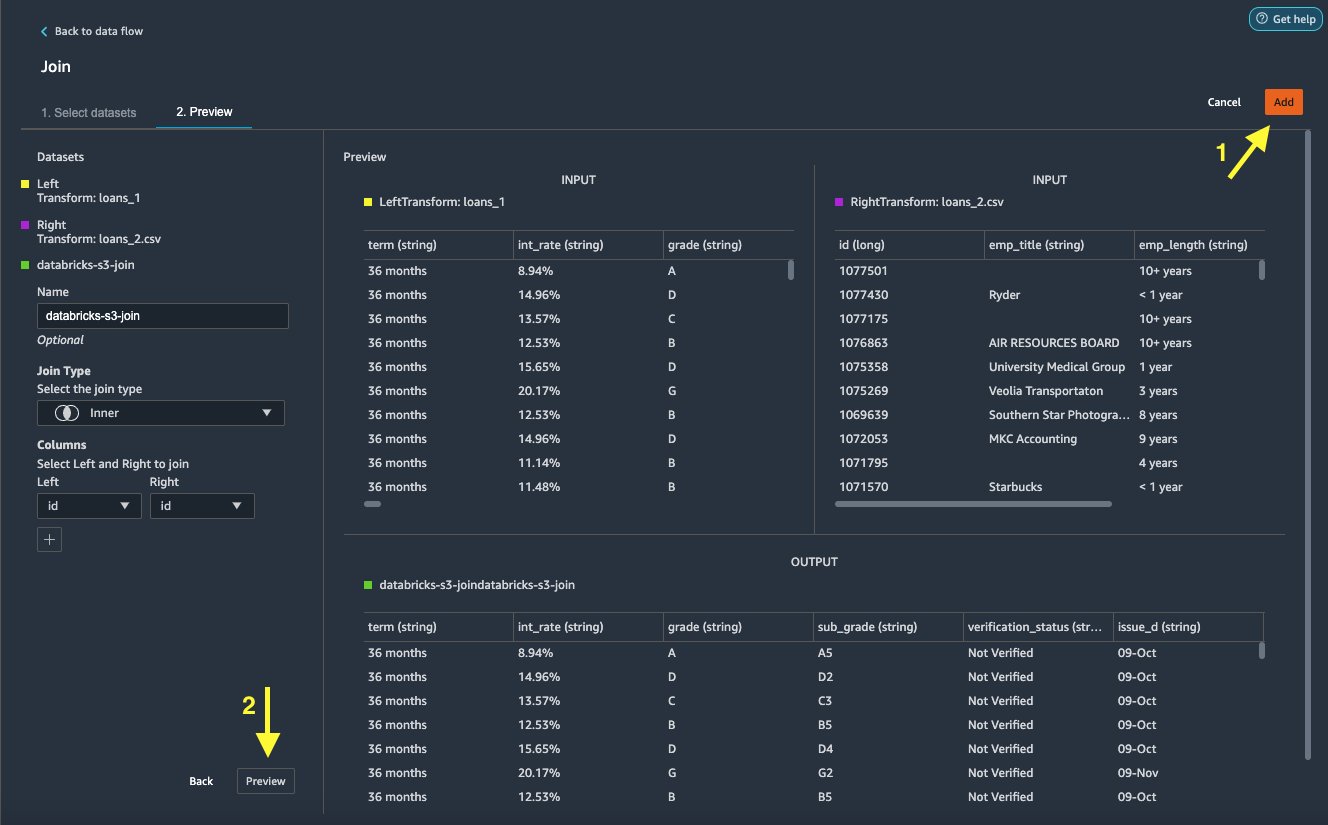

- För Namn , ange ett namn för anslutningen.

- För Gå med typväljer Inre för detta inlägg.

- Välj

idkolumn att gå med i. - Välja Ansök för att förhandsgranska den sammanfogade datamängden.

- Välja Lägg till för att lägga till det i dataflödet.

Tillämpa transformationer

Data Wrangler kommer med över 300 inbyggda transformationer, som inte kräver någon kodning. Låt oss använda inbyggda transformeringar för att förbereda datamängden.

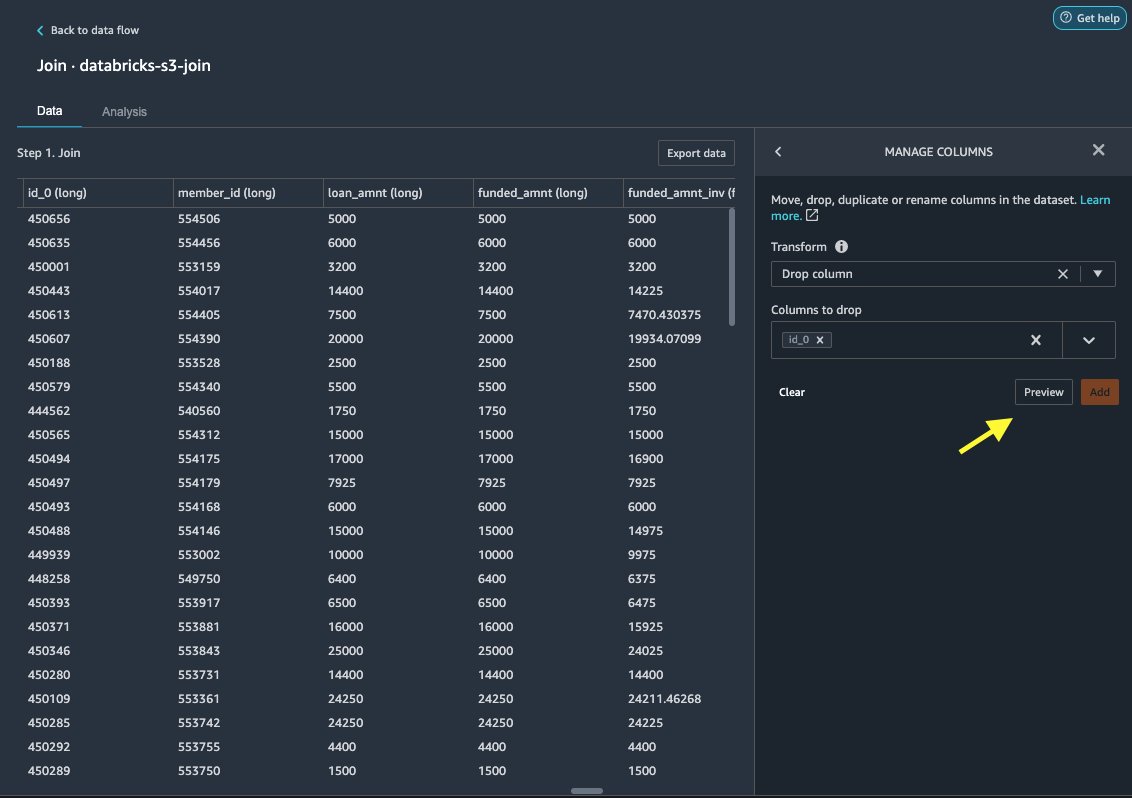

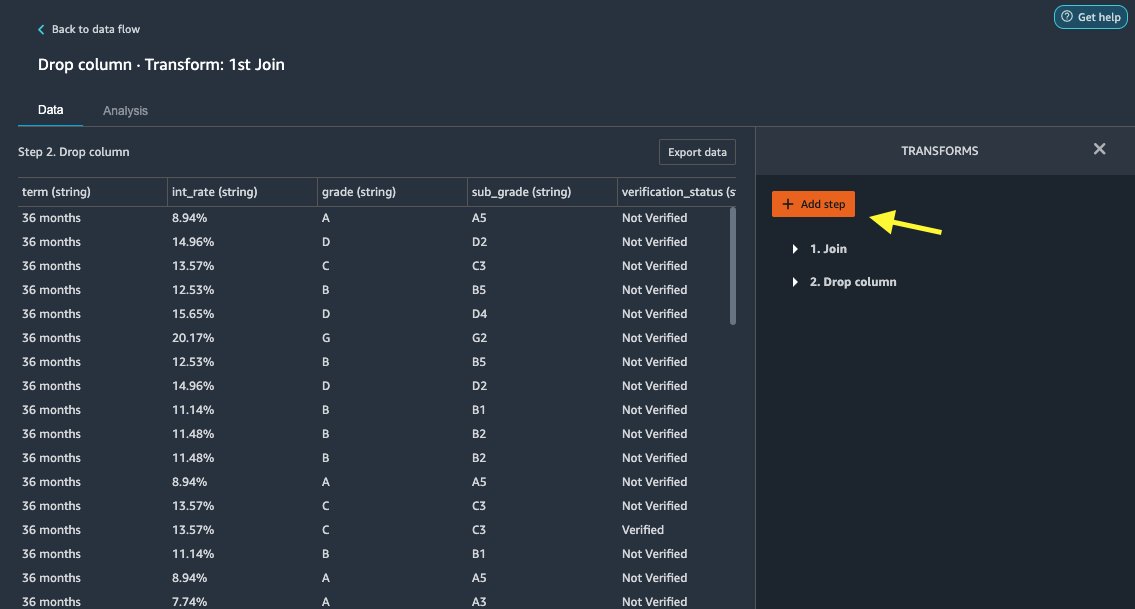

Släpp kolumn

Först släpper vi den redundanta ID-kolumnen.

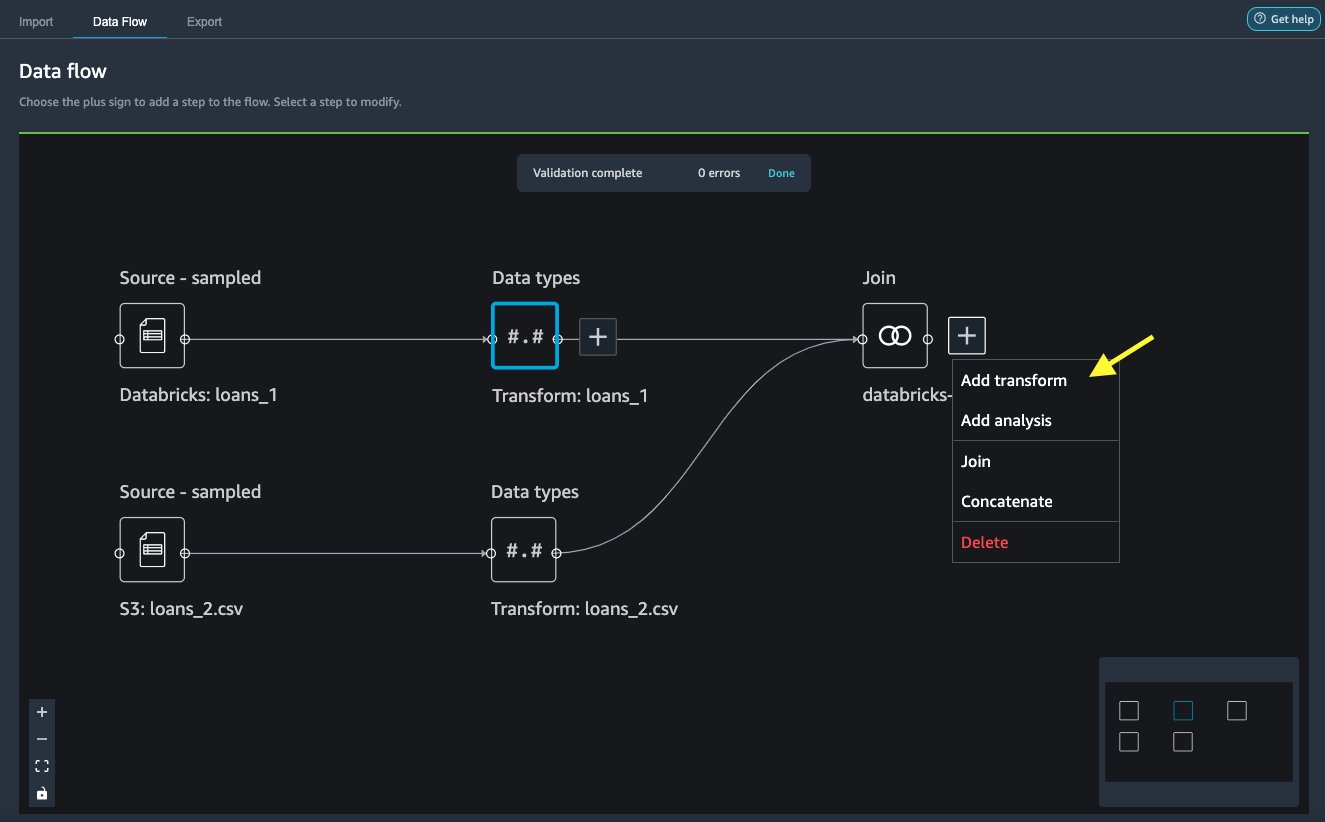

- Välj plustecknet på den sammanfogade noden.

- Välja Lägg till transform.

- Enligt Förvandlar, välja + Lägg till steg.

- Välja Hantera kolumner.

- För Förvandlaväljer Släpp kolumn.

- För Kolumner att släppa, välj kolumnen

id_0. - Välja Förhandsvisning.

- Välja Lägg till.

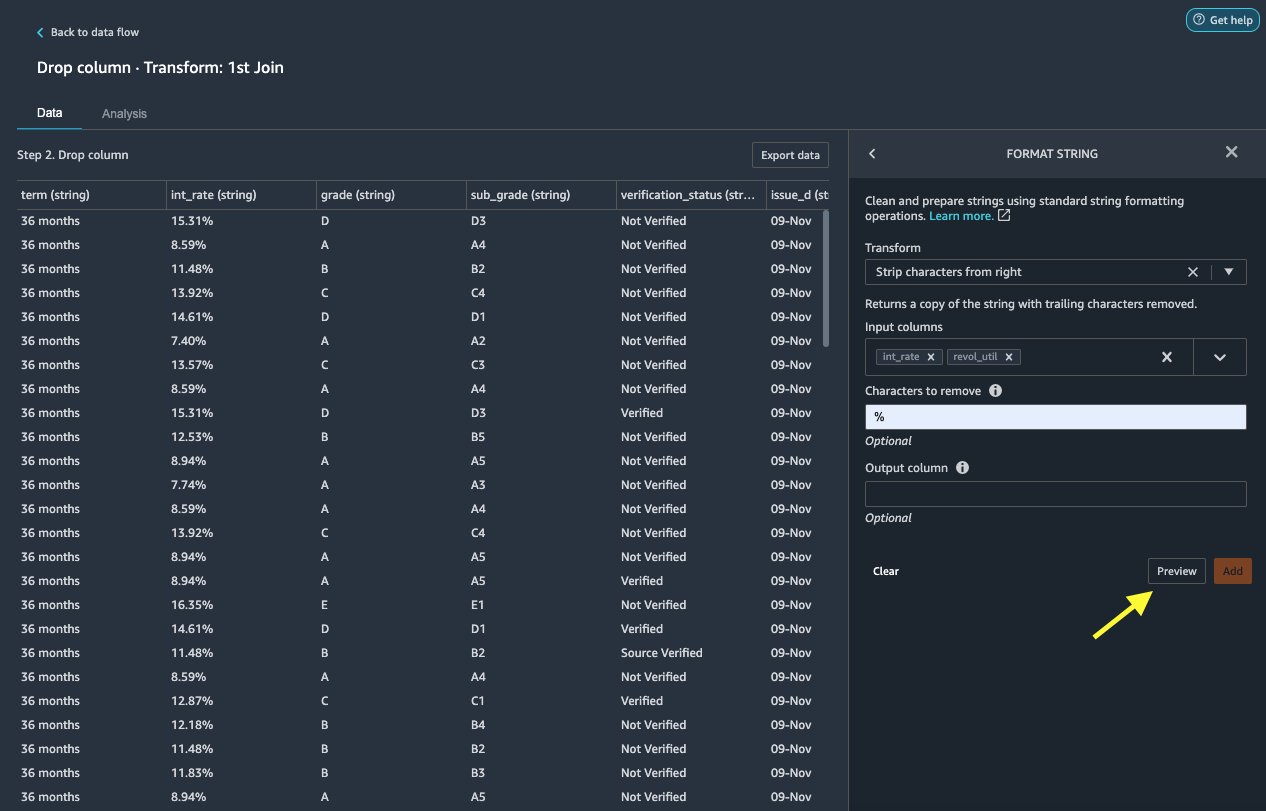

Formatera sträng

Låt oss använda strängformatering för att ta bort procentsymbolen från int_rate och revol_util kolumner.

- På Data flik, under Transväljer + Lägg till steg.

- Välja Formatera sträng.

- För Förvandlaväljer Ta bort tecken från höger.

Data Wrangler låter dig tillämpa din valda transformation på flera kolumner samtidigt.

- För Inmatningskolumnerväljer

int_rateochrevol_util. - För Tecken att ta bort, stiga på

%. - Välja Förhandsvisning.

- Välja Lägg till.

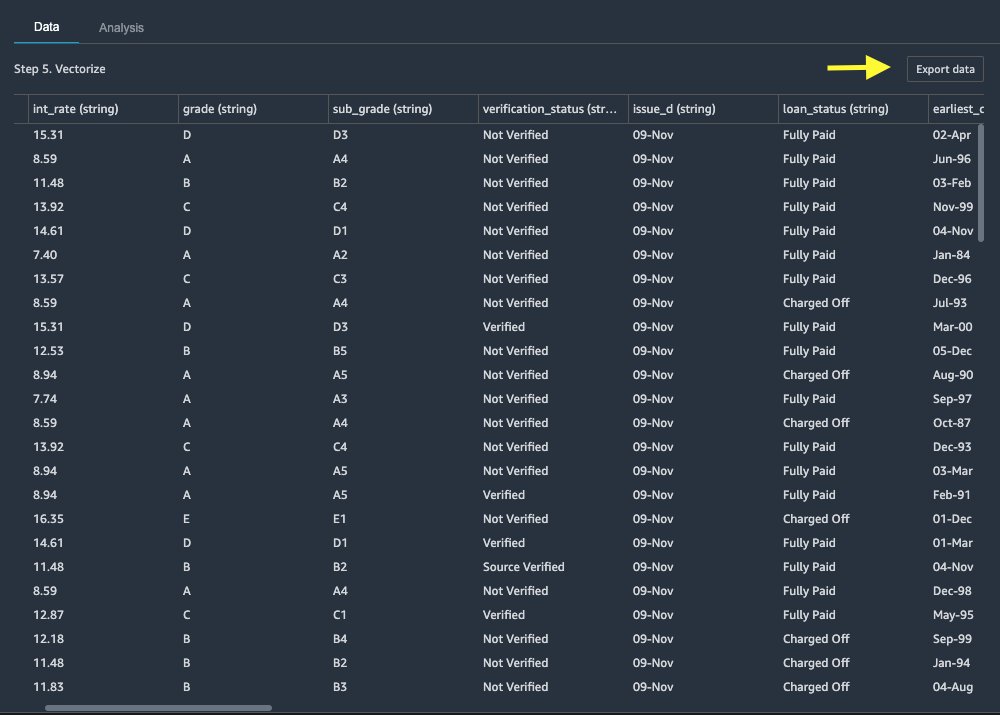

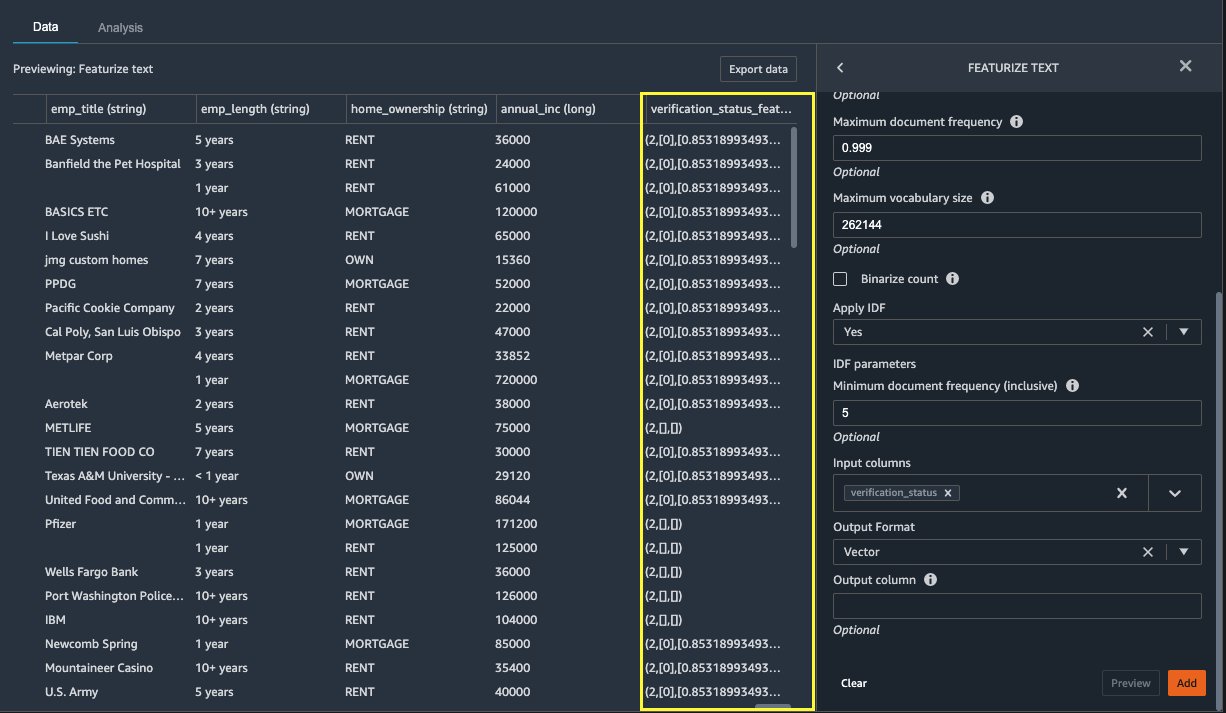

Presentera text

Låt oss nu vektorisera verification_status, en textfunktionskolumn. Vi omvandlar textkolumnen till termfrekvens–invers dokumentfrekvensvektorer (TF-IDF) genom att använda räknevektoriseraren och en standardtokenizer enligt beskrivningen nedan. Data Wrangler ger också möjlighet att ta med din egen tokenizer, om så önskas.

- Enligt Transformatorerväljer + Lägg till steg.

- Välja Presentera text.

- För Förvandlaväljer Vektorisera.

- För Inmatningskolumnerväljer

verification_status. - Välja Förhandsvisning.

- Välja Lägg till.

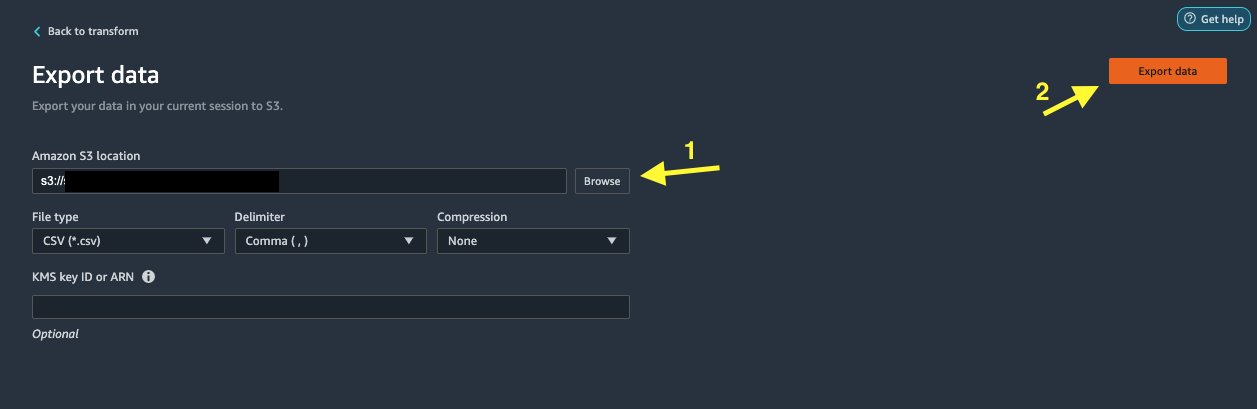

Exportera datamängden

När vi har tillämpat flera transformationer på olika kolumntyper, inklusive text, kategorisk och numerisk, är vi redo att använda den transformerade datamängden för ML-modellutbildning. Det sista steget är att exportera den transformerade datamängden till Amazon S3. I Data Wrangler har du flera alternativ att välja mellan för nedströmsförbrukning av transformationerna:

- Välja Exportsteg att automatiskt generera en Jupyter-anteckningsbok med SageMaker Processing-kod för bearbetning och exportera den transformerade datamängden till en S3-hink. För mer information, se Starta bearbetningsjobb med några få klick med Amazon SageMaker Data Wrangler.

- Exportera en Studio-anteckningsbok som skapar en SageMaker pipeline med ditt dataflöde, eller en anteckningsbok som skapar en Amazon SageMaker Feature Store funktionsgrupp och lägger till funktioner i en funktionsbutik offline eller online.

- Välja Exportera data för att exportera direkt till Amazon S3.

I det här inlägget drar vi nytta av Exportera data alternativet i Förvandla visa för att exportera den transformerade datamängden direkt till Amazon S3.

Städa upp

Om ditt arbete med Data Wrangler är klart, stäng av din Data Wrangler-instans för att undvika extra avgifter.

Slutsats

I det här inlägget tog vi upp hur du snabbt och enkelt kan ställa in och ansluta Databricks som en datakälla i Data Wrangler, interaktivt söka efter data lagrad i Databricks med SQL och förhandsgranska data innan import. Dessutom tittade vi på hur du kan sammanfoga din data i Databricks med data lagrad i Amazon S3. Vi tillämpade sedan datatransformationer på den kombinerade datamängden för att skapa en dataförberedelsepipeline. För att utforska fler data Wranglers analysmöjligheter, inklusive målläckage och generering av biasrapporter, se följande blogginlägg Accelerera databeredningen med Amazon SageMaker Data Wrangler för att förutsäga återinläggning av diabetiker.

För att komma igång med Data Wrangler, se Förbered ML-data med Amazon SageMaker Data Wrangler, och se den senaste informationen om Data Wrangler Produktsida.

Om författarna

Roop Bains är lösningsarkitekt på AWS med fokus på AI/ML. Han brinner för att hjälpa kunder att förnya sig och uppnå sina affärsmål med hjälp av artificiell intelligens och maskininlärning. På fritiden tycker Roop om att läsa och vandra.

Roop Bains är lösningsarkitekt på AWS med fokus på AI/ML. Han brinner för att hjälpa kunder att förnya sig och uppnå sina affärsmål med hjälp av artificiell intelligens och maskininlärning. På fritiden tycker Roop om att läsa och vandra.

Igor Alekseev är en Partner Solution Architect på AWS in Data and Analytics. Igor arbetar med strategiska partners som hjälper dem att bygga komplexa, AWS-optimerade arkitekturer. Innan han började på AWS, som Data/Solution Architect, implementerade han många projekt inom Big Data, inklusive flera datasjöar i Hadoop-ekosystemet. Som dataingenjör var han involverad i att tillämpa AI/ML för att upptäcka bedrägerier och kontorsautomation. Igors projekt var inom en mängd olika branscher, inklusive kommunikation, finans, allmän säkerhet, tillverkning och hälsovård. Tidigare arbetade Igor som full-stack ingenjör/tech lead.

Igor Alekseev är en Partner Solution Architect på AWS in Data and Analytics. Igor arbetar med strategiska partners som hjälper dem att bygga komplexa, AWS-optimerade arkitekturer. Innan han började på AWS, som Data/Solution Architect, implementerade han många projekt inom Big Data, inklusive flera datasjöar i Hadoop-ekosystemet. Som dataingenjör var han involverad i att tillämpa AI/ML för att upptäcka bedrägerier och kontorsautomation. Igors projekt var inom en mängd olika branscher, inklusive kommunikation, finans, allmän säkerhet, tillverkning och hälsovård. Tidigare arbetade Igor som full-stack ingenjör/tech lead.

Huong Nguyen är Sr. Product Manager på AWS. Hon leder användarupplevelsen för SageMaker Studio. Hon har 13 års erfarenhet av att skapa kundbesatta och datadrivna produkter för både företags- och konsumentutrymmen. På fritiden tycker hon om att läsa, vara i naturen och umgås med sin familj.

Huong Nguyen är Sr. Product Manager på AWS. Hon leder användarupplevelsen för SageMaker Studio. Hon har 13 års erfarenhet av att skapa kundbesatta och datadrivna produkter för både företags- och konsumentutrymmen. På fritiden tycker hon om att läsa, vara i naturen och umgås med sin familj.

Henry Wang är en mjukvaruutvecklingsingenjör på AWS. Han gick nyligen med i Data Wrangler-teamet efter examen från UC Davis. Han har ett intresse för datavetenskap och maskininlärning och gör 3D-utskrift som en hobby.

Henry Wang är en mjukvaruutvecklingsingenjör på AWS. Han gick nyligen med i Data Wrangler-teamet efter examen från UC Davis. Han har ett intresse för datavetenskap och maskininlärning och gör 3D-utskrift som en hobby.

- Myntsmart. Europas bästa bitcoin- och kryptobörs.

- Platoblockchain. Web3 Metaverse Intelligence. Kunskap förstärkt. FRI TILLGÅNG.

- CryptoHawk. Altcoin radar. Gratis provperiod.

- Källa: https://aws.amazon.com/blogs/machine-learning/prepare-data-from-databricks-for-machine-learning-using-amazon-sagemaker-data-wrangler/

- "

- 000

- 100

- 39

- 3d

- Om Oss

- tillgång

- rymma

- Annat

- avancerat

- Fördel

- algoritmer

- Alla

- amason

- analys

- analytics

- Tillämpa

- arkitektur

- konstgjord

- artificiell intelligens

- Konstgjord intelligens och maskininlärning

- delad

- Automation

- AWS

- Där vi får lov att vara utan att konstant prestera,

- BÄST

- Stora data

- Blogg

- gränsen

- SLUTRESULTAT

- inbyggd

- företag

- kapacitet

- fall

- Välja

- Rengöring

- klubb

- koda

- Kodning

- Kolumn

- kombinerad

- Gemensam

- Trygghet i vårdförloppet

- komplex

- konfiguration

- anslutna

- anslutning

- Anslutningar

- övervägande

- Konsol

- konsolidering

- Konsumenten

- konsumtion

- innehåller

- skapas

- skapar

- Skapa

- Aktuella

- Kunder

- datum

- datavetenskap

- Databas

- fördröja

- beroende

- Detektering

- Utveckling

- olika

- direkt

- displayer

- ner

- chaufför

- Drop

- lätt

- ekosystemet

- redaktör

- möjliggöra

- möjliggör

- ingenjör

- Teknik

- ange

- Företag

- exempel

- Utom

- utförande

- erfarenhet

- utforska

- familj

- Leverans

- Funktioner

- avgifter

- finansiering

- Förnamn

- Flexibilitet

- flöda

- efter

- format

- bedrägeri

- full

- generera

- generering

- god

- styrning

- Grupp

- hälso-och sjukvård

- hjälpa

- Hur ser din drömresa ut

- HTTPS

- Identitet

- genomföras

- med Esport

- importera

- Inklusive

- industrier

- informationen

- insikter

- Intelligens

- intresse

- Gränssnitt

- investering

- involverade

- IT

- Lediga jobb

- delta

- fogade

- Etiketter

- språk

- senaste

- leda

- ledande

- inlärning

- utlåning

- Lån

- såg

- Maskinen

- maskininlärning

- chef

- Produktion

- ML

- modell

- modeller

- mer

- multipel

- Natural

- Natur

- Navigering

- Nya funktioner

- anteckningsbok

- Erbjudanden

- offline

- nätet

- Alternativet

- Tillbehör

- beställa

- egen

- partnern

- partner

- brinner

- betalning

- procentuell

- prestanda

- personlig

- fas

- plattform

- policy

- Förutsägelser

- Förhandsvisning

- process

- Produkt

- Produkter

- Programmering

- projekt

- ger

- tillhandahålla

- allmän

- syfte

- snabbt

- Raw

- Läsning

- reducerande

- rapport

- kräver

- Obligatorisk

- ansvarig

- rinnande

- Säkerhet

- Vetenskap

- vetenskapsmän

- vald

- Serier

- service

- in

- inställning

- signifikant

- Enkelt

- Storlek

- Mjukvara

- mjukvaruutveckling

- lösning

- Lösningar

- utrymmen

- spendera

- Spendera

- delas

- stapel

- standard

- starta

- igång

- .

- status

- förvaring

- lagra

- Strategisk

- stark

- studio

- Framgångsrikt

- stödja

- Målet

- grupp

- Genom

- tid

- Utbildning

- Förvandla

- Transformation

- ui

- unika

- Uppdatering

- användning

- mängd

- olika

- medan

- utan

- Arbete

- arbetade

- fungerar

- skrivning