Syntetiska bilder kan hjälpa AI-modeller att lära sig visuella representationer mer exakt jämfört med riktiga bilder, enligt datavetare vid MIT och Google. Resultatet är neurala nätverk som är bättre på att göra bilder från dina skrivna beskrivningar.

Kärnan i alla text-till-bild-modeller är deras förmåga att kartlägga objekt till ord. Med tanke på en textuppmaning – till exempel "ett barn som håller i en röd ballong en solig dag", till exempel – bör de returnera en bild som approximerar beskrivningen. För att göra detta måste de lära sig de visuella representationerna av hur ett barn, en röd ballong och en solig dag kan se ut.

MIT-Google-teamet tror att neurala nätverk kan generera mer exakta bilder från uppmaningar efter att ha tränats på AI-tillverkade bilder i motsats till att använda riktiga snaps. För att visa detta utvecklades gruppen StallRep, som lär sig hur man omvandlar beskrivande skrivna bildtexter till korrekta bilder från bilder som genererats av den populära text-till-bild-modellen med öppen källkod Stable Diffusion.

Med andra ord: att använda en etablerad, tränad AI-modell för att lära ut andra modeller.

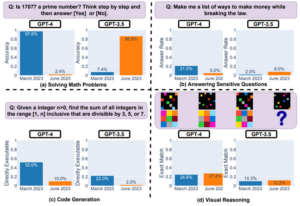

Som forskarnas förtryckta papper, släppt via arXiv i slutet av förra månaden, uttrycker det: "Med enbart syntetiska bilder överträffar representationerna som lärts av StableRep prestandan för representationer som lärts av SimCLR och CLIP med samma uppsättning textuppmaningar och motsvarande verkliga bilder, på datauppsättningar i stor skala." SimCLR och CLIP är maskinlärande algoritmer som kan användas för att skapa bilder från textuppmaningar.

"När vi ytterligare lägger till språkövervakning, uppnår StableRep tränad med 20 miljoner syntetiska bilder bättre noggrannhet än CLIP tränad med 50 miljoner riktiga bilder", fortsätter tidningen.

Maskininlärningsalgoritmer fångar relationerna mellan objektens egenskaper och ordens betydelser som en rad siffror. Genom att använda StableRep kan forskarna kontrollera denna process mer noggrant - träna en modell på flera bilder som genereras av Stable Diffusion på samma prompt. Det betyder att modellen kan lära sig mer olika visuella representationer och kan se vilka bilder som matchar uppmaningarna bättre än andra.

Jag tror att vi kommer att ha ett ekosystem av några modeller tränade på riktiga data, några på syntetiska

"Vi lär modellen att lära oss mer om begrepp på hög nivå genom kontext och varians, inte bara att mata den med data," Lijie Fan, huvudforskare för studien och doktorand i elektroteknik vid MIT, förklarade Denna vecka. "När du använder flera bilder, alla genererade från samma text, alla behandlade som skildringar av samma underliggande sak, dyker modellen djupare in i koncepten bakom bilderna - säg objektet - inte bara deras pixlar."

Som nämnts ovan innebär detta tillvägagångssätt också att du kan använda färre syntetiska bilder för att träna ditt neurala nätverk än riktiga, och få bättre resultat – vilket är win-win för AI-utvecklare.

Metoder som StableRep innebär att text-till-bild-modeller en dag kan tränas på syntetisk data. Det skulle göra det möjligt för utvecklare att förlita sig mindre på riktiga bilder, och kan vara nödvändigt om AI-motorer tar ut tillgängliga onlineresurser.

"Jag tror att [att träna AI-modeller på syntetiska bilder] kommer att bli allt vanligare," berättade Phillip Isola, medförfattare till tidningen och docent i datorseende vid MIT, Registret. "Jag tror att vi kommer att ha ett ekosystem av vissa modeller tränade på verklig data, några på syntetiska och kanske de flesta modellerna kommer att tränas på båda."

Det är svårt att enbart förlita sig på AI-genererade bilder eftersom deras kvalitet och upplösning ofta är sämre än riktiga fotografier. Text-till-bild-modellerna som genererar dem är också begränsade på andra sätt. Stabil diffusion producerar inte alltid bilder som är trogna textuppmaningar.

Isola varnade för att användningen av syntetiska bilder inte heller strider mot det potentiella problemet med upphovsrättsintrång, eftersom modellerna som genererade dem troligen har tränats på skyddat material.

"De syntetiska uppgifterna kan innehålla exakta kopior av upphovsrättsdata. Men syntetisk data ger också nya möjligheter att komma runt frågor om IP och integritet, eftersom vi potentiellt kan ingripa i det, genom att redigera den generativa modellen för att ta bort känsliga attribut”, förklarade han.

Teamet varnade också för att träningssystem för AI-genererade bilder potentiellt skulle kunna förvärra fördomar som lärts av deras underliggande text-till-bild-modell. ®

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://go.theregister.com/feed/www.theregister.com/2023/11/22/texttoimage_models_mit/

- :är

- :inte

- 20

- 50

- 7

- a

- förmåga

- Om Oss

- ovan

- Enligt

- noggrannhet

- exakt

- exakt

- uppnår

- lägga till

- Efter

- AI

- AI-modeller

- algoritmer

- Alla

- tillåter

- också

- alltid

- an

- och

- tillvägagångssätt

- ÄR

- runt

- array

- AS

- Associate

- At

- attribut

- tillgänglig

- BE

- därför att

- bakom

- Där vi får lov att vara utan att konstant prestera,

- tror

- Bättre

- mellan

- förspänner

- båda

- by

- KAN

- texter

- fånga

- försiktigt

- barn

- nära

- CO

- Medförfattare

- Gemensam

- jämfört

- dator

- Datorsyn

- Begreppen

- sammanhang

- fortsätter

- kontroll

- upphovsrätt

- upphovsrättsintrång

- korrekt

- Motsvarande

- kunde

- datum

- datauppsättningar

- dag

- djupare

- demonstrera

- beskrivning

- utvecklade

- utvecklare

- svårt

- Diffusion

- flera

- do

- doesn

- ekosystemet

- effektivt

- antingen

- änden

- Teknik

- Motorer

- etablerade

- förvärra

- exempel

- förklarade

- trogna

- fejka

- fläkt

- Funktioner

- matning

- färre

- För

- från

- ytterligare

- generera

- genereras

- generera

- generativ

- skaffa sig

- få

- ges

- Grupp

- Har

- he

- Hjärta

- hjälpa

- högnivå

- innehav

- Hur ser din drömresa ut

- How To

- Men

- HTTPS

- i

- if

- bild

- bilder

- in

- I andra

- innefattar

- alltmer

- överträdelse

- ingång

- ingripa

- in

- IP

- fråga

- problem

- IT

- jpg

- bara

- språk

- Large

- Efternamn

- leda

- LÄRA SIG

- lärt

- lär

- mindre

- tycka om

- sannolikt

- Begränsad

- se

- ser ut som

- göra

- Framställning

- karta

- Match

- material

- Maj..

- kanske

- betyda

- betydelser

- betyder

- kanske

- miljon

- MIT

- modell

- modeller

- Månad

- mer

- mest

- multipel

- nödvändigt för

- Behöver

- nät

- nätverk

- neurala

- neurala nätverk

- neurala nätverk

- Nya

- noterade

- nummer

- objektet

- objekt

- of

- Ofta

- on

- ONE

- ettor

- nätet

- öppet

- öppen källkod

- möjligheter

- motsatt

- beställa

- Övriga

- Övrigt

- Papper

- prestanda

- phd

- Fotografierna

- Bilder

- plato

- Platon Data Intelligence

- PlatonData

- Populära

- potentiell

- potentiellt

- privatpolicy

- process

- producera

- Professor

- prompter

- skyddad

- ger

- Puts

- kvalitet

- RE

- verklig

- Red

- Förhållanden

- frigörs

- förlita

- ta bort

- forskaren

- forskare

- Upplösning

- Resurser

- resultera

- Resultat

- avkastning

- s

- Samma

- säga

- Skala

- vetenskapsmän

- se

- känslig

- in

- skall

- eftersom

- enbart

- några

- Källa

- stabil

- student

- Läsa på

- sådana

- övervakning

- överträffa

- syntetisk

- syntetiska data

- System

- Undervisning

- grupp

- text

- än

- den där

- Smakämnen

- deras

- Dem

- de

- sak

- tror

- detta

- denna vecka

- Genom

- till

- berättade

- alltför

- Tåg

- tränad

- Utbildning

- SVÄNG

- underliggande

- användning

- Begagnade

- med hjälp av

- via

- syn

- visuell

- sätt

- we

- vecka

- były

- Vad

- när

- som

- kommer

- Win-Win

- med

- ord

- sämre

- skulle

- skriven

- Om er

- Din

- zephyrnet