Intervju Om du tror att generativ AI har en automatisk plats vid bordet i juridikvärlden, tänk om.

De stora språkmodellerna tenderar att generera felaktig juridisk information och bör inte litas på för rättstvister, har ny forskning visat.

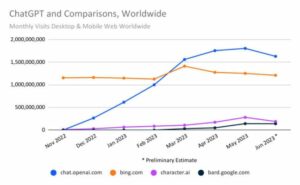

Förra året, när OpenAI visade GPT-4 var kapabel att klara advokatexamen, utropades det som ett genombrott inom AI och fick vissa människor att ifrågasätta om tekniken snart kunde ersätta advokater. Vissa hoppades att dessa typer av modeller skulle ge människor som inte har råd med dyra advokater möjlighet att utöva rättvisa, vilket gör tillgången till juridisk hjälp mer rättvis. Verkligheten är dock att LLM:er inte ens kan hjälpa professionella advokater effektivt, enligt en nyligen genomförd studie.

Det största bekymret är att AI ofta tillverkar falsk information, vilket utgör ett stort problem, särskilt i en bransch som förlitar sig på faktiska bevis. Ett team av forskare vid Yale och Stanford University som analyserade hallucinationsfrekvensen i populära stora språkmodeller fann att de ofta inte korrekt hämtar eller genererar relevant juridisk information, eller förstår och resonerar kring olika lagar.

Faktum är att OpenAI:s GPT-3.5, som för närvarande driver den fria versionen av ChatGPT, hallucinerar ungefär 69 procent av tiden när den testas över olika uppgifter. Resultaten var sämre för PaLM-2, systemet som tidigare låg bakom Googles Bard-chatbot, och Llama 2, den stora språkmodellen som släppts av Meta, som genererade falskheter med hastigheter på 72 respektive 88 procent.

Föga överraskande kämpar modellerna för att utföra mer komplexa uppgifter i motsats till än enklare. Att be AI att jämföra olika fall och se om de är överens om en fråga, till exempel, är utmanande, och det kommer mer sannolikt att generera felaktig information än när man ställs inför en enklare uppgift, som att kontrollera i vilken domstol ett ärende har lämnats in.

Även om LLM:er utmärker sig på att bearbeta stora mängder text och kan tränas på enorma mängder juridiska dokument - mer än någon mänsklig advokat kunde läsa under sin livstid - förstår de inte juridik och kan inte forma sunda argument.

"Medan vi har sett den här typen av modeller göra riktigt stora framsteg i form av deduktiva resonemang i kodnings- eller matematiska problem, är det inte den typ av färdigheter som kännetecknar förstklassig jurist," Daniel Ho, medförfattare till tidningen Yale-Stanford, berättar Registret.

"Vad advokater är riktigt bra på och var de utmärker sig beskrivs ofta som en form av analogt resonemang i ett common law-system, till resonemang baserat på prejudikat", tillade Ho, som är fakultetsbiträdande direktör för Stanford Institute for Human-Centered Artificiell intelligens.

Maskiner misslyckas ofta i enkla uppgifter också. När man blir ombedd att inspektera ett namn eller citat för att kontrollera om ett fall är verkligt, kan GPT-3.5, PaLM-2 och Llama 2 hitta på falsk information i svaren.

"Modellen behöver inte veta något om lagen ärligt för att svara på den frågan korrekt. Den behöver bara veta om ett fall existerar eller inte, och kan se det var som helst i utbildningskorpusen, säger Matthew Dahl, doktorand i juridik vid Yale University.

Det visar att AI inte ens kan hämta information korrekt och att det finns en grundläggande gräns för teknikens möjligheter. Dessa modeller är ofta förberedda för att vara behagliga och hjälpsamma. De bryr sig vanligtvis inte om att korrigera användarnas antaganden, utan kommer att ställa upp på dem istället. Om chatbotar till exempel ombeds att generera en lista över fall till stöd för något juridiskt argument, är de mer benägna att göra stämningar än att svara med ingenting. Ett par advokater lärde sig detta på den hårda vägen när de var det sanktione för att citera fall som helt uppfanns av OpenAI:s ChatGPT i deras domstolsärende.

Forskarna fann också att de tre modellerna de testade var mer benägna att vara kunniga i federala rättstvister relaterade till USA:s högsta domstol jämfört med lokala rättsliga processer som rör mindre och mindre mäktiga domstolar.

Eftersom GPT-3.5, PaLM-2 och Llama 2 tränades på text skrapad från internet, är det vettigt att de skulle vara mer bekanta med USA:s högsta domstols rättsutlåtanden, som publiceras offentligt jämfört med juridiska dokument som lämnats in i andra typer av domstolar som inte är lika lättillgängliga.

De var också mer benägna att kämpa med uppgifter som involverade att återkalla information från gamla och nya fall.

"Hallucinationer är vanligast bland Högsta domstolens äldsta och nyaste fall, och minst vanliga bland dess Warren-rättsfall efter kriget (1953-1969)," enligt tidningen. "Detta resultat tyder på en annan viktig begränsning av LLM:ers juridiska kunskap som användare bör vara medvetna om: LLM:s toppprestanda kan ligga flera år efter det nuvarande tillståndet för doktrinen, och LLM:er kan misslyckas med att internalisera rättspraxis som är mycket gammal men fortfarande tillämplig och relevant lag.”

För mycket AI kan skapa en "monokultur"

Forskarna var också oroade över att övertilltro till dessa system kunde skapa en laglig "monokultur". Eftersom AI är utbildad på en begränsad mängd data kommer det att hänvisa till mer framträdande, välkända fall som leder till att advokater ignorerar andra juridiska tolkningar eller relevanta prejudikat. De kan förbise andra fall som kan hjälpa dem att se olika perspektiv eller argument, vilket kan visa sig vara avgörande i rättstvister.

"Lagen i sig är inte monolitisk", säger Dahl. "En monokultur är särskilt farlig i en juridisk miljö. I USA har vi ett federalt common law-system där lagen utvecklas olika i olika stater i olika jurisdiktioner. Det finns olika linjer eller trender inom rättsvetenskap som utvecklas över tiden."

"Det kan leda till felaktiga resultat och omotiverad tillit på ett sätt som faktiskt kan skada rättstvister", tillägger Ho. Han förklarade att en modell kan generera felaktiga svar till advokater eller människor som vill förstå något som vräkningslagar.

"När du söker hjälp av en stor språkmodell kan du få exakt fel svar på när din ansökan ska lämnas in eller vilken typ av vräkningsregel i det här tillståndet", säger han och citerar ett exempel. "För att vad det säger dig är lagen i New York eller lagen i Kalifornien, i motsats till lagen som faktiskt har betydelse för dina speciella omständigheter i din jurisdiktion."

Forskarna drar slutsatsen att riskerna med att använda dessa typer av populära modeller för juridiska uppgifter är störst för dem som lämnar in pappersarbete i lägre domstolar i mindre delstater, särskilt om de har mindre expertis och frågar efter modellerna baserat på falska antaganden. Dessa människor är mer benägna att vara advokater, som är mindre mäktiga från mindre advokatbyråer med färre resurser, eller personer som vill representera sig själva.

"Kort sagt, vi finner att riskerna är störst för dem som skulle dra mest nytta av LLMs", skriver tidningen. ®

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://go.theregister.com/feed/www.theregister.com/2024/01/10/top_large_language_models_struggle/

- : har

- :är

- :inte

- :var

- $UPP

- 7

- 72

- a

- Om Oss

- tillgång

- tillgänglig

- Enligt

- exakt

- exakt

- tvärs

- faktiskt

- lagt till

- Lägger

- igen

- AI

- också

- bland

- mängd

- mängder

- an

- analys

- och

- Annan

- svara

- vilken som helst

- något

- var som helst

- tillämplig

- ÄR

- Argumentet

- argument

- konstgjord

- artificiell intelligens

- AS

- be

- bistå

- Associate

- antaganden

- At

- Automat

- medveten

- bar

- baserat

- BE

- därför att

- bakom

- fördel

- störst

- besvära sig

- genombrott

- men

- by

- kalifornien

- KAN

- kan inte

- kapacitet

- kapabel

- Vid

- fall

- utmanande

- karaktäriserar

- chatbot

- chatbots

- ChatGPT

- ta

- kontroll

- omständigheter

- CO

- Medförfattare

- Kodning

- Gemensam

- Vanlig lag

- jämföra

- jämfört

- fullborda

- fullständigt

- komplex

- Oro

- aktuella

- om

- avslutar

- korrekt

- kunde

- Domstol

- Domstolsanmälan

- Domstolar

- skapa

- avgörande

- Aktuella

- Nuvarande tillstånd

- För närvarande

- Dangerous

- Daniel

- datum

- beskriven

- utveckla

- utvecklar

- olika

- annorlunda

- Direktör

- do

- dokument

- doesn

- donation

- grund

- lättare

- lätt

- effektivt

- ge

- rättvis

- speciellt

- Även

- bevis

- examen

- exempel

- excel

- finns

- dyra

- expertis

- förklarade

- inför

- Faktum

- MISSLYCKAS

- fejka

- falsk

- osanningar

- bekant

- Federal

- färre

- in

- Arkivering

- hitta

- företag

- För

- formen

- former

- hittade

- Fri

- färsk

- från

- grundläggande

- generera

- genereras

- generativ

- Generativ AI

- få

- god

- stor

- Hård

- skada

- Har

- he

- hjälpa

- hjälp

- högsta

- Ärligt

- Men

- HTTPS

- stor

- humant

- if

- ignorera

- med Esport

- in

- I andra

- felaktig

- industrin

- info

- informationen

- istället

- Institute

- Intelligens

- Internet

- uppfann

- involverade

- fråga

- IT

- DESS

- sig

- jpg

- jurisdiktion

- jurisdiktioner

- bara

- Rättvisa

- Snäll

- Vet

- kunskap

- etikett

- språk

- Large

- Lag

- advokatbyrå

- Lagar

- Stämningar

- advokat

- advokater

- leda

- ledande

- lärt

- t minst

- Led

- Adress

- rättsliga förfaranden

- mindre

- livstid

- tycka om

- sannolikt

- BEGRÄNSA

- begränsning

- Begränsad

- rader

- Lista

- Rättstvister

- Lama

- du letar

- lägre

- göra

- GÖR

- Framställning

- matte

- Betyder Något

- Matthew

- Maj..

- meta

- kanske

- modell

- modeller

- Monolitisk

- mer

- mest

- mycket

- namn

- Behöver

- behov

- Nya

- New York

- Senaste

- inget

- of

- Ofta

- Gamla

- äldsta

- on

- ettor

- OpenAI

- Åsikter

- motsatt

- or

- Övriga

- utfall

- över

- par

- Papper

- pappersarbete

- särskilt

- särskilt

- Förbi

- Topp

- Personer

- procent

- prestanda

- perspektiv

- phd

- plato

- Platon Data Intelligence

- PlatonData

- Populära

- den mäktigaste

- befogenheter

- tidigare

- Problem

- problem

- förfaranden

- bearbetning

- producera

- professionell

- framträdande

- Bevisa

- publicly

- publicerade

- bedriva

- fråga

- rates

- Läsa

- verklig

- Verkligheten

- verkligen

- Anledningen

- erinrar

- senaste

- hänvisa

- relaterad

- frigörs

- relevanta

- tillit

- representerar

- forskning

- forskare

- Resurser

- respektive

- Svara

- svar

- resultera

- Resultat

- risker

- Regel

- s

- säger

- se

- Seek

- sett

- känsla

- in

- inställning

- flera

- Kort

- skall

- visade

- visas

- Visar

- sida

- Enkelt

- eftersom

- skicklighet

- mindre

- några

- något

- snart

- ljud

- stanford

- Stanford University

- Ange

- Stater

- Fortfarande

- steg

- Kamp

- student

- Läsa på

- sådana

- Föreslår

- stödja

- Överlägsen

- Högsta domstolen

- system

- System

- bord

- uppgift

- uppgifter

- grupp

- Teknologi

- teknikens

- tala

- berättar

- Tend

- testade

- text

- än

- den där

- Smakämnen

- lagen

- världen

- deras

- Dem

- sig själva

- Där.

- Dessa

- de

- tror

- detta

- de

- tre

- tid

- till

- alltför

- topp

- tränad

- Utbildning

- Trender

- typer

- förstå

- United

- USA

- universitet

- oberättigad

- på

- us

- användare

- med hjälp av

- vanligen

- olika

- Ve

- version

- mycket

- Warren

- var

- Sätt..

- we

- ALLBEKANT

- były

- Vad

- Vad är

- när

- om

- som

- medan

- VEM

- kommer

- med

- Vann

- världen

- sämre

- skulle

- Fel

- år

- år

- york

- Om er

- Din

- zephyrnet