När Stable Diffusion, AI-applikationen som återger fotorealistiska bilder som togs till framträdande plats för några veckor sedan, kom ett nytt modeord; hypernätverk.

Nu är redan stabil diffusion och hypernätverk så förenade att det är omöjligt att nämna det ena utan det andra i samma stycke.

"Jag har tränat stabila diffusionshypernätverk på små datamängder (nej, inte samtida konstnärer förutom din) för att lära dem obskyra "stilar" som de inte riktigt förstår direkt. Det fungerar precis som beskrivet, faktiskt bättre än jag själv trodde att det skulle göra”, säger en användare på twitter.

Jag har tränat stabila diffusionshypernätverk på små datamängder (nej, inte samtida konstnärer förutom yours truly) för att lära det obskyra "stilar" som det inte riktigt förstår direkt. det fungerar precis som han beskrev, faktiskt bättre än jag själv trodde att det skulle göra.

— regret maximizer (@regretmaximizer) December 20, 2022

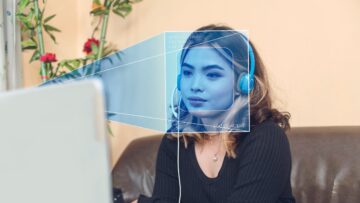

Detta symboliserar det hypernätverk som gripit nätanvändare på senare tid.

Inom datavetenskap är ett hypernätverk tekniskt sett ett nätverk som genererar vikter för ett huvudnätverk. Med andra ord, man tror att huvudnätverkets beteende är detsamma med andra neurala nätverk eftersom det lär sig att mappa några råa indata till sina önskade mål medan hypernätverket tar en uppsättning ingångar som innehåller information om vikternas struktur och genererar vikten för det lagret.

Läs också: AI-teknik som skapar livsförödande djupa falska bilder

Hur används hypernätverk?

För att förstå vad ett hypernätverk är, låt oss backa upp lite. Om du har skapat bilder på Stable Diffusion – AI-verktyget för att skapa digital konst och bilder – har du stött på det.

Träning hänvisar i allmänhet till en process där en modell lär sig (bestämmer) bra värden för alla vikter och bias från märkta exempel

Skapa bilder på Stabil diffusion är inte en automatisk process, som vi har täckt annorstädes. För att nå dit finns processer.

Först måste en AI-modell lära sig hur man renderar eller syntetiserar en bild av någon till ett foto från en 2D- eller 3D-modell via programvara. Även om modellen för stabil spridning testades noggrant, har den vissa träningsbegränsningar som kan korrigeras genom inbäddning och träningsmetoder för hypernätverk.

För att få bästa resultat kan slutanvändare välja att göra ytterligare utbildning för att finjustera genereringsutdata för att matcha mer specifika användningsfall. En utbildning för "inbäddning" involverar en samling bilder som tillhandahålls av användaren och låter modellen skapa visuellt liknande bilder närhelst namnet på inbäddningen används inom en genereringsuppmaning.

Inbäddningar är baserade på konceptet "textuell inversion" som utvecklats av forskare från Tel Aviv University där vektorrepresentationer för specifika tokens som används av modellens textkodare kopplas till nya pseudoord. Inbäddning kan minska fördomar inom originalmodellen eller efterlikna visuella stilar.

Ett "hypernätverk", å andra sidan, är ett förtränat neuralt nätverk som appliceras på olika punkter inom ett större neuralt nätverk, och hänvisar till den teknik som skapades av NovelAI-utvecklaren Kurumuz 2021, ursprungligen avsedd för textgenererande transformatormodeller .

Tränar på specifika artister

Hypernätverk är inkluderade för att styra resultat i en viss riktning, vilket gör att stabila diffusionsbaserade modeller kan replikera konststilar från specifika konstnärer. Nätverket har fördelen att kunna arbeta även när konstnären inte känns igen av originalmodellen och kommer fortfarande att bearbeta bilden genom att hitta viktiga områden som hår och ögon, och sedan lappa dessa områden i ett sekundärt latent utrymme.

"Inbäddningsskiktet i Stable Diffusion är ansvarigt för att koda indata (till exempel textprompten och klassetiketter) till lågdimensionella vektorer. Dessa vektorer hjälper diffusionsmodellen att producera bilder som matchar användarens input”, förklarar Benny Cheung i sin blogg.

"Hypernätverkslagret är ett sätt för systemet att lära sig och representera sin egen kunskap. Det gör att Stable Diffusion kan skapa bilder baserat på dess tidigare erfarenhet."

Medan dess inbäddningslager kodar indata som textprompt och klassetiketter till lågdimensionella vektorer för att hjälpa diffusionsmodellen att producera bilder som matchar användarens indata, är hypernätverkslagret något sätt för systemet att lära sig och representera sin egen. kunskap.

Med andra ord tillåter det Stable Diffusion att skapa bilder baserat på tidigare erfarenheter. I Stable Diffussion är ett hypernätverk ett extra lager som bearbetas efter att en bild har renderats genom modellen. Hypernätverket tenderar att snedställa alla resultat från modellen mot dina träningsdata på ett sätt som i huvudsak "ändrar" modellen.

Lagring av minne

Detta betyder i huvudsak att hypernätverket är ansvarigt för minneslagring av bilder som systemet tidigare har genererat. När en användare ger en ny input kan systemet använda sina tidigare befintliga kunskaper för att skapa en mer korrekt bild. Som sådana tillåter hypernätverk därför systemet att lära sig snabbare och förbättras allt eftersom.

Detta har fördelen att varje bild som innehåller något som beskriver din träningsdata kommer att se ut som din träningsdata.

"Vi fann att träning med inbäddning är lättare än att träna med ett hypernätverk för att skapa självporträtt. Vår träning gav bra resultat som vi är nöjda med”, skrev Cheung.

Vilken finjusteringsteknik använder du? Något som hypernätverk eller textinversion?

— Mathias Michel (@m91michel) December 21, 2022

Men det är en teknik som många fortfarande prutar med. Hypernätverk och AI-generatorer har precis börjat tillgodose användarnas behov och önskemål. Användargränssnitten och uppmaningsteknikerna kommer utan tvekan att utvecklas snabbt, och kommer kanske till och med att fånga Google off-guard, som MetaNews nyligen täckt.

- AI

- ai konst

- Bitcoin

- blockchain

- blockchain-efterlevnad

- coinbase

- coingenius

- Konsensus

- kryptokonferens

- crypto mining

- kryptovaluta

- decentraliserad

- djupa förfalskningar

- Defi

- Digitala tillgångar

- ethereum

- skisserat

- hypernätverk

- maskininlärning

- MetaNews

- icke fungibelt symbol

- plato

- plato ai

- Platon Data Intelligence

- PlatonData

- platogaming

- Polygon

- bevis på spel

- stabil-diffusion

- Teknologi

- W3

- zephyrnet