De säger "Handling talar högre än ord". Men i vissa fall kan ord (exakt dechiffrerade) bestämma hela handlingsförloppet som är relevant för mycket intelligenta maskiner och modeller. Detta tillvägagångssätt för att göra orden mer meningsfulla för maskinerna är NLP eller Naturlig språkbehandling.

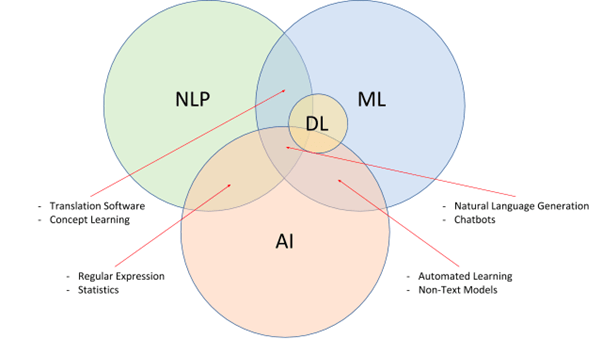

För den okunniga är NLP ett underområde av artificiell intelligens som kan bryta ner mänskligt språk och mata de intelligenta modellernas grundsatser. NLP, tillsammans med NLU (Natural Language Understanding) och NLG (Natural Language Generation), syftar till att utveckla mycket intelligenta och proaktiva sökmotorer, grammatikkontroller, översättare, röstassistenter och mer.

Enkelt uttryckt bryter NLP ner språkkomplexiteten, presenterar samma sak för maskiner som datauppsättningar att ta referens från, och extraherar även avsikten och sammanhanget för att utveckla dem ytterligare. Men att implementera dem kommer med sin del av utmaningar.

Vad är NLP: Från en startups perspektiv?

Det är svårt för människor att lära sig ett nytt språk, än mindre maskiner. Men om vi behöver maskiner för att hjälpa oss under dagen, måste de förstå och svara på den mänskliga typen av språkbruk. Natural Language Processing gör det enkelt genom att bryta ner det mänskliga språket i maskinförståeliga bitar, som används för att träna modeller till perfektion.

NLP har också stöd från NLU, som syftar till att bryta ner orden och meningarna ur en kontextuell synvinkel. Slutligen finns NLG som hjälper maskiner att svara genom att generera sin egen version av mänskligt språk för tvåvägskommunikation.

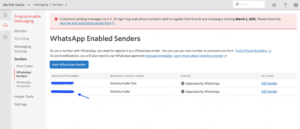

Nystartade företag som planerar att designa och utveckla chatbots, röstassistenter och andra interaktiva verktyg måste förlita sig på NLP-tjänster och -lösningar för att utveckla maskinerna med korrekt språk- och avsiktsdechiffreringsmöjligheter.

NLP-utmaningar att överväga

Ord kan ha olika betydelser. Slangar kan vara svårare att uttrycka kontextuellt. Och vissa språk är bara svåra att mata på, på grund av bristen på resurser. Trots att NLP är en av de mer eftertraktade teknikerna, kommer NLP med följande rotade och implementerande AI-utmaningar.

Brist på sammanhang för homografier, homofoner och homonymer

En "fladdermus" kan vara ett sportredskap och till och med ett trädhängande, bevingat däggdjur. Trots att stavningen är densamma skiljer de sig åt när det gäller betydelse och sammanhang. På liknande sätt låter "Där" och "Deras" samma men har olika stavningar och betydelser för dem.

Även människor har ibland svårt att förstå de subtila skillnaderna i användning. Därför, trots att NLP anses vara ett av de mer tillförlitliga alternativen för att träna maskiner i den språkspecifika domänen, kan ord med liknande stavningar, ljud och uttal avskaffa sammanhanget ganska avsevärt.

Tvetydighet

Om du tror att bara ord kan vara förvirrande, här är en tvetydig mening med oklara tolkningar.

"Jag knäppte ett barn i köpcentret med min kamera"- Om man pratar med det kan det vara så att maskinen blir förvirrad om huruvida ungen knäpptes med kameran eller när ungen knäpptes, han hade din kamera.

Denna form av förvirring eller oklarhet är ganska vanlig om man förlitar sig på icke-trovärdiga NLP-lösningar. När det gäller kategorisering kan tvetydigheter delas upp som syntaktisk (betydelsesbaserad), lexikal (ordbaserad) och semantisk (kontextbaserad).

Fel som är relevanta för hastighet och text

Maskiner som förlitar sig på semantisk feed kan inte tränas om tal- och textbitarna är felaktiga. Denna fråga är analog med inblandning av felaktigt använda eller till och med felstavade ord, vilket kan få modellen att agera över tid. Även om utvecklade verktyg för grammatikkorrigering är tillräckligt bra för att rensa bort meningsspecifika misstag, måste träningsdata vara felfria för att underlätta korrekt utveckling i första hand.

Oförmåga att passa in slangar och vardagsspråk

Även om NLP-tjänsterna försöker skala bortom oklarheter, fel och homonymer, är det inte lätt att passa in slagg eller kulturspecifikt ordagrant. Det finns ord som saknar standardordboksreferenser men som ändå kan vara relevanta för en specifik publikuppsättning. Om du planerar att designa en anpassad AI-driven röstassistent eller modell är det viktigt att passa in relevanta referenser för att göra resursen tillräckligt medveten.

Ett exempel skulle vara en "Big Bang Theory-specifik" chattbot som förstår "Buzzinga" och till och med svarar på detsamma.

Apati mot vertikal-specifik lingo

Som det kulturspecifika språkbruket använder vissa företag mycket tekniska och vertikalspecifika terminologier som kanske inte stämmer överens med en standard NLP-driven modell. Därför, om du planerar att utveckla fältspecifika lägen med taligenkänningsfunktioner, måste processen för enhetsextraktion, utbildning och dataanskaffning vara mycket kurerad och specifik.

Brist på användbara data

NLP bygger på begreppen sentimental och språklig analys av språket, följt av dataanskaffning, rensning, märkning och utbildning. Ändå har vissa språk inte mycket användbar data eller historisk kontext för NLP-lösningarna att arbeta med.

Brist på FoU

NLP-implementering är inte endimensionell. Istället kräver det hjälpmedel som neurala nätverk och djupinlärning för att utvecklas till något banbrytande. Att lägga till skräddarsydda algoritmer till specifika NLP-implementeringar är ett utmärkt sätt att designa anpassade modeller - ett hack som ofta skjuts ner på grund av bristen på adekvata forsknings- och utvecklingsverktyg.

Skala över dessa problem, idag: Hur väljer man rätt leverantör?

Från att åtgärda oklarheter till fel till problem med datainsamling, är det viktigt att ha rätt leverantör till ditt förfogande för att träna och utveckla den tänkta NLP-modellen. Och även om flera faktorer måste beaktas, är här några av de mer önskvärda funktionerna att tänka på när du ansluter:

- Ansenlig, domänspecifik databas (ljud, tal och video), oavsett språk.

- Möjlighet att implementera orddeltaggning för att eliminera oklarheter.

- Stöd för anpassade hjälpmedelstekniker som Flerspråkig meningsinbäddning för att förbättra tolkningens kvalitet.

- Sömlös datakommentar för att märka datamängder enligt kraven.

- Flerspråkig databas med färdiga val att arbeta med.

Försäljare som erbjuder de flesta eller till och med några av dessa funktioner kan övervägas för att designa dina NLP-modeller.

Wrap-Up

Naturligtvis har NLP utvecklats till en av de mer allmänt accepterade och hyllade teknikerna med artificiell intelligens. Om du är in i detaljerna, förväntas NLP-marknaden växa med nästan 1400 % till 2025, jämfört med den 2017. Enligt förväntningar och extrapolationer kommer NLP-marknaden att värderas till nästan 43 miljarder i slutet av 2025 — Statista

Trots fördelarna kommer Natural Language Processing med några begränsningar - något som du kan ta itu med när du ansluter till en pålitlig AI-leverantör.

Vatsal Ghiya, Grundare av Shaip, är en entreprenör med mer än 20 års erfarenhet av AI-programvara och tjänster inom hälsovård.

Ursprungligen publicerad på https://thinkml.ai den 1 juni 2022.

![]()

Vilka är de naturliga språkbearbetningsutmaningarna och hur åtgärdar man dem? publicerades ursprungligen i Chatbots liv på Medium, där människor fortsätter konversationen genom att lyfta fram och svara på denna berättelse.

- Myntsmart. Europas bästa bitcoin- och kryptobörs.

- Platoblockchain. Web3 Metaverse Intelligence. Kunskap förstärkt. FRI TILLGÅNG.

- CryptoHawk. Altcoin radar. Gratis provperiod.

- Source: https://chatbotslife.com/what-are-the-natural-language-processing-challenges-and-how-to-fix-6c1e185dd95?source=rss—-a49517e4c30b—4

- "

- 20 år

- 2022

- a

- exakt

- tvärs

- Agera

- Handling

- adress

- AI

- algoritmer

- Tvetydighet

- analys

- tillvägagångssätt

- runt

- konstgjord

- artificiell intelligens

- Assistent

- publik

- audio

- Där vi får lov att vara utan att konstant prestera,

- Fördelarna

- Bortom

- Miljarder

- raster

- företag

- kapacitet

- kapabel

- fall

- vissa

- utmaningar

- Välja

- samling

- Gemensam

- Kommunikation

- jämfört

- komplexiteter

- förvirring

- Anslutning

- Tänk

- Konversation

- kurerad

- beställnings

- datum

- Databas

- dag

- djup

- Designa

- design

- Trots

- Bestämma

- utveckla

- utveckla

- Utveckling

- utvecklings verktyg

- skilja sig

- olika

- domän

- ner

- enhet

- Entrepreneur

- utvecklas

- exempel

- förväntningar

- förväntat

- erfarenhet

- extrakt

- faktorer

- Funktioner

- Slutligen

- Förnamn

- passa

- Fast

- efter

- formen

- grundare

- från

- ytterligare

- generera

- generering

- god

- stor

- Väx

- hacka

- hälso-och sjukvård

- hjälpa

- här.

- höggradigt

- historisk

- Hur ser din drömresa ut

- How To

- Men

- HTTPS

- humant

- Människa

- genomföra

- genomförande

- genomföra

- med Esport

- förbättra

- Intelligens

- Intelligent

- uppsåt

- interaktiva

- tolkning

- fråga

- problem

- IT

- etikett

- märkning

- språk

- Språk

- LÄRA SIG

- inlärning

- Maskinen

- Maskiner

- göra

- GÖR

- Framställning

- marknad

- betyder

- meningsfull

- Medium

- kanske

- misstag

- modell

- modeller

- mer

- mest

- Natural

- behov

- nätverk

- erbjuda

- Tillbehör

- Övriga

- egen

- Personer

- perspektiv

- planering

- Punkt

- Synvinkel

- exakt

- problem

- process

- bearbetning

- kvalitet

- relevanta

- pålitlig

- Krav

- Kräver

- forskning

- forskning och utveckling

- resurs

- Resurser

- Samma

- Skala

- Sök

- Sökmotorer

- Tjänster

- in

- flera

- Dela

- liknande

- Liknande

- Mjukvara

- Lösningar

- några

- något

- talar

- specifik

- fart

- standard

- Fortfarande

- stödja

- Teknisk

- Tekniken

- Smakämnen

- därför

- tid

- gånger

- i dag

- verktyg

- verktyg

- mot

- Utbildning

- förstå

- förståelse

- förstår

- us

- användning

- värderas

- leverantör

- version

- Video

- utsikt

- Röst

- ogräs

- Vad

- om

- medan

- ord

- Arbete

- skulle

- år

- Din