ปัญญาประดิษฐ์กำลังฉีกขาด เครื่องจักรสามารถพูด เขียน เล่นเกม และสร้างภาพ วิดีโอ และเพลงต้นฉบับได้ แต่เมื่อความสามารถของ AI เติบโตขึ้น อัลกอริทึมก็มีเช่นกัน

ทศวรรษที่ผ่านมา อัลกอริทึมการเรียนรู้ของเครื่อง อาศัยการเชื่อมต่อภายในนับสิบล้านหรือพารามิเตอร์ อัลกอริทึมในปัจจุบันเข้าถึงผู้คนนับแสนล้านและเป็นประจำ แม้แต่พารามิเตอร์หลายล้านล้านตัว. นักวิจัยกล่าวว่าการปรับขนาดขึ้นยังคงให้ประสิทธิภาพที่เพิ่มขึ้น และโมเดลที่มีพารามิเตอร์นับสิบล้านล้านอาจมาถึงในลำดับสั้นๆ

ในการฝึกโมเดลขนาดใหญ่นั้น คุณต้องมีคอมพิวเตอร์ที่ทรงพลัง ในขณะที่ AI ในช่วงต้นปี 2010 ทำงานบนหน่วยประมวลผลกราฟิกจำนวนหนึ่ง ซึ่งเป็นชิปคอมพิวเตอร์ที่เก่งด้านการประมวลผลแบบขนานซึ่งมีความสำคัญต่อ AI ซึ่งเป็นความต้องการด้านคอมพิวเตอร์ ได้เติบโตอย่างก้าวกระโดดและรุ่นยอดนิยมตอนนี้ต้องการหลักร้อยหรือหลักพัน โอเพ่นเอไอ, ไมโครซอฟท์, Metaและอื่น ๆ กำลังสร้างซูเปอร์คอมพิวเตอร์โดยเฉพาะเพื่อจัดการงาน และพวกเขากล่าวว่าเครื่องจักร AI เหล่านี้จัดอยู่ในกลุ่มที่เร็วที่สุดในโลก

แม้ว่า GPU จะมีความสำคัญต่อการปรับขนาด AI ตัวอย่างเช่น A100 ของ Nvidia ยังคงเป็นหนึ่งในชิปที่เร็วที่สุดและใช้บ่อยที่สุดในคลัสเตอร์ AI ทางเลือกแปลกๆ ที่ออกแบบมาโดยเฉพาะสำหรับ AI ได้ปรากฏขึ้นในช่วงไม่กี่ปีที่ผ่านมา

Cerebras เสนอทางเลือกดังกล่าว

การทำอาหารของ AI

ขนาดของจานอาหารค่ำ - ด้านข้างประมาณ 8.5 นิ้ว - Wafer Scale Engine ของบริษัทคือ ชิปซิลิคอนที่ใหญ่ที่สุดในโลกซึ่งมีทรานซิสเตอร์ 2.6 ล้านล้านตัวและ 850,000 คอร์ที่ฝังอยู่บนเวเฟอร์ซิลิคอนแผ่นเดียว Wafer Scale Engine แต่ละเครื่องทำหน้าที่เป็นหัวใจของคอมพิวเตอร์ CS-2 ของบริษัท

เพียงอย่างเดียว CS-2 เป็นสัตว์ร้าย แต่เมื่อปีที่แล้ว Cerebras เปิดเผยแผน เพื่อเชื่อมโยง CS-2 เข้ากับระบบหน่วยความจำภายนอกที่เรียกว่า MemoryX และระบบเพื่อเชื่อมต่อ CS-2 ที่เรียกว่า SwarmX บริษัทกล่าวว่าเทคโนโลยีใหม่นี้สามารถเชื่อมโยงชิปได้มากถึง 192 ชิป และฝึกโมเดลที่มีขนาดใหญ่กว่า AI ที่ทันสมัยและใหญ่ที่สุดในปัจจุบันถึง XNUMX คำสั่ง

Andrew Feldman ซีอีโอและผู้ร่วมก่อตั้ง Cerebras กล่าวว่า “อุตสาหกรรมกำลังเคลื่อนผ่านโมเดลพารามิเตอร์ 1 ล้านล้านพารามิเตอร์ และเรากำลังขยายขอบเขตนั้นออกไปอีก 120 ลำดับความสำคัญ ทำให้เครือข่ายประสาทระดับสมองมีพารามิเตอร์ XNUMX ล้านล้านพารามิเตอร์”

ในเวลานั้น ทั้งหมดนี้เป็นทฤษฎี แต่เมื่อสัปดาห์ที่แล้ว บริษัท ประกาศ พวกเขาเชื่อมโยง CS-16 2 เครื่องเข้าด้วยกันเป็นซูเปอร์คอมพิวเตอร์ AI ระดับโลก

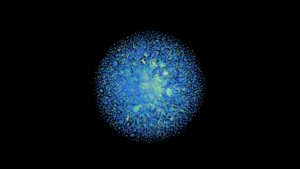

พบกับแอนโดรเมดา

เครื่องใหม่นี้มีชื่อว่า Andromeda มี 13.5 ล้านคอร์ที่สามารถทำความเร็วได้มากกว่า exaflop (การทำงานหนึ่งล้านล้านต่อวินาที) ที่ความแม่นยำครึ่งบิต 16 บิต เนื่องจากชิปที่เป็นเอกลักษณ์ที่แกนกลาง Andromeda จึงไม่สามารถเปรียบเทียบได้อย่างง่ายดายกับซูเปอร์คอมพิวเตอร์ที่ทำงานบน CPU และ GPU แบบดั้งเดิม แต่ เฟลด์แมนบอก ลวด HPC Andromeda นั้นเทียบเท่ากับซูเปอร์คอมพิวเตอร์ Polaris ของ Argonne National Laboratory ซึ่งจัดอยู่ในอันดับ เร็วเป็นอันดับ 17 ของโลกตามรายชื่อ Top500 ล่าสุด

นอกจากประสิทธิภาพแล้ว Andromeda ยังสร้างได้อย่างรวดเร็ว ต้นทุน และรอยเท้าอีกด้วย อาร์กอน เริ่มติดตั้งโพลาริส ในฤดูร้อนปี 2021 และซูเปอร์คอมพิวเตอร์ ถ่ายทอดสดในอีกหนึ่งปีต่อมา. ต้องใช้ชั้นวางมากถึง 40 ตู้ ตู้เก็บเอกสารเหมือนตู้เก็บส่วนประกอบของซุปเปอร์คอมพิวเตอร์ เมื่อเปรียบเทียบกันแล้ว Andromeda มีราคา 35 ล้านดอลลาร์ ซึ่งเป็นราคาที่พอประมาณสำหรับเครื่องจักรที่มีกำลังของมัน เพียงสามวันในการรวบรวมและใช้ชั้นวางเพียง 16 ชั้น

Cerebras ทดสอบระบบโดยฝึก GPT-3 โมเดลภาษาขนาดใหญ่ของ OpenAI ห้าเวอร์ชัน รวมถึง GPT-J และ GPT-NeoX แบบโอเพ่นซอร์สของ Eleuther AI และจากข้อมูลของ Cerebras บางทีการค้นพบที่สำคัญที่สุดก็คือ Andromeda ได้แสดงสิ่งที่พวกเขาเรียกว่า "มาตราส่วนเชิงเส้นที่เกือบจะสมบูรณ์แบบ" ของปริมาณงาน AI สำหรับโมเดลภาษาขนาดใหญ่ กล่าวโดยสรุปคือ เมื่อมีการเพิ่ม CS-2 เพิ่มเติม เวลาการฝึกจะลดลงตามสัดส่วน

โดยทั่วไป บริษัทกล่าวว่า เมื่อคุณเพิ่มชิปมากขึ้น ประสิทธิภาพที่เพิ่มขึ้นจะลดลง ในทางกลับกัน ชิป WSE ของ Cerebras อาจได้รับการพิสูจน์ว่าปรับขนาดได้อย่างมีประสิทธิภาพมากขึ้น เนื่องจากคอร์ 850,000 คอร์เชื่อมต่อกันบนซิลิคอนชิ้นเดียวกัน ยิ่งไปกว่านั้น แต่ละคอร์ยังมีโมดูลหน่วยความจำอยู่ข้างๆ เมื่อนำมารวมกัน ชิปจะลดระยะเวลาที่ใช้ในการเปลี่ยนข้อมูลระหว่างคอร์และหน่วยความจำ

“การปรับสเกลเชิงเส้นหมายความว่าเมื่อคุณเปลี่ยนจากระบบหนึ่งเป็นสอง ระบบจะใช้เวลาเพียงครึ่งเดียวในการทำงานของคุณให้เสร็จ นั่นเป็นคุณสมบัติที่ผิดปกติอย่างมากในการคำนวณ” เฟลด์แมนกล่าว ลวด HPC. และเขากล่าวว่ามันสามารถปรับขนาดได้มากกว่า 16 ระบบที่เชื่อมต่อกัน

นอกเหนือจากการทดสอบของ Cerebras แล้ว ผลการปรับขนาดเชิงเส้นยังแสดงให้เห็นระหว่างการทำงานที่ Argonne National Laboratory ซึ่งนักวิจัยใช้ Andromeda เพื่อฝึกอัลกอริทึมภาษาขนาดใหญ่ GPT-3-XL ในลำดับที่ยาวของจีโนม Covid-19

แน่นอน แม้ว่าระบบอาจปรับขนาดได้เกินกว่า 16 CS-2s แต่ยังคงมีการปรับขนาดเชิงเส้นในระดับใด นอกจากนี้ เรายังไม่ทราบว่า Cerebras ดำเนินการแบบตัวต่อตัวกับชิป AI อื่น ๆ ได้อย่างไร ผู้ผลิตชิป AI เช่น Nvidia และ Intel ได้เริ่มต้นขึ้นแล้ว เข้าร่วมในการเปรียบเทียบมาตรฐานของบุคคลที่สามเป็นประจำ โดยชอบของ MLperf Cerebras ยังไม่ได้มีส่วนร่วม

พื้นที่ว่าง

ถึงกระนั้น แนวทางดังกล่าวดูเหมือนจะเป็นการเจาะช่องเฉพาะของตัวเองในโลกของซูเปอร์คอมพิวเตอร์ และการปรับขนาดอย่างต่อเนื่องในภาษาขนาดใหญ่ AI เป็นกรณีการใช้งานหลัก แน่นอนเฟลด์แมน บอก มีสาย ปีก่อน ว่าบริษัทกำลังพูดคุยกับวิศวกรที่ OpenAI ซึ่งเป็นผู้นำด้านโมเดลภาษาขนาดใหญ่ (ผู้ก่อตั้ง OpenAI, Sam Altman เป็นผู้ลงทุนใน Cerebras ด้วย)

ในการเปิดตัวในปี 2020 GPT-3 รุ่นภาษาขนาดใหญ่ของ OpenAI ได้เปลี่ยนเกมทั้งในแง่ของประสิทธิภาพและขนาด ด้วยค่าพารามิเตอร์ 175 พันล้านพารามิเตอร์ จึงเป็นโมเดล AI ที่ใหญ่ที่สุดในขณะนั้น และทำให้นักวิจัยประหลาดใจด้วยความสามารถของมัน ตั้งแต่นั้นเป็นต้นมา โมเดลภาษาได้เข้าถึงพารามิเตอร์หลายล้านล้านพารามิเตอร์ และโมเดลที่ใหญ่กว่าอาจกำลังตามมา มีข่าวลือ—แค่นั้น—จนถึงตอนนี้ OpenAI จะปล่อย GPT-4 ในอนาคตอันใกล้นี้ และมันจะเป็นอีกก้าวกระโดดจาก GPT-3 (เราจะต้องรอดูจำนวนนั้น)

ที่กล่าวว่า แม้จะมีความสามารถ แต่โมเดลภาษาขนาดใหญ่ก็ไม่ได้สมบูรณ์แบบหรือเป็นที่ชื่นชอบในระดับสากล ข้อบกพร่องของพวกเขารวมถึงผลลัพธ์ที่อาจเป็นเท็จ ลำเอียง และน่ารังเกียจ Galactica ของ Meta ซึ่งได้รับการฝึกฝนเกี่ยวกับตำราทางวิทยาศาสตร์คือ ตัวอย่างล่าสุด. แม้จะมีชุดข้อมูลที่ใคร ๆ สันนิษฐานว่ามีแนวโน้มที่จะเป็นพิษน้อยกว่าการฝึกอบรมบนอินเทอร์เน็ตแบบเปิด แต่แบบจำลองนั้นถูกกระตุ้นให้สร้างข้อความที่เป็นอันตรายและไม่ถูกต้องได้อย่างง่ายดายและถูกดึงลงมาในเวลาเพียงสามวัน นักวิจัยสามารถแก้ไขข้อบกพร่องด้านภาษาของ AI ได้หรือไม่นั้นยังคงไม่แน่นอน

แต่ดูเหมือนว่าการขยายขนาดจะดำเนินต่อไปจนกว่าผลตอบแทนจะลดลง การก้าวกระโดดครั้งต่อไปอาจอยู่ใกล้แค่เอื้อม—และเราอาจมีฮาร์ดแวร์ที่จะทำให้มันเกิดขึ้นแล้ว

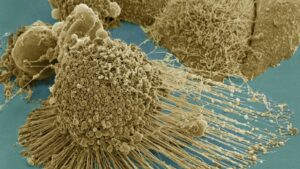

เครดิตภาพ: สมอง