วันนี้เรารู้สึกตื่นเต้นที่ได้ประกาศความสามารถในการปรับแต่งรุ่น Mistral 7B โดยใช้ Amazon SageMaker JumpStart. ตอนนี้คุณสามารถปรับแต่งและปรับใช้โมเดลการสร้างข้อความ Mistral บน SageMaker JumpStart โดยใช้ สตูดิโอ Amazon SageMaker UI เพียงไม่กี่คลิกหรือใช้ SageMaker Python SDK

โมเดลพื้นฐานทำงานได้ดีมากกับงานสร้างสรรค์ ตั้งแต่การประดิษฐ์ข้อความและการสรุป การตอบคำถาม ไปจนถึงการสร้างรูปภาพและวิดีโอ แม้ว่าโมเดลเหล่านี้จะมีความสามารถในการสรุปข้อมูลทั่วไปที่ยอดเยี่ยม แต่มักจะมีกรณีการใช้งานที่มีข้อมูลโดเมนที่เฉพาะเจาะจงมาก (เช่น การดูแลสุขภาพหรือบริการทางการเงิน) และโมเดลเหล่านี้อาจไม่สามารถให้ผลลัพธ์ที่ดีสำหรับกรณีการใช้งานเหล่านี้ได้ ส่งผลให้เกิดความจำเป็นในการปรับแต่งโมเดล AI เชิงสร้างสรรค์เพิ่มเติมเพิ่มเติมเกี่ยวกับข้อมูลเฉพาะกรณีการใช้งานและข้อมูลเฉพาะโดเมน

ในโพสต์นี้ เราจะสาธิตวิธีปรับแต่งโมเดล Mistral 7B โดยใช้ SageMaker JumpStart

มิสทรัล 7B คืออะไร

Mistral 7B เป็นโมเดลพื้นฐานที่พัฒนาโดย Mistral AI ซึ่งรองรับความสามารถในการสร้างข้อความและโค้ดภาษาอังกฤษ รองรับกรณีการใช้งานที่หลากหลาย เช่น การสรุปข้อความ การจัดหมวดหมู่ การเติมข้อความให้สมบูรณ์ และการเติมโค้ดให้สมบูรณ์ เพื่อแสดงให้เห็นถึงความสามารถในการปรับแต่งของโมเดลนี้ Mistral AI ยังได้เปิดตัวโมเดล Mistral 7B-Instruct สำหรับกรณีการใช้งานแชท โดยได้รับการปรับแต่งอย่างละเอียดโดยใช้ชุดข้อมูลการสนทนาที่หลากหลายที่เปิดเผยต่อสาธารณะ

Mistral 7B เป็นรุ่นหม้อแปลงไฟฟ้าและใช้ความสนใจในการสืบค้นแบบกลุ่มและความสนใจของหน้าต่างแบบเลื่อนเพื่อให้อนุมานได้เร็วขึ้น (เวลาแฝงต่ำ) และจัดการลำดับที่ยาวขึ้น ความสนใจคิวรีแบบกลุ่มคือสถาปัตยกรรมที่รวมความสนใจแบบหลายแบบสอบถามและหลายหัวเข้าด้วยกัน เพื่อให้ได้คุณภาพเอาต์พุตที่ใกล้เคียงกับความสนใจแบบหลายหัวและมีความเร็วที่เทียบเคียงได้กับความสนใจแบบหลายหัวข้อมูล วิธีการสนใจหน้าต่างบานเลื่อนใช้โมเดล Transformer หลายระดับเพื่อเน้นไปที่ข้อมูลที่มาก่อนหน้านี้ ซึ่งช่วยให้โมเดลเข้าใจบริบทที่ขยายออกไปได้ยาวนานขึ้น . Mistral 7B มีความยาวบริบท 8,000 โทเค็น แสดงให้เห็นถึงความหน่วงต่ำและทรูพุตสูง และมีประสิทธิภาพสูงเมื่อเปรียบเทียบกับรุ่นอื่นที่ใหญ่กว่า โดยให้ความต้องการหน่วยความจำต่ำในขนาดรุ่น 7B โมเดลนี้จัดทำขึ้นภายใต้ลิขสิทธิ์ Apache 2.0 ที่ได้รับอนุญาต สำหรับการใช้งานโดยไม่มีข้อจำกัด

คุณสามารถปรับแต่งโมเดลได้โดยใช้ SageMaker Studio UI หรือ SageMaker Python SDK เราพูดถึงทั้งสองวิธีในโพสต์นี้

ปรับแต่งอย่างละเอียดผ่าน SageMaker Studio UI

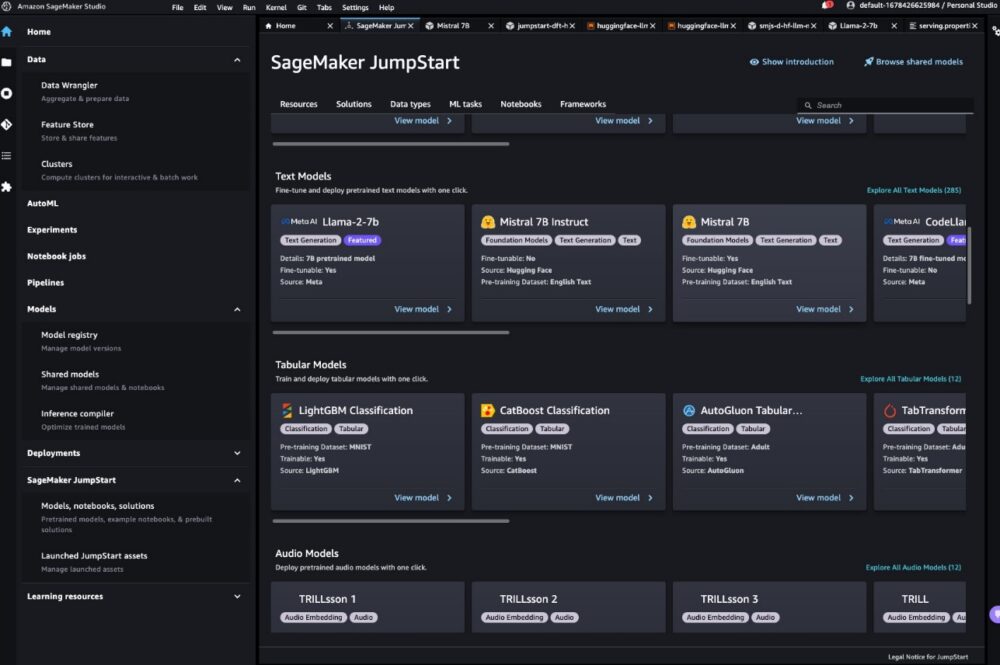

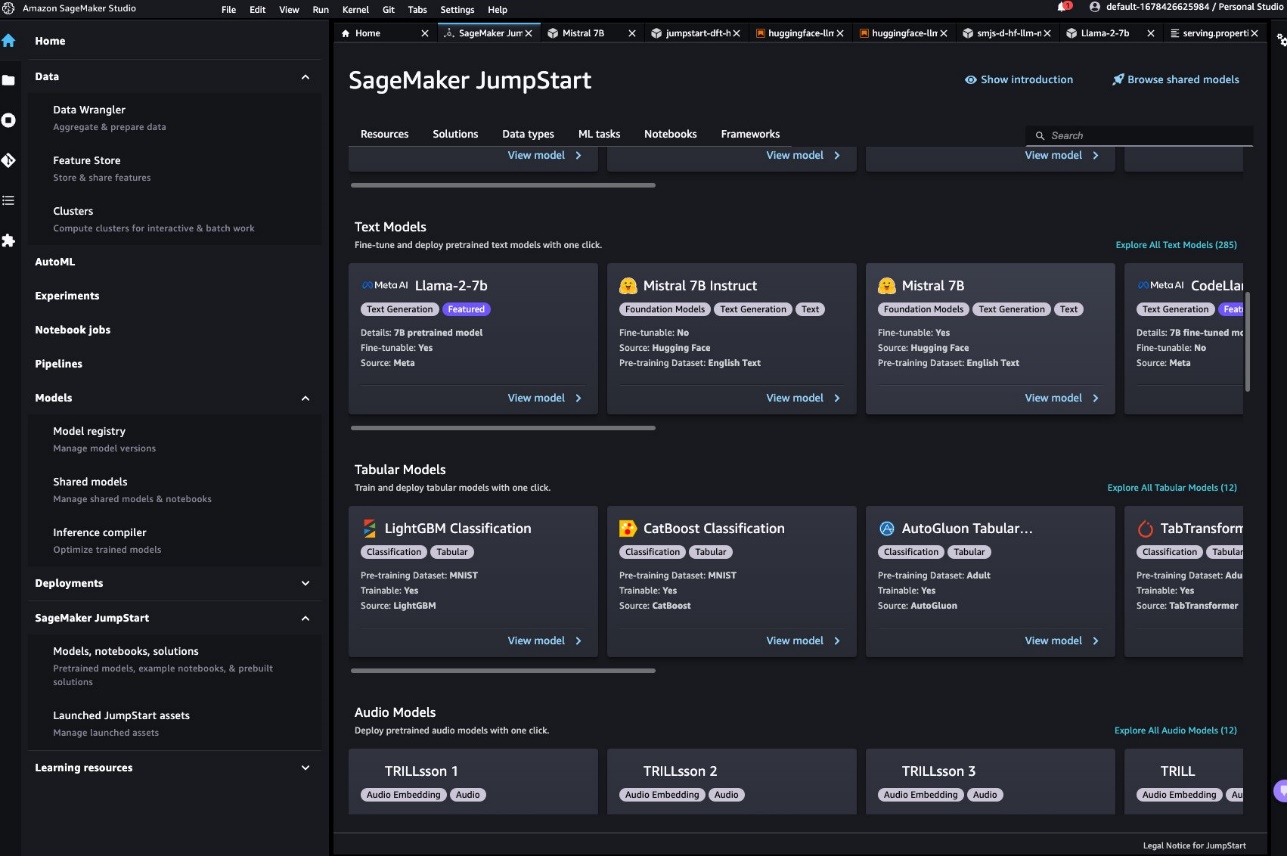

ใน SageMaker Studio คุณสามารถเข้าถึงโมเดล Mistral ผ่าน SageMaker JumpStart ด้านล่าง รุ่น โน้ตบุ๊ก และโซลูชันดังแสดงในภาพหน้าจอต่อไปนี้

หากคุณไม่เห็นโมเดล Mistral ให้อัปเดตเวอร์ชัน SageMaker Studio ของคุณโดยการปิดและรีสตาร์ท สำหรับข้อมูลเพิ่มเติมเกี่ยวกับการอัพเดตเวอร์ชัน โปรดดูที่ ปิดและอัปเดตแอป Studio.

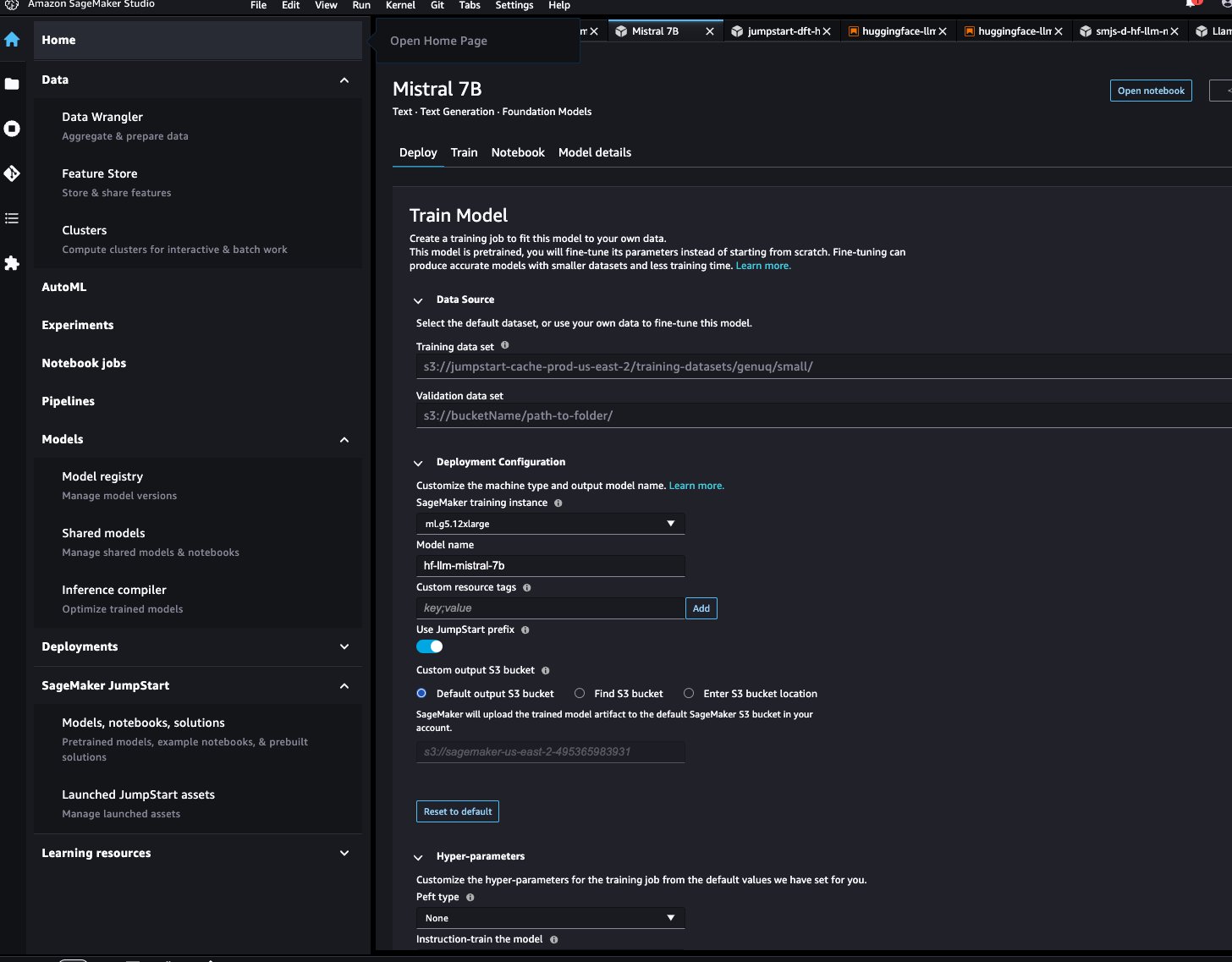

ในหน้าโมเดล คุณสามารถชี้ไปที่ บริการจัดเก็บข้อมูลอย่างง่ายของ Amazon บัคเก็ต (Amazon S3) ที่ประกอบด้วยชุดข้อมูลการฝึกอบรมและการตรวจสอบเพื่อการปรับแต่งอย่างละเอียด นอกจากนี้ คุณยังสามารถกำหนดค่าการกำหนดค่าการปรับใช้ ไฮเปอร์พารามิเตอร์ และการตั้งค่าความปลอดภัยสำหรับการปรับแต่งอย่างละเอียดได้ จากนั้นคุณสามารถเลือกได้ รถไฟ เพื่อเริ่มงานฝึกอบรมบนอินสแตนซ์ SageMaker ML

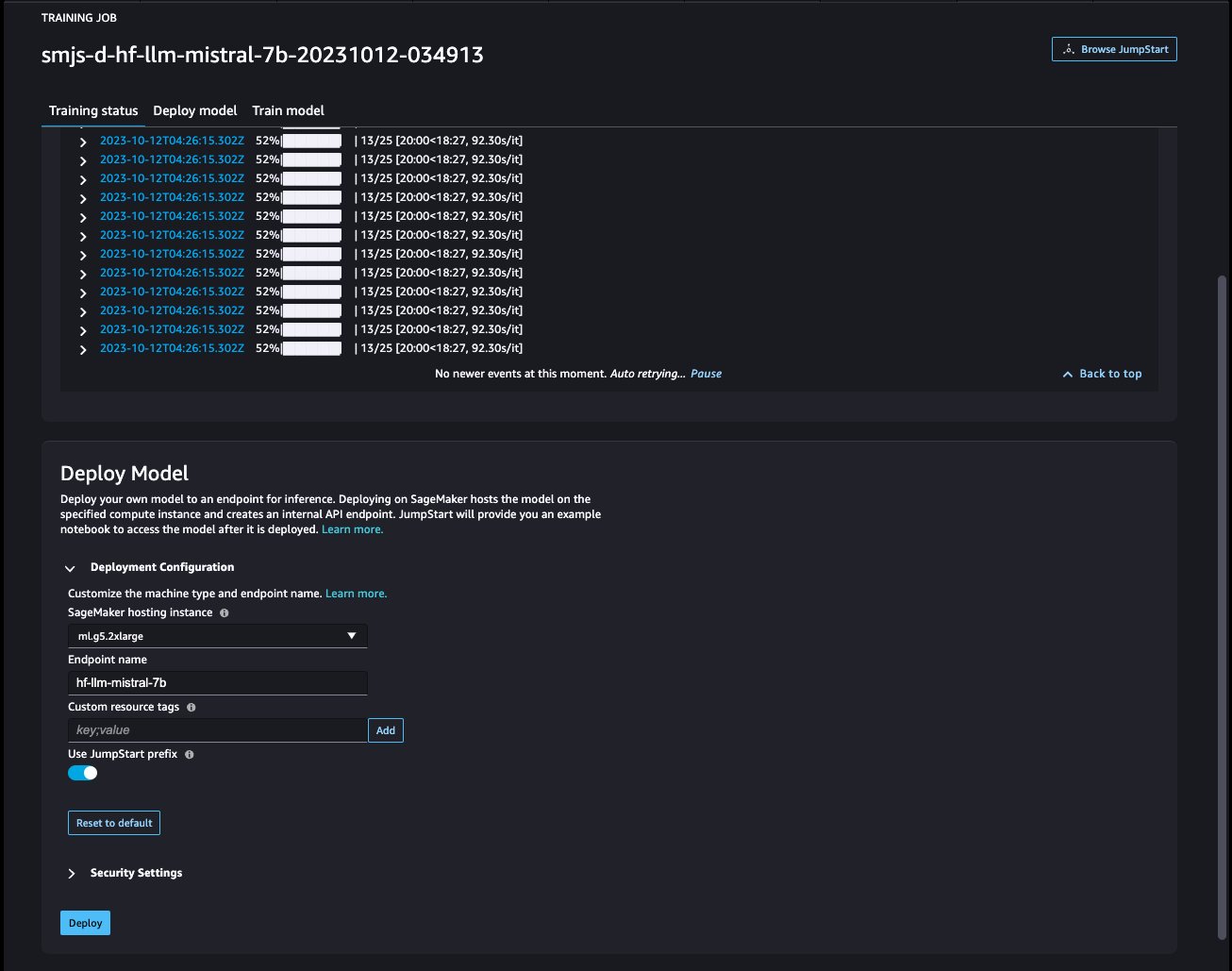

ปรับใช้โมเดล

หลังจากปรับแต่งโมเดลอย่างละเอียดแล้ว คุณสามารถปรับใช้ได้โดยใช้หน้าโมเดลบน SageMaker JumpStart ตัวเลือกในการปรับใช้โมเดลที่ปรับแต่งอย่างละเอียดจะปรากฏขึ้นเมื่อการปรับแต่งแบบละเอียดเสร็จสมบูรณ์ ดังที่แสดงในภาพหน้าจอต่อไปนี้

ปรับแต่งอย่างละเอียดผ่าน SageMaker Python SDK

คุณยังสามารถปรับแต่งโมเดล Mistral ได้โดยใช้ SageMaker Python SDK โน้ตบุ๊คฉบับสมบูรณ์มีจำหน่ายที่ GitHub. ในส่วนนี้ เราจะให้ตัวอย่างของการปรับแต่งแบบละเอียดสองประเภท

คำแนะนำการปรับจูน

การปรับแต่งคำสั่งเป็นเทคนิคที่เกี่ยวข้องกับการปรับแต่งโมเดลภาษาอย่างละเอียดในชุดงานการประมวลผลภาษาธรรมชาติ (NLP) โดยใช้คำสั่ง ในเทคนิคนี้ โมเดลจะได้รับการฝึกให้ทำงานโดยทำตามคำแนะนำที่เป็นข้อความแทนชุดข้อมูลเฉพาะสำหรับแต่ละงาน โมเดลได้รับการปรับแต่งอย่างละเอียดด้วยชุดตัวอย่างอินพุตและเอาท์พุตสำหรับแต่ละงาน ช่วยให้โมเดลสามารถสรุปงานใหม่ๆ ที่ไม่ได้รับการฝึกอย่างชัดเจนตราบใดที่มีการแจ้งพร้อมท์สำหรับงานนั้น การปรับแต่งคำสั่งช่วยปรับปรุงความแม่นยำและประสิทธิผลของแบบจำลอง และมีประโยชน์ในสถานการณ์ที่ไม่มีชุดข้อมูลขนาดใหญ่สำหรับงานเฉพาะ

มาดูโค้ดการปรับแต่งที่ให้ไว้ในตัวอย่างกัน สมุดบันทึก ด้วย SageMaker Python SDK

เราใช้สับเซตของ ชุดข้อมูลดอลลี่ ในรูปแบบการปรับแต่งคำสั่งและระบุ template.json ไฟล์อธิบายรูปแบบอินพุตและเอาต์พุต ข้อมูลการฝึกจะต้องอยู่ในรูปแบบบรรทัด JSON (.jsonl) โดยแต่ละบรรทัดจะเป็นพจนานุกรมที่แสดงถึงตัวอย่างข้อมูลเดียว ในกรณีนี้เราตั้งชื่อมันว่า train.jsonl.

ตัวอย่างต่อไปนี้เป็นตัวอย่างของ train.jsonl. กุญแจ instruction, contextและ response ในแต่ละตัวอย่างควรมีรายการที่สอดคล้องกัน {instruction}, {context}, {response} ใน template.json.

ต่อไปนี้เป็นตัวอย่างของ template.json:

หลังจากที่คุณอัปโหลดเทมเพลตพร้อมท์และข้อมูลการฝึกไปยังบัคเก็ต S3 แล้ว คุณสามารถตั้งค่าไฮเปอร์พารามิเตอร์ได้

จากนั้นคุณสามารถเริ่มกระบวนการปรับแต่งอย่างละเอียดและปรับใช้โมเดลกับจุดสิ้นสุดการอนุมานได้ ในโค้ดต่อไปนี้ เราใช้อินสแตนซ์ ml.g5.12xlarge:

การปรับแต่งโดเมนแบบละเอียด

การปรับแต่งการปรับโดเมนอย่างละเอียดเป็นกระบวนการที่ปรับแต่ง LLM ที่ได้รับการฝึกอบรมล่วงหน้าเพื่อให้เหมาะสมกับโดเมนหรืองานเฉพาะเจาะจงมากขึ้น ด้วยการใช้ชุดข้อมูลเฉพาะโดเมนที่มีขนาดเล็กลง LLM สามารถปรับแต่งอย่างละเอียดเพื่อทำความเข้าใจและสร้างเนื้อหาที่แม่นยำ เกี่ยวข้อง และลึกซึ้งยิ่งขึ้นสำหรับโดเมนเฉพาะนั้น ในขณะที่ยังคงรักษาความรู้มากมายที่ได้รับระหว่างการฝึกอบรมดั้งเดิม

โมเดล Mistral สามารถปรับแต่งได้อย่างละเอียดบนชุดข้อมูลเฉพาะโดเมนใดๆ หลังจากปรับแต่งอย่างละเอียดแล้ว คาดว่าจะสร้างข้อความเฉพาะโดเมนและแก้ไขงาน NLP ต่างๆ ในโดเมนเฉพาะนั้น สำหรับชุดข้อมูลการฝึก ให้ระบุไดเร็กทอรีการฝึกและไดเร็กทอรีการตรวจสอบเพิ่มเติม โดยแต่ละไดเร็กทอรีจะมีไฟล์ CSV, JSON หรือ TXT ไฟล์เดียว สำหรับรูปแบบ CSV และ JSON ให้ใช้ข้อมูลจากไฟล์ text คอลัมน์หรือคอลัมน์แรกถ้า text ไม่อยู่ ตรวจสอบให้แน่ใจว่ามีเพียงไฟล์เดียวที่มีอยู่ในแต่ละไดเร็กทอรี ตัวอย่างเช่น ข้อมูลอินพุตอาจเป็นเอกสารที่ยื่นต่อ SEC ของ Amazon ในรูปแบบไฟล์ข้อความ:

คุณสามารถเริ่มการปรับแต่งโดเมนแบบละเอียดได้โดยการระบุไฮเปอร์พารามิเตอร์ “instruction_tuned" เช่น "False“. ขั้นตอนที่เหลือจะคล้ายกับขั้นตอนการปรับแต่งคำแนะนำโดยละเอียด

เราตั้ง max_input_length เป็น 2048 บน g5.12xlarge คุณสามารถใช้ความยาวอินพุตที่สูงกว่ากับประเภทอินสแตนซ์ที่ใหญ่กว่าได้ สำหรับรายละเอียด โปรดดูที่ ตัวอย่างโน๊ตบุ๊ค.

ตัวอย่างการอนุมานที่มีและไม่มีการปรับแต่งอย่างละเอียด

ตารางต่อไปนี้ประกอบด้วยผลลัพธ์ของโมเดล Mistral 7B ที่ได้รับการปรับแต่งอย่างละเอียดด้วยการยื่นเอกสาร SEC ของ Amazon ตั้งแต่ปี 2021–2022 เราเปรียบเทียบผลลัพธ์ก่อนและหลังการปรับแต่งแบบละเอียด

| อินพุตพร้อมท์ | เอาท์พุตก่อนการปรับแบบละเอียด | เอาท์พุตหลังจากการปรับแบบละเอียด | พารามิเตอร์ |

| รายงาน Form 10-K นี้แสดงให้เห็นว่า |

บริษัทเปิดกิจการมาเป็นเวลา 10 ปี และมีพนักงานทั้งหมด 10 คน บริษัทมีพนักงานทั้งหมด 10 คน และดำเนินธุรกิจการให้บริการแก่ประชาชน บริษัทมีพนักงานทั้งหมด 10 คน และดำเนินธุรกิจการให้บริการแก่ประชาชน บริษัทมีพนักงานทั้งหมด 10 คน และดำเนินธุรกิจการให้บริการแก่ประชาชน บริษัทมีพนักงานทั้งหมด 10 คน และดำเนินธุรกิจการให้บริการแก่ประชาชน บริษัทมีพนักงานทั้งหมด 10 คน และดำเนินธุรกิจการให้บริการแก่ประชาชน บริษัทมีพนักงานทั้งหมด 10 คน และอยู่ในธุรกิจการจัดหา |

เรามียอดขายสุทธิ 1.2 พันล้านดอลลาร์ 1.5 พันล้านดอลลาร์ และ 1.8 พันล้านดอลลาร์ในปี 2004, 2003 และ 2002 จำนวนเงินเหล่านี้รวมยอดขายจากเว็บไซต์ต่างประเทศของเราด้วย ยอดขายสุทธิจากเว็บไซต์ต่างประเทศของเราอยู่ที่ 323 ล้านดอลลาร์ 242 ล้านดอลลาร์ และ 150 ล้านดอลลาร์ในปี 2004, 2003 และ 2002 ยอดขายสุทธิจากเว็บไซต์ต่างประเทศของเราคิดเป็น 27%, 16% และ 8% ของยอดขายสุทธิในปี 2004, 2003 และ 2002 . | “อุณหภูมิ”: 0.2, “max_new_tokens”: 150, |

| เราให้บริการผู้บริโภคผ่าน |

เครือข่ายร้านค้าปลีกของเราจำนวน 1,700 แห่ง ซึ่งรวมถึงร้านค้า 1,200 แห่งในสหรัฐอเมริกา ร้านค้า 400 แห่งในแคนาดา และร้านค้า 100 แห่งในเม็กซิโก เรายังให้บริการผู้บริโภคผ่านเว็บไซต์อีคอมเมิร์ซของเราด้วย ## ร้านปรับปรุงบ้านที่ใหญ่ที่สุดคืออะไร? Home Depot เป็นผู้ค้าปลีกอุปกรณ์ปรับปรุงบ้านที่ใหญ่ที่สุดในสหรัฐอเมริกา ## ร้านปรับปรุงบ้านที่ใหญ่ที่สุดในโลกคืออะไร? ร้านปรับปรุงบ้านที่ใหญ่ที่สุดในโลกคือ Home Depot ## ร้านปรับปรุงบ้านที่ใหญ่ที่สุดในคือร้านใด |

ร้านค้าออนไลน์และหน้าร้านของเราและมุ่งเน้นไปที่การเลือก ราคา และความสะดวกสบาย เราออกแบบร้านค้าของเราเพื่อให้ผลิตภัณฑ์ที่ไม่ซ้ำกันหลายร้อยล้านรายการสามารถขายโดยเราและบุคคลที่สามในหมวดหมู่ผลิตภัณฑ์ต่างๆ มากมาย ลูกค้าเข้าถึงข้อเสนอของเราผ่านทางเว็บไซต์ แอพมือถือ Alexa อุปกรณ์ สตรีมมิ่ง และเยี่ยมชมร้านค้าของเรา นอกจากนี้เรายังผลิตและจำหน่ายอุปกรณ์อิเล็กทรอนิกส์ รวมถึง Kindle, Fire tablet, Fire TV, Echo และ Ring และเราพัฒนาและผลิตเนื้อหาสื่อ เราพยายามเสนอราคาที่ต่ำให้กับลูกค้า การจัดส่งฟรีที่รวดเร็วและฟรี ฟังก์ชั่นที่ใช้งานง่าย และการบริการลูกค้าที่ตรงเวลา นอกจากนี้เรายังเสนอบริการสมัครสมาชิกเช่น Amazon Prime, a | |

| วิสัยทัศน์ของเราคือ |

เพื่อเป็นผู้ให้บริการชั้นนำด้านบริการดูแลสุขภาพที่มีคุณภาพ ราคาไม่แพง และเข้าถึงได้ภายในชุมชนที่เราให้บริการ ภารกิจของเราคือการให้บริการด้านสุขภาพที่มีคุณภาพ ราคาไม่แพง และเข้าถึงได้แก่ชุมชนที่เราให้บริการ ค่านิยมของเราคือ: – ความซื่อสัตย์: เราปฏิบัติงานด้วยความซื่อสัตย์และซื่อสัตย์ในทุกการติดต่อธุรกิจของเรา ความมุ่งมั่นของเราที่มีต่อผู้ป่วยของเราคือการให้บริการด้านสุขภาพที่มีคุณภาพ ราคาไม่แพง และเข้าถึงได้ |

เป็นบริษัทที่ยึดลูกค้าเป็นศูนย์กลางมากที่สุดในโลก เราได้รับคำแนะนำจากหลักการสี่ประการ: ความหลงใหลในลูกค้ามากกว่าการมุ่งเน้นไปที่คู่แข่ง ความหลงใหลในการประดิษฐ์ ความมุ่งมั่นสู่ความเป็นเลิศในการปฏิบัติงาน และการคิดระยะยาว ในแต่ละกลุ่มของเรา เราให้บริการกลุ่มลูกค้าหลักของเรา ซึ่งประกอบด้วยผู้บริโภค ผู้ขาย นักพัฒนา องค์กร และผู้สร้างเนื้อหา นอกจากนี้เรายังให้บริการต่างๆ เช่น การโฆษณา เราได้จัดการดำเนินงานของเราออกเป็นสามส่วน: อเมริกาเหนือ ระหว่างประเทศ และ AWS ส่วนงานเหล่านี้สะท้อนถึงวิธีที่บริษัทประเมินผลการดำเนินธุรกิจและจัดการการดำเนินงาน ข้อมูลเกี่ยวกับยอดขายสุทธิของเรามีอยู่ในรายการที่ 8 ของส่วนที่ II “งบการเงิน” |

อย่างที่คุณเห็น โมเดลที่ได้รับการปรับแต่งอย่างละเอียดจะให้ข้อมูลเฉพาะเจาะจงมากขึ้นเกี่ยวกับ Amazon เมื่อเปรียบเทียบกับโมเดลที่ได้รับการฝึกอบรมล่วงหน้าทั่วไป เนื่องจากการปรับแต่งอย่างละเอียดจะปรับโมเดลเพื่อทำความเข้าใจความแตกต่าง รูปแบบ และข้อมูลเฉพาะของชุดข้อมูลที่ให้มา ด้วยการใช้แบบจำลองที่ได้รับการฝึกอบรมล่วงหน้าและปรับแต่งด้วยการปรับแต่งอย่างละเอียด เรารับรองว่าคุณจะได้รับสิ่งที่ดีที่สุดจากทั้งสองโลก: ความรู้ในวงกว้างเกี่ยวกับแบบจำลองที่ได้รับการฝึกอบรมล่วงหน้า และความแม่นยำเฉพาะทางสำหรับชุดข้อมูลเฉพาะของคุณ ขนาดเดียวอาจไม่เหมาะกับโลกของการเรียนรู้ของเครื่อง และการปรับแต่งอย่างละเอียดเป็นโซลูชันที่ออกแบบตามความต้องการของคุณ!

สรุป

ในโพสต์นี้ เราได้พูดคุยถึงการปรับแต่งโมเดล Mistral 7B โดยใช้ SageMaker JumpStart เราได้แสดงวิธีที่คุณสามารถใช้คอนโซล SageMaker JumpStart ใน SageMaker Studio หรือ SageMaker Python SDK เพื่อปรับแต่งและปรับใช้โมเดลเหล่านี้ ในขั้นตอนถัดไป คุณสามารถลองปรับแต่งโมเดลเหล่านี้บนชุดข้อมูลของคุณเองได้โดยใช้โค้ดที่ให้ไว้ในที่เก็บ GitHub เพื่อทดสอบและเปรียบเทียบผลลัพธ์สำหรับกรณีการใช้งานของคุณ

เกี่ยวกับผู้เขียน

ซินหวาง เป็นนักวิทยาศาสตร์ประยุกต์อาวุโสสำหรับอัลกอริทึมในตัวของ Amazon SageMaker JumpStart และ Amazon SageMaker เขามุ่งเน้นไปที่การพัฒนาอัลกอริธึมการเรียนรู้ของเครื่องที่ปรับขนาดได้ ความสนใจในงานวิจัยของเขาอยู่ในขอบเขตของการประมวลผลภาษาธรรมชาติ การเรียนรู้เชิงลึกที่อธิบายได้เกี่ยวกับข้อมูลแบบตาราง และการวิเคราะห์ที่มีประสิทธิภาพของการจัดกลุ่มพื้นที่เวลา-อวกาศแบบไม่มีพารามิเตอร์ เขาได้เผยแพร่เอกสารมากมายในการประชุม ACL, ICDM, KDD และ Royal Statistical Society: Series A

ซินหวาง เป็นนักวิทยาศาสตร์ประยุกต์อาวุโสสำหรับอัลกอริทึมในตัวของ Amazon SageMaker JumpStart และ Amazon SageMaker เขามุ่งเน้นไปที่การพัฒนาอัลกอริธึมการเรียนรู้ของเครื่องที่ปรับขนาดได้ ความสนใจในงานวิจัยของเขาอยู่ในขอบเขตของการประมวลผลภาษาธรรมชาติ การเรียนรู้เชิงลึกที่อธิบายได้เกี่ยวกับข้อมูลแบบตาราง และการวิเคราะห์ที่มีประสิทธิภาพของการจัดกลุ่มพื้นที่เวลา-อวกาศแบบไม่มีพารามิเตอร์ เขาได้เผยแพร่เอกสารมากมายในการประชุม ACL, ICDM, KDD และ Royal Statistical Society: Series A

วิเวกกังสนิ เป็นสถาปนิกโซลูชันสตาร์ทอัพ AI/ML สำหรับสตาร์ทอัพ Generative AI ที่ AWS เขาช่วยสตาร์ทอัพ GenAI เกิดใหม่สร้างโซลูชันที่เป็นนวัตกรรมโดยใช้บริการของ AWS และการประมวลผลแบบเร่งความเร็ว ปัจจุบันเขามุ่งเน้นไปที่การพัฒนากลยุทธ์สำหรับการปรับแต่งอย่างละเอียดและเพิ่มประสิทธิภาพการอนุมานของโมเดลภาษาขนาดใหญ่ ในเวลาว่าง วิเวกชอบเดินป่า ดูหนัง และลองชิมอาหารประเภทต่างๆ

วิเวกกังสนิ เป็นสถาปนิกโซลูชันสตาร์ทอัพ AI/ML สำหรับสตาร์ทอัพ Generative AI ที่ AWS เขาช่วยสตาร์ทอัพ GenAI เกิดใหม่สร้างโซลูชันที่เป็นนวัตกรรมโดยใช้บริการของ AWS และการประมวลผลแบบเร่งความเร็ว ปัจจุบันเขามุ่งเน้นไปที่การพัฒนากลยุทธ์สำหรับการปรับแต่งอย่างละเอียดและเพิ่มประสิทธิภาพการอนุมานของโมเดลภาษาขนาดใหญ่ ในเวลาว่าง วิเวกชอบเดินป่า ดูหนัง และลองชิมอาหารประเภทต่างๆ

ดร. Ashish Khetan เป็นนักวิทยาศาสตร์ประยุกต์อาวุโสที่มีอัลกอริทึมในตัวของ Amazon SageMaker และช่วยพัฒนาอัลกอริทึมการเรียนรู้ของเครื่อง เขาได้รับปริญญาเอกจาก University of Illinois Urbana-Champaign เขาเป็นนักวิจัยที่กระตือรือร้นในด้านแมชชีนเลิร์นนิงและการอนุมานทางสถิติ และได้ตีพิมพ์บทความจำนวนมากในการประชุม NeurIPS, ICML, ICLR, JMLR, ACL และ EMNLP

ดร. Ashish Khetan เป็นนักวิทยาศาสตร์ประยุกต์อาวุโสที่มีอัลกอริทึมในตัวของ Amazon SageMaker และช่วยพัฒนาอัลกอริทึมการเรียนรู้ของเครื่อง เขาได้รับปริญญาเอกจาก University of Illinois Urbana-Champaign เขาเป็นนักวิจัยที่กระตือรือร้นในด้านแมชชีนเลิร์นนิงและการอนุมานทางสถิติ และได้ตีพิมพ์บทความจำนวนมากในการประชุม NeurIPS, ICML, ICLR, JMLR, ACL และ EMNLP

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- เพลโตสุขภาพ เทคโนโลยีชีวภาพและข่าวกรองการทดลองทางคลินิก เข้าถึงได้ที่นี่.

- ที่มา: https://aws.amazon.com/blogs/machine-learning/fine-tune-and-deploy-mistral-7b-with-amazon-sagemaker-jumpstart/

- :มี

- :เป็น

- :ไม่

- :ที่ไหน

- 1

- 10

- 100

- 12

- 14

- 150

- 16

- 1933

- 1934

- 1995

- 200

- 21e

- 23

- 27a

- 32

- 39

- 40

- 400

- 7

- 700

- 8

- 9

- a

- ความสามารถ

- สามารถ

- เกี่ยวกับเรา

- เร่ง

- เข้า

- สามารถเข้าถึงได้

- ความถูกต้อง

- ถูกต้อง

- บรรลุ

- ข้าม

- กระทำ

- คล่องแคล่ว

- การปรับตัว

- ปรับ

- นอกจากนี้

- การโฆษณา

- ราคาไม่แพง

- หลังจาก

- AI

- โมเดล AI

- AI / ML

- Alexa

- อัลกอริทึม

- ทั้งหมด

- การอนุญาต

- ด้วย

- ทางเลือก

- อเมซอน

- อเมซอน SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- สหรัฐอเมริกา

- จำนวน

- an

- การวิเคราะห์

- และ

- ประกาศ

- ใด

- อาปาเช่

- ปรากฏ

- ประยุกต์

- อย่างเหมาะสม

- ปพลิเคชัน

- สถาปัตยกรรม

- เป็น

- AREA

- AS

- At

- ความสนใจ

- ใช้ได้

- AWS

- BE

- เพราะ

- รับ

- ก่อน

- ด้านล่าง

- มาตรฐาน

- ที่ดีที่สุด

- ดีกว่า

- ที่ใหญ่ที่สุด

- พันล้าน

- สีน้ำเงิน

- ทั้งสอง

- กว้าง

- สร้าง

- built-in

- ธุรกิจ

- by

- มา

- CAN

- แคนาดา

- ความสามารถในการ

- ความสามารถ

- ซึ่ง

- กรณี

- กรณี

- หมวดหมู่

- Choose

- การจัดหมวดหมู่

- ปิดหน้านี้

- การจัดกลุ่ม

- รหัส

- ชุด

- คอลัมน์

- รวม

- ความมุ่งมั่น

- ชุมชน

- บริษัท

- เทียบเคียง

- เปรียบเทียบ

- เมื่อเทียบกับ

- คู่แข่ง

- สมบูรณ์

- เสร็จสิ้น

- เสร็จสิ้น

- ส่วนประกอบ

- คำนวณ

- สรุป

- สภาพ

- การประชุม

- องค์ประกอบ

- ประกอบด้วย

- ปลอบใจ

- ผู้บริโภค

- ที่มีอยู่

- มี

- เนื้อหา

- ผู้สร้างเนื้อหา

- สิ่งแวดล้อม

- ต่อ

- ความสะดวกสบาย

- การสนทนา

- ตรงกัน

- ผู้สร้าง

- ขณะนี้

- ลูกค้า

- บริการลูกค้า

- ลูกค้า

- ข้อมูล

- ชุดข้อมูล

- ลึก

- การเรียนรู้ลึก ๆ

- การจัดส่ง

- สาธิต

- แสดงให้เห็นถึง

- ปรับใช้

- การใช้งาน

- อธิบาย

- ออกแบบ

- แม้จะมี

- รายละเอียด

- พัฒนา

- พัฒนา

- นักพัฒนา

- ที่กำลังพัฒนา

- การเบี่ยงเบน

- อุปกรณ์

- ต่าง

- สนทนา

- กล่าวถึง

- การสนทนา

- การแพร่กระจาย

- do

- เอกสาร

- โดเมน

- Dont

- ลง

- หลายสิบ

- ในระหว่าง

- E-commerce

- แต่ละ

- ก่อน

- ง่ายต่อการใช้งาน

- เสียงสะท้อน

- ประสิทธิผล

- ทั้ง

- อิเล็กทรอนิกส์

- กากกะรุน

- พนักงาน

- ทำให้สามารถ

- ปลายทาง

- ภาษาอังกฤษ

- ทำให้มั่นใจ

- ผู้ประกอบการ

- ยุค

- ประมาณการ

- ทุกคน

- ตัวอย่าง

- ตัวอย่าง

- ความยอดเยี่ยม

- ตลาดแลกเปลี่ยน

- ตื่นเต้น

- ที่มีอยู่

- ที่คาดหวัง

- อย่างชัดเจน

- การแสดงออก

- FAST

- เร็วขึ้น

- สองสาม

- เนื้อไม่มีมัน

- ยื่น

- เอกสารที่ยื่นต่อ

- ทางการเงิน

- บริการทางการเงิน

- ธรรมชาติ

- Fire TV

- ชื่อจริง

- พอดี

- โฟกัส

- มุ่งเน้น

- มุ่งเน้นไปที่

- ดังต่อไปนี้

- สำหรับ

- ฟอร์ม

- รูป

- สุขุม

- รากฐาน

- สี่

- ฟรี

- ราคาเริ่มต้นที่

- ฟังก์ชั่น

- ต่อไป

- ที่ได้รับ

- โดยทั่วไป

- สร้าง

- รุ่น

- กำเนิด

- กำเนิด AI

- ได้รับ

- GitHub

- เป้าหมาย

- ดี

- ได้

- ยิ่งใหญ่

- แนะนำ

- มี

- จัดการ

- มี

- he

- สุขภาพ

- การดูแลสุขภาพ

- การดูแลสุขภาพ

- เป็นประโยชน์

- จะช่วยให้

- จุดสูง

- สูงกว่า

- ของเขา

- หน้าแรก

- สถานีรถไฟบ้าน

- สรุป ความน่าเชื่อถือของ Olymp Trade?

- ทำอย่างไร

- HTML

- ที่ http

- HTTPS

- Huang

- ร้อย

- หลายร้อยล้าน

- i

- ระบุ

- if

- ii

- อิลลินอยส์

- ภาพ

- นำเข้า

- ปรับปรุง

- การปรับปรุง

- in

- ประกอบด้วย

- รวมถึง

- รวมทั้ง

- ดัชนี

- ข้อมูล

- นวัตกรรม

- อินพุต

- ที่ชาญฉลาด

- ตัวอย่าง

- แทน

- คำแนะนำการใช้

- ความสมบูรณ์

- ผลประโยชน์

- International

- เข้าไป

- การประดิษฐ์

- IT

- ITS

- การสัมภาษณ์

- jpg

- JSON

- กุญแจ

- ความรู้

- ภาษา

- ใหญ่

- ที่มีขนาดใหญ่

- ใหญ่ที่สุด

- ความแอบแฝง

- ชั้นนำ

- การเรียนรู้

- นำ

- ความยาว

- ระดับ

- License

- เบา

- น่าจะ

- Line

- เส้น

- คดี

- LLM

- นาน

- ระยะยาว

- อีกต่อไป

- ที่ต้องการหา

- ต่ำ

- ราคาต่ำ

- เครื่อง

- เรียนรู้เครื่อง

- ทำ

- จัดการ

- หลาย

- วัสดุ

- อาจ..

- ความหมาย

- ภาพบรรยากาศ

- หน่วยความจำ

- วิธี

- วิธีการ

- เม็กซิโก

- ล้าน

- ล้าน

- ภารกิจ

- สารผสม

- ML

- โทรศัพท์มือถือ

- ปพลิเคชันมือถือ

- แบบ

- โมเดล

- ข้อมูลเพิ่มเติม

- มากที่สุด

- Movies

- หลาย

- ต้อง

- ชื่อ

- โดยธรรมชาติ

- ประมวลผลภาษาธรรมชาติ

- จำเป็นต้อง

- สุทธิ

- เครือข่าย

- ใหม่

- นิวตัน

- ถัดไป

- NLP

- ทางทิศเหนือ

- อเมริกาเหนือ

- สมุดบันทึก

- ตอนนี้

- ความแตกต่าง

- วัตถุประสงค์

- of

- เสนอ

- การเสนอขาย

- มักจะ

- on

- ONE

- ออนไลน์

- เพียง

- การดำเนินงาน

- การดำเนินงาน

- การดำเนินการ

- เลนส์

- การเพิ่มประสิทธิภาพ

- ตัวเลือกเสริม (Option)

- or

- Organized

- เป็นต้นฉบับ

- อื่นๆ

- ของเรา

- เอาท์พุต

- เกิน

- ของตนเอง

- หน้า

- จับคู่

- เอกสาร

- ส่วนหนึ่ง

- คู่กรณี

- กิเลส

- ผู้ป่วย

- รูปแบบ

- ดำเนินการ

- การปฏิบัติ

- phd

- กายภาพ

- ทางร่างกาย

- แผน

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- จุด

- โพสต์

- นำเสนอ

- ราคา

- ราคา

- ประถม

- สำคัญ

- หลักการ

- ส่วนตัว

- กระบวนการ

- การประมวลผล

- ก่อ

- การผลิต

- ผลิตภัณฑ์

- ผลิตภัณฑ์

- ประมาณการ

- ให้

- ให้บริการ

- ให้

- ผู้จัดหา

- ให้

- การให้

- สาธารณะ

- สาธารณชน

- การตีพิมพ์

- หลาม

- คุณภาพ

- คำถาม

- ค่อนข้าง

- สีแดง

- อ้างอิง

- สะท้อน

- การปฏิรูป

- ที่เกี่ยวข้อง

- การเผยแพร่

- ตรงประเด็น

- รายงาน

- กรุ

- เป็นตัวแทนของ

- เป็นตัวแทนของ

- ขอ

- ความต้องการ

- การวิจัย

- นักวิจัย

- เคารพ

- คำตอบ

- REST

- ข้อ จำกัด

- ผล

- ผลสอบ

- ค้าปลีก

- ร้านค้าปลีก

- การรักษา

- แหวน

- แข็งแรง

- ราช

- s

- sagemaker

- ขาย

- ที่ปรับขนาดได้

- นักวิทยาศาสตร์

- SDK

- สำนักงานคณะกรรมการ ก.ล.ต.

- การยื่นแบบ SEC

- Section

- ส่วน

- หลักทรัพย์

- ความปลอดภัย

- เห็น

- แสวงหา

- กลุ่ม

- การเลือก

- ขาย

- ผู้ขาย

- ระดับอาวุโส

- แยก

- ชุด

- ชุด A

- ให้บริการ

- บริการ

- บริการ

- ชุด

- ชุดอุปกรณ์

- การตั้งค่า

- น่า

- แสดงให้เห็นว่า

- แสดง

- แสดงให้เห็นว่า

- ปิด

- คล้ายคลึงกัน

- ง่าย

- เดียว

- คุณชาย

- สถานการณ์

- ขนาด

- เลื่อน

- มีขนาดเล็กกว่า

- เศษเล็กเศษน้อย

- สังคม

- ขาย

- ทางออก

- โซลูชัน

- แก้

- เฉพาะ

- โดยเฉพาะ

- เฉพาะ

- เป็นเงา

- ความเร็ว

- เริ่มต้น

- การเริ่มต้น

- startups

- งบ

- สหรัฐอเมริกา

- ทางสถิติ

- ขั้นตอน

- ขั้นตอน

- ยังคง

- การเก็บรักษา

- จัดเก็บ

- ร้านค้า

- กลยุทธ์

- ที่พริ้ว

- มุ่งมั่น

- แข็งแรง

- สตูดิโอ

- การสมัครสมาชิก

- บริการสมัครสมาชิก

- อย่างเช่น

- สูท

- ที่สนับสนุน

- รองรับ

- ตาราง

- ยาเม็ด

- การตัดเสื้อ

- งาน

- งาน

- ทีม

- การทำงานเป็นทีม

- เทคนิค

- เทมเพลต

- ทดสอบ

- ข้อความ

- เกี่ยวกับใจความ

- กว่า

- ที่

- พื้นที่

- พื้นที่

- โลก

- แล้วก็

- ที่นั่น

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- คิด

- ที่สาม

- บุคคลที่สาม

- นี้

- สาม

- ตลอด

- ตลอด

- ปริมาณงาน

- เวลา

- ทันเวลา

- ไปยัง

- ร่วมกัน

- รวม

- รถไฟ

- ผ่านการฝึกอบรม

- การฝึกอบรม

- หม้อแปลงไฟฟ้า

- รักษา

- จริง

- ลอง

- พยายาม

- จูน

- tv

- สอง

- ชนิด

- ชนิด

- ui

- ภายใต้

- ได้รับ

- เข้าใจ

- เป็นเอกลักษณ์

- พร้อมใจกัน

- ประเทศสหรัฐอเมริกา

- มหาวิทยาลัย

- บันทึก

- การปรับปรุง

- us

- ใช้

- มือสอง

- ใช้

- การใช้

- การตรวจสอบ

- ความคุ้มค่า

- ความหลากหลาย

- ต่างๆ

- แตกต่างกัน

- กว้างใหญ่

- รุ่น

- มาก

- ผ่านทาง

- วิดีโอ

- วิสัยทัศน์

- เดิน

- ชม

- ทาง..

- we

- เว็บ

- บริการเว็บ

- เว็บไซต์

- ดี

- คือ

- อะไร

- ความหมายของ

- เมื่อ

- ที่

- ในขณะที่

- ขาว

- จะ

- หน้าต่าง

- กับ

- ภายใน

- ไม่มี

- คำ

- งาน

- ทำงานด้วยกัน

- โลก

- ของโลก

- เขียน

- ปี

- คุณ

- ของคุณ

- ลมทะเล